Erfahren Sie, wie Datensatzdestillation das Modelltraining beschleunigt und die Rechenkosten senkt, indem große Datensätze durch einen kleinen, optimierten Satz synthetischer Stichproben ersetzt werden.

Erfahren Sie, wie Datensatzdestillation das Modelltraining beschleunigt und die Rechenkosten senkt, indem große Datensätze durch einen kleinen, optimierten Satz synthetischer Stichproben ersetzt werden.

Das Trainieren von Modellen scheint vielleicht der zeitaufwendigste Teil der Arbeit eines Datenwissenschaftlers zu sein. Tatsächlich verbringen sie jedoch den größten Teil ihrer Zeit, oft 60 bis 80 %, damit, Daten vorzubereiten: sie zu sammeln, zu bereinigen und für die Modellierung zu organisieren. Mit zunehmender Größe der Datensätze steigt auch der Zeitaufwand für die Vorbereitung, was Experimente verlangsamt und Iterationen erschwert.

Um dieses Problem anzugehen, haben Forscher jahrelang nach Möglichkeiten gesucht, das Training zu optimieren. Ansätze wie synthetische Daten, Datensatzkomprimierung und bessere Optimierungsmethoden zielen alle darauf ab, die Kosten und Reibungsverluste bei der Arbeit mit großen Datensätzen zu reduzieren und die Arbeitsabläufe beim maschinellen Lernen zu beschleunigen.

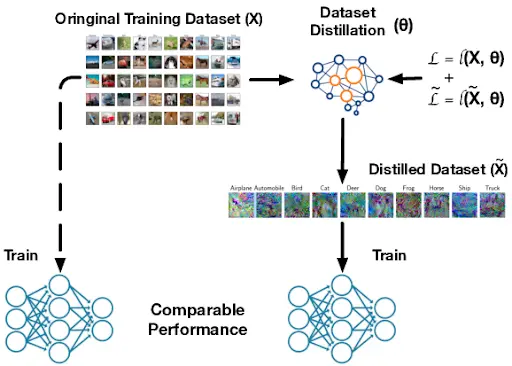

Eine wichtige Frage, die sich dabei stellt, ist, ob wir einen Datensatz drastisch verkleinern können und trotzdem die gleiche Leistung erzielen wie beim Training eines Modells mit den vollständigen Daten. Die Datensatzdestillation ist eine vielversprechende Antwort darauf.

Es erstellt eine kompakte Version eines großen Trainingsdatensatzes und bewahrt dabei die wesentlichen Muster, die das Modell für ein effektives Lernen benötigt. Es ermöglicht ein schnelleres Training, geringere Rechenanforderungen und effizientere Experimente. Man kann es sich wie einen Spickzettel für das Modell vorstellen, einen kleinen Satz synthetischer Datenbeispiele, die darauf ausgelegt sind, dieselben Kernmuster wie der vollständige Datensatz zu vermitteln.

In diesem Artikel untersuchen wir, wie Datensatzdestillation funktioniert und wie sie skalierbares maschinelles Lernen und Deep Learning in realen Anwendungen unterstützt. Los geht's!

Datensatzdestillation ist ein Prozess, bei dem ein großer Trainingsdatensatz zu einem viel kleineren Datensatz verdichtet wird, der einem Modell dennoch fast dieselben Informationen wie der ursprüngliche Datensatz vermittelt. Viele Forscher bezeichnen diesen Prozess auch als Datensatzkondensation, da das Ziel darin besteht, die wesentlichen Muster zu erfassen, die im gesamten Datensatz auftreten.

Ein destillierter Datensatz unterscheidet sich von zufällig generierten synthetischen Daten oder der einfachen Auswahl einer kleineren Teilmenge realer Bilder. Es handelt sich nicht um einen zufälligen gefälschten Datensatz oder eine gekürzte Kopie des Originals.

Stattdessen wird es bewusst optimiert, um die wichtigsten Muster zu erfassen. Während dieses Prozesses wird jedes Pixel und jedes Merkmal angepasst und optimiert, sodass ein neuronales Netzwerk, das auf den destillierten Daten trainiert wurde, fast so lernt, als wäre es auf dem gesamten Datensatz trainiert worden.

Diese Idee tauchte erstmals 2018 in einem arXiv-Artikel von Tongzhou Wang, Jun-Yan Zhu, Antonio Torralba und Alexei A. Efros auf. In frühen Tests wurden einfache Datensätze wie MNIST und CIFAR-10 verwendet, wodurch leicht gezeigt werden konnte, dass einige wenige destillierte Samples Tausende von realen Bildern ersetzen konnten.

.webp)

Seitdem haben Folgearbeiten die Datensatzdestillation weiter vorangetrieben, darunter auch bei ICML und ICLR veröffentlichte Methoden, die die Verdichtung effizienter und skalierbarer machen.

Die Datensatzdestillation verbessert die Trainingseffizienz und beschleunigt die Entwicklungszyklen. Durch die Reduzierung der Datenmenge, aus der ein Modell lernen muss, werden die Rechenanforderungen gesenkt.

Dies ist besonders nützlich für kontinuierliches Lernen, bei dem Modelle im Laufe der Zeit aktualisiert werden, für die Suche nach neuronalen Architekturen, bei der viele Modelldesigns getestet werden, und für das Edge-Training, bei dem Modelle auf kleinen Geräten mit begrenzter Speicher- und Rechenleistung ausgeführt werden. Insgesamt machen diese Vorteile die Datensatzdestillation zu einer hervorragenden Option für die schnelle Initialisierung, die schnelle Feinabstimmung und die Erstellung früher Prototypen in vielen Machine-Learning-Workflows.

Datensatzdestillation erzeugt synthetische oder künstlich generierte Trainingsbeispiele. Diese Beispiele helfen einem Modell dabei, auf eine Weise zu lernen, die dem Training mit realen Daten sehr ähnlich ist. Dabei werden drei Schlüsselfaktoren während des normalen Trainings verfolgt.

An erster Stelle steht die Verlustfunktion, also die Fehlerbewertung des Modells, die angibt, wie falsch seine Vorhersagen sind. An zweiter Stelle stehen die Modellparameter, also die internen Gewichte des Netzwerks, die während des Lernprozesses aktualisiert werden.

An dritter Stelle steht der Trainingsverlauf, der beschreibt, wie sich der Fehler und die Gewichte im Laufe der Zeit Schritt für Schritt verändern. Die synthetischen Stichproben werden dann so optimiert, dass beim Training eines Modells darauf der Fehler sinkt und die Gewichte auf die gleiche Weise aktualisiert werden wie beim vollständigen Datensatz.

Hier sehen Sie genauer, wie der Prozess der Datensatzdestillation funktioniert:

Alle Methoden zur Datensatzdestillation basieren auf derselben Grundidee, auch wenn sie unterschiedliche Algorithmen verwenden, um dieses Ziel zu erreichen. Die meisten Ansätze lassen sich in drei Kategorien einteilen: Leistungsanpassung, Verteilungsanpassung und Parameteranpassung.

Als Nächstes schauen wir uns jedes einzelne an und sehen, wie es funktioniert.

Die Leistungsanpassung bei der Datensatzdestillation konzentriert sich auf die Erstellung eines kleinen, optimierten Trainingssatzes, mit dem ein Modell fast die gleiche Genauigkeit erreichen kann, als wäre es mit dem vollständigen Originaldatensatz trainiert worden. Anstatt eine zufällige Teilmenge auszuwählen, werden die destillierten Stichproben so optimiert, dass ein damit trainiertes Modell ähnliche Vorhersagen, ein ähnliches Verlustverhalten während des Trainings oder eine ähnliche endgültige Genauigkeit wie ein mit dem Originaldatensatz trainiertes Modell erzielt.

Meta-Lernen ist eine gängige Methode, um diesen Prozess zu verbessern. Der destillierte Datensatz wird durch wiederholte Trainingsepisoden aktualisiert, sodass er in vielen möglichen Situationen effektiv ist.

Während dieser Episoden simuliert die Methode, wie ein Schülermodell aus den aktuellen destillierten Stichproben lernt, überprüft, wie gut dieser Schüler mit realen Daten abschneidet, und passt dann die destillierten Stichproben an, damit sie bessere Lehrer sind. Mit der Zeit lernt der destillierte Satz, schnelles Lernen und starke Generalisierung zu unterstützen, selbst wenn das Schülermodell mit unterschiedlichen Anfangsgewichten startet oder eine andere Architektur verwendet. Dadurch wird der destillierte Datensatz zuverlässiger und ist nicht an einen einzigen Trainingslauf gebunden.

.webp)

Unterdessen generiert das Distributionsabgleichverfahren synthetische Daten, die den statistischen Mustern des realen Datensatzes entsprechen. Anstatt sich nur auf die endgültige Genauigkeit eines Modells zu konzentrieren, konzentriert sich dieser Ansatz auf die internen Merkmale, die ein neuronales Netzwerk während des Lernens generiert.

Als Nächstes wollen wir uns die beiden Techniken ansehen, die das Distributionsabgleichen vorantreiben.

Die einlagige Verteilungsanpassung konzentriert sich auf eine einzelne Schicht eines neuronalen Netzwerks und vergleicht die Merkmale, die es für reale gegenüber synthetischen Daten erzeugt. Diese Merkmale, auch Aktivierungen genannt, erfassen, was das Modell zu diesem Zeitpunkt im Netzwerk gelernt hat.

Indem die synthetischen Daten ähnliche Aktivierungen erzeugen, sorgt die Methode dafür, dass der destillierte Datensatz dieselben wichtigen Muster wie der ursprüngliche Datensatz widerspiegelt. In der Praxis werden die synthetischen Samples so lange aktualisiert, bis die Aktivierungen in der ausgewählten Schicht denen aus echten Bildern sehr nahe kommen.

Dieser Ansatz ist relativ einfach, da er jeweils nur eine Darstellungsebene ausrichtet. Er eignet sich besonders gut für kleinere Datensätze oder Aufgaben, bei denen keine tiefgreifende, mehrstufige Merkmalshierarchie erforderlich ist. Durch die klare Ausrichtung eines Merkmalsraums liefert das Single-Layer-Matching ein stabiles und aussagekräftiges Signal für das Lernen mit dem destillierten Datensatz.

Die mehrschichtige Verteilungsanpassung basiert auf der Idee, reale und synthetische Daten zu vergleichen, indem dies nicht nur auf einer Ebene, sondern auf mehreren Ebenen eines neuronalen Netzwerks erfolgt. Verschiedene Ebenen erfassen unterschiedliche Arten von Informationen, von einfachen Kanten und Texturen in frühen Ebenen bis hin zu Formen und komplexeren Mustern in tieferen Ebenen.

Durch den Abgleich der Merkmale über diese Ebenen hinweg wird der destillierte Datensatz so angepasst, dass er widerspiegelt, was das Modell auf mehreren Ebenen lernt. Da dieser Ansatz die Merkmale im gesamten Netzwerk aufeinander abstimmt, trägt er dazu bei, dass die synthetischen Daten reichhaltigere Signale bewahren, auf die sich das Modell stützt, um Klassen voneinander zu unterscheiden.

Dies ist besonders hilfreich im Bereich Computer Vision, also bei Aufgaben, bei denen Modelle lernen, Bilder und Videos zu verstehen, da nützliche Muster über viele Schichten verteilt sind. Wenn die Merkmalsverteilungen in mehreren Tiefen gut übereinstimmen, fungiert der destillierte Datensatz als stärkerer und zuverlässigerer Ersatz für die ursprünglichen Trainingsdaten.

Eine weitere wichtige Kategorie bei der Datensatzdestillation ist die Parameteranpassung. Anstatt die Genauigkeit oder Merkmalsverteilungen anzupassen, wird angepasst, wie sich die Gewichte eines Modells während des Trainings ändern. Indem das Training mit dem destillierten Datensatz ähnliche Parameteraktualisierungen wie das Training mit realen Daten erzeugt, folgt das Modell einem nahezu identischen Lernpfad.

Als Nächstes werden wir die beiden wichtigsten Methoden zur Parameteranpassung durchgehen.

Beim Single-Step-Matching wird verglichen, was mit den Gewichten eines Modells nach nur einem Trainingsschritt mit realen Daten geschieht. Der destillierte Datensatz wird dann so abgestimmt, dass ein darauf trainiertes Modell nach einem Schritt eine sehr ähnliche Gewichtsaktualisierung erzeugt. Da sich diese Methode nur auf diese einzelne Aktualisierung konzentriert, ist sie unkompliziert und schnell durchzuführen.

Der Nachteil ist, dass ein einzelner Schritt nicht den gesamten Lernprozess widerspiegelt, insbesondere bei schwierigeren Aufgaben, bei denen das Modell viele Aktualisierungen benötigt, um reichhaltigere Funktionen aufzubauen. Aus diesem Grund funktioniert das Single-Step-Matching in der Regel am besten bei einfacheren Problemen oder kleineren Datensätzen, bei denen nützliche Muster schnell erkannt werden können.

Im Gegensatz dazu untersucht die mehrstufige Parameteranpassung, wie sich die Gewichte eines Modells über mehrere Trainingsschritte hinweg verändern, nicht nur über einen einzigen. Diese Abfolge von Aktualisierungen ist die Trainingskurve des Modells.

Der destillierte Datensatz ist so aufgebaut, dass ein Modell, das mit den synthetischen Stichproben trainiert wird, eine Entwicklung nimmt, die derjenigen bei realen Daten sehr nahe kommt. Durch die Anpassung an einen längeren Lernabschnitt erfasst der destillierte Satz mehr von der Struktur des ursprünglichen Trainingsprozesses.

Da es widerspiegelt, wie sich das Lernen im Laufe der Zeit entwickelt, eignet sich das mehrstufige Abgleichverfahren in der Regel besser für größere oder komplexere Datensätze, bei denen Modelle viele Aktualisierungen benötigen, um nützliche Muster zu erkennen. Es erfordert zwar mehr Rechenaufwand, da track Schritte track müssen, aber es liefert oft destillierte Datensätze, die sich besser verallgemeinern lassen und eine bessere Leistung bieten als das einstufige Abgleichverfahren.

Mit einem besseren Verständnis der wichtigsten Destillationsansätze können wir uns nun ansehen, wie synthetische Daten erstellt werden. Bei der Datensatzdestillation werden synthetische Stichproben optimiert, um das wichtigste Lernsignal zu erfassen, sodass ein kleiner Satz einen viel größeren Datensatz ersetzen kann.

Als Nächstes werden wir sehen, wie diese destillierten Daten generiert und ausgewertet werden.

Während der Datensatzdestillation werden die synthetischen Pixel über viele Trainingsschritte hinweg aktualisiert. Das neuronale Netzwerk lernt aus den aktuellen synthetischen Bildern und sendet gradientenbasiertes Feedback, das angibt, wie sich jedes Pixel ändern sollte, um besser zu den Mustern im realen Datensatz zu passen.

Dies funktioniert, weil der Prozess differenzierbar ist (d. h. jeder Schritt ist glatt und hat klar definierte Gradienten, sodass kleine Pixeländerungen zu vorhersehbaren Änderungen des Verlusts führen), wodurch das Modell die synthetischen Daten während des Gradientenabstiegs reibungslos anpassen kann.

Im Zuge der weiteren Optimierung beginnen die synthetischen Bilder, eine aussagekräftige Struktur zu bilden, einschließlich Formen und Texturen, die das Modell erkennt. Diese verfeinerten synthetischen Bilder werden häufig für Bildklassifizierungsaufgaben verwendet, da sie die wichtigsten visuellen Merkmale erfassen, die ein Klassifikator lernen muss.

Destillierte Datensätze werden bewertet, indem Modelle darauf trainiert und die Ergebnisse mit Modellen verglichen werden, die auf realen Daten trainiert wurden. Forscher messen die Validierungsgenauigkeit und prüfen, ob der synthetische Satz die Unterscheidungsmerkmale (die Muster oder Signale, anhand derer das Modell eine Klasse von einer anderen unterscheidet) beibehält, die zur Trennung der Klassen erforderlich sind. Sie testen auch die Stabilität und Generalisierung über verschiedene Durchläufe oder Modellkonfigurationen hinweg, um sicherzustellen, dass die destillierten Daten nicht zu Überanpassung führen.

Als Nächstes werden wir uns Beispiele genauer ansehen, die zeigen, wie destillierte Datensätze das Training beschleunigen und die Rechenkosten senken, während sie gleichzeitig eine starke Leistung beibehalten, selbst wenn die Daten begrenzt oder hochspezialisiert sind.

Beim Thema Computer Vision geht es darum, Modelle so zu trainieren, dass sie visuelle Daten wie Bilder und Videos verstehen. Diese Modelle lernen Muster wie Kanten, Texturen, Formen und Objekte und nutzen diese dann für Aufgaben wie Bildklassifizierung, Objekterkennung oder Segmentierung. Da Sehprobleme oft mit großen Unterschieden in Bezug auf Beleuchtung, Hintergründe und Blickwinkel einhergehen, benötigen Computer-Vision-Systeme in der Regel große Datensätze, um gut zu generalisieren, was das Training teuer und langsam macht.

Bei Anwendungsfällen der Bildklassifizierung wie medizinischen Scans, Wildtierbeobachtung oder Fehlererkennung in Fabriken stehen Modelle oft vor einem schwierigen Kompromiss zwischen Genauigkeit und Trainingskosten. Diese Aufgaben umfassen in der Regel riesige Datensätze.

Durch Datensatzdestillation kann der ursprüngliche Trainingssatz auf eine kleine Anzahl synthetischer Bilder komprimiert werden, die dennoch die wichtigsten visuellen Hinweise für den Klassifikator enthalten. Bei großen Benchmarks wie ImageNet hat sich gezeigt, dass destillierte Sätze, die nur etwa 4,2 % der Originalbilder verwenden, eine hohe Klassifizierungsgenauigkeit beibehalten. Das bedeutet, dass ein winziger synthetischer Proxy Millionen von echten Samples mit weitaus weniger Rechenaufwand ersetzen kann.

Die neuronale Architektursuche (Neural Architecture Search, NAS) ist eine Technik, die automatisch viele mögliche neuronale Netzwerkdesigns untersucht, um das für eine Aufgabe am besten geeignete zu finden. Da NAS eine große Anzahl von Kandidatenmodellen trainieren und bewerten muss, kann die Ausführung auf vollständigen Datensätzen langsam und sehr rechenintensiv sein.

Die Datensatzdestillation hilft dabei, indem sie einen winzigen synthetischen Trainingssatz erstellt, der immer noch das wichtigste Lernsignal der Originaldaten enthält, sodass jede Kandidatenarchitektur viel schneller getestet werden kann. Auf diese Weise kann NAS Designs effizient vergleichen und gleichzeitig die Rangfolge guter und schlechter Architekturen einigermaßen zuverlässig halten, wodurch die Suchkosten gesenkt werden, ohne die Qualität des endgültigen Modells wesentlich zu beeinträchtigen.

Kontinuierliche Lernsysteme, also Modelle, die sich bei Eingang neuer Daten ständig aktualisieren, anstatt einmalig trainiert zu werden, benötigen schnelle und speichereffiziente Updates. Edge-Geräte wie Kameras, Telefone und Sensoren unterliegen ähnlichen Einschränkungen, da sie nur über begrenzte Rechen- und Speicherkapazitäten verfügen.

Die Datensatzdestillation hilft in beiden Fällen, indem sie einen großen Trainingssatz zu einem winzigen synthetischen Satz komprimiert, sodass Modelle sich anhand eines kleinen Wiedergabesatzes anpassen oder neu trainieren können, anstatt den gesamten Datensatz zu verwenden. Beispielsweise hat die kernbasierte Meta-Lernarbeit gezeigt, dass bereits 10 destillierte Stichproben eine Genauigkeit von über 64 % bei CIFAR-10, einem Standard-Benchmark für die Bildklassifizierung, erreichen können. Da der Wiederholungssatz so kompakt ist, werden Aktualisierungen viel schneller und praktischer, insbesondere wenn Modelle häufig aktualisiert werden müssen.

Die Datensatzdestillation kann auch zusammen mit der Wissensdestillation für große Sprachmodelle eingesetzt werden. Ein kleiner destillierter Datensatz kann die wichtigsten Aufgabensignale aus dem Lehrer-Modell beibehalten, sodass ein komprimiertes Schüler-Modell effizienter trainiert oder aktualisiert werden kann, ohne dass dabei viel Leistung verloren geht. Da diese Datensätze sehr klein sind, eignen sie sich besonders für den Einsatz am Rand oder auf Geräten, wo Speicherplatz und Rechenleistung begrenzt sind, das Modell aber nach Updates dennoch genau bleiben soll.

Hier sind einige Vorteile der Datensatzdestillation:

Obwohl die Datensatzdestillation mehrere Vorteile bietet, gibt es einige Einschränkungen, die zu beachten sind:

Durch Datensatzdestillation kann ein Modell anhand einer kleinen Menge synthetischer Stichproben fast genauso effektiv trainiert werden wie anhand eines vollständigen Datensatzes. Dadurch wird maschinelles Lernen schneller, effizienter und einfacher skalierbar. Wenn Modelle wachsen und mehr Daten benötigen, bieten destillierte Datensätze eine praktische Möglichkeit, die Rechenkosten zu senken, ohne dabei an Genauigkeit einzubüßen.

Treten Sie unserer Community bei und besuchen Sie unser GitHub-Repository, um mehr über KI zu erfahren. Wenn Sie Ihr eigenes Vision-KI-Projekt aufbauen möchten, informieren Sie sich über unsere Lizenzoptionen. Erfahren Sie mehr über Anwendungen wie KI im Gesundheitswesen und Vision-KI im Einzelhandel auf unseren Lösungsseiten.