Erfahren Sie, wie die monokulare Tiefenschätzung funktioniert, wie sie sich im Vergleich zu sensorbasierten Tiefenmessverfahren verhält und wie sie eine skalierbare 3D-Wahrnehmung in Bildverarbeitungssystemen ermöglicht.

Erfahren Sie, wie die monokulare Tiefenschätzung funktioniert, wie sie sich im Vergleich zu sensorbasierten Tiefenmessverfahren verhält und wie sie eine skalierbare 3D-Wahrnehmung in Bildverarbeitungssystemen ermöglicht.

Selbstfahrende Autos sind so konzipiert, dass sie ihre Umgebung verstehen, um sicher fahren zu können. Das bedeutet, dass sie mehr können als nur Objekte wie Fußgänger oder andere Fahrzeuge zu erkennen.

Sie müssen auch wissen, wie weit diese Objekte entfernt sind, um richtig reagieren zu können. Maschinen dieses Gefühl für Entfernungen zu vermitteln, ist jedoch nicht einfach. Im Gegensatz zu Menschen nehmen sie Tiefe nicht auf natürliche Weise aus Bildern wahr und müssen dies ausdrücklich lernen.

Ein Grund dafür ist, dass die meisten Kameras die Welt als flache, zweidimensionale Bilder erfassen. Diese Bilder in etwas zu verwandeln, das die Tiefe und 3D-Struktur der realen Welt widerspiegelt, ist schwierig, insbesondere wenn die Systeme unter alltäglichen Bedingungen zuverlässig funktionieren müssen.

Interessanterweise ermöglicht es die Bildverarbeitung, ein Teilgebiet der KI, das sich auf die Interpretation und das Verständnis visueller Daten konzentriert, Maschinen, die Welt anhand von Bildern besser zu verstehen. Beispielsweise ist die monokulare Tiefenschätzung eine Bildverarbeitungstechnik, die die Entfernung von Objekten nur anhand eines einzigen Kamerabildes schätzt.

Durch das Erlernen visueller Hinweise wie Objektgröße, Perspektive, Textur und Schattierung können diese Modelle die Tiefe vorhersagen, ohne auf zusätzliche Sensoren wie LiDAR (Light Detection and Ranging) oder Stereokameras angewiesen zu sein. In diesem Artikel werden wir untersuchen, was monokulare Tiefenschätzung ist, wie sie funktioniert und einige ihrer Anwendungen in der Praxis. Lassen Sie uns beginnen!

Die monokulare Tiefenschätzung ermöglicht es einer Maschine, anhand eines einzigen Bildes zu erkennen, wie weit Objekte von ihr entfernt sind. Da dieser Ansatz nur eine Kamera benötigt, hat er mehrere Vorteile, darunter geringere Kosten und einfachere Hardwareanforderungen.

Beispielsweise kann es in erschwinglichen Heimrobotern eingesetzt werden, die mit einer einzigen Kamera arbeiten. Selbst anhand eines einzigen Bildes kann das Robotersystem erkennen, welche Wände näher und welche Türen weiter entfernt sind, und daraus die Gesamttiefe des Raums ableiten.

Oftmals enthält ein einzelnes Bild keine Informationen im richtigen Maßstab, sodass sich die monokulare Tiefenschätzung in der Regel auf die relative Tiefe konzentriert. Mit anderen Worten: Sie kann bestimmen, welche Objekte näher und welche weiter entfernt sind, auch wenn die genauen Entfernungen nicht bekannt sind.

Wenn ein Modell anhand von Daten mit Ground-Truth-Entfernungen oder absoluter Tiefe trainiert wird, beispielsweise anhand von Tiefenmessungen von Sensoren wie LiDAR, kann es lernen, Entfernungen in realen Einheiten wie Metern vorherzusagen. Ohne diese Art von Referenzdaten kann das Modell zwar weiterhin relative Tiefen ableiten, aber keine zuverlässigen Schätzungen absoluter Entfernungen vornehmen.

Das Ergebnis der monokularen Tiefenschätzung ist in der Regel eine Tiefenkarte, also ein Bild, in dem jedes Pixel angibt, wie nah oder fern sich der jeweilige Teil der Szene befindet. Eine Tiefenkarte vermittelt Bildverarbeitungssystemen ein grundlegendes Verständnis der 3D-Struktur der Umgebung.

Die Tiefenschätzung kann auf verschiedene Weise erfolgen, abhängig von den verfügbaren Sensoren, Hardware-Einschränkungen und Genauigkeitsanforderungen. Herkömmliche Methoden stützen sich häufig auf mehrere Blickwinkel oder spezielle Sensoren, um die Entfernung direkt zu messen.

Ein gängiger Ansatz ist die Stereosehtechnik, bei der die Tiefe durch den Vergleich zweier synchronisierter Bilder geschätzt wird, die aus leicht unterschiedlichen Blickwinkeln aufgenommen wurden. Durch die Messung des Unterschieds zwischen entsprechenden Punkten in den beiden Bildern kann das System ableiten, wie weit Objekte von der Kamera entfernt sind.

Ein weiterer Ansatz sind RGB-D-Systeme (Rot, Grün, Blau und Tiefe), die aktive Tiefensensoren verwenden, um die Entfernung an jedem Pixel direkt zu messen. Diese Systeme können in kontrollierten Umgebungen genaue Tiefeninformationen liefern, erfordern jedoch zusätzliche Hardware.

LiDAR-basierte Verfahren hingegen verwenden Laserimpulse, um präzise dreidimensionale Darstellungen einer Szene zu erzeugen. LiDAR-Sensoren sind zwar sehr genau, aber oft teuer und erhöhen die Komplexität der Hardware erheblich.

Im Gegensatz dazu wird bei der monokularen Tiefenschätzung die Tiefe nur anhand eines einzigen RGB-Bildes ermittelt. Da hierfür keine mehreren Kameras oder speziellen Sensoren erforderlich sind, lässt sich dieses Verfahren leichter in großem Maßstab einsetzen und ist eine gute Option, wenn Kosten und Hardware-Ressourcen begrenzt sind.

Bei der Schätzung der Tiefe anhand eines einzelnen Bildes lernen monokulare Tiefenmodelle, visuelle Hinweise zu erkennen, die Menschen instinktiv zur Beurteilung von Entfernungen nutzen. Zu diesen Hinweisen gehören perspektivische Linien, Objektgröße, Texturdichte, Objektüberlappung und Schattierung, die alle Aufschluss darüber geben, wie weit Objekte von der Kamera entfernt sind.

Diese Hinweise wirken zusammen, um ein Gefühl von Tiefe zu erzeugen. Objekte, die kleiner erscheinen oder teilweise verdeckt sind, befinden sich oft weiter entfernt, während klarere Details und größere visuelle Erscheinungen in der Regel darauf hindeuten, dass etwas näher ist.

Um diese Muster zu erlernen, werden monokulare Tiefenmodelle anhand umfangreicher Bilddatensätze trainiert, oft in Kombination mit Tiefeninformationen aus anderen Quellen wie LiDAR- oder Stereosystemen. Während des Trainings lernen die Modelle, wie visuelle Hinweise mit der Tiefe zusammenhängen, sodass sie zum Zeitpunkt der Inferenz aus einem einzigen Bild die Entfernung ableiten können.

Mit vielfältigen Trainingsdaten können moderne Bildverarbeitungsmodelle dieses erworbene Verständnis auf eine Vielzahl von Umgebungen übertragen, darunter Innen- und Außenbereiche, und auch mit ungewohnten Blickwinkeln umgehen.

Als Nächstes werden wir die wichtigsten Ansätze zur Schätzung der Tiefe anhand eines einzelnen Bildes untersuchen und wie sich diese Methoden im Laufe der Zeit weiterentwickelt haben.

Frühe Methoden zur Tiefenschätzung basierten auf einfachen visuellen Regeln, die mit der Kamerageometrie zusammenhingen. Hinweise wie Perspektive, Objektgröße und die Frage, ob ein Objekt ein anderes verdeckte, wurden zur Entfernungsschätzung herangezogen.

Wenn beispielsweise zwei ähnliche Objekte in unterschiedlichen Größen erschienen, wurde angenommen, dass das kleinere Objekt weiter entfernt war. Diese Ansätze funktionierten recht gut in kontrollierten Umgebungen, in denen Faktoren wie Beleuchtung, Kameraposition und Szenenlayout konsistent blieben.

In realen Szenen treffen diese Annahmen jedoch oft nicht zu. Schwankungen in der Beleuchtung, Änderungen des Blickwinkels und eine erhöhte Komplexität der Szene können zu unzuverlässigen Tiefenschätzungen führen, wodurch die Wirksamkeit klassischer Methoden in unkontrollierten Umgebungen eingeschränkt wird.

Frühe Methoden des maschinellen Lernens brachten mehr Flexibilität in die Tiefenschätzung, indem sie Muster direkt aus Daten lernten. Anstatt sich nur auf feste geometrische Regeln zu stützen, versuchten diese Modelle, die Beziehung zwischen visuellen Informationen und Entfernung zu lernen, wobei sie die Tiefenschätzung als Regressionsproblem behandelten, das auf Hinweisen wie Kanten, Texturen und Farbänderungen basierte.

Die Auswahl dieser Merkmale war ein wichtiger Teil des Prozesses. Die Ingenieure mussten entscheiden, welche visuellen Signale extrahiert und wie sie dargestellt werden sollten, und die Leistung des Modells hing stark von diesen Entscheidungen ab.

Dieser Ansatz funktionierte zwar besser als frühere Methoden, hatte aber dennoch seine Grenzen. Wenn den ausgewählten Merkmalen wichtiger Kontext fehlte, waren die Tiefenvorhersagen weniger genau. Mit zunehmender Komplexität und Vielfalt der Szenen hatten diese Modelle oft Schwierigkeiten, zuverlässige Ergebnisse zu liefern.

Die meisten modernen monokularen Tiefenschätzungssysteme verwenden Deep Learning, d. h. neuronale Netze mit vielen Schichten, die komplexe Muster aus Daten lernen können. Diese Modelle lernen, die Tiefe direkt aus Bildern vorherzusagen und Tiefenkarten zu erstellen.

Viele Ansätze basieren auf Convolutional Neural Networks (CNNs), einer Art neuronaler Netze, die Bilder durch Erkennung von Mustern wie Kanten und Formen verarbeiten. Diese Modelle verwenden häufig eine Encoder-Decoder-Konfiguration: Der Encoder extrahiert visuelle Merkmale aus dem Bild, und der Decoder wandelt diese Merkmale in eine Tiefenkarte um. Durch die Verarbeitung des Bildes in mehreren Maßstäben kann das Modell das Gesamtlayout der Szene erfassen und gleichzeitig klare Objektgrenzen erkennen.

Neuere Modelle konzentrieren sich darauf, Beziehungen zwischen verschiedenen Teilen eines Bildes zu verstehen. Transformer-basierte und Vision Transformer (ViT)-Modelle verwenden Aufmerksamkeitsmechanismen, mit denen das Modell erkennen kann, welche Bereiche eines Bildes am relevantesten sind, und entfernte Bereiche miteinander in Beziehung setzen kann. Dies hilft dem Modell, ein konsistenteres Verständnis der Tiefe in der gesamten Szene aufzubauen.

Einige Systeme kombinieren beide Ideen. Hybride CNN-Transformer-Modelle verwenden CNNs, um feine lokale Details zu erfassen, und Transformer, um den globalen Kontext der Szene zu modellieren. Dies verbessert zwar häufig die Genauigkeit, erfordert jedoch in der Regel mehr Rechenressourcen, wie z. B. zusätzlichen Speicher und Rechenleistung.

Wenn Sie sich mit der monokularen Tiefenschätzung beschäftigen, fragen Sie sich vielleicht, warum das Verständnis von Tiefe ein so wichtiger Bestandteil von bildbasierten KI-Systemen ist.

Wenn ein System abschätzen kann, wie weit Objekte und Oberflächen entfernt sind, erhält es ein besseres Verständnis dafür, wie eine Szene aufgebaut ist und wie verschiedene Elemente miteinander in Beziehung stehen. Diese Art von räumlichem Bewusstsein ist für zuverlässige Entscheidungen unerlässlich, insbesondere in realen Anwendungen wie dem autonomen Fahren.

Tiefeninformationen liefern auch wertvolle Kontextinformationen für andere Aufgaben im Bereich Computer Vision. Beispielsweise kann die Objekterkennung, unterstützt durch Modelle wie Ultralytics , einem System mitteilen, was in einer Szene vorhanden ist, aber die Tiefeninformationen helfen dabei, zu beantworten, wo sich diese Objekte relativ zur Kamera und zueinander befinden.

Zusammen ermöglichen diese Funktionen eine Vielzahl von Vision-KI-Anwendungen, wie beispielsweise die Erstellung von 3D-Karten, die Navigation in komplexen Umgebungen und das Verständnis einer Szene als Ganzes.

Roboter und autonome Fahrzeuge sind auf diese Informationen angewiesen, um sich sicher fortzubewegen, Hindernissen auszuweichen und in Echtzeit auf Veränderungen zu reagieren. So stützt sich beispielsweise Teslas rein visueller Fahransatz auf Kamerabilder in Kombination mit Tiefenschätzung statt auf LiDAR, um zu erkennen, wie weit Objekte entfernt sind und wie sie auf der Straße positioniert sind.

Obwohl sich die Modellarchitekturen unterscheiden, folgen die meisten monokularen Tiefenschätzungsmodelle einem ähnlichen Prozess, um ein einzelnes Bild in eine Tiefenkarte umzuwandeln. Hier ist ein kurzer Überblick über die wichtigsten Schritte:

Der soeben beschriebene Prozess setzt voraus, dass wir bereits über ein trainiertes oder vortrainiertes Modell verfügen. Aber wie funktioniert das Training eines monokularen Tiefenschätzungsmodells eigentlich?

Das Training beginnt mit der Vorbereitung der Bilddaten, damit diese vom Netzwerk effizient verarbeitet werden können. Die Eingabebilder werden in ihrer Größe angepasst und auf einen einheitlichen Maßstab normiert. Anschließend werden sie durch das Modell geleitet, um eine vorhergesagte Tiefenkarte zu generieren, die den Abstand jedes Pixels schätzt.

Die vorhergesagte Tiefenkarte wird dann mit Referenz-Tiefendaten unter Verwendung einer Verlustfunktion verglichen, die misst, wie weit die Vorhersage des Modells von der tatsächlichen Tiefe entfernt ist. Dieser Verlustwert stellt den aktuellen Fehler des Modells dar und liefert ein Signal für Verbesserungen.

Ein Optimierer nutzt dieses Signal, um das Modell durch Anpassung seiner internen Gewichte zu aktualisieren. Dazu berechnet der Optimierer den Gradienten, der beschreibt, wie sich der Verlust in Bezug auf jeden Modellparameter ändert, und wendet diese Aktualisierungen wiederholt über mehrere Epochen oder vollständige Durchläufe des Trainingsdatensatzes an.

Dieser iterative Trainingsprozess des überwachten Lernens wird durch Hyperparameter wie die Lernrate gesteuert, die bestimmt, wie groß jeder Aktualisierungsschritt ist, und die Batchgröße, die festlegt, wie viele Bilder gleichzeitig verarbeitet werden. Da das Training eine große Anzahl mathematischer Operationen umfasst, wird es in der Regel mithilfe einer Grafikprozessoreinheit (GPU) beschleunigt, die sich hervorragend für parallele Berechnungen eignet.

Nach Abschluss des Trainings wird das Modell anhand von Standardbewertungsmetriken anhand eines Validierungssatzes bewertet, der aus Bildern besteht, die während des Trainings nicht verwendet wurden. Diese Bewertung hilft dabei, zu messen, wie gut das Modell auf neue Daten verallgemeinert werden kann.

Das trainierte Modell kann dann für neue Szenarien wiederverwendet oder feinabgestimmt werden. Insgesamt ermöglicht dieser Trainingsprozess monokularen Tiefenschätzungsmodellen die Erstellung konsistenter Tiefenschätzungen, die für nachgelagerte Aufgaben wie 3D-Rekonstruktion und den Einsatz in der realen Welt unerlässlich sind.

Die monokulare Tiefenschätzung hat sich rasch verbessert, da Modelle mittlerweile ganze Szenen besser verstehen können und nicht mehr nur kleine visuelle Details. Frühere Ansätze erzeugten oft ungleichmäßige Tiefenkarten, insbesondere in komplexen Umgebungen.

Neuere Modelle, wie sie in aktuellen Forschungsarbeiten auf arXiv vorgestellt werden, konzentrieren sich stärker auf einen globalen Kontext, was zu stabileren und realistischeren Tiefenvorhersagen führt. Bekannte Modelle wie MiDaS und DPT haben diesen Wandel vorangetrieben, indem sie Tiefen aus vielfältigen, hochauflösenden Datensätzen gelernt und gut auf viele Szenen verallgemeinert haben.

Neuere Modelle, darunter ZoeDepth und Depth Anything V2, bauen auf dieser Arbeit auf, indem sie die Skalenkonsistenz verbessern und gleichzeitig eine starke Leistung über einen breiten Bereich von Einstellungen hinweg beibehalten. Diese Art von Fortschritt wird häufig anhand gängiger Benchmark-Datensätze wie KITTI und NYU gemessen, die sowohl Außen- als auch Innenaufnahmen abdecken.

Ein weiterer klarer Trend ist die Balance zwischen Genauigkeit und Praktikabilität. Kleinere Modelle sind auf Geschwindigkeit optimiert und können in Echtzeit auf Edge- oder Mobilgeräten ausgeführt werden, während größere Modelle eine höhere Auflösung und Tiefengenauigkeit über große Entfernungen priorisieren.

Als Nächstes sehen wir uns einige Beispiele aus der Praxis an, die zeigen, wie die monokulare Tiefenschätzung verwendet wird, um aus einem einzigen Bild Rückschlüsse auf die 3D-Struktur einer Szene zu ziehen.

In all diesen Fällen ist es wichtig zu bedenken, dass die Tiefeninformationen eine aus visuellen Hinweisen abgeleitete Schätzung und keine präzise Messung sind. Daher eignet sich die monokulare Tiefenschätzung zwar zum Verständnis der relativen Anordnung und der räumlichen Beziehungen, kann jedoch keine Sensoren ersetzen, die für die genaue Entfernungsmessung ausgelegt sind, wie beispielsweise LiDAR- oder Stereosysteme.

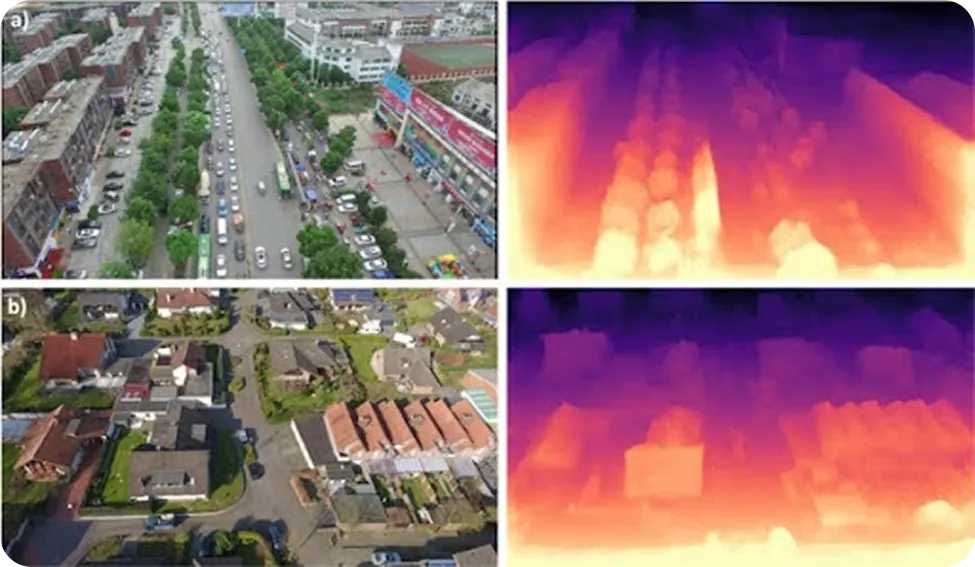

Drohnen werden häufig in Umgebungen eingesetzt, in denen GPS-Signale unzuverlässig sind, beispielsweise in Wäldern, auf Baustellen, in Katastrophengebieten oder in dicht bebauten städtischen Gebieten. Um unter diesen Bedingungen sicher fliegen zu können, müssen sie die Umgebung erfassen und wissen, wie weit Hindernisse entfernt sind. In der Vergangenheit waren dafür in der Regel zusätzliche Sensoren wie LiDAR oder Stereokameras erforderlich, die das Gewicht, den Stromverbrauch und die Gesamtkosten erhöhten.

Die monokulare Tiefenschätzung ist eine einfachere Alternative. Mit nur einer einzigen RGB-Kamera können Drohnen anhand von Bildern die Tiefe schätzen und ein grundlegendes 3D-Verständnis ihrer Umgebung aufbauen. So können sie detect wie Gebäude, Bäume oder plötzliche Veränderungen im Gelände detect und ihre Flugbahn in Echtzeit anpassen.

Diese Tiefenschätzungen unterstützen wichtige Navigationsaufgaben, darunter die Vermeidung von Hindernissen, die Höhenkontrolle und die sichere Landung. Dadurch können leichte Drohnen Kartierungs-, Inspektions- und Navigationsaufgaben ausführen, ohne auf spezielle Tiefensensoren angewiesen zu sein.

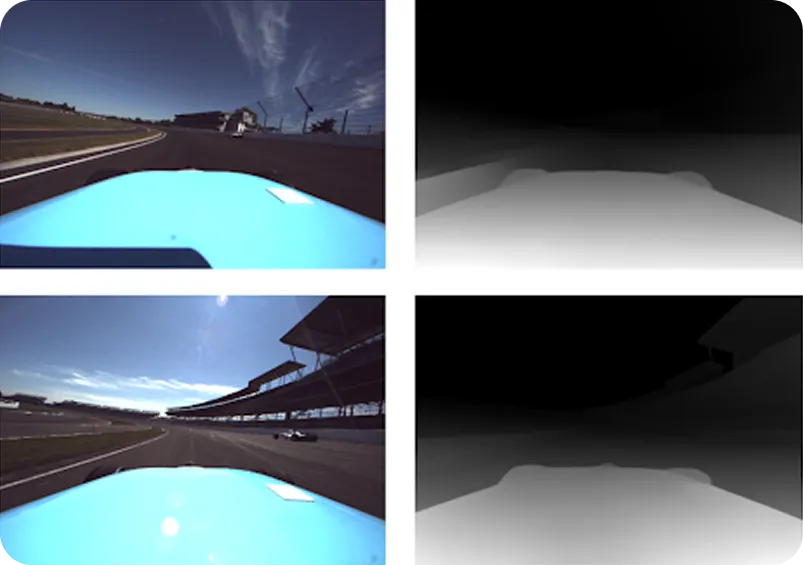

Autonome Fahrzeuge sind in der Regel stark auf LiDAR-Sensoren angewiesen, die mithilfe von Laserimpulsen Entfernungen messen und ein 3D-Bild der Straße erstellen. LiDAR ist zwar sehr genau, hat jedoch Schwierigkeiten mit scharfen Straßenkanten, steilen Hängen, Sichtbehinderungen oder plötzlichen Fahrzeugneigungen und liefert manchmal nur spärliche oder fehlende Tiefendaten.

Die monokulare Tiefenschätzung kann diese Lücken füllen, indem sie dichte Tiefeninformationen aus einem einzigen RGB-Bild liefert, selbst wenn die LiDAR-Daten unvollständig sind. Stellen Sie sich ein Szenario vor, in dem sich ein selbstfahrendes Auto mit hoher Geschwindigkeit einer Kuppe nähert. Die LiDAR-Strahlen können über die Straße hinter der Kuppe hinausreichen, sodass Unsicherheit darüber besteht, was vor dem Fahrzeug liegt.

Die kamerabasierte Tiefenschätzung kann jedoch anhand visueller Hinweise wie Perspektive und Textur weiterhin Rückschlüsse auf die Form der Straße ziehen und so dazu beitragen, dass das Fahrzeug eine zuverlässige Wahrnehmung beibehält, bis sich die LiDAR-Daten stabilisiert haben. Zusammen ermöglichen LiDAR und monokulare Tiefenschätzung eine stabilere Wahrnehmung und eine sicherere Steuerung unter schwierigen Fahrbedingungen.

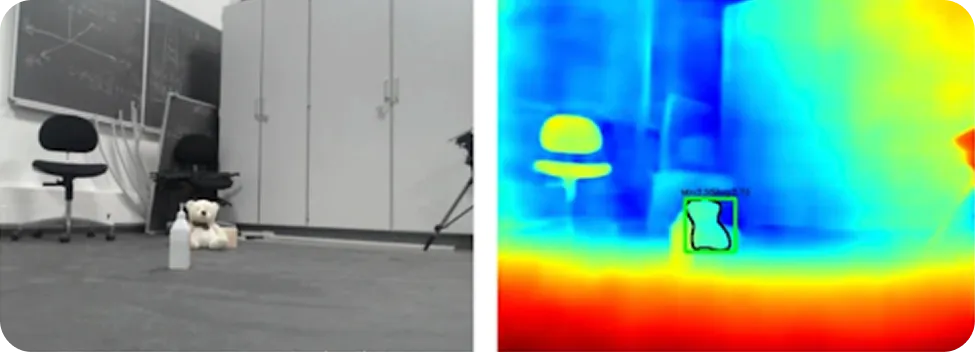

Roboter werden oft an Orten eingesetzt, an denen keine detaillierten Karten verfügbar sind und sich die Bedingungen ständig ändern. Um sich sicher zu bewegen, benötigen sie ein zuverlässiges Gefühl dafür, wie viel Platz um sie herum vorhanden ist und wo sich Hindernisse befinden.

Die monokulare Tiefenschätzung kann dieses räumliche Bewusstsein mit einer einzigen RGB-Kamera vermitteln, ohne dass dafür schwere oder teure Hardware erforderlich ist. Durch das Erlernen visueller Hinweise wie Maßstab und Perspektive können Tiefenschätzungsmodelle dichte Tiefenkarten der Umgebung erstellen. Dadurch erhalten Roboter eine klare Vorstellung von der Entfernung zu Oberflächen und Objekten.

Insbesondere wenn Tiefeninformationen mit Computer-Vision-Aufgaben wie Objekterkennung und semantischer Segmentierung kombiniert werden, können Roboter ein vollständigeres Bild ihrer Umgebung gewinnen. Sie können Objekte identifizieren, deren Entfernung einschätzen und entscheiden, wo sie sich sicher bewegen können. Dies unterstützt die Hindernisvermeidung, die Erkennung freier Räume und die Echtzeit-Wegplanung.

Hier sind einige der wichtigsten Vorteile der Verwendung der monokularen Tiefenschätzung:

Die monokulare Tiefenschätzung bietet zwar klare Vorteile, jedoch sind auch einige Einschränkungen zu berücksichtigen:

Die monokulare Tiefenschätzung ist zwar ein interessantes Forschungsgebiet, jedoch ist es wichtig zu verstehen, wo sie praktisch eingesetzt werden kann und wo nicht. Die von ihr ermittelten Entfernungen sind Schätzungen, die auf dem basieren, was das Modell in einem Bild sieht, und keine exakten Messungen aus der realen Welt.

Aus diesem Grund kann die Qualität der Ergebnisse je nach Faktoren wie Beleuchtung, Komplexität der Szene und Ähnlichkeit der Szene mit dem, worauf das Modell trainiert wurde, variieren. Die monokulare Tiefenschätzung ist in der Regel gut geeignet, um zu erkennen, was näher und was weiter entfernt ist, aber sie ist nicht zuverlässig, wenn Sie genaue Entfernungen benötigen.

In Situationen, in denen Präzision wirklich wichtig ist, wie z. B. bei sicherheitskritischen Systemen, industriellen Inspektionen oder Robotern, die sehr präzise mit Objekten interagieren müssen, muss die Tiefe direkt gemessen werden. Sensoren wie LiDAR, Radar, Stereokameras oder Structured-Light-Systeme sind dafür ausgelegt und liefern wesentlich zuverlässigere Entfernungsinformationen.

Die monokulare Tiefenschätzung kann auch unter schwierigen Sichtbedingungen Probleme bereiten. Schlechte Beleuchtung, starke Schatten, reflektierende oder transparente Oberflächen, Nebel, Rauch oder Szenen mit sehr geringer visueller Textur können die Zuverlässigkeit der Tiefenschätzung beeinträchtigen. Die Tiefenschätzung über große Entfernungen ist ein weiterer Fall, in dem spezielle Sensoren in der Regel besser funktionieren.

Wenn es um Lösungen für die Praxis geht, eignet sich die monokulare Tiefenschätzung am besten als unterstützendes Werkzeug und nicht als eigenständige Lösung. Sie kann nützliche räumliche Kontextinformationen liefern, Lücken füllen, wenn andere Sensoren an ihre Grenzen stoßen, und das allgemeine Verständnis der Szene verbessern. Sie sollte jedoch nicht die einzige Quelle für Tiefeninformationen sein, wenn Genauigkeit, Sicherheit oder strenge Zuverlässigkeitsanforderungen wichtig sind.

Die monokulare Tiefenschätzung ist eine Technik der Bildverarbeitung, mit der Maschinen anhand eines einzigen Kamerabildes die Entfernung von Objekten schätzen können. Durch das Erlernen visueller Hinweise wie Perspektive, Objektgröße, Textur und Schattierung können diese KI-Modelle die 3D-Struktur einer Szene ableiten, ohne auf Sensoren wie LiDAR oder Stereokameras angewiesen zu sein. Dies macht die monokulare Tiefenschätzung zu einem kostengünstigen und skalierbaren Ansatz für Anwendungen wie autonomes Fahren, Robotik und das Verständnis von 3D-Szenen.

Um mehr über Vision AI zu erfahren, besuchen Sie unser GitHub-Repository und treten Sie unserer Community bei. Auf unseren Lösungsseiten erfahren Sie mehr über KI in der Robotik und Computer Vision in der Fertigung. Entdecken Sie unsere Lizenzoptionen und starten Sie noch heute mit Computer Vision!