Scoprite come l'IA neuro-simbolica mira a combinare apprendimento e logica per costruire sistemi in grado di comprendere il contesto e fornire decisioni più trasparenti e spiegabili.

Scoprite come l'IA neuro-simbolica mira a combinare apprendimento e logica per costruire sistemi in grado di comprendere il contesto e fornire decisioni più trasparenti e spiegabili.

Oggi, grazie alla rapida crescita dell'intelligenza artificiale (AI) e alla crescente disponibilità di potenza di calcolo, i modelli avanzati di AI vengono rilasciati più rapidamente che mai. Di fatto, lo spazio dell'IA sta guidando un'innovazione significativa in molti settori.

Ad esempio, nel settore sanitario, i sistemi di IA vengono utilizzati per assistere in compiti quali l'analisi di immagini mediche per una diagnosi precoce. Tuttavia, come ogni tecnologia, l'IA ha i suoi limiti.

Uno dei problemi principali è la trasparenza. Ad esempio, un modello di rilevamento degli oggetti può individuare con precisione un tumore in una risonanza magnetica cerebrale, ma può essere difficile capire come il modello sia arrivato a tale conclusione. Questa mancanza di spiegazioni rende più difficile per medici e ricercatori fidarsi completamente dei risultati dell'IA o convalidarli.

È proprio per questo che sta crescendo l'interesse per il campo emergente dell'IA neuro-simbolica. L'IA neuro-simbolica combina i punti di forza del riconoscimento dei modelli dell'apprendimento profondo con il ragionamento strutturato e basato su regole dell'IA simbolica. L'obiettivo è creare sistemi che facciano previsioni accurate, ma che siano anche in grado di spiegare il loro ragionamento in modo comprensibile per l'uomo.

In questo articolo esploreremo come funziona l'intelligenza artificiale neuro-simbolica e come unisce l'apprendimento e il ragionamento per costruire sistemi più trasparenti e consapevoli del contesto. Iniziamo!

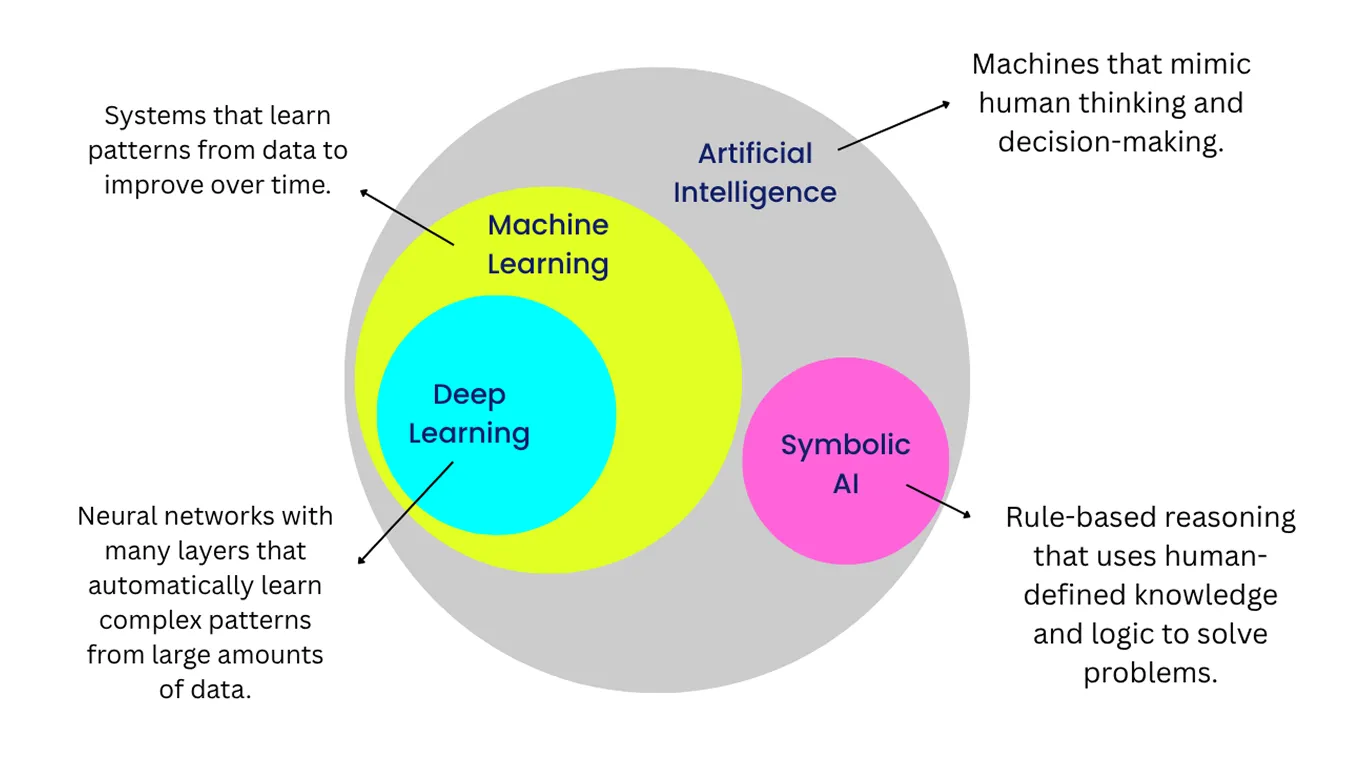

Prima di immergerci nell'IA neuro-simbolica, diamo un'occhiata più da vicino ai due sottocampi che essa riunisce: l'apprendimento profondo e l'IA simbolica.

L'apprendimento profondo si concentra sul riconoscimento di modelli nei dati, mentre l'intelligenza artificiale simbolica utilizza regole, logica o buon senso per risolvere i problemi. Ciascuna di esse ha dei punti di forza, ma anche dei limiti. Combinandole, l'IA neuro-simbolica crea sistemi in grado di imparare dai dati e di spiegare le proprie decisioni in modo più chiaro.

L'apprendimento profondo è una branca dell'apprendimento automatico che utilizza reti neurali artificiali, liberamente ispirate al modo in cui il cervello elabora le informazioni. Queste reti imparano analizzando grandi quantità di dati e regolando le loro connessioni interne per migliorare le prestazioni.

Questo permette loro di riconoscere schemi in immagini, suoni e testi senza bisogno di regole artigianali per ogni situazione. Per questo motivo, l'apprendimento profondo è molto efficace per compiti incentrati sulla percezione, come il riconoscimento delle immagini, l'elaborazione del parlato e la traduzione linguistica.

Un buon esempio è rappresentato da un modello di computer vision addestrato a segment gli oggetti nelle immagini. Con un numero sufficiente di esempi etichettati, può imparare a separare strade, veicoli e pedoni nei filmati del traffico in tempo reale.

Tuttavia, nonostante la loro accuratezza, i modelli di deep learning spesso faticano a spiegare chiaramente come sono arrivati a un determinato risultato. Questa sfida, comunemente chiamata "problema della scatola nera", rende più difficile per gli utenti interpretare o verificare le decisioni del modello, soprattutto in settori sensibili come la sanità o la finanza. È importante perché un'intelligenza artificiale responsabile richiede trasparenza, fiducia e la capacità di capire perché un modello ha fatto una determinata previsione.

L'IA simbolica adotta un approccio più strutturato all'intelligenza e al processo decisionale. Rappresenta la conoscenza tramite simboli e applica regole logiche per lavorare con quella conoscenza, in modo simile a come usiamo il ragionamento e il linguaggio per risolvere i problemi. Ogni fase del processo di ragionamento è definita, il che rende le decisioni dell'intelligenza artificiale simbolica trasparenti e più facili da spiegare.

La conoscenza simbolica funziona particolarmente bene nei compiti che seguono regole chiare e ben definite, come la pianificazione, la programmazione o la gestione di conoscenze strutturate. Tuttavia, l'intelligenza artificiale simbolica ha difficoltà con i dati non strutturati o con le situazioni che non rientrano in categorie predefinite.

Un esempio comune di approccio simbolico in azione è rappresentato dai primi programmi di scacchi. Essi seguivano regole artigianali e strategie fisse piuttosto che imparare dalle partite precedenti o adattarsi ad avversari diversi. Di conseguenza, il loro gioco tendeva a essere rigido e prevedibile.

Negli anni 2010, con la diffusione dell'apprendimento profondo, i ricercatori hanno iniziato a cercare modi per andare oltre il semplice riconoscimento dei modelli e per comprendere le relazioni e il contesto. Questo cambiamento ha reso possibile per i modelli di intelligenza artificiale non solo detect gli oggetti in una scena, come un gatto e un tappetino, ma anche interpretare le relazioni tra questi oggetti, ad esempio riconoscendo che il gatto è seduto sul tappetino.

Tuttavia, questi progressi hanno anche evidenziato un limite fondamentale. I modelli di apprendimento profondo sono in grado di riconoscere molto bene gli schemi, ma spesso faticano a spiegare il loro ragionamento o a gestire situazioni non familiari. Questa rinnovata attenzione al ragionamento ha riportato i ricercatori a un campo che esiste dagli anni '80: l'IA neuro-simbolica.

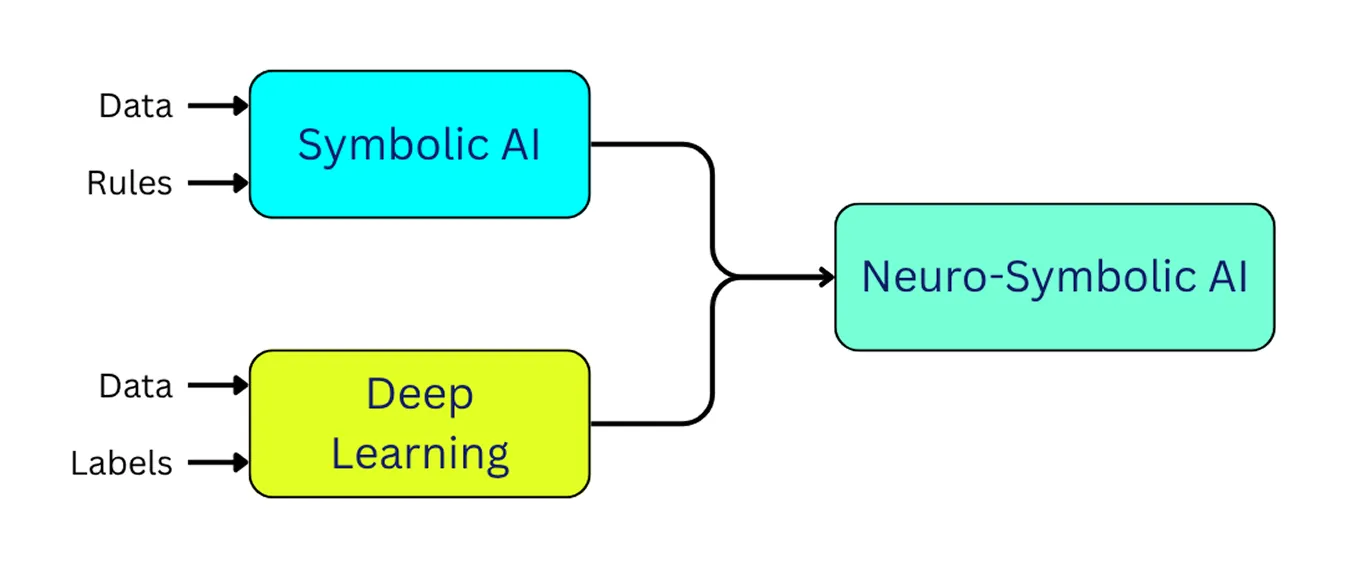

L'IA neuro-simbolica integra l'apprendimento profondo e l'IA simbolica. Consente ai modelli di apprendere dagli esempi come fa l'apprendimento profondo, applicando allo stesso tempo la logica e il ragionamento come fa l'IA simbolica.

In poche parole, l'IA neuro-simbolica è in grado di riconoscere le informazioni, comprendere il contesto e fornire spiegazioni più chiare per le sue decisioni. Questo approccio ci avvicina allo sviluppo di sistemi di IA che si comportano in modo più affidabile e simile a quello umano.

Le architetture neuro-simboliche riuniscono l'apprendimento e il ragionamento in un'unica struttura. In genere comprende tre parti principali: uno strato di percezione neurale che interpreta i dati grezzi, uno strato di ragionamento simbolico che applica la logica e uno strato di integrazione che collega i due. A seguire, daremo un'occhiata più da vicino a ciascun livello.

Il componente di percezione neurale elabora dati non strutturati, come immagini, video, testo o audio, e li converte in rappresentazioni interne con cui il sistema può lavorare. In genere utilizza modelli di apprendimento profondo per detect schemi e identificare oggetti o caratteristiche nell'input. In questa fase, il sistema riconosce ciò che è presente nei dati, ma non ragiona ancora sul significato, sulle relazioni o sul contesto.

Ecco alcuni tipi comuni di modelli di deep learning utilizzati in questo livello:

In definitiva, questi modelli neurali estraggono e rappresentano caratteristiche significative dai dati grezzi. Questo risultato diventa l'input per il livello di ragionamento simbolico, che interpreta e ragiona su ciò che il sistema ha rilevato.

Il livello di ragionamento simbolico prende le informazioni prodotte dal livello di percezione neurale e ne trae un senso usando la logica. Invece di lavorare solo su schemi, si affida a regole, grafi di conoscenza, basi di conoscenza e ontologie (descrizioni organizzate di concetti e di come si relazionano tra loro). Queste aiutano il sistema a capire come i diversi elementi si integrano tra loro e quali azioni hanno senso in una determinata situazione.

Ad esempio, in un'auto a guida autonoma, il livello di percezione neurale può riconoscere un semaforo rosso nel feed della telecamera. Il livello di ragionamento simbolico può quindi applicare una regola come: "Se il semaforo è rosso, il veicolo deve fermarsi". Poiché il ragionamento si basa su regole chiare, le decisioni del sistema sono più facili da spiegare e verificare, il che è particolarmente importante in situazioni in cui la sicurezza e la responsabilità sono importanti.

Lo strato di integrazione collega lo strato di percezione neurale e lo strato di ragionamento simbolico, assicurando che l'apprendimento e il ragionamento operino insieme. In una direzione, converte gli output dei modelli neurali (come il rilevamento di un pedone) in rappresentazioni simboliche che descrivono l'oggetto e i suoi attributi.

Nell'altra direzione, prende regole simboliche (per esempio, "un veicolo deve fermarsi se un pedone si trova sulle strisce pedonali") e le traduce in segnali che guidano i modelli neurali. Ciò può comportare l'evidenziazione di aree rilevanti di un'immagine, influenzare l'attenzione o modellare i percorsi decisionali del modello.

Questo scambio bidirezionale forma un ciclo di feedback. Il lato neurale acquisisce struttura e interpretabilità dalle regole simboliche, mentre il lato simbolico può adattarsi più efficacemente sulla base dei dati del mondo reale. Tecniche come le reti neurali logiche (LNN) consentono questa interazione incorporando vincoli logici direttamente nelle architetture neurali.

Collegando la percezione e il ragionamento in questo modo, l'intelligenza artificiale neuro-simbolica può produrre decisioni accurate e più facili da interpretare. Molti ricercatori considerano questo approccio come un passo promettente verso un'IA più affidabile e allineata all'uomo, e potenzialmente come base per i futuri progressi verso l'intelligenza artificiale generale (AGI).

Ora che abbiamo capito meglio cos'è e come funziona un'intelligenza artificiale neuro-simbolica, diamo un'occhiata ad alcuni casi d'uso reali.

I veicoli autonomi devono comprendere l'ambiente circostante per operare in sicurezza. Utilizzano tecnologie come la computer vision per detect pedoni, veicoli, segnaletica stradale e cartelli stradali.

Sebbene i modelli di deep learning siano in grado di identificare con precisione questi oggetti, non sempre comprendono il loro significato nel contesto o la loro relazione in una situazione reale. Per esempio, un modello neurale potrebbe riconoscere un pedone sulle strisce pedonali, ma non è in grado di capire se sta per attraversare o se è solo fermo e in attesa.

L'intelligenza artificiale neuro-simbolica cerca di colmare questo divario consentendo ai veicoli a guida autonoma di combinare il riconoscimento visivo con il ragionamento logico, in modo da poter interpretare le situazioni piuttosto che limitarsi a identificare gli oggetti. Recenti ricerche sull'IA hanno dimostrato che i sistemi che combinano la percezione neurale con regole simboliche possono migliorare la previsione del comportamento dei pedoni.

In questi sistemi, la componente neurale analizza spunti visivi come la postura, il movimento e la posizione del pedone. La componente simbolica applica quindi regole logiche, considerando fattori come la presenza di una persona in prossimità di un attraversamento pedonale o l'indicazione del segnale stradale corrente.

Combinando queste due prospettive, il sistema neuro-simbolico può fare di più che detect semplicemente un pedone. Può fare una previsione ragionevole sulla probabilità che il pedone attraversi e può spiegare perché ha preso questa decisione. Questo porta a un comportamento più sicuro e trasparente nei veicoli autonomi.

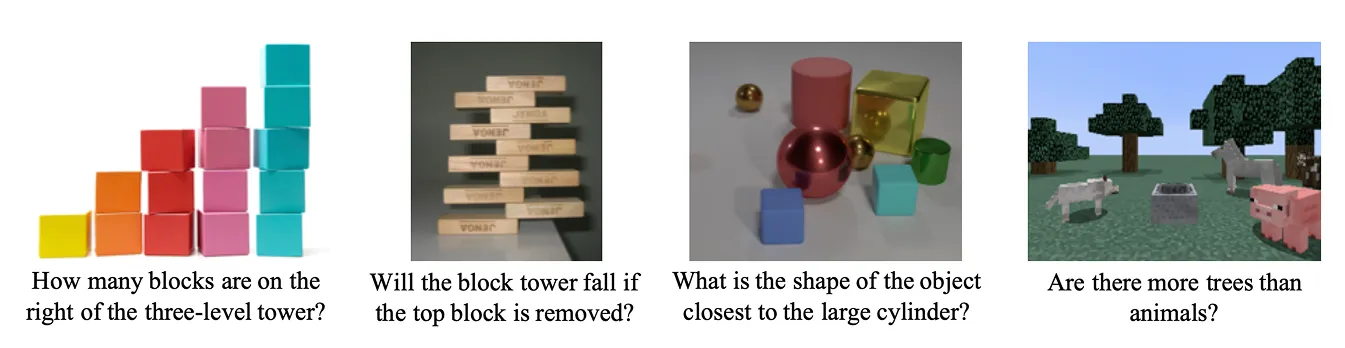

Un'altra importante applicazione dell'intelligenza artificiale neuro-simbolica è la risposta a domande visive (VQA). I sistemi VQA sono progettati per rispondere a domande sulle immagini.

Il sistema riunisce modelli linguistici di grandi dimensioni (LLM) e modelli visivi per eseguire ragionamenti multimodali, combinando ciò che il sistema vede con ciò che comprende. Ad esempio, se a un sistema VQA viene mostrata un'immagine e gli viene chiesto: "La tazza è sul tavolo?", deve riconoscere gli oggetti ma anche capire la relazione tra di essi. Deve determinare se la tazza si trova effettivamente sopra il tavolo nella scena.

Uno studio recente ha dimostrato come l'IA neuro-simbolica possa migliorare la VQA integrando la percezione neurale con il ragionamento simbolico. Nel sistema proposto, la rete neurale analizza innanzitutto l'immagine per riconoscere gli oggetti e i loro attributi, come il colore, la forma o le dimensioni.

La componente di ragionamento simbolico applica quindi regole logiche per interpretare la relazione tra questi oggetti e rispondere alla domanda. Se si chiede "Quanti cilindri grigi ci sono nella scena?", la parte neurale identifica tutti i cilindri e i loro colori, mentre la parte simbolica li filtra in base ai criteri e conta quelli corretti.

Questa ricerca mostra come la VQA neuro-simbolica possa andare oltre la semplice fornitura di risposte. Poiché il modello può mostrare i passi compiuti per giungere a una conclusione, supporta l'IA spiegabile, in cui i sistemi fanno previsioni e giustificano i loro ragionamenti in modo comprensibile per le persone.

Ecco alcuni dei principali vantaggi dell'utilizzo dell'IA neuro-simbolica:

Nonostante il suo potenziale, l'IA neuro-simbolica è ancora in evoluzione e presenta alcune sfide pratiche. Ecco alcuni dei suoi limiti principali:

L'IA neuro-simbolica rappresenta un passo importante verso la costruzione di sistemi di IA in grado non solo di percepire il mondo, ma anche di ragionare su di esso e di spiegare le proprie decisioni. A differenza dei tradizionali sistemi di deep learning, che si basano principalmente su modelli appresi dai dati, l'IA neuro-simbolica combina l'apprendimento statistico con la logica e la conoscenza strutturate. Piuttosto che sostituire l'apprendimento profondo, si basa su di esso, avvicinandoci allo sviluppo di IA in grado di comprendere e ragionare in modo più simile all'uomo.

Unitevi alla nostra comunità ed esplorate il nostro repository GitHub. Consultate le nostre pagine dedicate alle soluzioni per scoprire le varie applicazioni dell'IA in agricoltura e della visione computerizzata nella sanità. Scoprite le nostre opzioni di licenza e iniziate a costruire il vostro progetto di Vision AI!