Capire la precisione mediamAP) nel rilevamento di oggetti. Imparate il significato, il calcolo e perché mAP è fondamentale per valutare le prestazioni del modello.

Capire la precisione mediamAP) nel rilevamento di oggetti. Imparate il significato, il calcolo e perché mAP è fondamentale per valutare le prestazioni del modello.

L'adozione dell'IA sta crescendo rapidamente e l'IA viene integrata in varie innovazioni, dalle auto a guida autonoma ai sistemi di vendita al dettaglio in grado di identificare i prodotti su uno scaffale. Queste tecnologie si basano sulla computer vision, una branca dell'intelligenza artificiale (IA) che consente alle macchine di analizzare i dati visivi.

Una metrica di valutazione chiave utilizzata per misurare l'accuratezza dei sistemi e degli algoritmi di visione artificiale è la precisione mediamAP). La metrica mAP indica quanto la previsione di un modello di Vision AI corrisponda ai risultati del mondo reale.

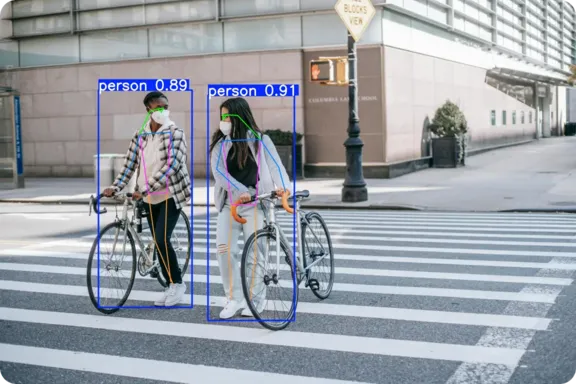

Un compito comune della computer vision è il rilevamento degli oggetti, in cui un modello identifica più oggetti in un'immagine e disegna dei riquadri di delimitazione attorno ad essi. mAP è la metrica standard utilizzata per valutare le prestazioni dei modelli di rilevamento degli oggetti ed è ampiamente utilizzata per effettuare il benchmark di modelli di deep learning come Ultralytics YOLO11.

In questo articolo vedremo come viene calcolata la precisione media media e perché è essenziale per chiunque addestri o valuti modelli di object detection. Iniziamo!

La precisione media media è un punteggio che indica l'accuratezza di un modello di deep learning quando si tratta di attività relative al recupero di informazioni visive, come il rilevamento e l'identificazione di diversi oggetti in un'immagine. Ad esempio, si consideri un modello di object detection che analizza una foto contenente un cane, un gatto e un'auto. Un modello affidabile può eseguire l'object detection riconoscendo ogni oggetto e disegnando bounding box ed etichette attorno ad esso, evidenziando dove si trova e cosa è.

mAP indica la capacità del modello di svolgere questo compito su molte immagini e su diversi tipi di oggetti. Controlla se il modello identifica accuratamente ogni oggetto e la sua posizione all'interno dell'immagine. Il punteggio varia da 0 a 1, dove uno significa che il modello ha trovato tutto perfettamente e zero significa che non ha detect alcun oggetto.

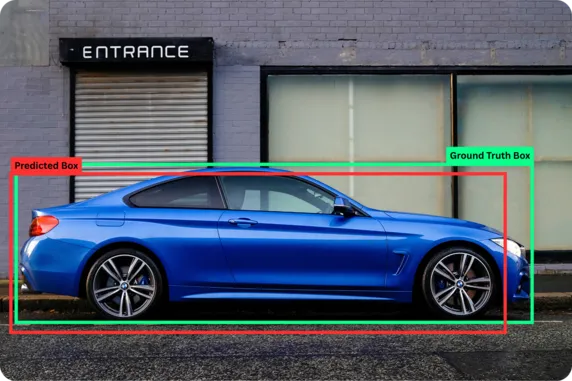

Prima di esplorare i concetti alla base della precisione media media nel machine learning, cerchiamo di capire meglio due termini di base: ground truth e previsioni.

La ground truth si riferisce ai dati di riferimento accurati, in cui gli oggetti e le loro posizioni nell'immagine sono accuratamente etichettati da persone attraverso un processo noto come annotazione. Le predizioni, invece, sono i risultati forniti dai modelli di IA dopo aver analizzato un'immagine. Confrontando le predizioni del modello di IA con la ground truth, possiamo misurare quanto il modello si è avvicinato all'ottenimento dei risultati corretti.

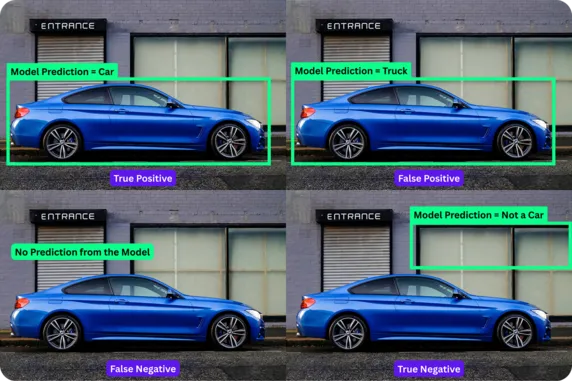

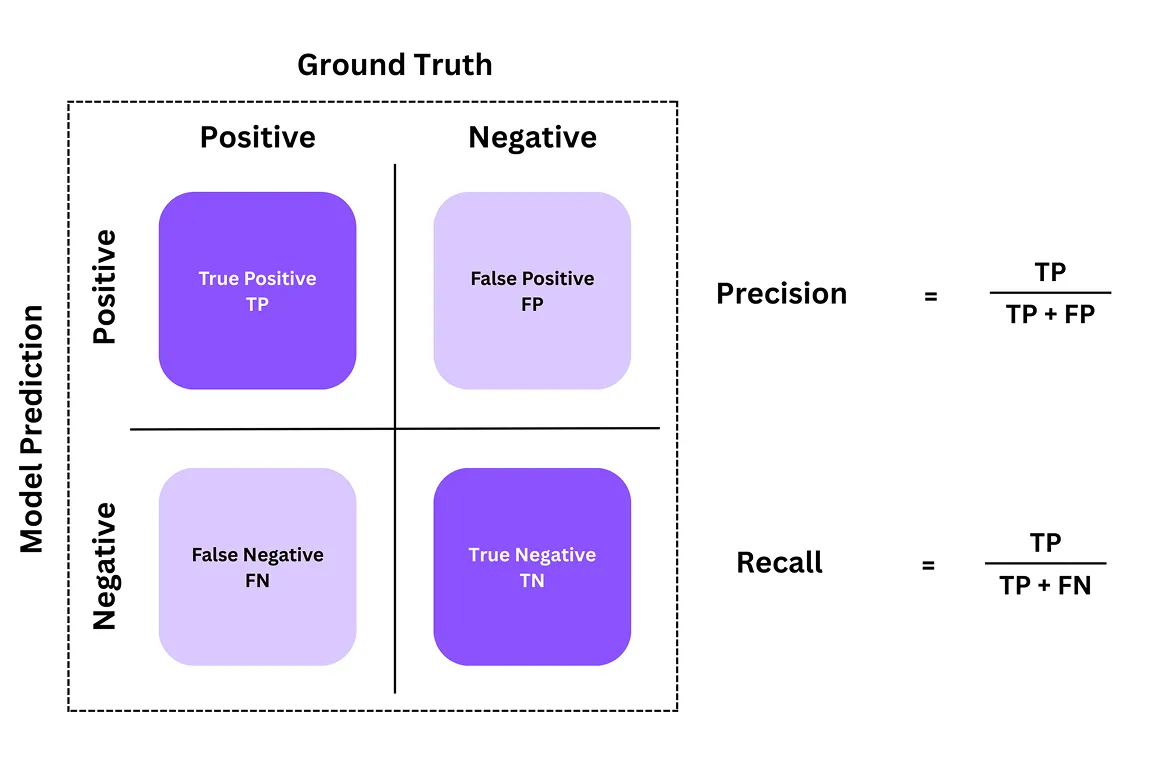

Una matrice di confusione viene spesso utilizzata per capire quanto è preciso un modello di rilevamento oggetti. È una tabella che mostra come le previsioni del modello corrispondono alle risposte corrette effettive (ground truth). Da questa tabella, possiamo ottenere una ripartizione di quattro componenti o risultati chiave: veri positivi, falsi positivi, falsi negativi e veri negativi.

Ecco cosa rappresentano questi componenti nella matrice di confusione:

I veri negativi non sono comunemente utilizzati nel rilevamento degli oggetti, poiché di solito ignoriamo le molte regioni vuote di un'immagine. Tuttavia, è essenziale in altri compiti di computer vision, come la classificazione delle immagini, in cui il modello assegna un'etichetta all'immagine. Per esempio, se il compito è quello di detect se un'immagine contiene o meno un gatto e il modello identifica correttamente "nessun gatto" quando l'immagine non ne contiene, si tratta di un vero negativo.

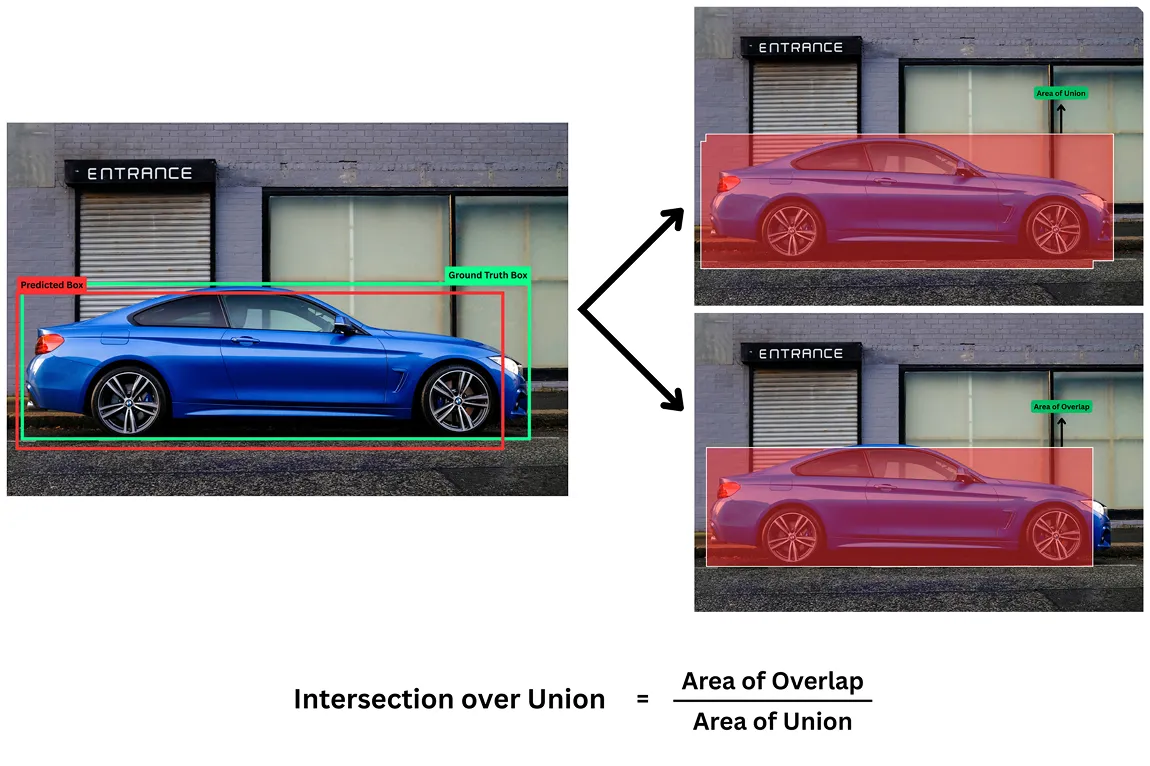

Un'altra metrica fondamentale per valutare i modelli di rilevamento degli oggetti è l' Intersection over UnionIoU). Per questi modelli di Vision AI, il semplice rilevamento della presenza di un oggetto in un'immagine non è sufficiente; è necessario anche individuare la posizione dell'oggetto nell'immagine per disegnare i riquadri di delimitazione.

La metrica IoU misura quanto la casella prevista dal modello corrisponda a quella reale e corretta (verità di base). Il punteggio è compreso tra 0 e 1, dove 1 significa una corrispondenza perfetta e 0 significa nessuna sovrapposizione.

Ad esempio, un IoU più alto (come 0,80 o 0,85) significa che il riquadro previsto è molto simile a quello della verità a terra, indicando una localizzazione accurata. Un IoU più basso (come 0,30 o 0,25) significa che il modello non ha localizzato accuratamente l'oggetto.

Per determinare se un rilevamento è riuscito, utilizziamo diverse soglie. Una soglia IoU comune è 0,5, il che significa che un riquadro previsto deve sovrapporsi al riquadro della verità a terra di almeno il 50% per essere considerato un vero positivo. Qualsiasi sovrapposizione al di sotto di questa soglia è considerata un falso positivo.

Finora, abbiamo esplorato alcune metriche di valutazione di base per comprendere le prestazioni dei modelli di object detection. Partendo da questo, due delle metriche più importanti sono precision e recall. Ci forniscono un quadro chiaro di quanto siano accurate le rilevazioni del modello. Diamo un'occhiata a cosa sono.

I valori di precisione ci dicono quante previsioni del modello sono state effettivamente corrette. Risponde alla domanda: di tutti gli oggetti che il modello ha dichiarato di detect, quanti erano realmente presenti?

I valori di richiamo, invece, misurano la capacità del modello di individuare tutti gli oggetti reali presenti nell'immagine. Risponde alla domanda: di tutti gli oggetti reali presenti, quanti ne ha detect correttamente il modello?

Insieme, precisione e richiamo ci forniscono un quadro più chiaro delle prestazioni di un modello. Ad esempio, se un modello prevede 10 auto in un'immagine e 9 di queste sono effettivamente auto, ha una precisione del 90% (una previsione positiva).

Queste due metriche di valutazione spesso comportano un compromesso: un modello può raggiungere un valore di precisione elevato effettuando solo previsioni di cui è pienamente convinto, ma ciò può fargli perdere molti oggetti, il che riduce il livello di recall. Allo stesso tempo, può anche raggiungere un recall molto elevato prevedendo una bounding box quasi ovunque, ma ciò ridurrebbe la precisione.

Mentre la precisione e il richiamo ci aiutano a capire come si comporta un modello su singole previsioni, la precisione mediaAP) può fornire una visione più ampia. Illustra come cambia la precisione del modello man mano che tenta di detect più oggetti e riassume le sue prestazioni in un unico numero.

Per calcolare il punteggio medio di precisione, possiamo prima creare una metrica combinata simile a un grafico chiamata curva precisione-richiamo (o curva PR) per ogni tipo di oggetto. Questa curva mostra cosa succede quando il modello fa più previsioni.

Si consideri uno scenario in cui il modello inizia a rilevare solo gli oggetti più facili o più evidenti. In questa fase, la precisione è elevata perché la maggior parte delle previsioni sono corrette, ma il richiamo è basso perché molti oggetti vengono ancora tralasciati. Quando il modello cerca di detect un maggior numero di oggetti, compresi quelli più difficili o rari, di solito introduce più errori. Questo fa sì che la precisione diminuisca, mentre il richiamo aumenti.

La precisione media è l'area sotto la curva (AUC della curva PR). Un'area più ampia significa che il modello è in grado di mantenere accurate le sue previsioni, anche quando rileva un numero maggiore di oggetti. L'AP viene calcolata separatamente per ogni etichetta di classe.

Ad esempio, in un modello in grado di detect auto, biciclette e pedoni, possiamo calcolare i valori di AP singolarmente per ciascuna di queste tre categorie. Questo ci aiuta a capire quali sono gli oggetti che il modello è in grado di rilevare e quali invece devono ancora essere migliorati.

Dopo aver calcolato la precisione media per ogni classe di oggetti, abbiamo ancora bisogno di un singolo punteggio che rifletta le prestazioni complessive del modello in tutte le classi. Questo risultato può essere ottenuto con la formula della precisione media . Questa formula calcola la media dei punteggi AP per ogni categoria.

Ad esempio, supponiamo che un modello di computer vision come YOLO11 ottenga un AP di 0,827 per le auto, 0,679 per le moto, 0,355 per i camion, 0,863 per gli autobus e 0,982 per le biciclette. Utilizzando la formula mAP , possiamo sommare questi numeri e dividerli per il numero totale di classi come segue:

mAP = (0,827 + 0,679 + 0,355 + 0,863 + 0,982) ÷ 5 = 0,7432 ≈ 0,743

Il punteggio mAP di 0,743 fornisce una soluzione semplice per giudicare le prestazioni del modello in tutte le classi di oggetti. Un valore vicino a 1 significa che il modello è accurato per la maggior parte delle categorie, mentre un valore inferiore indica che ha difficoltà con alcune.

Ora che abbiamo capito meglio come si calcolano AP e mAP e quali sono i loro componenti, ecco una panoramica del loro significato nella computer vision:

Analizziamo poi come metriche chiave come la mAP possano essere utili nella creazione di casi d'uso reali di computer vision.

Quando si parla di auto a guida autonoma, il rilevamento degli oggetti è fondamentale per identificare pedoni, segnali stradali, ciclisti e segnaletica di corsia. Ad esempio, se un bambino attraversa improvvisamente la strada, l'auto ha pochi secondi per detect l'oggetto (il bambino), individuare la sua posizione, track suo movimento e intraprendere l'azione necessaria (frenare).

Modelli come YOLO11 sono progettati per il rilevamento di oggetti in tempo reale in questi scenari ad alto rischio. In questi casi, la mAP diventa una misura critica di sicurezza.

Un punteggio mAP elevato garantisce che il sistema rilevi rapidamente il bambino, lo localizzi con precisione e attivi la frenata con un ritardo minimo. Un mAP basso può significare mancati rilevamenti o pericolosi errori di classificazione, come il confondere il bambino con un altro piccolo oggetto.

Allo stesso modo, nel retail, i modelli di object detection possono essere utilizzati per automatizzare attività come il monitoraggio delle scorte e i processi di checkout. Quando un cliente scansiona un prodotto presso una cassa self-service, un errore nel rilevamento può causare frustrazione.

Un punteggio mAP elevato assicura che il modello distingua accuratamente tra prodotti simili e disegni riquadri di delimitazione precisi, anche quando gli articoli sono strettamente imballati. Un punteggio mAP basso può portare a confusione. Per esempio, se il modello confonde una bottiglia di succo d'arancia con una bottiglia di succo di mela, visivamente simile, potrebbe causare una fatturazione errata e rapporti di inventario imprecisi.

I sistemi di vendita al dettaglio integrati con modelli come YOLO11 possono detect prodotti in tempo reale, confrontarli con l'inventario e aggiornare istantaneamente i sistemi di back-end. In contesti di vendita al dettaglio frenetici, mAP svolge un ruolo cruciale nel mantenere le operazioni accurate e affidabili.

Il miglioramento dell'accuratezza diagnostica nell'assistenza sanitaria inizia con il rilevamento preciso delle immagini mediche. Modelli come YOLO11 possono aiutare i radiologi a individuare tumori, fratture o altre anomalie dalle scansioni mediche. In questo caso, la precisione media è una metrica essenziale per valutare l'affidabilità clinica di un modello.

Un mAP elevato indica che il modello raggiunge sia un elevato richiamo (identificando il maggior numero di problemi reali) sia un'elevata precisione (evitando i falsi allarmi), che è fondamentale nel processo decisionale clinico. Inoltre, la soglia IoU in ambito sanitario è spesso impostata molto alta (0,85 o 0,90) per garantire un rilevamento estremamente accurato.

Tuttavia, un punteggio mAP basso può destare preoccupazioni. Se il modello non trova un tumore, potrebbe ritardare la diagnosi o portare a un trattamento non corretto.

Ecco i principali vantaggi dell'utilizzo della precisione media (mean average precision) per valutare i modelli di object detection:

Sebbene l'utilizzo della metrica mAP presenti diversi vantaggi, è necessario considerare alcune limitazioni. Ecco alcuni fattori da tenere in considerazione:

Abbiamo visto che la precisione media non è solo un punteggio tecnico, ma un riflesso delle potenziali prestazioni del modello nel mondo reale. Che si tratti di un sistema di veicoli autonomi o di una cassa al dettaglio, un punteggio mAP elevato è un indicatore affidabile delle prestazioni e della praticità di un modello.

Sebbene mAP sia una metrica essenziale e d'impatto, deve essere considerata come parte di una strategia di valutazione a tutto tondo. Per applicazioni critiche come l'assistenza sanitaria e la guida autonoma, non è sufficiente affidarsi esclusivamente al mAP.

È necessario considerare anche fattori aggiuntivi come la velocità di inferenza (la velocità con cui il modello fa previsioni), le dimensioni del modello (che influiscono sulla distribuzione sui dispositivi edge) e l'analisi qualitativa degli errori (la comprensione dei tipi di errori commessi dal modello) per garantire che il sistema sia sicuro, efficiente e realmente adatto allo scopo previsto.

Unisciti alla nostra community in crescita e al nostro repository GitHub per saperne di più sulla computer vision. Esplora le nostre pagine delle soluzioni per scoprire le applicazioni della computer vision in agricoltura e dell'AI nella logistica. Scopri le nostre opzioni di licenza per iniziare subito a utilizzare il tuo modello di computer vision!