Scopri perché Ultralytics è più veloce sull'edge e perché questo è importante per le applicazioni di visione artificiale di nuova generazione che richiedono bassa latenza ed efficienza.

Scopri perché Ultralytics è più veloce sull'edge e perché questo è importante per le applicazioni di visione artificiale di nuova generazione che richiedono bassa latenza ed efficienza.

All'inizio di questa settimana, Ultralytics ha lanciato Ultralytics Ultralytics , un YOLO più veloce, leggero e compatto che mira a ridefinire le prestazioni dei sistemi di visione artificiale all'avanguardia. YOLO26 supporta le stesse attività di visione di base dei precedenti YOLO , tra cui il rilevamento di oggetti e la segmentazione di istanze.

La differenza fondamentale tra YOLO26 e i modelli precedenti è l'ambiente in cui è stato progettato per funzionare. Anziché ottimizzarlo principalmente per le unità di elaborazione grafica (GPU) cloud o per prestazioni basate su benchmark, YOLO26 è stato progettato da zero per l'implementazione nel mondo reale su dispositivi edge e hardware integrato.

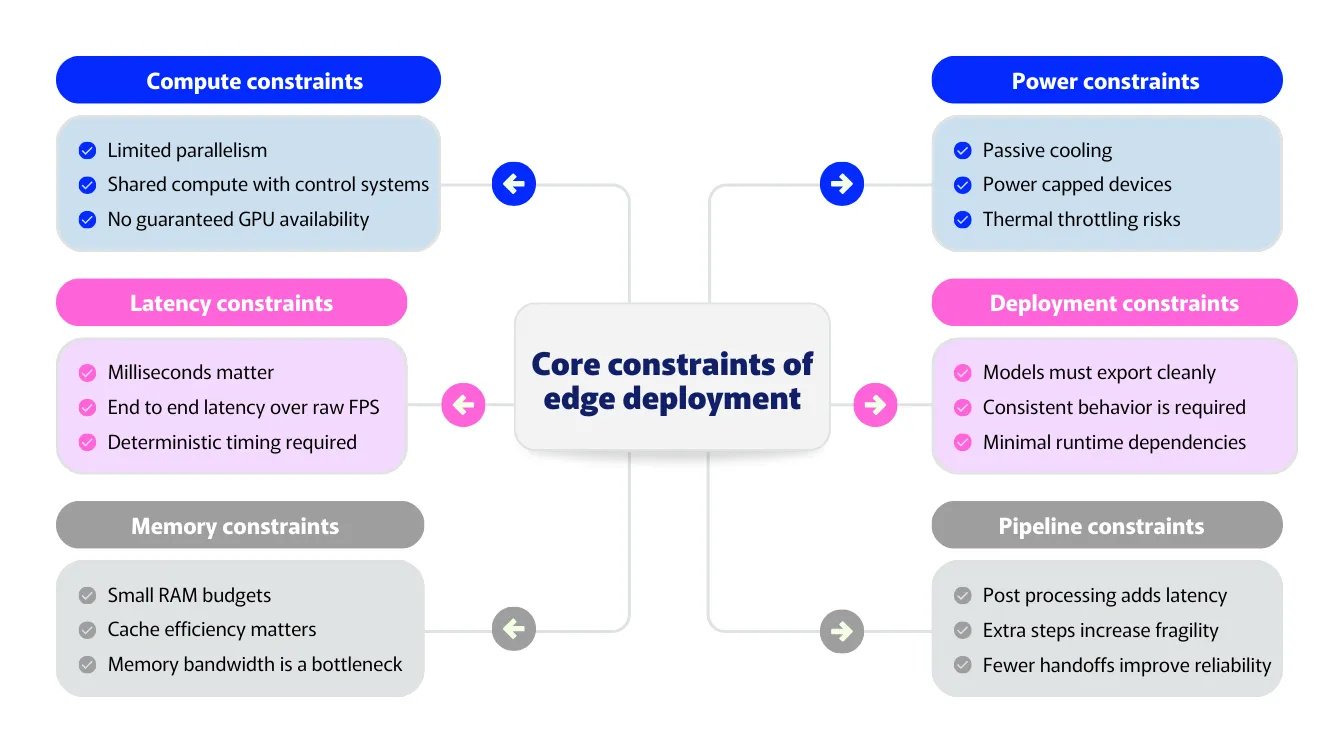

Con il passaggio della visione artificiale dalla ricerca alla produzione, la realtà dei limiti prestazionali sta diventando sempre più evidente. Gli ambienti edge sono caratterizzati da budget di latenza ridotti, memoria limitata, vincoli di alimentazione e termici e dalla necessità di un comportamento prevedibile su piattaforme diverse.

In questi contesti, le prestazioni complessive del sistema dipendono non solo dalla velocità di inferenza grezza, ma anche dall'efficienza con cui opera l'intera pipeline. Il sovraccarico di post-elaborazione, la pressione sulla memoria e i percorsi di esecuzione specifici della piattaforma sono spesso fonte di colli di bottiglia.

YOLO26 affronta queste sfide adottando un approccio più rapido e incentrato sull'edge che considera l'intera pipeline di inferenza anziché le singole metriche del modello. Concentrandosi sull'ottimizzazione dell'edge, semplificando la pipeline di inferenza ed eliminando i passaggi di post-elaborazione non necessari, YOLO26 offre miglioramenti in termini di velocità che si traducono in una minore latenza e un comportamento più affidabile in produzione.

In questo articolo vedremo come le scelte architetturali di YOLO26 si traducono in miglioramenti delle prestazioni nel mondo reale e perché una maggiore velocità ai margini cambia radicalmente le possibilità delle applicazioni di visione artificiale di nuova generazione.

L'esecuzione di modelli di visione artificiale sull'edge è molto diversa dalla loro esecuzione nel cloud. Negli ambienti cloud, i sistemi hanno in genere accesso a GPU potenti, grandi quantità di memoria e hardware stabile. Sull'edge, le stesse ipotesi non sono valide.

La maggior parte delle implementazioni edge funziona su architetture hardware diverse, non su GPU. I dispositivi utilizzano in genere più processori specializzati per diverse attività, ottimizzati per garantire efficienza e basso consumo energetico piuttosto che per la capacità di calcolo grezza delle GPU cloud.

La latenza è un altro vincolo importante. I sistemi edge spesso operano con limiti di tempo in tempo reale molto stretti, dove anche piccoli ritardi possono influire sulla reattività o sulla sicurezza. In questi casi, la latenza end-to-end è più importante della velocità di inferenza grezza. Un modello può essere veloce sulla carta, ma risultare comunque insufficiente una volta aggiunti la post-elaborazione e il trasferimento dei dati.

Anche la memoria gioca un ruolo importante. Molti dispositivi edge hanno una memoria limitata e cache condivise. Tensori intermedi di grandi dimensioni e un utilizzo inefficiente della memoria possono rallentare i sistemi, anche quando il modello stesso è efficiente.

I limiti di potenza e termici aggiungono ulteriori vincoli. I dispositivi edge spesso funzionano senza raffreddamento attivo e con budget energetici fissi. Le prestazioni devono essere efficienti e sostenibili, non solo veloci in brevi raffiche.

Oltre a tutto ciò, le implementazioni edge richiedono coerenza. I modelli devono comportarsi allo stesso modo su tutti i dispositivi e runtime. Il codice specifico della piattaforma o le complesse fasi di post-elaborazione possono introdurre sottili differenze che rendono i sistemi più difficili da implementare e mantenere.

Questi vincoli definiscono il vero significato delle prestazioni ai margini. In altre parole, le prestazioni sono definite dall'intera pipeline, non da un singolo parametro.

In che modo i vincoli dell'implementazione edge sono correlati ai requisiti di un modello di visione artificiale creato per l'edge? Il collegamento diventa chiaro quando i modelli passano dall'ambito della ricerca ai sistemi reali.

Negli ambienti cloud, le prestazioni vengono spesso misurate utilizzando parametri di riferimento quali la velocità e l'accuratezza dell'inferenza. A livello periferico, tali parametri forniscono solo un quadro parziale della situazione. I sistemi di visione funzionano in genere su hardware eterogeneo, dove l'inferenza della rete neurale viene scaricata su acceleratori specializzati, mentre altre parti della pipeline vengono eseguite su processori generici.

In questo contesto, la velocità del modello non è sufficiente. È fondamentale il rendimento dell'intero sistema una volta implementato il modello. Un modello può sembrare veloce di per sé, ma risultare comunque insufficiente se la post-elaborazione, il trasferimento dei dati o le fasi specifiche della piattaforma aggiungono un sovraccarico.

Ecco perché la visione edge richiede un modello prestazionale che si concentri sull'efficienza a livello di sistema piuttosto che su benchmark isolati. YOLO26 riflette questo cambiamento concentrandosi sull'ottimizzazione edge-first, sull'inferenza semplificata e sull'esecuzione end-to-end pensata per l'implementazione nel mondo reale.

All'edge, le prestazioni sono definite dalla capacità di un modello di adattarsi all'architettura hardware effettiva del dispositivo. Progettare prima per l'edge garantisce che i sistemi di visione funzionino in modo affidabile su piattaforme reali, indipendentemente dalla combinazione specifica di unità di elaborazione disponibili.

Un approccio edge-first dà priorità a un'esecuzione prevedibile ed efficiente su hardware eterogeneo, piuttosto che adattare modelli ottimizzati per le GPU cloud a posteriori. In parole povere, ciò significa privilegiare operazioni che si traducono bene in acceleratori di reti neurali, riducendo al minimo il lavoro non neurale al di fuori del modello e riducendo la complessità superflua che può rallentare l'esecuzione end-to-end.

YOLO26 è stato progettato tenendo conto di questi vincoli. La sua architettura punta su prestazioni costanti anziché su un throughput di picco in condizioni ideali. Semplificando i percorsi di esecuzione ed eliminando i calcoli superflui, YOLO26 riduce il sovraccarico lungo tutta la pipeline di inferenza e sfrutta meglio l'accelerazione e la gerarchia di memoria disponibili sul dispositivo.

Questo approccio migliora anche l'affidabilità. L'ottimizzazione edge-first porta a tempi più prevedibili e a un minor numero di picchi di prestazioni, il che è fondamentale per i sistemi in tempo reale. Anziché affidarsi a hardware specializzato o a pesanti post-elaborazioni per ottenere velocità, YOLO26 pone l'accento sull'efficienza lungo tutta la pipeline di inferenza.

Forse vi starete chiedendo cosa significhi eliminare passaggi di post-elaborazione non necessari. Per capirlo, facciamo un passo indietro e vediamo come funzionano i sistemi tradizionali di rilevamento degli oggetti.

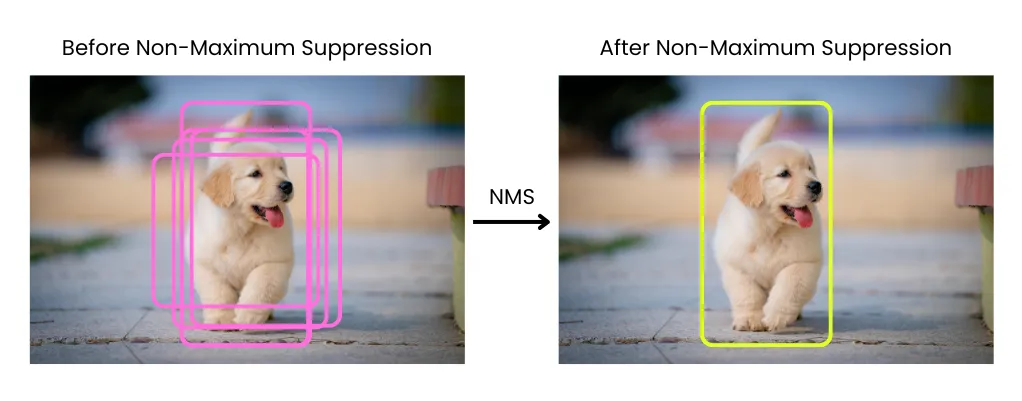

In molte pipeline di rilevamento degli oggetti, l'inferenza non termina quando il modello produce le sue previsioni. Il modello genera invece un gran numero di riquadri di delimitazione sovrapposti, che devono poi essere filtrati e perfezionati prima di poter essere utilizzati. Questa pulizia avviene attraverso fasi di post-elaborazione che vengono eseguite al di fuori del modello stesso.

Una delle fasi di post-elaborazione più comuni è la soppressione non massima, o NMS. NMS i riquadri di delimitazione sovrapposti e mantiene solo i rilevamenti più affidabili, rimuovendo i duplicati che si riferiscono allo stesso oggetto. Sebbene questo approccio sia efficace, introduce un calcolo aggiuntivo dopo il completamento dell'inferenza.

Alla fine, questo lavoro extra ha un costo. Le fasi di post-elaborazione come NMS non NMS adatte agli acceleratori specializzati utilizzati per l'inferenza delle reti neurali, che sono ottimizzati per il calcolo neurale denso piuttosto che per operazioni che richiedono un controllo elevato o un uso intensivo della memoria.

Di conseguenza, NMS ulteriore latenza e sovraccarico di memoria, e il suo costo aumenta con l'aumentare del numero di rilevamenti. Anche quando il modello stesso è veloce, NMS comunque consumare una parte significativa del tempo di esecuzione totale.

La post-elaborazione aumenta anche la complessità del sistema. Poiché risiede al di fuori del modello, deve essere implementata separatamente per diversi runtime e target hardware. Ciò porta spesso a percorsi di codice specifici per piattaforma, comportamenti incoerenti tra i dispositivi e pipeline di distribuzione più fragili.

Ma soprattutto, la post-elaborazione vanifica il concetto di prestazioni end-to-end reali. Misurare la velocità di inferenza del modello non riflette il comportamento del sistema in produzione. Ciò che conta in definitiva è il tempo totale che intercorre tra l'input e l'output finale, compresi tutti i passaggi della pipeline.

In queste situazioni, la post-elaborazione diventa un collo di bottiglia nascosto ai margini. Aumenta la latenza, consuma CPU e complica l'implementazione, il tutto rimanendo al di fuori del modello stesso.

YOLO26 elimina NMS affrontando la causa principale dei rilevamenti duplicati anziché eliminarli dopo l'inferenza. Anziché produrre molte previsioni sovrapposte che devono essere filtrate, il modello viene addestrato per generare direttamente un insieme più piccolo di rilevamenti finali affidabili.

Ciò è reso possibile modificando il modo in cui vengono apprese le rilevazioni durante l'addestramento. YOLO26 favorisce una relazione uno a uno più chiara tra oggetti e previsioni, riducendo la ridondanza alla fonte. Di conseguenza, le rilevazioni duplicate vengono risolte all'interno della rete stessa piuttosto che attraverso una post-elaborazione esterna.

La rimozione NMS un impatto immediato sulle prestazioni edge. Poiché NMS si adatta bene agli acceleratori di reti neurali, la sua eliminazione riduce il movimento della memoria ed evita costose fasi di elaborazione non neurale. Ciò riduce la latenza end-to-end e rende le prestazioni più prevedibili, soprattutto sui dispositivi edge dove la post-elaborazione può altrimenti consumare una parte significativa del tempo di esecuzione totale.

Inoltre semplifica il processo di inferenza. Con un minor numero di passaggi al di fuori del modello, vi è meno movimento di dati e meno passaggi tra i componenti. L'output del modello è già il risultato finale, il che rende l'esecuzione più prevedibile.

Un'altra innovazione di YOLO26 è la rimozione della Distribution Focal Loss, o DFL, che era stata utilizzata nei precedenti YOLO per la regressione dei bounding box. Anziché prevedere direttamente una singola coordinata, i modelli che utilizzavano la DFL apprendevano una distribuzione dei valori possibili e poi derivavano un bounding box finale da tale distribuzione. Questo approccio ha contribuito a migliorare la precisione della localizzazione e ha rappresentato un importante passo avanti rispetto alle generazioni precedenti.

Nel corso del tempo, tuttavia, il DFL ha anche introdotto dei compromessi. La previsione delle distribuzioni aumenta la complessità dell'architettura del modello e richiede maggiori calcoli, il che può rallentare l'inferenza sulle CPU e rendere più difficile l'esportazione dei modelli in diversi formati di distribuzione. Il DFL ha anche imposto intervalli di regressione fissi, che potrebbero limitare la flessibilità nel rilevare oggetti di grandi dimensioni.

YOLO26 elimina il DFL come parte della sua transizione verso un design più semplice e end-to-end. La regressione del bounding box è stata riprogettata per essere più diretta, riducendo i calcoli superflui e mantenendo la precisione. Questa modifica è in linea con l'approccio NMS di YOLO26.

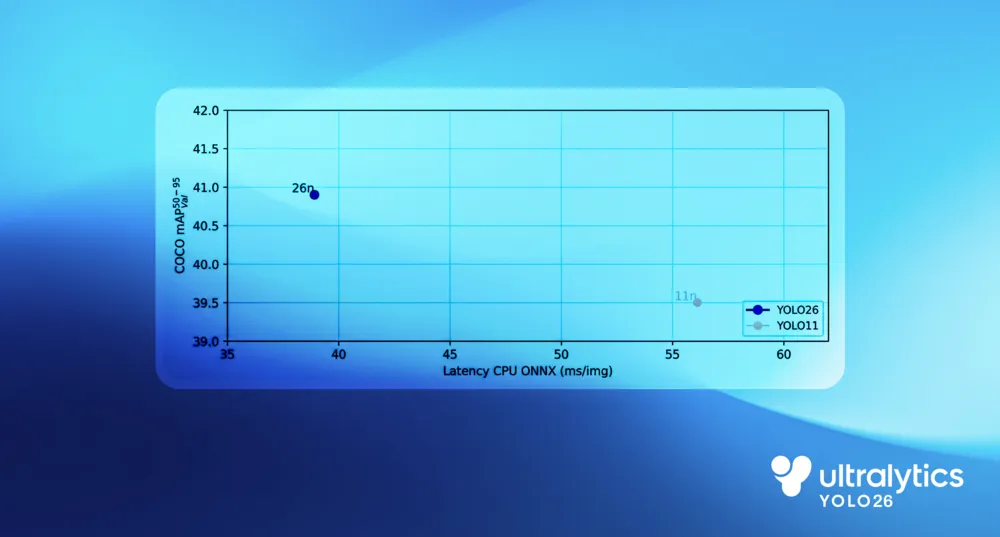

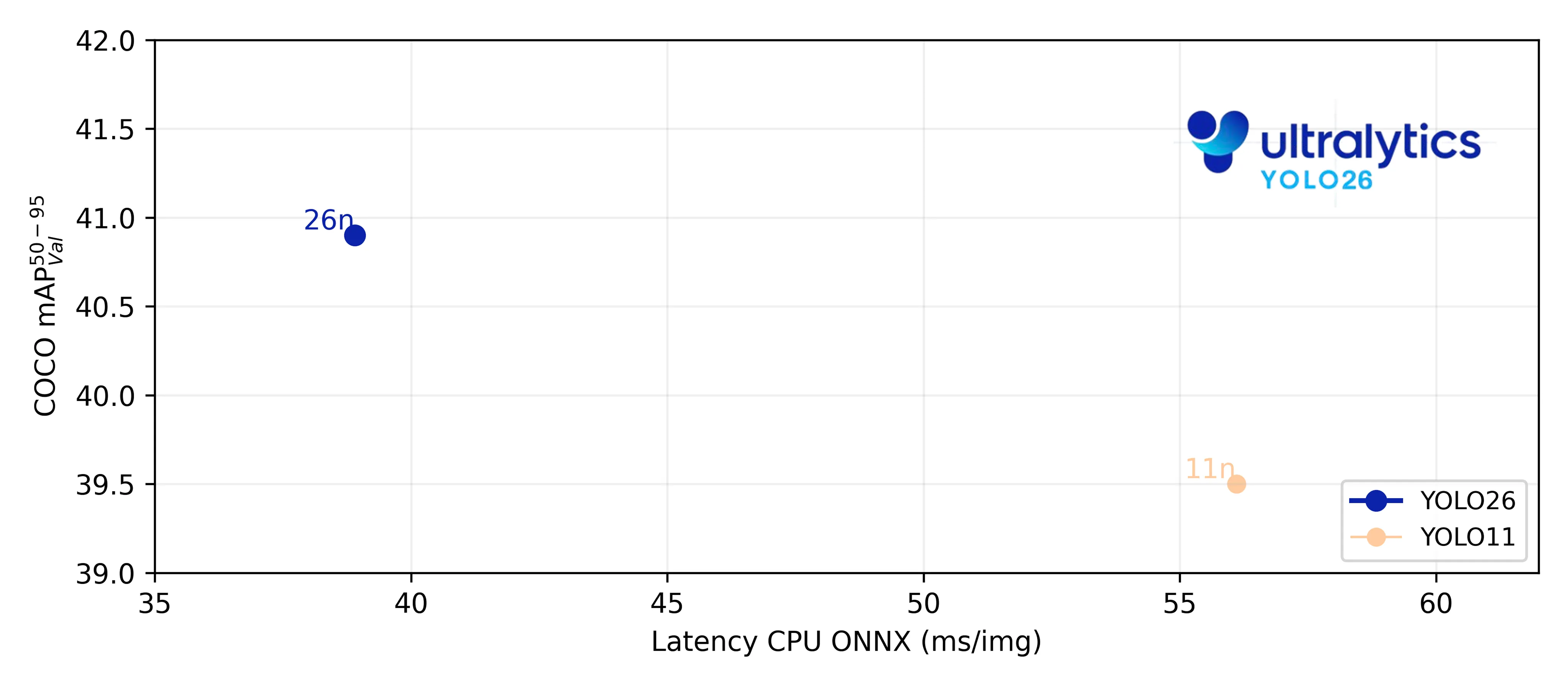

Nei benchmark CPU, YOLO26 mostra un netto miglioramento delle prestazioni rispetto YOLO precedenti YOLO . Rispetto a Ultralytics YOLO11, il modello nano YOLO26 offre CPU fino al 43% più veloce, una differenza che ha un impatto significativo nelle implementazioni edge nel mondo reale.

Questo vantaggio deriva dalla semplificazione dell'intera pipeline di inferenza piuttosto che dall'ottimizzazione di un singolo componente. L'esecuzione end-to-end elimina il sovraccarico di post-elaborazione, un metodo di regressione del bounding box più diretto riduce il calcolo e le scelte di progettazione CPU migliorano l'efficienza di esecuzione sui processori generici.

Insieme, queste modifiche riducono la latenza, diminuiscono CPU e garantiscono prestazioni più veloci e costanti sull'hardware edge reale.

I vantaggi prestazionali di YOLO26 vanno oltre una maggiore velocità di inferenza. Grazie alla semplificazione del modello e alla riduzione dell'overhead di memoria, diventa più facile da implementare e più affidabile da eseguire in ambienti edge.

Il design end-to-end di YOLO26 semplifica anche l'esportazione. Con un numero inferiore di componenti ausiliari e nessuna fase di post-elaborazione esterna, i modelli esportati sono completamente autonomi. Ciò riduce le dipendenze specifiche della piattaforma e contribuisce a garantire un comportamento coerente tra i runtime e gli obiettivi hardware.

In pratica, ciò significa che YOLO26 può essere implementato più facilmente su dispositivi edge quali telecamere, robot e sistemi integrati, utilizzando vari formati di esportazione. Ciò che esporti è ciò che esegui, con meno passaggi di integrazione e meno rischi di deviazioni nell'implementazione.

Finora abbiamo visto come il design edge-first di YOLO26 migliori le prestazioni a livello di sistema. Il vero impatto, tuttavia, risiede nel modo in cui rende più facile l'integrazione dell'IA visiva nelle applicazioni del mondo reale.

Ad esempio, nella robotica e negli ambienti industriali, i sistemi di visione operano spesso con rigidi vincoli in tempo reale. Le decisioni devono essere prese in modo rapido e coerente, utilizzando risorse di calcolo limitate e senza fare affidamento sulla connettività cloud. Con Ultralytics , soddisfare questi requisiti diventa pratico.

Applicazioni come la navigazione robotica e la manipolazione di oggetti traggono vantaggio da una latenza inferiore e da un'inferenza più prevedibile, consentendo ai robot di rispondere in modo fluido ai cambiamenti nell'ambiente circostante. Analogamente, in ambito industriale, i modelli di visione possono essere eseguiti direttamente sulle linee di produzione per detect , track e monitorare i processi senza introdurre ritardi o complessità aggiuntive.

Consentendo un'inferenza veloce e affidabile sull'hardware edge, YOLO26 contribuisce a rendere la Vision AI una parte naturale della robotica e dei sistemi industriali, anziché una sfida da implementare e mantenere.

YOLO26 è stato progettato per l'edge, dove vincoli reali come latenza, memoria e affidabilità definiscono ciò che è possibile fare. Progettando il modello intorno all'esecuzione CPU, all'inferenza end-to-end e a un'implementazione più semplice, YOLO26 rende l'integrazione dell'IA visiva nei sistemi reali una realtà pratica. Questo approccio edge-first consente un'ampia gamma di applicazioni, dalla robotica e dalla visione industriale all'IA integrata e on-device, dove le prestazioni e la prevedibilità sono fondamentali.

Unitevi alla nostra comunità in crescita ed esplorate il nostro repository GitHub per trovare risorse pratiche sull'intelligenza artificiale. Per costruire con Vision AI oggi, esplorate le nostre opzioni di licenza. Per scoprire come l 'IA in agricoltura sta trasformando l'agricoltura e come Vision AI nella sanità sta plasmando il futuro, visitate le nostre pagine dedicate alle soluzioni.