Esplora la segmentazione concettuale promptabile, in che modo differisce dai metodi tradizionali e come modelli correlati come YOLOE-26 consentono funzionalità a vocabolario aperto.

Esplora la segmentazione concettuale promptabile, in che modo differisce dai metodi tradizionali e come modelli correlati come YOLOE-26 consentono funzionalità a vocabolario aperto.

La visione artificiale sta avanzando rapidamente e viene ampiamente utilizzata per analizzare immagini e video in ambienti reali. Ad esempio, applicazioni che vanno dai sistemi di gestione del traffico all'analisi dei dati di vendita al dettaglio vengono integrate con modelli di visione artificiale.

In molte di queste applicazioni, i modelli di visione, come i modelli di rilevamento degli oggetti, vengono addestrati a riconoscere un insieme predefinito di oggetti, tra cui veicoli, persone e attrezzature. Durante l'addestramento, a questi modelli vengono mostrati molti esempi etichettati in modo che possano imparare come appare ogni oggetto e come distinguerlo dagli altri in una scena.

Per le attività di segmentazione, i modelli fanno un ulteriore passo avanti producendo contorni precisi a livello di pixel attorno a questi oggetti. Ciò consente ai sistemi di capire esattamente dove si trova ogni oggetto in un'immagine.

Questo funziona bene fintanto che il sistema deve solo riconoscere ciò su cui è stato addestrato. Tuttavia, negli ambienti reali, questo è raramente il caso.

Le scene visive sono tipicamente dinamiche. Appaiono nuovi oggetti e concetti visivi, le condizioni cambiano e gli utenti spesso desiderano segment che non facevano parte della configurazione di addestramento originale.

Questi limiti sono particolarmente evidenti quando si parla di segmentazione. Con la continua evoluzione della Vision AI, cresce la necessità di modelli di segmentazione più flessibili, in grado di adattarsi a nuovi concetti senza richiedere ripetuti processi di riqualificazione. Ecco perché la segmentazione concettuale promptabile (PCS) sta attirando sempre più attenzione.

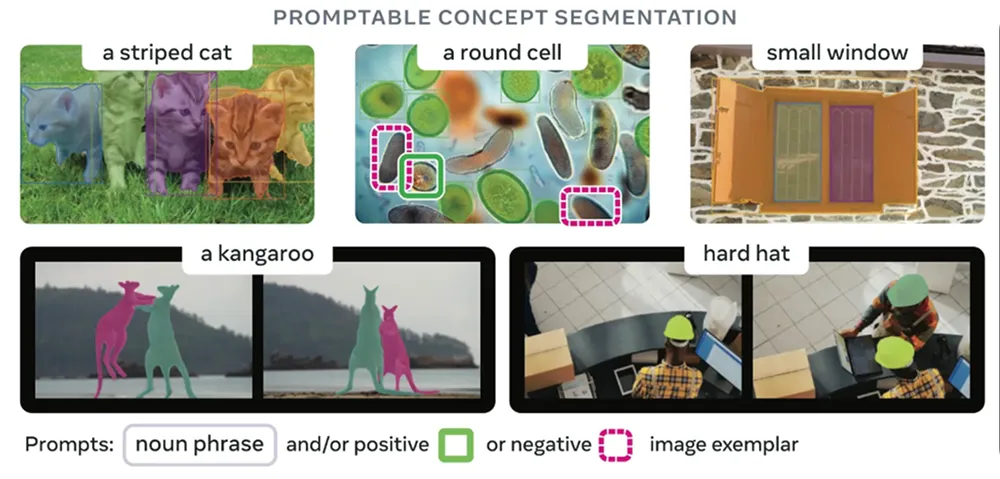

Anziché affidarsi a un elenco fisso di categorie di oggetti, gli utenti possono descrivere ciò che desiderano segment testo, suggerimenti visivi o immagini di esempio. Questi modelli sono quindi in grado di identificare e segment le regioni che corrispondono al concetto descritto, anche se tale concetto non è stato esplicitamente incluso durante l'addestramento.

In questo articolo vedremo come funziona la segmentazione dei concetti promptable, in che modo si differenzia dagli approcci tradizionali e dove viene utilizzata oggi.

Nella maggior parte dei casi, i modelli di segmentazione vengono addestrati per riconoscere un breve elenco di tipi di oggetti. Ciò funziona bene quando un sistema di intelligenza artificiale visiva deve solo detect segment insieme specifico di oggetti.

Nelle applicazioni reali, tuttavia, le scene visive sono dinamiche. Appaiono nuovi oggetti, i requisiti delle attività cambiano e gli utenti spesso devono segment che non erano inclusi nel set di etichette originale. Supportare queste situazioni significa in genere raccogliere nuovi dati e annotazioni di alta qualità e riqualificare il modello, il che aumenta i costi e rallenta l'implementazione.

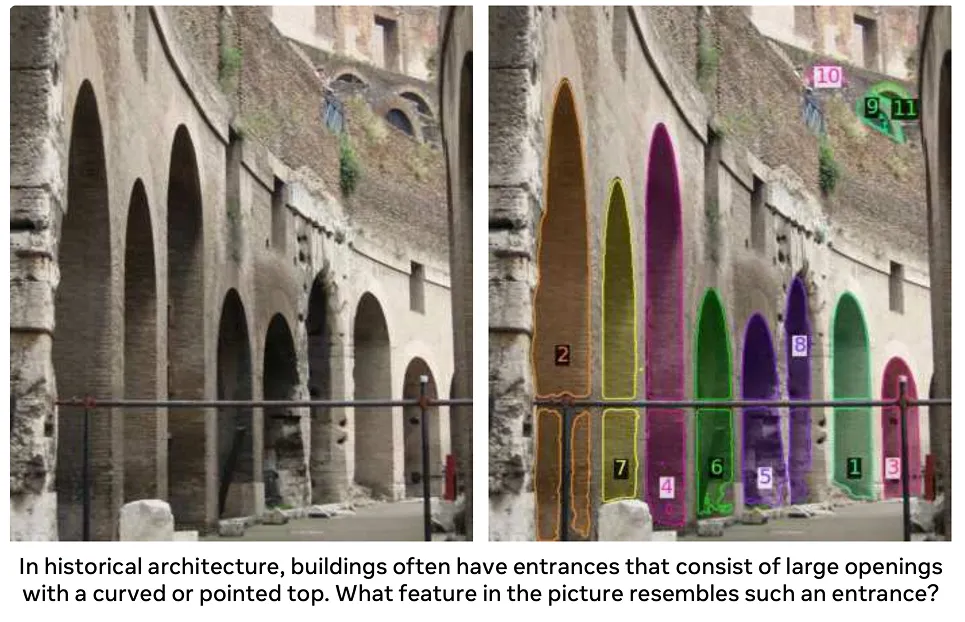

La segmentazione concettuale promptabile risolve questo problema consentendo agli utenti di indicare al modello cosa cercare invece di scegliere da un elenco fisso di etichette. Gli utenti descrivono l'oggetto o l'idea che stanno cercando e il modello evidenzia tutte le aree corrispondenti nell'immagine. Ciò rende molto più facile collegare l'intenzione dell'utente ai pixel effettivi di un'immagine.

I modelli che supportano la segmentazione dei concetti promptable sono flessibili perché possono accettare diversi tipi di input. In altre parole, esiste più di un modo per indicare al modello cosa cercare, ad esempio tramite descrizioni testuali, suggerimenti visivi o immagini di esempio.

Ecco uno sguardo più da vicino a ciascun approccio:

Prima di approfondire il funzionamento della segmentazione concettuale promptabile, confrontiamola con i vari metodi tradizionali di segmentazione degli oggetti.

PCS consente modelli con vocabolario aperto e basati su prompt. È in grado di lavorare con nuove idee descritte tramite prompt, cosa che la segmentazione tradizionale non può fare. Esistono diversi tipi di approcci di segmentazione tradizionali, ciascuno con le proprie ipotesi e limitazioni.

Ecco una panoramica di alcuni tipi fondamentali di segmentazione tradizionale:

Tutti questi approcci si basano su un elenco predefinito di categorie di oggetti. Funzionano bene all'interno di tale ambito, ma non gestiscono molto bene i concetti al di fuori di esso. Quando è necessario segmentare un nuovo oggetto specifico, di solito sono necessari ulteriori dati di addestramento e una messa a punto del modello.

PCS mira a cambiare questa situazione. Anziché essere vincolato a categorie predefinite, consente di descrivere ciò che si desidera segment un'immagine al momento dell'inferenza.

Passiamo ora ad analizzare come i modelli di segmentazione si sono evoluti verso la segmentazione concettuale promptable.

Un modello di base molto diffuso che ha segnato un cambiamento nella segmentazione è stato SAM, ovvero il modello Segment Anything Model. È stato introdotto nel 2023. Invece di basarsi su categorie di oggetti predefinite, SAM agli utenti di guidare la segmentazione utilizzando semplici prompt visivi come punti o riquadri di delimitazione.

Con SAM, gli utenti non dovevano più selezionare un'etichetta. Bastava semplicemente indicare dove si trovava un oggetto e il modello generava una maschera per esso. Ciò rendeva la segmentazione più flessibile, ma gli utenti dovevano comunque mostrare al modello dove guardare.

SAM , rilasciato nel 2024, ha sviluppato questa idea gestendo scene più complesse ed estendendo la segmentazione guidata ai video. Ha migliorato la robustezza in diverse condizioni di illuminazione, forme degli oggetti e movimenti, pur continuando a basarsi principalmente su prompt visivi per guidare la segmentazione.

Il modello SAM è l'ultimo passo di questa evoluzione. È stato lanciato lo scorso anno ed è un modello unificato che combina la comprensione visiva con la guida linguistica, consentendo un comportamento coerente nelle attività di segmentazione di immagini e video.

Con SAM , gli utenti non sono limitati a puntare o disegnare suggerimenti. Possono invece descrivere ciò che desiderano segment del testo, e il modello ricerca nell'immagine o nei fotogrammi video le regioni che corrispondono a tale descrizione.

La segmentazione è guidata da concetti piuttosto che da categorie di oggetti fisse, supportando l'uso di un vocabolario aperto in scenari diversi e nel tempo. Infatti, SAM opera su un ampio spazio concettuale appreso che si basa su un'ontologia derivata da fonti come Wikidata e ampliata attraverso dati di addestramento su larga scala.

Rispetto alle versioni precedenti che si basavano principalmente su prompt geometrici, SAM rappresenta un passo avanti verso una segmentazione più flessibile e basata sui concetti. Ciò lo rende più adatto alle applicazioni del mondo reale, dove gli oggetti o le idee di interesse possono cambiare e non sempre possono essere definiti in anticipo.

Come funziona la segmentazione dei concetti promptable? Si basa su modelli di visione e linguaggio visivo preaddestrati su larga scala, ovvero modelli addestrati su enormi raccolte di immagini e, in molti casi, su testi abbinati. Questo addestramento consente loro di apprendere modelli visivi generali e significati semantici.

La maggior parte dei modelli PCS utilizza architetture basate su trasformatori, che elaborano un'intera immagine in una sola volta per comprendere come le diverse regioni sono correlate tra loro. Un trasformatore visivo estrae le caratteristiche visive dall'immagine, mentre un codificatore di testo converte le parole in rappresentazioni numeriche con cui il modello può lavorare.

Durante l'addestramento, questi modelli possono apprendere da diversi tipi di supervisione, tra cui maschere a livello di pixel che definiscono i confini esatti degli oggetti, riquadri di delimitazione che individuano approssimativamente gli oggetti ed etichette a livello di immagine che descrivono ciò che appare in un'immagine. L'addestramento utilizzando diversi tipi di dati etichettati aiuta il modello a catturare sia i dettagli più fini che i concetti visivi più ampi.

Al momento dell'inferenza, ovvero quando il modello viene effettivamente utilizzato per effettuare previsioni, PCS segue un processo guidato da prompt. L'utente fornisce indicazioni tramite descrizioni testuali, suggerimenti visivi come punti o riquadri o immagini di esempio. Il modello codifica sia il prompt che l'immagine in una rappresentazione interna condivisa o in embedding e identifica le regioni che corrispondono al concetto descritto.

Un decodificatore di maschere converte quindi questa rappresentazione condivisa in maschere di segmentazione precise a livello di pixel. Poiché il modello collega le caratteristiche visive al significato semantico, è in grado di segment concetti anche se questi non sono stati esplicitamente inclusi durante l'addestramento.

Inoltre, spesso è possibile perfezionare il risultato modificando il prompt o aggiungendo ulteriori indicazioni, aiutando così il modello a gestire scene complesse o ambigue. Questo processo iterativo supporta l'ottimizzazione pratica durante l'implementazione.

I modelli di segmentazione concettuale promptable vengono in genere valutati in base alla loro capacità segment concetti mai visti segment e alla loro robustezza in scene diverse. I benchmark si concentrano spesso sulla qualità della maschera, sulla generalizzazione e sull'efficienza computazionale, riflettendo i requisiti di implementazione nel mondo reale.

Vediamo ora dove viene già utilizzata la segmentazione dei concetti promptable e dove sta iniziando ad avere un impatto reale.

L'imaging medico coinvolge molte strutture biologiche, malattie e tipi di scansione, e ogni giorno si presentano nuovi casi. I modelli di segmentazione tradizionali faticano a stare al passo con questa varietà.

Il PCS si inserisce naturalmente in questo spazio perché consente ai medici di descrivere ciò che desiderano trovare invece di scegliere da un elenco breve e rigido. Con frasi di testo o suggerimenti visivi, il PCS può essere utilizzato per segment direttamente segment o aree di interesse, senza dover riqualificare il modello per ogni nuova attività. Ciò semplifica la gestione delle diverse esigenze cliniche, riduce la necessità di disegnare manualmente maschere e funziona con molti tipi di immagini.

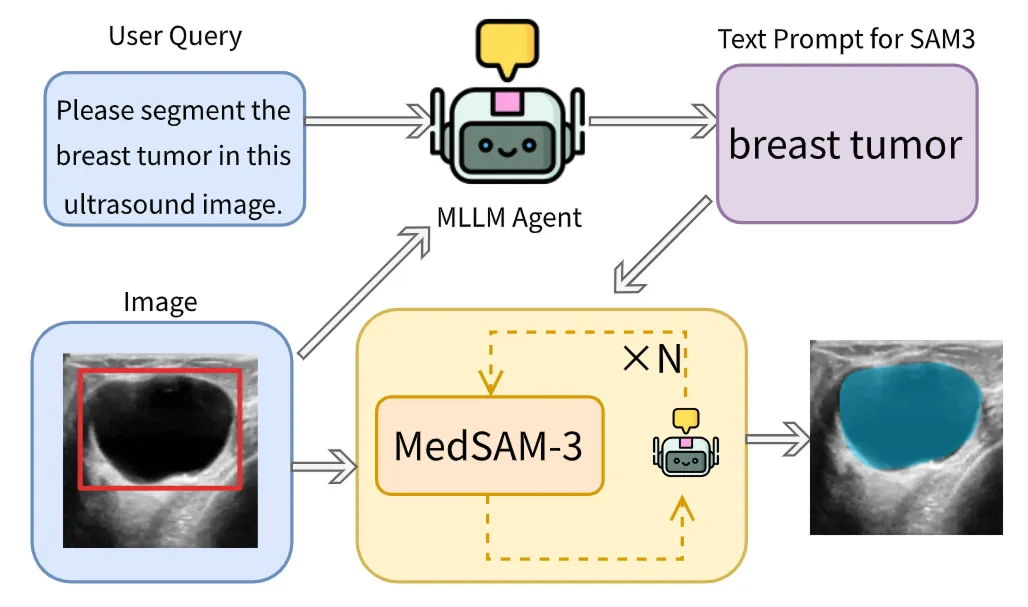

Un ottimo esempio è MedSAM-3, che adatta l'architettura SAM per PCS con prompt testuali nell'imaging medico. Questo modello può essere sollecitato con termini anatomici e patologici espliciti, come nomi di organi quali fegato o rene e concetti relativi alle lesioni quali tumore o lesione. A fronte di un prompt, il modello segmenta direttamente la regione corrispondente nell'immagine medica.

MedSAM-3 integra anche modelli linguistici multimodali di grandi dimensioni (MLLM o LLM multimodali), in grado di elaborare sia testi che immagini. Questi modelli operano in una configurazione agent-in-the-loop, in cui i risultati vengono perfezionati in modo iterativo per migliorare la precisione nei casi più complessi.

MedSAM-3 offre ottime prestazioni con dati provenienti da radiografie, risonanza magnetica, TAC, ecografie e video, dimostrando come il PCS possa rendere più flessibili ed efficienti i flussi di lavoro di imaging medico in contesti clinici reali.

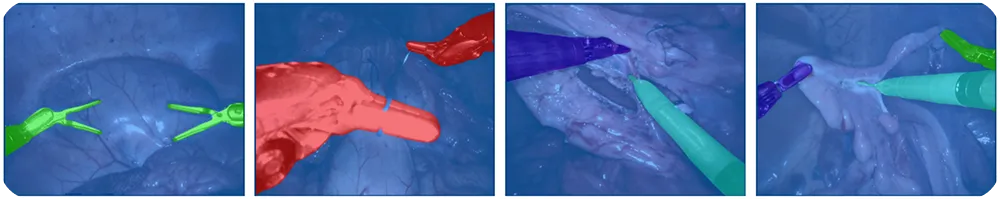

La chirurgia robotica si affida a sistemi di visione per track e comprendere scene chirurgiche in rapida evoluzione. Gli strumenti si muovono rapidamente, l'illuminazione varia e nuovi strumenti possono comparire in qualsiasi momento, rendendo difficile mantenere sistemi di etichettatura predefiniti.

Con il PCS, i robot possono track , guidare le telecamere e seguire le fasi chirurgiche in tempo reale. Ciò riduce l'etichettatura manuale e rende i sistemi più facili da adattare alle diverse procedure. I chirurghi o i sistemi automatizzati possono utilizzare suggerimenti testuali come "pinza", "bisturi" o "telecamera" per indicare cosa deve essere segmentato in un'immagine.

Un altro modello all'avanguardia interessante relativo alla segmentazione dei concetti promptable è il nostro Ultralytics . Il nostro modello introduce la segmentazione a vocabolario aperto e guidata da prompt nella famigliaYOLO Ultralytics YOLO .

YOLOE-26 è basato sull'architettura Ultralytics e supporta la segmentazione delle istanze a vocabolario aperto. YOLOE-26 consente agli utenti di guidare la segmentazione in diversi modi.

Supporta prompt testuali, in cui brevi frasi visivamente fondate possono specificare l'oggetto di destinazione, nonché prompt visivi, che forniscono ulteriori indicazioni basate su segnali visivi. Inoltre, YOLOE-26 include una modalità senza prompt per l'inferenza zero-shot, in cui il modello rileva e segmenta gli oggetti da un vocabolario integrato senza richiedere prompt da parte dell'utente.

YOLOE-26 è ideale per applicazioni quali analisi video, percezione robotica e sistemi basati su edge, in cui le categorie di oggetti possono cambiare ma la bassa latenza e l'affidabilità della velocità di trasmissione rimangono essenziali. È particolarmente utile anche per l'etichettatura dei dati e la curatela dei set di dati, poiché semplifica i flussi di lavoro automatizzando parti del processo di annotazione.

Ecco alcuni dei principali vantaggi dell'utilizzo della segmentazione concettuale promptabile:

Sebbene il PCS presenti evidenti vantaggi, è opportuno considerare alcune limitazioni:

Mentre esplori la segmentazione promptable, potresti chiederti per quali applicazioni sia più adatta e quando un modello di visione artificiale tradizionale come YOLO26 sia più indicato per il problema che stai cercando di risolvere. La segmentazione promptable funziona bene per oggetti generici, ma non è adatta per casi d'uso che richiedono risultati molto precisi e coerenti.

Il rilevamento dei difetti è un ottimo esempio. Nel settore manifatturiero, i difetti sono spesso minuscoli e impercettibili, come piccoli graffi, ammaccature, disallineamenti o irregolarità superficiali. Possono anche variare notevolmente a seconda dei materiali, dell'illuminazione e delle condizioni di produzione.

Questi problemi sono difficili da descrivere con un semplice prompt e ancora più difficili da detect per un modello generico. Nel complesso, i modelli basati su prompt tendono a non rilevare i difetti o a produrre risultati instabili, mentre i modelli addestrati specificamente sui dati relativi ai difetti sono molto più affidabili per i sistemi di ispezione reali.

La segmentazione concettuale promptabile rende i sistemi di visione più facili da adattare al mondo reale, dove nuovi oggetti e idee compaiono continuamente. Invece di essere vincolati a etichette fisse, gli utenti possono semplicemente descrivere ciò che desiderano segment lasciare che il modello faccia il resto, risparmiando tempo e riducendo il lavoro manuale. Sebbene presenti ancora alcune limitazioni, il PCS sta già cambiando il modo in cui la segmentazione viene utilizzata nella pratica e probabilmente diventerà una parte fondamentale dei futuri sistemi di visione.

Scopri di più sull'IA visitando il nostro repository GitHub e unendoti alla nostra community. Consulta le nostre pagine dedicate alle soluzioni per saperne di più sull'IA nella robotica e sulla visione artificiale nella produzione. Scopri le nostre opzioni di licenza per iniziare subito a utilizzare Vision AI!