Applicazioni del Segment Anything Model 2 di Meta AISAM 2)

Unisciti a noi per approfondire il Segment Anything Model 2SAM 2) di Meta AI e capire per quali applicazioni in tempo reale può essere utilizzato in vari settori.

Unisciti a noi per approfondire il Segment Anything Model 2SAM 2) di Meta AI e capire per quali applicazioni in tempo reale può essere utilizzato in vari settori.

Il 29 luglio 2024, Meta AI ha rilasciato la seconda versione del suo Segment Anything Model, SAM 2. Il nuovo modello è in grado di individuare i pixel di un oggetto in un'immagine o in un video. Il nuovo modello è in grado di individuare i pixel che appartengono a un oggetto target sia nelle immagini che nei video! La cosa migliore è che il modello è in grado di seguire costantemente un oggetto in tutti i fotogrammi di un video in tempo reale. SAM 2 apre interessanti possibilità per l'editing video, le esperienze di realtà mista e una più rapida annotazione dei dati visivi per l'addestramento dei sistemi di visione artificiale.

Sulla base del successo del SAM originale, utilizzato in settori quali le scienze marine, le immagini satellitari e la medicina, SAM 2 affronta sfide quali gli oggetti in rapido movimento e i cambiamenti di aspetto. L'accuratezza e l'efficienza migliorate lo rendono uno strumento versatile per un'ampia gamma di applicazioni. In questo articolo ci concentreremo sui campi di applicazione diSAM 2 e sui motivi per cui è importante per la comunità dell'intelligenza artificiale.

Il Segment Anything Model 2 è un modello di base avanzato che supporta la segmentazione visiva a comando o PVS sia nelle immagini che nei video. PVS è una tecnica in cui un modello può segment o identificare diverse parti di un'immagine o di un video in base a specifiche richieste o input forniti dall'utente. Queste indicazioni possono essere sotto forma di clic, caselle o maschere che evidenziano l'area di interesse. Il modello genera quindi una maschera di segmentazione che delinea l'area specificata.

L'architettura di SAM 2 si basa sul SAM originale, ampliando la segmentazione delle immagini per includere anche la segmentazione video. È dotato di un decodificatore di maschere leggero che utilizza i dati dell'immagine e le richieste per creare maschere di segmentazione. Per i video, SAM 2 introduce un sistema di memoria che consente di ricordare le informazioni dei fotogrammi precedenti, garantendo un tracciamento accurato nel tempo. Il sistema di memoria comprende componenti che memorizzano e richiamano dettagli sugli oggetti da segmentare. SAM 2 è anche in grado di gestire le occlusioni, di track oggetti attraverso più fotogrammi e di gestire le richieste ambigue generando diverse possibili maschere. L'architettura avanzata di SAM 2 lo rende altamente capace in ambienti visivi sia statici che dinamici.

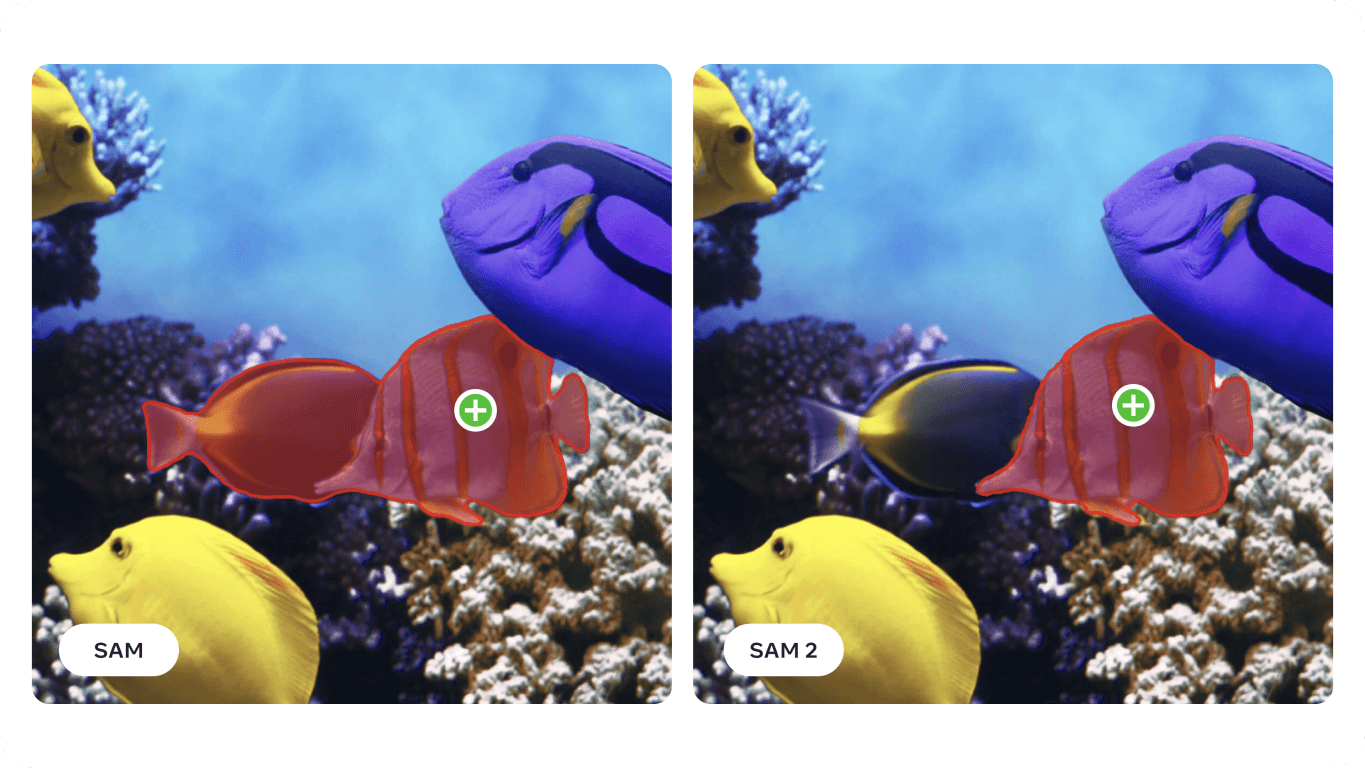

In particolare, per quanto riguarda la segmentazione dei video, SAM 2 raggiunge una maggiore precisione con un numero di interazioni con l'utente tre volte inferiore rispetto ai metodi precedenti. Per quanto riguarda la segmentazione delle immagini, SAM 2 supera il Segment Anything Model (SAM) originale, risultando sei volte più veloce e più preciso. Questo miglioramento è stato illustrato nel documento di ricerca SAM 2 su 37 diversi set di dati, tra cui 23 su cui SAM era stato precedentemente testato.

È interessante notare che SAM 2 di Meta AI è stato sviluppato creando il più grande set di dati di segmentazione video fino ad oggi, il set di dati SA-V. Questo ampio set di dati comprende oltre 50.000 video e 35,5 milioni di maschere di segmentazione ed è stato raccolto grazie ai contributi interattivi degli utenti. Gli annotatori hanno fornito suggerimenti e correzioni per aiutare il modello ad apprendere da un'ampia varietà di scenari e tipi di oggetti.

Grazie alle sue avanzate capacità di segmentazione di immagini e video, SAM 2 può essere utilizzato in diversi settori. Esploriamo alcune di queste applicazioni.

Il nuovo modello di segmentazione di Meta AI può essere utilizzato per applicazioni di realtà aumentata (AR) e realtà virtuale (VR). Ad esempio, SAM 2 può identificare e segment con precisione gli oggetti del mondo reale e rendere più realistica l'interazione con gli oggetti virtuali. Può essere utile in vari campi come i giochi, l'istruzione e la formazione, dove è essenziale un'interazione realistica tra elementi virtuali e reali.

Con l'avanzare dei dispositivi come gli occhiali AR, le capacità di SAM 2 potrebbero presto essere integrate in essi. Immaginate di indossare gli occhiali e di guardarvi intorno in salotto. Quando gli occhiali segment e notano la ciotola dell'acqua del cane, potrebbero ricordarvi di riempirla, come mostrato nell'immagine sottostante. Oppure, se state cucinando una nuova ricetta, gli occhiali potrebbero identificare gli ingredienti presenti sul vostro piano di lavoro e fornirvi istruzioni e suggerimenti passo dopo passo, migliorando la vostra esperienza culinaria e assicurandovi di avere tutti gli elementi necessari a portata di mano.

La ricerca che ha utilizzato il modello SAM ha dimostrato che può essere applicato in domini specializzati come l'imaging sonar. Le immagini sonar presentano sfide uniche a causa della bassa risoluzione, degli elevati livelli di rumore e delle forme complesse degli oggetti nelle immagini. Mettendo a punto SAM per le immagini sonar, i ricercatori hanno dimostrato la sua capacità di segment con precisione vari oggetti subacquei, come detriti marini, formazioni geologiche e altri oggetti di interesse. Immagini subacquee precise e affidabili possono essere utilizzate nella ricerca marina, nell'archeologia subacquea, nella gestione della pesca e nella sorveglianza per compiti quali la mappatura dell'habitat, la scoperta di artefatti e il rilevamento di minacce.

%25252525201.png)

Poiché SAM 2 si basa e migliora molte delle sfide affrontate da SAM , ha il potenziale per migliorare ulteriormente l'analisi delle immagini sonar. Le sue precise capacità di segmentazione possono aiutare in diverse applicazioni marine, tra cui la ricerca scientifica e la pesca. Ad esempio, SAM 2 è in grado di delineare efficacemente le strutture sottomarine, detect detriti marini e identificare gli oggetti nelle immagini sonar forward-looking, contribuendo a un'esplorazione e a un monitoraggio sottomarino più accurati ed efficienti.

Ecco i potenziali vantaggi dell'uso di SAM 2 per analizzare le immagini sonar:

Integrando SAM 2 nei processi di imaging sonar, l'industria marina può ottenere maggiore efficienza, precisione e affidabilità nell'esplorazione e nell'analisi subacquea, portando in ultima analisi a risultati migliori nella ricerca marina.

Un'altra applicazione di SAM 2 è quella dei veicoli autonomi. SAM 2 è in grado di identificare con precisione oggetti come pedoni, altri veicoli, segnali stradali e ostacoli in tempo reale. Il livello di dettaglio che SAM 2 è in grado di fornire è essenziale per prendere decisioni sicure in materia di navigazione e di prevenzione delle collisioni. Elaborando con precisione i dati visivi, SAM 2 contribuisce a creare una mappa dettagliata e affidabile dell'ambiente e a migliorare il processo decisionale.

La capacità di SAM 2 di funzionare bene in diverse condizioni di illuminazione, cambiamenti meteorologici e ambienti dinamici lo rende affidabile per i veicoli autonomi. Che si tratti di una strada urbana trafficata o di un'autostrada nebbiosa, SAM 2 è in grado di identificare e segment con precisione gli oggetti, in modo che il veicolo possa rispondere correttamente alle varie situazioni.

Tuttavia, ci sono alcune limitazioni da tenere presenti. Nel caso di oggetti complessi e in rapido movimento, SAM 2 può talvolta non cogliere i dettagli più fini e le sue previsioni possono diventare instabili da un fotogramma all'altro. Inoltre, SAM 2 può talvolta confondere più oggetti simili in scene affollate. Queste sfide sono il motivo per cui l'integrazione di ulteriori sensori e tecnologie è fondamentale nelle applicazioni di guida autonoma.

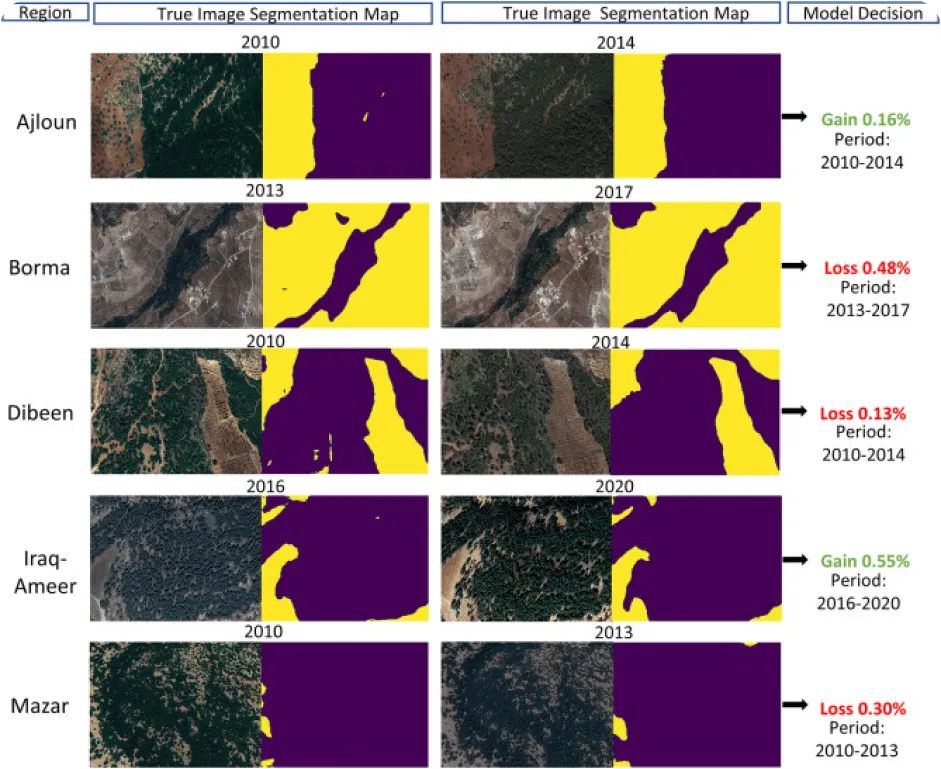

Il monitoraggio ambientale tramite computer vision può essere difficile, soprattutto quando mancano dati annotati, ma è anche questo che lo rende un'applicazione interessante per SAM 2. SAM 2 può essere utilizzato per track e analizzare i cambiamenti nei paesaggi naturali segmentando e identificando con precisione varie caratteristiche ambientali come foreste, corpi idrici, aree urbane e terreni agricoli da immagini satellitari o di droni. In particolare, una segmentazione precisa aiuta a monitorare la deforestazione, l'urbanizzazione e i cambiamenti nell'uso del suolo nel tempo, fornendo dati preziosi per la conservazione e la pianificazione ambientale.

Ecco alcuni dei vantaggi dell'utilizzo di un modello come SAM 2 per analizzare i cambiamenti ambientali nel tempo:

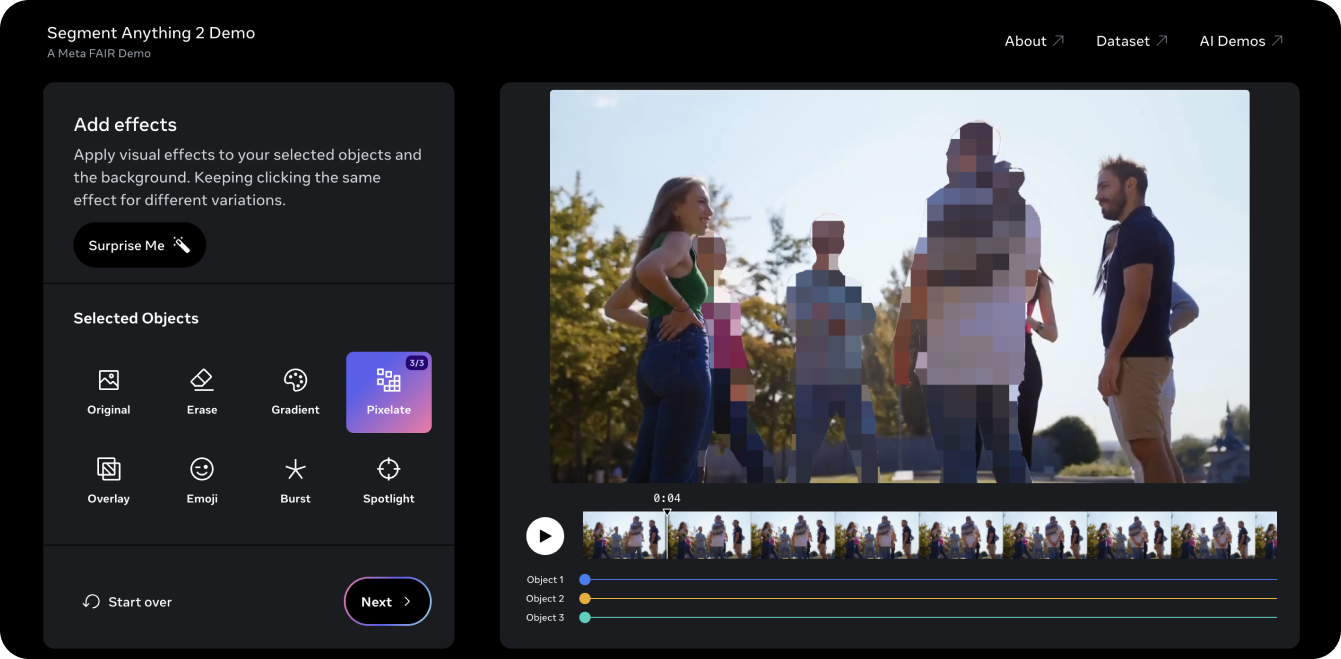

La demo di Segment Anything 2 è un ottimo modo per provare il modello su un video. Utilizzando le funzionalità PVS di SAM 2, abbiamo preso un vecchio video diUltralytics su YouTube e siamo riusciti a segment tre oggetti o persone nel video e a pixelarli. Tradizionalmente, l'editing di tre individui da un video come questo sarebbe stato lungo e noioso e avrebbe richiesto una mascheratura manuale fotogramma per fotogramma. Tuttavia, SAM 2 semplifica questo processo. Con pochi clic sulla demo, è possibile proteggere l'identità di tre oggetti di interesse in pochi secondi.

La demo consente anche di provare alcuni effetti visivi diversi, come l'accensione di un riflettore sugli oggetti selezionati per il tracciamento e la cancellazione degli oggetti tracciati. Se vi è piaciuta la demo e siete pronti a iniziare a innovare con SAM 2, consultate la pagina dei documenti del modelloSAM 2 diUltralytics per ottenere istruzioni dettagliate su come utilizzare il modello. Esplorate le caratteristiche, le fasi di installazione e gli esempi per sfruttare appieno il potenziale di SAM 2 nei vostri progetti!

Il Segment Anything Model 2SAM 2) di Meta AI sta trasformando la segmentazione di video e immagini. Con il miglioramento di compiti come il tracciamento degli oggetti, stiamo scoprendo nuove opportunità nell'editing video, nella realtà mista, nella ricerca scientifica e nell'imaging medico. Semplificando compiti complessi e velocizzando le annotazioni, SAM 2 è pronto a diventare uno strumento importante per la comunità dell'IA. Continuando a esplorare e innovare con modelli come SAM 2, possiamo aspettarci applicazioni ancora più innovative e progressi in vari campi!

Scopri di più sull'IA esplorando il nostro repository GitHub e unendoti alla nostra community. Consulta le nostre pagine delle soluzioni per informazioni dettagliate sull'IA nella produzione e nell'assistenza sanitaria. 🚀