Esplorazione di SAM 3: il nuovo modello Segment Anything di Meta AI

Scoprite come SAM 3, il nuovo Segment Anything Model di Meta AI, semplifica il detect, la segment e il track degli oggetti nelle immagini e nei video del mondo reale.

Scoprite come SAM 3, il nuovo Segment Anything Model di Meta AI, semplifica il detect, la segment e il track degli oggetti nelle immagini e nei video del mondo reale.

Il 19 novembre 2025, Meta AI ha rilasciato il Segment Anything Model 3, noto anche come SAM 3. Quest'ultima versione del Segment Anything Model introduce nuovi modi per detect, segment e track oggetti in immagini e video del mondo reale, utilizzando suggerimenti testuali, visivi ed esempi di immagini.

Il modello SAM 3 si basa su SAM e SAM 2 e apporta nuovi progressi e funzionalità come la segmentazione dei concetti, il rilevamento del vocabolario aperto e il tracciamento dei video in tempo reale. È in grado di comprendere brevi frasi di sostantivo, di seguire gli oggetti attraverso i fotogrammi e di identificare concetti rari o a grana fine che i modelli precedenti non erano in grado di gestire con la stessa coerenza.

Nell'ambito della release SAM 3, Meta ha introdotto anche SAM 3D. Questa suite di modelli di nuova generazione ricostruisce oggetti, scene e corpi umani completi da una singola immagine ed espande l'ecosistema Segment Anything alla comprensione 3D. Queste aggiunte aprono nuove applicazioni nei settori della computer vision, della robotica, dell'editing multimediale e dei flussi di lavoro creativi.

In questo articolo esploreremo cos'è il SAM 3, cosa lo distingue dal SAM 2, come funziona il modello e le sue applicazioni reali. Iniziamo!

SAM 3 è un modello di visione computerizzata all'avanguardia in grado di identificare, separare e track oggetti in immagini e video sulla base di semplici istruzioni. Invece di affidarsi a un elenco fisso di etichette, SAM 3 comprende il linguaggio naturale e gli indizi visivi, rendendo facile dire al modello cosa si vuole trovare.

Con SAM 3, ad esempio, è possibile digitare una breve frase come "scuolabus giallo" o "gatto a strisce", fare clic su un oggetto o evidenziare un esempio in un'immagine. Il modello detect ogni oggetto corrispondente e genererà maschere di segmentazione pulite (un contorno visivo che mostra esattamente quali pixel appartengono a un oggetto). SAM 3 è anche in grado di seguire gli oggetti nei vari fotogrammi del video, mantenendoli coerenti con il loro movimento.

Un'altra parte interessante dell'annuncio di Meta AI è SAM 3D, che estende il progetto Segment Anything alla comprensione 3D. SAM 3D può prendere una singola immagine 2D e ricostruire la forma, la posa o la struttura di un oggetto o di un corpo umano in tre dimensioni. In altre parole, il modello può stimare come un oggetto occupa lo spazio anche quando è disponibile un solo punto di vista.

SAM 3D è stato rilasciato in due modelli diversi: SAM 3D Objects, che ricostruisce oggetti di uso quotidiano con geometria e texture, e SAM 3D Body, che stima la forma e la posa del corpo umano da una singola immagine. Entrambi i modelli utilizzano la segmentazione prodotta da SAM 3 e generano una rappresentazione 3D che si allinea all'aspetto e alla posizione dell'oggetto nella foto originale.

Ecco alcuni dei principali aggiornamenti introdotti SAM 3 per riunire rilevamento, segmentazione e tracciamento in un modello unificato:

Supponiamo di guardare un video di un safari con molti animali diversi e di voler detect e segment solo gli elefanti. Come si presenterebbe questo compito nelle diverse versioni di SAM?

Con SAM, è necessario fare clic manualmente su ogni elefante in ogni fotogramma per generare una maschera di segmentazione. Non c'è tracciamento, quindi ogni nuovo fotogramma richiede nuovi clic.

Con SAM 2, è possibile fare clic una volta su un elefante, ottenere la sua maschera e il modello track lo stesso elefante attraverso il video. Tuttavia, è necessario fare clic separatamente se si desidera segment più elefanti (oggetti specifici), poiché SAM 2 non comprende categorie come "elefante".

Con SAM 3, il flusso di lavoro diventa molto più semplice. È possibile digitare "elefante" o disegnare un riquadro di delimitazione intorno a un singolo elefante per fornire un esempio, e il modello troverà automaticamente tutti gli elefanti nel video, li segment e li track in modo coerente attraverso i fotogrammi. Il modello supporta ancora le richieste di clic e di riquadro utilizzate nelle versioni precedenti, ma ora è in grado di rispondere anche a richieste di testo e a immagini esemplari, cosa che SAM e SAM 2 non potevano fare.

Diamo quindi un'occhiata più da vicino a come funziona il modello SAM 3 e a come è stato addestrato.

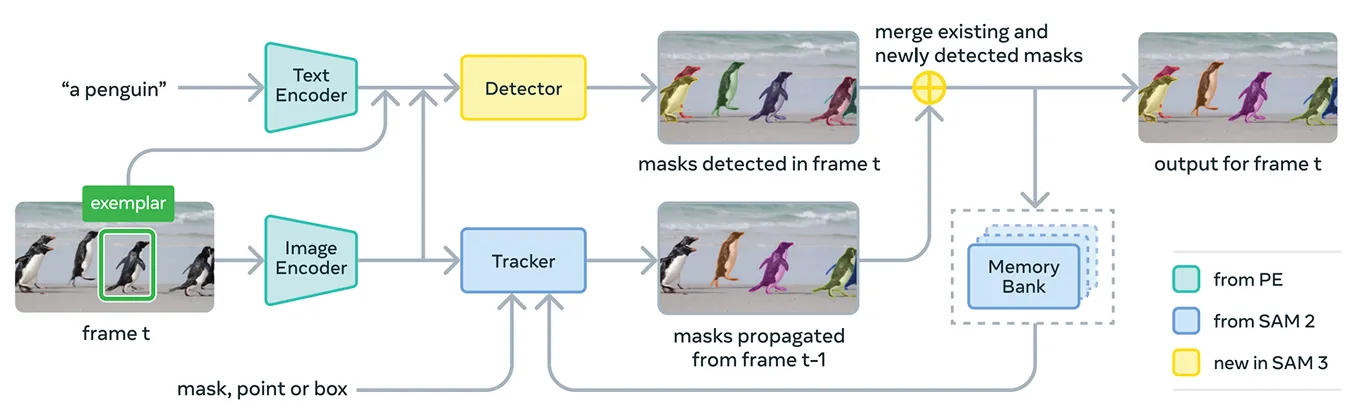

SAM 3 riunisce diversi componenti per supportare i prompt concettuali e visivi in un unico sistema. Il modello utilizza Meta Perception Encoder, il codificatore unificato open-source di immagini e testi di Meta.

Questo codificatore è in grado di elaborare sia immagini che brevi frasi di sostantivi. In poche parole, SAM 3 è in grado di collegare le caratteristiche linguistiche e visive in modo più efficace rispetto alle versioni precedenti del Segment Anything Model.

Oltre a questo codificatore, SAM 3 include un rilevatore basato sulla famiglia di modelli di trasformatori DETR. Questo rilevatore identifica gli oggetti presenti nell'immagine e aiuta il sistema a determinare quali oggetti corrispondono alla richiesta dell'utente.

In particolare, per la segmentazione dei video, SAM 3 utilizza un componente di tracciamento che si basa sul banco di memoria e sul codificatore di memoria di SAM 2. Questo permette al SAM di conservare le informazioni sugli oggetti tra i vari fotogrammi, in modo da poterli ri-identificare e seguire nel tempo. In questo modo, il modello conserva le informazioni sugli oggetti nei vari fotogrammi, in modo da poterli identificare e track nuovamente nel tempo.

Per addestrare SAM 3, Meta aveva bisogno di un numero di dati annotati molto superiore a quello attualmente disponibile su Internet. Le maschere di segmentazione e le etichette di testo di alta qualità sono difficili da creare su larga scala, e delineare completamente ogni istanza di un concetto nelle immagini e nei video è lento e costoso.

Per risolvere questo problema, Meta ha costruito un nuovo motore di dati che combina SAM 3 stesso, altri modelli di intelligenza artificiale e annotatori umani che lavorano insieme. Il flusso di lavoro inizia con una pipeline di sistemi di intelligenza artificiale, tra cui SAM 3 e un modello di sottotitolazione basato su Llama.

Questi sistemi analizzano grandi collezioni di immagini e video, generano didascalie, le convertono in etichette di testo e producono i primi candidati alla maschera di segmentazione. Gli annotatori umani e dell'intelligenza artificiale esaminano poi questi candidati.

Gli annotatori AI, addestrati per eguagliare o addirittura superare l'accuratezza umana in compiti come il controllo della qualità delle maschere e la verifica della copertura dei concetti, filtrano i casi più semplici. L'uomo interviene solo per gli esempi più impegnativi in cui il modello può ancora avere difficoltà.

Questo approccio dà a Meta un notevole impulso alla velocità di annotazione. Lasciando che gli annotatori AI gestiscano i casi più semplici, la pipeline diventa circa cinque volte più veloce per le richieste negative e il 36% più veloce per le richieste positive in domini a grana fine.

Questa efficienza ha permesso di scalare il set di dati a più di quattro milioni di concetti unici. Il ciclo costante di proposte dell'intelligenza artificiale, correzioni umane e previsioni aggiornate del modello migliora anche la qualità delle etichette nel tempo e aiuta SAM 3 ad apprendere un insieme molto più ampio di concetti visivi e testuali.

Per quanto riguarda le prestazioni, SAM 3 offre un netto miglioramento rispetto ai modelli precedenti. Nel nuovo benchmark SA-Co di Meta, che valuta il rilevamento e la segmentazione di concetti a vocabolario aperto, SAM 3 raggiunge prestazioni circa doppie rispetto ai sistemi precedenti, sia nelle immagini che nei video.

Inoltre, è pari o superiore a SAM 2 in compiti visivi interattivi come point-to-mask e mask-to-masklet. Meta registra ulteriori miglioramenti nelle valutazioni più difficili, come la LVIS a zero colpi (in cui i modelli devono riconoscere categorie rare senza esempi di addestramento) e il conteggio degli oggetti (che misura se vengono rilevate tutte le istanze di un oggetto), evidenziando una maggiore generalizzazione tra i vari domini.

Oltre a questi miglioramenti in termini di precisione, SAM 3 è efficiente: elabora un'immagine con più di 100 oggetti rilevati in circa 30 millisecondi su una GPU H200 e mantiene una velocità quasi in tempo reale durante il tracciamento di più oggetti nel video.

Ora che abbiamo una migliore comprensione di SAM 3, vediamo come viene utilizzato in applicazioni reali, dal ragionamento avanzato guidato dal testo alla ricerca scientifica e ai prodotti Meta.

SAM 3 può anche essere utilizzato come strumento all'interno di un modello linguistico multimodale più ampio, che Meta chiama Agente SAM 3. Invece di dare a SAM 3 una frase breve come "elefante", l'agente può suddividere una domanda più complicata in richieste più piccole che SAM 3 comprende.

Ad esempio, se l'utente chiede: "Quale oggetto nell'immagine è usato per controllare e guidare un cavallo?", l'agente prova diverse frasi sostantive, le invia a SAM 3 e controlla quali maschere hanno senso. Continua a perfezionarsi finché non trova l'oggetto giusto.

Anche senza essere stato addestrato su set di dati speciali per il ragionamento, l'agente SAM 3 ha ottenuto buoni risultati in benchmark progettati per interrogazioni testuali complesse, come ReasonSeg e OmniLabel. Ciò dimostra che SAM 3 è in grado di supportare sistemi che richiedono sia la comprensione del linguaggio sia la segmentazione visiva a grana fine.

È interessante notare che SAM 3 viene già utilizzato in contesti di ricerca in cui le etichette visive dettagliate sono importanti. Meta ha collaborato con Conservation X Labs e Osa Conservation per creare SA-FARI, un set di dati pubblici per il monitoraggio della fauna selvatica con oltre 10.000 video di trappole con telecamera.

Ogni animale in ogni fotogramma è etichettato con caselle e maschere di segmentazione, cosa che richiederebbe molto tempo per l'annotazione manuale. Analogamente, nella ricerca oceanica, SAM 3 viene utilizzato insieme a FathomNet e MBARI per creare maschere di segmentazione delle istanze per le immagini subacquee e supportare nuovi parametri di valutazione.

Questi set di dati aiutano gli scienziati ad analizzare i filmati in modo più efficiente e a studiare animali e habitat che di solito sono difficili da track su scala. I ricercatori possono anche utilizzare queste risorse per costruire i propri modelli per l'identificazione delle specie, l'analisi del comportamento e il monitoraggio ecologico automatizzato.

Oltre ai suoi utilizzi per la ricerca, SAM 3 sta anche creando nuove funzionalità e casi d'uso per i prodotti di consumo di Meta. Ecco un assaggio di alcuni dei modi in cui è già stato integrato:

SAM 3 rappresenta un entusiasmante passo avanti per la segmentazione. Introduce la segmentazione concettuale, le richieste di testo a vocabolario aperto e il tracking migliorato. Con prestazioni notevolmente superiori sia nelle immagini che nei video e l'aggiunta di SAM 3D, la suite di modelli apre nuove possibilità per la Vision AI, gli strumenti creativi, la ricerca scientifica e i prodotti reali.

Unitevi alla nostra comunità ed esplorate il nostro repository GitHub per scoprire di più sull'IA. Se volete creare il vostro progetto Vision AI, date un'occhiata alle nostre opzioni di licenza. Per saperne di più su applicazioni come l'IA nella sanità e l'IA di visione nella vendita al dettaglio, visitate le nostre pagine dedicate alle soluzioni.