Implementando aplicações de visão computacional em dispositivos de IA de borda

Explore como a Edge AI e as inovações da NVIDIA, como o Jetson, Triton e o TensorRT, estão a simplificar a implementação de aplicações de visão computacional.

Explore como a Edge AI e as inovações da NVIDIA, como o Jetson, Triton e o TensorRT, estão a simplificar a implementação de aplicações de visão computacional.

Graças aos recentes avanços em visão computacional e inteligência artificial (IA), o que antes era apenas um campo de pesquisa agora está impulsionando aplicações impactantes em diversos setores. De carros autônomos a imagens médicas e segurança, os sistemas de visão computacional estão resolvendo problemas reais em escala.

Muitas dessas aplicações envolvem a análise de imagens e vídeos em tempo real, e depender da computação em nuvem nem sempre é prático devido à latência, custos e preocupações com a privacidade. A IA de borda (Edge AI) é uma ótima solução nessas situações. Ao executar modelos de Visão de IA diretamente em dispositivos de borda, as empresas podem processar dados de forma mais rápida, acessível e com maior segurança, tornando a IA em tempo real mais acessível.

Durante o YOLO Vision 2024 (YV24), o evento híbrido anual organizado pela Ultralytics, um dos temas centrais foi a democratização da Vision AI, tornando a implementação mais fácil de utilizar e eficiente. Guy Dahan, Arquiteto de Soluções Sénior da NVIDIA, discutiu como as soluções de hardware e software da NVIDIA, incluindo dispositivos de computação edge, servidores de inferência, estruturas de otimização e SDKs de implementação de IA, estão a ajudar os programadores a otimizar a IA no edge.

Neste artigo, vamos explorar as principais conclusões da apresentação de Guy Dahan no YV24 e como as inovações mais recentes da NVIDIAestão a tornar a implementação da Vision AI mais rápida e mais escalável.

Guy Dahan começou a sua intervenção exprimindo o seu entusiasmo por se juntar virtualmente ao YV24 e o seu interesse pelo pacote Ultralytics Python e pelosmodelos Ultralytics YOLO , dizendo: "Utilizo Ultralytics desde o dia em que foi lançado. Gosto muito do Ultralytics - já utilizava YOLOv5 antes disso e sou um verdadeiro entusiasta deste pacote".

Em seguida, ele introduziu o conceito de Edge AI, explicando que envolve a execução de computações de IA diretamente em dispositivos como câmeras, drones ou máquinas industriais, em vez de enviar dados para servidores de nuvem distantes para processamento.

Em vez de esperar que imagens ou vídeos sejam carregados, analisados e, em seguida, enviados de volta com os resultados, a IA de Borda (Edge AI) possibilita analisar os dados instantaneamente no próprio dispositivo. Isso torna os sistemas de Visão de IA mais rápidos, eficientes e menos dependentes da conectividade com a internet. A IA de Borda é particularmente útil para aplicações de tomada de decisão em tempo real, como carros autônomos, câmeras de segurança e fábricas inteligentes.

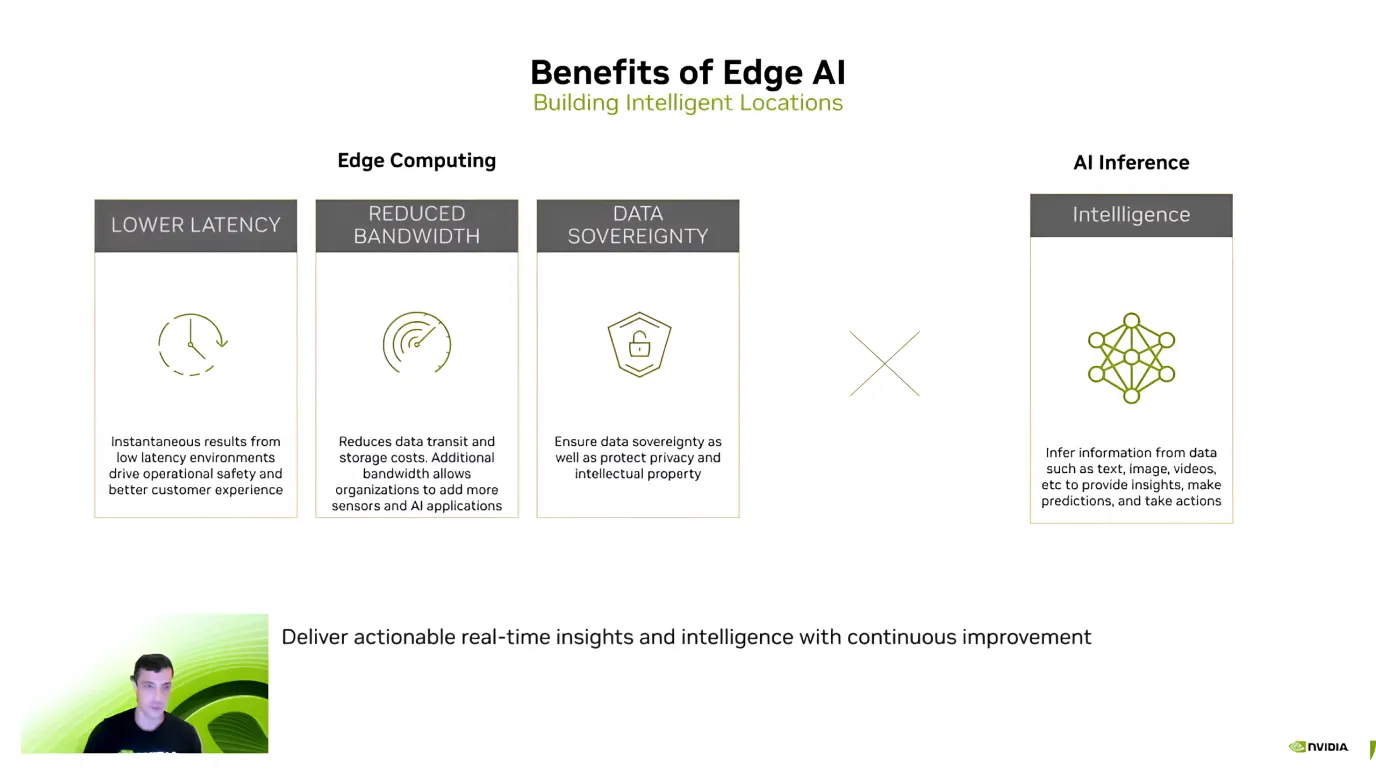

Após apresentar a Edge AI, Guy Dahan destacou suas principais vantagens, focando na eficiência, economia de custos e segurança de dados. Ele explicou que um dos maiores benefícios é a baixa latência - como os modelos de IA processam os dados diretamente no dispositivo, não há necessidade de enviar informações para a nuvem e esperar por uma resposta.

A Edge AI também ajuda a reduzir custos e proteger dados confidenciais. Enviar grandes quantidades de dados para a nuvem, especialmente fluxos de vídeo, pode ser caro. No entanto, processá-los localmente reduz os custos de largura de banda e armazenamento.

Outra vantagem fundamental é a privacidade dos dados, porque as informações permanecem no dispositivo em vez de serem transferidas para um servidor externo. Isso é particularmente importante para aplicações de saúde, finanças e segurança, onde manter os dados locais e seguros é uma prioridade máxima.

Com base nestes benefícios, Guy Dahan comentou a crescente adoção da IA de ponta. Ele observou que, desde que NVIDIA introduziu o Jetson em 2014, o uso aumentou dez vezes. Atualmente, mais de 1,2 milhões de programadores estão a trabalhar com dispositivos Jetson.

Guy Dahan centrou-se depois nos dispositivosNVIDIA Jetson, uma família de dispositivos de computação de ponta para IA concebidos para proporcionar um elevado desempenho com baixo consumo de energia. Os dispositivos Jetson são ideais para aplicações de visão por computador em sectores como a robótica, a agricultura, os cuidados de saúde e a automação industrial. "Os Jetsons são dispositivos de IA de ponta especificamente concebidos para a IA. Posso mesmo acrescentar que, originalmente, foram concebidos sobretudo para a visão por computador", acrescentou Guy Dahan.

Os dispositivos Jetson vêm em três níveis, cada um adequado para diferentes necessidades:

Além disso, Guy Dahan partilhou sobre o próximo Jetson AGX Thor, que será lançado este ano, e disse que irá oferecer oito vezes o desempenho GPU (Unidade de Processamento Gráfico), o dobro da capacidade de memória e um desempenho melhorado CPU (Unidade de Processamento Central). Foi especificamente concebido para robótica humanoide e aplicações avançadas de IA Edge.

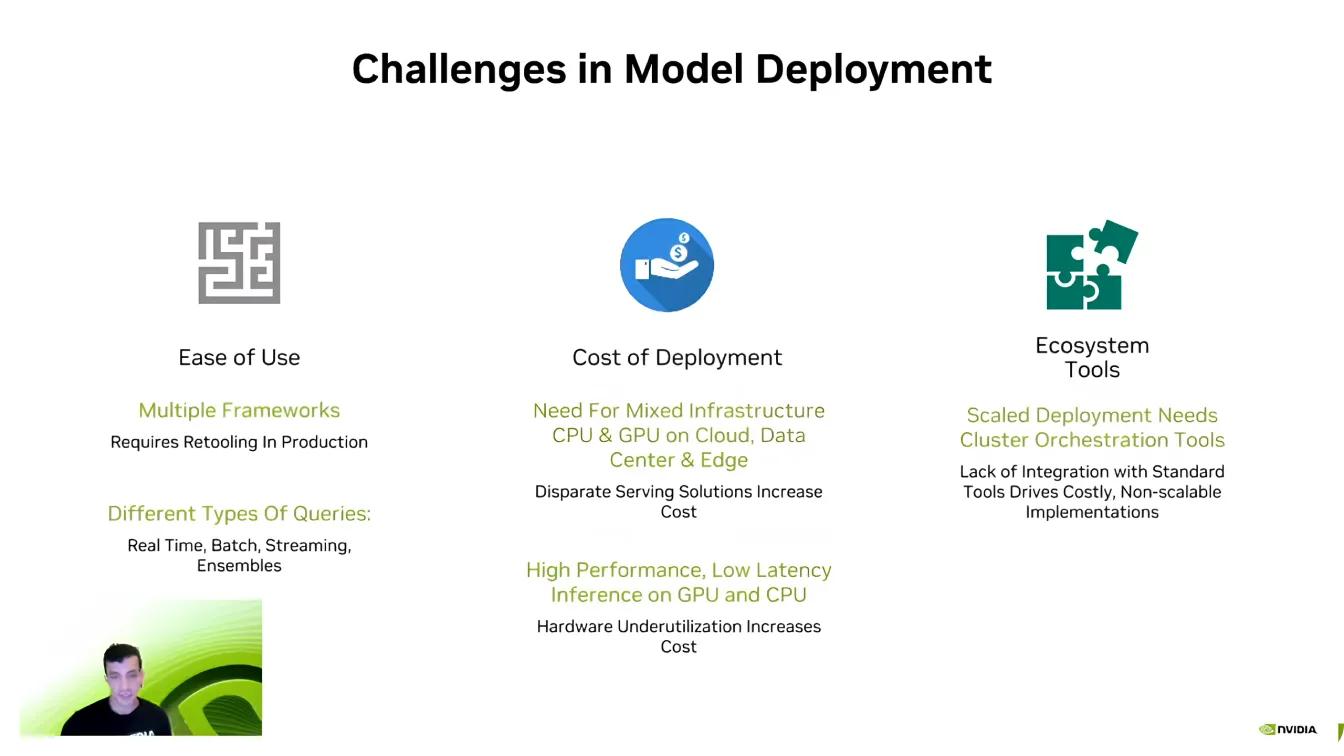

Guy Dahan então mudou para discutir o lado do software da Edge AI e explicou que, mesmo com hardware poderoso, implantar modelos de forma eficiente pode ser um desafio.

Um dos maiores obstáculos é a compatibilidade, uma vez que os programadores de IA trabalham frequentemente com diferentes estruturas de IA, como PyTorch e TensorFlow. A mudança entre essas estruturas pode ser difícil, exigindo que os desenvolvedores recriem ambientes para garantir que tudo seja executado corretamente.

A escalabilidade é outro desafio fundamental. Os modelos de IA exigem um poder computacional significativo e, como Dahan disse, "Nunca houve uma empresa de IA que quisesse menos poder computacional". Expandir as aplicações de IA em vários dispositivos pode rapidamente se tornar caro, tornando a otimização essencial.

Além disso, os pipelines de IA são complexos, muitas vezes envolvendo diferentes tipos de dados, processamento em tempo real e integração de sistemas. Os desenvolvedores se esforçam muito para garantir que seus modelos interajam perfeitamente com os ecossistemas de software existentes. Superar esses desafios é uma parte crucial para tornar as implantações de IA mais eficientes e escaláveis.

De seguida, Guy Dahan centrou a sua atenção no Servidor de InferênciaTriton da NVIDIA. Ele ressaltou que muitas empresas e startups começam o desenvolvimento de AI sem otimizar totalmente seus modelos. Redesenhar todo um pipeline de AI do zero pode ser disruptivo e demorado, dificultando o dimensionamento eficiente.

Em vez de exigir uma revisão completa do sistema, Triton permite que os programadores refinem e optimizem gradualmente os seus fluxos de trabalho de IA, integrando componentes mais eficientes sem quebrar a configuração existente. Com suporte para várias estruturas de IA, incluindo TensorFlow, PyTorch, ONNX e TensorRT, Triton permite uma implementação perfeita em ambientes de nuvem, centros de dados e dispositivos de borda com ajustes mínimos.

Aqui estão algumas das principais vantagens do Servidor de Inferência Triton da NVIDIA:

Digamos que está à procura de ainda mais aceleração; NVIDIA TensorRT é uma opção interessante para otimizar os seus modelos de IA. Guy Dahan explicou que TensorRT é um optimizador de aprendizagem profunda de alto desempenho criado para GPUs NVIDIA . Modelos do TensorFlow, PyTorch, ONNX e MXNet podem ser convertidos em arquivos GPU altamente eficientes usando o TensorRT.

O que torna TensorRT tão fiável são as suas optimizações específicas de hardware. Um modelo optimizado para dispositivos Jetson não terá um desempenho tão eficiente noutras GPUs porque TensorRT afina o desempenho com base no hardware alvo. Um modelo de visão computacional com ajuste fino pode resultar em um aumento na velocidade de inferência de até 36 vezes em comparação com modelos não otimizados.

Guy Dahan também chamou a atenção para o suporte do Ultralytics para o TensorRT, falando sobre como este torna a implementação de modelos de IA mais rápida e eficiente. Os modelosYOLO Ultralytics podem ser exportados diretamente para o formato TensorRT , permitindo aos programadores optimizá-los para GPUs NVIDIA sem necessidade de efetuar quaisquer alterações.

A terminar a palestra, Guy Dahan apresentou o DeepStream 7.0, uma estrutura de IA concebida para o processamento em tempo real de dados de vídeo, áudio e sensores utilizando GPUs NVIDIA . Criado para suportar aplicações de visão computacional de alta velocidade, permite a deteção, o seguimento e a análise de objectos em sistemas autónomos, segurança, automação industrial e cidades inteligentes. Ao executar a IA diretamente em dispositivos de borda, o DeepStream elimina a dependência do cloud, reduzindo a latência e melhorando a eficiência.

Especificamente, o DeepStream pode lidar com o processamento de vídeo alimentado por IA do início ao fim. Ele oferece suporte a fluxos de trabalho completos, desde a decodificação e pré-processamento de vídeo até a inferência de IA e pós-processamento.

Recentemente, o DeepStream introduziu várias atualizações para aprimorar a implementação de IA, tornando-a mais acessível e escalável. Novas ferramentas simplificam o desenvolvimento, melhoram o rastreamento de várias câmeras e otimizam os pipelines de IA para melhor desempenho.

Os desenvolvedores agora têm suporte expandido para ambientes Windows, recursos aprimorados de fusão de sensores para integrar dados de várias fontes e acesso a aplicativos de referência pré-construídos para acelerar a implantação. Essas melhorias tornam o DeepStream uma solução mais flexível e eficiente para aplicações de IA em tempo real, ajudando os desenvolvedores a dimensionar a análise inteligente de vídeo com facilidade.

Conforme ilustrado na palestra de Guy Dahan na YV24, a IA de ponta está redefinindo as aplicações de visão computacional. Com os avanços em hardware e software, o processamento em tempo real está se tornando mais rápido, mais eficiente e econômico.

À medida que mais indústrias adotam a Edge AI, abordar desafios como a fragmentação e a complexidade da implementação será fundamental para desbloquear todo o seu potencial. A adoção dessas inovações impulsionará aplicações de IA mais inteligentes e responsivas, moldando o futuro da visão computacional.

Faça parte da nossa crescente comunidade! Explore nosso repositório GitHub para saber mais sobre IA e confira nossas opções de licenciamento para dar o pontapé inicial em seus projetos de Visão de IA. Tem curiosidade sobre inovações como IA na área da saúde e visão computacional na manufatura? Visite nossas páginas de soluções para saber mais!