Развертывание приложений компьютерного зрения на периферийных AI-устройствах

Узнайте, как Edge AI и инновации NVIDIA, такие как Jetson, Triton и TensorRT, упрощают развертывание приложений компьютерного зрения.

Узнайте, как Edge AI и инновации NVIDIA, такие как Jetson, Triton и TensorRT, упрощают развертывание приложений компьютерного зрения.

Благодаря последним достижениям в области компьютерного зрения и искусственного интеллекта (AI) то, что когда-то было просто областью исследований, теперь стимулирует эффективные приложения в различных отраслях. От самоуправляемых автомобилей до медицинской визуализации и безопасности, системы компьютерного зрения решают реальные проблемы в масштабе.

Многие из этих приложений включают анализ изображений и видео в режиме реального времени, и полагаться на облачные вычисления не всегда практично из-за задержки, затрат и проблем с конфиденциальностью. Edge AI — отличное решение в этих ситуациях. Запуская модели Vision AI непосредственно на периферийных устройствах, предприятия могут обрабатывать данные быстрее, доступнее и с большей безопасностью, что делает AI в реальном времени более доступным.

На YOLO Vision 2024 (YV24), ежегодном гибридном мероприятии, проводимом Ultralytics, одной из центральных тем была демократизация Vision AI за счет более удобного и эффективного развертывания. Гай Дахан (Guy Dahan), старший архитектор решений в NVIDIA, рассказал о том, как аппаратные и программные решения NVIDIA, включая пограничные вычислительные устройства, серверы выводов, фреймворки оптимизации и SDK для развертывания ИИ, помогают разработчикам оптимизировать ИИ на границе.

В этой статье мы рассмотрим ключевые моменты из выступления Гая Дахана на YV24 и то, как последние инновации NVIDIAделают развертывание Vision AI более быстрым и масштабируемым.

Гай Дахан начал свое выступление с того, что с энтузиазмом отнесся к виртуальному участию в YV24 и выразил интерес к пакету Ultralytics Python имоделям Ultralytics YOLO , сказав: "Я использую Ultralytics со дня его выхода. Мне очень нравится Ultralytics - я использовал YOLOv5 еще до этого, и я настоящий энтузиаст этого пакета".

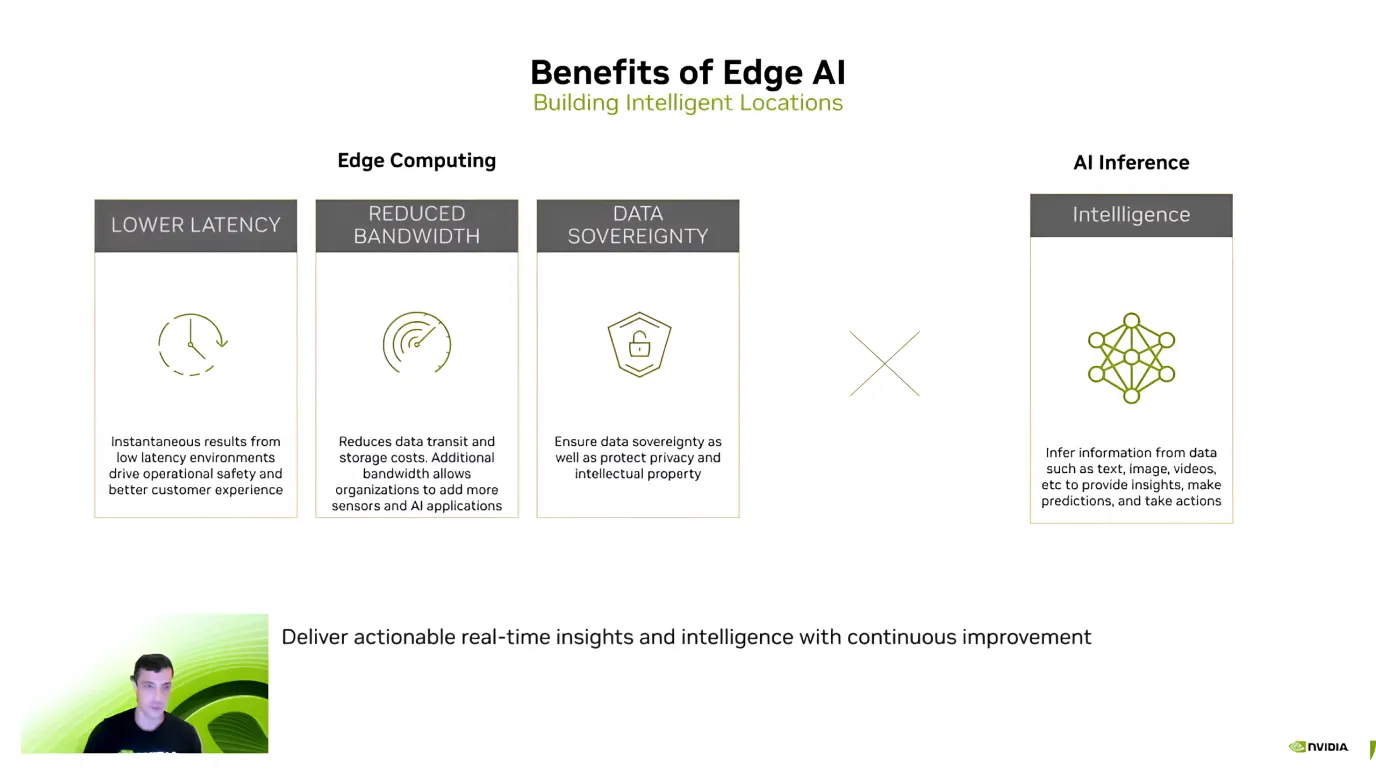

Затем он представил концепцию Edge AI, объяснив, что она включает в себя выполнение ИИ-вычислений непосредственно на устройствах, таких как камеры, дроны или промышленные машины, вместо отправки данных на удаленные облачные серверы для обработки.

Вместо того чтобы ждать, пока изображения или видео будут загружены, проанализированы, а затем отправлены обратно с результатами, Edge AI позволяет анализировать данные мгновенно на самом устройстве. Это делает системы Vision AI быстрее, эффективнее и менее зависимыми от подключения к Интернету. Edge AI особенно полезен для приложений принятия решений в реальном времени, таких как самоуправляемые автомобили, камеры видеонаблюдения и умные фабрики.

После представления Edge AI Гай Дахан выделил его основные преимущества, сосредоточив внимание на эффективности, экономии затрат и безопасности данных. Он объяснил, что одним из самых больших преимуществ является низкая задержка - поскольку модели AI обрабатывают данные непосредственно на устройстве, нет необходимости отправлять информацию в облако и ждать ответа.

Edge AI также помогает снизить затраты и защитить конфиденциальные данные. Отправка больших объемов данных в облако, особенно видеопотоков, может быть дорогостоящей. Однако локальная обработка снижает затраты на пропускную способность и хранение.

Еще одно ключевое преимущество — конфиденциальность данных, поскольку информация остается на устройстве, а не передается на внешний сервер. Это особенно важно для приложений в сфере здравоохранения, финансов и безопасности, где сохранение локальных и безопасных данных является главным приоритетом.

Основываясь на этих преимуществах, Гай Дахан прокомментировал растущее внедрение Edge AI. Он отметил, что с тех пор, как NVIDIA представила Jetson в 2014 году, его использование выросло в десять раз. Сегодня более 1,2 миллиона разработчиков работают с устройствами Jetson.

Затем Гай Дахан рассказал об устройствахNVIDIA Jetson- семействе устройств для вычислений на основе ИИ, созданных для обеспечения высокой производительности при низком энергопотреблении. Устройства Jetson идеально подходят для приложений компьютерного зрения в таких отраслях, как робототехника, сельское хозяйство, здравоохранение и промышленная автоматизация. "Jetson - это устройства Edge AI, специально созданные для ИИ. Я даже могу добавить, что изначально они были разработаны в основном для компьютерного зрения", - добавил Гай Дахан.

Устройства Jetson поставляются в трех категориях, каждая из которых подходит для различных нужд:

Также Гай Дахан рассказал о грядущей модели Jetson AGX Thor, которая выйдет на рынок в этом году, и сообщил, что ее производительность будет в восемь раз выше, чем у GPU (графический процессор), в два раза больше памяти и улучшенная производительность CPU (центральный процессор). Он специально разработан для гуманоидной робототехники и передовых приложений Edge AI.

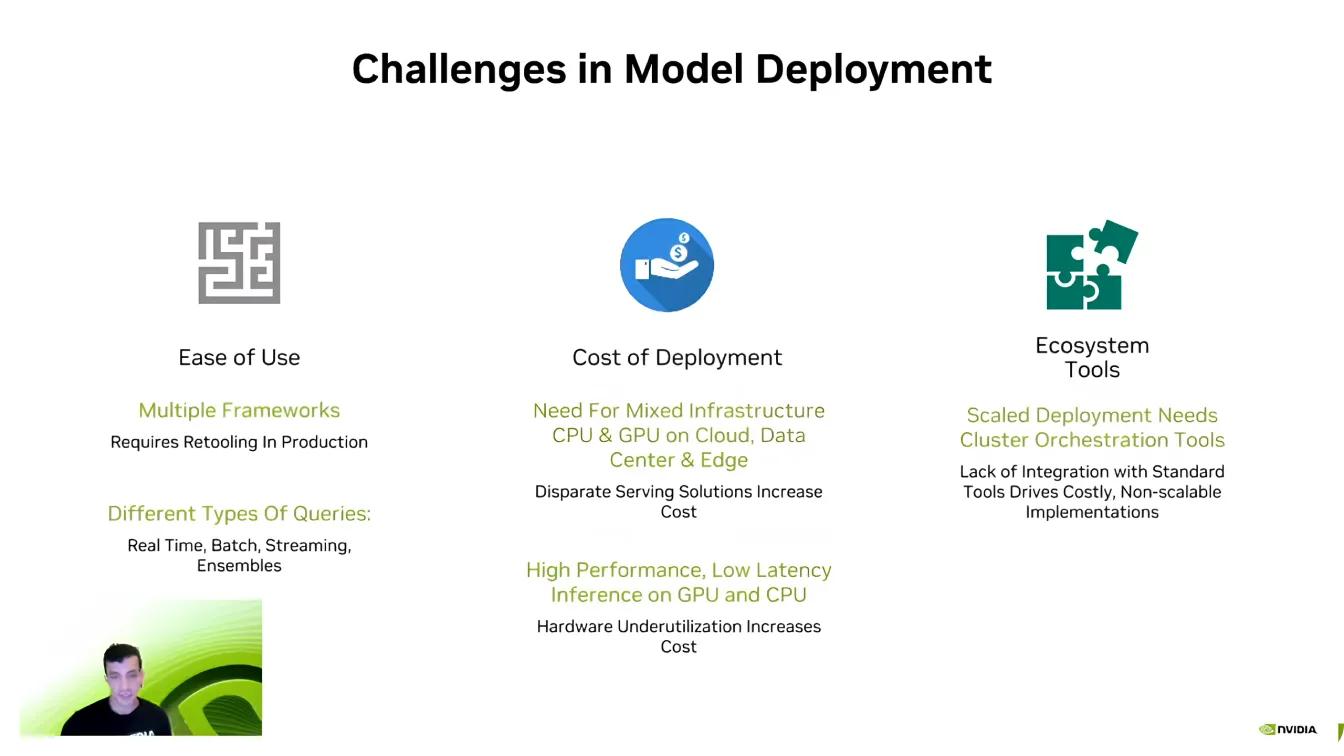

Затем Гай Дахан перешел к обсуждению программной стороны Edge AI и объяснил, что даже при наличии мощного оборудования эффективное развертывание моделей может быть сложной задачей.

Одним из самых больших препятствий является совместимость, поскольку разработчики ИИ часто работают с различными фреймворками ИИ, такими как PyTorch и TensorFlow. Перемещение между этими фреймворками может быть затруднено, что требует от разработчиков воссоздания окружения для обеспечения корректной работы.

Масштабируемость — еще одна ключевая проблема. Модели ИИ требуют значительной вычислительной мощности, и, как выразился Дахан, «Еще не было компании, занимающейся ИИ, которой требовалось бы меньше вычислений». Расширение приложений ИИ на несколько устройств может быстро стать дорогостоящим, что делает оптимизацию необходимой.

Кроме того, конвейеры ИИ сложны и часто включают в себя различные типы данных, обработку в реальном времени и системную интеграцию. Разработчики прилагают много усилий, чтобы их модели беспрепятственно взаимодействовали с существующими программными экосистемами. Преодоление этих проблем является важной частью повышения эффективности и масштабируемости развертываний ИИ.

Далее Гай Дахан обратил внимание на Triton Inference Server от NVIDIA. Он отметил, что многие компании и стартапы начинают разработку ИИ без полной оптимизации своих моделей. Переделка всего конвейера ИИ с нуля может быть разрушительной и отнимать много времени, что затрудняет эффективное масштабирование.

Вместо того чтобы полностью перестраивать систему, Triton позволяет разработчикам постепенно дорабатывать и оптимизировать рабочие процессы ИИ, интегрируя более эффективные компоненты, не ломая существующие настройки. Благодаря поддержке множества фреймворков ИИ, включая TensorFlow, PyTorch, ONNX и TensorRT, Triton обеспечивает бесшовное развертывание в облачных средах, центрах обработки данных и пограничных устройствах с минимальными изменениями.

Вот некоторые из ключевых преимуществ Triton Inference Server от NVIDIA:

Допустим, вам нужно еще большее ускорение; NVIDIA TensorRT это интересный вариант для оптимизации ваших моделей ИИ. Гай Дахан (Guy Dahan) рассказал, что TensorRT - это высокопроизводительный оптимизатор глубокого обучения, созданный для NVIDIA GPU. Модели из TensorFlow, PyTorch, ONNX и MXNet могут быть преобразованы в высокоэффективные GPU файлы с помощью TensorRT.

Надежность TensorRT обеспечивается за счет оптимизации под конкретное оборудование. Модель, оптимизированная для устройств Jetson, не будет работать так же эффективно на других GPU, потому что TensorRT точно настраивает производительность в зависимости от целевого оборудования. Тонкая настройка модели компьютерного зрения может привести к увеличению скорости вычислений в 36 раз по сравнению с неоптимизированными моделями.

Гай Дахан также обратил внимание на поддержку TensorRT в Ultralytics, рассказав о том, как она позволяет ускорить и повысить эффективность развертывания моделей ИИ. Модели Ultralytics YOLO могут быть напрямую экспортированы в формат TensorRT , что позволяет разработчикам оптимизировать их для графических процессоров NVIDIA без необходимости внесения каких-либо изменений.

Завершая выступление на высокой ноте, Гай Дахан продемонстрировал DeepStream 7.0 - фреймворк ИИ, предназначенный для обработки видео, аудио и сенсорных данных в реальном времени с помощью NVIDIA GPU. Созданный для поддержки высокоскоростных приложений компьютерного зрения, он позволяет обнаруживать, отслеживать и анализировать объекты в автономных системах, системах безопасности, промышленной автоматизации и умных городах. Запуская ИИ непосредственно на пограничных устройствах, DeepStream устраняет зависимость от облака, снижая задержки и повышая эффективность.

В частности, DeepStream может обрабатывать видео с использованием ИИ от начала до конца. Он поддерживает сквозные рабочие процессы, от декодирования и предварительной обработки видео до логического вывода ИИ и постобработки.

Недавно DeepStream представила несколько обновлений для улучшения развертывания AI, сделав его более доступным и масштабируемым. Новые инструменты упрощают разработку, улучшают отслеживание с нескольких камер и оптимизируют конвейеры AI для повышения производительности.

Теперь разработчики имеют расширенную поддержку сред Windows, улучшенные возможности объединения данных от нескольких источников и доступ к предварительно созданным эталонным приложениям для ускорения развертывания. Эти улучшения делают DeepStream более гибким и эффективным решением для приложений ИИ в реальном времени, помогая разработчикам с легкостью масштабировать интеллектуальную видеоаналитику.

Как было показано в основном докладе Гая Дахана на YV24, Edge AI переопределяет приложения компьютерного зрения. Благодаря достижениям в области аппаратного и программного обеспечения обработка в реальном времени становится быстрее, эффективнее и экономичнее.

По мере того как все больше отраслей внедряют Edge AI, решение таких проблем, как фрагментация и сложность развертывания, станет ключом к раскрытию его полного потенциала. Принятие этих инноваций будет стимулировать более разумные и отзывчивые приложения ИИ, формируя будущее компьютерного зрения.

Станьте частью нашего растущего сообщества! Изучите наш репозиторий на GitHub, чтобы узнать больше об ИИ, и ознакомьтесь с нашими вариантами лицензирования, чтобы дать старт своим проектам в области Vision AI. Интересуетесь инновациями, такими как ИИ в здравоохранении и компьютерное зрение в производстве? Посетите страницы наших решений, чтобы узнать больше!