Узнайте, как ансамблевое обучение повышает производительность моделей ИИ с помощью таких методов, как суммирование, наращивание и суммирование, обеспечивая более точные и стабильные прогнозы.

Узнайте, как ансамблевое обучение повышает производительность моделей ИИ с помощью таких методов, как суммирование, наращивание и суммирование, обеспечивая более точные и стабильные прогнозы.

Чтобы увидеть наглядную демонстрацию концепций, описанных в этой статье, посмотрите видео ниже.

Такие инновации в области ИИ, как рекомендательные системы и системы обнаружения мошенничества, опираются на алгоритмы и модели машинного обучения, позволяющие делать прогнозы и принимать решения на основе данных. Эти модели позволяют выявлять закономерности, прогнозировать тенденции и автоматизировать сложные задачи.

Однако одна модель может не справиться со всеми деталями реальных данных. Она может хорошо работать в одних случаях, но не справляться с другими, например, модель обнаружения мошенничества может упустить новые типы транзакций.

С этим ограничением часто сталкиваются инженеры ИИ при создании и развертывании моделей машинного обучения. Одни модели слишком хорошо подходят к обучающим данным, а другие плохо подходят, пропуская важные закономерности. Ансамблевое обучение - это метод ИИ, который помогает решить эти проблемы путем объединения нескольких моделей, известных как базовые обучаемые, в единую, более мощную систему.

Можно представить, что это команда экспертов, которые вместе работают над решением проблемы. В этой статье мы рассмотрим, что такое ансамблевое обучение, как оно работает и где его можно использовать. Давайте начнем!

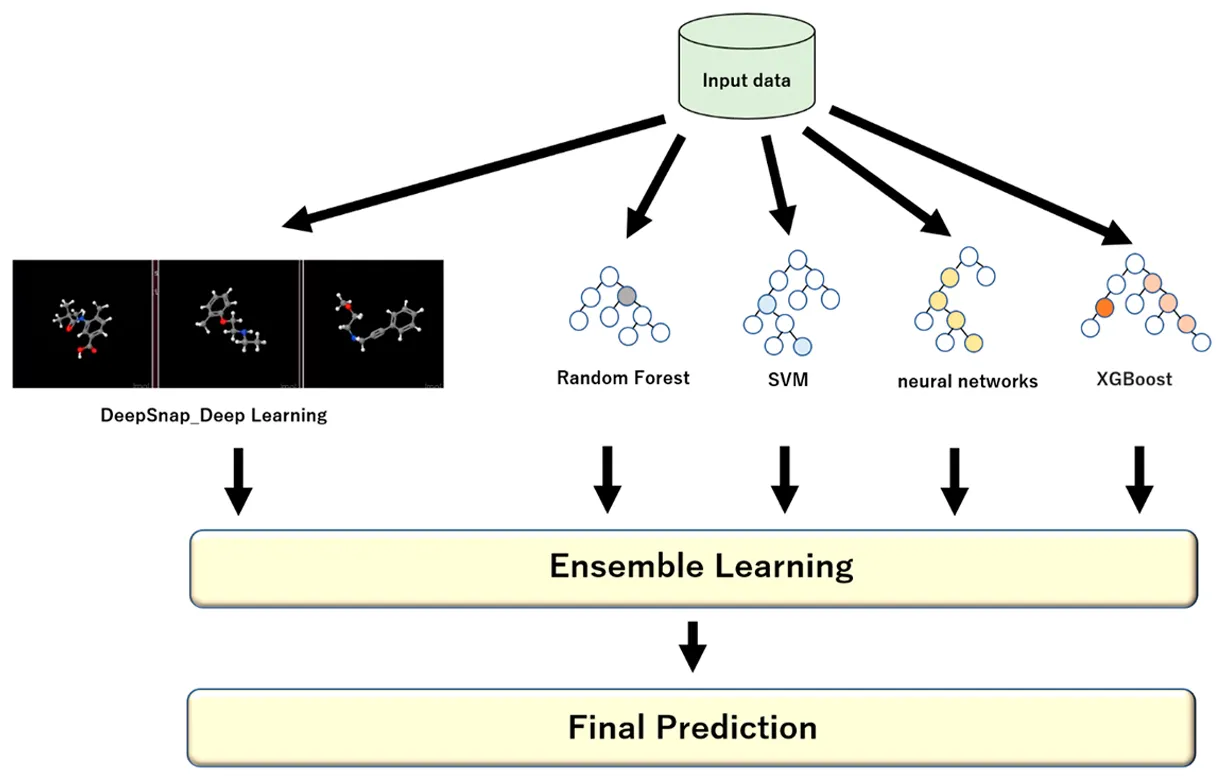

Под ансамблевым обучением понимается набор методов, которые объединяют несколько моделей для решения одной и той же задачи и дают единый, улучшенный результат. Оно может применяться как в контролируемом обучении (когда модели обучаются на основе маркированных данных), так и в неконтролируемом обучении (когда модели находят закономерности в немаркированных данных).

Вместо того чтобы полагаться на одну модель для составления прогнозов, ансамбль использует несколько моделей, каждая из которых рассматривает данные по-своему. Когда их результаты объединяются, результат часто оказывается более точным, стабильным и обобщенным, чем тот, которого могла бы достичь любая отдельная модель.

Это можно сравнить с группой аналитиков, решающих одну и ту же задачу. Каждый аналитик или отдельная модель интерпретируют данные по-своему.

Один может сосредоточиться на закономерностях, другой - на аномалиях, третий - на контексте. Объединив их взгляды, группа может принять решение, которое будет более сбалансированным и надежным, чем любое индивидуальное суждение.

Этот подход также помогает решить две самые большие проблемы в машинном обучении: смещение и дисперсию. Модель с высокой погрешностью слишком проста и упускает из виду важные закономерности, а модель с высокой дисперсией слишком чувствительна и слишком точно соответствует обучающим данным. Объединяя модели, ансамблевое обучение находит баланс между этими двумя факторами, улучшая работу системы на новых, еще не изученных данных.

Каждая модель в ансамбле известна как базовый обучаемый или базовая модель. В зависимости от используемой техники ансамбля это может быть один и тот же тип алгоритма или смесь различных алгоритмов.

Вот несколько распространенных примеров различных моделей, используемых в ансамблевом обучении:

Ансамбль комбинированных моделей обычно называют сильным обучаемым, поскольку он объединяет сильные стороны базовых обучаемых (также называемых слабыми моделями), сводя к минимуму их слабые стороны. Для этого он объединяет предсказания каждой модели в структурированном виде, используя мажоритарное голосование для задач классификации или взвешенное усреднение для задач регрессии, чтобы получить более точный конечный результат.

Прежде чем мы погрузимся в различные методы ансамблевого обучения, давайте сделаем шаг назад и поймем, когда этот тип подхода следует использовать в проекте машинного обучения или ИИ.

Ансамблевое обучение наиболее эффективно в тех случаях, когда одна модель не в состоянии сделать точный или последовательный прогноз. Его также можно использовать в ситуациях, когда данные сложны, зашумлены или непредсказуемы.

Вот несколько распространенных случаев, когда ансамблевые методы особенно эффективны:

Кроме того, их проще обучать, легче интерпретировать и быстрее поддерживать. Прежде чем использовать ансамбль, важно сопоставить выгоду от более высокой точности с дополнительным временем, вычислительной мощностью и сложностью, которые он требует.

Далее рассмотрим основные способы применения ансамблевого обучения в проектах машинного обучения. Существует несколько основных методов, используемых для объединения моделей, каждый из которых по-своему улучшает производительность. Наиболее распространенными методами ансамблевого обучения являются bagging, boosting, stacking и blending.

Bagging, сокращение от bootstrap aggregating, - это метод ансамблевого обучения, который помогает повысить стабильность и точность модели за счет обучения нескольких версий одной и той же модели на разных частях данных.

Каждое подмножество создается с помощью процесса, называемого бутстреп-выборкой, когда точки данных выбираются случайным образом с заменой. Это означает, что после выбора одной точки данных она возвращается в пул, прежде чем будет выбрана следующая, поэтому одна и та же точка может появиться несколько раз, а другие могут быть пропущены. Такая случайность гарантирует, что каждая модель тренируется на немного отличающейся версии набора данных.

Во время вывода все обученные модели работают параллельно, делая прогнозы на новых, еще не полученных данных. Каждая модель выдает свой собственный результат, основанный на том, чему она научилась, и эти отдельные прогнозы затем объединяются для получения окончательного результата.

Для задач регрессии, таких как прогнозирование цен на жилье или прогнозов продаж, это обычно означает усреднение результатов всех моделей для получения более гладкой оценки. Для задач классификации, таких как определение того, является ли сделка мошеннической или нет, ансамбль часто принимает решение о выборе окончательного класса большинством голосов.

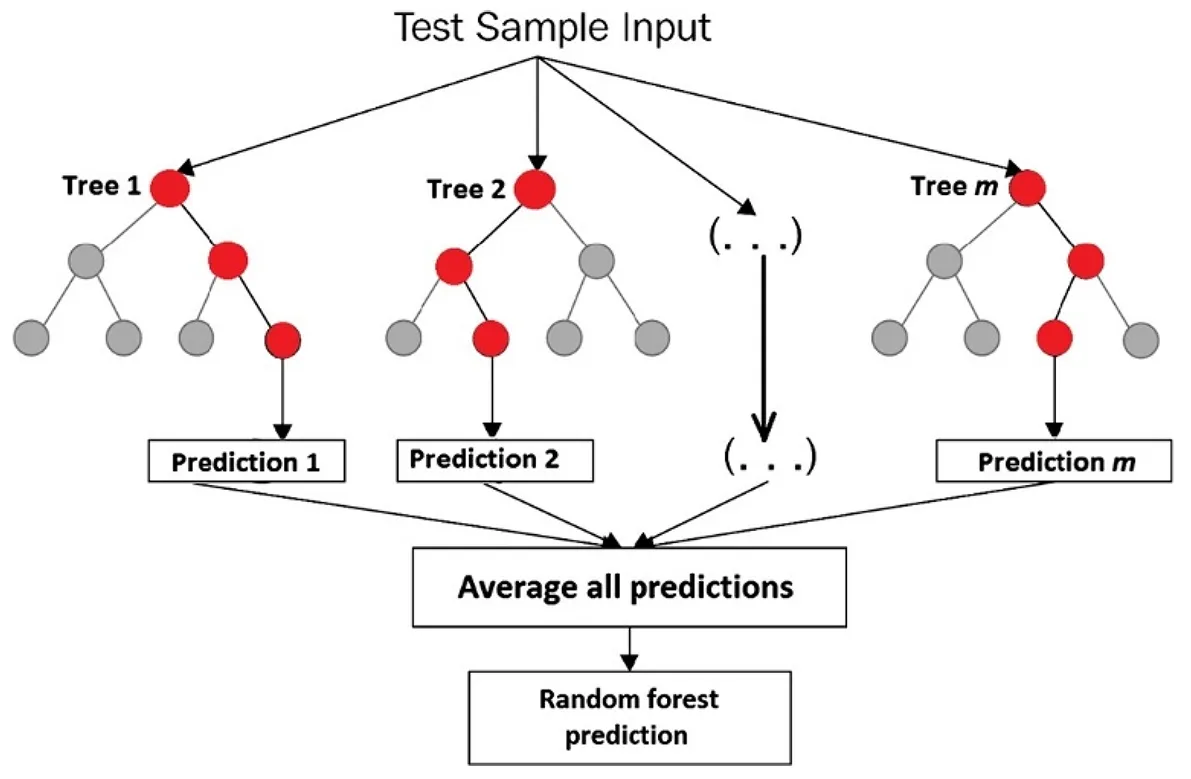

Хорошим примером того, как пакетная обработка хорошо работает, являются деревья решений, которые могут легко перестраиваться при обучении на одном наборе данных. Обучая множество деревьев на немного отличающихся выборках и объединяя их результаты, пакетная обработка уменьшает избыточную подгонку и повышает надежность.

Рассмотрим алгоритм Random Forest. Это ансамбль деревьев решений, где каждое дерево обучается на случайном подмножестве обучающего набора данных, а также на случайном подмножестве признаков.

Эта случайность помогает деревьям быть менее коррелированными, а общей модели - более стабильной и точной. Алгоритм Random Forest можно использовать для classify изображений, detect мошенничества, прогнозирования оттока клиентов, прогнозирования продаж или оценки цен на недвижимость.

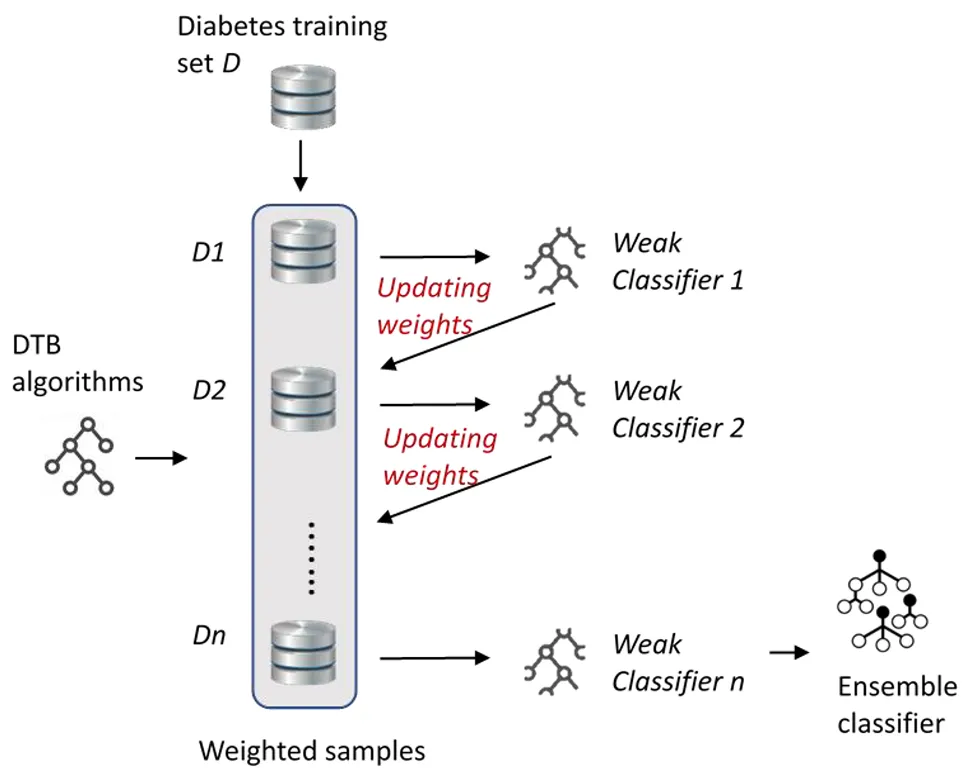

Boosting - это еще одна техника ансамблевого обучения, которая направлена на улучшение слабых обучаемых (моделей) путем их последовательного, а не параллельного обучения. Основная концепция бустинга заключается в том, что каждая новая модель учится на ошибках предыдущих, постепенно улучшая общую производительность модели.

В отличие от мешка, который уменьшает дисперсию за счет усреднения независимых моделей, бустинг уменьшает смещение, заставляя каждую новую модель уделять больше внимания сложным случаям, с которыми не справились предыдущие модели.

Поскольку модели boosting обучаются последовательно, способ объединения их прогнозов в конце несколько отличается от других ансамблевых методов. Каждая модель вносит вклад в итоговый прогноз пропорционально своей эффективности в процессе обучения, при этом более точные модели получают больший вес.

Для задач регрессии конечный результат обычно представляет собой взвешенную сумму всех предсказаний моделей. Для задач классификации алгоритм объединяет взвешенные голоса моделей, чтобы определить окончательный класс. Такой подход помогает создать сильную общую модель, придавая больший вес более точным моделям и одновременно извлекая уроки из остальных.

Вот несколько распространенных типов алгоритмов усиления:

Стекинг, также называемый стековым обобщением, делает еще один шаг вперед, используя предсказания нескольких моделей в качестве исходных данных для конечной модели, известной как метаобучаемая модель. Можно представить это как группу экспертов, каждый из которых делится своим мнением, а затем лицо, принимающее окончательное решение, учится взвешивать эти мнения, чтобы сделать наилучший выбор.

Например, одна модель может отлично справляться с выявлением мошенничества, а другая лучше предсказывает отток клиентов. Метаучитель изучает работу каждой модели и использует их сильные стороны для более точного конечного прогноза.

Смешивание работает аналогично стекированию, поскольку также объединяет прогнозы нескольких моделей для принятия окончательного решения, но при этом использует более простой и быстрый подход. Вместо того чтобы использовать кросс-валидацию (метод, при котором данные разбиваются на несколько частей и чередуются между обучением и тестированием, чтобы сделать модель более надежной), как это делает стекинг, смешивание откладывает небольшую часть данных, называемую "удерживающим набором".

Базовые модели обучаются на оставшихся данных, а затем делают предсказания на наборе holdout, который они раньше не видели. В результате получаются две ключевые части информации: фактические ответы, или истинные метки, и предсказания, сделанные каждой базовой моделью.

Затем эти прогнозы передаются другой модели, называемой смесительной или мета-моделью. Эта финальная модель изучает, насколько точны предсказания каждой базовой модели, и учится комбинировать их наилучшим образом.

Поскольку смешивание основывается только на одной тренировочной и тестовой разбивке, а не на многократном повторении процесса, оно работает быстрее и проще в настройке. Компромисс заключается в том, что он имеет немного меньше информации для обучения, что может сделать его немного менее точным.

Важной частью ансамблевого обучения является оценка того, насколько хорошо модель работает на данных, с которыми она раньше не сталкивалась. Независимо от того, насколько совершенной является методика, ее необходимо протестировать на предмет обобщения, то есть она должна делать точные прогнозы на новых, реальных примерах, а не просто запоминать обучающие данные.

Вот некоторые общие показатели производительности, используемые для оценки моделей ИИ:

До сих пор мы изучали, как работает ансамблевое обучение и какие методы за ним стоят. Теперь давайте посмотрим, где этот подход приносит пользу.

Вот несколько ключевых областей, в которых обычно применяется ансамблевое обучение:

Хотя ансамблевое обучение чаще всего используется для структурированных или табличных данных, таких как электронные таблицы, содержащие числовую или категориальную информацию, оно также может применяться к неструктурированным данным, таким как текст, изображения, аудио- и видеоматериалы.

Эти типы данных сложнее и труднее для интерпретации моделями, но методы ансамблей помогают повысить точность и надежность. Например, в компьютерном зрении ансамбли могут улучшить такие задачи, как классификация изображений и обнаружение объектов.

Объединяя прогнозы нескольких моделей зрения, таких как сверточные нейронные сети (CNN), система может распознавать объекты более точно и справляться с изменениями освещения, угла или фона, которые могут сбить с толку одну модель.

Интересный пример использования ансамблевого обучения в компьютерном зрении - когда инженер комбинирует несколько моделей обнаружения объектов для повышения точности. Представьте себе инженера, работающего над системой мониторинга безопасности на строительной площадке, где освещение, углы и размеры объектов постоянно меняются.

Одна модель может не заметить рабочего в тени или сбить с толку движущуюся технику. Использование ансамбля моделей, каждая из которых обладает различными достоинствами, делает систему более надежной и снижает вероятность совершения подобных ошибок.

В частности, такие модели, как Ultralytics YOLOv5 сочетаются с ансамблем моделей. Инженеры могут объединять различные варианты YOLOv5 , такие как YOLOv5x и YOLOv5l6, чтобы делать совместные прогнозы. Каждая модель анализирует одно и то же изображение и производит свои собственные обнаружения, которые затем усредняются для получения более сильного и точного конечного результата.

Вот некоторые ключевые преимущества использования ансамблевого обучения:

Хотя ансамблевое обучение дает различные преимущества, необходимо учитывать и некоторые проблемы. Вот несколько факторов, которые следует иметь в виду:

Ансамблевое обучение показывает, как объединение нескольких моделей может сделать системы ИИ более точными и надежными. Это помогает сократить количество ошибок и повысить производительность при решении различных задач. По мере того как машинное обучение и ИИ продолжают развиваться, подобные методы способствуют более широкому внедрению и созданию более практичных и высокопроизводительных ИИ-решений.

Присоединяйтесь к нашему растущему сообществу и репозиторию GitHub, чтобы узнать больше о Vision AI. Изучите страницы наших решений, чтобы узнать о применении компьютерного зрения в сельском хозяйстве и ИИ в логистике. Ознакомьтесь с нашими вариантами лицензирования, чтобы начать работу над собственной моделью компьютерного зрения уже сегодня!