SAM 3'ü Keşfetmek: Meta AI'ın yeni Segment Anything Modeli

Meta AI'ın yeni Segment Anything Modeli SAM 3'ün gerçek dünya görüntüleri ve videolarındaki nesneleri detect etmeyi, segment ayırmayı ve track nasıl kolaylaştırdığını öğrenin.

Meta AI'ın yeni Segment Anything Modeli SAM 3'ün gerçek dünya görüntüleri ve videolarındaki nesneleri detect etmeyi, segment ayırmayı ve track nasıl kolaylaştırdığını öğrenin.

Meta AI, 19 Kasım 2025 tarihinde SAM 3 olarak da bilinen Segment Anything Model 3'ü piyasaya sürdü. Segment Anything Modelinin bu en son sürümü, metin istemleri, görsel istemler ve görüntü örnekleri kullanarak gerçek dünya görüntüleri ve videolarındaki nesneleri detect etmek, segment ayırmak ve track için yeni yollar sunar.

SAM 3 modeli şu temeller üzerine kuruludur SAM ve SAM 2 'ye göre kavram segmentasyonu, açık kelime algılama ve gerçek zamanlı video izleme gibi yeni gelişmeler ve özellikler getiriyor. Kısa isim cümlelerini anlayabilir, kareler boyunca nesneleri takip edebilir ve daha önceki modellerin tutarlı bir şekilde işleyemediği ince taneli veya nadir kavramları belirleyebilir.

SAM 3 sürümünün bir parçası olarak Meta, SAM 3D'yi de tanıttı. Yeni nesil modellerden oluşan bu paket, nesneleri, sahneleri ve tüm insan vücutlarını tek bir görüntüden yeniden yapılandırıyor ve Segment Anything ekosistemini 3D anlayışına doğru genişletiyor. Bu eklemeler bilgisayarla görme, robotik, medya düzenleme ve yaratıcı iş akışlarında yeni uygulamaların önünü açıyor.

Bu makalede SAM 3'ün ne olduğunu, onu SAM 2'den ayıran özellikleri, modelin nasıl çalıştığını ve gerçek dünyadaki uygulamalarını inceleyeceğiz. Haydi başlayalım!

SAM 3, basit talimatlara dayanarak görüntü ve videolardaki nesneleri tanımlayabilen, ayırabilen ve track son teknoloji ürünü bir bilgisayarla görme modelidir. SAM 3, sabit bir etiket listesine güvenmek yerine doğal dili ve görsel ipuçlarını anlayarak modele ne bulmak istediğinizi söylemenizi kolaylaştırır.

Örneğin SAM 3 ile "sarı okul otobüsü" veya "çizgili bir kedi" gibi kısa bir ifade yazabilir, bir nesneye tıklayabilir veya bir görüntüdeki bir örneği vurgulayabilirsiniz. Model daha sonra eşleşen her nesneyi detect edecek ve temiz segmentasyon maskeleri (tam olarak hangi piksellerin bir nesneye ait olduğunu gösteren görsel bir taslak) oluşturacaktır. SAM 3 ayrıca bu nesneleri video kareleri boyunca takip edebilir ve hareket ettikçe tutarlı kalmalarını sağlayabilir.

Meta AI'nin duyurusunun bir diğer heyecan verici kısmı ise Segment Anything projesini 3D anlayışa genişleten SAM 3D. SAM 3D tek bir 2D görüntüyü alıp bir nesnenin ya da insan vücudunun şeklini, duruşunu ya da yapısını üç boyutlu olarak yeniden yapılandırabiliyor. Başka bir deyişle, model, yalnızca bir bakış açısı mevcut olduğunda bile bir şeyin alanı nasıl kapladığını tahmin edebilir.

SAM 3D iki farklı model olarak piyasaya sürüldü: Günlük eşyaları geometri ve doku ile yeniden yapılandıran SAM 3D Objects ve tek bir görüntüden insan vücudunun şeklini ve duruşunu tahmin eden SAM 3D Body. Her iki model de SAM 3'ün segmentasyon çıktısını kullanır ve ardından orijinal fotoğraftaki nesnenin görünümü ve konumuyla uyumlu bir 3B temsil oluşturur.

SAM 3'ün algılama, segmentasyon ve izlemeyi tek bir birleşik modelde bir araya getirmek için getirdiği önemli güncellemelerden bazıları şunlardır:

Diyelim ki birçok farklı hayvanın bulunduğu bir safari videosu izliyorsunuz ve sadece filleri detect edip segment ayırmak istiyorsunuz. Bu görev SAM'in farklı sürümlerinde nasıl görünür?

SAM ile, segmentasyon maskesi oluşturmak için her karedeki her filin üzerine manuel olarak tıklamanız gerekir. İzleme yoktur, bu nedenle her yeni kare yeni tıklamalar gerektirir.

SAM 2 ile bir filin üzerine bir kez tıklayabilir, maskesini alabilir ve model aynı fili video boyunca track . Ancak, SAM 2 "fil" gibi kategorileri kendi başına anlamadığından, birden fazla fili (belirli nesneleri) segment ayırmak istiyorsanız yine de ayrı tıklamalar sağlamanız gerekir.

SAM 3 ile iş akışı çok daha basit hale geliyor. Bir örnek vermek için "fil" yazabilir veya tek bir filin etrafına sınırlayıcı bir kutu çizebilirsiniz; model videodaki her fili otomatik olarak bulacak, segment ayıracak ve kareler arasında tutarlı bir şekilde track . Önceki sürümlerde kullanılan tıklama ve kutu istemlerini hala destekliyor, ancak şimdi SAM ve SAM 2'nin yapamadığı bir şey olan metin istemlerine ve örnek görüntülere de yanıt verebiliyor.

Şimdi SAM 3 modelinin nasıl çalıştığına ve nasıl eğitildiğine daha yakından bakalım.

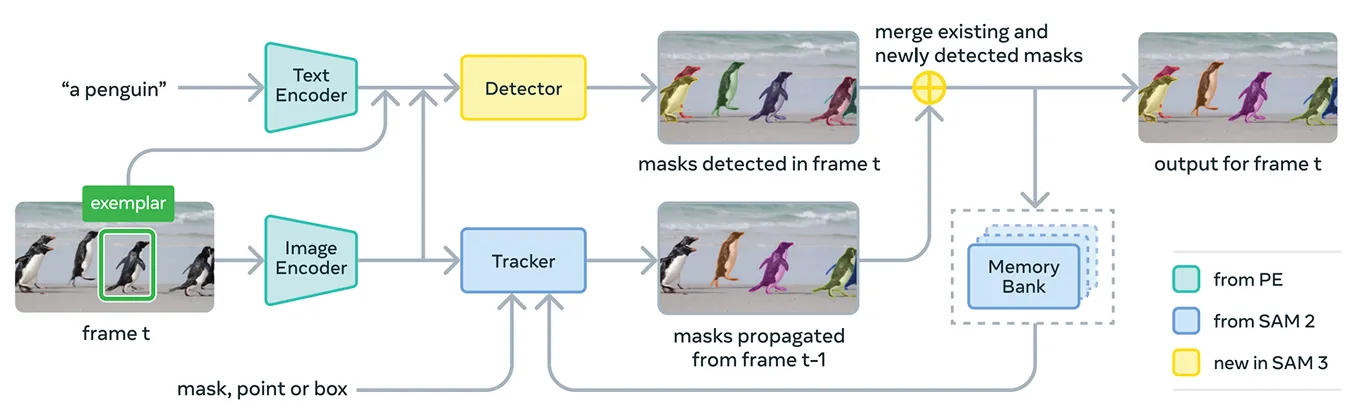

SAM 3, kavram ipuçlarını ve görsel ipuçlarını tek bir sistemde desteklemek için çeşitli bileşenleri bir araya getirir. Model, özünde Meta'nın birleşik açık kaynaklı görüntü-metin kodlayıcısı olan Meta Perception Encoder'ı kullanır.

Bu kodlayıcı hem görüntüleri hem de kısa isim cümlelerini işleyebilir. Basitçe söylemek gerekirse, bu SAM 3'ün dil ve görsel özellikleri Segment Anything Model'in önceki sürümlerinden daha etkili bir şekilde birbirine bağlamasını sağlar.

Bu kodlayıcıya ek olarak SAM 3, DETR transformatör modelleri ailesini temel alan bir dedektör içerir. Bu detektör görüntüdeki nesneleri tanımlar ve sistemin hangi nesnelerin kullanıcının komutuna karşılık geldiğini belirlemesine yardımcı olur.

Özellikle, video segmentasyonu için SAM 3, SAM 2'deki bellek bankası ve bellek kodlayıcısına dayanan bir izleme bileşeni kullanır. Bu, modelin nesneler hakkında kareler boyunca bilgi tutmasını sağlar, böylece onları zaman içinde yeniden tanımlayabilir ve track .

SAM 3'ü eğitmek için Meta'nın şu anda internette mevcut olandan çok daha fazla açıklamalı veriye ihtiyacı vardı. Yüksek kaliteli segmentasyon maskeleri ve metin etiketlerini büyük ölçekte oluşturmak zordur ve görüntü ve videolardaki bir kavramın her örneğini tam olarak özetlemek yavaş ve pahalıdır.

Bunu çözmek için Meta, SAM 3'ün kendisini, ek yapay zeka modellerini ve birlikte çalışan insan açıklamacıları birleştiren yeni bir veri motoru oluşturdu. İş akışı, SAM 3 ve Llama tabanlı bir altyazı modeli de dahil olmak üzere bir dizi yapay zeka sistemiyle başlıyor.

Bu sistemler büyük resim ve video koleksiyonlarını tarar, altyazılar oluşturur, bu altyazıları metin etiketlerine dönüştürür ve erken segmentasyon maskesi adayları üretir. İnsan ve yapay zeka yorumcuları daha sonra bu adayları gözden geçirir.

Maske kalitesini kontrol etme ve kavram kapsamını doğrulama gibi görevlerde insan doğruluğuyla eşleşecek ve hatta onu aşacak şekilde eğitilen yapay zeka açıklayıcıları, basit vakaları filtreler. İnsanlar yalnızca modelin hala zorlanabileceği daha zorlu örnekler için devreye giriyor.

Bu yaklaşım Meta'ya açıklama hızında büyük bir artış sağlıyor. Yapay zekanın kolay durumları ele almasına izin vererek, işlem hattı negatif istemlerde yaklaşık beş kat ve ince taneli alanlardaki pozitif istemlerde %36 daha hızlı hale geliyor.

Bu verimlilik, veri kümesini dört milyondan fazla benzersiz kavrama ölçeklendirmeyi mümkün kılmıştır. Yapay zeka önerilerinin, insan düzeltmelerinin ve güncellenmiş model tahminlerinin sürekli döngüsü de zaman içinde etiket kalitesini artırıyor ve SAM 3'ün çok daha geniş bir görsel ve metin tabanlı kavram setini öğrenmesine yardımcı oluyor.

Performans açısından SAM 3, önceki modellere göre net bir iyileşme sağlıyor. Meta'nın açık kelime kavram tespiti ve segmentasyonunu değerlendiren yeni SA-Co kriterinde SAM 3, hem görüntülerde hem de videolarda önceki sistemlerin yaklaşık iki katı performans elde ediyor.

Ayrıca, noktadan maskeye ve maskeden maskeye gibi etkileşimli görsel görevlerde SAM 2 ile eşleşir veya daha üstündür. Meta, sıfır atışlı LVIS (modellerin eğitim örnekleri olmadan nadir kategorileri tanıması gereken) ve nesne sayma (bir nesnenin tüm örneklerinin tespit edilip edilmediğini ölçen) gibi daha zor değerlendirmelerde ek kazanımlar bildirerek alanlar arasında daha güçlü genellemeyi vurguluyor.

Bu doğruluk iyileştirmelerine ek olarak SAM 3, 100'den fazla algılanan nesne içeren bir görüntüyü bir H200 GPU 'da yaklaşık 30 milisaniyede işleyerek ve videoda birden fazla nesneyi izlerken gerçek zamana yakın hızları koruyarak verimlidir.

Artık SAM 3'ü daha iyi anladığımıza göre, gelişmiş metin güdümlü akıl yürütmeden bilimsel araştırmalara ve Meta'nın kendi ürünlerine kadar gerçek uygulamalarda nasıl kullanıldığını inceleyelim.

SAM 3, Meta'nın SAM 3 Agent olarak adlandırdığı daha büyük bir çok modlu dil modelinin içinde bir araç olarak da kullanılabilir. SAM 3'e "fil" gibi kısa bir ifade vermek yerine, ajan daha karmaşık bir soruyu SAM 3'ün anlayabileceği daha küçük istemlere bölebilir.

Örneğin, kullanıcı "Resimdeki hangi nesne bir atı kontrol etmek ve yönlendirmek için kullanılır?" diye sorarsa, ajan farklı isim cümleleri dener, bunları SAM 3'e gönderir ve hangi maskelerin anlamlı olduğunu kontrol eder. Doğru nesneyi bulana kadar iyileştirmeye devam eder.

SAM 3 Agent, özel muhakeme veri kümeleri üzerinde eğitilmeden bile ReasonSeg ve OmniLabel gibi karmaşık metin sorguları için tasarlanmış ölçütlerde iyi performans göstermektedir. Bu, SAM 3'ün hem dil anlama hem de ince taneli görsel segmentasyona ihtiyaç duyan sistemleri destekleyebileceğini göstermektedir.

İlginç bir şekilde SAM 3, ayrıntılı görsel etiketlerin önemli olduğu araştırma ortamlarında kullanılmaya başlandı bile. Meta, Conservation X Labs ve Osa Conservation ile birlikte çalışarak 10.000'den fazla kamera tuzağı videosu içeren halka açık bir yaban hayatı izleme veri seti olan SA-FARI'yi oluşturdu.

Her karedeki her hayvan kutularla ve segmentasyon maskeleriyle etiketleniyor, bu da elle açıklama yapmanın son derece zaman alıcı olacağı bir şey. Benzer şekilde, okyanus araştırmalarında SAM 3, su altı görüntüleri için örnek segmentasyon maskeleri oluşturmak ve yeni değerlendirme kriterlerini desteklemek için FathomNet ve MBARI ile birlikte kullanılmaktadır.

Bu tür veri kümeleri, bilim insanlarının video görüntülerini daha verimli bir şekilde analiz etmelerine ve genellikle ölçekli olarak track zor olan hayvanları ve habitatları incelemelerine yardımcı olur. Araştırmacılar bu kaynakları tür tanımlama, davranış analizi ve otomatik ekolojik izleme için kendi modellerini oluşturmak üzere de kullanabilirler.

SAM 3, araştırma kullanımlarının yanı sıra Meta'nın tüketici ürünlerinde yeni özelliklere ve kullanım alanlarına da güç veriyor. İşte SAM 3'ün halihazırda entegre edildiği bazı yöntemlere bir bakış:

SAM 3, segmentasyon için heyecan verici bir adımdır. Kavram segmentasyonu, açık kelime dağarcığına sahip metin istemleri ve gelişmiş izleme özellikleri sunuyor. Hem görüntülerde hem de videolarda fark edilir derecede daha güçlü performans ve SAM 3D'nin eklenmesiyle, model paketi Vision AI, yaratıcı araçlar, bilimsel araştırmalar ve gerçek dünya ürünleri için yeni olanaklar sunuyor.

Topluluğumuza katılın ve yapay zeka hakkında daha fazlasını keşfetmek için GitHub depomuzu keşfedin. Kendi Vision AI projenizi oluşturmak istiyorsanız lisanslama seçeneklerimize göz atın. Çözüm sayfalarımızı ziyaret ederek sağlık hizmetlerinde yapay zeka ve perakendede Vision AI gibi uygulamalar hakkında daha fazlasını keşfedin.