Ultralytics'in YOLO Vision 2025 Shenzhen'den öne çıkan başlıkları!

Ultralytics 'in yenilikçileri, iş ortaklarını ve yapay zeka topluluğunu ilham dolu bir gün için bir araya getirdiği YOLO Vision 2025 Shenzhen'den önemli anları tekrar gözden geçirin.

Ultralytics 'in yenilikçileri, iş ortaklarını ve yapay zeka topluluğunu ilham dolu bir gün için bir araya getirdiği YOLO Vision 2025 Shenzhen'den önemli anları tekrar gözden geçirin.

26 Ekim'de YOLO Vision 2025 (YV25), Shenzhen'deki OCT Yaratıcı Kültür Parkı'ndaki B10 Binası'nda Çin'de ilk kez görücüye çıktı. Ultralytics'in hibrit Vision AI etkinliği 200'den fazla katılımcıyı yüz yüze bir araya getirdi ve çok daha fazlası YouTube ve Bilibili üzerinden çevrimiçi olarak katıldı.

YV25 Shenzhen canlı yayını YouTube'da şimdiden 3.500 görüntülemeyi geçti ve etkinliğin önemli noktaları topluluk genelinde paylaşıldıkça dikkat çekmeye devam ediyor. Vision AI'ın bundan sonra nereye gideceğine dair fikirler, sohbetler ve uygulamalı keşiflerle dolu bir gündü.

Gün, herkesi etkinlik boyunca bağlantı kurmaya, öğrenmeye ve tartışmalara katılmaya davet eden ev sahibimiz Huang Xueying'in sıcak karşılamasıyla başladı. Eylül ayındaki Londra etkinliğinin ardından bunun yılın ikinci YOLO Vision'ı olduğunu açıkladı ve Vision AI topluluğunu Shenzhen'de tekrar bir araya getirmenin ne kadar heyecan verici olduğunu paylaştı.

Bu makalede, model güncellemeleri, konuşmacı oturumları, canlı demolar ve herkesi bir araya getiren topluluk anları da dahil olmak üzere günün öne çıkan olaylarını tekrar gözden geçireceğiz. Hadi başlayalım!

Günün ilk açılış konuşmasını yapan Ultralytics Kurucusu ve CEO'su Glenn Jocher, Ultralytics YOLO modellerinin bir araştırma buluşundan dünyanın en yaygın kullanılan Vision AI modellerinden bazılarına nasıl dönüştüğünü paylaştı. Glenn, ilk çalışmalarının YOLO 'nun kullanımını kolaylaştırmaya odaklandığını açıkladı.

Modelleri PyTorch'a taşıdı, belgeleri geliştirdi ve her şeyi açık bir şekilde paylaştı, böylece her yerdeki geliştiriciler bunun üzerine inşa edebildi. Hatırladığı gibi, "2018'de balıklama atladım. Geleceğimin burada olduğuna karar verdim." Kişisel bir çaba olarak başlayan şey hızla küresel bir açık kaynak hareketine dönüştü.

Bugün, Ultralytics YOLO modelleri her gün milyarlarca çıkarıma güç sağlıyor ve Glenn bu ölçeğin yalnızca onu oluşturmaya yardımcı olan insanlar sayesinde mümkün olduğunu vurguladı. Dünyanın dört bir yanından araştırmacılar, mühendisler, öğrenciler, hobiciler ve açık kaynak katkıda bulunanlar YOLO 'yu bugünkü haline getirdi.

Glenn'in ifadesiyle, "Dışarıda onlardan [katkıda bulunanlardan] neredeyse bin tane var ve bunun için çok minnettarız. Bu insanlar olmasaydı bugün burada olamazdık."

Ultralytics YOLO26'ya ilk bakış bu yılın başlarında YOLO Vision 2025 Londra etkinliğinde paylaşıldı ve Ultralytics YOLO model ailesinde bir sonraki büyük adım olarak tanıtıldı. YV25 Shenzhen'de Glenn, bu duyurudan bu yana kaydedilen ilerleme hakkında bir güncelleme yaptı ve yapay zeka topluluğuna modelin nasıl geliştiğine daha yakından bakma fırsatı verdi.

YOLO26, gerçek dünyada kullanım için pratik kalırken daha küçük, daha hızlı ve daha doğru olacak şekilde tasarlanmıştır. Glenn, ekibin geçtiğimiz yılı mimariyi iyileştirmek, cihazlar arasında performans kıyaslaması yapmak ve araştırma ve topluluk geri bildirimlerinden elde edilen içgörüleri birleştirmek için harcadığını açıkladı. Amaç, modellerin dağıtımını zorlaştırmadan son teknoloji ürünü bir performans sunmak.

Glenn'in vurguladığı temel güncellemelerden biri, YOLO26'nın özel bir hiperparametre ayarlama kampanyasıyla eşleştirilerek tamamen sıfırdan eğitimden daha büyük veri kümeleri üzerinde ince ayar yapmaya geçmesidir. Bu yaklaşımın gerçek dünyadaki kullanım durumlarıyla çok daha uyumlu olduğunu belirtti.

Etkinlikte paylaşılan diğer önemli gelişmelerden bazıları şunlardır:

Bu güncellemeler birlikte, CPU 'da %43'e kadar daha hızlı olan ve aynı zamanda daha doğru olan modellerle sonuçlanır. Ultralytics YOLO11Bu da YOLO26'yı özellikle gömülü cihazlar, robotik ve uç sistemler için etkili kılıyor.

YOLO26, şu anda YOLO11'de mevcut olan tüm aynı görevleri ve model boyutlarını destekleyecek ve bu da aile genelinde 25 model çeşidi ile sonuçlanacaktır. Bunlar arasında algılama, segmentasyon, poz tahmini, yönlendirilmiş sınırlayıcı kutular ve sınıflandırma için nano boyuttan ekstra büyük boyuta kadar değişen modeller yer alıyor.

Ekip ayrıca beş uyarılabilir varyant üzerinde çalışıyor. Bunlar, bir metin komutu alabilen ve eğitime ihtiyaç duymadan doğrudan sınırlayıcı kutuları döndürebilen modellerdir.

Bu, farklı kullanım durumlarına uyarlanması daha kolay olan daha esnek, talimat tabanlı görüntü iş akışlarına yönelik erken bir adımdır. YOLO26 modelleri hala aktif geliştirme aşamasındadır, ancak ilk performans sonuçları güçlüdür ve ekip bunları yakında yayınlamak için çalışmaktadır.

YOLO26 güncellemesinden sonra Glenn, Ultralytics Platformunun canlı bir demosunu vermek üzere Ürün Mühendisliği Başkanımız Prateek Bhatnagar'ı ağırladı. Bu platform, veri kümelerini keşfetmek, görüntülere açıklama eklemek, modelleri eğitmek ve sonuçları karşılaştırmak da dahil olmak üzere bilgisayarla görme iş akışının önemli bölümlerini bir araya getirmek için oluşturulmaktadır.

Prateek, platformun Ultralytics'in açık kaynak köklerine sadık kaldığını ve geliştiricilerin birbirlerinin çalışmalarına katkıda bulunabileceği, yeniden kullanabileceği ve geliştirebileceği iki topluluk alanı, bir veri kümesi topluluğu ve bir proje topluluğu sunduğunu belirtti. Demo sırasında, yapay zeka destekli ek açıklama, kolay bulut eğitimi ve yerel GPU kaynaklarına ihtiyaç duymadan doğrudan topluluktan modellere ince ayar yapma becerisini sergiledi.

Platform şu anda geliştirme aşamasında. Prateek, dinleyicileri duyuruları izlemeye teşvik etti ve ekibin lansmanı desteklemek için Çin'de büyüdüğünü belirtti.

İvmenin artmasıyla birlikte etkinlik, farklı YOLO modellerinin arkasındaki birkaç araştırmacının yer aldığı bir panel tartışmasına dönüştü. Panelde Glenn Jocher ile birlikte Kıdemli Makine Öğrenimi Mühendisimiz Jing Qiu; Meta'da Makine Öğrenimi Mühendisi ve YOLOv10'un yazarlarından biri olan Chen Hui ve Meituan'da Algoritma Stratejisti ve YOLOv6'nın yazarlarından biri olan Bo Zhang yer aldı.

Tartışma, YOLO 'nun gerçek dünya kullanımı yoluyla nasıl gelişmeye devam ettiğine odaklandı. Konuşmacılar, ilerlemenin genellikle uç cihazlarda verimli bir şekilde çalışma, küçük nesne algılamayı iyileştirme ve model dışa aktarımını basitleştirme gibi pratik dağıtım zorlukları tarafından nasıl yönlendirildiğine değindi.

Panel, sadece doğruluk peşinde koşmak yerine, üretim ortamlarında hız, kullanılabilirlik ve güvenilirliği dengelemenin önemine dikkat çekti. Bir başka ortak çıkarım da yinelemenin ve topluluk geri bildiriminin değeriydi.

İşte sohbetten diğer bazı ilginç bilgiler:

Daha sonra, YZ topluluğundaki liderlerin dijital insanlardan robotlara, multimodal muhakemeden verimli uç dağıtımına kadar YZ'nin nasıl geliştiğini paylaştığı YV25 Shenzhen'deki açılış konuşmalarından bazılarına daha yakından bakalım.

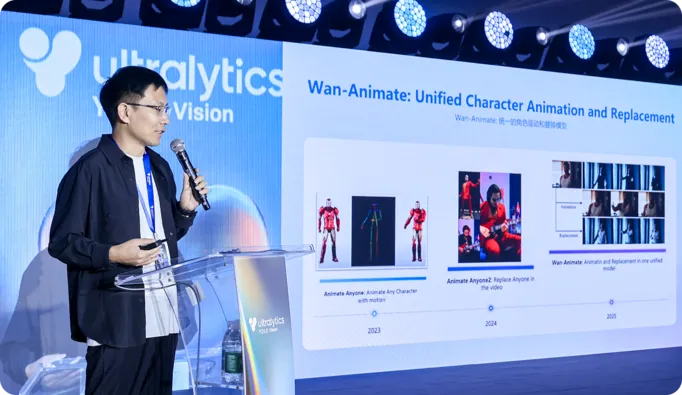

Alibaba Qwen Lab'dan Dr. Peng Zhang, aydınlatıcı bir oturumda, ekibinin daha doğal hareket ve kontrole sahip etkileyici dijital insanlar üretebilen büyük video modellerini nasıl geliştirdiğini paylaştı. Gerçekçi konuşma, jest ve animasyon üretmek için ses veya hareket referanslarını kullanan Wan S2V ve Wan Animate'i anlatarak tamamen metin odaklı üretimin sınırlamalarını ele aldı.

Dr. Zhang ayrıca, görünüm ve hareketin sıfır çekim klonlanması ve bir yüzü doğrudan canlı bir kamera akışından canlandırabilen hafif modeller de dahil olmak üzere gerçek zamanlı etkileşimli avatarlara doğru kaydedilen ilerlemeden bahsetti ve gerçekçi dijital insanları günlük cihazlarda sorunsuz bir şekilde çalışmaya yaklaştırdı.

YV25 Shenzhen'deki ana temalardan biri, dünyayı sadece gören vizyon modellerinden, onun içinde hareket edebilen sistemlere geçişti. Başka bir deyişle, algı artık boru hattının sonu değil; eylemin başlangıcı haline geliyor.

Örneğin, D-Robotics'ten Hu Chunxu açılış konuşmasında geliştirme kitlerinin ve SoC (çip üzerinde sistem) çözümlerinin algılama, gerçek zamanlı hareket kontrolü ve karar verme süreçlerini birleşik bir donanım ve yazılım yığını üzerinde nasıl entegre ettiğini anlattı. Algı ve eylemi ayrı aşamalar yerine sürekli bir geri bildirim döngüsü olarak ele alan yaklaşımları, gerçek ortamlarda daha güvenilir bir şekilde hareket edebilen, uyum sağlayabilen ve etkileşime girebilen robotları destekliyor.

Baidu Paddle'dan Alex Zhang konuşmasında bu fikri yineleyerek YOLO ve PaddleOCR'ın nesneleri detect etmek ve ardından etraflarındaki metni ve yapıyı yorumlamak için nasıl birlikte çalıştığını açıkladı. Bu, sistemlerin görüntüleri ve belgeleri lojistik, denetimler ve otomatik işleme gibi görevler için kullanılabilir, yapılandırılmış bilgilere dönüştürmesini sağlar.

YV25 Shenzhen'deki bir diğer ilginç konu da Vision AI'nin uç cihazlarda nasıl daha verimli ve yetenekli hale geldiğiydi.

DEEPX'ten Paul Jung, YOLO modellerini doğrudan gömülü donanıma dağıtarak buluta olan bağımlılığı azaltma hakkında konuştu. DEEPX, düşük güç tüketimi, optimize edilmiş çıkarım ve donanıma duyarlı model ayarlamaya odaklanarak dronlar, mobil robotlar ve dinamik ortamlarda çalışan endüstriyel sistemler için gerçek zamanlı algılama sağlıyor.

Benzer şekilde Moore Threads'ten Liu Lingfei, Moore Threads E300 platformunun kompakt cihazlarda yüksek hızlı görüntü çıkarımı sağlamak için merkezi işlem birimiCPU), grafik işlem birimi (GPU) ve sinir işleme birimi (NPU) hesaplamayı nasıl entegre ettiğini paylaştı.

Platform birden fazla YOLO akışını yüksek kare hızlarında çalıştırabilir ve araç zinciri niceleme, statik derleme ve performans ayarlama gibi adımları basitleştirir. Moore Threads ayrıca geliştiricilerin önündeki engelleri azaltmak için geniş bir bilgisayarla görme modelleri ve dağıtım örnekleri setini açık kaynaklı hale getirmiştir.

Yakın zamana kadar, hem görüntüleri anlayabilen hem de dili yorumlayabilen tek bir model oluşturmak, çalıştırması pahalı olan büyük dönüştürücü mimarileri gerektiriyordu. YV25 Shenzhen'de Yuanshi Intelligence'dan Yue Ziyin, dönüştürücülerin uzun bağlamlı muhakeme yeteneklerini tekrarlayan modellerin verimliliği ile harmanlayan bir mimari olan RWKV'ye genel bir bakış sundu.

Vision-RWKV'nin görüntüleri çözünürlükle doğrusal olarak ölçeklenecek şekilde işleyerek bu tasarımı bilgisayarla görmeye nasıl uyguladığını açıkladı. Bu da onu yüksek çözünürlüklü girdiler ve hesaplamanın sınırlı olduğu uç cihazlar için uygun hale getiriyor.

Yue ayrıca, nesne algılamanın ötesine geçerek sahneleri, belgeleri ve gerçek dünya bağlamını yorumlamak için görüntü özelliklerinin metin anlama ile eşleştirildiği görsel-dil sistemlerinde RWKV'nin nasıl kullanıldığını gösterdi.

Sahnede yapılan konuşmalar vizyon yapay zekasının nereye gittiğine dair ileriye bakarken, zemindeki stantlar bugün zaten nasıl kullanıldığını gösterdi. Katılımcılar canlı çalışan modelleri görme, donanım seçeneklerini karşılaştırma ve bu sistemleri inşa eden ekiplerle doğrudan konuşma fırsatı buldu.

İşte sergilenen teknolojiye bir bakış:

Tüm heyecan verici teknolojilere ek olarak, YV25 Shenzhen'in en iyi yanlarından biri de bilgisayarla görme topluluğunu ve Ultralytics ekibini tekrar yüz yüze bir araya getirmekti. Gün boyunca insanlar demoların etrafında toplandı, kahve molaları sırasında fikirlerini paylaştı ve konuşmalar bittikten sonra da sohbetler devam etti.

Araştırmacılar, mühendisler, öğrenciler ve inşaatçılar notlarını karşılaştırdı, sorular sordu ve dağıtımdan model eğitimine kadar gerçek dünya deneyimlerini paylaştı. Grupo Osborne'dan Cinco Jotas sayesinde etkinliğe taze oyulmuş jamón ile İspanyol kültüründen bir dokunuş bile getirdik ve sıcak bir bağlantı anı yarattık. Güzel bir mekan, coşkulu bir kalabalık ve ortak bir ivme duygusu günü gerçekten özel kıldı.

İlham verici açılış konuşmalarından uygulamalı demolara kadar YOLO Vision 2025 Shenzhen, Ultralytics topluluğunu tanımlayan inovasyon ruhunu yakaladı. Gün boyunca, konuşmacılar ve katılımcılar fikir alışverişinde bulundular, yeni teknolojileri keşfettiler ve yapay zekanın geleceği için ortak bir vizyon üzerinde bağlantı kurdular. Birlikte, enerjik ve Ultralytics YOLO ile bir sonraki adım için hazır ayrıldılar.

Yapay zeka ve bilgisayar görüşü ile nelerin mümkün olduğunu yeniden hayal edin. Daha fazlasını keşfetmek için topluluğumuza ve GitHub depomuza katılın. Tarımda yapay görme ve perakendede yapay zeka gibi uygulamalar hakkında daha fazla bilgi edinin. Lisanslama seçenek lerimizi keşfedin ve bilgisayarla görmeyi bugün kullanmaya başlayın!