اكتشف كيف يسهّل SAM 3، وهو نموذج Segment Anything Model الجديد من Meta AI، detect الأجسام segment track عبر الصور ومقاطع الفيديو في العالم الحقيقي.

اكتشف كيف يسهّل SAM 3، وهو نموذج Segment Anything Model الجديد من Meta AI، detect الأجسام segment track عبر الصور ومقاطع الفيديو في العالم الحقيقي.

في 19 نوفمبر 2025، أصدرت Meta AI نموذج Segment Anything Model 3، المعروف أيضًا باسم SAM 3. يقدم هذا الإصدار الأخير من نموذج Segment Anything Model طرقًا جديدة detect الأجسام في الصور ومقاطع الفيديو في العالم الحقيقي segment track باستخدام مطالبات نصية ومطالبات مرئية وأمثلة للصور.

يعتمد نموذج SAM 3 على SAM و SAM 2، ويجلب تطورات وميزات جديدة مثل تجزئة المفاهيم، واكتشاف المفردات المفتوحة، وتتبع الفيديو في الوقت الفعلي. ويمكنه فهم عبارات الأسماء القصيرة، وتتبع الكائنات عبر الإطارات، وتحديد المفاهيم الدقيقة أو النادرة التي لم تستطع النماذج السابقة التعامل معها بشكل متسق.

كجزء من إصدار SAM 3، قدمت Meta أيضًا SAM 3D. تعمل هذه المجموعة من نماذج الجيل التالي على إعادة بناء الأجسام والمشاهد والأجسام البشرية الكاملة من صورة واحدة وتوسّع نظام Segment Anything البيئي إلى فهم ثلاثي الأبعاد. تفتح هذه الإضافات تطبيقات جديدة عبر الرؤية الحاسوبية والروبوتات وتحرير الوسائط وسير العمل الإبداعي.

في هذه المقالة، سوف نستكشف ما هو SAM 3، وما الذي يميزه عن SAM 2، وكيف يعمل النموذج، وتطبيقاته في العالم الحقيقي. لنبدأ!

SAM 3 هو نموذج متطور للرؤية الحاسوبية يمكنه تحديد وفصل track الأشياء في الصور ومقاطع الفيديو بناءً على تعليمات بسيطة. وبدلاً من الاعتماد على قائمة ثابتة من التسميات، يفهم SAM 3 اللغة الطبيعية والإشارات البصرية، مما يجعل من السهل إخبار النموذج بما تريد العثور عليه.

على سبيل المثال، باستخدام SAM 3، يمكنك كتابة عبارة قصيرة مثل "حافلة مدرسية صفراء" أو "قطة مخططة"، أو النقر على كائن ما، أو تمييز مثال في صورة. سيقوم النموذج بعد ذلك detect كل كائن مطابق وإنشاء أقنعة تجزئة نظيفة (مخطط مرئي يوضح بالضبط وحدات البكسل التي تنتمي إلى كائن ما). يمكن SAM 3 أيضاً تتبُّع هذه الكائنات عبر إطارات الفيديو، مع الحفاظ على اتساقها أثناء تحركها.

جزء آخر مثير آخر من إعلان Meta AI هو SAM 3D، الذي يوسع مشروع Segment Anything ليشمل الفهم ثلاثي الأبعاد. يمكن أن يأخذ SAM 3D صورة واحدة ثنائية الأبعاد ويعيد بناء شكل أو وضعية أو بنية جسم ما أو جسم الإنسان في ثلاثة أبعاد. وبعبارة أخرى، يمكن للنموذج تقدير كيفية شغل شيء ما للفضاء حتى في حالة توفر وجهة نظر واحدة فقط.

تم إصدار SAM 3D كنموذجين مختلفين: SAM 3D Objects، الذي يُعيد بناء العناصر اليومية مع الهندسة والملمس الهندسي، و SAM 3D Body، الذي يُقدّر شكل جسم الإنسان ووضعه من صورة واحدة. ويستخدم كلا النموذجين مخرجات التجزئة من SAM 3، ثم ينشئان تمثيلاً ثلاثي الأبعاد يتوافق مع مظهر وموضع الجسم في الصورة الأصلية.

فيما يلي بعض التحديثات الرئيسية التي يقدمها SAM 3 لدمج الاكتشاف والتجزئة والتتبع معًا في نموذج واحد موحد:

لنفترض أنك تشاهد فيديو سفاري به العديد من الحيوانات المختلفة، وتريد detect الأفيال segment فقط. كيف ستبدو هذه المهمة عبر الإصدارات المختلفة من SAM

باستخدام SAM ستحتاج إلى النقر يدويًا على كل فيل في كل إطار لإنشاء قناع تجزئة. لا يوجد تتبع، لذا فإن كل إطار جديد يتطلب نقرات جديدة.

باستخدام SAM 2، يمكنك النقر مرة واحدة على فيل، والحصول على قناعه، وسيقوم النموذج track هذا الفيل نفسه عبر الفيديو. ومع ذلك، ستظل بحاجة إلى توفير نقرات منفصلة إذا أردت segment عدة أفيال (كائنات محددة)، لأن SAM 2 لا يفهم فئات مثل "فيل" بمفرده.

مع SAM 3، يصبح سير العمل أبسط بكثير. يمكنك كتابة كلمة "فيل" أو رسم مربع محدّد حول فيل واحد لتقديم مثال، وسيعثر النموذج تلقائيًا على كل فيل في الفيديو، segment track بشكل متسق عبر الإطارات. لا يزال يدعم مطالبات النقر والمربعات المستخدمة في الإصدارات السابقة، ولكن الآن يمكنه أيضًا الاستجابة للمطالبات النصية والصور النموذجية، وهو أمر لم يتمكن SAM و SAM 2 من القيام به.

بعد ذلك، دعنا نلقي نظرة فاحصة على كيفية عمل نموذج SAM 3 وكيفية تدريبه.

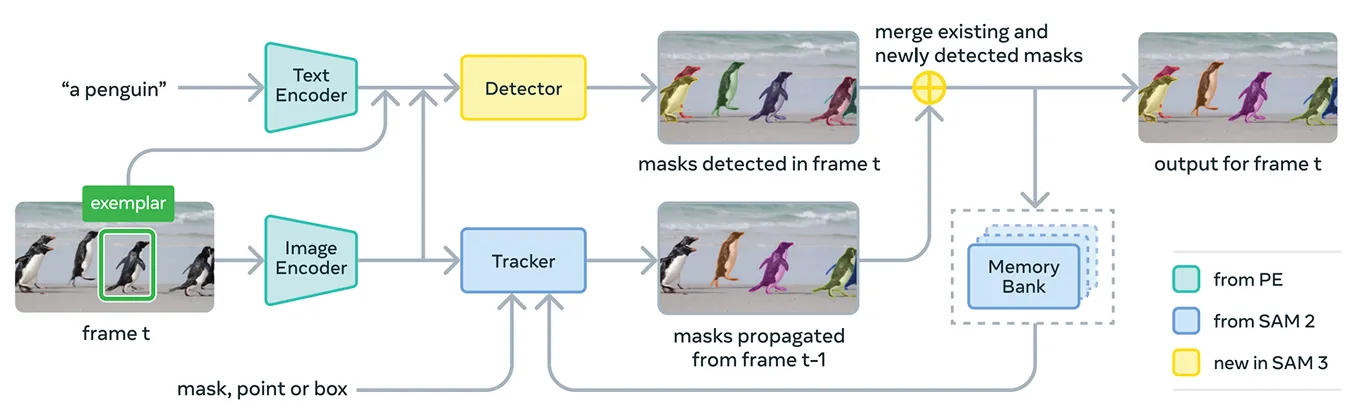

يجمع SAM 3 عدة مكونات معًا لدعم مطالبات المفاهيم والمطالبات المرئية في نظام واحد. ويستخدم النموذج في جوهره برنامج Meta Perception Encoder، وهو برنامج Meta لتشفير النصوص والصور الموحّد مفتوح المصدر.

يمكن لهذا المشفر معالجة كل من الصور والعبارات الاسمية القصيرة. ببساطة، يسمح هذا ببساطة SAM 3 بالربط بين اللغة والميزات المرئية بشكل أكثر فعالية من الإصدارات السابقة من نموذج Segment Anything.

بالإضافة إلى أداة التشفير هذه، يتضمن SAM 3 كاشفًا يستند إلى عائلة DETR من نماذج المحولات. يحدد هذا الكاشف الأجسام الموجودة في الصورة ويساعد النظام على تحديد الأجسام التي تتوافق مع مطالبة المستخدم.

على وجه التحديد، بالنسبة لتجزئة الفيديو، يستخدم SAM 3 مكوّن تتبع يعتمد على بنك الذاكرة ومشفّر الذاكرة من SAM 2. يتيح ذلك للنموذج الاحتفاظ بمعلومات حول الكائنات عبر الإطارات حتى يتمكن من إعادة تحديدها track بمرور الوقت.

لتدريب SAM 3، تحتاج Meta إلى بيانات مشروحة أكثر بكثير مما هو موجود حاليًا على الإنترنت. من الصعب إنشاء أقنعة تجزئة عالية الجودة وتسميات نصية عالية الجودة على نطاق واسع، كما أن تحديد كل مثيل لمفهوم ما في الصور ومقاطع الفيديو بطيء ومكلف.

ولحل هذه المشكلة، قامت شركة Meta ببناء محرك بيانات جديد يجمع بين SAM 3 نفسه ونماذج الذكاء الاصطناعي الإضافية والمشرحين البشريين الذين يعملون معًا. ويبدأ سير العمل بمجموعة من أنظمة الذكاء الاصطناعي، بما في ذلك SAM 3 ونموذج التعليق التوضيحي القائم على Llama.

تقوم هذه الأنظمة بفحص مجموعات كبيرة من الصور ومقاطع الفيديو، وإنشاء تعليقات توضيحية وتحويل تلك التعليقات إلى تسميات نصية، وإنتاج أقنعة تجزئة مرشحة في وقت مبكر. ثم يقوم الشارحون البشريون والذكاء الاصطناعي بمراجعة هذه التسميات المرشحة.

يقوم شرّاح الذكاء الاصطناعي، المدربون على مطابقة الدقة البشرية أو حتى تجاوزها في مهام مثل التحقق من جودة القناع والتحقق من تغطية المفاهيم، بتصفية الحالات المباشرة. يتدخل البشر فقط في الأمثلة الأكثر صعوبة حيث قد لا يزال النموذج يعاني.

يمنح هذا النهج Meta دفعة كبيرة في سرعة التعليق التوضيحي. من خلال السماح لمشرحي الذكاء الاصطناعي بالتعامل مع الحالات السهلة، يصبح خط الأنابيب أسرع بحوالي خمسة أضعاف في المطالبات السلبية و36% أسرع في المطالبات الإيجابية في المجالات الدقيقة.

مكّنت هذه الكفاءة من توسيع نطاق مجموعة البيانات إلى أكثر من أربعة ملايين مفهوم فريد. كما أن الحلقة المستمرة من مقترحات الذكاء الاصطناعي والتصحيحات البشرية والتنبؤات النموذجية المحدّثة تحسّن جودة التسمية بمرور الوقت وتساعد SAM 3 على تعلم مجموعة أوسع بكثير من المفاهيم المرئية والنصية.

فيما يتعلق بالأداء، يقدم SAM 3 تحسناً واضحاً مقارنةً بالنماذج السابقة. في معيار SA-Co الجديد من Meta، الذي يقيّم اكتشاف المفاهيم المفتوحة المفردات وتجزئتها، يحقق SAM 3 ضعف أداء الأنظمة السابقة تقريبًا في كل من الصور والفيديو.

كما أنه يتطابق أو يتجاوز SAM 2 في المهام البصرية التفاعلية مثل الإشارة إلى القناع والقناع إلى القناع. يُبلغ Meta عن مكاسب إضافية في التقييمات الأصعب مثل تقييمات LVIS الصفرية (حيث يجب على النماذج التعرف على الفئات النادرة دون أمثلة تدريبية) وعدّ الكائنات (قياس ما إذا تم اكتشاف جميع حالات الكائن)، مما يسلط الضوء على تعميم أقوى عبر المجالات.

وبالإضافة إلى هذه التحسينات في الدقة، يتميز SAM 3 بالكفاءة، حيث يعالج صورة تحتوي على أكثر من 100 جسم مكتشف في حوالي 30 مللي ثانية على GPU H200 ويحافظ على سرعات قريبة من الوقت الحقيقي عند تتبع أجسام متعددة في الفيديو.

والآن بعد أن أصبح لدينا فهم أفضل لـ SAM 3، دعونا نستعرض كيفية استخدامه في التطبيقات الحقيقية، بدءًا من الاستدلال المتقدم الموجه للنصوص إلى البحث العلمي ومنتجات Meta الخاصة.

يمكن أيضًا استخدام SAM 3 كأداة داخل نموذج لغوي أكبر متعدد الوسائط، وهو ما يُطلق عليه Meta اسم وكيل SAM 3. فبدلاً من إعطاء SAM 3 عبارة قصيرة مثل "فيل"، يمكن للوكيل تقسيم سؤال أكثر تعقيداً إلى مطالبات أصغر يفهمها SAM 3.

على سبيل المثال، إذا سأل المستخدم: "ما هو الكائن الموجود في الصورة الذي يُستخدم للتحكم في الحصان وتوجيهه؟" يقوم الوكيل بتجربة عبارات اسمية مختلفة، ويرسلها إلى SAM 3، ويتحقق من الأقنعة التي تبدو منطقية. ويستمر في التنقيح حتى يجد الكائن الصحيح.

حتى من دون أن يتم تدريبه على مجموعات بيانات استدلالية خاصة، فإن وكيل SAM 3 يحقق أداءً جيدًا في المعايير المصممة للاستعلامات النصية المعقدة، مثل ReasonSeg و OmniLabel. وهذا يدل على أن SAM 3 يمكنه دعم الأنظمة التي تحتاج إلى فهم اللغة والتجزئة البصرية الدقيقة.

ومن المثير للاهتمام أن SAM 3 يُستخدم بالفعل في إعدادات بحثية حيث التسميات المرئية المفصلة مهمة. عملت شركة Meta مع مختبرات Conservation X Labs و Osa Conservation لبناء SA-FARI، وهي مجموعة بيانات عامة لرصد الحياة البرية تضم أكثر من 10000 مقطع فيديو مصيدة بالكاميرات.

يتم تمييز كل حيوان في كل إطار بمربعات وأقنعة تجزئة، وهو أمر يستغرق وقتاً طويلاً للغاية في التعليق التوضيحي يدوياً. وبالمثل، في أبحاث المحيطات، يتم استخدام SAM 3 جنبًا إلى جنب مع FathomNet و MBARI لإنشاء أقنعة تجزئة مثيلة للصور تحت الماء ودعم معايير التقييم الجديدة.

تساعد مجموعات البيانات هذه العلماء على تحليل لقطات الفيديو بكفاءة أكبر ودراسة الحيوانات والموائل التي يصعب عادةً track على نطاق واسع. يمكن للباحثين أيضًا استخدام هذه الموارد لبناء نماذجهم الخاصة لتحديد الأنواع وتحليل السلوك والمراقبة البيئية الآلية.

بالإضافة إلى استخداماته البحثية، يعمل SAM 3 أيضًا على تشغيل ميزات وحالات استخدام جديدة عبر منتجات Meta الاستهلاكية. إليك لمحة عن بعض الطرق التي يتم دمجها بالفعل:

يُعد SAM 3 خطوة مثيرة إلى الأمام في التجزئة. فهي تُقدِّم تجزئة المفاهيم، ومطالبات نصية مفتوحة المفردات، وتتبُّع محسَّن. مع أداء أقوى بشكل ملحوظ عبر كل من الصور والفيديو، وإضافة SAM 3D، تفتح مجموعة النماذج إمكانيات جديدة للذكاء الاصطناعي للرؤية، والأدوات الإبداعية، والبحث العلمي، والمنتجات الواقعية.

انضم إلى مجتمعنا واستكشف مستودع GitHub الخاص بنا لاكتشاف المزيد عن الذكاء الاصطناعي. إذا كنت تتطلع إلى إنشاء مشروعك الخاص بالذكاء الاصطناعي المرئي الخاص بك، تحقق من خيارات الترخيص لدينا. استكشف المزيد حول تطبيقات مثل الذكاء الاصطناعي في الرعاية الصحية والذكاء الاصطناعي المرئي في البيع بالتجزئة من خلال زيارة صفحات الحلول الخاصة بنا.