Grundlagen der Kantendetektion in der Bildverarbeitung verstehen

Kantenerkennung in der Bildverarbeitung. Lernen Sie Sobel-, Canny- und andere Kantenerkennungsalgorithmen kennen, um Kanten genau detect und eine robuste Kantenerkennung zu erreichen.

Kantenerkennung in der Bildverarbeitung. Lernen Sie Sobel-, Canny- und andere Kantenerkennungsalgorithmen kennen, um Kanten genau detect und eine robuste Kantenerkennung zu erreichen.

Als Menschen erkennen wir beim Betrachten eines Bildes auf natürliche Weise die Kanten von Objekten, folgen ihren Kurven und nehmen die Texturen auf ihren Oberflächen wahr. Für einen Computer beginnt das Verständnis jedoch auf der Ebene der einzelnen Pixel.

Ein Pixel, die kleinste Einheit eines digitalen Bildes, speichert Farbe und Helligkeit an einem einzigen Punkt. Durch die Verfolgung von Änderungen dieser Pixelwerte über ein Bild hinweg kann ein Computer Muster detect , die wichtige Details offenbaren.

Insbesondere die Bildverarbeitung verwendet Pixeldaten, um wesentliche Merkmale hervorzuheben und Ablenkungen zu entfernen. Eine gängige Technik der Bildverarbeitung ist die Kantenerkennung, die Punkte identifiziert, an denen sich Helligkeit oder Farbe stark ändern, um Objekte zu umreißen, Grenzen zu markieren und Strukturen hinzuzufügen.

Dies ermöglicht es Computern, Formen zu trennen, Dimensionen zu messen und zu interpretieren, wie Teile einer Szene miteinander verbunden sind. Die Kantenerkennung ist oft der erste Schritt in der fortgeschrittenen Bildanalyse.

In diesem Artikel werden wir uns ansehen, was Kantenerkennung ist, wie sie funktioniert und welche realen Anwendungen es gibt. Los geht's!

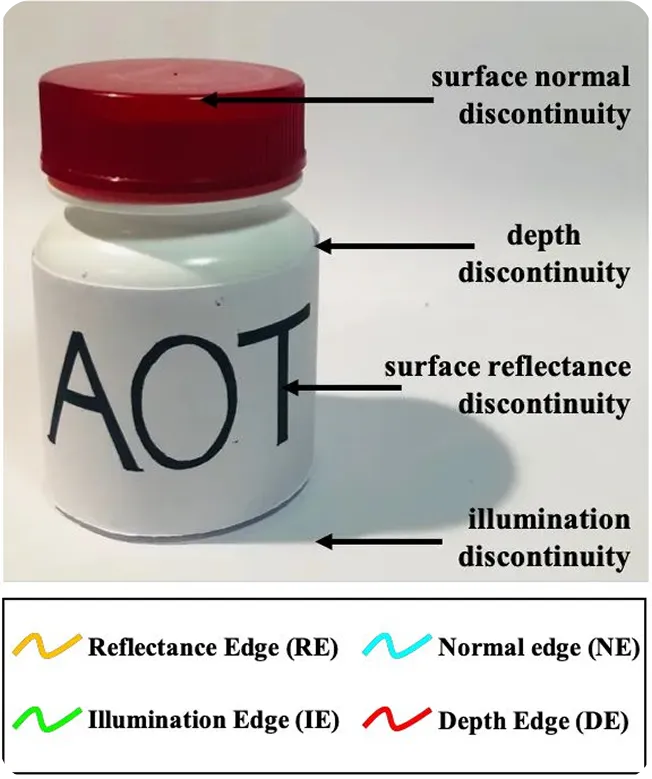

Die Kantenerkennung konzentriert sich auf die Suche nach Stellen in einem Bild, an denen sich Helligkeit oder Farbe merklich von einem Punkt zum nächsten ändert. Wenn die Änderung gering ist, wirkt der Bereich glatt. Wenn die Änderung stark ist, markiert sie oft die Grenze zwischen zwei verschiedenen Regionen.

Hier sind einige Gründe, warum diese Pixeländerungen auftreten:

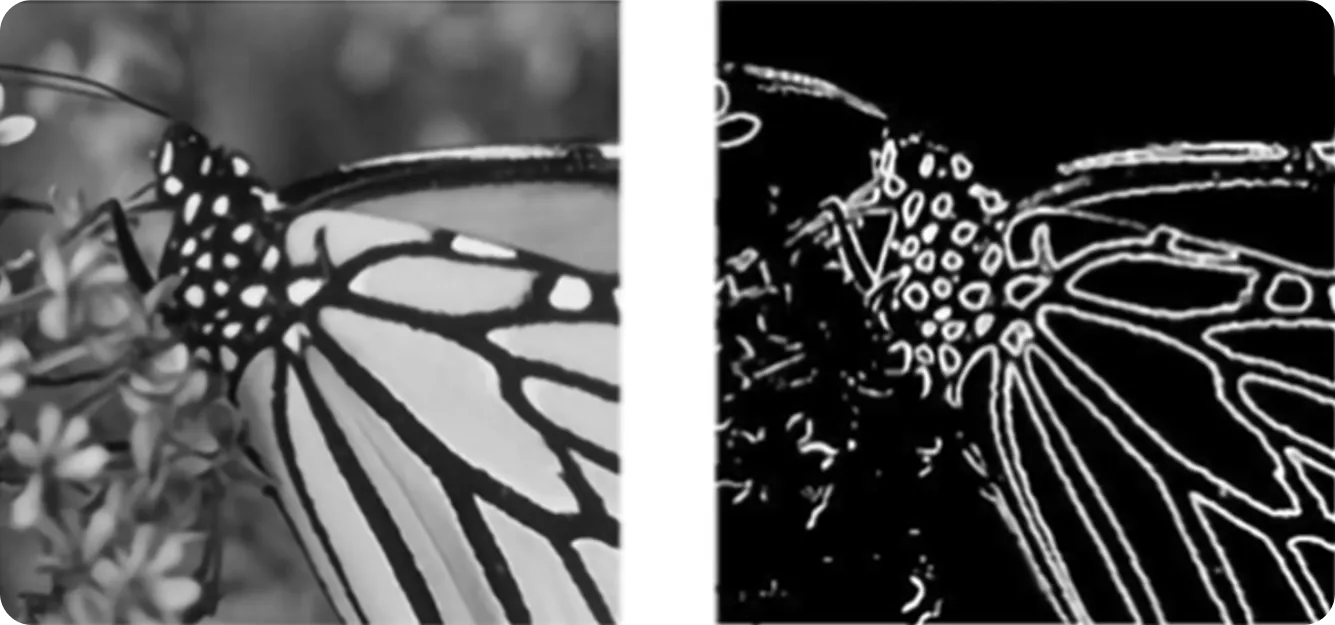

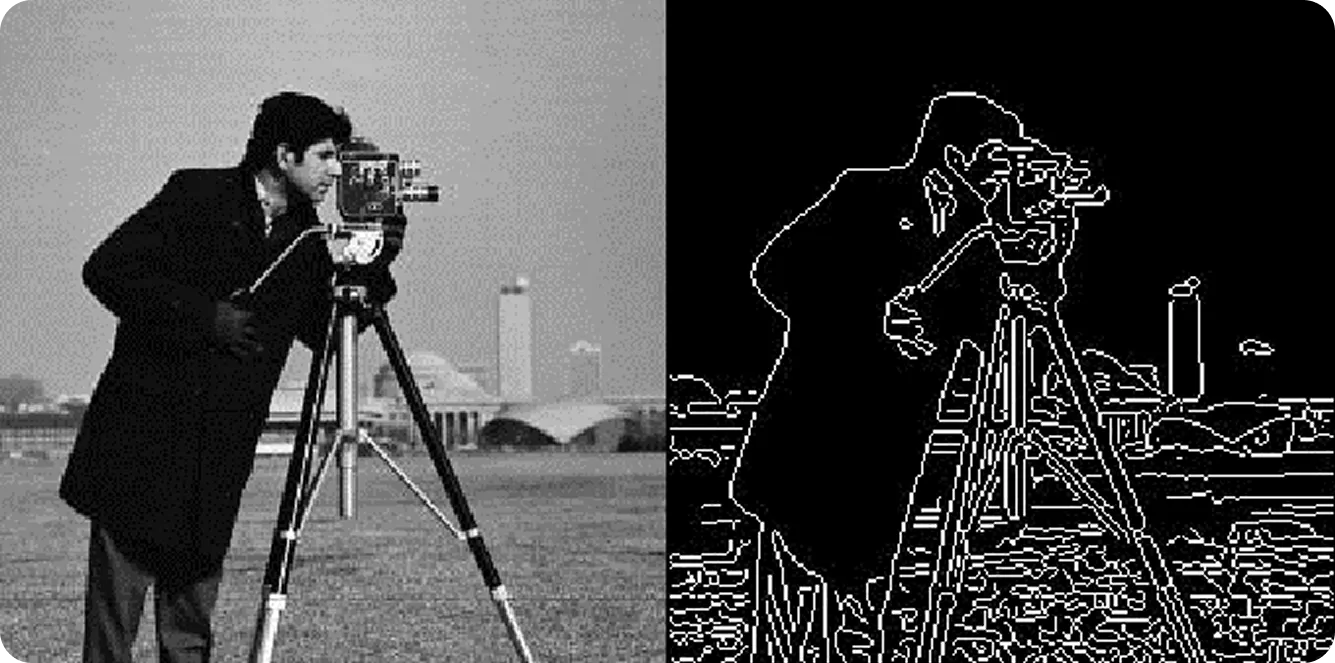

Die Kantenerkennung beginnt in der Regel damit, ein Farbbild in ein Graustufenbild umzuwandeln, sodass jeder Punkt nur die Helligkeit anzeigt. Dies erleichtert es dem Algorithmus, sich auf Helligkeits- und Dunkelheitsunterschiede anstelle von Farben zu konzentrieren.

Als Nächstes können spezielle Filter das Bild scannen, um Stellen zu finden, an denen sich die Helligkeit plötzlich ändert. Diese Filter berechnen, wie stark sich die Helligkeit ändert, was als Gradient bezeichnet wird. Ein höherer Gradient wird durch einen größeren Unterschied zwischen nahegelegenen Punkten verursacht, was oft ein Signal für eine Kante ist.

Der Algorithmus verfeinert dann das Bild weiter, entfernt kleine Details und behält nur die wichtigsten Linien und Formen bei. Das Ergebnis ist eine klare Kontur und ein Ausgabebild, das für weitere Analysen verwendet werden kann.

Bevor wir uns eingehender mit der Kantenerkennung befassen, wollen wir erörtern, wie sie sich im Laufe der Zeit entwickelt hat.

Die Bildverarbeitung begann mit einfachen, regelbasierten Methoden wie Thresholding und Filterung, um Bilder zu bereinigen und zu verbessern. Im analogen Zeitalter bedeutete dies, mit Fotos oder Filmen unter Verwendung von optischen Filtern, Vergrößerungsgläsern oder chemischen Behandlungen zu arbeiten, um Details herauszuarbeiten.

Techniken wie Kontrastanpassung, Rauschunterdrückung, Anpassung der Bildintensität und grundlegende Kantenerkennung trugen dazu bei, die Eingangsbilder klarer zu machen und Formen und Texturen hervorzuheben. In den 1960er und 70er Jahren eröffnete der Übergang von der analogen zur digitalen Verarbeitung den Weg für moderne Analysen in Bereichen wie Astronomie, medizinische Bildgebung und Satellitenüberwachung.

In den 1980er und 90er Jahren ermöglichten schnellere Computer die Bewältigung komplexerer Aufgaben wie Merkmalsextraktion, Formerkennung und grundlegende Objekterkennung. Algorithmen wie der Sobel-Operator und Canny boten eine präzisere Kantenerkennung, während die Mustererkennung in Bereichen von der industriellen Automatisierung bis zum Lesen von gedrucktem Text durch optische Zeichenerkennung Anwendung fand.

Heute haben stetige Fortschritte in der Technologie zur Entwicklung von Computer Vision geführt. Vision AI oder Computer Vision ist ein Zweig der KI, der sich darauf konzentriert, Maschinen das Interpretieren und Verstehen visueller Informationen beizubringen.

Während die traditionelle Bildverarbeitung, wie z. B. Double Thresholding (das Bilder klarer macht, indem es starke Kanten beibehält und schwache entfernt) und die Kantendetektion, festen Regeln folgte und nur bestimmte Aufgaben bewältigen konnte, verwendet Computer Vision datengesteuerte Modelle, die aus Beispielen lernen und sich an neue Situationen anpassen können.

Heutzutage gehen bildgebende Systeme weit über die bloße Verbesserung von Bildern oder die Erkennung von Kanten hinaus. Sie können Objekte erkennen, Bewegungen track und den Kontext einer ganzen Szene verstehen.

Eine der wichtigsten Techniken, die dies ermöglichen, ist die Faltung (Convolution). Eine Faltungsoperation ist ein Prozess, bei dem kleine Filter (auch Kernel genannt) ein Bild scannen, um wichtige Muster wie Kanten, Ecken und Texturen zu finden. Diese Muster werden zu den Bausteinen, die Computer-Vision-Modelle verwenden, um Objekte zu erkennen und zu verstehen.

Zum Beispiel können Computer-Vision-Modelle wie Ultralytics YOLO11 verwenden diese auf Faltung basierenden Merkmale, um fortgeschrittene Aufgaben wie die Segmentierung von Objekten durchzuführen. Dies steht in engem Zusammenhang mit der Kantendetektion, denn die Segmentierung von Objekten erfordert eine genaue Abgrenzung der Grenzen jedes Objekts in einem Bild.

Während sich die Kantenerkennung darauf konzentriert, Intensitätsänderungen in Kantenpixeln zu finden, um Objektkanten zu markieren, baut die Instanzsegmentierung auf dieser Idee auf, um Kanten detect , classify und jedes Objekt in seine eigene Region zu trennen.

Selbst mit dem Wachstum von Computer Vision ist die Bildverarbeitung immer noch ein wichtiger Bestandteil vieler Anwendungen. Das liegt daran, dass Computer Vision oft auf grundlegenden Bildvorverarbeitungsschritten aufbaut.

Vor dem Erkennen von Objekten oder dem Verstehen einer Szene bereinigen Systeme in der Regel das Bild, reduzieren Rauschen und finden Kanten, um wichtige Details hervorzuheben. Diese Schritte machen fortschrittliche Modelle genauer und effizienter.

Als Nächstes wollen wir uns einige der gebräuchlichsten Bildverarbeitungsalgorithmen ansehen, die zur detect Kanten verwendet werden, und wie sie funktionieren.

Die Sobel-Kantendetektion ist eine Schlüsselmethode, um die Konturen von Objekten in einem Bild zu finden. Anstatt jedes Detail auf einmal zu analysieren, konzentriert sie sich auf Bereiche, in denen sich die Helligkeit von einem Pixel zum nächsten benachbarten Pixel stark ändert.

Diese plötzlichen Veränderungen markieren in der Regel den Punkt, an dem ein Objekt endet und ein anderes beginnt oder an dem ein Objekt auf den Hintergrund trifft. Durch die Isolierung dieser Kanten wandelt Sobel ein komplexes Bild in eine sauberere Kontur um, die für andere Systeme leichter zu verarbeiten ist, z. B. für die Verfolgung von Bewegungen, die Erkennung von Formen oder die Erkennung von Objekten.

Man kann sich die Sobel-Kantenerkennung als einen Gradientendetektor vorstellen, der misst, wie sich die Intensität über ein Bild verändert. Im Kern funktioniert dies durch eine Faltungsoperation: Kleine Matrizen, so genannte Kernel, werden über das Bild geschoben und gewichtete Summen benachbarter Pixelwerte berechnet.

Diese Kernel sind so konzipiert, dass sie Helligkeitsänderungen entlang horizontaler und vertikaler Richtungen hervorheben. Im Gegensatz zu Deep-Learning-Modellen, bei denen Kernel aus Daten gelernt werden, verwendet Sobel feste Kernel, um Kanten effizient hervorzuheben, ohne dass ein Training erforderlich ist.

Hier ist eine genauere Betrachtung der Funktionsweise der Sobel-Kantenerkennungsmethode:

Die Canny-Kantenerkennung ist eine weitere beliebte Methode, um Kanten in einem Bild zu finden. Sie ist dafür bekannt, saubere und präzise Konturen zu erzeugen. Im Gegensatz zu einfachen Kantenerkennungstechniken folgt sie einer Reihe sorgfältig entwickelter Schritte, um Rauschen herauszufiltern, Grenzen zu schärfen und sich auf die wichtigsten Kanten zu konzentrieren.

Hier ist ein kurzer Überblick über die Funktionsweise eines Canny-Kantendetektors:

Da die Canny-Kantenerkennung genaue Ergebnisse liefert und gleichzeitig Rauschen herausfiltert, wird sie häufig in Bereichen eingesetzt, in denen Präzision wichtig ist. Sie wird beispielsweise in Branchen wie der medizinischen Bildgebung, der Satellitenkartierung, dem Scannen von Dokumenten und der Robot Vision eingesetzt.

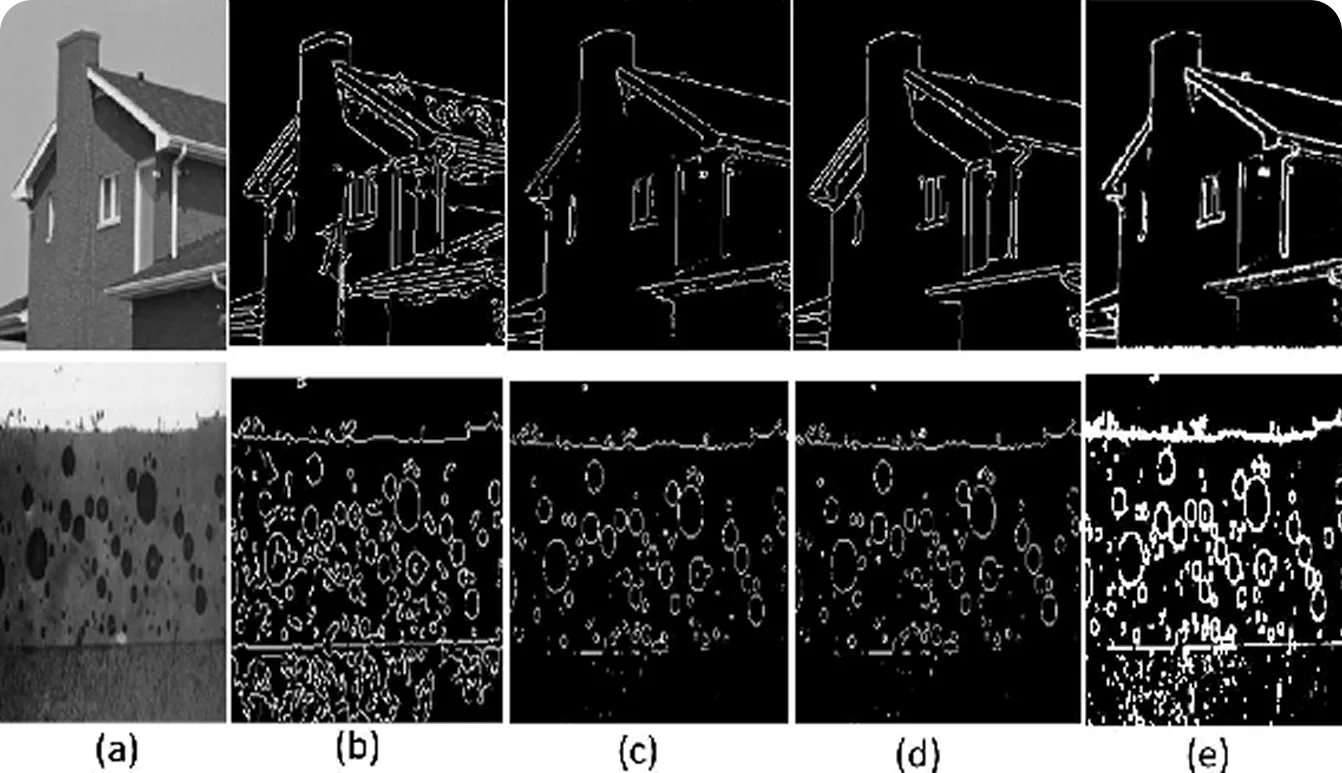

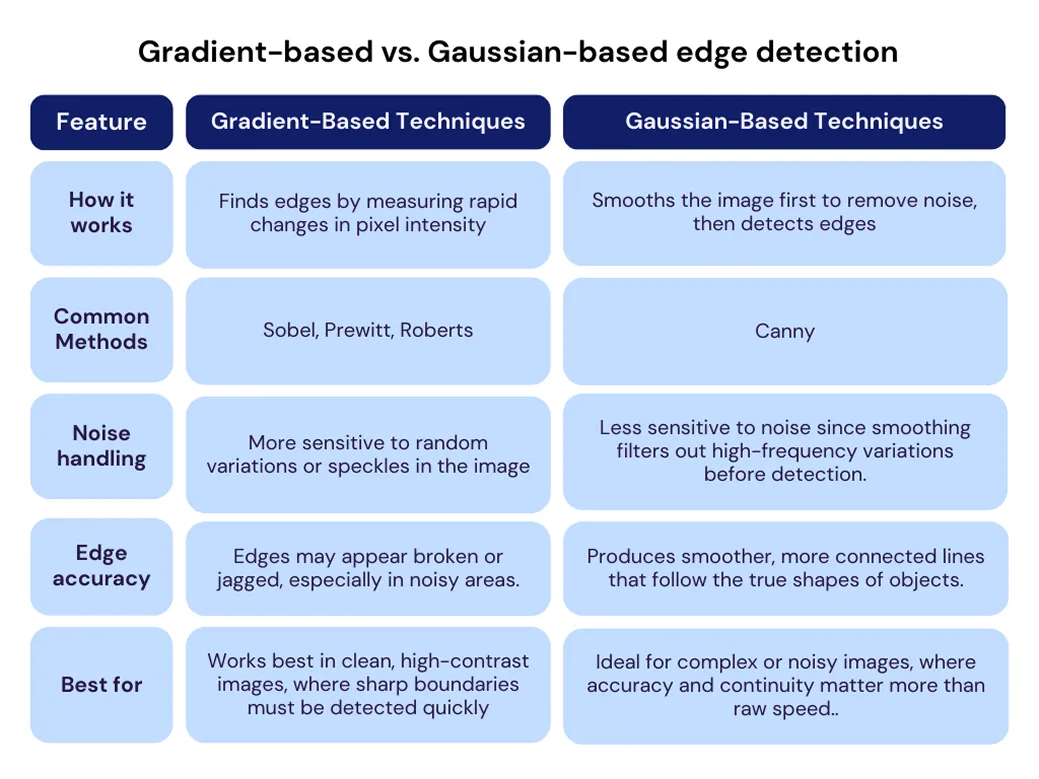

Bisher haben wir uns Sobel und Canny als zwei Beispiele für die Kantendetektion angesehen. Obwohl beide darauf abzielen, Kanten zu finden, gehen sie das Problem unterschiedlich an.

Gradientenbasierte Methoden (wie Sobel, Prewitt und Scharr) detect Kanten, indem sie nach starken Helligkeitsveränderungen, dem sogenannten Gradienten, suchen. Sie scannen das Bild und markieren die Stellen, an denen diese Veränderung am stärksten ist. Diese Methoden sind einfach, schnell und funktionieren gut, wenn die Bilder klar sind. Sie sind jedoch empfindlich gegenüber Rauschen - winzige Helligkeitsschwankungen können fälschlicherweise für Kanten gehalten werden.

Gauß-basierte Methoden (wie Canny oder Laplacian of Gaussian) fügen einen zusätzlichen Schritt hinzu, um dieses Problem zu behandeln: zuerst das Bild zu verwischen. Diese Glättung, die oft mit einem Gauß-Filter durchgeführt wird, reduziert kleine Variationen, die falsche Kanten erzeugen könnten. Nach der Glättung suchen diese Methoden immer noch nach scharfen Helligkeitsänderungen, aber die Ergebnisse sind sauberer und genauer für verrauschte oder qualitativ minderwertige Bilder.

Nachdem wir besser verstanden haben, wie Kantenerkennung funktioniert, wollen wir untersuchen, wie sie in realen Situationen angewendet wird.

Die Inspektion großer Betonstrukturen wie Brücken und Hochhäuser ist oft eine anspruchsvolle und gefährliche Aufgabe. Diese Strukturen können sich über weite Entfernungen erstrecken oder große Höhen erreichen, was traditionelle Inspektionen langsam, teuer und riskant macht. Diese Inspektionen erfordern in der Regel auch Gerüste, Seilzugang, manuelle Nahbereichsmessungen oder Fotografie.

Ein interessanter Ansatz wurde 2019 untersucht, als Forscher eine sicherere und schnellere Methode testeten, bei der Drohnen mit hochauflösenden Kameras eingesetzt wurden, um detaillierte Eingangsbilder von Betonoberflächen aufzunehmen. Diese Bilder wurden dann mit verschiedenen Kantenerkennungsverfahren verarbeitet, um Risse automatisch zu identifizieren.

Die Studie zeigte, dass diese Methode den Bedarf an direktem menschlichen Zugang zu Gefahrenbereichen deutlich reduzierte und Inspektionen beschleunigte. Ihre Genauigkeit hing jedoch weiterhin von Faktoren wie Lichtverhältnissen, Bildschärfe und stabilem Drohnenbetrieb ab. In einigen Fällen war eine menschliche Überprüfung weiterhin erforderlich, um Falschmeldungen zu beseitigen.

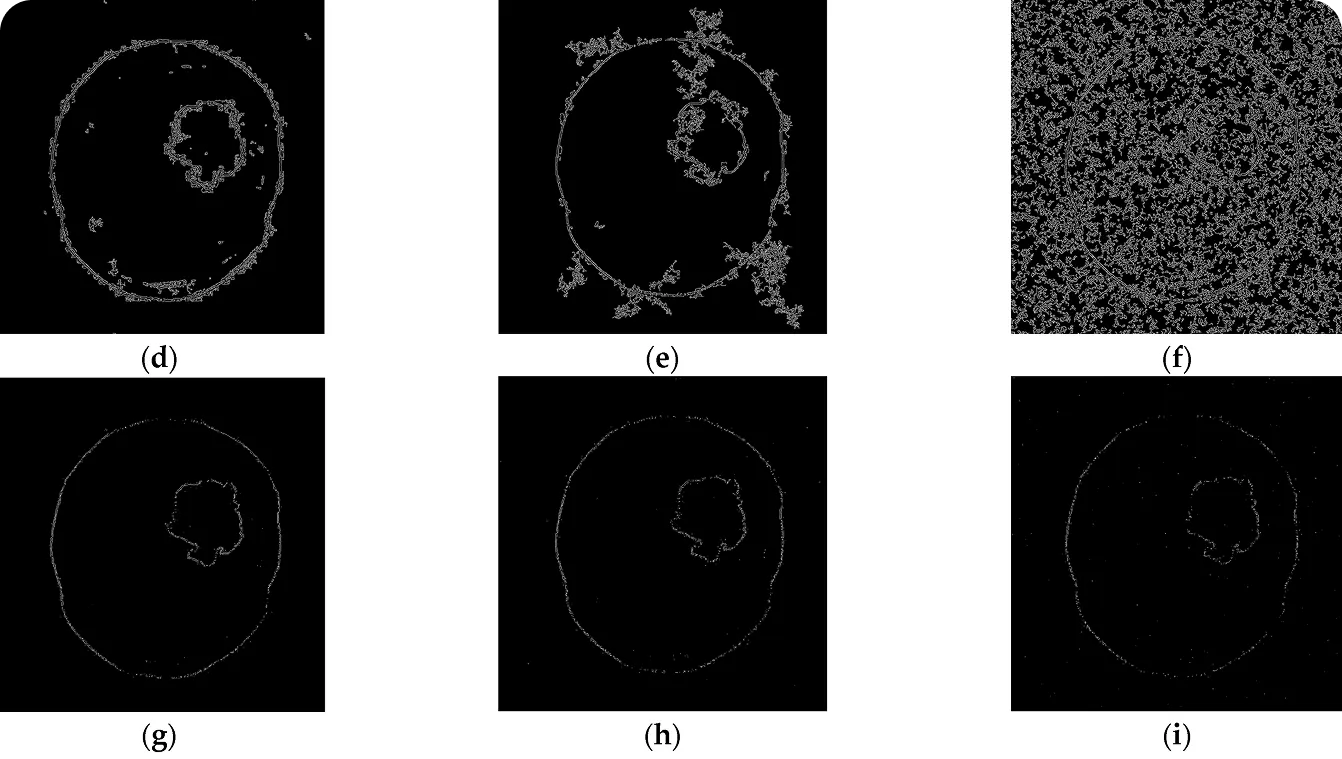

Röntgenaufnahmen und MRTs enthalten oft visuelle Störungen, die als Rauschen bekannt sind und die feine Details schwerer erkennbar machen können. Dies stellt Ärzte vor eine Herausforderung, wenn sie versuchen, die Ränder eines Tumors zu erkennen, die Konturen eines Organs nachzuzeichnen oder subtile Veränderungen im Laufe der Zeit zu beobachten.

Eine aktuelle Studie zur medizinischen Bildgebung untersuchte, wie gut gängige Kantenerkennungsmethoden wie Sobel, Canny, Prewitt und Laplacian mit verrauschten Bildern umgehen können. Die Forscher fügten den Bildern verschiedene Arten und Grade von Rauschen hinzu und überprüften, wie genau jede Methode wichtige Merkmale umreißen konnte.

Canny lieferte in der Regel die saubersten Kanten, selbst bei starkem Rauschen, war aber nicht in jedem Fall die beste Lösung. Einige Methoden funktionierten bei bestimmten Rauschmustern besser, daher gibt es keine perfekte Lösung.

Dies unterstreicht, warum Technologien wie Computer Vision so wichtig sind. Durch die Kombination fortschrittlicher Algorithmen und Vision AI-Modelle können solche Lösungen über die einfache Kantenerkennung hinausgehen und auch unter schwierigen Bedingungen genauere und zuverlässigere Ergebnisse liefern.

Hier sind einige der Vorteile der Verwendung von Kantenerkennung und Bildverarbeitung:

Obwohl die Kantendetektion in der Bildverarbeitung viele Vorteile bietet, ist sie auch mit einigen Herausforderungen verbunden. Hier sind einige der wichtigsten Einschränkungen, die es zu berücksichtigen gilt:

Die Kantenerkennung ist davon inspiriert, wie unsere Augen und unser Gehirn zusammenarbeiten, um die Welt zu verstehen. In Bezug auf das menschliche Sehen reagieren spezialisierte Neuronen im visuellen Kortex sehr empfindlich auf Kanten, Linien und Grenzen.

Diese visuellen Hinweise helfen uns, schnell zu erkennen, wo ein Objekt endet und ein anderes beginnt. Deshalb ist selbst eine einfache Strichzeichnung sofort erkennbar - unser Gehirn verlässt sich stark auf Kanten, um Formen und Objekte zu identifizieren.

Computervision zielt darauf ab, diese Fähigkeit zu imitieren, geht aber noch einen Schritt weiter. Modelle wie Ultralytics YOLO11 gehen über die einfache Hervorhebung von Kanten und die Bildverbesserung hinaus. Sie können Objekte detect , sie präzise umreißen und Bewegungen in Echtzeit track . Dieses tiefere Verständnis macht sie in Szenarien unverzichtbar, in denen die Kantenerkennung allein nicht ausreicht.

Hier sind einige der wichtigsten von YOLO11 unterstützten Computer-Vision-Aufgaben, die auf der Kantenerkennung aufbauen und darüber hinausgehen:

Ein gutes Beispiel für die Verbesserung einer Anwendung, die sich traditionell auf die Kantenerkennung stützt, ist die Risserkennung in Infrastruktur- und Industrieanlagen. Computer-Vision-Modelle wie YOLO11 können so trainiert werden, dass sie Risse auf Straßen, Brücken und Pipelines genau erkennen. Die gleiche Technik kann auch bei der Wartung von Flugzeugen, bei Gebäudeinspektionen und bei der Qualitätskontrolle in der Fertigung eingesetzt werden, um Inspektionen zu beschleunigen und die Sicherheit zu verbessern.

Die Kantenerkennung hat einen langen Weg zurückgelegt, von einfachen frühen Methoden bis hin zu fortschrittlichen Techniken, die selbst subtile Grenzen in komplexen Bildern erkennen können. Sie hilft, wichtige Details hervorzuheben, Schlüsselbereiche zu markieren und Bilder für eine tiefere Analyse vorzubereiten, was sie zu einem Kernbestandteil der Bildverarbeitung macht.

In der Computer Vision spielt die Kantenerkennung eine wichtige Rolle bei der Definition von Formen, der Trennung von Objekten und der Extraktion nützlicher Informationen. Sie wird in vielen Bereichen wie der medizinischen Bildgebung, industriellen Inspektionen, dem autonomen Fahren und der Sicherheit eingesetzt, um eine genaue und zuverlässige visuelle Erfassung zu ermöglichen.

Treten Sie unserer Community bei und erkunden Sie unser GitHub-Repository, um mehr über KI zu erfahren. Wenn Sie Ihr eigenes Vision-KI-Projekt starten möchten, informieren Sie sich über unsere Lizenzoptionen. Entdecken Sie auf unseren Lösungsseiten mehr über Anwendungen wie KI im Gesundheitswesen und Vision AI im Einzelhandel.