Entdecken Sie die Promptable Concept Segmentation, wie sie sich von herkömmlichen Methoden unterscheidet und wie verwandte Modelle wie YOLOE-26 offene Vokabularfunktionen ermöglichen.

Entdecken Sie die Promptable Concept Segmentation, wie sie sich von herkömmlichen Methoden unterscheidet und wie verwandte Modelle wie YOLOE-26 offene Vokabularfunktionen ermöglichen.

Vision AI entwickelt sich rasant weiter und wird in großem Umfang zur Analyse von Bildern und Videos in realen Umgebungen eingesetzt. So werden beispielsweise Anwendungen, die von Verkehrsmanagementsystemen bis hin zu Einzelhandelsanalysen reichen, mit Computervisionsmodellen integriert.

In vielen dieser Anwendungen werden Bildverarbeitungsmodelle, wie beispielsweise Objekterkennungsmodelle, darauf trainiert, eine vordefinierte Gruppe von Objekten zu erkennen, darunter Fahrzeuge, Personen und Ausrüstung. Während des Trainings werden diesen Modellen viele beschriftete Beispiele gezeigt, damit sie lernen können, wie jedes Objekt aussieht und wie es von anderen Objekten in einer Szene unterschieden werden kann.

Bei Segmentierungsaufgaben gehen Modelle noch einen Schritt weiter, indem sie präzise Umrisse auf Pixelebene um diese Objekte herum erstellen. Dadurch können Systeme genau erkennen, wo sich jedes Objekt in einem Bild befindet.

Dies funktioniert gut, solange das System nur das erkennen muss, worauf es trainiert wurde. In realen Umgebungen ist dies jedoch selten der Fall.

Visuelle Szenen sind in der Regel dynamisch. Es tauchen neue Objekte und visuelle Konzepte auf, Bedingungen ändern sich, und Benutzer möchten oft segment , die nicht Teil des ursprünglichen Trainingssetups waren.

Diese Einschränkungen werden besonders deutlich, wenn es um die Segmentierung geht. Mit der Weiterentwicklung der Vision-KI wächst der Bedarf an flexibleren Segmentierungsmodellen, die sich ohne wiederholtes Retraining an neue Konzepte anpassen können. Aus diesem Grund gewinnt die Promptable Concept Segmentation (PCS) zunehmend an Bedeutung.

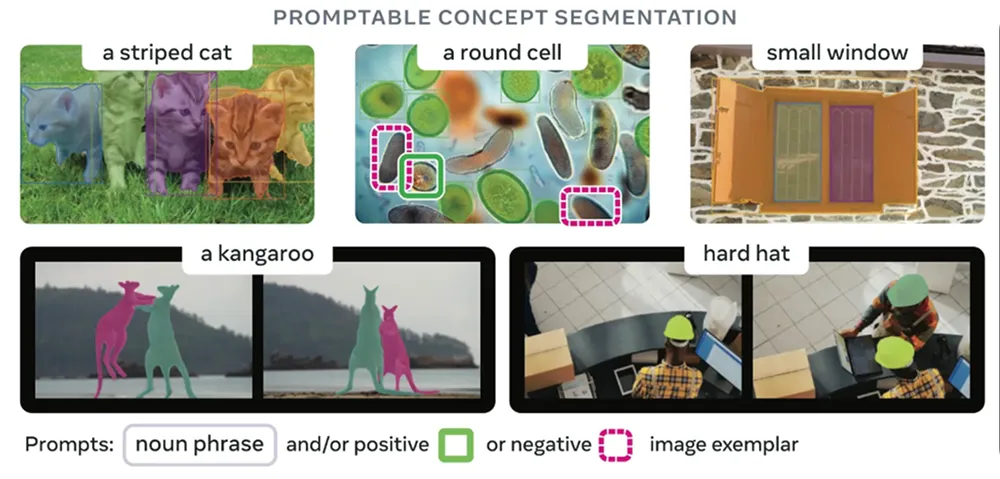

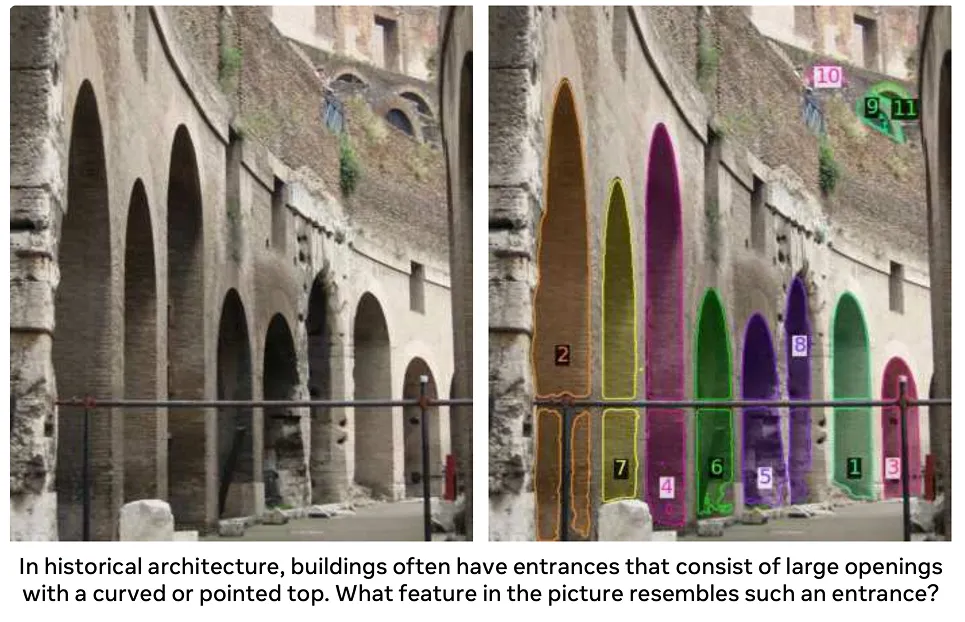

Anstatt sich auf eine feste Liste von Objektkategorien zu verlassen, können Benutzer segment Text, visuellen Hinweisen oder Beispielbildern beschreiben, was sie segment möchten. Diese Modelle können dann segment Bereiche identifizieren und segment , die dem beschriebenen Konzept entsprechen, selbst wenn dieses Konzept während des Trainings nicht explizit enthalten war.

In diesem Artikel untersuchen wir, wie die promptable Konzeptsegmentierung funktioniert, wie sie sich von herkömmlichen Ansätzen unterscheidet und wo sie heute eingesetzt wird.

In den meisten Fällen werden Segmentierungsmodelle darauf trainiert, eine kurze Liste von Objekttypen zu erkennen. Dies funktioniert gut, wenn ein Vision-KI-System nur segment bestimmte Gruppe von Objekten detect segment muss.

In realen Anwendungen sind visuelle Szenen jedoch dynamisch. Es tauchen neue Objekte auf, Aufgabenanforderungen ändern sich und Benutzer müssen häufig segment , die nicht im ursprünglichen Label-Set enthalten waren. Um diese Situationen zu unterstützen, müssen in der Regel neue hochwertige Daten und Annotationen gesammelt und das Modell neu trainiert werden, was die Kosten erhöht und die Bereitstellung verlangsamt.

Die Promptable-Konzeptsegmentierung löst dieses Problem, indem sie den Benutzern ermöglicht, dem Modell mitzuteilen, wonach es suchen soll, anstatt aus einer festen Liste von Labels auszuwählen. Die Benutzer beschreiben das gesuchte Objekt oder die gesuchte Idee, und das Modell hebt alle übereinstimmenden Bereiche im Bild hervor. Dadurch wird es viel einfacher, die Absicht eines Benutzers mit den tatsächlichen Pixeln in einem Bild zu verknüpfen.

Modelle, die die Segmentierung von Konzepten auf Abruf unterstützen, sind flexibel, da sie verschiedene Arten von Eingaben verarbeiten können. Mit anderen Worten: Es gibt mehr als eine Möglichkeit, dem Modell mitzuteilen, wonach es suchen soll, beispielsweise durch Textbeschreibungen, visuelle Hinweise oder Beispielbilder.

Hier ein genauerer Blick auf die einzelnen Ansätze:

Bevor wir uns näher mit der Funktionsweise der promptfähigen Konzeptsegmentierung befassen, wollen wir sie zunächst mit verschiedenen traditionellen Methoden der Objektsegmentierung vergleichen.

PCS ermöglicht Modelle mit offenem Vokabular und promptgesteuerten Funktionen. Es kann mit neuen Ideen arbeiten, die durch Prompts beschrieben werden, was bei herkömmlicher Segmentierung nicht möglich ist. Es gibt verschiedene Arten herkömmlicher Segmentierungsansätze, die jeweils ihre eigenen Annahmen und Einschränkungen haben.

Hier ein Überblick über einige wichtige Arten der traditionellen Segmentierung:

Alle diese Ansätze basieren auf einer vordefinierten Liste von Objektkategorien. Innerhalb dieses Rahmens funktionieren sie gut, aber Konzepte außerhalb dieses Rahmens können sie nicht sehr gut verarbeiten. Wenn ein neues spezifisches Objekt segmentiert werden muss, sind in der Regel zusätzliche Trainingsdaten und eine Feinabstimmung des Modells erforderlich.

PCS will das ändern. Anstatt in vordefinierte Kategorien eingeschränkt zu sein, können Sie damit zum Zeitpunkt der Inferenz beschreiben, was Sie segment einem Bild segment möchten.

Als Nächstes wollen wir uns ansehen, wie sich Segmentierungsmodelle hin zur promptfähigen Konzeptsegmentierung entwickelt haben.

Ein beliebtes Fundamentmodell, das einen Wandel in der Segmentierung markierte, war SAModer Segment Anything Model. Es wurde 2023 eingeführt. Anstatt sich auf vordefinierte Objektkategorien zu stützen, SAM den Benutzern, die Segmentierung mithilfe einfacher visueller Eingabeaufforderungen wie Punkten oder Begrenzungsrahmen zu steuern.

Mit SAM mussten Benutzer keine Beschriftung mehr auswählen. Sie konnten einfach angeben, wo sich ein Objekt befand, und das Modell generierte eine Maske dafür. Dadurch wurde die Segmentierung flexibler, aber die Benutzer mussten dem Modell weiterhin zeigen, wo es suchen sollte.

SAM , veröffentlicht im Jahr 2024, baute auf dieser Idee auf, indem es komplexere Szenen verarbeitete und die promptable Segmentierung auf Videos ausweitete. Es verbesserte die Robustheit unter verschiedenen Lichtverhältnissen, Objektformen und Bewegungen, während es sich weiterhin hauptsächlich auf visuelle Prompts stützte, um die Segmentierung zu steuern.

Das Modell SAM ist der neueste Schritt in dieser Entwicklung. Es wurde letztes Jahr veröffentlicht und ist ein einheitliches Modell, das visuelles Verständnis mit Sprachsteuerung kombiniert und so ein konsistentes Verhalten bei Bild- und Videosegmentierungsaufgaben ermöglicht.

Mit SAM sind Benutzer nicht auf Zeigen oder Zeichnen beschränkt. Stattdessen können sie segment Text beschreiben, was sie segment möchten, und das Modell durchsucht das Bild oder die Videobilder nach Bereichen, die dieser Beschreibung entsprechen.

Die Segmentierung orientiert sich eher an Konzepten als an festen Objektkategorien und unterstützt so die Verwendung eines offenen Vokabulars in verschiedenen Szenarien und über einen längeren Zeitraum hinweg. Tatsächlich arbeitet SAM mit einem großen, erlernten Konzeptraum, der auf einer Ontologie basiert, die aus Quellen wie Wikidata abgeleitet und durch umfangreiche Trainingsdaten erweitert wurde.

Im Vergleich zu früheren Versionen, die sich hauptsächlich auf geometrische Vorgaben stützten, stellt SAM einen Schritt in Richtung einer flexibleren, konzeptorientierten Segmentierung dar. Dadurch eignet es sich besser für reale Anwendungen, bei denen sich die Objekte oder Ideen von Interesse ändern können und nicht immer im Voraus definiert werden können.

Wie funktioniert also die Segmentierung nach Prompt-Konzepten? Sie basiert auf großen, vorab trainierten Bild- und Bild-Sprachmodellen, die anhand riesiger Bildersammlungen und in vielen Fällen auch gepaarten Texten trainiert wurden. Durch dieses Training lernen sie allgemeine visuelle Muster und semantische Bedeutungen.

Die meisten PCS-Modelle verwenden transformatorbasierte Architekturen, die ein gesamtes Bild auf einmal verarbeiten, um zu verstehen, wie verschiedene Bereiche miteinander in Beziehung stehen. Ein Vision-Transformator extrahiert visuelle Merkmale aus dem Bild, während ein Text-Encoder Wörter in numerische Darstellungen umwandelt, mit denen das Modell arbeiten kann.

Während des Trainings können diese Modelle aus verschiedenen Arten der Überwachung lernen, darunter Masken auf Pixelebene, die genaue Objektgrenzen definieren, Begrenzungsrahmen, die Objekte grob lokalisieren, und Bildbeschriftungen, die beschreiben, was in einem Bild zu sehen ist. Das Training mit verschiedenen Arten von beschrifteten Daten hilft dem Modell, sowohl feine Details als auch umfassendere visuelle Konzepte zu erfassen.

Bei der Inferenz, d. h. wenn das Modell tatsächlich für Vorhersagen verwendet wird, folgt PCS einem promptgesteuerten Prozess. Der Benutzer gibt Anweisungen in Form von Textbeschreibungen, visuellen Hinweisen wie Punkten oder Kästchen oder Beispielbildern. Das Modell kodiert sowohl den Prompt als auch das Bild in eine gemeinsame interne Darstellung oder Einbettung und identifiziert Bereiche, die mit dem beschriebenen Konzept übereinstimmen.

Ein Maskendecoder wandelt diese gemeinsame Darstellung dann in präzise Segmentierungsmasken auf Pixelebene um. Da das Modell visuelle Merkmale mit semantischer Bedeutung verknüpft, kann es segment Konzepte segment , auch wenn diese während des Trainings nicht explizit enthalten waren.

Außerdem kann die Ausgabe oft durch Anpassen der Eingabeaufforderung oder Hinzufügen zusätzlicher Anweisungen verfeinert werden, was dem Modell hilft, komplexe oder mehrdeutige Szenen zu verarbeiten. Dieser iterative Prozess unterstützt die praktische Optimierung während der Bereitstellung.

Promptable Concept Segmentation-Modelle werden in der Regel danach bewertet, wie gut sie segment unbekannte Konzepte segment und wie robust sie in verschiedenen Szenen funktionieren. Benchmarks konzentrieren sich häufig auf Maskenqualität, Generalisierung und Recheneffizienz und spiegeln damit die Anforderungen des realen Einsatzes wider.

Als Nächstes wollen wir uns ansehen, wo die Segmentierung von promptierbaren Konzepten bereits eingesetzt wird und erste konkrete Auswirkungen zeigt.

Die medizinische Bildgebung umfasst viele biologische Strukturen, Krankheiten und Scan-Typen, und jeden Tag kommen neue Fälle hinzu. Herkömmliche Segmentierungsmodelle haben Schwierigkeiten, mit dieser Vielfalt Schritt zu halten.

PCS fügt sich nahtlos in diesen Bereich ein, da es Ärzten ermöglicht, zu beschreiben, was sie finden möchten, anstatt aus einer kurzen, starren Liste auszuwählen. Mit Textphrasen oder visuellen Eingabeaufforderungen kann PCS verwendet werden, um segment oder relevante Bereiche direkt segment , ohne das Modell für jede neue Aufgabe neu trainieren zu müssen. Dies erleichtert die Handhabung vielfältiger klinischer Anforderungen, reduziert den Bedarf an manuellem Maskieren und funktioniert bei vielen Bildgebungstypen.

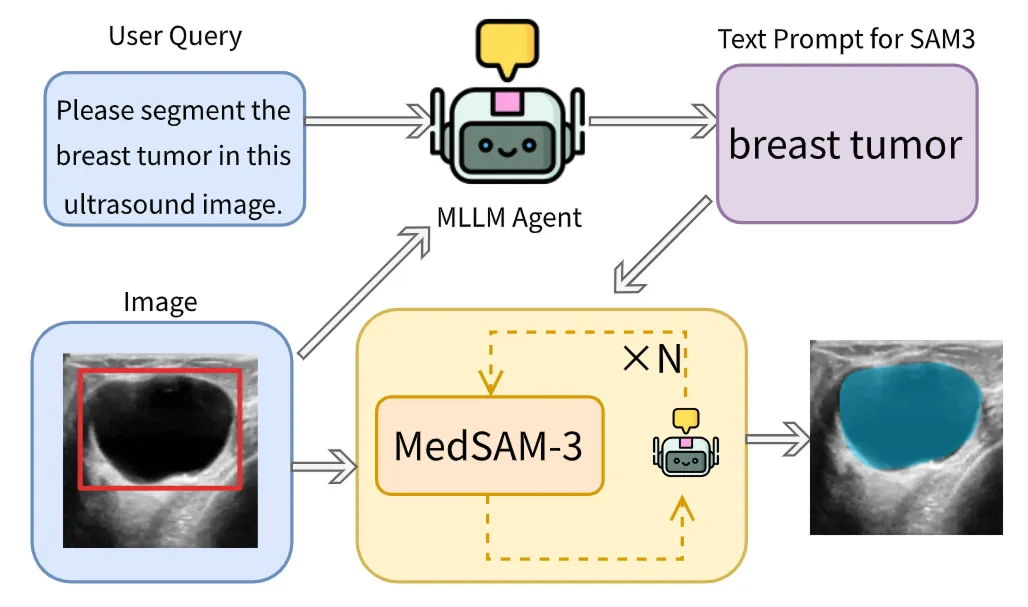

Ein gutes Beispiel hierfür ist MedSAM-3, das die SAM für textbasierte PCS in der medizinischen Bildgebung adaptiert. Dieses Modell kann mit expliziten anatomischen und pathologischen Begriffen wie Organbezeichnungen (z. B. Leber oder Niere) und läsionsbezogenen Begriffen (z. B. Tumor oder Läsion) angesteuert werden. Nach Eingabe eines Befehls segmentiert das Modell direkt den entsprechenden Bereich im medizinischen Bild.

MedSAM-3 integriert auch multimodale große Sprachmodelle (MLLMs oder multimodale LLMs), die sowohl Texte als auch Bilder verarbeiten können. Diese Modelle arbeiten in einer Agent-in-the-Loop-Konfiguration, bei der die Ergebnisse iterativ verfeinert werden, um die Genauigkeit in schwierigeren Fällen zu verbessern.

MedSAM-3 liefert gute Ergebnisse bei Röntgen-, MRT-, CT-, Ultraschall- und Videodaten und verdeutlicht, wie PCS flexiblere und effizientere Arbeitsabläufe in der medizinischen Bildgebung in realen klinischen Umgebungen ermöglichen kann.

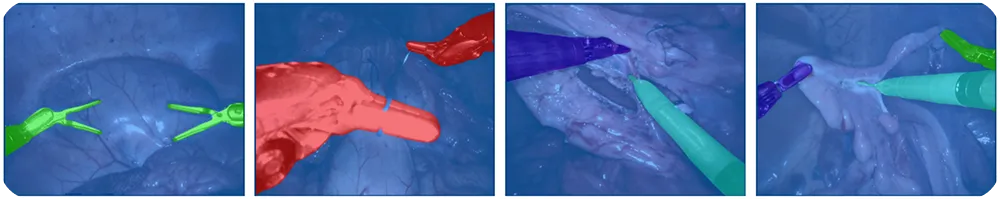

Die Roboterchirurgie stützt sich auf Bildverarbeitungssysteme, um track und sich schnell verändernde Operationssituationen zu erfassen. Instrumente bewegen sich schnell, die Beleuchtung variiert und neue Instrumente können jederzeit hinzukommen, was die Pflege vordefinierter Beschriftungssysteme erschwert.

Mit PCS können Roboter track , Kameras führen und chirurgische Schritte in Echtzeit verfolgen. Dies reduziert die manuelle Kennzeichnung und erleichtert die Anpassung der Systeme an verschiedene Verfahren. Chirurgen oder automatisierte Systeme können Textbefehle wie „Greifer“, „Skalpell“ oder „Kamerawerkzeug“ verwenden, um anzugeben, was in einem Bild segmentiert werden soll.

Ein weiteres interessantes, hochmodernes Modell im Zusammenhang mit der promptfähigen Konzeptsegmentierung ist unser Ultralytics . Unser Modell erweitert die Ultralytics YOLO um eine promptgesteuerte Segmentierung mit offenem Vokabular.

YOLOE-26 basiert auf der Ultralytics -Architektur und unterstützt die Instanzsegmentierung mit offenem Vokabular. Mit YOLOE-26 können Benutzer die Segmentierung auf verschiedene Weise steuern.

Es unterstützt Text-Prompts, bei denen kurze, visuell fundierte Phrasen das Zielobjekt spezifizieren können, sowie visuelle Prompts, die zusätzliche Hinweise auf der Grundlage von Bildhinweisen liefern. Darüber hinaus verfügt YOLOE-26 über einen promptfreien Modus für Zero-Shot-Inferenz, bei dem das Modell Objekte aus einem integrierten Vokabular erkennt und segmentiert, ohne dass Benutzer-Prompts erforderlich sind.

YOLOE-26 eignet sich hervorragend für Anwendungen wie Videoanalyse, Robotikwahrnehmung und Edge-basierte Systeme, bei denen sich die Objektkategorien ändern können, aber eine geringe Latenz und ein zuverlässiger Durchsatz unerlässlich bleiben. Es ist auch besonders nützlich für die Datenkennzeichnung und Datensatzkuratierung, da es Arbeitsabläufe durch die Automatisierung von Teilen des Annotationsprozesses rationalisiert.

Hier sind einige der wichtigsten Vorteile der Verwendung der promptfähigen Konzeptsegmentierung:

Obwohl PCS klare Vorteile hat, gibt es einige Einschränkungen zu beachten:

Wenn Sie sich mit der promptfähigen Segmentierung beschäftigen, fragen Sie sich vielleicht, für welche Anwendungen sie am besten geeignet ist und wann ein traditionelles Computer-Vision-Modell wie YOLO26 besser für das Problem geeignet ist, das Sie lösen möchten. Die promptfähige Segmentierung eignet sich gut für allgemeine Objekte, ist jedoch nicht für Anwendungsfälle geeignet, die sehr präzise und konsistente Ergebnisse erfordern.

Die Fehlererkennung ist ein gutes Beispiel dafür. In der Fertigung sind Fehler oft winzig und kaum wahrnehmbar, wie z. B. kleine Kratzer, Dellen, Fehlausrichtungen oder Oberflächenunregelmäßigkeiten. Sie können auch je nach Material, Beleuchtung und Produktionsbedingungen sehr unterschiedlich sein.

Diese Probleme lassen sich nur schwer mit einer einfachen Eingabe beschreiben und sind für ein Allzweckmodell noch schwieriger detect zu detect . Insgesamt neigen promptbasierte Modelle dazu, Fehler zu übersehen oder instabile Ergebnisse zu liefern, während Modelle, die speziell auf Fehlerdaten trainiert wurden, für reale Inspektionssysteme wesentlich zuverlässiger sind.

Die Promptable Concept Segmentation erleichtert die Anpassung von Bildverarbeitungssystemen an die reale Welt, in der ständig neue Objekte und Ideen auftauchen. Anstatt sich auf feste Bezeichnungen festzulegen, können Benutzer einfach beschreiben, was sie segment möchten, segment den Rest dem Modell überlassen, was Zeit spart und den manuellen Aufwand reduziert. Obwohl es noch Einschränkungen gibt, verändert PCS bereits jetzt die praktische Anwendung der Segmentierung und wird wahrscheinlich zu einem zentralen Bestandteil zukünftiger Bildverarbeitungssysteme werden.

Erfahren Sie mehr über KI, indem Sie unser GitHub-Repository besuchen und unserer Community beitreten. Auf unseren Lösungsseiten erfahren Sie mehr über KI in der Robotik und Computer Vision in der Fertigung. Entdecken Sie unsere Lizenzoptionen und starten Sie noch heute mit Vision AI!