Scopri perché la potatura e la quantizzazione sono essenziali per ottimizzare i modelli di computer vision e consentire prestazioni più veloci sui dispositivi edge.

Scopri perché la potatura e la quantizzazione sono essenziali per ottimizzare i modelli di computer vision e consentire prestazioni più veloci sui dispositivi edge.

I dispositivi edge stanno diventando sempre più comuni con il progredire della tecnologia. Dagli smartwatch che track frequenza cardiaca ai droni aerei che monitorano le strade, i sistemi edge possono elaborare i dati in tempo reale all'interno del dispositivo stesso.

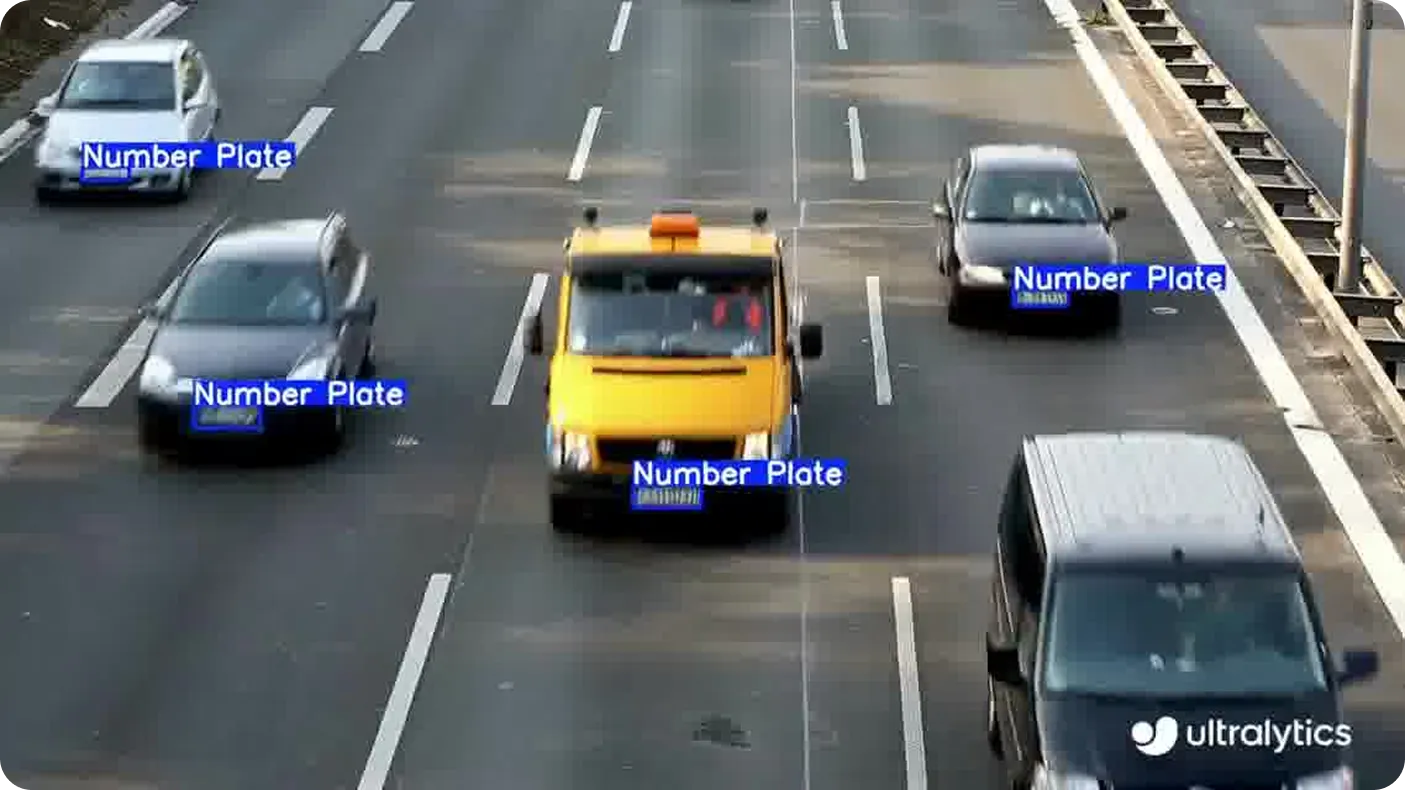

Questo metodo è spesso più veloce e sicuro dell'invio di dati al cloud, soprattutto per le applicazioni che coinvolgono dati personali, come il rilevamento di targhe o il tracciamento dei gesti. Questi sono esempi di computer vision, una branca dell'intelligenza artificiale (IA) che consente alle macchine di interpretare e comprendere le informazioni visive.

Tuttavia, una considerazione importante è che tali applicazioni richiedono modelli di Vision AI in grado di gestire calcoli complessi, utilizzando risorse minime e operando in modo indipendente. La maggior parte dei modelli di computer vision sono sviluppati per sistemi ad alte prestazioni, il che li rende meno adatti per l'implementazione diretta su dispositivi edge.

Per colmare questo divario, gli sviluppatori spesso applicano ottimizzazioni mirate che adattano il modello per funzionare in modo efficiente su hardware più piccolo. Questi aggiustamenti sono fondamentali per le implementazioni edge nel mondo reale, dove la memoria e la potenza di elaborazione sono limitate.

È interessante notare che i modelli di visione computerizzata come Ultralytics YOLO11 sono già stati progettati tenendo conto dell'efficienza dei bordi, il che li rende ideali per le attività in tempo reale. Tuttavia, le loro prestazioni possono essere ulteriormente migliorate utilizzando tecniche di ottimizzazione del modello, come il pruning e la quantizzazione, che consentono un'inferenza ancora più rapida e un minore utilizzo di risorse su dispositivi limitati.

In questo articolo esamineremo più da vicino cosa sono il pruning e la quantizzazione, come funzionano e come possono aiutare i modelli YOLO a ottenere risultati nelle implementazioni edge del mondo reale. Iniziamo!

Quando si preparano i modelli di Vision AI per la distribuzione su dispositivi edge, uno degli obiettivi chiave è rendere il modello leggero e affidabile senza sacrificare le prestazioni. Ciò comporta spesso la riduzione delle dimensioni del modello e delle esigenze computazionali in modo che possa operare in modo efficiente su hardware con memoria, potenza o capacità di elaborazione limitate. Due modi comuni per farlo sono la potatura e la quantizzazione.

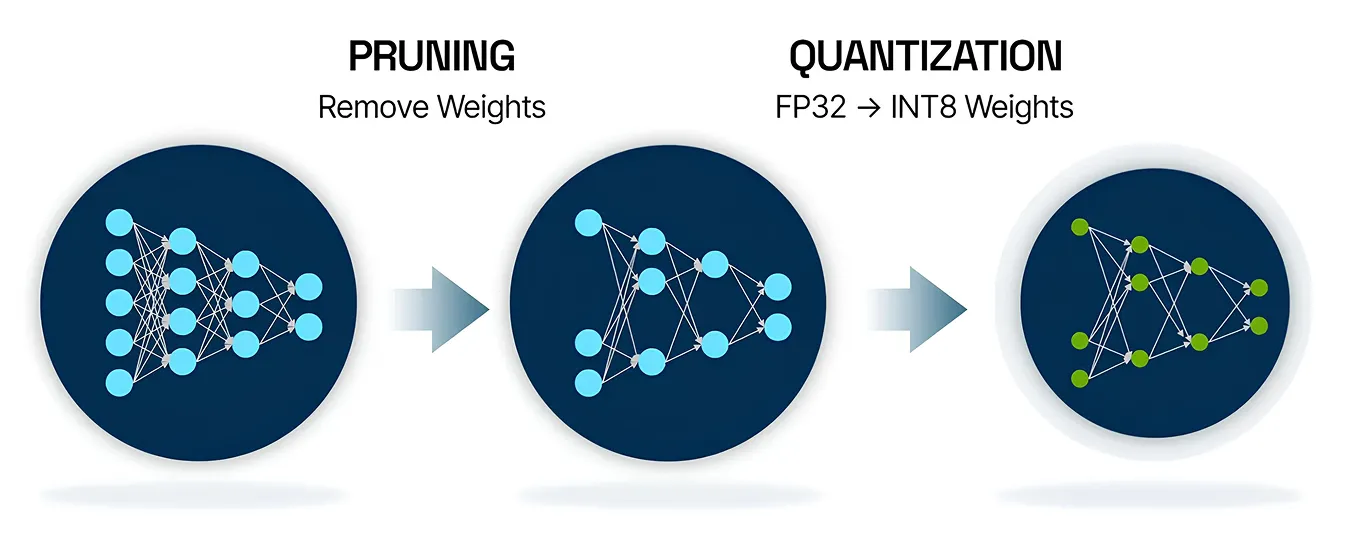

Il pruning è una tecnica di ottimizzazione dei modelli di IA che aiuta a rendere le reti neurali più piccole ed efficienti. In molti casi, alcune parti di un modello, come determinate connessioni o nodi, non contribuiscono molto alle sue previsioni finali. Il pruning funziona identificando e rimuovendo queste parti meno importanti, il che riduce le dimensioni del modello e ne velocizza le prestazioni.

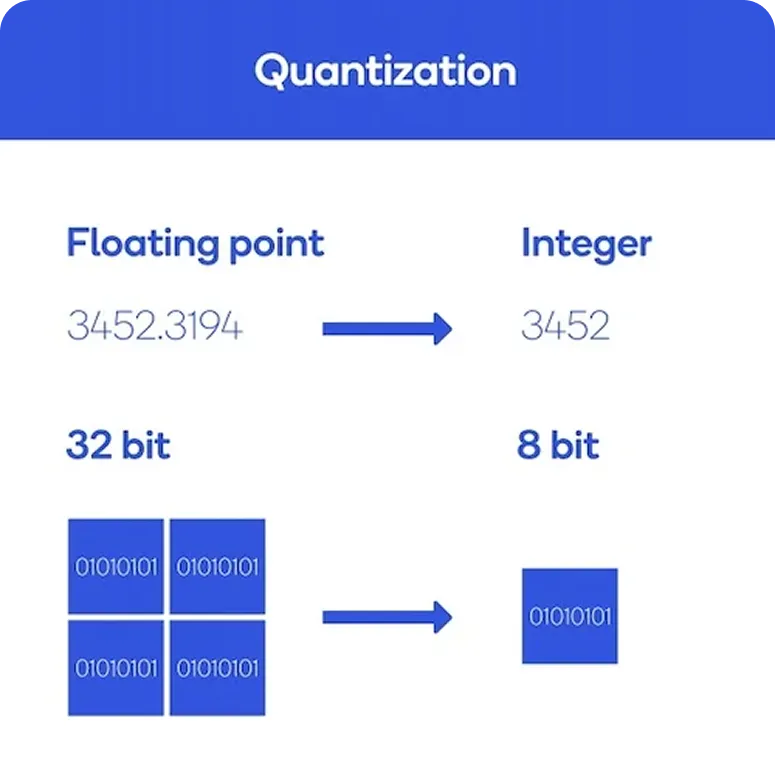

D'altra parte, la quantizzazione è una tecnica di ottimizzazione che riduce la precisione dei numeri utilizzati da un modello. Invece di fare affidamento su numeri in virgola mobile a 32 bit ad alta precisione, il modello passa a formati più piccoli ed efficienti come i numeri interi a 8 bit. Questo cambiamento aiuta a ridurre l'utilizzo della memoria e accelera l'inferenza, il processo in cui il modello fa previsioni.

Ora che abbiamo una migliore comprensione di cosa sono la potatura e la quantizzazione, vediamo come funzionano entrambe.

Il pruning viene eseguito utilizzando un processo noto come analisi di sensitività. Questo processo identifica quali parti dei modelli di reti neurali, come determinati pesi, neuroni o canali, contribuiscono meno alla previsione dell'output finale. Queste parti possono essere rimosse con un effetto minimo sull'accuratezza. Dopo il pruning, il modello viene solitamente riaddestrato per mettere a punto le sue prestazioni. Questo ciclo può essere ripetuto per trovare il giusto equilibrio tra le sue dimensioni e l'accuratezza.

Nel frattempo, la quantizzazione del modello si concentra su come il modello gestisce i dati. Inizia con la calibrazione, in cui il modello viene eseguito su dati di esempio per apprendere l'intervallo di valori che deve elaborare. Tali valori vengono quindi convertiti da virgola mobile a 32 bit a formati di precisione inferiore come interi a 8 bit.

Esistono diversi strumenti che facilitano l'uso di pruning e quantizzazione nei progetti di IA del mondo reale. La maggior parte dei framework di IA, come PyTorch e TensorFlow, include un supporto integrato per queste tecniche di ottimizzazione, consentendo agli sviluppatori di integrarle direttamente nel processo di distribuzione dei modelli.

Una volta ottimizzato un modello, strumenti come ONNX Runtime possono aiutare a eseguirlo in modo efficiente su varie piattaforme hardware come server, desktop e dispositivi edge. Inoltre, Ultralytics offre integrazioni che consentono di esportare i modelli YOLO in formati adatti alla quantizzazione, rendendo più facile ridurre le dimensioni del modello e aumentare le prestazioni.

I modelliYOLO Ultralytics , come YOLO11 , sono ampiamente riconosciuti per la loro velocità di rilevamento degli oggetti in un unico passaggio, che li rende ideali per le attività di Vision AI in tempo reale. Sono già stati progettati per essere abbastanza leggeri ed efficienti da poter essere distribuiti su tutto il territorio. Tuttavia, gli strati responsabili dell'elaborazione delle caratteristiche visive, chiamati strati convoluzionali, possono richiedere una notevole potenza di calcolo durante l'inferenza.

Ci si potrebbe chiedere: se YOLO11 è già ottimizzato per l'uso su dispositivi edge, perché ha bisogno di ulteriori ottimizzazioni? Semplicemente, non tutti i dispositivi edge sono uguali. Alcuni funzionano con un hardware minimo, come i piccoli processori incorporati che consumano meno energia di una normale lampadina a LED.

In questi casi, anche un modello semplificato come YOLO11 necessita di un'ottimizzazione aggiuntiva per garantire prestazioni fluide e affidabili. Tecniche come il pruning e la quantizzazione aiutano a ridurre le dimensioni del modello e a velocizzare l'inferenza senza impattare in modo significativo sull'accuratezza, rendendole ideali per questi ambienti vincolati.

Per facilitare l'applicazione di queste tecniche di ottimizzazione, Ultralytics supporta diverse integrazioni che possono essere utilizzate per esportare i modelli YOLO in diversi formati come ONNX, TensorRT, OpenVINO, CoreML e PaddlePaddle. Ogni formato è progettato per funzionare bene con specifici tipi di hardware e ambienti di distribuzione.

Ad esempio, ONNX è spesso utilizzato nei workflow di quantizzazione grazie alla sua compatibilità con un'ampia gamma di strumenti e piattaforme. TensorRT, invece, è altamente ottimizzato per i dispositivi NVIDIA e supporta l'inferenza a bassa precisione utilizzando INT8, rendendolo ideale per l'implementazione ad alta velocità sulle GPU edge.

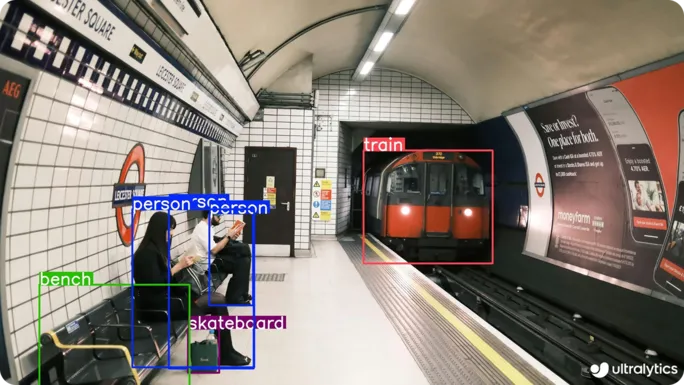

Poiché la computer vision continua a espandersi in varie applicazioni del mondo reale, i modelli YOLO ottimizzati consentono di eseguire attività come il rilevamento di oggetti, la segmentazione di istanze e il tracciamento di oggetti su hardware più piccolo e più veloce. A seguire, analizziamo un paio di casi d'uso in cui il pruning e la quantizzazione rendono più efficienti e pratici questi compiti di computer vision.

Molti spazi industriali, così come le aree pubbliche, dipendono dal monitoraggio in tempo reale per rimanere sicuri e protetti. Luoghi come stazioni di transito, siti produttivi e grandi strutture all'aperto hanno bisogno di sistemi Vision AI in grado di detect persone o veicoli in modo rapido e preciso. Spesso questi luoghi sono caratterizzati da una connettività limitata e da vincoli hardware che rendono difficile l'implementazione di modelli di grandi dimensioni.

In questi casi, un modello ottimizzato di Vision AI come YOLO11 è un'ottima soluzione. Le sue dimensioni compatte e le sue prestazioni veloci lo rendono perfetto per l'esecuzione su dispositivi edge a basso consumo, come telecamere integrate o sensori intelligenti. Questi modelli possono elaborare i dati visivi direttamente sul dispositivo, consentendo di rilevare in tempo reale violazioni della sicurezza, accessi non autorizzati o attività anomale, senza dover ricorrere a un accesso costante al cloud.

I cantieri edili sono ambienti frenetici e imprevedibili, pieni di macchinari pesanti, operai in movimento e attività costante. Le condizioni possono cambiare rapidamente a causa di variazioni di programma, spostamento di attrezzature o persino improvvisi cambiamenti meteorologici. In un contesto così dinamico, la sicurezza dei lavoratori può sembrare una sfida continua.

Il monitoraggio in tempo reale svolge un ruolo fondamentale, ma i sistemi tradizionali spesso si affidano all'accesso al cloud o a un hardware costoso che potrebbe non essere pratico in loco. È qui che modelli come YOLO11 possono essere d'impatto. YOLO11 può essere ottimizzato per funzionare su dispositivi edge piccoli ed efficienti che operano direttamente sul posto senza bisogno di una connessione a Internet.

Si pensi, ad esempio, a un cantiere di grandi dimensioni, come l'ampliamento di un'autostrada che si estende per diversi ettari. In questo tipo di ambiente, seguire manualmente ogni veicolo o attrezzatura può essere difficile e richiede molto tempo. Un drone dotato di telecamera e di un modello YOLO11 ottimizzato può aiutare a rilevare e seguire automaticamente i veicoli, a monitorare il flusso del traffico e a individuare problemi di sicurezza come accessi non autorizzati o comportamenti di guida non sicuri.

Ecco alcuni vantaggi chiave offerti dai metodi di ottimizzazione dei modelli di computer vision come la potatura e la quantizzazione:

Sebbene il pruning e la quantizzazione offrano molti vantaggi, presentano anche alcuni compromessi che gli sviluppatori dovrebbero considerare quando ottimizzano i modelli. Ecco alcune limitazioni da tenere a mente:

Il pruning e la quantizzazione sono tecniche utili che aiutano i modelli YOLO a funzionare meglio sui dispositivi edge. Riducono le dimensioni del modello, diminuiscono le sue esigenze di calcolo e accelerano le previsioni, il tutto senza una sensibile perdita di accuratezza.

Questi metodi di ottimizzazione offrono inoltre agli sviluppatori la flessibilità di adattare i modelli a diversi tipi di hardware senza doverli ricostruire completamente. Con alcuni aggiustamenti e test, diventa più facile applicare la Vision AI in situazioni reali.

Unisciti alla nostra community in crescita! Esplora il nostro repository GitHub per saperne di più sull'AI. Sei pronto per iniziare i tuoi progetti di computer vision? Scopri le nostre opzioni di licenza. Scopri l'AI in agricoltura e la Vision AI nel settore sanitario visitando le nostre pagine delle soluzioni!