Ultralytics ' điểm nổi bật chính từ YOLO Tầm nhìn 2025 Thâm Quyến!

Xem lại những khoảnh khắc quan trọng từ YOLO Tầm nhìn 2025 Thâm Quyến, nơi Ultralytics đã quy tụ những nhà đổi mới, đối tác và cộng đồng AI trong một ngày đầy cảm hứng.

Xem lại những khoảnh khắc quan trọng từ YOLO Tầm nhìn 2025 Thâm Quyến, nơi Ultralytics đã quy tụ những nhà đổi mới, đối tác và cộng đồng AI trong một ngày đầy cảm hứng.

Vào ngày 26 tháng 10, YOLO Vision 2025 (YV25) đã ra mắt tại Trung Quốc tại Tòa nhà B10 trong Công viên Văn hóa Sáng tạo OCT ở Thâm Quyến. Ultralytics 'Sự kiện Vision AI kết hợp đã thu hút hơn 200 người tham dự trực tiếp, cùng nhiều người khác tham gia trực tuyến qua YouTube và Bilibili.

Buổi phát trực tiếp YV25 Thâm Quyến đã đạt hơn 3.500 lượt xem trên YouTube và tiếp tục thu hút sự chú ý khi những điểm nổi bật của sự kiện được chia sẻ rộng rãi trong cộng đồng. Đó là một ngày tràn ngập ý tưởng, thảo luận và khám phá thực tế về hướng đi tiếp theo của Vision AI.

Ngày hội bắt đầu với lời chào đón nồng nhiệt từ chủ nhà, cô Huang Xueying, người đã mời mọi người kết nối, học hỏi và tham gia thảo luận trong suốt sự kiện. Cô giải thích rằng đây là lần thứ hai YOLO Tầm nhìn của năm, sau phiên bản London vào tháng 9 và chia sẻ về sự thú vị khi tập hợp cộng đồng Vision AI lại với nhau tại Thâm Quyến.

Trong bài viết này, chúng ta sẽ cùng điểm lại những điểm nổi bật trong ngày, bao gồm các bản cập nhật mô hình, các buổi diễn thuyết, buổi demo trực tiếp và những khoảnh khắc cộng đồng đã gắn kết mọi người lại với nhau. Cùng bắt đầu thôi!

Bài phát biểu quan trọng đầu tiên trong ngày được dẫn dắt bởi Ultralytics Nhà sáng lập kiêm Tổng giám đốc điều hành Glenn Jocher đã chia sẻ về cách các mô hình YOLO Ultralytics đã phát triển từ một bước đột phá trong nghiên cứu thành một số mô hình Vision AI được sử dụng rộng rãi nhất trên thế giới. Glenn giải thích rằng công việc ban đầu của ông tập trung vào việc tạo ra YOLO dễ sử dụng hơn.

Ông đã chuyển các mô hình đến PyTorch , cải thiện tài liệu hướng dẫn và chia sẻ mọi thứ một cách công khai để các nhà phát triển ở khắp mọi nơi có thể xây dựng dựa trên đó. Như anh nhớ lại, "Tôi đã lao vào lĩnh vực này ngay từ năm 2018. Tôi quyết định đây chính là tương lai của mình." Khởi đầu từ một nỗ lực cá nhân, phong trào nguồn mở này đã nhanh chóng trở thành một phong trào toàn cầu.

Hôm nay, Ultralytics YOLO Các mô hình hỗ trợ hàng tỷ suy luận mỗi ngày, và Glenn nhấn mạnh rằng quy mô này chỉ có thể đạt được nhờ những người đã góp phần xây dựng nó. Các nhà nghiên cứu, kỹ sư, sinh viên, người yêu thích và những người đóng góp mã nguồn mở từ khắp nơi trên thế giới đã định hình YOLO thành những gì chúng ta thấy ngày nay.

Như Glenn đã nói, "Có gần một ngàn người [đóng góp] ngoài kia và chúng tôi vô cùng biết ơn vì điều đó. Chúng tôi sẽ không thể có được ngày hôm nay nếu không có những người này."

Cái nhìn đầu tiên vào Ultralytics YOLO26 đã được chia sẻ vào đầu năm nay tại sự kiện YOLO Vision 2025 London , nơi nó được giới thiệu là bước tiến lớn tiếp theo trong Ultralytics YOLO Gia đình mẫu. Tại YV25 Thâm Quyến, Glenn đã cung cấp thông tin cập nhật về tiến độ kể từ thông báo đó và giúp cộng đồng AI có cái nhìn sâu sắc hơn về sự phát triển của mô hình.

YOLO26 được thiết kế để nhỏ gọn hơn, nhanh hơn và chính xác hơn, đồng thời vẫn đảm bảo tính thực tiễn khi sử dụng. Glenn giải thích rằng nhóm đã dành cả năm qua để tinh chỉnh kiến trúc, đánh giá hiệu năng trên nhiều thiết bị và kết hợp những hiểu biết sâu sắc từ nghiên cứu và phản hồi của cộng đồng. Mục tiêu là mang lại hiệu năng tiên tiến mà không làm cho việc triển khai các mô hình trở nên khó khăn hơn.

Một trong những cập nhật cốt lõi mà Glenn nhấn mạnh là YOLO26 được kết hợp với một chiến dịch tinh chỉnh siêu tham số chuyên dụng, chuyển từ đào tạo hoàn toàn từ đầu sang tinh chỉnh trên các tập dữ liệu lớn hơn. Ông giải thích thêm rằng phương pháp này phù hợp hơn nhiều với các trường hợp sử dụng thực tế.

Sau đây là một số cải tiến quan trọng khác được chia sẻ tại sự kiện:

Cùng nhau, những bản cập nhật này tạo ra các mô hình nhanh hơn tới 43% trên CPU đồng thời cũng chính xác hơn Ultralytics YOLO11 , khiến YOLO26 đặc biệt có tác động đến các thiết bị nhúng, robot và hệ thống biên.

YOLO26 sẽ hỗ trợ tất cả các tác vụ và kích thước mô hình tương tự hiện có trong YOLO11 , tạo ra 25 biến thể mô hình trên toàn bộ họ. Bao gồm các mô hình phát hiện, phân đoạn, ước tính tư thế, hộp giới hạn định hướng và phân loại, từ nano đến cực lớn.

Nhóm cũng đang phát triển năm biến thể có thể nhắc nhở. Đây là những mô hình có thể nhận lời nhắc văn bản và trả về hộp giới hạn trực tiếp mà không cần đào tạo.

Đây là bước đầu tiên hướng tới quy trình làm việc thị giác dựa trên hướng dẫn linh hoạt hơn, dễ dàng thích ứng với các trường hợp sử dụng khác nhau. Các mô hình YOLO26 vẫn đang được phát triển tích cực, nhưng kết quả hiệu suất ban đầu rất khả quan và nhóm đang nỗ lực để sớm ra mắt chúng.

Sau bản cập nhật YOLO26, Glenn đã chào đón Prateek Bhatnagar , Trưởng phòng Kỹ thuật Sản phẩm của chúng tôi, đến để trình diễn trực tiếp Ultralytics Nền tảng. Nền tảng này được xây dựng để kết hợp các phần chính của quy trình thị giác máy tính, bao gồm khám phá tập dữ liệu, chú thích hình ảnh, đào tạo mô hình và so sánh kết quả.

Prateek chỉ ra rằng nền tảng này vẫn trung thành với Ultralytics 'nguồn gốc mã nguồn mở, giới thiệu hai không gian cộng đồng, một cộng đồng tập dữ liệu và một cộng đồng dự án, nơi các nhà phát triển có thể đóng góp, tái sử dụng và cải thiện công việc của nhau. Trong buổi demo, anh ấy đã giới thiệu tính năng chú thích hỗ trợ AI, đào tạo đám mây dễ dàng và khả năng tinh chỉnh mô hình trực tiếp từ cộng đồng mà không cần sự hỗ trợ của địa phương. GPU tài nguyên.

Nền tảng này hiện đang trong quá trình phát triển. Prateek khuyến khích khán giả chú ý theo dõi thông báo và lưu ý rằng nhóm đang phát triển tại Trung Quốc để hỗ trợ việc ra mắt.

Với đà phát triển, sự kiện đã chuyển thành một cuộc thảo luận nhóm có sự tham gia của một số nhà nghiên cứu đứng sau các YOLO mô hình. Hội thảo bao gồm Glenn Jocher, cùng với Jing Qiu , Kỹ sư học máy cao cấp của chúng tôi; Chen Hui , Kỹ sư học máy tại Meta và là một trong những tác giả của YOLOv10 ; và Bo Zhang , một Nhà chiến lược thuật toán tại Meituan và là một trong những tác giả của YOLOv6 .

Cuộc thảo luận tập trung vào cách YOLO tiếp tục phát triển thông qua ứng dụng thực tế. Các diễn giả đã đề cập đến việc tiến độ thường được thúc đẩy bởi những thách thức triển khai thực tế, chẳng hạn như vận hành hiệu quả trên các thiết bị biên, cải thiện khả năng phát hiện vật thể nhỏ và đơn giản hóa việc xuất mô hình.

Thay vì chỉ tập trung vào độ chính xác, hội thảo đã lưu ý tầm quan trọng của việc cân bằng tốc độ, khả năng sử dụng và độ tin cậy trong môi trường sản xuất. Một điểm chung khác là giá trị của việc lặp lại và phản hồi từ cộng đồng.

Sau đây là một số thông tin thú vị khác từ cuộc trò chuyện:

Tiếp theo, chúng ta hãy cùng xem xét kỹ hơn một số bài phát biểu quan trọng tại YV25 Thâm Quyến, nơi các nhà lãnh đạo trong cộng đồng AI đã chia sẻ về sự phát triển của AI thị giác, từ con người và robot kỹ thuật số đến lý luận đa phương thức và triển khai hiệu quả tại biên.

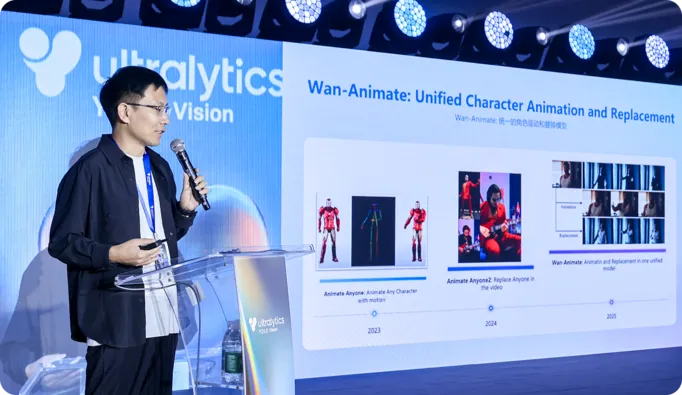

Trong một buổi chia sẻ sâu sắc, Tiến sĩ Peng Zhang từ Alibaba Qwen Lab đã chia sẻ về cách nhóm của ông đang phát triển các mô hình video lớn có thể tạo ra những con người kỹ thuật số biểu cảm với chuyển động và khả năng điều khiển tự nhiên hơn. Ông đã giới thiệu về Wan S2V và Wan Animate, hai công nghệ sử dụng tham chiếu âm thanh hoặc chuyển động để tạo ra lời nói, cử chỉ và hoạt hình chân thực, giải quyết những hạn chế của việc tạo ra các mô hình chỉ dựa trên văn bản.

Tiến sĩ Zhang cũng nói về tiến trình đang được thực hiện đối với các avatar tương tác thời gian thực, bao gồm cả việc sao chép ngoại hình và chuyển động mà không cần chụp và các mô hình nhẹ có thể hoạt hình hóa khuôn mặt trực tiếp từ nguồn cấp dữ liệu camera trực tiếp, giúp con người kỹ thuật số giống người thật có thể hoạt động mượt mà hơn trên các thiết bị hàng ngày.

Một trong những chủ đề chính tại YV25 Thâm Quyến là sự chuyển đổi từ các mô hình thị giác chỉ đơn thuần nhìn nhận thế giới sang các hệ thống có thể hoạt động trong đó. Nói cách khác, nhận thức không còn là điểm cuối của đường ống nữa; nó đang trở thành điểm khởi đầu của hành động.

Ví dụ, trong bài phát biểu quan trọng của mình, Hu Chunxu từ D-Robotics đã mô tả cách các bộ công cụ phát triển và giải pháp SoC (hệ thống trên chip) của họ tích hợp cảm biến, điều khiển chuyển động thời gian thực và ra quyết định trên một nền tảng phần cứng và phần mềm thống nhất. Bằng cách coi nhận thức và hành động như một vòng phản hồi liên tục, thay vì các giai đoạn riêng biệt, phương pháp của họ hỗ trợ robot có thể di chuyển, thích nghi và tương tác đáng tin cậy hơn trong môi trường thực tế.

Alex Zhang từ Baidu Paddle đã nhắc lại ý tưởng này trong bài phát biểu của mình, giải thích cách YOLO và PaddleOCR làm việc cùng nhau để detect Các đối tượng và sau đó diễn giải văn bản và cấu trúc xung quanh chúng. Điều này cho phép hệ thống chuyển đổi hình ảnh và tài liệu thành thông tin có cấu trúc, hữu ích cho các nhiệm vụ như hậu cần, kiểm tra và xử lý tự động.

Một chủ đề thú vị khác tại YV25 Thâm Quyến là cách Vision AI đang trở nên hiệu quả và có khả năng hơn trên các thiết bị biên .

Paul Jung từ DEEPX đã nói về việc triển khai YOLO Mô hình hóa trực tiếp trên phần cứng nhúng, giảm sự phụ thuộc vào đám mây. Bằng cách tập trung vào mức tiêu thụ điện năng thấp, suy luận tối ưu và điều chỉnh mô hình dựa trên phần cứng, DEEPX cho phép nhận thức thời gian thực cho máy bay không người lái, robot di động và hệ thống công nghiệp hoạt động trong môi trường năng động.

Tương tự như vậy, Liu Lingfei từ Moore Threads đã chia sẻ cách nền tảng Moore Threads E300 tích hợp bộ xử lý trung tâm ( CPU ), bộ xử lý đồ họa ( GPU ) và bộ xử lý thần kinh (NPU) để cung cấp khả năng suy luận thị giác tốc độ cao trên các thiết bị nhỏ gọn.

Nền tảng có thể chạy nhiều YOLO phát trực tuyến ở tốc độ khung hình cao, và chuỗi công cụ của nó đơn giản hóa các bước như lượng tử hóa, biên dịch tĩnh và điều chỉnh hiệu suất. Moore Threads cũng đã mã nguồn mở một bộ lớn các mô hình thị giác máy tính và ví dụ triển khai để giảm bớt rào cản cho các nhà phát triển.

Cho đến gần đây, việc xây dựng một mô hình duy nhất vừa có thể hiểu hình ảnh vừa diễn giải ngôn ngữ đòi hỏi những kiến trúc máy biến áp lớn, tốn kém chi phí vận hành. Tại YV25 Thâm Quyến, Yue Ziyin từ Yuanshi Intelligence đã trình bày tổng quan về RWKV, một kiến trúc kết hợp khả năng suy luận ngữ cảnh dài của máy biến áp với hiệu quả của các mô hình hồi quy.

Ông giải thích cách Vision-RWKV áp dụng thiết kế này vào thị giác máy tính bằng cách xử lý hình ảnh theo cách tuyến tính với độ phân giải. Điều này làm cho nó phù hợp với các đầu vào có độ phân giải cao và các thiết bị biên nơi khả năng tính toán bị hạn chế.

Yue cũng cho thấy cách RWKV được sử dụng trong các hệ thống ngôn ngữ thị giác, trong đó các đặc điểm hình ảnh được ghép nối với khả năng hiểu văn bản để vượt ra ngoài phạm vi phát hiện đối tượng và chuyển sang diễn giải các cảnh, tài liệu và bối cảnh thế giới thực.

Trong khi các buổi tọa đàm trên sân khấu hướng đến tương lai của AI thị giác, các gian hàng trên sàn trưng bày cho thấy công nghệ này đã và đang được ứng dụng như thế nào. Người tham dự được xem các mô hình vận hành thực tế, so sánh các tùy chọn phần cứng và trao đổi trực tiếp với các nhóm xây dựng hệ thống này.

Sau đây là cái nhìn thoáng qua về công nghệ được trưng bày:

Ngoài tất cả các công nghệ thú vị, một trong những phần tốt nhất của YV25 Thâm Quyến là mang đến cộng đồng thị giác máy tính và Ultralytics lại họp trực tiếp với nhau. Suốt cả ngày, mọi người tụ tập quanh các buổi demo, chia sẻ ý tưởng trong giờ nghỉ giải lao và tiếp tục trò chuyện rất lâu sau khi buổi thảo luận kết thúc.

Các nhà nghiên cứu, kỹ sư, sinh viên và thợ xây đã so sánh ghi chú, đặt câu hỏi và trao đổi kinh nghiệm thực tế từ khâu triển khai đến đào tạo mô hình. Và nhờ Cinco Jotas từ Grupo Osborne , chúng tôi thậm chí còn mang đến một chút văn hóa Tây Ban Nha cho sự kiện với món thịt nguội jamón mới thái, tạo nên một khoảnh khắc kết nối ấm áp. Một địa điểm tuyệt đẹp, một đám đông cuồng nhiệt và một cảm giác chung về động lực đã làm cho ngày hôm đó thực sự đặc biệt.

Từ những bài phát biểu quan trọng đầy cảm hứng đến các bản demo thực hành, YOLO Tầm nhìn 2025 Thâm Quyến đã nắm bắt được tinh thần đổi mới định hình Ultralytics Cộng đồng. Trong suốt cả ngày, các diễn giả và người tham dự đã trao đổi ý tưởng, khám phá các công nghệ mới và kết nối với nhau thông qua tầm nhìn chung về tương lai của AI. Cùng nhau, họ rời đi với năng lượng tràn đầy và sẵn sàng cho những điều sắp tới. Ultralytics YOLO .

Hãy tưởng tượng lại những gì có thể với AI và thị giác máy tính. Tham gia cộng đồng và kho lưu trữ GitHub của chúng tôi để khám phá thêm. Tìm hiểu thêm về các ứng dụng như thị giác máy tính trong nông nghiệp và AI trong bán lẻ . Khám phá các tùy chọn cấp phép của chúng tôi và bắt đầu với thị giác máy tính ngay hôm nay!