Erfahren Sie, wie Mask R-CNN verwendet werden kann, um Objekte in Bildern und Videos für verschiedene Anwendungen in unterschiedlichen Bereichen präzise segment .

Erfahren Sie, wie Mask R-CNN verwendet werden kann, um Objekte in Bildern und Videos für verschiedene Anwendungen in unterschiedlichen Bereichen präzise segment .

Innovationen wie Roboter in Lagerhäusern, selbstfahrende Autos, die sich sicher durch belebte Straßen bewegen, Drohnen, die Feldfrüchte überprüfen, und KI-Systeme, die Produkte in Fabriken inspizieren, werden mit zunehmender Verbreitung von KI immer häufiger. Eine Schlüsseltechnologie, die diese Innovationen vorantreibt, ist Computer Vision, ein Zweig der KI, der es Maschinen ermöglicht, visuelle Daten zu verstehen und zu interpretieren.

Die Objekterkennung ist beispielsweise eine Computer-Vision-Aufgabe, die hilft, Objekte in Bildern mithilfe von Begrenzungsrahmen zu identifizieren und zu lokalisieren. Begrenzungsrahmen bieten zwar hilfreiche Informationen, liefern aber nur eine grobe Schätzung der Position eines Objekts und können seine genaue Form oder seine Grenzen nicht erfassen. Dies macht sie weniger effektiv in Anwendungen, die eine präzise Identifizierung erfordern.

Um dieses Problem zu lösen, entwickelten Forscher Segmentierungsmodelle, die die exakten Konturen von Objekten erfassen und so pixelgenaue Details für eine genauere Erkennung und Analyse liefern.

Mask R-CNN ist eines dieser Modelle. Es wurde 2017 von Facebook AI Research (FAIR) eingeführt und baut auf früheren Modellen wie R-CNN, Fast R-CNN und Faster R-CNN auf. Als wichtiger Meilenstein in der Geschichte der Computer Vision hat Mask R-CNN den Weg für fortschrittlichere Modelle geebnet, wie z. B. Ultralytics YOLO11.

In diesem Artikel wird untersucht, was Maske R-CNN ist, wie sie funktioniert, welche Anwendungen es gibt und welche Verbesserungen nach ihr kamen, die zu YOLO11 führten.

Mask R-CNN, was für Mask Region-based Convolutional Neural Network steht, ist ein Deep-Learning-Modell, das für Computer-Vision-Aufgaben wie Objekterkennung und Instanzsegmentierung entwickelt wurde.

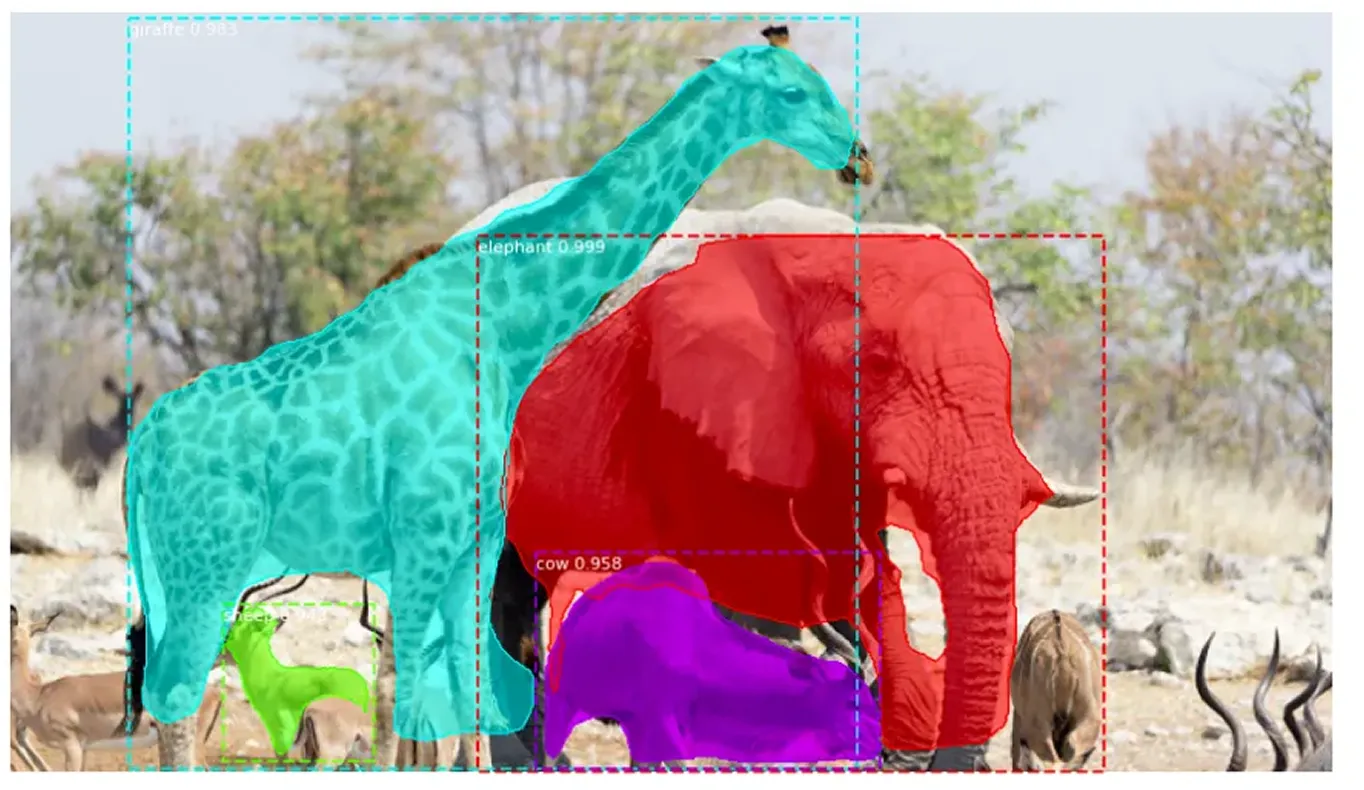

Die Instanzsegmentierung geht über die traditionelle Objekterkennung hinaus, indem sie nicht nur Objekte in einem Bild identifiziert, sondern auch jedes einzelne genau umreißt. Sie weist jedem erkannten Objekt eine eindeutige Bezeichnung zu und erfasst seine exakte Form auf Pixelebene. Dieser detaillierte Ansatz ermöglicht es, klar zwischen überlappenden Objekten zu unterscheiden und komplexe Formen präzise zu verarbeiten.

Mask R-CNN baut auf Faster R-CNN auf, das Objekte erkennt und beschriftet, aber nicht ihre genauen Formen definiert. Mask R-CNN verbessert dies, indem es die exakten Pixel identifiziert, aus denen jedes Objekt besteht, was eine viel detailliertere und genauere Bildanalyse ermöglicht.

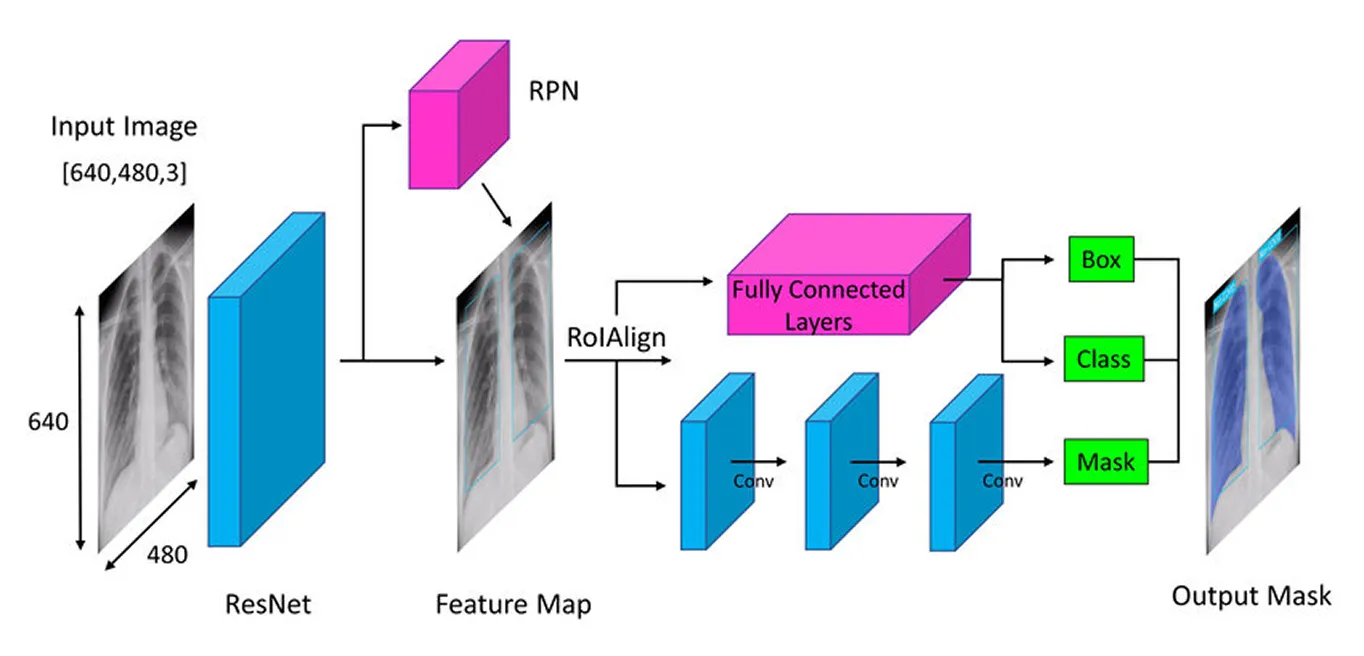

Mask R-CNN verfolgt einen schrittweisen Ansatz zur genauen detect und segment von Objekten. Es beginnt mit der Extraktion von Schlüsselmerkmalen mithilfe eines tiefen neuronalen Netzwerks (ein mehrschichtiges Modell, das aus Daten lernt), identifiziert dann potenzielle Objektbereiche mit einem Regionsvorschlagsnetzwerk (eine Komponente, die wahrscheinliche Objektregionen vorschlägt) und verfeinert diese Bereiche schließlich durch die Erstellung detaillierter Segmentierungsmasken (genaue Umrisse von Objekten), die die genaue Form jedes Objekts erfassen.

Als Nächstes werden wir jeden Schritt durchgehen, um eine bessere Vorstellung davon zu bekommen, wie Mask R-CNN funktioniert.

Der erste Schritt in der Architektur von Mask R-CNN besteht darin, das Bild in seine Hauptbestandteile zu zerlegen, damit das Modell verstehen kann, was sich darin befindet. Stellen Sie sich das so vor, als würden Sie ein Foto betrachten und auf natürliche Weise Details wie Formen, Farben und Kanten wahrnehmen. Das Modell macht etwas Ähnliches mit einem tiefen neuronalen Netzwerk, das als "Backbone" (oft ResNet-50 oder ResNet-101) bezeichnet wird und wie seine Augen fungiert, um das Bild zu scannen und wichtige Details zu erkennen.

Da Objekte in Bildern sehr klein oder sehr groß sein können, verwendet Mask R-CNN ein Feature Pyramid Network. Dies ist wie eine Lupe mit der das Modell sowohl feine Details als auch das Gesamtbild erkennen kann, wodurch sichergestellt wird, dass Objekte aller Größen wahrgenommen werden.

Sobald diese wichtigen Merkmale extrahiert wurden, geht das Modell dazu über, die potenziellen Objekte im Bild zu lokalisieren und bereitet so die Bühne für weitere Analysen.

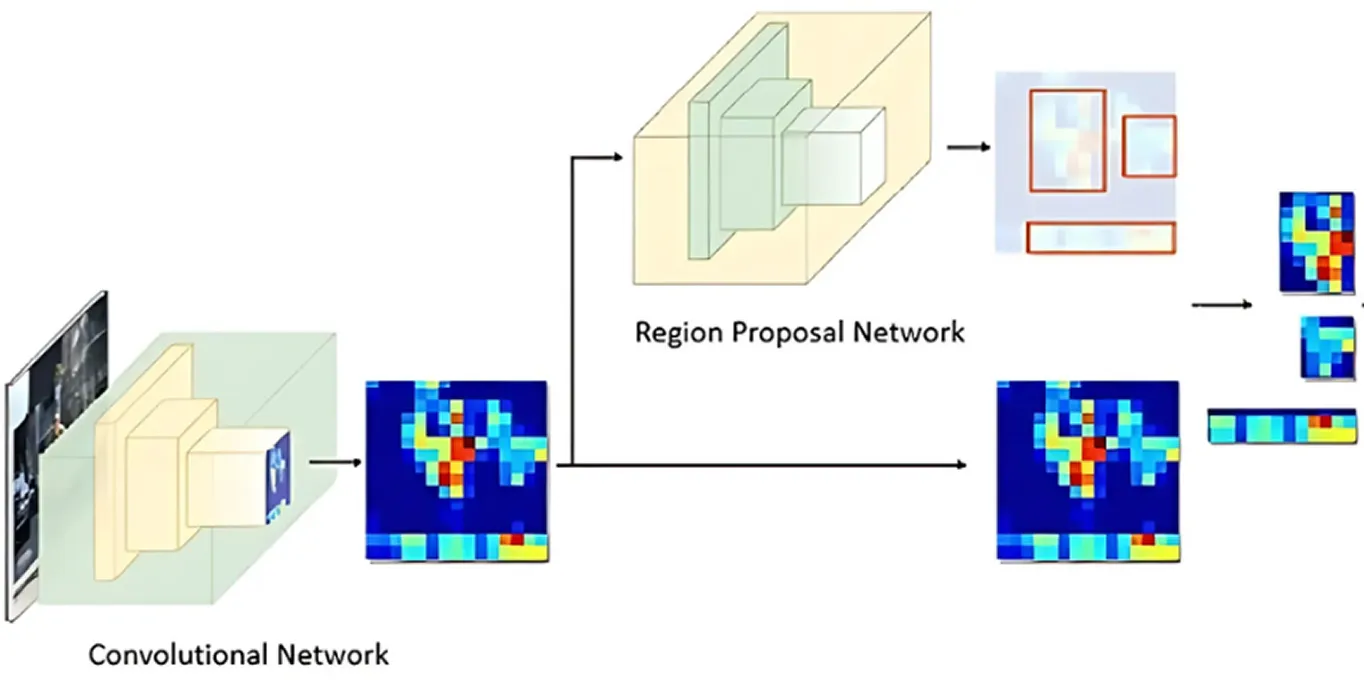

Nachdem das Bild auf wichtige Merkmale hin verarbeitet wurde, übernimmt das Region Proposal Network. Dieser Teil des Modells betrachtet das Bild und schlägt Bereiche vor, die wahrscheinlich Objekte enthalten.

Dies geschieht, indem mehrere mögliche Objektpositionen generiert werden, die als Anker bezeichnet werden. Das Netzwerk bewertet dann diese Anker und wählt die vielversprechendsten für die weitere Analyse aus. Auf diese Weise konzentriert sich das Modell nur auf die Bereiche, die am wahrscheinlichsten von Interesse sind, anstatt jede einzelne Stelle im Bild zu überprüfen.

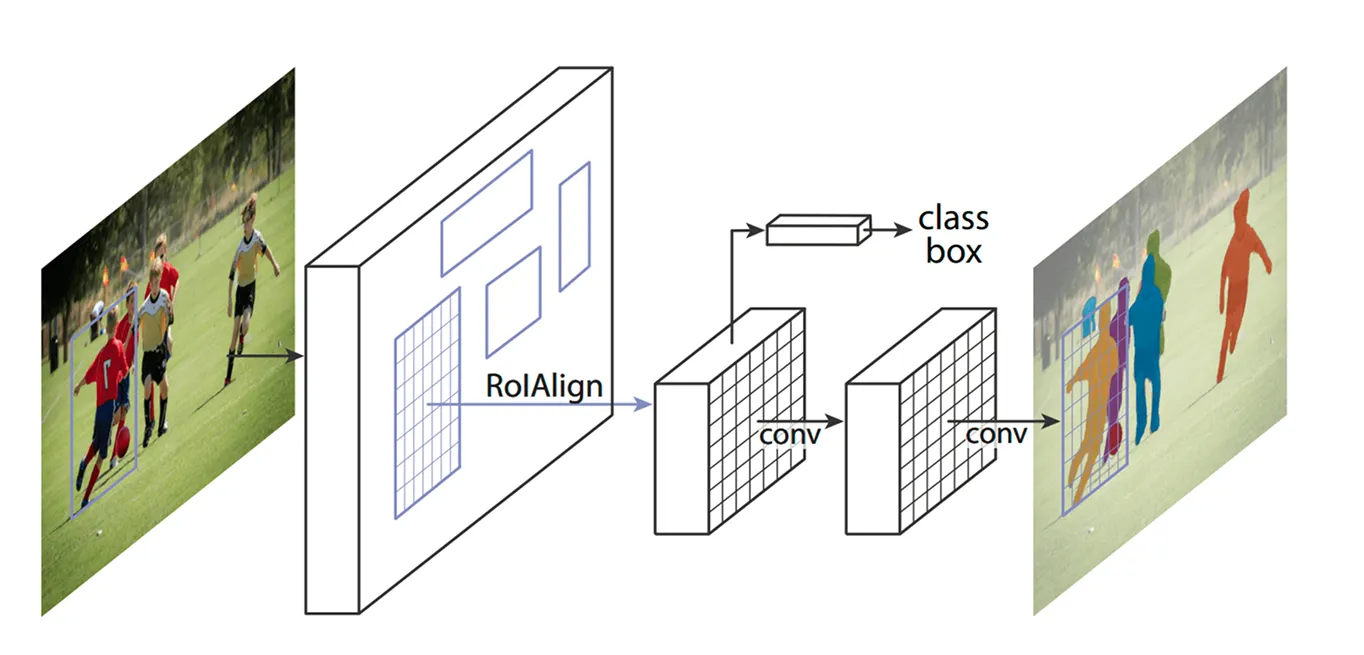

Nachdem die Schlüsselbereiche identifiziert wurden, besteht der nächste Schritt darin, die aus diesen Regionen extrahierten Details zu verfeinern. Frühere Modelle verwendeten eine Methode namens ROI Pooling (Region of Interest Pooling), um Merkmale aus jedem Bereich zu erfassen, aber diese Technik führte manchmal zu leichten Fehlstellungen beim Anpassen der Größe von Regionen, was sie weniger effektiv machte - insbesondere bei kleineren oder überlappenden Objekten.

Mask R-CNN verbessert dies durch die Verwendung einer Technik, die als ROI Align (Region of Interest Align) bezeichnet wird. Anstatt Koordinaten wie beim ROI Pooling zu runden, verwendet ROI Align bilineare Interpolation, um Pixelwerte genauer zu schätzen. Bilineare Interpolation ist eine Methode, die einen neuen Pixelwert berechnet, indem sie die Werte seiner vier nächsten Nachbarn mittelt, was weichere Übergänge erzeugt. Dadurch bleiben die Merkmale korrekt auf das Originalbild ausgerichtet, was zu einer genaueren Objekterkennung und -segmentierung führt.

In einem Fußballspiel könnten beispielsweise zwei Spieler, die nahe beieinander stehen, miteinander verwechselt werden, weil sich ihre Bounding Boxes überschneiden. ROI Align hilft, sie zu trennen, indem ihre Formen unterschiedlich bleiben.

Sobald ROI Align das Bild verarbeitet hat, besteht der nächste Schritt in der classify Objekte und der Feinabstimmung ihrer Position. Das Modell sieht sich jede extrahierte Region an und entscheidet, welches Objekt sie enthält. Es ordnet den verschiedenen Kategorien eine Wahrscheinlichkeitsbewertung zu und wählt die beste Übereinstimmung aus.

Gleichzeitig passt es die Bounding Boxes an, um die Objekte besser zu erfassen. Die anfänglichen Boxen sind möglicherweise nicht ideal platziert, daher trägt dies zur Verbesserung der Genauigkeit bei, indem sichergestellt wird, dass jede Box das erkannte Objekt eng umschließt.

Schließlich geht Mask R-CNN noch einen Schritt weiter: Es generiert parallel eine detaillierte Segmentierungsmaske für jedes Objekt.

Als dieses Modell auf den Markt kam, wurde es von der KI-Gemeinschaft mit großer Begeisterung aufgenommen und bald in verschiedenen Anwendungen eingesetzt. Seine Fähigkeit, Objekte in Echtzeit detect und zu segment , machte es zu einem Wendepunkt in verschiedenen Branchen.

Zum Beispiel ist es eine schwierige Aufgabe, gefährdete Tiere in freier Wildbahn aufzuspüren. Viele Arten bewegen sich durch dichte Wälder, so dass es für Naturschützer schwierig ist, sie im track . Herkömmliche Methoden nutzen Kamerafallen, Drohnen und Satellitenbilder, aber das manuelle Sortieren all dieser Daten ist zeitaufwändig. Falsche Identifizierungen und verpasste Sichtungen können die Schutzbemühungen verlangsamen.

Durch die Erkennung einzigartiger Merkmale wie Tigerstreifen, Giraffenflecken oder die Form von Elefantenohren kann Mask R-CNN Tiere in Bildern und Videos mit größerer Genauigkeit detect und segment . Selbst wenn Tiere teilweise von Bäumen verdeckt werden oder dicht beieinander stehen, kann das Modell sie trennen und jedes einzelne identifizieren, was die Überwachung von Wildtieren schneller und zuverlässiger macht.

Trotz seiner historischen Bedeutung in der Objekterkennung und -segmentierung weist Mask R-CNN auch einige wesentliche Nachteile auf. Hier sind einige Herausforderungen im Zusammenhang mit Mask R-CNN:

Masken-R-CNN war hervorragend für Segmentierungsaufgaben geeignet, aber viele Branchen wollten Computer Vision einsetzen und legten dabei Wert auf Geschwindigkeit und Echtzeitleistung. Diese Anforderung veranlasste die Forscher, einstufige Modelle zu entwickeln, die Objekte in einem einzigen Durchgang detect und so die Effizienz erheblich verbessern.

Im Gegensatz zu dem mehrstufigen Prozess von Mask R-CNN konzentrieren sich einstufige Computer-Vision-Modelle wie YOLO (You Only Look Once) auf Echtzeit-Computer-Vision-Aufgaben. Anstatt Erkennung und Segmentierung getrennt zu behandeln, können YOLO ein Bild in einem Durchgang analysieren. Dies macht sie ideal für Anwendungen wie autonomes Fahren, Gesundheitswesen, Fertigung und Robotik, bei denen eine schnelle Entscheidungsfindung entscheidend ist.

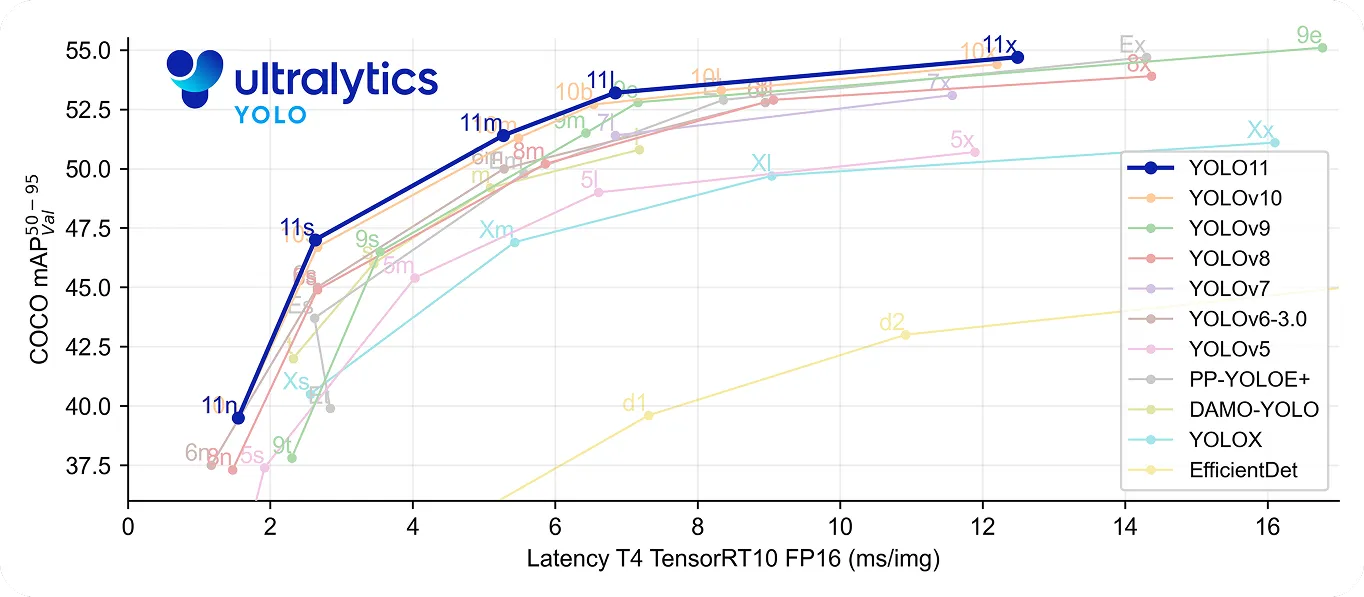

YOLO11 geht noch einen Schritt weiter, indem es sowohl schnell als auch genau ist. Es verwendet 22 % weniger Parameter als YOLOv8m und erreicht dennoch eine höhere durchschnittliche GenauigkeitmAP) auf dem COCO , d. h. es erkennt Objekte präziser. Die verbesserte Verarbeitungsgeschwindigkeit macht es zu einer guten Wahl für Echtzeitanwendungen, bei denen es auf jede Millisekunde ankommt.

Rückblickend auf die Geschichte der Computer Vision wird Mask R-CNN als ein wichtiger Durchbruch in der Objektdetektion und -segmentierung angesehen. Dank seines detaillierten, mehrstufigen Prozesses liefert es auch in komplexen Umgebungen sehr präzise Ergebnisse.

Dieser Prozess macht sie jedoch langsamer als Echtzeitmodelle wie YOLO. Da der Bedarf an Geschwindigkeit und Effizienz wächst, verwenden viele Anwendungen jetzt einstufige Modelle wie Ultralytics YOLO11, die eine schnelle und genaue Objekterkennung bieten. Die Maske R-CNN ist zwar wichtig für das Verständnis der Entwicklung der Computer Vision, aber der Trend zu Echtzeitlösungen unterstreicht die wachsende Nachfrage nach schnelleren und effizienteren Computer Vision Lösungen.

Treten Sie unserer wachsenden Community bei! Erkunden Sie unser GitHub-Repository, um mehr über KI zu erfahren. Sind Sie bereit, Ihre eigenen Computer-Vision-Projekte zu starten? Sehen Sie sich unsere Lizenzoptionen an. Entdecken Sie KI in der Landwirtschaft und Vision AI im Gesundheitswesen, indem Sie unsere Lösungsseiten besuchen!