Узнайте, как SAM 3, новая модель Segment Anything Model от Meta AI, позволяет легко detect, segment и track объекты на реальных изображениях и видео.

Узнайте, как SAM 3, новая модель Segment Anything Model от Meta AI, позволяет легко detect, segment и track объекты на реальных изображениях и видео.

19 ноября 2025 года компания Meta AI выпустила Segment Anything Model 3, также известную как SAM 3. В этой последней версии Segment Anything Model представлены новые способы detect, segment и track объектов на реальных изображениях и видео с помощью текстовых, визуальных подсказок и примеров изображений.

Модель SAM 3 основывается на SAM и SAM 2 и привносит новые усовершенствования и функции, такие как сегментация понятий, определение открытого словарного запаса и отслеживание видео в реальном времени. Она способна понимать короткие фразы существительных, следить за объектами в кадре и определять тонкие или редкие понятия, с которыми предыдущие модели справлялись не так уверенно.

В рамках выпуска SAM 3 компания Meta также представила SAM 3D. Этот набор моделей нового поколения позволяет восстанавливать объекты, сцены и целые человеческие тела по одному изображению и расширяет экосистему Segment Anything до 3D-понимания. Эти дополнения открывают новые возможности для применения в компьютерном зрении, робототехнике, редактировании мультимедиа и творческих процессах.

В этой статье мы рассмотрим, что такое SAM 3, чем он отличается от SAM 2, как работает модель и каковы ее реальные возможности применения. Давайте начнем!

SAM 3 - это современная модель компьютерного зрения, которая позволяет идентифицировать, разделять и track объекты на изображениях и видео, основываясь на простых инструкциях. Вместо того чтобы полагаться на фиксированный список меток, SAM 3 понимает естественный язык и визуальные подсказки, что позволяет легко объяснить модели, что вы хотите найти.

Например, с помощью SAM 3 вы можете ввести короткую фразу типа "желтый школьный автобус" или "полосатый кот", щелкнуть на объекте или выделить пример на изображении. Модель detect все совпадающие объекты и создаст чистые маски сегментации (визуальный контур, показывающий, какие именно пиксели принадлежат объекту). SAM 3 также может отслеживать эти объекты на протяжении всех кадров видео, сохраняя их последовательность при перемещении.

Еще одна интересная часть анонса Meta AI - SAM 3D, которая расширяет проект Segment Anything до 3D-понимания. SAM 3D может взять одно 2D-изображение и восстановить форму, позу или структуру объекта или человеческого тела в трех измерениях. Другими словами, модель может оценить, как что-то занимает пространство, даже если доступна только одна точка зрения.

SAM 3D был выпущен в виде двух различных моделей: SAM 3D Objects, восстанавливающая геометрию и текстуру повседневных предметов, и SAM 3D Body, оценивающая форму и позу человеческого тела по одному изображению. Обе модели используют результаты сегментации, полученные в SAM 3, а затем генерируют 3D-представление, соответствующее внешнему виду и положению объекта на исходной фотографии.

Вот некоторые из ключевых обновлений SAM 3, позволяющих объединить обнаружение, сегментацию и отслеживание в единую модель:

Допустим, вы смотрите видео с сафари, в котором много разных животных, и вам нужно detect и segment только слонов. Как будет выглядеть эта задача в разных версиях SAM?

При использовании SAM вам придется вручную нажимать на каждого слона в каждом кадре, чтобы создать маску сегментации. Отслеживания нет, поэтому каждый новый кадр требует новых щелчков.

В SAM 2 вы можете один раз щелкнуть на слоне, получить его маску, и модель будет track этого слона на протяжении всего видео. Однако для segment нескольких слонов (конкретных объектов) вам все равно придется делать отдельные щелчки, поскольку SAM 2 не понимает такие категории, как "слон", самостоятельно.

С SAM 3 рабочий процесс значительно упрощается. Вы можете ввести слово "слон" или нарисовать ограничительную рамку вокруг одного слона для примера, и модель автоматически найдет всех слонов в видео, segment их и будет track их последовательно по всем кадрам. Модель по-прежнему поддерживает подсказки в виде щелчков и квадратиков, использовавшиеся в предыдущих версиях, но теперь она также может реагировать на текстовые подсказки и изображения-примеры, чего не могли сделать SAM и SAM 2.

Далее рассмотрим подробнее, как работает модель SAM 3 и как она была обучена.

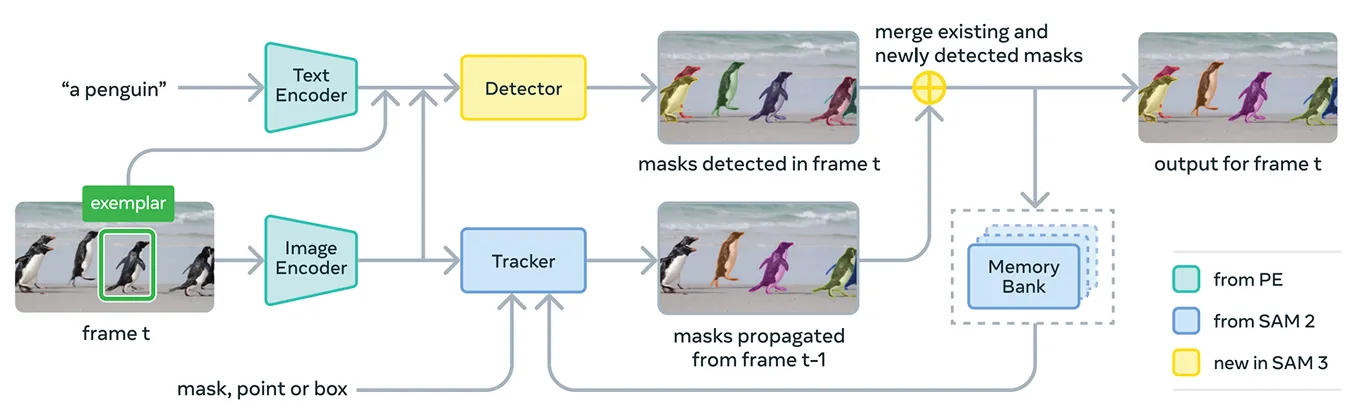

SAM 3 объединяет несколько компонентов для поддержки концептуальных и визуальных подсказок в одной системе. В основе модели лежит Meta Perception Encoder - унифицированный кодировщик изображений и текстов с открытым исходным кодом компании Meta.

Этот кодировщик может обрабатывать как изображения, так и короткие фразы существительных. Проще говоря, это позволяет SAM 3 связывать языковые и визуальные особенности более эффективно, чем предыдущие версии Segment Anything Model.

В дополнение к этому кодировщику SAM 3 включает детектор, основанный на семействе трансформаторных моделей DETR. Этот детектор идентифицирует объекты на изображении и помогает системе определить, какие объекты соответствуют подсказке пользователя.

В частности, для сегментации видео в SAM 3 используется компонент отслеживания, построенный на базе банка памяти и кодировщика памяти из SAM 2. Это позволяет модели хранить информацию об объектах в разных кадрах, чтобы повторно идентифицировать и track их с течением времени.

Для обучения SAM 3 компании Meta потребовалось гораздо больше аннотированных данных, чем существует в настоящее время в Интернете. Высококачественные маски сегментации и текстовые метки сложно создавать в больших масштабах, а полное описание каждого экземпляра понятия на изображениях и видео - медленное и дорогостоящее занятие.

Чтобы решить эту проблему, компания Meta создала новый механизм обработки данных, который объединяет сам SAM 3, дополнительные модели искусственного интеллекта и человеческих аннотаторов. Рабочий процесс начинается с конвейера систем искусственного интеллекта, включая SAM 3 и модель субтитров на основе Llama.

Эти системы сканируют большие коллекции изображений и видео, генерируют подписи, преобразуют их в текстовые метки и создают кандидатов на ранние маски сегментации. Затем эти кандидатуры просматривают аннотаторы из числа людей и искусственного интеллекта.

ИИ-аннотаторы, обученные с точностью до человека или даже превосходящие его в таких задачах, как проверка качества масок и проверка охвата концепций, отсеивают простые случаи. Люди подключаются только к более сложным примерам, в которых модель может не справиться.

Такой подход позволяет Meta значительно увеличить скорость аннотирования. Позволяя ИИ-аннотаторам обрабатывать легкие случаи, конвейер становится примерно в пять раз быстрее при работе с отрицательными подсказками и на 36 % быстрее при работе с положительными подсказками в доменах с тонкой структурой.

Такая эффективность позволила увеличить набор данных до более чем четырех миллионов уникальных понятий. Постоянный цикл из предложений ИИ, человеческих исправлений и обновленных прогнозов модели также улучшает качество меток с течением времени и помогает SAM 3 изучать гораздо более широкий набор визуальных и текстовых понятий.

Что касается производительности, то SAM 3 демонстрирует явное улучшение по сравнению с предыдущими моделями. В новом бенчмарке SA-Co от Meta, который оценивает обнаружение и сегментацию концептов в открытом словаре, SAM 3 достигает примерно вдвое большей производительности, чем предыдущие системы, как в изображениях, так и в видео.

Он также соответствует или превосходит SAM 2 в интерактивных визуальных задачах, таких как "укажи на маску" и "маска на маску". Meta сообщает о дополнительных достижениях в более сложных задачах, таких как zero-shot LVIS (когда модели должны распознавать редкие категории без обучающих примеров) и подсчет объектов (измерение того, все ли экземпляры объекта обнаружены), что свидетельствует о более сильной обобщенности в разных областях.

Помимо повышения точности, SAM 3 отличается высокой производительностью: он обрабатывает изображение с более чем 100 обнаруженными объектами примерно за 30 миллисекунд на GPU H200 и поддерживает скорость, близкую к реальному времени, при отслеживании нескольких объектов на видео.

Теперь, когда мы лучше понимаем, что такое SAM 3, давайте рассмотрим, как он используется в реальных приложениях - от продвинутых текстовых рассуждений до научных исследований и собственных продуктов Meta.

SAM 3 также можно использовать как инструмент внутри более крупной мультимодальной языковой модели, которую Meta называет SAM 3 Agent. Вместо того чтобы дать SAM 3 короткую фразу, например "слон", агент может разбить более сложный вопрос на более мелкие подсказки, которые SAM 3 поймет.

Например, если пользователь спрашивает: "Какой предмет на картинке используется для управления лошадью?", агент пробует разные фразы существительных, отправляет их в SAM 3 и проверяет, какие маски имеют смысл. Он продолжает уточнять, пока не найдет нужный объект.

Даже не будучи обученным на специальных наборах данных для рассуждений, агент SAM 3 демонстрирует отличные результаты в тестах, предназначенных для сложных текстовых запросов, таких как ReasonSeg и OmniLabel. Это показывает, что SAM 3 может поддерживать системы, которым требуется как понимание языка, так и тонкая визуальная сегментация.

Интересно, что SAM 3 уже используется в исследовательских целях, где важны подробные визуальные метки. Meta сотрудничала с Conservation X Labs и Osa Conservation для создания SA-FARI, публичного набора данных мониторинга дикой природы, содержащего более 10 000 видеозаписей с камер-ловушек.

Каждое животное в каждом кадре помечено рамками и масками сегментации, что потребовало бы очень много времени для аннотирования вручную. Аналогичным образом, в океанических исследованиях SAM 3 используется совместно с FathomNet и MBARI для создания масок сегментации экземпляров для подводных снимков и поддержки новых эталонов оценки.

Такие наборы данных помогают ученым более эффективно анализировать видеоматериалы и изучать животных и среду обитания, которые обычно сложно track в масштабе. Исследователи также могут использовать эти ресурсы для создания собственных моделей для идентификации видов, анализа поведения и автоматизированного экологического мониторинга.

Помимо использования в научных исследованиях, SAM 3 также позволяет реализовать новые функции и варианты использования в потребительских продуктах Meta. Вот некоторые из способов его интеграции:

SAM 3 - это потрясающий шаг вперед в области сегментации. В нем появились сегментация понятий, текстовые подсказки с открытым словарем и улучшенное отслеживание. Благодаря заметно более высокой производительности на изображениях и видео, а также добавлению SAM 3D, набор моделей открывает новые возможности для искусственного интеллекта, творческих инструментов, научных исследований и реальных продуктов.

Присоединяйтесь к нашему сообществу и изучайте наш репозиторий GitHub, чтобы узнать больше об искусственном интеллекте. Если вы хотите создать свой собственный проект Vision AI, ознакомьтесь с нашими возможностями лицензирования. Посетите страницы наших решений и узнайте больше о таких областях применения, как ИИ в здравоохранении и ИИ в розничной торговле.