Triển khai các ứng dụng thị giác máy tính trên các thiết bị AI biên

Khám phá cách Edge AI và NVIDIA những đổi mới của, như Jetson, Triton , Và TensorRT , đang đơn giản hóa việc triển khai các ứng dụng thị giác máy tính.

Khám phá cách Edge AI và NVIDIA những đổi mới của, như Jetson, Triton , Và TensorRT , đang đơn giản hóa việc triển khai các ứng dụng thị giác máy tính.

Nhờ những tiến bộ gần đây trong lĩnh vực thị giác máy tính và trí tuệ nhân tạo (AI), lĩnh vực từng chỉ là nghiên cứu này hiện đang thúc đẩy các ứng dụng có tác động lớn trong nhiều ngành công nghiệp. Từ xe tự lái đến hình ảnh y tế và an ninh, các hệ thống thị giác máy tính đang giải quyết các vấn đề thực tế trên quy mô lớn.

Nhiều ứng dụng trong số này liên quan đến việc phân tích hình ảnh và video theo thời gian thực và việc dựa vào điện toán đám mây không phải lúc nào cũng thiết thực do độ trễ, chi phí và các vấn đề về quyền riêng tư. Edge AI là một giải pháp tuyệt vời trong những tình huống này. Bằng cách chạy các mô hình Vision AI trực tiếp trên các thiết bị edge, các doanh nghiệp có thể xử lý dữ liệu nhanh hơn, tiết kiệm chi phí hơn và bảo mật hơn, giúp AI thời gian thực trở nên dễ tiếp cận hơn.

Trong YOLO Vision 2024 (YV24) , sự kiện kết hợp thường niên do Ultralytics , một trong những chủ đề chính là dân chủ hóa Vision AI bằng cách triển khai thân thiện và hiệu quả hơn với người dùng. Guy Dahan , Kiến trúc sư Giải pháp Cấp cao tại NVIDIA , đã thảo luận về cách NVIDIA Các giải pháp phần cứng và phần mềm, bao gồm các thiết bị điện toán biên, máy chủ suy luận, khuôn khổ tối ưu hóa và SDK triển khai AI, đang giúp các nhà phát triển tối ưu hóa AI tại biên.

Trong bài viết này, chúng ta sẽ khám phá những điểm chính từ bài phát biểu quan trọng của Guy Dahan tại YV24 và cách NVIDIA Những cải tiến mới nhất của Vision AI đang giúp việc triển khai trở nên nhanh hơn và có khả năng mở rộng hơn.

Guy Dahan bắt đầu bài phát biểu của mình bằng cách bày tỏ sự nhiệt tình của mình khi tham gia YV24 trực tuyến và sự quan tâm của mình đối với Ultralytics Python gói và Ultralytics Các mô hình YOLO , nói rằng, "Tôi đã sử dụng Ultralytics kể từ ngày nó ra mắt. Tôi thực sự thích Ultralytics - Tôi đã sử dụng YOLOv5 thậm chí trước đó nữa, và tôi thực sự đam mê gói sản phẩm này."

Sau đó, ông giới thiệu khái niệm Edge AI, giải thích rằng nó liên quan đến việc chạy các tính toán AI trực tiếp trên các thiết bị như máy ảnh, máy bay không người lái hoặc máy móc công nghiệp, thay vì gửi dữ liệu đến các máy chủ đám mây ở xa để xử lý.

Thay vì chờ hình ảnh hoặc video được tải lên, phân tích và sau đó gửi lại kết quả, Edge AI giúp bạn có thể phân tích dữ liệu ngay lập tức trên chính thiết bị. Điều này làm cho các hệ thống Vision AI nhanh hơn, hiệu quả hơn và ít phụ thuộc hơn vào kết nối internet. Edge AI đặc biệt hữu ích cho các ứng dụng ra quyết định theo thời gian thực, chẳng hạn như xe tự lái, camera an ninh và nhà máy thông minh.

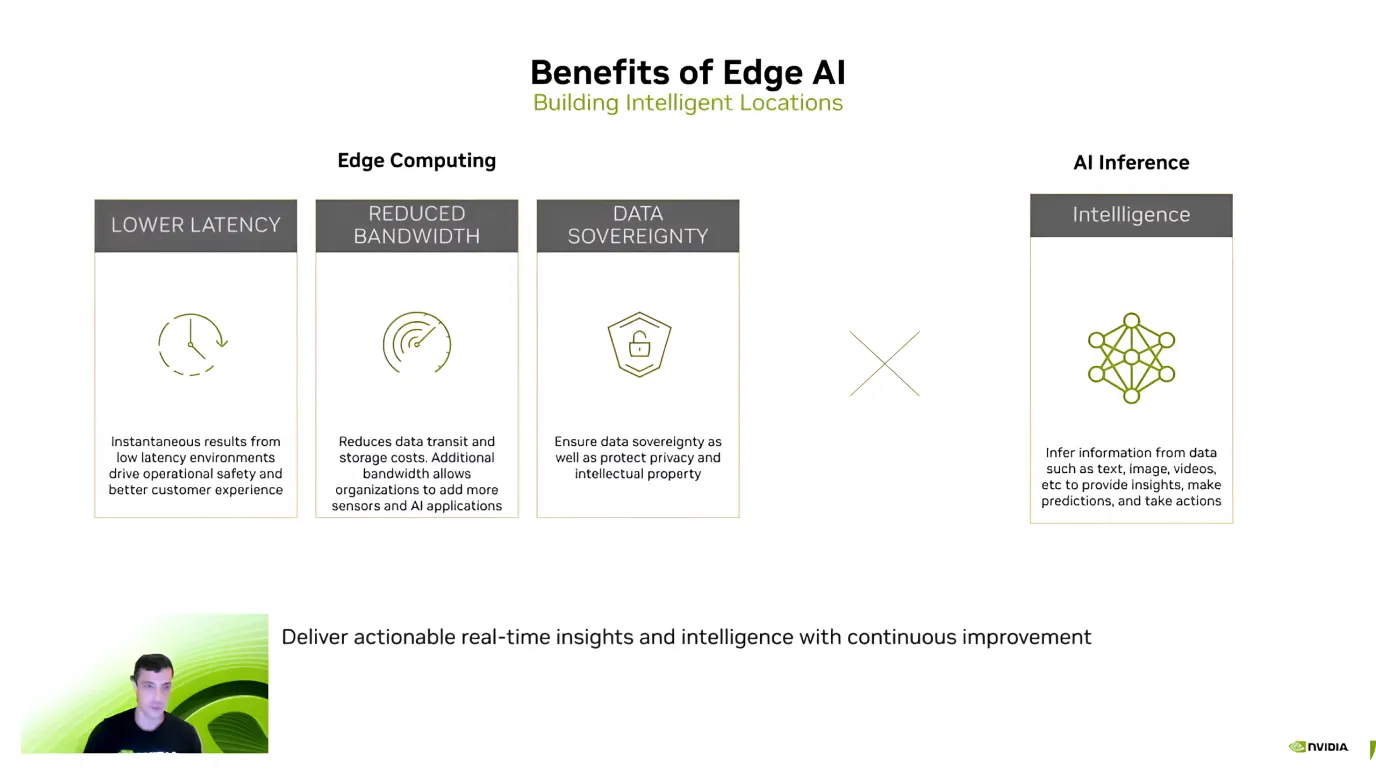

Sau khi giới thiệu về Edge AI, Guy Dahan đã nhấn mạnh những ưu điểm chính của nó, tập trung vào hiệu quả, tiết kiệm chi phí và bảo mật dữ liệu. Ông giải thích rằng một trong những lợi ích lớn nhất là độ trễ thấp - vì các mô hình AI xử lý dữ liệu trực tiếp trên thiết bị nên không cần gửi thông tin lên đám mây và chờ phản hồi.

Edge AI cũng giúp giảm chi phí và bảo vệ dữ liệu nhạy cảm. Việc gửi một lượng lớn dữ liệu lên đám mây, đặc biệt là các luồng video, có thể tốn kém. Tuy nhiên, việc xử lý cục bộ sẽ giảm chi phí băng thông và lưu trữ.

Một ưu điểm chính khác là quyền riêng tư dữ liệu vì thông tin vẫn còn trên thiết bị thay vì được chuyển đến máy chủ bên ngoài. Điều này đặc biệt quan trọng đối với các ứng dụng chăm sóc sức khỏe, tài chính và bảo mật, nơi việc giữ dữ liệu cục bộ và an toàn là ưu tiên hàng đầu.

Dựa trên những lợi ích này, Guy Dahan đã bình luận về việc áp dụng Edge AI ngày càng tăng. Ông lưu ý rằng kể từ khi NVIDIA Kể từ khi Jetson được giới thiệu vào năm 2014, lượng sử dụng đã tăng gấp mười lần. Hiện nay, hơn 1,2 triệu nhà phát triển đang làm việc với các thiết bị Jetson.

Sau đó, Guy Dahan tập trung vào các thiết bị NVIDIA Jetson , một dòng thiết bị điện toán biên AI được thiết kế để mang lại hiệu suất cao với mức tiêu thụ điện năng thấp. Thiết bị Jetson lý tưởng cho các ứng dụng thị giác máy tính trong các lĩnh vực như robot, nông nghiệp, chăm sóc sức khỏe và tự động hóa công nghiệp. "Jetson là thiết bị AI biên được thiết kế riêng cho AI. Tôi thậm chí có thể nói thêm rằng ban đầu chúng được thiết kế chủ yếu cho thị giác máy tính", Guy Dahan nói thêm.

Các thiết bị Jetson có ba cấp độ, mỗi cấp độ phù hợp với các nhu cầu khác nhau:

Ngoài ra, Guy Dahan đã chia sẻ về Jetson AGX Thor sắp ra mắt, ra mắt trong năm nay và cho biết nó sẽ cung cấp gấp tám lần GPU (Bộ xử lý đồ họa) hiệu suất, dung lượng bộ nhớ gấp đôi và cải thiện CPU Hiệu suất (Bộ xử lý trung tâm). Được thiết kế đặc biệt cho robot hình người và các ứng dụng AI tiên tiến.

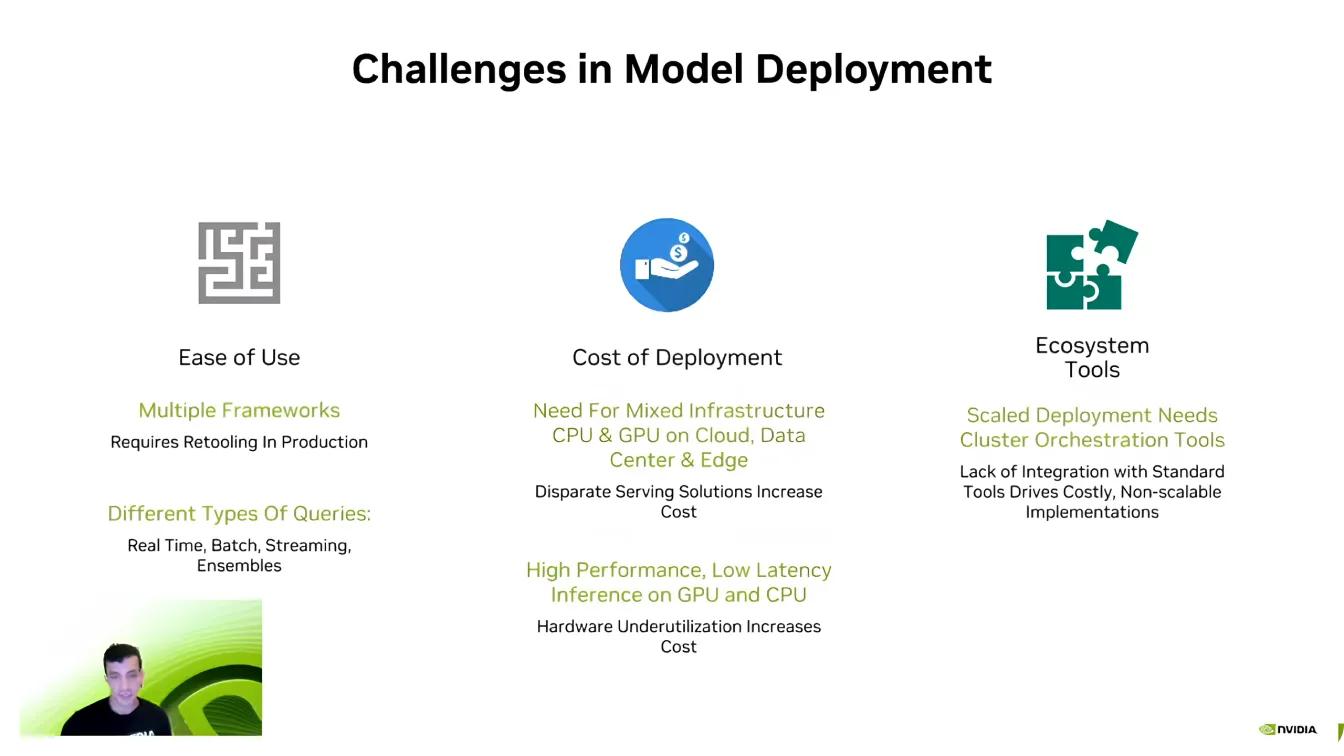

Sau đó, Guy Dahan chuyển sang thảo luận về khía cạnh phần mềm của Edge AI và giải thích rằng ngay cả với phần cứng mạnh mẽ, việc triển khai các mô hình một cách hiệu quả có thể là một thách thức.

Một trong những rào cản lớn nhất là khả năng tương thích, vì các nhà phát triển AI thường làm việc với các khuôn khổ AI khác nhau như PyTorch Và TensorFlow . Việc di chuyển giữa các khuôn khổ này có thể khó khăn, đòi hỏi các nhà phát triển phải tạo lại môi trường để đảm bảo mọi thứ chạy chính xác.

Khả năng mở rộng là một thách thức quan trọng khác. Các mô hình AI đòi hỏi sức mạnh tính toán đáng kể và như Dahan đã nói, "Chưa bao giờ có một công ty AI nào muốn ít tính toán hơn." Việc mở rộng các ứng dụng AI trên nhiều thiết bị có thể nhanh chóng trở nên tốn kém, khiến việc tối ưu hóa trở nên cần thiết.

Ngoài ra, các AI pipeline (quy trình AI) rất phức tạp, thường liên quan đến các loại dữ liệu khác nhau, xử lý thời gian thực và tích hợp hệ thống. Các nhà phát triển nỗ lực rất nhiều để đảm bảo các mô hình của họ tương tác liền mạch với các hệ sinh thái phần mềm hiện có. Vượt qua những thách thức này là một phần quan trọng để làm cho các triển khai AI hiệu quả và có khả năng mở rộng hơn.

Tiếp theo, Guy Dahan chuyển sự chú ý của mình sang NVIDIA Triton Inference Server . Ông chỉ ra rằng nhiều công ty và công ty khởi nghiệp bắt đầu phát triển AI mà không tối ưu hóa hoàn toàn mô hình của họ. Việc thiết kế lại toàn bộ quy trình AI từ đầu có thể gây gián đoạn và tốn thời gian, khiến việc mở rộng quy mô hiệu quả trở nên khó khăn.

Thay vì yêu cầu phải đại tu toàn bộ hệ thống, Triton cho phép các nhà phát triển dần dần tinh chỉnh và tối ưu hóa quy trình làm việc AI của họ, tích hợp các thành phần hiệu quả hơn mà không phá vỡ thiết lập hiện có. Với sự hỗ trợ cho nhiều khuôn khổ AI, bao gồm TensorFlow , PyTorch , ONNX , Và TensorRT , Triton cho phép triển khai liền mạch trên các môi trường đám mây, trung tâm dữ liệu và thiết bị biên với những điều chỉnh tối thiểu.

Dưới đây là một số lợi thế chính của NVIDIA 'S Triton Máy chủ suy luận:

Giả sử bạn đang tìm kiếm khả năng tăng tốc mạnh mẽ hơn nữa; NVIDIA TensorRT là một lựa chọn thú vị để tối ưu hóa các mô hình AI của bạn. Guy Dahan đã giải thích thêm rằng TensorRT là một trình tối ưu hóa học sâu hiệu suất cao được xây dựng cho NVIDIA GPU. Các mô hình từ TensorFlow , PyTorch , ONNX và MXNet có thể được chuyển đổi thành hiệu quả cao GPU -tệp thực thi sử dụng TensorRT .

Điều gì làm cho TensorRT Các tối ưu hóa dành riêng cho phần cứng của nó rất đáng tin cậy. Một mô hình được tối ưu hóa cho các thiết bị Jetson sẽ không hoạt động hiệu quả trên các GPU khác vì TensorRT Tinh chỉnh hiệu suất dựa trên phần cứng mục tiêu. Một mô hình thị giác máy tính được tinh chỉnh có thể tăng tốc độ suy luận lên đến 36 lần so với các mô hình chưa được tối ưu hóa.

Guy Dahan cũng kêu gọi sự chú ý đến Ultralytics ' hỗ trợ cho TensorRT , nói về cách nó giúp triển khai mô hình AI nhanh hơn và hiệu quả hơn. Ultralytics YOLO các mô hình có thể được xuất trực tiếp sang TensorRT định dạng, cho phép các nhà phát triển tối ưu hóa chúng cho NVIDIA GPU mà không cần phải thực hiện bất kỳ thay đổi nào.

Kết thúc bài nói chuyện bằng một nốt cao, Guy Dahan đã giới thiệu DeepStream 7.0 - một khuôn khổ AI được thiết kế để xử lý dữ liệu video, âm thanh và cảm biến theo thời gian thực bằng cách sử dụng NVIDIA GPU. Được thiết kế để hỗ trợ các ứng dụng thị giác máy tính tốc độ cao, DeepStream cho phép phát hiện, theo dõi và phân tích đối tượng trên các hệ thống tự động, an ninh, tự động hóa công nghiệp và thành phố thông minh. Bằng cách chạy AI trực tiếp trên các thiết bị biên, DeepStream loại bỏ sự phụ thuộc vào đám mây, giảm độ trễ và cải thiện hiệu quả.

Cụ thể, DeepStream có thể xử lý quá trình xử lý video bằng AI từ đầu đến cuối. Nó hỗ trợ các quy trình làm việc end-to-end, từ giải mã và tiền xử lý video đến suy luận AI và hậu xử lý.

Gần đây, DeepStream đã giới thiệu một số bản cập nhật để tăng cường triển khai AI, giúp nó dễ tiếp cận và có khả năng mở rộng hơn. Các công cụ mới đơn giản hóa quá trình phát triển, cải thiện khả năng theo dõi đa camera và tối ưu hóa các quy trình AI để có hiệu suất tốt hơn.

Giờ đây, các nhà phát triển đã có được sự hỗ trợ mở rộng cho môi trường Windows, khả năng hợp nhất cảm biến nâng cao để tích hợp dữ liệu từ nhiều nguồn và quyền truy cập vào các ứng dụng tham chiếu dựng sẵn để tăng tốc triển khai. Những cải tiến này làm cho DeepStream trở thành một giải pháp linh hoạt và hiệu quả hơn cho các ứng dụng AI thời gian thực, giúp các nhà phát triển dễ dàng mở rộng quy mô phân tích video thông minh.

Như được minh họa trong bài phát biểu quan trọng của Guy Dahan tại YV24, Edge AI đang định nghĩa lại các ứng dụng thị giác máy tính. Với những tiến bộ trong phần cứng và phần mềm, quá trình xử lý thời gian thực đang trở nên nhanh hơn, hiệu quả hơn và tiết kiệm chi phí hơn.

Khi ngày càng có nhiều ngành công nghiệp áp dụng Edge AI, việc giải quyết các thách thức như phân mảnh và độ phức tạp trong triển khai sẽ là chìa khóa để khai thác toàn bộ tiềm năng của nó. Việc chấp nhận những đổi mới này sẽ thúc đẩy các ứng dụng AI thông minh hơn, phản hồi nhanh hơn, định hình tương lai của thị giác máy tính.

Hãy trở thành một phần của cộng đồng đang phát triển của chúng tôi! Khám phá kho lưu trữ GitHub của chúng tôi để tìm hiểu thêm về AI và xem các tùy chọn cấp phép của chúng tôi để khởi động các dự án Vision AI của bạn. Bạn có tò mò về những đổi mới như AI trong chăm sóc sức khỏe và thị giác máy tính trong sản xuất? Hãy truy cập các trang giải pháp của chúng tôi để tìm hiểu thêm!