Xem cách học tập kết hợp (ensemble learning) tăng cường hiệu suất mô hình AI thông qua các kỹ thuật như bagging, boosting và stacking để cung cấp các dự đoán chính xác và ổn định hơn.

Xem cách học tập kết hợp (ensemble learning) tăng cường hiệu suất mô hình AI thông qua các kỹ thuật như bagging, boosting và stacking để cung cấp các dự đoán chính xác và ổn định hơn.

Để hiểu rõ hơn về các khái niệm được đề cập trong bài viết này, hãy xem video bên dưới.

Các cải tiến AI như công cụ đề xuất và hệ thống phát hiện gian lận dựa trên các thuật toán và mô hình học máy để đưa ra dự đoán và quyết định dựa trên dữ liệu. Các mô hình này có thể xác định các mẫu, dự báo xu hướng và giúp tự động hóa các tác vụ phức tạp.

Tuy nhiên, một mô hình duy nhất có thể gặp khó khăn trong việc nắm bắt tất cả các chi tiết trong dữ liệu thực tế. Nó có thể hoạt động tốt trong một số trường hợp nhưng lại không hiệu quả trong những trường hợp khác, chẳng hạn như một mô hình phát hiện gian lận bỏ sót các loại giao dịch mới.

Hạn chế này là điều mà các kỹ sư AI thường gặp phải khi xây dựng và triển khai các mô hình máy học. Một số mô hình bị quá khớp (overfit) do học dữ liệu huấn luyện quá sát, trong khi những mô hình khác bị thiếu khớp (underfit) do bỏ lỡ các mẫu quan trọng. Học tập ансамбль (Ensemble learning) là một kỹ thuật AI giúp giải quyết những thách thức này bằng cách kết hợp nhiều mô hình, được gọi là các bộ học cơ sở (base learners), thành một hệ thống duy nhất, mạnh mẽ hơn.

Bạn có thể xem nó như một nhóm các chuyên gia làm việc cùng nhau để giải quyết một vấn đề. Trong bài viết này, chúng ta sẽ khám phá học tập ансамбль là gì, nó hoạt động như thế nào và nó có thể được sử dụng ở đâu. Hãy bắt đầu nào!

Ensemble learning (học tập tập hợp) đề cập đến một tập hợp các kỹ thuật kết hợp nhiều mô hình để giải quyết cùng một vấn đề và tạo ra một kết quả duy nhất, được cải thiện. Nó có thể được áp dụng trong cả supervised learning (học có giám sát, nơi các mô hình học từ dữ liệu được gắn nhãn) và unsupervised learning (học không giám sát, nơi các mô hình tìm thấy các mẫu trong dữ liệu không được gắn nhãn).

Thay vì dựa vào một mô hình duy nhất để đưa ra dự đoán, một tập hợp (ensemble) sử dụng nhiều mô hình mà mỗi mô hình xem xét dữ liệu theo cách riêng của nó. Khi các đầu ra của chúng được kết hợp, kết quả thường chính xác hơn, ổn định hơn và có khả năng khái quát hóa tốt hơn so với những gì bất kỳ mô hình đơn lẻ nào có thể đạt được.

Bạn có thể so sánh nó với một nhóm các nhà phân tích giải quyết cùng một vấn đề. Mỗi nhà phân tích hoặc mô hình riêng lẻ diễn giải dữ liệu khác nhau.

Một người có thể tập trung vào các mẫu, người khác tập trung vào các điểm bất thường và người khác nữa tập trung vào bối cảnh. Bằng cách kết hợp các quan điểm của họ lại với nhau, nhóm có thể đưa ra một quyết định cân bằng và đáng tin cậy hơn so với bất kỳ phán đoán riêng lẻ nào.

Cách tiếp cận này cũng giúp giải quyết hai trong số những thách thức lớn nhất trong học máy: độ chệch và phương sai. Một mô hình có độ chệch cao thì quá đơn giản và bỏ qua các mẫu quan trọng, trong khi một mô hình có phương sai cao thì quá nhạy cảm và khớp quá chặt với dữ liệu huấn luyện. Bằng cách kết hợp các mô hình, học tập ансамбль tìm thấy sự cân bằng giữa hai điều này, cải thiện hiệu quả hoạt động của hệ thống trên dữ liệu mới, chưa từng thấy.

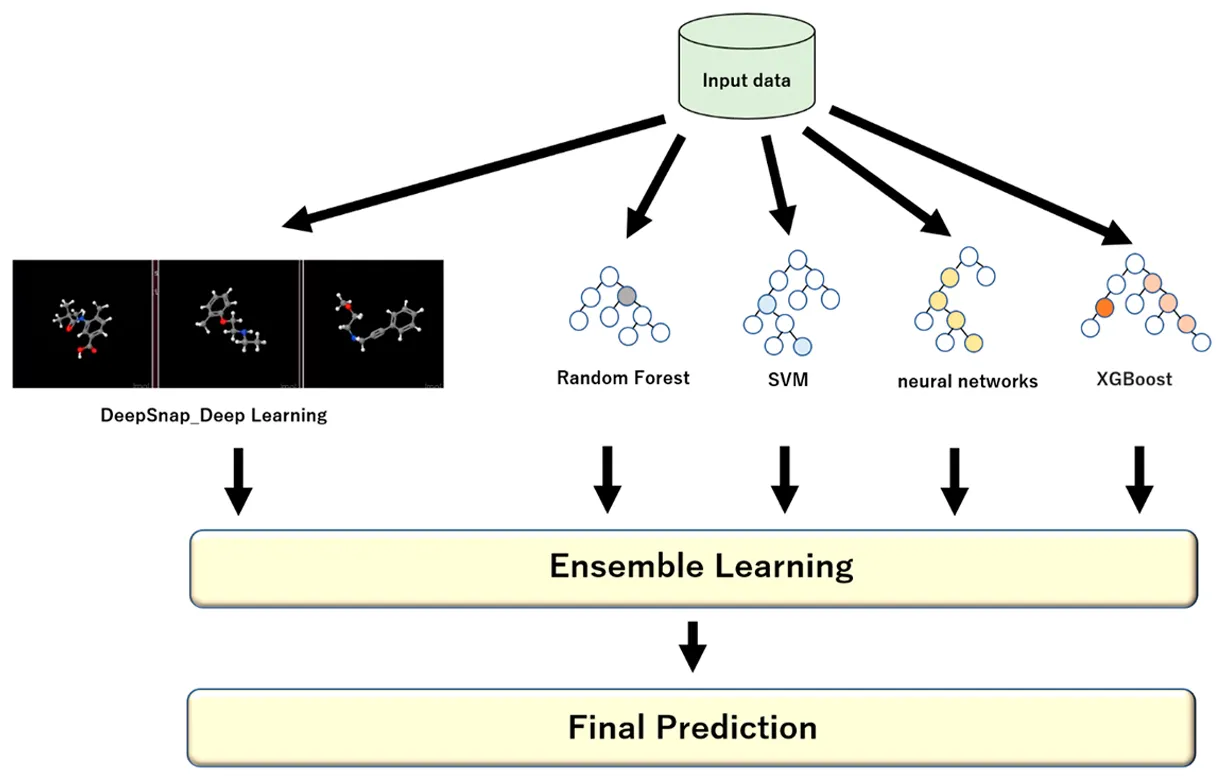

Mỗi mô hình trong một tập hợp (ensemble) được gọi là một base learner hoặc base model. Chúng có thể là cùng một loại thuật toán hoặc hỗn hợp các thuật toán khác nhau, tùy thuộc vào kỹ thuật tập hợp đang được sử dụng.

Dưới đây là một số ví dụ phổ biến về các mô hình khác nhau được sử dụng trong ensemble learning:

Một mô hình kết hợp thường được gọi là mô hình mạnh vì nó tích hợp các điểm mạnh của các mô hình cơ sở (còn được gọi là mô hình yếu) đồng thời giảm thiểu các điểm yếu của chúng. Nó thực hiện điều này bằng cách kết hợp các dự đoán của từng mô hình một cách có cấu trúc, sử dụng phương pháp bỏ phiếu đa số cho các tác vụ phân loại hoặc tính trung bình có trọng số cho các tác vụ hồi quy để tạo ra kết quả cuối cùng chính xác hơn.

Trước khi đi sâu vào các kỹ thuật học tập ансамбль khác nhau, hãy lùi lại một bước và hiểu khi nào loại phương pháp này nên được sử dụng trong một dự án học máy hoặc AI.

Ensemble learning (học tập tập hợp) có tác động lớn nhất khi một mô hình đơn lẻ gặp khó khăn trong việc đưa ra các dự đoán chính xác hoặc nhất quán. Nó cũng có thể được sử dụng trong các tình huống mà dữ liệu phức tạp, nhiễu hoặc khó đoán.

Dưới đây là một số trường hợp phổ biến mà các phương pháp ensemble đặc biệt hiệu quả:

Phương pháp này cũng đơn giản hơn để huấn luyện, dễ diễn giải hơn và bảo trì nhanh hơn. Trước khi sử dụng một tập hợp mô hình (ensemble), điều quan trọng là phải cân nhắc lợi ích của độ chính xác cao hơn so với thời gian, sức mạnh tính toán và độ phức tạp mà nó đòi hỏi.

Tiếp theo, hãy xem xét các cách chính mà học tập kết hợp có thể được áp dụng trong các dự án học máy. Có một số kỹ thuật cốt lõi được sử dụng để kết hợp các mô hình, mỗi kỹ thuật cải thiện hiệu suất theo cách riêng của nó. Các phương pháp kết hợp phổ biến nhất là bagging, boosting, stacking và blending.

Bagging, viết tắt của bootstrap aggregating, là một phương pháp học tập ансамбль giúp cải thiện tính ổn định và độ chính xác của mô hình bằng cách huấn luyện nhiều phiên bản của cùng một mô hình trên các phần dữ liệu khác nhau.

Mỗi tập hợp con được tạo bằng một quy trình gọi là bootstrap sampling, trong đó các điểm dữ liệu được chọn ngẫu nhiên có hoàn lại. Điều này có nghĩa là sau khi một điểm dữ liệu được chọn, nó sẽ được đưa trở lại vào nhóm trước khi điểm tiếp theo được chọn, vì vậy cùng một điểm có thể xuất hiện nhiều lần, trong khi những điểm khác có thể bị bỏ qua. Tính ngẫu nhiên này đảm bảo rằng mỗi mô hình được huấn luyện trên một phiên bản hơi khác của tập dữ liệu.

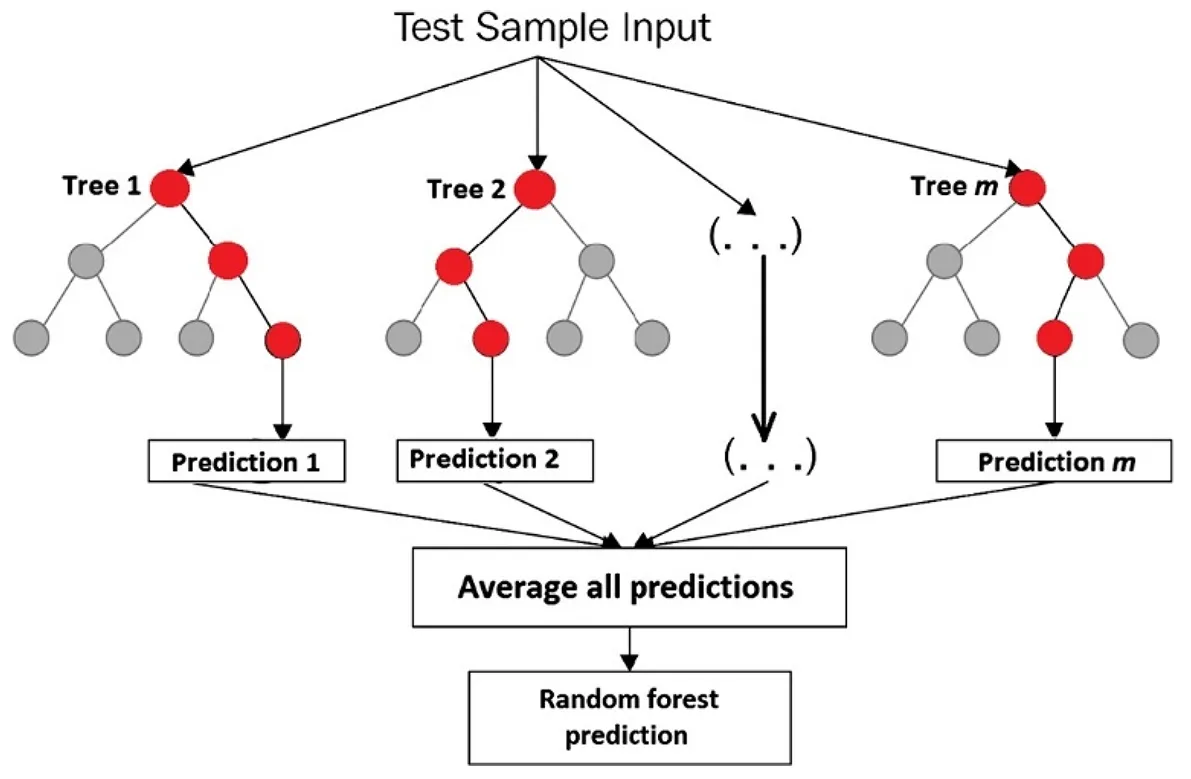

Trong quá trình suy luận, tất cả các mô hình đã được đào tạo chạy song song để đưa ra dự đoán về dữ liệu mới, chưa từng thấy. Mỗi mô hình tạo ra đầu ra riêng dựa trên những gì nó đã học và các dự đoán riêng lẻ này sau đó được kết hợp để tạo thành kết quả cuối cùng.

Đối với các tác vụ hồi quy, chẳng hạn như dự đoán giá nhà hoặc dự báo doanh số, điều này thường có nghĩa là tính trung bình các kết quả đầu ra của tất cả các mô hình để có được ước tính mượt mà hơn. Đối với các tác vụ phân loại, chẳng hạn như xác định xem một giao dịch có gian lận hay không, tập hợp thường lấy biểu quyết đa số để quyết định lớp cuối cùng.

Một ví dụ điển hình về nơi bagging hoạt động tốt là với cây quyết định, có thể dễ dàng bị quá khớp khi được huấn luyện trên một tập dữ liệu duy nhất. Bằng cách huấn luyện nhiều cây trên các mẫu hơi khác nhau và kết hợp kết quả của chúng, bagging làm giảm tình trạng quá khớp và cải thiện độ tin cậy.

Hãy xem xét thuật toán Random Forest. Nó là một tập hợp các cây quyết định, trong đó mỗi cây được huấn luyện trên một tập hợp con ngẫu nhiên của tập dữ liệu huấn luyện cũng như một tập hợp con ngẫu nhiên của các đặc trưng.

Tính ngẫu nhiên này giúp đảm bảo các cây ít tương quan hơn và mô hình tổng thể ổn định và chính xác hơn. Thuật toán Rừng Ngẫu Nhiên có thể được sử dụng để classify hình ảnh, detect gian lận, dự đoán tỷ lệ khách hàng rời bỏ, dự báo doanh số hoặc ước tính giá bất động sản.

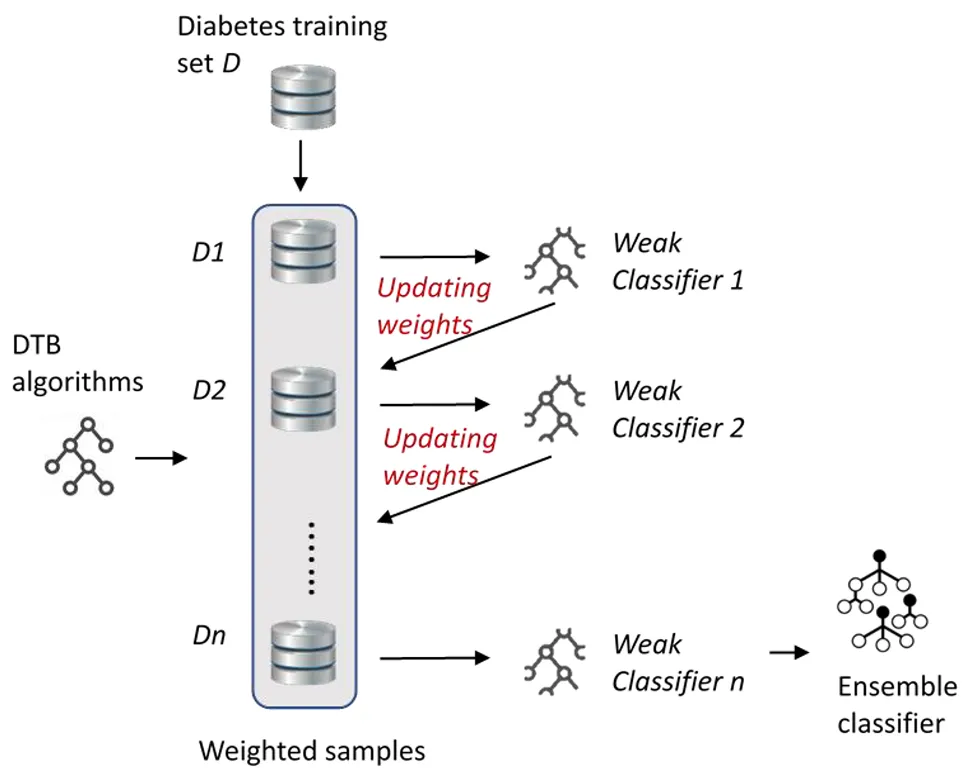

Boosting là một kỹ thuật ensemble learning khác tập trung vào việc cải thiện các weak learner (mô hình) bằng cách huấn luyện chúng tuần tự, hết mô hình này đến mô hình khác, thay vì song song. Khái niệm cốt lõi của boosting là mỗi mô hình mới học hỏi từ những sai lầm của các mô hình trước đó, dần dần cải thiện hiệu suất mô hình tổng thể.

Không giống như bagging, làm giảm phương sai bằng cách lấy trung bình các mô hình độc lập, boosting làm giảm độ lệch bằng cách làm cho mỗi mô hình mới chú ý nhiều hơn đến các trường hợp khó mà các mô hình trước đó gặp khó khăn.

Vì các mô hình boosting được huấn luyện tuần tự, nên cách kết hợp các dự đoán của chúng ở cuối khác một chút so với các phương pháp tập hợp khác. Mỗi mô hình đóng góp vào dự đoán cuối cùng tỷ lệ với hiệu suất của nó trong quá trình huấn luyện, với các mô hình chính xác hơn nhận được trọng số lớn hơn.

Đối với các tác vụ hồi quy, kết quả cuối cùng thường là tổng có trọng số của tất cả các dự đoán mô hình. Đối với các tác vụ phân loại, thuật toán kết hợp các phiếu bầu có trọng số từ các mô hình để quyết định lớp cuối cùng. Cách tiếp cận này giúp boosting tạo ra một mô hình tổng thể mạnh mẽ bằng cách tăng trọng số cho các mô hình chính xác hơn trong khi vẫn học hỏi từ những mô hình khác.

Dưới đây là một số loại thuật toán boosting phổ biến:

Xếp chồng (Stacking), còn được gọi là tổng quát hóa xếp chồng, tiến thêm một bước bằng cách sử dụng các dự đoán từ một số mô hình làm đầu vào cho một mô hình cuối cùng được gọi là meta learner. Bạn có thể hình dung nó giống như việc có một nhóm chuyên gia, mỗi người chia sẻ ý kiến của họ, sau đó một người ra quyết định cuối cùng học cách cân nhắc những ý kiến đó để đưa ra quyết định tốt nhất có thể.

Ví dụ: một mô hình có thể giỏi phát hiện gian lận, trong khi một mô hình khác lại giỏi dự đoán tỷ lệ khách hàng rời bỏ. Meta learner nghiên cứu cách mỗi mô hình hoạt động và sử dụng điểm mạnh của chúng để đưa ra dự đoán cuối cùng chính xác hơn.

Blending hoạt động tương tự như stacking vì nó cũng kết hợp các dự đoán từ một số mô hình để đưa ra quyết định cuối cùng, nhưng nó thực hiện một cách tiếp cận đơn giản và nhanh hơn. Thay vì sử dụng cross-validation (một phương pháp chia dữ liệu thành nhiều phần và luân chuyển chúng giữa huấn luyện và kiểm tra để làm cho mô hình đáng tin cậy hơn), như stacking, blending dành ra một phần nhỏ của dữ liệu, được gọi là holdout set.

Các mô hình cơ sở được huấn luyện trên dữ liệu còn lại và sau đó đưa ra dự đoán trên tập hợp giữ lại, mà chúng chưa từng thấy trước đây. Điều này tạo ra hai phần thông tin chính: câu trả lời thực tế, hoặc nhãn đúng và các dự đoán được đưa ra bởi mỗi mô hình cơ sở.

Những dự đoán này sau đó được chuyển đến một mô hình khác gọi là mô hình pha trộn (blending model) hoặc siêu mô hình (meta model). Mô hình cuối cùng này nghiên cứu mức độ chính xác của các dự đoán của từng mô hình cơ sở và học cách kết hợp chúng theo cách tốt nhất có thể.

Vì blending chỉ dựa vào một lần chia dữ liệu huấn luyện và kiểm tra thay vì lặp lại quy trình nhiều lần, nó chạy nhanh hơn và dễ thiết lập hơn. Đổi lại, nó có ít thông tin hơn để học hỏi, điều này có thể làm cho nó kém chính xác hơn một chút.

Một phần quan trọng của học tập ансамбль là đánh giá mức độ hoạt động của mô hình trên dữ liệu mà nó chưa từng thấy trước đây. Cho dù một kỹ thuật có tiên tiến đến đâu, nó phải được kiểm tra để đảm bảo rằng nó có thể tổng quát hóa, có nghĩa là nó sẽ đưa ra các dự đoán chính xác trên các ví dụ mới, thực tế thay vì chỉ ghi nhớ dữ liệu huấn luyện.

Dưới đây là một số metrics (số liệu) hiệu suất phổ biến được sử dụng để đánh giá các mô hình AI:

Cho đến nay, chúng ta đã khám phá cách thức hoạt động của học tập ансамбль và các kỹ thuật đằng sau nó. Bây giờ, hãy xem cách tiếp cận này đang tạo ra tác động ở đâu.

Dưới đây là một số lĩnh vực chính mà học tập ансамб применяются phổ biến:

Mặc dù ensemble learning (học tập ансамбль) thường được sử dụng nhất với dữ liệu có cấu trúc hoặc dạng bảng, như bảng tính chứa thông tin số hoặc phân loại, nó cũng có thể được áp dụng cho dữ liệu phi cấu trúc như văn bản, hình ảnh, âm thanh và video.

Các loại dữ liệu này phức tạp hơn và khó giải thích hơn đối với các mô hình, nhưng các phương pháp tập hợp giúp cải thiện độ chính xác và độ tin cậy. Ví dụ: trong thị giác máy tính, các tập hợp có thể tăng cường các tác vụ như phân loại hình ảnh và nhận diện đối tượng.

Bằng cách kết hợp các dự đoán của nhiều mô hình thị giác, chẳng hạn như mạng nơ-ron tích chập (CNN), hệ thống có thể nhận dạng các đối tượng chính xác hơn và xử lý các biến thể về ánh sáng, góc hoặc nền có thể gây nhầm lẫn cho một mô hình duy nhất.

Một ví dụ thú vị về việc sử dụng học tập ансамбль trong thị giác máy tính là khi một kỹ sư kết hợp nhiều mô hình phát hiện đối tượng để cải thiện độ chính xác. Hãy tưởng tượng một kỹ sư làm việc trên một hệ thống giám sát an toàn cho một công trường xây dựng, nơi ánh sáng, góc độ và kích thước đối tượng liên tục thay đổi.

Một mô hình duy nhất có thể bỏ sót một công nhân trong bóng tối hoặc nhầm lẫn máy móc đang chuyển động. Bằng cách sử dụng một tập hợp các mô hình, mỗi mô hình có những điểm mạnh khác nhau, hệ thống trở nên đáng tin cậy hơn và ít có khả năng mắc phải những lỗi đó.

Đặc biệt, các mô hình như Ultralytics YOLOv5 đi đôi với việc tổng hợp mô hình. Các kỹ sư có thể kết hợp các mô hình khác nhau YOLOv5 Các biến thể, chẳng hạn như YOLOv5x và YOLOv5l6, để cùng nhau đưa ra dự đoán. Mỗi mô hình phân tích cùng một hình ảnh và đưa ra các phát hiện riêng, sau đó được tính trung bình để tạo ra kết quả cuối cùng mạnh mẽ và chính xác hơn.

Dưới đây là một số lợi ích chính của việc sử dụng học tập ансамб:

Mặc dù ensemble learning (học tập ансамбль) mang lại nhiều lợi thế, nhưng cũng có một số thách thức cần xem xét. Dưới đây là một vài yếu tố cần lưu ý:

Ensemble learning (học tập tập hợp) cho thấy cách kết hợp nhiều mô hình có thể làm cho hệ thống AI chính xác và đáng tin cậy hơn. Nó giúp giảm lỗi và cải thiện hiệu suất trên các loại tác vụ khác nhau. Khi machine learning (học máy) và AI tiếp tục phát triển, các kỹ thuật như thế này đang thúc đẩy việc áp dụng rộng rãi hơn và các giải pháp AI thiết thực, hiệu suất cao hơn.

Tham gia cộng đồng đang phát triển của chúng tôi và kho lưu trữ GitHub để tìm hiểu thêm về Vision AI. Khám phá các trang giải pháp của chúng tôi để tìm hiểu về các ứng dụng của thị giác máy tính trong nông nghiệp và AI trong logistics. Xem các tùy chọn cấp phép của chúng tôi để bắt đầu với mô hình thị giác máy tính của riêng bạn ngay hôm nay!