PaliGemma 2 von Google: Einblicke in fortgeschrittene VLM-Modelle

Werfen Sie mit uns einen genaueren Blick auf Googleneue Vision-Sprachmodelle: PaliGemma 2. Diese Modelle können beim Verstehen und Analysieren von Bildern und Text helfen.

Werfen Sie mit uns einen genaueren Blick auf Googleneue Vision-Sprachmodelle: PaliGemma 2. Diese Modelle können beim Verstehen und Analysieren von Bildern und Text helfen.

Am 5. Dezember 2024 stellte Google PaliGemma 2 vor, die neueste Version seines hochmodernen Vision-Language-Modells (VLM). PaliGemma 2 wurde entwickelt, um Aufgaben zu bewältigen, die Bilder und Text kombinieren, wie z. B. die Erstellung von Bildunterschriften, die Beantwortung visueller Fragen und die Erkennung von Objekten in Bildern.

Aufbauend auf dem ursprünglichen PaliGemma, das bereits ein starkes Werkzeug für mehrsprachige Bildunterschriften und Objekterkennung war, bringt PaliGemma 2 mehrere wichtige Verbesserungen mit sich. Dazu gehören größere Modellgrößen, Unterstützung für höher auflösende Bilder und eine bessere Leistung bei komplexen visuellen Aufgaben. Diese Upgrades machen es noch flexibler und effektiver für eine Vielzahl von Anwendungen.

In diesem Artikel werfen wir einen genaueren Blick auf PaliGemma 2, einschließlich seiner Funktionsweise, seiner wichtigsten Merkmale und der Anwendungen, in denen es glänzt. Los geht's!

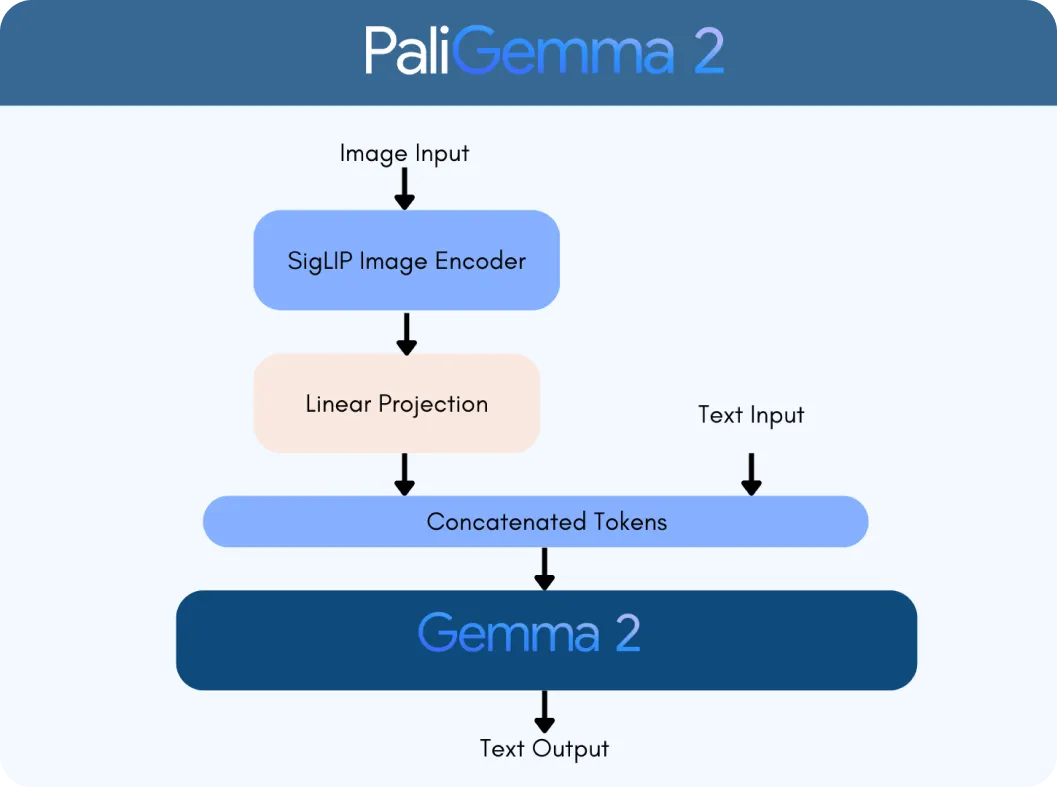

PaliGemma 2 basiert auf zwei Schlüsseltechnologien: dem SigLIP Vision Encoder und dem Gemma 2 Sprachmodell. Der SigLIP Encoder verarbeitet visuelle Daten, wie Bilder oder Videos, und zerlegt sie in Merkmale, die das Modell analysieren kann. Gemma 2 hingegen verarbeitet Text und ermöglicht es dem Modell, mehrsprachige Sprache zu verstehen und zu generieren. Zusammen bilden sie ein VLM, das entwickelt wurde, um visuelle und Textinformationen nahtlos zu interpretieren und zu verbinden.

Was PaliGemma 2 zu einem wichtigen Fortschritt macht, ist seine Skalierbarkeit und Vielseitigkeit. Im Gegensatz zur Originalversion ist PaliGemma 2 in drei Größen erhältlich - 3 Milliarden (3B), 10 Milliarden (10B) und 28 Milliarden (28B) Parameter. Diese Parameter sind wie die internen Einstellungen des Modells, die ihm helfen, Daten effektiv zu lernen und zu verarbeiten. Es unterstützt auch verschiedene Bildauflösungen (z. B. 224 x 224 Pixel für schnelle Aufgaben und 896 x 896 für detaillierte Analysen), wodurch es an verschiedene Anwendungen angepasst werden kann.

Die Integration der fortschrittlichen Sprachfunktionen von Gemma 2 mit der Bildverarbeitung von SigLIP macht PaliGemma 2 deutlich intelligenter. Es kann Aufgaben wie die folgenden bewältigen:

PaliGemma 2 geht über die separate Verarbeitung von Bildern und Text hinaus - es bringt sie auf sinnvolle Weise zusammen. Zum Beispiel kann es Beziehungen in einer Szene verstehen, wie z. B. die Erkennung, dass „Die Katze auf dem Tisch sitzt“, oder das Identifizieren von Objekten unter Hinzufügung von Kontext, wie z. B. die Erkennung eines berühmten Wahrzeichens.

Als Nächstes werden wir ein Beispiel anhand des in der Abbildung unten gezeigten Graphen durchgehen, um ein besseres Verständnis dafür zu bekommen, wie PaliGemma 2 visuelle und textuelle Daten verarbeitet. Nehmen wir an, Sie laden diesen Graphen hoch und fragen das Modell: „Was stellt dieser Graph dar?

Der Prozess beginnt mit dem SigLIP-Vision-Encoder von PaliGemma 2, der die Bilder analysiert und die wichtigsten Merkmale extrahiert. Bei einem Diagramm umfasst dies die Identifizierung von Elementen wie Achsen, Datenpunkten und Beschriftungen. Der Encoder ist darauf trainiert, sowohl breite Muster als auch feine Details zu erfassen. Außerdem wird eine optische Zeichenerkennung (OCR) eingesetzt, um im Bild eingebetteten Text detect und zu verarbeiten. Diese visuellen Merkmale werden in Token umgewandelt, d. h. in numerische Darstellungen, die das Modell verarbeiten kann. Diese Tokens werden dann mithilfe einer linearen Projektionsebene angepasst, eine Technik, die gewährleistet, dass sie nahtlos mit Textdaten kombiniert werden können.

Gleichzeitig verarbeitet das Gemma 2 Sprachmodell die dazugehörige Anfrage, um ihre Bedeutung und Absicht zu ermitteln. Der Text aus der Anfrage wird in Token umgewandelt, und diese werden mit den visuellen Token von SigLIP kombiniert, um eine multimodale Darstellung zu erstellen, ein einheitliches Format, das visuelle und textuelle Daten miteinander verbindet.

Mithilfe dieser integrierten Darstellung generiert PaliGemma 2 Schritt für Schritt eine Antwort durch autoregressive Dekodierung, eine Methode, bei der das Modell jeweils einen Teil der Antwort auf der Grundlage des bereits verarbeiteten Kontexts vorhersagt.

Nachdem wir nun verstanden haben, wie es funktioniert, wollen wir die wichtigsten Funktionen untersuchen, die PaliGemma 2 zu einem zuverlässigen Vision-Language-Modell machen:

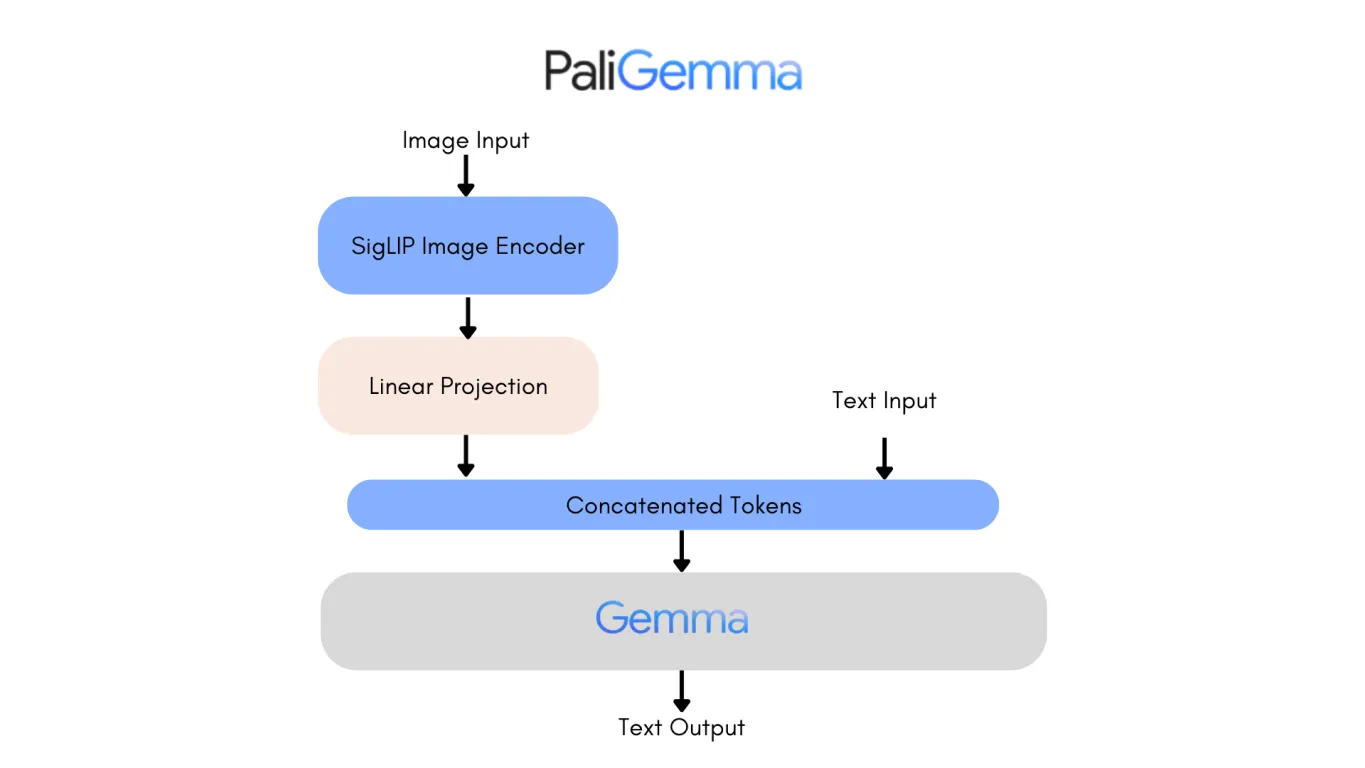

Ein Blick auf die Architektur der ersten Version von PaliGemma ist eine gute Möglichkeit, die Verbesserungen von PaliGemma 2 zu erkennen. Eine der bemerkenswertesten Änderungen ist der Ersatz des ursprünglichen Gemma-Sprachmodells durch Gemma 2, was zu erheblichen Verbesserungen sowohl in der Leistung als auch in der Effizienz führt.

Gemma 2, das in den Parametergrößen 9B und 27B erhältlich ist, wurde entwickelt, um erstklassige Genauigkeit und Geschwindigkeit zu liefern und gleichzeitig die Bereitstellungskosten zu senken. Dies wird durch eine neu gestaltete Architektur erreicht, die für die Inferenz-Effizienz über verschiedene Hardware-Konfigurationen hinweg optimiert ist, von leistungsstarken GPUs bis hin zu zugänglicheren Konfigurationen.

Infolgedessen ist PaliGemma 2 ein äußerst genaues Modell. Die 10B-Version von PaliGemma 2 erzielt einen niedrigeren Non-Entailment Sentence (NES)-Score von 20,3 im Vergleich zu 34,3 des ursprünglichen Modells, was bedeutet, dass weniger faktische Fehler in seinen Ausgaben enthalten sind. Diese Fortschritte machen PaliGemma 2 skalierbarer, präziser und anpassungsfähiger an ein breiteres Spektrum von Anwendungen, von detaillierter Bildunterschriftung bis hin zur visuellen Beantwortung von Fragen.

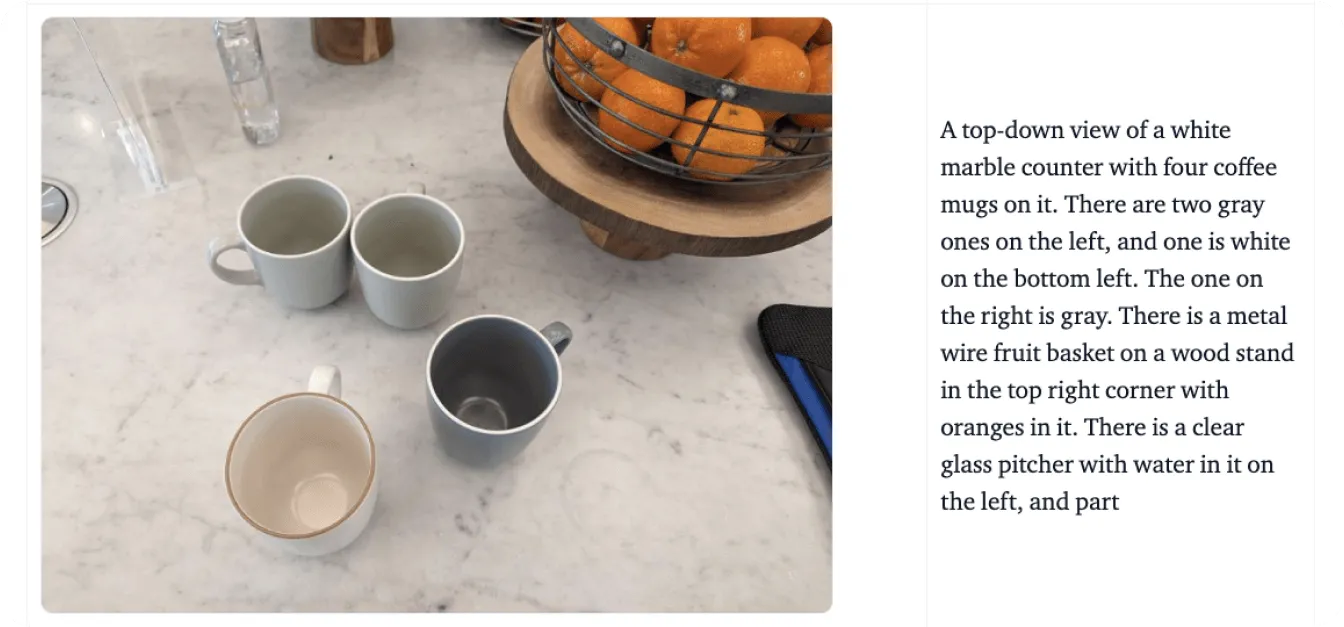

PaliGemma 2 hat das Potenzial, Branchen neu zu definieren, indem es visuelles und sprachliches Verständnis nahtlos miteinander verbindet. In Bezug auf die Barrierefreiheit kann es beispielsweise detaillierte Beschreibungen von Objekten, Szenen und räumlichen Beziehungen generieren und so sehbehinderten Menschen wichtige Unterstützung bieten. Diese Fähigkeit hilft den Benutzern, ihre Umgebung besser zu verstehen, und bietet ihnen mehr Unabhängigkeit bei alltäglichen Aufgaben.

Zusätzlich zur Barrierefreiheit hat PaliGemma 2 Auswirkungen auf verschiedene Branchen, darunter:

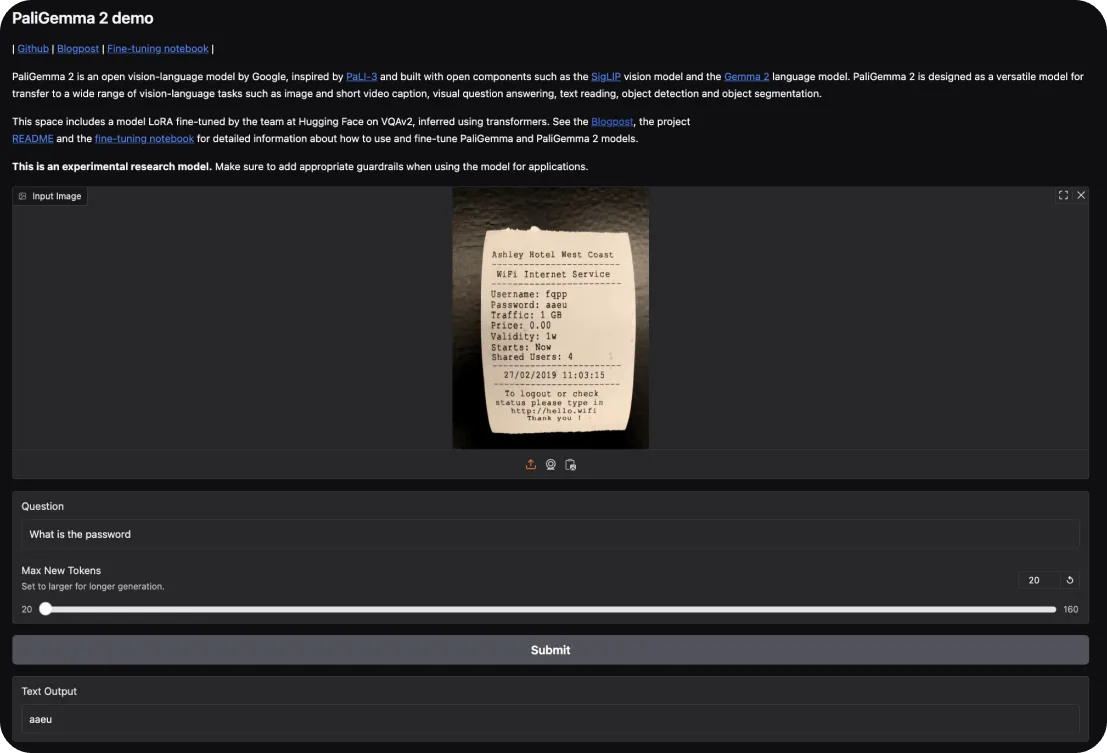

Um PaliGemma 2 auszuprobieren, können Sie mit der interaktiven Demo von Hugging Facebeginnen. Damit können Sie die Fähigkeiten von PaliGemma bei Aufgaben wie Bildbeschriftung und Beantwortung visueller Fragen erkunden. Laden Sie einfach ein Bild hoch und stellen Sie dem Modell Fragen dazu oder fordern Sie eine Beschreibung der Szene an.

Wenn Sie tiefer eintauchen möchten, erfahren Sie hier, wie Sie selbst Hand anlegen können:

Nachdem wir nun verstanden haben, wie man mit PaliGemma 2 beginnt, wollen wir uns die wichtigsten Stärken und Schwächen genauer ansehen, die bei der Verwendung dieser Modelle zu beachten sind.

Das zeichnet PaliGemma 2 als Vision-Language-Modell aus:

Hier sind einige Bereiche, in denen PaliGemma 2 möglicherweise Einschränkungen aufweist:

PaliGemma 2 ist ein faszinierender Fortschritt im Vision-Language-Modeling und bietet verbesserte Skalierbarkeit, Flexibilität bei der Feinabstimmung und Genauigkeit. Es kann als wertvolles Werkzeug für Anwendungen dienen, die von Lösungen für Barrierefreiheit und E-Commerce bis hin zu Diagnostik im Gesundheitswesen und Bildung reichen.

Obwohl es Einschränkungen gibt, wie z. B. Rechenanforderungen und eine Abhängigkeit von hochwertigen Daten, machen seine Stärken es zu einer praktischen Wahl für die Bewältigung komplexer Aufgaben, die visuelle und textuelle Daten integrieren. PaliGemma 2 kann Forschern und Entwicklern eine robuste Grundlage bieten, um das Potenzial von KI in multimodalen Anwendungen zu erforschen und zu erweitern.

Werden Sie Teil der KI-Konversation, indem Sie unser GitHub-Repository und unsere Community besuchen. Lesen Sie, wie KI in der Landwirtschaft und im Gesundheitswesen Fortschritte macht! 🚀