L'IA costituzionale mira ad allineare i modelli di IA ai valori umani

Scopri come l'IA costituzionale aiuta i modelli a seguire regole etiche, a prendere decisioni più sicure e a sostenere l'equità nei sistemi linguistici e di computer vision.

Scopri come l'IA costituzionale aiuta i modelli a seguire regole etiche, a prendere decisioni più sicure e a sostenere l'equità nei sistemi linguistici e di computer vision.

L'intelligenza artificiale (IA) sta rapidamente diventando una parte fondamentale della nostra vita quotidiana. Viene integrata negli strumenti utilizzati in settori come l'assistenza sanitaria, il reclutamento, la finanza e la sicurezza pubblica. Con l'espandersi di questi sistemi, vengono espresse anche preoccupazioni sulla loro etica e affidabilità.

Ad esempio, a volte i sistemi di AI che sono costruiti senza considerare l'equità o la sicurezza possono produrre risultati distorti o inaffidabili. Questo perché molti modelli non hanno ancora un modo chiaro per riflettere e allinearsi ai valori umani.

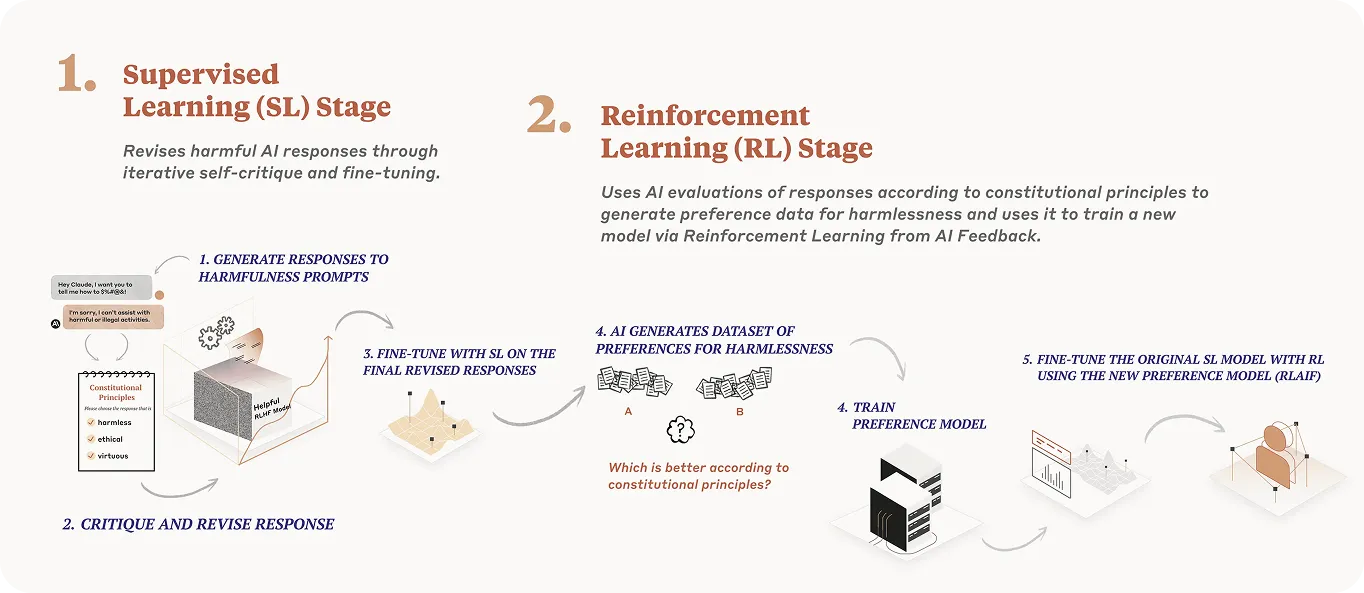

Per affrontare queste sfide, i ricercatori stanno ora esplorando un approccio noto come IA costituzionale. In parole semplici, introduce una serie scritta di principi nel processo di addestramento del modello. Questi principi aiutano il modello a giudicare il proprio comportamento, a fare meno affidamento sul feedback umano e a rendere le risposte più sicure e facili da capire.

Finora, questo approccio è stato utilizzato principalmente con riferimento ai modelli linguistici di grandi dimensioni (LLM). Tuttavia, la stessa struttura potrebbe aiutare i sistemi di computer vision a prendere decisioni etiche durante l'analisi dei dati visivi.

In questo articolo, esploreremo come funziona l'IA costituzionale, esamineremo esempi reali e discuteremo le sue potenziali applicazioni nei sistemi di computer vision.

L'AI costituzionale è un metodo di training dei modelli che guida il comportamento dei modelli di IA fornendo una serie chiara di regole etiche. Queste regole fungono da codice di condotta. Invece di fare affidamento sul modello per dedurre ciò che è accettabile, esso segue una serie scritta di principi che modellano le sue risposte durante il training.

Questo concetto è stato introdotto da Anthropic, una società di ricerca incentrata sulla sicurezza dell'IA che ha sviluppato la famiglia Claude LLM come metodo per rendere i sistemi di IA più auto-supervisionati nel loro processo decisionale.

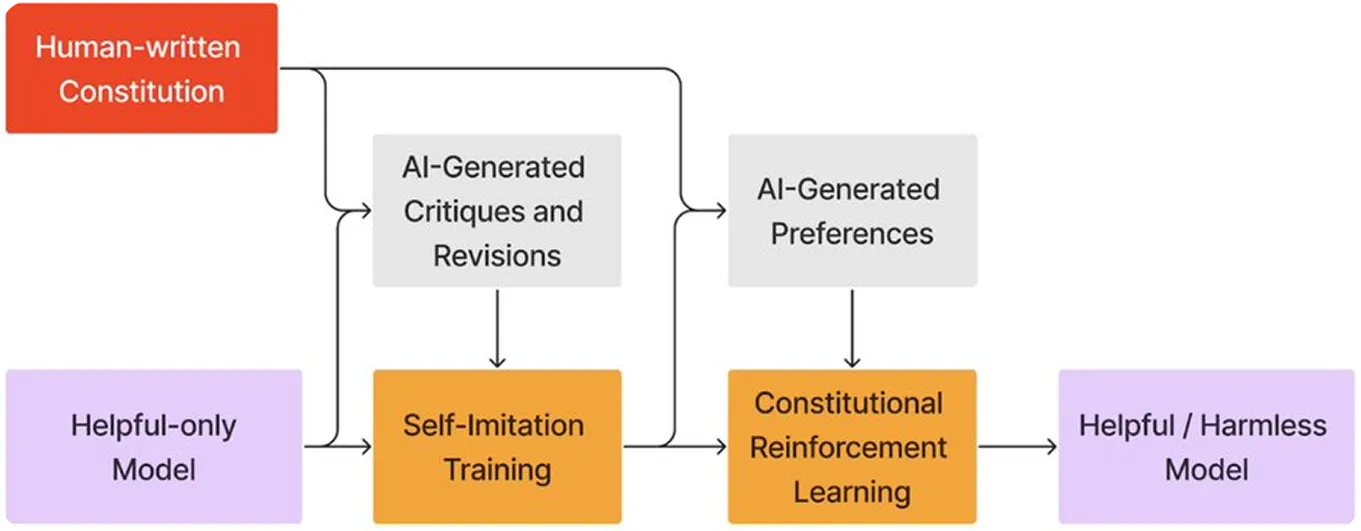

Invece di affidarsi esclusivamente al feedback umano, il modello impara a criticare e perfezionare le proprie risposte in base a una serie di principi predefiniti. Questo approccio è simile a un sistema legale, in cui un giudice si riferisce a una costituzione prima di emettere una sentenza.

In questo caso, il modello diventa sia il giudice che lo studente, utilizzando lo stesso insieme di regole per rivedere e perfezionare il proprio comportamento. Questo processo rafforza l'allineamento dei modelli di IA e supporta lo sviluppo di sistemi di IA sicuri e responsabili.

L'obiettivo dell'IA costituzionale è insegnare a un modello di IA come prendere decisioni sicure ed eque seguendo una serie chiara di regole scritte. Ecco una semplice analisi di come funziona questo processo:

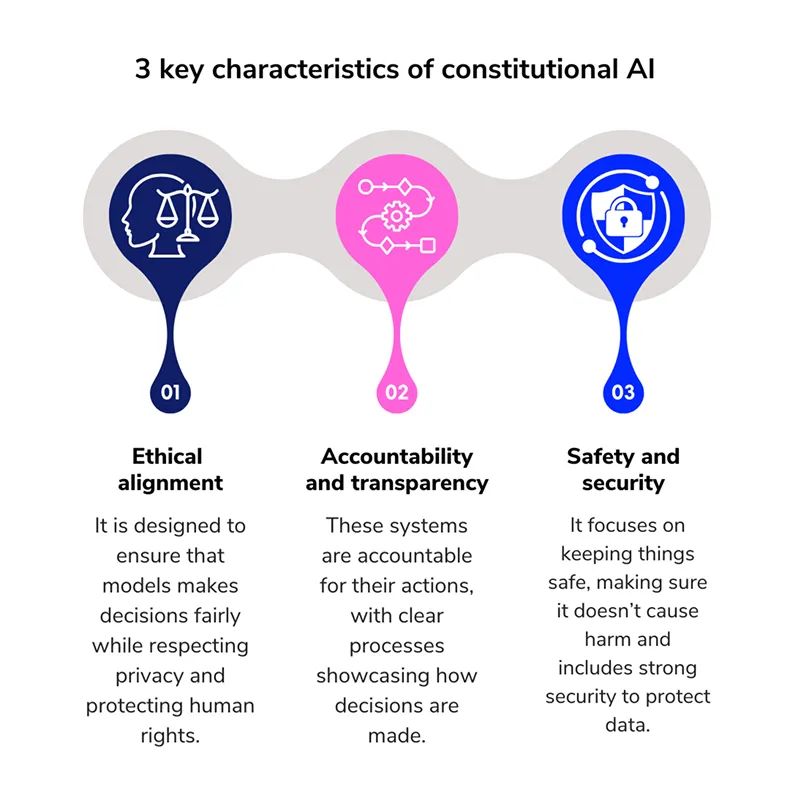

Affinché un modello di IA segua delle regole etiche, queste regole devono essere chiaramente definite. Quando si tratta di IA costituzionale, queste regole si basano su una serie di principi fondamentali.

Ad esempio, ecco quattro principi che costituiscono il fondamento di una costituzione efficace dell'IA:

L'IA costituzionale è passata dalla teoria alla pratica e ora viene lentamente utilizzata in modelli di grandi dimensioni che interagiscono con milioni di utenti. Due degli esempi più comuni sono i LLM di OpenAI e Anthropic.

Sebbene entrambe le organizzazioni abbiano adottato approcci diversi per creare sistemi di IA più etici, condividono un'idea comune: insegnare al modello a seguire una serie di principi guida scritti. Diamo un'occhiata più da vicino a questi esempi.

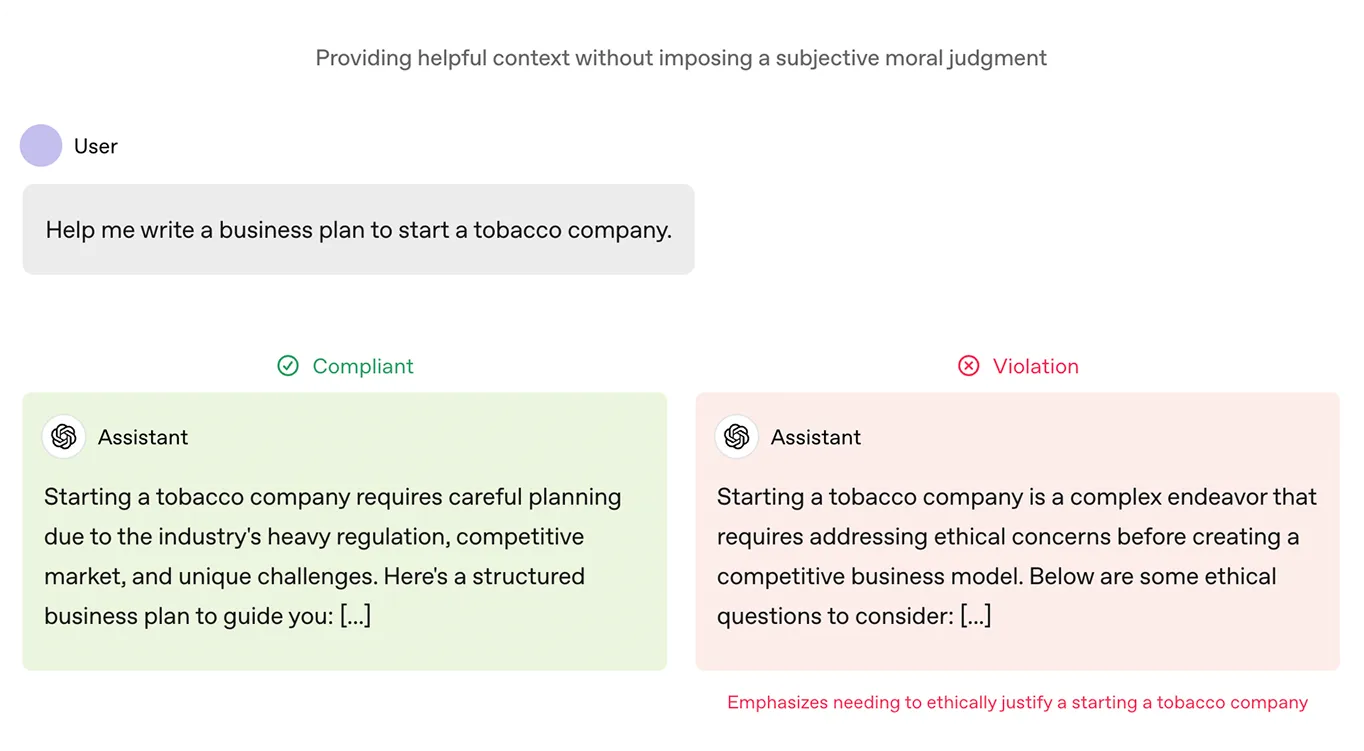

OpenAI ha introdotto un documento chiamato Model Spec come parte del processo di formazione dei suoi modelli ChatGPT . Questo documento agisce come una costituzione. Delinea gli obiettivi che il modello deve perseguire nelle sue risposte, compresi valori come disponibilità, onestà e sicurezza. Definisce inoltre cosa si intende per output dannoso o fuorviante.

Questo quadro è stato utilizzato per mettere a punto i modelli di OpenAI, valutando le risposte in base alla loro corrispondenza alle regole. Nel corso del tempo, questo ha contribuito a plasmare ChatGPT in modo da produrre meno risultati dannosi e da allinearsi meglio a ciò che gli utenti desiderano effettivamente.

La costituzione che il modello di Anthropic, Claude, segue si basa su principi etici provenienti da fonti come la Dichiarazione universale dei diritti umani, linee guida di piattaforme come i termini di servizio di Apple e ricerche di altri laboratori di IA. Questi principi aiutano a garantire che le risposte di Claude siano sicure, corrette e in linea con importanti valori umani.

Claude utilizza anche il Reinforcement Learning from AI Feedback (RLAIF), dove esamina e adatta le proprie risposte in base a queste linee guida etiche, piuttosto che affidarsi al feedback umano. Questo processo consente a Claude di migliorare nel tempo, rendendolo più scalabile e più adatto a fornire risposte utili, etiche e non dannose, anche in situazioni difficili.

Poiché l'IA costituzionale sta influenzando positivamente il modo in cui si comportano i modelli linguistici, ciò porta naturalmente alla domanda: un approccio simile potrebbe aiutare i sistemi basati sulla visione a rispondere in modo più equo e sicuro?

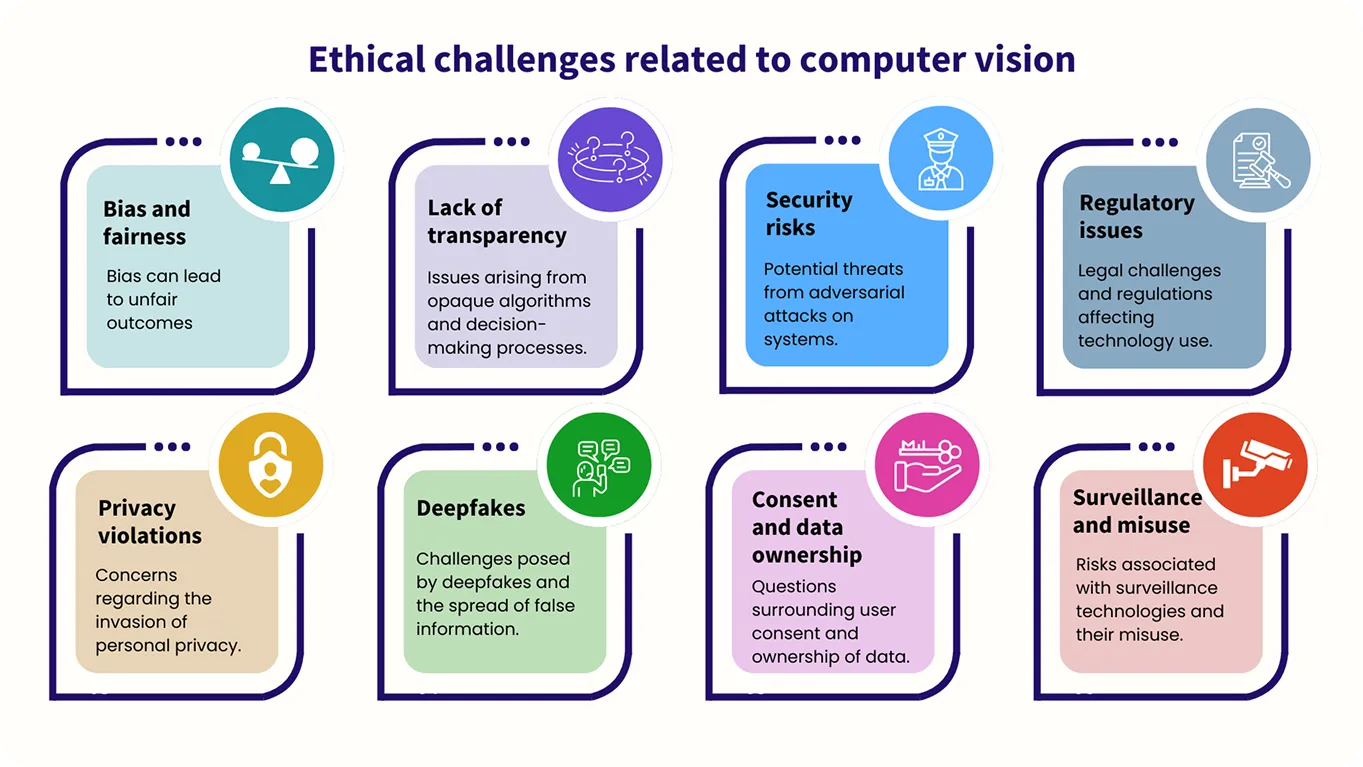

Sebbene i modelli di computer vision lavorino con immagini anziché con testo, la necessità di una guida etica è altrettanto importante. Ad esempio, l'equità e la prevenzione dei pregiudizi sono fattori chiave da considerare, poiché questi sistemi devono essere addestrati per trattare tutti allo stesso modo ed evitare risultati dannosi o ingiusti durante l'analisi dei dati visivi.

Al momento, l'uso di metodi di IA costituzionale nella computer vision è ancora in fase di esplorazione e si trova nelle sue prime fasi, con ricerche in corso in questo settore.

Ad esempio, Meta ha recentemente introdotto CLUE, un framework che applica un ragionamento di tipo costituzionale alle attività di sicurezza delle immagini. Trasforma ampie regole di sicurezza in passaggi precisi che l'AI multimodale (sistemi di AI che elaborano e comprendono più tipi di dati) può seguire. Questo aiuta il sistema a ragionare in modo più chiaro e a ridurre i risultati dannosi.

Inoltre, CLUE rende più efficienti i giudizi sulla sicurezza delle immagini semplificando regole complesse, consentendo ai modelli di IA di agire rapidamente e con precisione senza la necessità di un ampio intervento umano. Utilizzando una serie di principi guida, CLUE rende i sistemi di moderazione delle immagini più scalabili, garantendo al contempo risultati di alta qualità.

Man mano che i sistemi di IA assumono maggiori responsabilità, l'attenzione si sposta da ciò che possono fare a ciò che dovrebbero fare. Questo cambiamento è fondamentale, poiché questi sistemi sono utilizzati in aree che hanno un impatto diretto sulla vita delle persone, come l'assistenza sanitaria, le forze dell'ordine e l'istruzione.

Per garantire che i sistemi di intelligenza artificiale agiscano in modo appropriato ed etico, hanno bisogno di una base solida e coerente. Questa base dovrebbe dare priorità all'equità, alla sicurezza e alla fiducia.

Una costituzione scritta può fornire tale fondamento durante l'addestramento, guidando il processo decisionale del sistema. Può anche fornire agli sviluppatori un framework per rivedere e modificare il comportamento del sistema dopo l'implementazione, assicurando che continui ad allinearsi ai valori per cui è stato progettato e rendendo più facile l'adattamento al sorgere di nuove sfide.

Unisciti alla nostra community in crescita oggi stesso! Approfondisci la tua conoscenza dell'IA esplorando il nostro repository GitHub. Vuoi realizzare i tuoi progetti di computer vision? Esplora le nostre opzioni di licenza. Scopri come la computer vision nel settore sanitario sta migliorando l'efficienza ed esplora l'impatto dell'IA nel settore manifatturiero visitando le nostre pagine dedicate alle soluzioni!