Scopri perché è essenziale affrontare l'IA in modo etico, come vengono gestite le normative sull'IA in tutto il mondo e quale ruolo puoi svolgere nella promozione di un uso etico dell'IA.

Scopri perché è essenziale affrontare l'IA in modo etico, come vengono gestite le normative sull'IA in tutto il mondo e quale ruolo puoi svolgere nella promozione di un uso etico dell'IA.

Con la crescente diffusione della tecnologia AI, le discussioni sull'utilizzo dell'intelligenza artificiale (AI) in modo etico sono diventate molto comuni. Poiché molti di noi utilizzano quotidianamente strumenti basati sull'IA come ChatGPT , c'è una buona ragione per chiedersi se stiamo adottando l'IA in modo sicuro e moralmente corretto. I dati sono alla base di tutti i sistemi di IA e molte applicazioni di IA utilizzano dati personali come le immagini del vostro viso, le transazioni finanziarie, le cartelle cliniche, i dettagli sul vostro lavoro o la vostra posizione. Dove vanno a finire questi dati e come vengono gestiti? Queste sono alcune delle domande a cui l'IA etica cerca di rispondere e di sensibilizzare gli utenti dell'IA.

Quando discutiamo di questioni etiche relative all'IA, è facile lasciarsi trasportare e saltare alle conclusioni pensando a scenari come Terminator e ai robot che prendono il sopravvento. Tuttavia, la chiave per capire come affrontare l'IA etica in modo pratico è semplice e piuttosto diretta. Si tratta di costruire, implementare e utilizzare l'IA in modo equo, trasparente e responsabile. In questo articolo, esploreremo perché l'IA dovrebbe rimanere etica, come creare innovazioni etiche nell'IA e cosa puoi fare per promuovere l'uso etico dell'IA. Iniziamo!

Prima di addentrarci nelle specifiche dell'AI etica, diamo un'occhiata più da vicino al motivo per cui è diventato un argomento di conversazione così essenziale nella comunità dell'AI e cosa significa esattamente che l'AI sia etica.

L'etica in relazione all'IA non è un argomento di conversazione nuovo. Se ne discute fin dagli anni '50. All'epoca, Alan Turing introdusse il concetto di intelligenza artificiale e il test di Turing, una misura della capacità di una macchina di esibire un'intelligenza simile a quella umana attraverso la conversazione, che diede inizio alle prime discussioni etiche sull'IA. Da allora, i ricercatori hanno commentato e sottolineato l'importanza di considerare gli aspetti etici dell'IA e della tecnologia. Tuttavia, solo di recente organizzazioni e governi hanno iniziato a creare normative per imporre un'IA etica.

Ci sono tre ragioni principali per questo:

Con l'AI che diventa sempre più avanzata e riceve maggiore attenzione a livello globale, la conversazione sull'AI etica diventa inevitabile.

Per capire veramente cosa significa che l'IA sia etica, dobbiamo analizzare le sfide che l'IA etica deve affrontare. Queste sfide riguardano una serie di questioni, tra cui la parzialità, la privacy, la responsabilità e la sicurezza. Alcune di queste lacune nell'IA etica sono state scoperte nel tempo implementando soluzioni di IA con pratiche scorrette, mentre altre potrebbero emergere in futuro.

.webp)

Ecco alcune delle principali sfide etiche nell'IA:

Affrontando queste sfide, possiamo sviluppare sistemi di IA che vadano a beneficio della società.

Successivamente, esaminiamo come implementare soluzioni di IA etiche che affrontino ciascuna delle sfide menzionate in precedenza. Concentrandosi su aree chiave come la creazione di modelli di IA imparziali, la formazione degli stakeholder, la priorità alla privacy e la garanzia della sicurezza dei dati, le organizzazioni possono creare sistemi di IA efficaci ed etici.

La creazione di modelli AI imparziali inizia con l'utilizzo di dataset diversificati e rappresentativi per l'addestramento. Audit regolari e metodi di rilevamento dei bias aiutano a identificare e mitigare i bias. Tecniche come il re-sampling o il re-weighting possono rendere i dati di addestramento più equi. La collaborazione con esperti del settore e il coinvolgimento di team diversificati nello sviluppo possono anche aiutare a riconoscere e affrontare i bias da diverse prospettive. Questi passaggi aiutano a impedire ai sistemi AI di favorire ingiustamente un particolare gruppo.

.webp)

Più si conosce la black box dell'AI, meno diventa scoraggiante, rendendo essenziale per tutti coloro che sono coinvolti in un progetto di AI capire come funziona l'AI alla base di qualsiasi applicazione. Le parti interessate, inclusi sviluppatori, utenti e decision-maker, possono affrontare meglio le implicazioni etiche dell'AI quando hanno una conoscenza completa dei diversi concetti di AI. Programmi di formazione e workshop su argomenti come bias, trasparenza, responsabilità e privacy dei dati possono costruire questa comprensione. Una documentazione dettagliata che spieghi i sistemi di AI e i loro processi decisionali può aiutare a costruire la fiducia. Anche una comunicazione regolare e aggiornamenti sulle pratiche etiche di AI possono essere una grande aggiunta alla cultura organizzativa.

Dare priorità alla privacy significa sviluppare policy e pratiche solide per proteggere i dati personali. I sistemi di IA dovrebbero utilizzare dati ottenuti con il consenso appropriato e applicare tecniche di minimizzazione dei dati per limitare la quantità di informazioni personali elaborate. La crittografia e l'anonimizzazione possono proteggere ulteriormente i dati sensibili.

È essenziale la conformità alle normative sulla protezione dei dati, come il GDPR (Regolamento generale sulla protezione dei dati). Il GDPR stabilisce le linee guida per la raccolta e l'elaborazione delle informazioni personali degli individui all'interno dell'Unione Europea. È inoltre fondamentale essere trasparenti sulla raccolta, l'uso e l'archiviazione dei dati. Valutazioni regolari dell'impatto sulla privacy possono identificare potenziali rischi e supportare il mantenimento della privacy come priorità.

Oltre alla privacy, la sicurezza dei dati è essenziale per la costruzione di sistemi di AI etici. Solide misure di cybersecurity proteggono i dati da violazioni e accessi non autorizzati. Audit di sicurezza e aggiornamenti regolari sono necessari per tenere il passo con l'evoluzione delle minacce.

I sistemi di IA dovrebbero incorporare funzionalità di sicurezza come controlli di accesso, archiviazione sicura dei dati e monitoraggio in tempo reale. Un piano di risposta agli incidenti chiaro aiuta le organizzazioni ad affrontare rapidamente eventuali problemi di sicurezza. Dimostrando un impegno per la sicurezza dei dati, le organizzazioni possono costruire fiducia tra utenti e stakeholder.

Per Ultralytics, l'IA etica è un principio fondamentale che guida il nostro lavoro. Come afferma Glenn Jocher, fondatore e CEO: "L'IA etica non è solo una possibilità, è una necessità. Comprendendo e rispettando le normative, possiamo garantire che le tecnologie AI siano sviluppate e utilizzate in modo responsabile in tutto il mondo. La chiave è bilanciare l'innovazione con l'integrità, assicurando che l'IA serva l'umanità in modo positivo e vantaggioso. Diamo l'esempio e dimostriamo che l'IA può essere una forza per il bene".

Questa filosofia ci spinge a dare priorità all'equità, alla trasparenza e alla responsabilità nelle nostre soluzioni di IA. Integrando queste considerazioni etiche nei nostri processi di sviluppo, miriamo a creare tecnologie che spingano i confini dell'innovazione e aderiscano ai più alti standard di responsabilità. Il nostro impegno per un'IA etica aiuta il nostro lavoro ad avere un impatto positivo sulla società e stabilisce un punto di riferimento per le pratiche di IA responsabili in tutto il mondo.

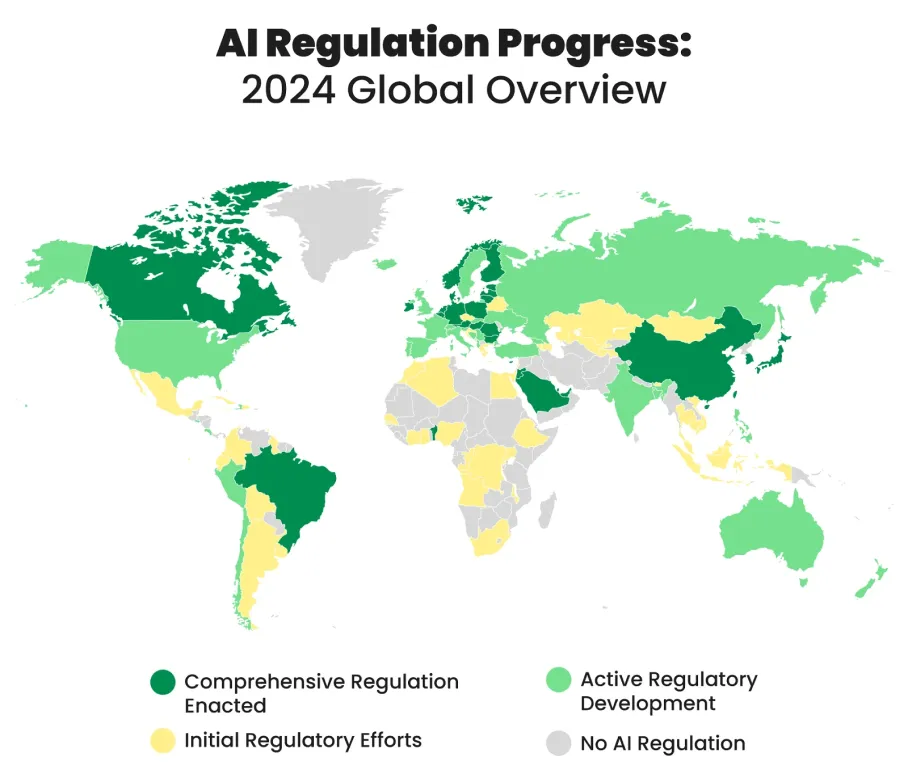

Diversi paesi in tutto il mondo stanno sviluppando e implementando normative sull'IA per guidare l'uso etico e responsabile delle tecnologie di IA. Queste normative mirano a bilanciare l'innovazione con considerazioni morali e a proteggere gli individui e la società dai potenziali rischi associati alle innovazioni dell'IA.

Ecco alcuni esempi di misure adottate in tutto il mondo per regolamentare l'uso dell'IA:

Promuovere l'IA etica è più facile di quanto si possa pensare. Imparando di più su questioni come pregiudizi, trasparenza e privacy, potete diventare una voce attiva nella conversazione sull'IA etica. Sostenete e seguite le linee guida etiche, verificate regolarmente la correttezza e proteggete la privacy dei dati. Quando si utilizzano strumenti di IA come ChatGPT, essere trasparenti sul loro utilizzo aiuta a creare fiducia e rende l'IA più etica. Adottando queste misure, potete contribuire a promuovere un'IA sviluppata e utilizzata in modo equo, trasparente e responsabile.

In Ultralytics ci impegniamo per un'IA etica. Se volete saperne di più sulle nostre soluzioni di IA e vedere come manteniamo una mentalità etica, visitate il nostro repository GitHub, unitevi alla nostra comunità ed esplorate le nostre ultime soluzioni in settori come quello sanitario e manifatturiero! 🚀