FastVLM: Apple presenta il suo nuovo modello linguistico di visione veloce

Apple presenta FastVLM al CVPR 2025. Questo modello open‑source di visione‑linguaggio presenta l'encoder FastViTHD, offrendo un tempo‑al‑primo‑token fino a 85 × più veloce.

Apple presenta FastVLM al CVPR 2025. Questo modello open‑source di visione‑linguaggio presenta l'encoder FastViTHD, offrendo un tempo‑al‑primo‑token fino a 85 × più veloce.

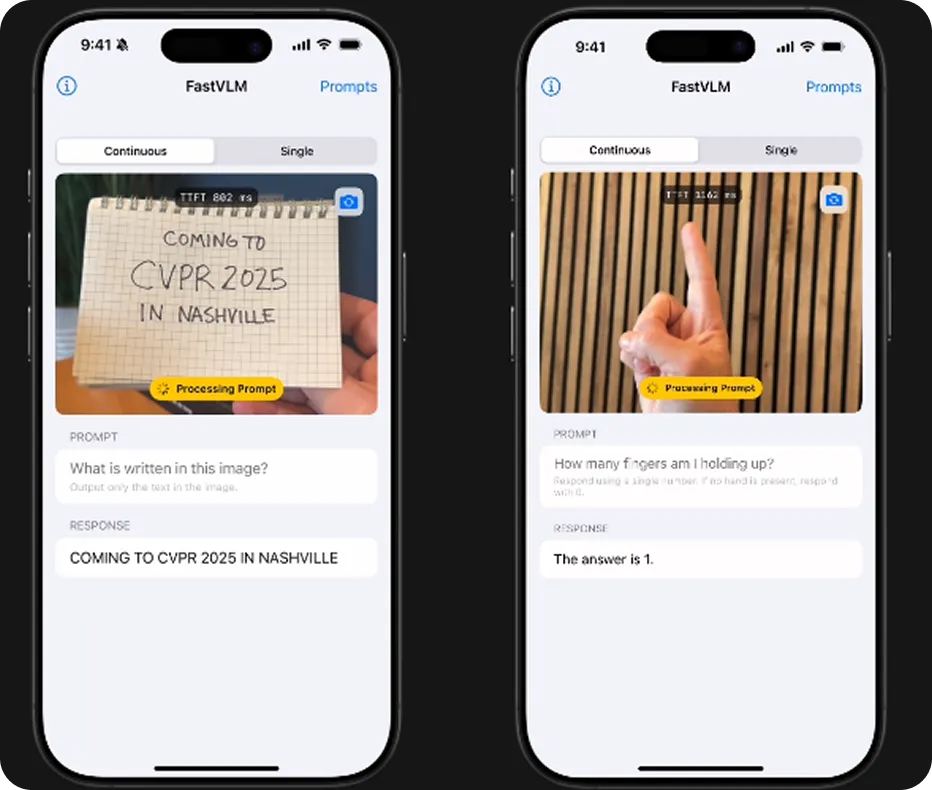

Alla conferenza CVPR 2025, Apple ha presentato un nuovo modello di IA open-source chiamato FastVLM. È stato creato per comprendere sia le immagini che il linguaggio e funziona su dispositivi Apple come iPhone, iPad e Mac. Ciò significa che può fornire risultati intelligenti rapidamente, senza inviare i tuoi dati al cloud.

Ciò che rende FastVLM particolarmente interessante è la sua velocità ed efficienza. Apple ha sviluppato un nuovo encoder di visione chiamato FastViTHD, che aiuta il modello a interpretare immagini di alta qualità utilizzando meno memoria ed energia. Tutta l'elaborazione avviene localmente sul dispositivo, con conseguenti tempi di risposta più rapidi e al contempo preservando la privacy dell'utente.

In questo articolo esploreremo come funziona FastVLM, cosa lo distingue e perché questa versione di Apple potrebbe essere un passo avanti significativo per le applicazioni AI di tutti i giorni sui tuoi dispositivi.

Prima di analizzare cosa rende FastVLM speciale, vediamo cosa significa l'acronimo "VLM" nel suo nome. Si riferisce a un modello di visione-linguaggio, progettato per comprendere e collegare contenuti visivi con il linguaggio.

I VLM uniscono la comprensione visiva e il linguaggio, consentendo loro di eseguire attività come descrivere una foto, rispondere a domande su uno screenshot o estrarre testo da un documento. I modelli di visione-linguaggio funzionano tipicamente in due parti: una elabora l'immagine e la converte in dati, mentre l'altra interpreta tali dati per generare una risposta che puoi leggere o ascoltare.

Potresti aver già utilizzato questo tipo di innovazione dell'IA senza nemmeno rendertene conto. Le app che scansionano ricevute, leggono carte d'identità, generano didascalie per immagini o aiutano le persone con problemi di vista a interagire con i loro schermi spesso si affidano a modelli di visione-linguaggio che funzionano silenziosamente in background.

Apple ha creato FastVLM per eseguire le stesse attività di altri modelli di visione-linguaggio, ma con maggiore velocità, maggiore privacy e prestazioni ottimizzate sui propri dispositivi. Può comprendere il contenuto di un'immagine e rispondere con testo, ma a differenza di molti modelli che si basano su server cloud, FastVLM può essere eseguito interamente su iPhone, iPad o Mac.

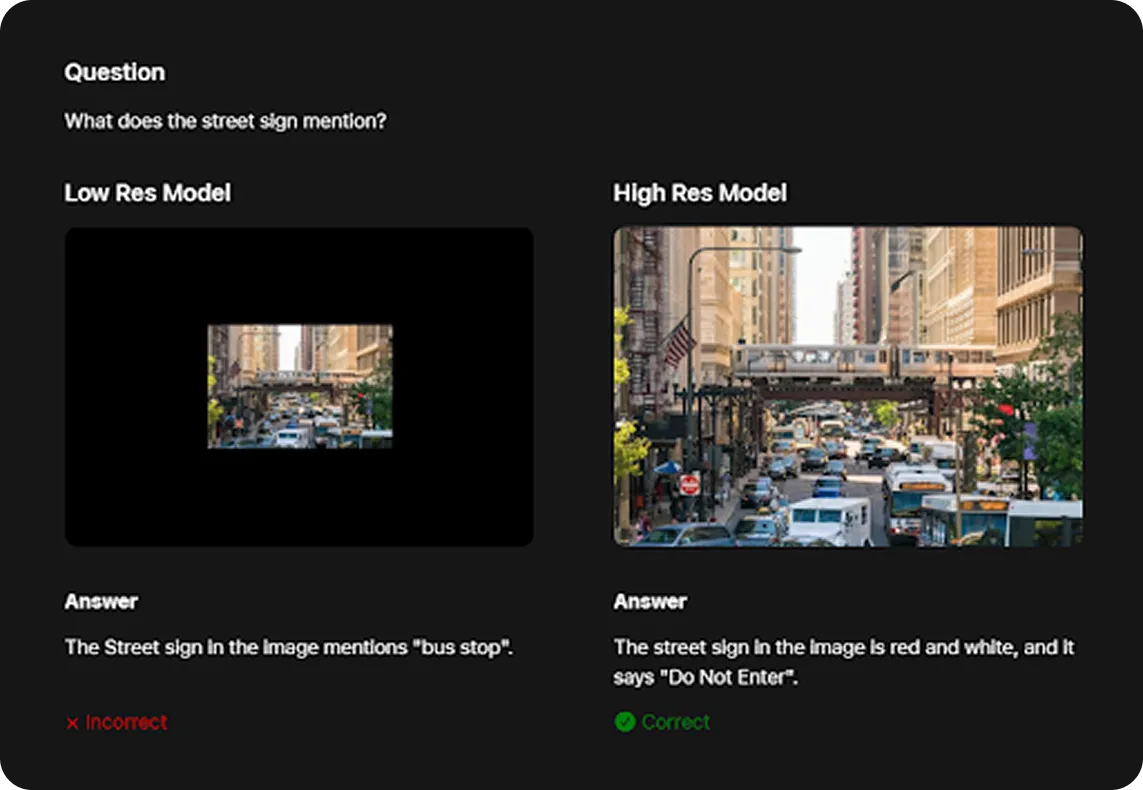

I VLM generalmente funzionano meglio con immagini ad alta risoluzione. Ad esempio, come mostrato di seguito, FastVLM è stato in grado di identificare correttamente un segnale stradale come “Divieto di accesso” solo quando gli è stata fornita una versione ad alta risoluzione dell'immagine. Tuttavia, gli input ad alta risoluzione di solito rallentano i modelli. È qui che FastViTHD fa la differenza.

Il nuovo encoder di visione di Apple, FastViTHD, aiuta FastVLM a elaborare immagini di alta qualità in modo più efficiente, utilizzando meno memoria ed energia. Nello specifico, FastViTHD è abbastanza leggero da funzionare senza problemi anche su dispositivi più piccoli.

Inoltre, FastVLM è disponibile pubblicamente nel repository GitHub di FastVLM, dove gli sviluppatori possono accedere al codice sorgente, apportare modifiche e utilizzarlo nelle proprie app in conformità con i termini di licenza di Apple.

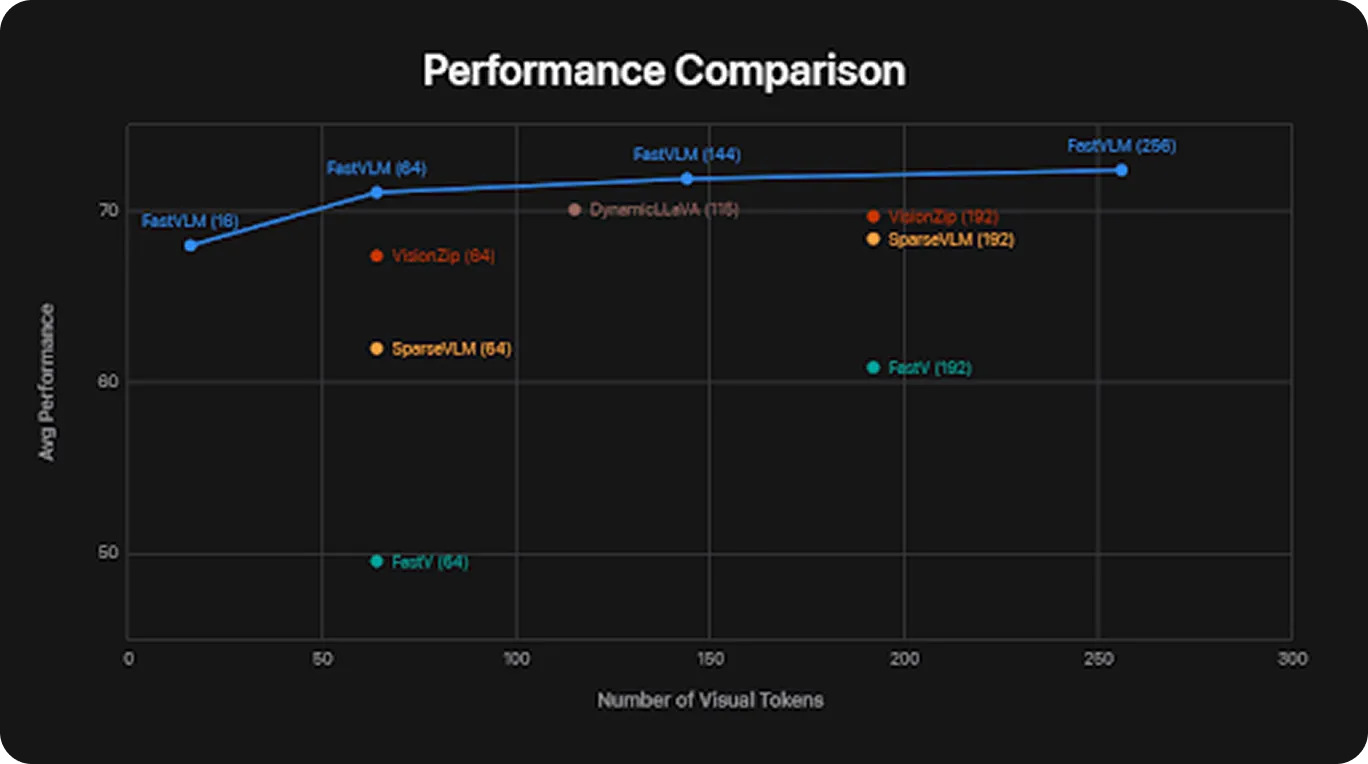

Rispetto ad altri modelli di visione-linguaggio, FastVLM è ottimizzato per essere eseguito su dispositivi di uso quotidiano come smartphone e laptop. Nei test di performance, FastVLM ha generato la sua prima parola o output fino a 85 volte più velocemente di modelli come LLaVA-OneVision-0.5B.

Ecco una panoramica di alcuni dei benchmark standard su cui FastVLM è stato valutato:

In questi benchmark, FastVLM ha ottenuto risultati competitivi pur utilizzando meno risorse. Porta l'AI visiva pratica ai dispositivi di uso quotidiano come telefoni, tablet e laptop.

Successivamente, esaminiamo più da vicino FastViTHD, l'encoder di visione che svolge un ruolo cruciale nelle prestazioni di elaborazione delle immagini di FastVLM.

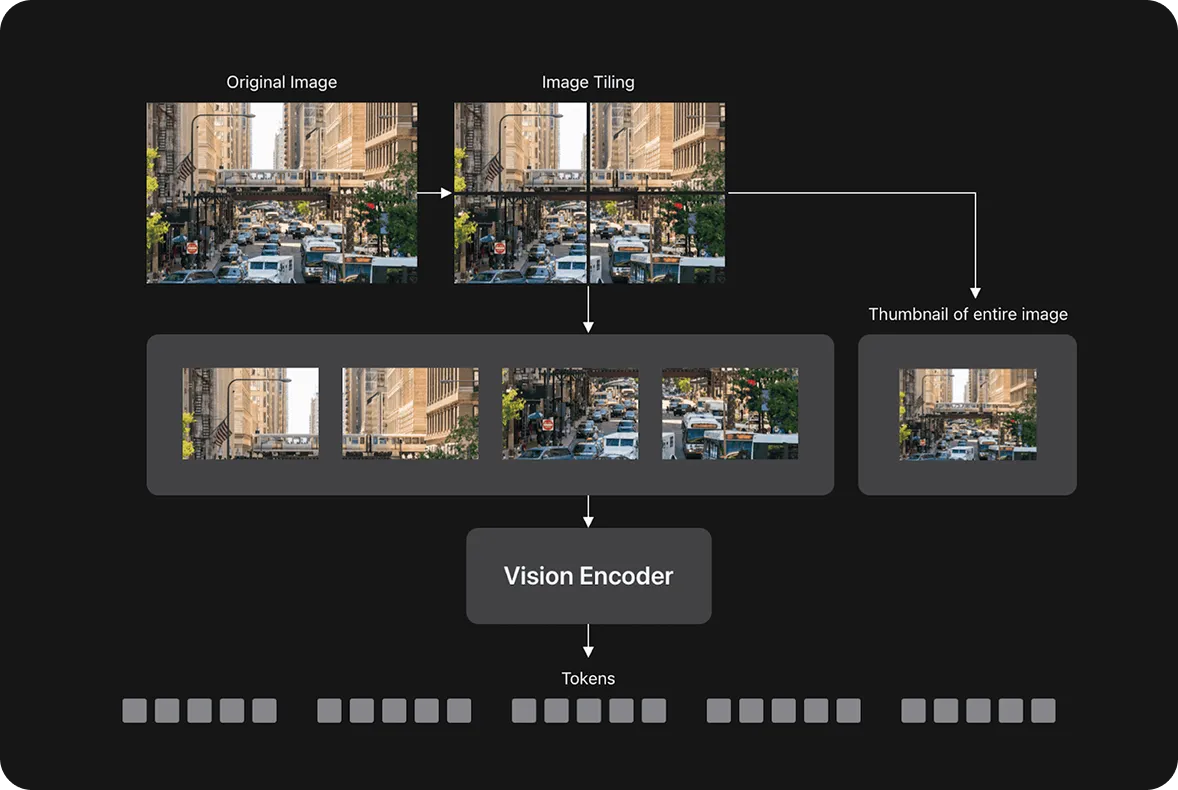

La maggior parte dei modelli linguistici visivi divide un'immagine in migliaia di piccole patch chiamate token. Più token ci sono, più tempo ed energia il modello ha bisogno per capire l'immagine. Questo può rallentare le cose, specialmente su telefoni o laptop.

FastViTHD evita il rallentamento che deriva dall'elaborazione di troppi token utilizzandone un numero inferiore, pur comprendendo l'intera immagine. Combina due approcci: i transformer, che sono bravi a modellare schemi e relazioni, e i livelli convoluzionali, che sono efficienti nell'elaborazione dei dati visivi. Il risultato è un sistema che funziona più velocemente e utilizza meno memoria.

Secondo Apple, FastViTHD è fino a 3,4 volte più piccolo di alcuni encoder di visione tradizionali, pur mantenendo un'elevata precisione. Invece di fare affidamento su tecniche di ottimizzazione del modello come il token pruning (rimozione di patch di immagini meno importanti per accelerare l'elaborazione), raggiunge l'efficienza attraverso un'architettura più semplice e snella.

Apple ha rilasciato FastVLM in tre diverse dimensioni: 0.5B, 1.5B e 7B parametri (dove "B" sta per miliardo, riferendosi al numero di pesi addestrabili nel modello). Ogni versione è progettata per adattarsi a diversi tipi di dispositivi. I modelli più piccoli possono essere eseguiti su telefoni e tablet, mentre il modello 7B più grande è più adatto per desktop o attività più impegnative.

Questo offre agli sviluppatori la flessibilità di scegliere ciò che funziona meglio per le loro app. Possono creare qualcosa di veloce e leggero per dispositivi mobili o qualcosa di più complesso per sistemi più grandi, il tutto utilizzando la stessa architettura di modello sottostante.

Apple ha addestrato le varianti del modello FastVLM utilizzando la pipeline LLaVA‑1.5, un framework per l'allineamento della visione e dei modelli linguistici. Per la componente linguistica, hanno valutato FastVLM utilizzando modelli open-source esistenti come Qwen e Vicuna, noti per la generazione di testo naturale e coerente. Questa configurazione consente a FastVLM di elaborare immagini sia semplici che complesse e produrre risposte leggibili e pertinenti.

Potresti chiederti, perché è importante l'elaborazione efficiente delle immagini di FastVLM? Si riduce a quanto agevolmente le app possono funzionare in tempo reale senza fare affidamento sul cloud. FastVLM può gestire immagini ad alta risoluzione, fino a 1152 per 1152 pixel, pur rimanendo abbastanza veloce e leggero da funzionare direttamente sul tuo dispositivo.

Ciò significa che le app possono descrivere ciò che la fotocamera vede, scansionare le ricevute mentre vengono acquisite o rispondere alle modifiche sullo schermo, il tutto mantenendo tutto in locale. È particolarmente utile per aree come l'istruzione, l'accessibilità, la produttività e la fotografia.

Poiché FastViTHD è efficiente anche quando si tratta di immagini di grandi dimensioni, aiuta a mantenere i dispositivi reattivi e freschi. Funziona con tutte le dimensioni dei modelli, incluso quello più piccolo, che funziona su iPhone entry-level. Ciò significa che le stesse funzionalità AI possono funzionare su telefoni, tablet e Mac.

FastVLM può alimentare un'ampia gamma di applicazioni, grazie ai suoi vantaggi chiave come velocità, efficienza e privacy on-device. Ecco alcuni modi in cui può essere utilizzato:

Assistenti AI sul dispositivo: FastVLM può funzionare bene con gli assistenti AI che hanno bisogno di capire rapidamente cosa c'è sullo schermo. Poiché viene eseguito direttamente sul dispositivo e mantiene privati i dati, può aiutare con attività come la lettura di testo, l'identificazione di pulsanti o icone e la guida degli utenti in tempo reale senza la necessità di inviare informazioni al cloud.

FastVLM porta l'IA di visione-linguaggio on-device sui dispositivi Apple, combinando velocità, privacy ed efficienza. Con il suo design leggero e il rilascio open-source, consente la comprensione delle immagini in tempo reale su app mobili e desktop.

Ciò contribuisce a rendere l'IA più pratica e accessibile per l'uso quotidiano e offre agli sviluppatori una solida base per la creazione di applicazioni utili e incentrate sulla privacy. Guardando al futuro, è probabile che i modelli di visione-linguaggio svolgano un ruolo importante nel modo in cui interagiamo con la tecnologia, rendendo l'IA più reattiva, consapevole del contesto e utile nelle situazioni quotidiane.

Esplora il nostro repository GitHub per saperne di più sull'AI. Unisciti alla nostra attiva community e scopri le innovazioni in settori come l'AI nel settore automobilistico e la Vision AI nella produzione. Per iniziare oggi stesso con la computer vision, consulta le nostre opzioni di licenza.