Appleは、Eye Tracking、Music Haptics、Vocal Shortcutsのような新しいAI対応のアクセシビリティ機能を発表しました。これらはシームレスなユーザーエクスペリエンスを提供します。

Appleは、Eye Tracking、Music Haptics、Vocal Shortcutsのような新しいAI対応のアクセシビリティ機能を発表しました。これらはシームレスなユーザーエクスペリエンスを提供します。

2024年5月15日、アップルはアクセシビリティに強く焦点を当てたiOS 18の次期アップデートを発表した。今年後半にリリースが予定されているアップルの新しいアップデートには、アイトラッキング、Haptic Music、Vocal Shortcutsなどの革新的な機能が含まれている。

これらのAppleのアクセシビリティ機能により、運動機能に問題のある人、聴覚や視覚に障害のある人、および発話に困難のある人がAppleデバイスをより簡単に使用できるようになります。Appleシリコン、人工知能(AI)、および機械学習は、このような機能の背景にある技術的進歩です。Appleの新機能と、それらが日常生活に与える影響について見ていきましょう。

社会として、私たちは技術の進歩がすべての人にとって包括的なものになるようにする必要があります。テクノロジーをアクセス可能にすることで、多くの人々の生活を変えることができます。たとえば、テクノロジーは今日あらゆる仕事の大きな部分を占めていますが、アクセスできないインターフェースは、障害を持つ人々のキャリアの妨げになる可能性があります。調査によると、障害者の失業率は、2018年には障害のない人のほぼ2倍になっています。

法制度もテクノロジーのアクセシビリティ向上に取り組んでいます。多くの国で、ウェブサイトやデジタル製品のアクセシビリティ基準を義務付ける法律が追加されています。米国では、ウェブサイトのアクセシビリティに関する訴訟が着実に増加しており、2017年から2022年までに約14,000件の訴訟が起こされ、2022年だけでも3,000件以上に上ります。法的要件に関わらず、アクセシビリティは誰もが完全に社会参加できるインクルーシブな社会に不可欠です。そこで、Appleのアクセシビリティ機能が役立ちます。

Appleは2009年以来、すべての人にテクノロジーをアクセス可能にすることに取り組んできました。その年、彼らはVoiceOverを導入しました。これは、視覚障碍のあるユーザーがジェスチャーと音声フィードバックを使用してiPhoneを操作できる機能です。画面上の内容を読み上げることで、ユーザーがデバイスと対話しやすくなります。

それ以来、Appleはアクセシビリティ機能を継続的に改善および拡張してきました。画面を拡大するためのズーム、視覚的なコントラストを向上させるための色の反転、聴覚障害者向けのモノラルオーディオを導入しました。これらの機能は、さまざまな障害を持つユーザーがデバイスを操作する方法を大幅に改善しました。

過去に見られたAppleの主要なアクセシビリティ機能のいくつかについて詳しく見ていきましょう。

手の動きが不自由な人でも、画面を見るだけで簡単にインターネットを閲覧したり、メッセージを送ったり、スマートホームデバイスを操作したりできるようになりました。これらの進歩により、日常生活がより管理しやすくなり、以前は困難だったタスクを自力で完了できるようになります。

Appleの今後のエキサイティングなアクセシビリティ機能のもう1つは、アイトラッキングであり、これを現実のものにします。身体の不自由なユーザー向けに設計されたアイトラッキングは、iPadおよびiPhoneでハンズフリーナビゲーションオプションを提供します。AIと前面カメラを使用して、ユーザーが見ている場所を認識することにより、ボタン、スワイプ、およびその他のジェスチャを簡単にアクティブ化できます。

前面カメラは、アイトラッキングの設定とキャリブレーションを数秒で行います。Dwell Controlを使ってアプリの要素と対話し、目だけでボタンやスワイプなどの機能にアクセスすることができます。このデバイスは、デバイス上の機械学習を使用してすべてのデータを安全に処理するため、ユーザーはプライバシーが保護されていることを信頼できます。アイトラッキングは、追加のハードウェアやアクセサリーを必要とせず、iPadOSとiOS アプリケーションでシームレスに動作します。Apple Vision ProのVisionOSにも、簡単なナビゲーションのための視線追跡機能が搭載されています。

ミュージック触覚は、まもなくリリースされるAppleのアクセシビリティ機能の1つです。iPhoneで音楽を体験するために、聴覚障がいのあるユーザー向けに設計されています。使用すると、Taptic Engineがオーディオと同期して、タップ、テクスチャ、洗練された振動を生成します。音楽のリズムとニュアンスを感じることができます。Taptic Engineは、音楽のフィーリングを捉えるために、さまざまな強度、パターン、振動の持続時間を生成できるため、非常に詳細です。

ミュージック触覚は、聴覚に障がいのある人がこれまで不可能だった方法で音楽とつながることを可能にします。これにより、日々の生活の中で新たな体験の世界が開かれます。音楽を聴きながらランニングをしたり、友人と一緒に歌を楽しんだりすることが、共有された没入感のある体験になります。振動は、ワークアウトプレイリストのエネルギ―に合わせることで、エクササイズをより意欲的にしたり、お気に入りの瞑想曲で神経を落ち着かせたりするのに役立ちます。ミュージック触覚は、Apple Musicカタログにある数百万の楽曲をサポートしており、開発者向けのAPIとして利用できるようになるため、よりアクセシブルなアプリを作成できます。

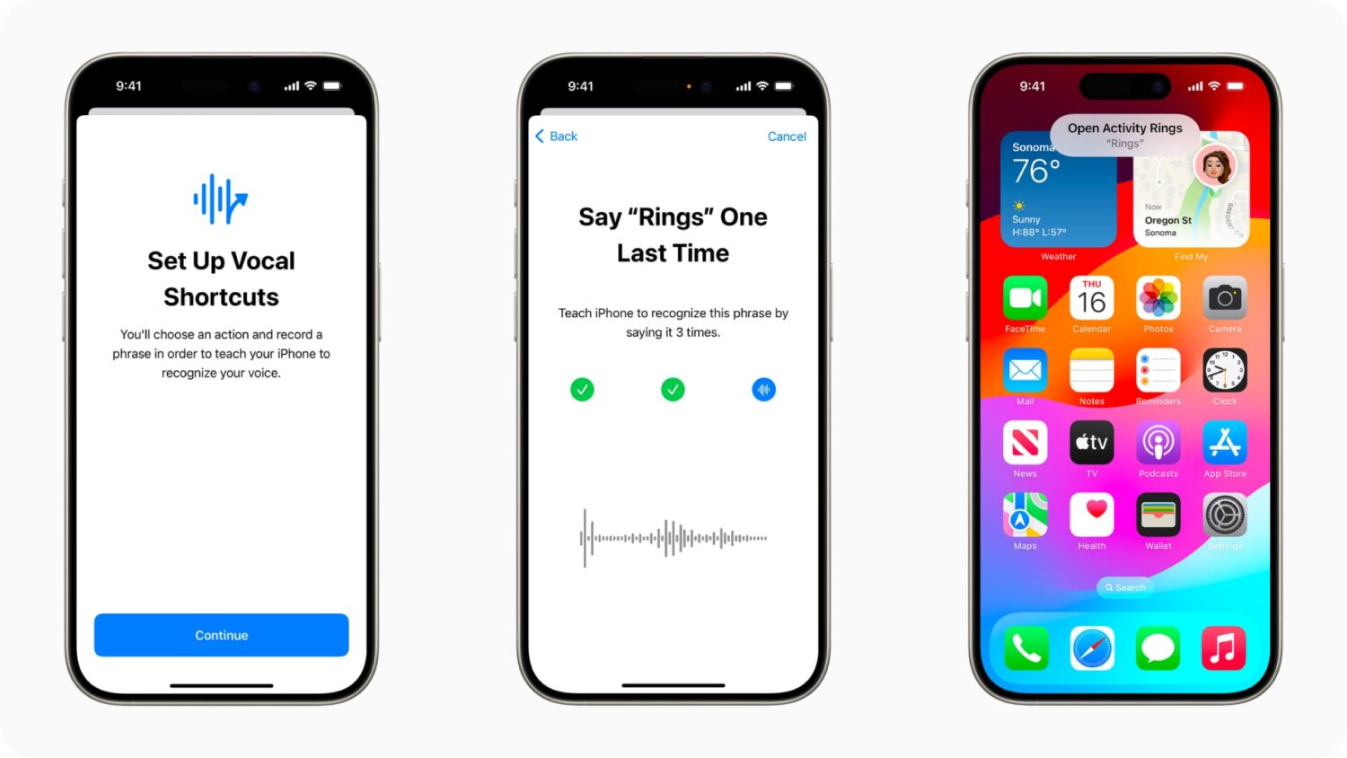

Appleは、新しいアクセシビリティ機能のリストで、AIを使用して音声システムを改善するためにVocal Shortcutsを設計しました。これにより、iPhoneおよびiPadユーザーは「カスタム発話」を作成して、Siriがショートカットを起動し、複雑なタスクを管理できます。これは、脳性麻痺、ALS、または脳卒中のような状態の人々にとって特に役立ちます。

「非定型的な発話を聞く」機能は、オンデバイスの機械学習を使用して、さまざまな発話パターンを認識して適応し、メッセージの送信やリマインダーの設定などのタスクを容易にします。カスタム語彙や複雑な単語をサポートすることで、Vocal Shortcutsはパーソナライズされた効率的なユーザーエクスペリエンスを提供します。

また、乗客が旅行中により快適にデバイスを使用できるようにするための、Appleの新しいアクセシビリティ機能もいくつかあります。たとえば、Vehicle Motion Cuesは、移動中の車両の乗客の乗り物酔いを軽減するのに役立つ、iPhoneおよびiPadの新機能です。

乗り物酔いは、人が見ているものと感じているものとの感覚の不一致が原因で起こることが多く、移動中に機器を使用することを不快にさせる。ビークル・モーション・キューは、画面の端に車両の動きの変化を表すドットのアニメーションを表示することで、この問題に対処します。メインのコンテンツを邪魔することなく、感覚の衝突を軽減します。この機能は、iPhoneやiPadに内蔵されたセンサーを利用して、ユーザーが動いている乗り物に乗っていることをdetect し、それに応じて調整します。

CarPlayは、アクセシビリティを向上させるためのアップデートも行われました。ボイスコントロールにより、ユーザーは音声コマンドでCarPlayとそのアプリを操作できます。また、サウンド認識は、聴覚に障がいのあるユーザーに、車のクラクションやサイレンを知らせます。色覚特性を持つユーザーのために、カラーフィルタはCarPlayインターフェースの視覚的な使いやすさを向上させます。これらの機能強化は、すべての乗客が車内でより快適に過ごせるように役立ちます。

Apple Vision Proはすでに、字幕、クローズドキャプション、トランスクリプションといったAppleのアクセシビリティ機能を提供し、ユーザーが音声やビデオを追うのを助けている。そして今回、アップルはこれらの機能をさらに拡張します。新しいAI主導のLive Captions機能は、リアルタイムで画面にテキストを表示することで、誰もがライブの会話やアプリからの音声で話されたダイアログを追うことができます。これは、耳の不自由な方にとって特に有益です。

例えば、VisionOSでのFaceTime通話中、ユーザーは話されたダイアログがスクリーンに書き起こされているのを見ることができ、ペルソナ(コンピューターが生成した仮想アバター)を使った接続や共同作業が容易になる。

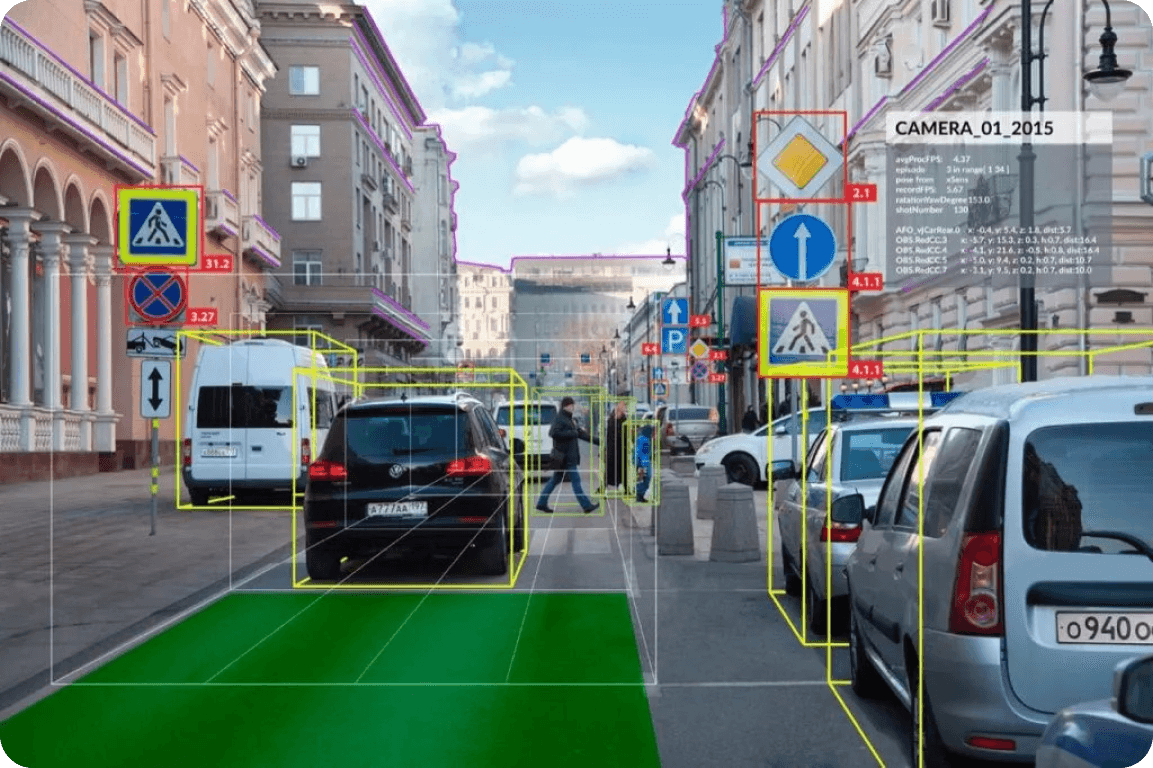

Appleのアクセシビリティへの取り組みと同様に、他の多くの企業もAIを活用してアクセシブルなソリューションを積極的に研究し、革新しています。たとえば、AI対応の自動運転車は、運転を容易にすることで、移動に不自由のある人々に自立性を提供できます。これまで、障がいのある人々は、手動制御、ステアリング補助、車椅子対応機能などの改造を施した特殊車両を使用して運転してきました。コンピュータビジョンのようなAI技術の統合により、これらの車両はさらに多くのサポートを提供できるようになりました。

テスラのオートパイロットは、AIによる運転支援の好例だ。高度なセンサーとカメラを使って障害物をdetect し、交通信号を解釈し、リアルタイムのナビゲーションアシストを提供する。こうしたAIの入力により、車両は車線内にとどまったり、交通状況に応じて速度を調整したりするなど、さまざまな運転タスクをこなすことができる。コンピューター・ビジョンによる洞察は、誰にとってもより安全で利用しやすい運転体験を提供する。

これらの新しいAppleのアップデートにより、AI主導のインクルージョンの新しい時代が到来します。Appleは、アクセシビリティ機能にAIを統合することで、障害を持つ人々の日常業務を容易にし、テクノロジーにおけるインクルージョンとイノベーションを促進しています。これらの進歩は、さまざまな市場に影響を与えます。テクノロジー企業はインクルージョンの新たなベンチマークを設定し、ヘルスケアは障害を持つ個人の自立性の向上から恩恵を受け、家電製品はアクセシブルなデバイスに対する需要が高まるでしょう。テクノロジーの未来は、すべての人にとってシームレスなユーザーエクスペリエンスを創造することにあると考えられます。

最先端のAI開発に関する最新情報を得るには、GitHubリポジトリをチェックして、コミュニティに参加してください。AIが自動運転技術、製造業、ヘルスケアなどをどのように変革しているかをご覧ください。