Meta AIの新しいSegment Anything ModelであるSAM 3が、実世界の画像や動画からオブジェクトを簡単にdetect、segment、track する方法をご覧ください。

Meta AIの新しいSegment Anything ModelであるSAM 3が、実世界の画像や動画からオブジェクトを簡単にdetect、segment、track する方法をご覧ください。

2025年11月19日、Meta AIはSegment Anything Model 3(通称SAM 3)をリリースした。このSegment Anything Modelの最新バージョンは、テキストプロンプト、ビジュアルプロンプト、画像例を使用して、実世界の画像やビデオ内のオブジェクトをdetect、segment、track する新しい方法を紹介します。

SAM 3モデルは、以下をベースにしている。 SAMとSAM 2をベースとし、コンセプトセグメンテーション、オープンボキャブラリー検出、リアルタイムビデオトラッキングなどの新しい進化と機能をもたらします。短い名詞句を理解し、フレームをまたいでオブジェクトを追跡し、以前のモデルでは一貫して扱うことができなかった細かな概念や希少な概念を識別することができます。

SAM 3リリースの一環として、MetaはSAM 3Dも発表した。この次世代モデルスイートは、1つの画像からオブジェクト、シーン、人体全体を再構築し、Segment Anythingエコシステムを3D理解へと拡張します。これらの追加により、コンピュータビジョン、ロボット工学、メディア編集、クリエイティブワークフローにまたがる新たなアプリケーションを開拓します。

この記事では、SAM 3とは何か、SAM 2と何が違うのか、このモデルがどのように機能するのか、そして実際の応用例について探っていく。始めよう!

SAM 3は、簡単な指示に基づいて画像やビデオ内のオブジェクトを識別、分離、track できる最先端のコンピュータビジョンモデルです。固定されたラベルリストに頼るのではなく、SAM 3は自然言語と視覚的な手がかりを理解するため、見つけたいものを簡単にモデルに伝えることができます。

例えば、SAM 3では、"黄色のスクールバス "や "縞模様の猫 "といった短いフレーズを入力したり、オブジェクトをクリックしたり、画像内の例をハイライトしたりすることができる。するとモデルは、一致するオブジェクトをすべてdetect し、きれいなセグメンテーションマスク(どのピクセルがオブジェクトに属するかを正確に示す視覚的アウトライン)を生成する。SAM 3はまた、ビデオフレームをまたいでこれらのオブジェクトを追跡し、オブジェクトが移動しても一貫性を保つことができる。

Meta AIの発表のもう一つのエキサイティングな部分は、SAM Anythingプロジェクトを3D理解に拡張するSAM 3Dである。SAM 3Dは、1枚の2D画像を用いて、物体や人体の形状、ポーズ、構造を3次元的に再構築することができる。言い換えれば、このモデルは、1つの視点しか利用できない場合でも、何かが空間をどのように占めているかを推定することができる。

SAM 3Dは2つの異なるモデルとしてリリースされている:SAM 3D Objectsは、日用品をジオメトリとテクスチャで再構築し、SAM 3D Bodyは、1枚の画像から人体の形状とポーズを推定します。どちらのモデルも、SAM 3のセグメンテーション出力を使用し、元の写真におけるオブジェクトの外観と位置に沿った3D表現を生成します。

検出、セグメンテーション、トラッキングを1つの統一されたモデルにまとめるために、SAM 3が導入した主なアップデートをいくつか紹介しよう:

さまざまな動物が登場するサファリのビデオを見ていて、ゾウだけをdetect segment したいとしよう。SAM異なるバージョン間で、このタスクはどのように見えるだろうか?

SAM、セグメンテーションマスクを生成するために、各フレームの象を手動でクリックする必要がある。トラッキングがないので、新しいフレームごとに新しいクリックが必要になる。

SAM 2では、象を一度クリックすると、その象のマスクを取得し、モデルは同じ象をビデオを通してtrack ことができます。しかし、SAM 2は "ゾウ "のようなカテゴリーを単独では理解できないため、複数のゾウ(特定のオブジェクト)をsegment したい場合は、別々にクリックする必要がある。

SAM 3を使えば、ワークフローはよりシンプルになる。象 "と入力するか、1頭の象の周囲にバウンディングボックスを描くと、モデルは自動的にビデオ内のすべての象を見つけ、segment し、フレーム間で一貫してtrack します。以前のバージョンで使用されていたクリックとボックスのプロンプトはまだサポートしていますが、テキストプロンプトや模範画像にも反応できるようになりました。

次に、SAM 3モデルがどのように機能し、どのようにトレーニングされたかを詳しく見てみよう。

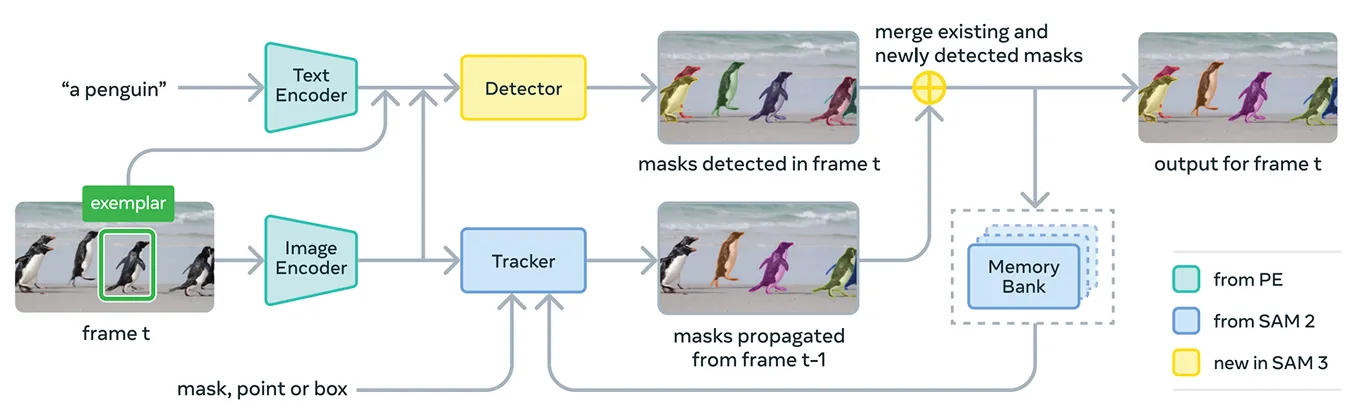

SAM 3は、コンセプト・プロンプトとビジュアル・プロンプトを1つのシステムでサポートするために、いくつかのコンポーネントを1つにまとめたものである。その中核となるモデルは、Metaの統一されたオープンソースの画像-テキストエンコーダであるMeta Perception Encoderを使用している。

このエンコーダは、画像と短い名詞句の両方を処理できる。簡単に言えば、これによりSAM 3は、以前のバージョンのSegment Anything Modelよりも、言語と視覚的特徴をより効果的に結びつけることができる。

このエンコーダーの上に、SAM 3はDETRファミリーの変圧器モデルに基づく検出器を搭載している。この検出器は画像内のオブジェクトを識別し、どのオブジェクトがユーザーのプロンプトに対応するかをシステムが判断するのに役立ちます。

具体的には、ビデオのセグメンテーションにおいて、SAM 3は、SAM 2のメモリバンクとメモリエンコーダをベースにしたトラッキングコンポーネントを使用する。これにより、モデルはフレームをまたいでオブジェクトに関する情報を保持し、時間の経過とともにオブジェクトを再識別してtrack することができる。

SAM 3をトレーニングするために、Metaは現在インターネット上に存在するデータよりもはるかに多くのアノテーションデータを必要とした。高品質のセグメンテーション・マスクやテキスト・ラベルを大規模に作成するのは困難であり、画像やビデオ内のコンセプトのすべてのインスタンスを完全にアウトライン化するのは時間もコストもかかる。

これを解決するために、Metaは、SAM 3自体、追加のAIモデル、人間のアノテーターを組み合わせた新しいデータエンジンを構築した。ワークフローは、SAM 3とLlamaベースのキャプションモデルを含むAIシステムのパイプラインから始まる。

これらのシステムは、画像やビデオの大規模なコレクションをスキャンし、キャプションを生成し、それらのキャプションをテキストラベルに変換し、初期のセグメンテーションマスク候補を生成する。その後、人間とAIのアノテーターがこれらの候補をレビューする。

AIのアノテーターは、マスクの品質チェックやコンセプトのカバレッジの検証といったタスクにおいて、人間の精度に匹敵、あるいはそれを上回るように訓練されており、簡単なケースは除外される。人間が介入するのは、モデルがまだ苦戦する可能性のある、より困難な事例のみである。

このアプローチにより、Metaはアノテーション速度を大幅に向上させた。AIアノテーターに簡単なケースを処理させることで、パイプラインは、きめの細かいドメインにおいて、否定的なプロンプトでは約5倍、肯定的なプロンプトでは36%高速化する。

この効率性により、データセットを400万以上のユニークな概念に拡張することが可能になった。AIによる提案、人間による修正、モデル予測の更新の絶え間ないループは、時間の経過とともにラベルの質を向上させ、SAM 3が視覚的およびテキストベースの概念をより幅広く学習するのにも役立っている。

性能に関しては、SAM 3は以前のモデルよりも明らかに向上している。オープンボキャブラリーの概念検出とセグメンテーションを評価するMetaの新しいSA-Coベンチマークにおいて、SAM 3は画像とビデオの両方で、以前のシステムの約2倍の性能を達成した。

また、Point-to-MaskやMask-to-Maskletのような対話的な視覚タスクにおいても、SAM 2と同等かそれ以上の結果を示しています。Metaは、ゼロショットLVIS(モデルが訓練例なしで希少なカテゴリを認識しなければならない)やオブジェクトカウンティング(オブジェクトのすべてのインスタンスが検出されたかどうかを測定する)のような難しい評価でさらなる向上を報告しており、ドメインを超えたより強力な汎化を強調しています。

こうした精度の向上に加え、SAM 3は効率的で、H200GPU 上で、100個以上の物体が検出された画像を約30ミリ秒で処理し、ビデオ内の複数の物体を追跡する際にもほぼリアルタイムに近い速度を維持する。

SAM 3についての理解を深めたところで、高度なテキストガイド付き推論から科学研究、Meta社独自の製品まで、実際のアプリケーションでどのように使用されているかを見ていこう。

SAM 3は、Meta社がSAM 3エージェントと呼ぶ、より大きなマルチモーダル言語モデル内のツールとして使用することもできる。SAM 3に「象」のような短いフレーズを与える代わりに、エージェントはより複雑な質問をSAM 3が理解できるような小さなプロンプトに分割することができる。

例えば、ユーザーが "馬をコントロールし、誘導するために使用されるオブジェクトは何ですか?"と質問した場合、エージェントは様々な名詞句を試し、SAM 3に送り、どのマスクが意味をなすかをチェックする。そして、正しいオブジェクトを見つけるまで改良を続ける。

特別な推論データセットで訓練されなくても、SAM 3エージェントはReasonSegやOmniLabelのような複雑なテキストクエリ用に設計されたベンチマークで優れた性能を発揮する。これは、SAM 3が言語理解ときめ細かい視覚的セグメンテーションの両方を必要とするシステムをサポートできることを示している。

興味深いことに、SAM 3は、詳細な視覚的ラベルが重要な研究現場ですでに使用されている。MetaはConservation X LabsとOsa Conservationと協力して、10,000以上のカメラトラップ映像からなる野生動物モニタリングデータセット、SA-FARIを構築した。

すべてのフレームのすべての動物にボックスとセグメンテーションマスクのラベルが付けられ、手作業で注釈を付けるには非常に時間がかかる。同様に海洋研究においても、SAM 3はFathomNetやMBARIとともに、水中画像のインスタンスセグメンテーションマスクを作成し、新しい評価ベンチマークをサポートするために使用されている。

このようなデータセットは、科学者がビデオ映像をより効率的に分析し、通常スケールでtrack ことが困難な動物や生息地を研究するのに役立つ。また、研究者はこれらのリソースを利用して、種の同定、行動分析、自動化された生態系モニタリングのための独自のモデルを構築することもできる。

研究用途に加え、SAM 3はメタ社の消費者向け製品に新たな機能や使用例を提供している。ここでは、SAM 3がすでに統合されている方法のいくつかを垣間見ることができる:

SAM 3は、セグメンテーションのエキサイティングな進歩である。コンセプトセグメンテーション、オープンボキャブラリーテキストプロンプト、改良されたトラッキングが導入されています。画像とビデオの両方で顕著に強化されたパフォーマンスと、SAM 3Dの追加により、このモデルスイートは、ビジョンAI、クリエイティブツール、科学研究、実世界の製品に新たな可能性を開きます。

私たちのコミュニティに参加して、GitHubリポジトリを探索し、AIについてもっと発見してください。独自のビジョンAIプロジェクトを構築したい場合は、 ライセンスオプションをご覧ください。ヘルスケアにおけるAIや 小売業におけるビジョンAIのようなアプリケーションについては、ソリューションのページをご覧ください。