Meta AIのSegment Anything Model 2SAM 2)に潜入し、様々な業界でどのようなリアルタイムアプリケーションに利用できるかを理解しましょう。

Meta AIのSegment Anything Model 2SAM 2)に潜入し、様々な業界でどのようなリアルタイムアプリケーションに利用できるかを理解しましょう。

2024年7月29日、Meta AIはSegment Anything Modelの第2バージョン、SAM 2をリリースした。この新しいモデルは、画像と動画の両方において、どのピクセルが対象物に属するかをピンポイントで特定できる!最も優れている点は、このモデルがリアルタイムでビデオの全フレームにわたって一貫してオブジェクトを追跡できることだ。SAM 2は、ビデオ編集、ミックスド・リアリティ体験、コンピューター・ビジョン・システムのトレーニングのためのビジュアル・データのアノテーションの高速化など、エキサイティングな可能性を切り開きます。

海洋科学、衛星画像、医療などの分野で使用されてきたオリジナルのSAM成功に基づき、SAM 2は動きの速い物体や外観の変化などの課題に取り組んでいる。精度と効率が向上したことで、幅広い用途に使える万能ツールとなった。この記事では、SAM 2がどのような分野で応用できるのか、そしてなぜAIコミュニティにとって重要なのかに焦点を当てる。

Segment Anything Model 2は、画像と動画の両方でプロンプト可能なビジュアルセグメンテーション(PVS)をサポートする高度な基礎モデルです。PVSは、モデルが segmentまたは、ユーザーによって与えられた特定のプロンプトや入力に基づいて、画像や動画のさまざまな部分を識別する技術です。これらのプロンプトは、関心のある領域を強調するクリック、ボックス、またはマスクの形式をとることができる。そしてモデルは、指定された領域の輪郭を描くセグメンテーションマスクを生成する。

SAM 2は、オリジナルのSAM ベースに、画像セグメンテーションからビデオセグメンテーションへと拡張したアーキテクチャである。画像データとプロンプトを使用してセグメンテーションマスクを作成する、軽量のマスクデコーダーが特徴である。動画については、SAM 2はメモリシステムを導入し、前のフレームの情報を記憶することで、時間経過に伴う正確なトラッキングを実現している。メモリーシステムには、セグメンテーションされるオブジェクトの詳細を記憶し、呼び出すコンポーネントが含まれる。SAM 2はまた、オクルージョンを処理し、複数のフレームを通してオブジェクトをtrack し、いくつかの可能性のあるマスクを生成することで、あいまいなプロンプトを管理することができる。SAM 2の高度なアーキテクチャーは、静的な視覚環境でも動的な視覚環境でも高い能力を発揮する。

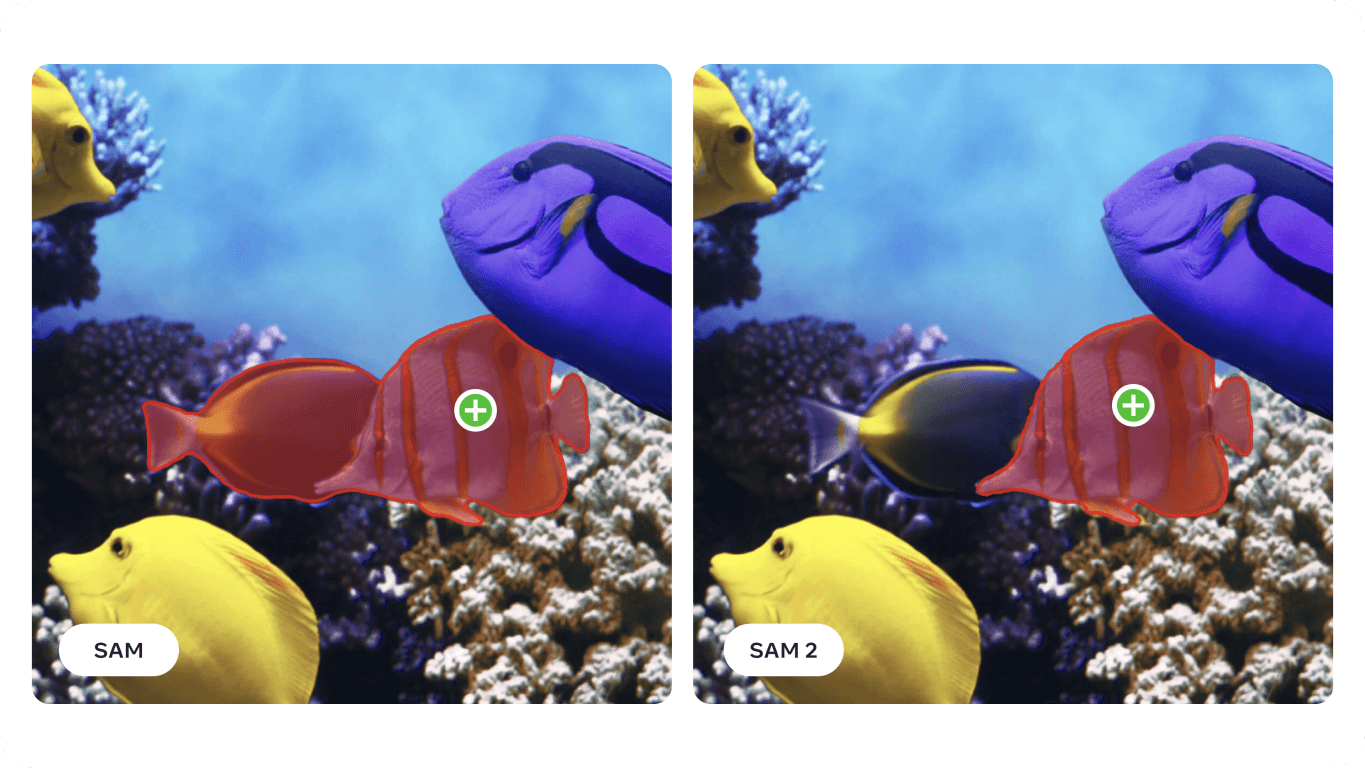

具体的には、ビデオセグメンテーションに関して、SAM 2は、以前の手法と比較して、3倍少ないユーザーインタラクションで高い精度を達成した。画像セグメンテーションに関しては、SAM 2 はオリジナルのSegment Anything Model (SAM) を凌駕し、6 倍高速かつ高精度である。この改善は、SAM 2の研究論文で、SAM 以前にテストされた23のデータセットを含む、37の異なるデータセットにわたって紹介されています。

興味深いことに、Meta AIのSAM 2は、これまでで最大のビデオ・セグメンテーション・データセットであるSA-Vデータセットを作成することによって開発された。この膨大なデータセットには、50,000以上の動画と3,550万以上のセグメンテーションマスクが含まれ、インタラクティブなユーザー投稿によって収集された。アノテーターは、多種多様なシナリオとオブジェクトタイプからモデルが学習するのを助けるために、プロンプトと修正を提供した。

画像とビデオのセグメンテーションにおける高度な機能のおかげで、SAM 2は様々な業界で使用できる。これらのアプリケーションのいくつかを見てみよう。

Meta AIの新しいセグメンテーションモデルは、拡張現実(AR)や仮想現実(VR)アプリケーションに使用できる。例えば、SAM 2は、現実世界のオブジェクトを正確に識別してsegment し、仮想オブジェクトとのインタラクションをよりリアルに感じさせることができる。ゲーム、教育、トレーニングなど、仮想と現実の要素間のリアルな相互作用が不可欠な様々な分野で役立つ。

ARグラスのようなデバイスがより進化するにつれて、SAM 2の機能がそれらに統合される日も近いかもしれない。 メガネをかけてリビングルームを見渡すことを想像してみてほしい。メガネがsegment 犬の水飲み器に気づいたら、下の画像のように水を補充するよう促してくれるかもしれない。あるいは、あなたが新しいレシピを調理している場合、メガネはカウンタートップにある材料を識別し、ステップ・バイ・ステップの手順やヒントを提供することができる。

モデルSAM 使用した研究は、ソナーイメージングのような特殊な領域にも適用できることを示している。ソナー画像は、解像度が低く、ノイズレベルが高く、画像内の物体の形状が複雑であるため、ユニークな課題を伴う。ソナー画像用にSAM 微調整することで、研究者たちは、海洋ゴミ、地層、その他の関心事項など、さまざまな水中物体を正確にsegment する能力を実証した。正確で信頼性の高い水中画像は、海洋研究、水中考古学、漁業管理、生息地のマッピング、人工物の発見、脅威の検出などのタスクのための監視に使用することができます。

%25252525201.png)

SAM 2は、SAM 直面している多くの課題を基に改良されたものであるため、ソナー・イメージングの解析をさらに向上させる可能性を秘めている。その正確なセグメンテーション能力は、科学研究や漁業を含む様々な海洋アプリケーションを支援することができる。例えば、SAM 2は、水中構造物の輪郭を効果的に描き、海洋ゴミをdetect し、前方探査ソナー画像内の物体を識別することができ、より正確で効率的な水中探査とモニタリングに貢献する。

ソナーイメージングの解析にSAM 2を使用する潜在的な利点は以下の通りである:

SAM 2をソナー・イメージング・プロセスに統合することで、海洋産業は水中探査と分析において、より高い効率、精度、信頼性を達成することができ、最終的には海洋研究においてより良い結果を導くことができる。

SAM 2のもう一つの応用は自律走行車だ。SAM 2は、歩行者、他の車両、道路標識、障害物などのオブジェクトをリアルタイムで正確に識別することができる。SAM 2が提供できる詳細なレベルは、安全なナビゲーションや衝突回避の判断に不可欠である。視覚データを正確に処理することで、SAM 2は詳細で信頼性の高い環境地図を作成し、より良い意思決定につながります。

SAM 2は、さまざまな照明条件、天候の変化、ダイナミックな環境でもうまく機能する能力を持っているため、自律走行車にとって信頼できるものとなっている。交通量の多い都会の通りであろうと霧の高速道路であろうと、SAM 2は一貫して物体を正確に識別し、segment ことができるため、車両はさまざまな状況に正しく対応することができる。

しかし、留意すべき限界もある。複雑で動きの速い物体に対しては、SAM 2は細かいディテールを見逃すことがあり、フレーム間で予測が不安定になることがある。また、SAM 2は、混雑したシーンで複数の似たような物体を混同することがある。このような課題があるため、自律走行アプリケーションでは、追加のセンサーとテクノロジーの統合が極めて重要なのだ。

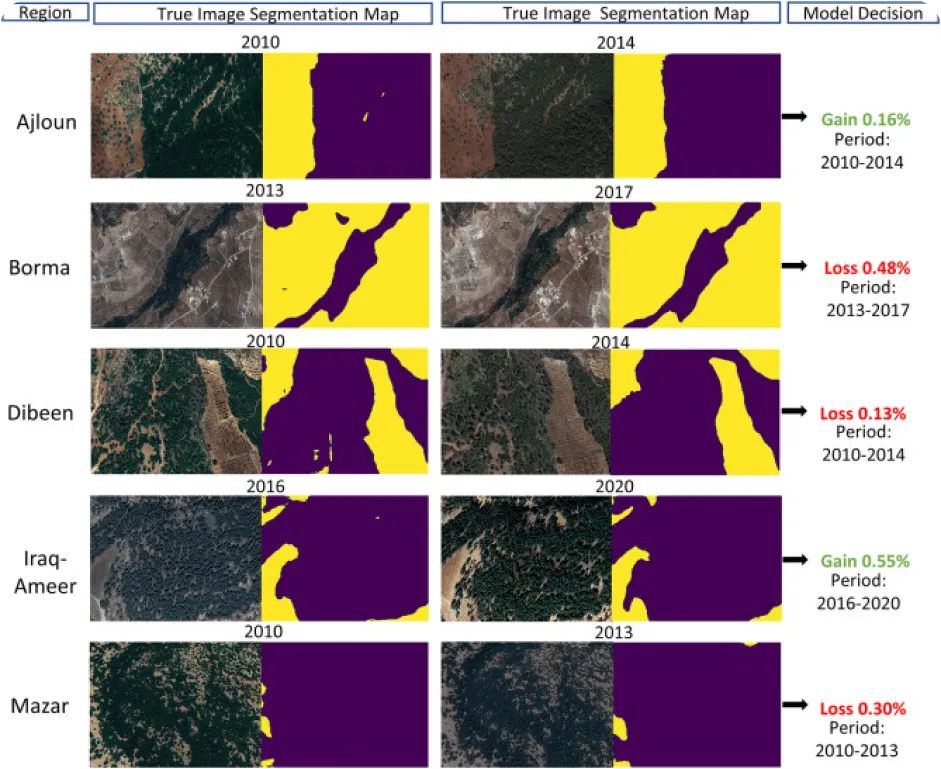

コンピュータービジョンを使った環境モニタリングは、特に注釈付きデータが不足している場合には厄介なものだが、それこそがSAM 2の興味深い用途でもある。SAM 2は、衛星画像やドローン画像から、森林、水域、都市部、農地など様々な環境特徴を正確にセグメント化し識別することで、自然景観の変化をtrack ・分析するために使用できる。特に、正確なセグメンテーションは、森林伐採、都市化、土地利用の経年変化を監視し、環境保全や計画立案に貴重なデータを提供するのに役立つ。

SAM 2のようなモデルを使用して経年的な環境変化を分析する利点は以下の通りである:

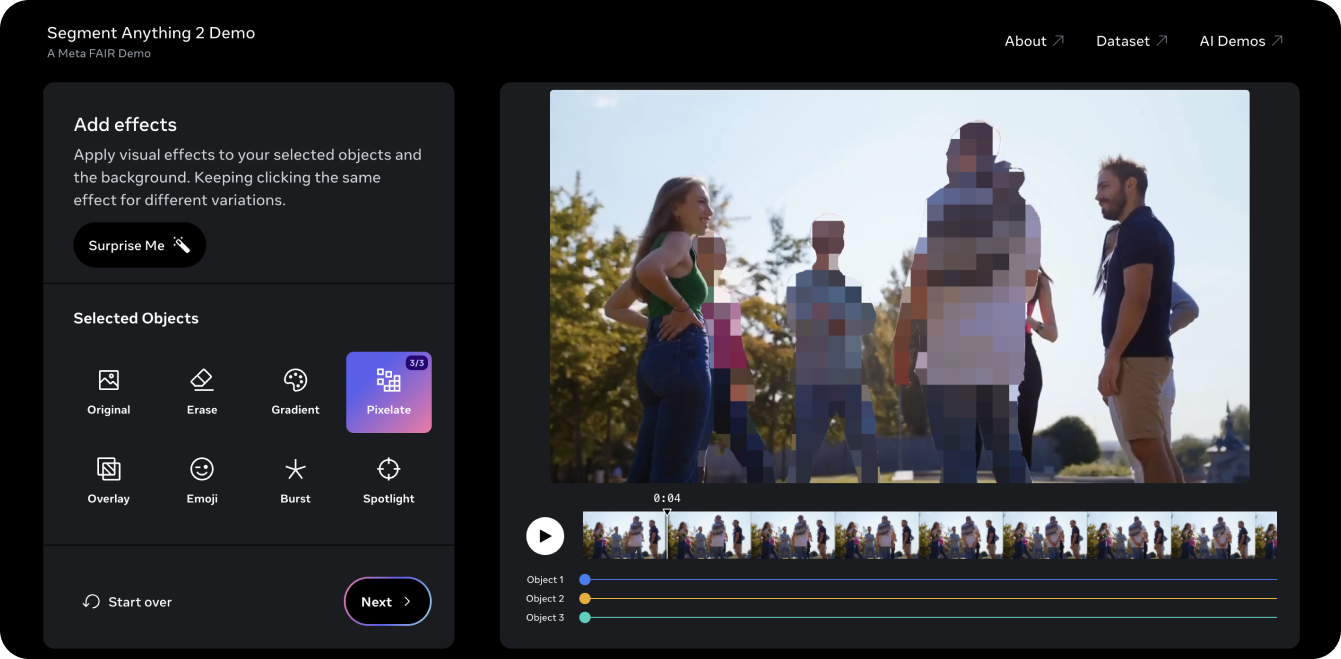

Segment Anything 2 Demoは、ビデオでモデルを試すのに最適な方法です。SAM 2のPVS機能を使って、古いUltralytics YouTubeビデオを撮影し、ビデオ内の3つのオブジェクトまたは人物をsegment し、ピクセル化することができました。従来、このような動画から3人の人物を編集するには、時間と手間がかかり、フレームごとに手作業でマスキングする必要がありました。しかし、SAM 2はこのプロセスを簡素化します。デモを数回クリックするだけで、興味のある3つのオブジェクトのアイデンティティを数秒で保護することができます。

デモでは、トラッキングのために選択したオブジェクトにスポットライトを当てたり、トラッキングされているオブジェクトを消したりといった、いくつかの異なる視覚効果を試すこともできます。デモが気に入り、SAM 2を使ったイノベーションを始める準備ができたら、Ultralytics SAM 2モデルのドキュメントページで、モデルを実際に使うための詳しい説明をご覧ください。SAM 2の機能、インストール手順、使用例をご覧になり、SAM 2の可能性をプロジェクトで十分にご活用ください!

Meta AIのSegment Anything Model 2SAM 2)は、ビデオや画像のセグメンテーションに変革をもたらします。オブジェクトトラッキングのようなタスクが改善されるにつれて、我々はビデオ編集、複合現実、科学研究、医療画像において新たな機会を発見している。複雑なタスクを容易にし、アノテーションを高速化することで、SAM 2はAIコミュニティにとって重要なツールになる準備が整っています。私たちがSAM 2のようなモデルを探求し、革新し続けることで、様々な分野での画期的な応用や進歩がさらに期待できる!

GitHubリポジトリを探索し、コミュニティに参加して、AIについてもっと知りましょう。製造業およびヘルスケアにおけるAIの詳細な洞察については、ソリューションページをご覧ください。🚀