Khám phá SAM 3: Mô hình Segment Anything mới của Meta AI

Tìm hiểu cách SAM 3, Mô hình Phân khúc Bất kỳ mới của Meta AI giúp bạn dễ dàng detect , segment , Và track các đối tượng trên hình ảnh và video thực tế.

Tìm hiểu cách SAM 3, Mô hình Phân khúc Bất kỳ mới của Meta AI giúp bạn dễ dàng detect , segment , Và track các đối tượng trên hình ảnh và video thực tế.

Vào ngày 19 tháng 11 năm 2025, Meta AI đã phát hành Segment Anything Model 3 , còn được gọi là SAM 3. Phiên bản mới nhất của Mô hình Phân khúc Bất kỳ này giới thiệu những cách mới để detect , segment , Và track các đối tượng trong hình ảnh và video thực tế bằng cách sử dụng lời nhắc văn bản, lời nhắc trực quan và ví dụ hình ảnh.

Các SAM Mô hình SAM 3 được xây dựng dựa trên SAM và SAM 2 , mang đến những cải tiến và tính năng mới như phân đoạn khái niệm, phát hiện từ vựng mở và theo dõi video theo thời gian thực. Nó có thể hiểu các cụm danh từ ngắn, theo dõi đối tượng trên nhiều khung hình và nhận diện các khái niệm chi tiết hoặc hiếm mà các mô hình trước đó không thể xử lý một cách nhất quán.

Là một phần của SAM Phiên bản 3.0.3, Meta cũng giới thiệu SAM 3D . Bộ mô hình thế hệ tiếp theo này tái tạo các vật thể, cảnh và toàn bộ cơ thể người từ một hình ảnh duy nhất và mở rộng hệ sinh thái Segment Anything sang lĩnh vực 3D . Những bổ sung này mở ra các ứng dụng mới trong thị giác máy tính , robot, chỉnh sửa phương tiện và quy trình làm việc sáng tạo.

Trong bài viết này, chúng ta sẽ khám phá những gì SAM 3 là, điều gì làm cho nó khác biệt với SAM 2, cách thức hoạt động của mô hình và ứng dụng thực tế của nó. Hãy bắt đầu thôi!

SAM 3 là một mô hình thị giác máy tính hiện đại có thể xác định, phân tách và track các đối tượng trong hình ảnh và video dựa trên các hướng dẫn đơn giản. Thay vì dựa vào danh sách nhãn cố định, SAM 3 hiểu được ngôn ngữ tự nhiên và tín hiệu trực quan, giúp bạn dễ dàng cho mô hình biết bạn muốn tìm gì.

Ví dụ, với SAM 3, bạn có thể nhập một cụm từ ngắn như "xe buýt trường học màu vàng" hoặc "mèo sọc", nhấp vào một đối tượng hoặc tô sáng một ví dụ trong hình ảnh. Sau đó, mô hình sẽ detect mọi đối tượng phù hợp và tạo ra mặt nạ phân đoạn rõ ràng (một phác thảo trực quan hiển thị chính xác những điểm ảnh nào thuộc về một đối tượng). SAM 3 cũng có thể theo dõi các đối tượng đó trên các khung hình video, giữ cho chúng nhất quán khi di chuyển.

Một phần thú vị khác trong thông báo của Meta AI là SAM 3D, mở rộng dự án Segment Anything thành hiểu biết về 3D . SAM Công nghệ 3D có thể sử dụng một hình ảnh 2D duy nhất để tái tạo hình dạng, tư thế hoặc cấu trúc của một vật thể hoặc cơ thể người trong không gian ba chiều. Nói cách khác, mô hình có thể ước tính vị trí của một vật thể ngay cả khi chỉ có một góc nhìn.

SAM 3D đã được phát hành dưới dạng hai mô hình khác nhau: SAM Đối tượng 3D, tái tạo các vật dụng hàng ngày bằng hình học và kết cấu, và SAM Cơ thể 3D, ước tính hình dạng và tư thế cơ thể người từ một hình ảnh duy nhất. Cả hai mô hình đều sử dụng kết quả phân đoạn từ SAM 3 và sau đó tạo ra hình ảnh 3D phù hợp với hình dáng và vị trí của vật thể trong ảnh gốc.

Sau đây là một số cập nhật quan trọng SAM 3 giới thiệu cách kết hợp phát hiện, phân đoạn và theo dõi thành một mô hình thống nhất:

Giả sử bạn đang xem một video về chuyến đi săn với nhiều loài động vật khác nhau và bạn muốn detect Và segment chỉ có voi. Nhiệm vụ này sẽ như thế nào trong các phiên bản khác nhau của SAM ?

Với SAM , bạn sẽ cần phải nhấp thủ công vào từng con voi trong mỗi khung hình để tạo mặt nạ phân đoạn. Không có tính năng theo dõi, vì vậy mỗi khung hình mới đều cần nhấp chuột mới.

Với SAM 2, bạn có thể nhấp một lần vào một con voi, lấy mặt nạ của nó và mô hình sẽ track cùng một con voi đó qua video. Tuy nhiên, bạn vẫn cần phải cung cấp các cú nhấp chuột riêng biệt nếu bạn muốn segment nhiều con voi (vật thể cụ thể), vì SAM 2 không hiểu được các phạm trù như “voi”.

Với SAM 3, quy trình làm việc trở nên đơn giản hơn nhiều. Bạn có thể nhập "voi" hoặc vẽ một khung giới hạn xung quanh một con voi để làm ví dụ, và mô hình sẽ tự động tìm thấy mọi con voi trong video. segment họ, và track chúng nhất quán trên các khung hình. Nó vẫn hỗ trợ các lời nhắc nhấp và hộp được sử dụng trong các phiên bản trước, nhưng giờ đây nó cũng có thể phản hồi các lời nhắc văn bản và hình ảnh mẫu, đó là điều gì đó SAM Và SAM 2 không thể làm được.

Tiếp theo, chúng ta hãy xem xét kỹ hơn cách SAM 3 mô hình hoạt động và cách thức đào tạo.

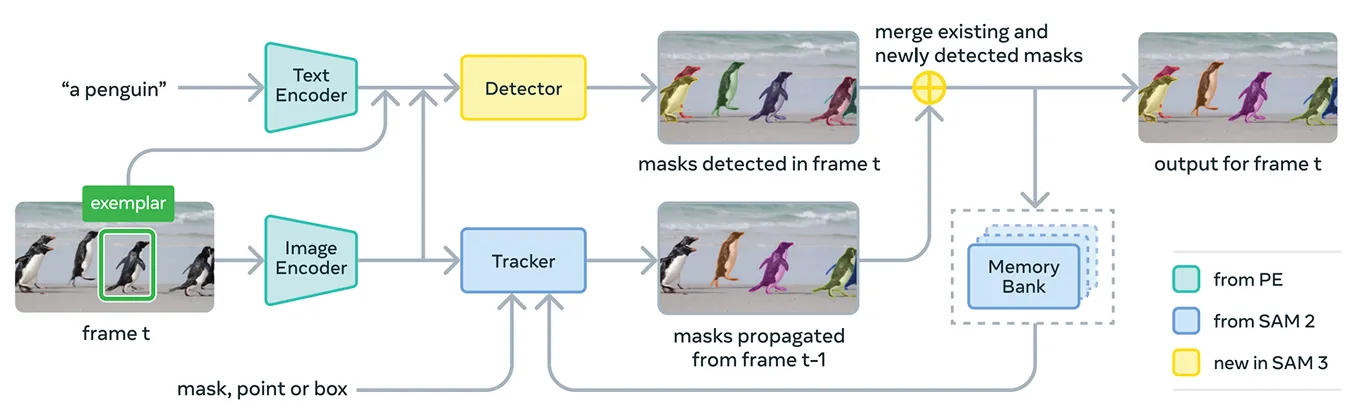

SAM 3 kết hợp nhiều thành phần lại với nhau để hỗ trợ các gợi ý khái niệm và gợi ý trực quan trong một hệ thống duy nhất. Về cơ bản, mô hình này sử dụng Meta Perception Encoder, một bộ mã hóa hình ảnh-văn bản mã nguồn mở thống nhất của Meta.

Bộ mã hóa này có thể xử lý cả hình ảnh và cụm danh từ ngắn. Nói một cách đơn giản, điều này cho phép SAM 3 để liên kết ngôn ngữ và các tính năng trực quan hiệu quả hơn so với các phiên bản trước của Mô hình phân đoạn bất kỳ.

Trên đầu bộ mã hóa này, SAM 3 bao gồm một bộ phát hiện dựa trên dòng mô hình máy biến áp DETR. Bộ phát hiện này nhận dạng các vật thể trong ảnh và giúp hệ thống xác định vật thể nào tương ứng với lời nhắc của người dùng.

Cụ thể, đối với phân đoạn video, SAM 3 sử dụng một thành phần theo dõi được xây dựng trên ngân hàng bộ nhớ và bộ mã hóa bộ nhớ từ SAM 2. Điều này cho phép mô hình lưu giữ thông tin về các đối tượng trên các khung hình để có thể xác định lại và track chúng theo thời gian.

Để đào tạo SAM 3. Meta cần nhiều dữ liệu được chú thích hơn nhiều so với những gì hiện có trên internet. Mặt nạ phân đoạn và nhãn văn bản chất lượng cao rất khó tạo ở quy mô lớn, và việc phác thảo đầy đủ mọi trường hợp của một khái niệm trong hình ảnh và video rất chậm và tốn kém.

Để giải quyết vấn đề này, Meta đã xây dựng một công cụ dữ liệu mới kết hợp SAM 3, các mô hình AI bổ sung và các chú thích viên làm việc cùng nhau. Quy trình làm việc bắt đầu với một chuỗi các hệ thống AI, bao gồm SAM 3 và mô hình chú thích dựa trên Llama .

Các hệ thống này quét các bộ sưu tập hình ảnh và video lớn, tạo chú thích, chuyển đổi các chú thích đó thành nhãn văn bản và tạo ra các ứng viên mặt nạ phân đoạn sớm. Sau đó, các chú thích viên là con người và AI sẽ xem xét các ứng viên này.

Các chú thích viên AI, được đào tạo để đạt được độ chính xác ngang bằng hoặc thậm chí vượt trội hơn con người trong các nhiệm vụ như kiểm tra chất lượng khẩu trang và xác minh phạm vi khái niệm, sẽ lọc ra những trường hợp đơn giản. Con người chỉ can thiệp vào những ví dụ khó hơn mà mô hình có thể vẫn gặp khó khăn.

Cách tiếp cận này giúp Meta tăng tốc đáng kể tốc độ chú thích. Bằng cách để AI xử lý các trường hợp dễ dàng, quy trình xử lý sẽ nhanh hơn khoảng năm lần đối với các lời nhắc tiêu cực và nhanh hơn 36% đối với các lời nhắc tích cực trong các miền chi tiết.

Hiệu quả này cho phép mở rộng tập dữ liệu lên hơn bốn triệu khái niệm độc đáo. Vòng lặp liên tục của các đề xuất AI, hiệu chỉnh của con người và dự đoán mô hình được cập nhật cũng cải thiện chất lượng nhãn theo thời gian và giúp SAM 3. Học một tập hợp rộng hơn nhiều các khái niệm trực quan và dựa trên văn bản.

Về mặt hiệu suất, SAM Phiên bản 3 mang lại sự cải tiến rõ rệt so với các mô hình trước đó. Trên chuẩn SA-Co mới của Meta, đánh giá khả năng phát hiện và phân đoạn khái niệm từ vựng mở, SAM 3 đạt hiệu suất gấp đôi so với các hệ thống trước đây về cả hình ảnh và video.

Nó cũng phù hợp hoặc vượt quá SAM 2 về các tác vụ trực quan tương tác như điểm-đến-mặt nạ và mặt nạ-đến-mặt nạ con. Meta báo cáo những cải tiến bổ sung trong các bài đánh giá khó hơn như LVIS zero-shot (trong đó các mô hình phải nhận dạng các danh mục hiếm mà không cần ví dụ huấn luyện) và đếm đối tượng (đo lường xem tất cả các trường hợp của một đối tượng có được phát hiện hay không), làm nổi bật khả năng khái quát hóa mạnh mẽ hơn trên nhiều lĩnh vực.

Ngoài những cải tiến về độ chính xác này, SAM 3 là hiệu quả, xử lý hình ảnh với hơn 100 đối tượng được phát hiện trong khoảng 30 mili giây trên H200 GPU và duy trì tốc độ gần như thời gian thực khi theo dõi nhiều đối tượng trong video.

Bây giờ chúng ta đã hiểu rõ hơn về SAM 3, chúng ta hãy cùng tìm hiểu cách thức sử dụng nó trong các ứng dụng thực tế, từ lý luận hướng dẫn bằng văn bản nâng cao đến nghiên cứu khoa học và các sản phẩm riêng của Meta.

SAM 3 cũng có thể được sử dụng như một công cụ bên trong một mô hình ngôn ngữ đa phương thức lớn hơn, mà Meta gọi là SAM 3. Đại lý. Thay vì đưa ra SAM 3 một cụm từ ngắn như "con voi", tác nhân có thể chia một câu hỏi phức tạp hơn thành các câu hỏi nhỏ hơn SAM 3 hiểu.

Ví dụ, nếu người dùng hỏi, "Vật thể nào trong hình được sử dụng để điều khiển và hướng dẫn một con ngựa?", tác nhân sẽ thử các cụm danh từ khác nhau, gửi chúng đến SAM 3, và kiểm tra xem mặt nạ nào có ý nghĩa. Nó tiếp tục tinh chỉnh cho đến khi tìm thấy đúng đối tượng.

Ngay cả khi không được đào tạo về các tập dữ liệu lý luận đặc biệt, SAM 3 Agent hoạt động tốt trên các điểm chuẩn được thiết kế cho các truy vấn văn bản phức tạp, chẳng hạn như ReasonSeg và OmniLabel. Điều này cho thấy SAM 3 có thể hỗ trợ các hệ thống cần cả khả năng hiểu ngôn ngữ và phân đoạn hình ảnh chi tiết.

Thật thú vị, SAM 3 đã được sử dụng trong các bối cảnh nghiên cứu, nơi mà nhãn trực quan chi tiết rất quan trọng. Meta đã hợp tác với Conservation X Labs và Osa Conservation để xây dựng SA-FARI, một bộ dữ liệu giám sát động vật hoang dã công cộng với hơn 10.000 video từ bẫy ảnh.

Mỗi loài động vật trong mỗi khung hình đều được dán nhãn bằng hộp và mặt nạ phân đoạn, một việc sẽ cực kỳ tốn thời gian nếu chú thích bằng tay. Tương tự, trong nghiên cứu đại dương, SAM 3 đang được sử dụng cùng với FathomNet và MBARI để tạo mặt nạ phân đoạn trường hợp cho hình ảnh dưới nước và hỗ trợ các tiêu chuẩn đánh giá mới.

Các tập dữ liệu như vậy giúp các nhà khoa học phân tích cảnh quay video hiệu quả hơn và nghiên cứu các loài động vật và môi trường sống thường khó tiếp cận. track ở quy mô lớn. Các nhà nghiên cứu cũng có thể sử dụng các nguồn lực này để xây dựng mô hình riêng của họ nhằm nhận dạng loài, phân tích hành vi và giám sát sinh thái tự động.

Ngoài mục đích nghiên cứu, SAM 3 cũng đang hỗ trợ các tính năng và trường hợp sử dụng mới trên các sản phẩm tiêu dùng của Meta. Dưới đây là một số cách mà Meta đã và đang được tích hợp:

SAM Phiên bản 3 là một bước tiến đáng chú ý trong lĩnh vực phân đoạn. Phiên bản này giới thiệu khả năng phân đoạn khái niệm, gợi ý văn bản từ vựng mở và cải thiện khả năng theo dõi. Với hiệu suất mạnh mẽ hơn đáng kể trên cả hình ảnh và video, cùng với việc bổ sung SAM Bộ mô hình 3D mở ra những khả năng mới cho Vision AI, các công cụ sáng tạo, nghiên cứu khoa học và các sản phẩm thực tế.

Tham gia cộng đồng của chúng tôi và khám phá kho lưu trữ GitHub để tìm hiểu thêm về AI. Nếu bạn đang muốn xây dựng dự án Vision AI của riêng mình, hãy xem qua các tùy chọn cấp phép của chúng tôi. Khám phá thêm về các ứng dụng như AI trong chăm sóc sức khỏe và Vision AI trong bán lẻ bằng cách truy cập trang giải pháp của chúng tôi.