効率的なエッジAI、AIアクセラレーション、リアルタイム物体検出のためのRKNNツールキットを使用して、Rockchip上でUltralytics YOLO11 展開する方法をご覧ください。

効率的なエッジAI、AIアクセラレーション、リアルタイム物体検出のためのRKNNツールキットを使用して、Rockchip上でUltralytics YOLO11 展開する方法をご覧ください。

AIコミュニティで最近話題になっているのは、特にコンピュータビジョンにおけるエッジAIです。AI駆動型アプリケーションの成長に伴い、電力とコンピューティングリソースが限られた組み込みデバイス上でモデルを効率的に実行する必要性が高まっています。

例えば、ドローンはリアルタイムのナビゲーションにVision AIを使用し、スマートカメラは物体を瞬時にdetect し、産業オートメーションシステムはクラウドコンピューティングに依存することなく品質管理を行う。これらのアプリケーションでは、リアルタイムのパフォーマンスと低レイテンシーを確保するために、エッジ・デバイス上で直接、高速で効率的なAI処理が必要です。しかし、エッジ・デバイス上でAIモデルを実行することは必ずしも容易ではありません。AIモデルは多くの場合、多くのエッジ・デバイスが処理できる以上の電力とメモリを必要とします。

Rockchip社のRKNNツールキットは、ディープラーニングモデルをRockchip社製デバイス向けに最適化することで、この問題を解決します。専用のニューラル・プロセッシング・ユニット(NPU)を使用して推論を高速化し、CPU GPU 処理に比べてレイテンシーと消費電力を削減します。

ビジョンAIのコミュニティは Ultralytics YOLO11をRockchipベースのデバイスで実行することを熱望してきました。私たちは、 YOLO11 RKNNモデル形式にエクスポートするサポートを追加しました。この記事では、RKNNへのエクスポートがどのように機能するのか、そしてなぜRockchip搭載デバイスにYOLO11 展開することが画期的なことなのかを探ります。

Rockchip社はシステムオンチップ(SoC)を設計する会社である。これらのチップは、CPU、GPU、およびニューラル・プロセッシング・ユニット(NPU)を組み合わせ、一般的なコンピューティング・タスクから、物体検出や画像処理に依存するビジョンAIアプリケーションまで、あらゆるものを処理する。

Rockchip SoCは、シングルボードコンピュータ(SBC)、開発ボード、産業用AIシステム、スマートカメラなど、さまざまなデバイスで使用されています。多くの有名なハードウェアメーカー(Radxa、ASUS、Pine64、Orange Pi、Odroid、Khadas、Banana Pi)が、Rockchip SoCを搭載したデバイスを構築しています。これらのボードは、パフォーマンス、電力効率、および手頃な価格のバランスが取れているため、エッジAIおよびコンピュータビジョンアプリケーションで人気があります。

AIモデルがこれらのデバイス上で効率的に実行できるように、RockchipはRKNN(Rockchip Neural Network)ツールキットを提供しています。これにより、開発者は深層学習モデルを変換および最適化して、Rockchipのニューラルプロセッシングユニット(NPU)を使用できます。

RKNNモデルは、低遅延推論と効率的な電力使用のために最適化されています。モデルをRKNNに変換することで、開発者はRockchip搭載デバイス上でより高速な処理速度、低消費電力、および改善された効率を実現できます。

RKNNモデルがRockchip搭載デバイスでAIパフォーマンスをどのように向上させるかについて詳しく見ていきましょう。

広範なコンピューティングタスクを処理するCPUやGPUとは異なり、RockchipのNPUは深層学習に特化して設計されています。AIモデルをRKNN形式に変換することで、開発者はNPU上で直接推論を実行できます。これにより、RKNNモデルは、迅速かつ効率的な処理が不可欠なリアルタイムのコンピュータビジョンタスクに特に役立ちます。

NPUは、ニューラルネットワークの計算を並行して処理するように構築されているため、AIタスクにおいてCPUやGPUよりも高速かつ効率的です。CPUはタスクを一度に1ステップずつ処理し、GPUはワークロードを複数のコアに分散しますが、NPUはAI固有の計算をより効率的に実行するように最適化されています。

その結果、RKNNモデルはより高速に動作し、消費電力が少なくなるため、バッテリ駆動デバイス、スマートカメラ、産業オートメーション、およびリアルタイムの意思決定を必要とするその他のエッジAIアプリケーションに最適です。

Ultralytics YOLO Only Look Once)モデルは、物体検出、インスタンス分割、画像分類などのリアルタイムコンピュータビジョンタスク用に設計されています。スピード、精度、効率性で知られ、農業、製造、ヘルスケア、自律システムなどの業界で広く使用されています。

これらのモデルは、時間の経過とともに大幅に改善されてきた。例えば、Ultralytics YOLOv5はオブジェクト検出をPyTorch使いやすくした。その後、Ultralytics YOLOv8は、ポーズ推定や画像分類などの新機能を追加した。そして今、YOLO11 11は、より少ないリソースで精度を高めることで、さらに進化している。実際、YOLO11mはCOCO データセットにおいて、YOLOv8m22%少ないパラメータでより優れた性能を発揮し、より正確で効率的なものになっています。

Ultralytics YOLO モデルは、複数のフォーマットへのエクスポートもサポートしており、異なるプラットフォームへの柔軟な展開が可能です。これらのフォーマットには、ONNX、TensorRT、CoreML、OpenVINO含まれ、開発者は、ターゲットとするハードウェアに基づいて性能を最適化する自由を得ることができます。

YOLO11 RKNNモデル形式へのエクスポートがサポートされたことで、YOLO11 Rockchip社のNPUを活用できるようになりました。最小モデルであるRKNN形式のYOLO11nは、1画像あたり99.5msという驚異的な推論時間を達成し、組み込み機器でもリアルタイム処理が可能です。

現在、YOLO11 物体検出モデルは、RKNNフォーマットにエクスポートできます。また、今後のアップデートで、他のコンピュータビジョンタスクとINT8量子化のサポートを追加する予定です。

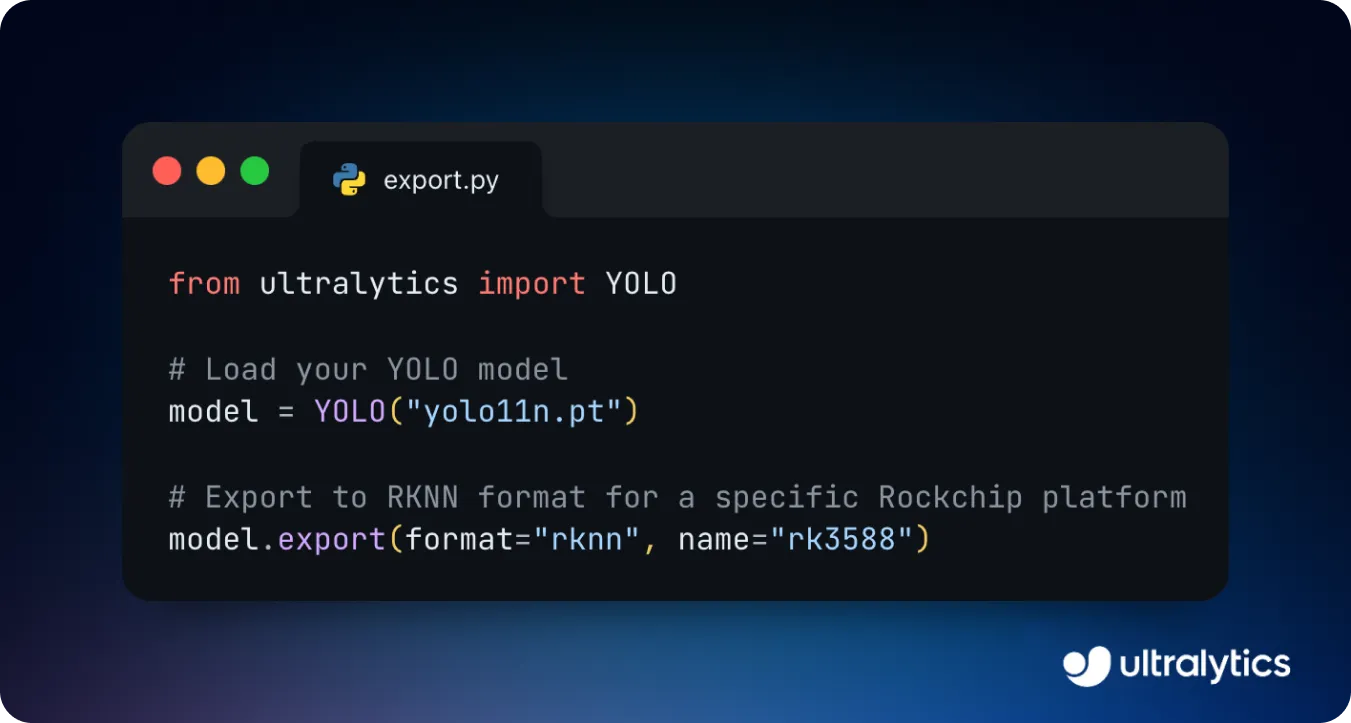

YOLO11 RKNNフォーマットへのエクスポートは簡単なプロセスです。カスタム学習した YOLO11 モデルをロードし、ターゲットRockchipプラットフォームを指定し、数行のコードでRKNN形式に変換できます。RKNNフォーマットは、RK3588、RK3566、RK3576など、さまざまなRockchip SoCと互換性があり、幅広いハードウェア・サポートを保証します。

一度エクスポートされたRKNNモデルは、Rockchipベースのデバイスに展開することができます。モデルを展開するには、エクスポートしたRKNNファイルをRockchipデバイスにロードし、推論を実行するだけです。推論は、学習済みのAIモデルを使用して新しい画像やビデオを分析し、リアルタイムでオブジェクトをdetect するプロセスです。わずか数行のコードで、画像やビデオストリームからオブジェクトの識別を開始できます。

YOLO11 実世界のRockchip対応デバイスでどのように展開できるかを知るために、主要なエッジAIアプリケーションをいくつか見てみよう。

Rockchipプロセッサは、Androidタブレット、開発ボード、産業用AIシステムに広く使用されています。Android、Linux、Pythonサポートしているため、さまざまな業界向けのVision AI主導型ソリューションを簡単に構築、展開できます。

Rockchip搭載デバイスでYOLO11 実行する一般的なアプリケーションは、堅牢なタブレットです。これらのタブレットは、倉庫、建設現場、工業環境などの厳しい環境向けに設計された耐久性のある高性能タブレットです。これらのタブレットは、物体検出を活用して効率と安全性を向上させることができます。

例えば、倉庫物流では、作業員がYOLO11 搭載のRockchip社製タブレットを使って在庫を自動スキャン・detect することで、人的ミスを減らし、処理時間を短縮することができる。同様に、建設現場では、このタブレットを使って作業員がヘルメットやベストなど必要な安全装備を着用しているかどうかをdetect し、企業が規制を強化したり事故を防止したりするのに役立てることができる。

製造および自動化に関して言えば、Rockchipを搭載した産業用ボードは、品質管理およびプロセス監視において大きな役割を果たすことができます。産業用ボードは、産業環境における組み込みシステム向けに設計された、コンパクトで高性能なコンピューティングモジュールです。これらのボードには通常、プロセッサ、メモリ、I/Oインターフェース、およびセンサー、カメラ、自動機械と統合できる接続オプションが含まれています。

これらのボード上でYOLO11 モデルを実行することで、生産ラインをリアルタイムで分析し、問題を即座に発見して効率を向上させることが可能になる。例えば、自動車製造では、RockchipハードウェアとYOLO11 使用したAIシステムは、自動車が組立ラインを移動する際に、傷、ずれた部品、塗装の欠陥をdetect ことができます。これらの欠陥をリアルタイムで特定することで、メーカーは無駄を省き、生産コストを削減し、自動車が顧客に届く前に、より高い品質基準を確保することができる。

Rockchipベースのデバイスは、性能、コスト、効率のバランスが良く、エッジAIアプリケーションにYOLO11 導入するのに最適な選択肢となる。

RockchipベースのデバイスでYOLO11 実行する利点は以下の通りである:

Ultralytics YOLO11 、ハードウェアアクセラレーションとRKNNフォーマットを活用することで、Rockchipベースのデバイス上で効率的に実行できます。これにより推論時間が短縮され、パフォーマンスが向上するため、リアルタイムのコンピューター・ビジョン・タスクやエッジAIアプリケーションに最適です。

RKNNツールキットは、量子化や微調整などの主要な最適化ツールを提供し、YOLO11 モデルがRockchipプラットフォーム上で良好に動作することを保証します。効率的なオンデバイス処理のためのモデルの最適化は、エッジAIの採用が拡大するにつれて不可欠となります。適切なツールとハードウェアがあれば、開発者はさまざまな産業におけるコンピュータビジョンソリューションの新たな可能性を解き放つことができます。

コミュニティに参加し、GitHubリポジトリを調べて、AIの詳細をご覧ください。農業におけるコンピュータビジョンとヘルスケアにおけるAIがソリューションページを訪問してどのようにイノベーションを推進しているかをご覧ください。また、ライセンスオプションをチェックして、今すぐVision AIソリューションの構築を開始してください。