バギング、ブースティング、スタッキングなどのテクニックによってAIモデルのパフォーマンスを向上させ、より正確で安定した予測を実現するアンサンブル学習をご覧ください。

バギング、ブースティング、スタッキングなどのテクニックによってAIモデルのパフォーマンスを向上させ、より正確で安定した予測を実現するアンサンブル学習をご覧ください。

この記事で取り上げた概念の視覚的な解説については、以下の動画をご覧ください。

レコメンデーション・エンジンや不正検知システムのようなAIイノベーションは、データに基づいて予測や意思決定を行う機械学習アルゴリズムやモデルに依存している。これらのモデルは、パターンを特定し、傾向を予測し、複雑なタスクの自動化を支援することができる。

しかし、単一のモデルでは、実世界のデータに含まれるすべての詳細を把握することは難しい。例えば、不正検出モデルが新しいタイプのトランザクションを見逃すといったように、あるケースではうまく機能しても、他のケースではうまく機能しないこともある。

この限界は、AIエンジニアが機械学習モデルを構築・展開する際にしばしば直面するものだ。モデルによっては、学習データを忠実に学習しすぎて過剰適合するものもあれば、重要なパターンを見逃して過小適合するものもある。アンサンブル学習は、ベース学習者として知られる複数のモデルを、より強力な単一のシステムに組み合わせることで、こうした課題に対処するのに役立つAI技術だ。

それは、問題を解決するために協力し合う専門家のチームのようなものだと考えることができる。この記事では、アンサンブル学習とは何か、どのように機能するのか、そしてどのような場面で活用できるのかを探る。始めよう!

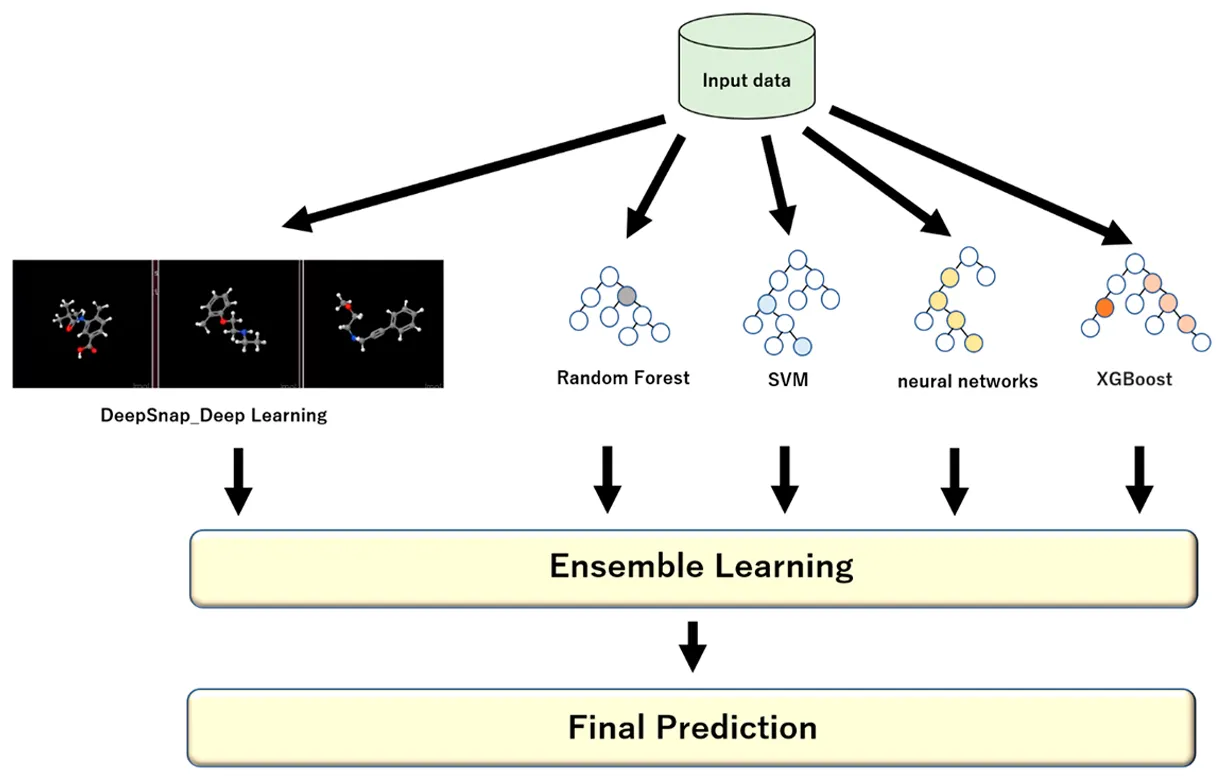

アンサンブル学習とは、同じ問題を解決するために複数のモデルを組み合わせ、一つの改善された結果を生み出す一連のテクニックを指す。教師あり学習(モデルがラベル付けされたデータから学習する)と教師なし学習(モデルがラベル付けされていないデータからパターンを見つける)の両方に適用できる。

アンサンブルは、1つのモデルに依存して予測を行うのではなく、それぞれが独自の方法でデータを見る複数のモデルを使用する。それらの出力が組み合わされるとき、その結果はしばしば、単一のモデルが単独で達成できるものよりも正確で安定し、一般化できる。

同じ問題に取り組むアナリストのパネルと比較することができる。アナリストやモデルによってデータの解釈は異なります。

ある者はパターンに注目し、別の者は異常性に注目し、また別の者は文脈に注目するかもしれない。それぞれの視点をまとめることで、グループは個人の判断よりもバランスの取れた、信頼できる判断を下すことができる。

このアプローチは、機械学習における最大の課題の2つ、バイアスと分散を解決するのにも役立つ。バイアスが大きいモデルは単純すぎて重要なパターンを見落としてしまうし、分散が大きいモデルは過敏すぎて学習データにフィットしすぎる。モデルを組み合わせることで、アンサンブル学習はこの2つのバランスを見つけ、新しい未知のデータに対するシステムの性能を向上させる。

アンサンブルの各モデルは、ベース学習者またはベースモデルと呼ばれる。これらは、使用されるアンサンブル手法によって、同じ種類のアルゴリズムであったり、異なるアルゴリズムのミックスであったりする。

ここでは、アンサンブル学習で使用されるさまざまなモデルの一般的な例をいくつか紹介する:

結合モデル・アンサンブルは、一般的に強い学習者と呼ばれる。それは、ベースとなる学習者(弱いモデルとも呼ばれる)の長所を統合し、短所を最小化するからである。より正確な最終結果を得るために、分類タスクでは多数決を、回帰タスクでは加重平均を使用し、構造化された方法で各モデルの予測値を結合します。

様々なアンサンブル学習テクニックに飛び込む前に、一歩引いて、機械学習やAIプロジェクトでこの種のアプローチをどのような場合に使うべきかを理解しよう。

アンサンブル学習は、単一のモデルでは正確で一貫性のある予測が困難な場合に最も効果を発揮する。また、データが複雑で、ノイズが多く、予測不可能な場合にも使用できる。

ここでは、アンサンブル・メソッドが特に効果的な一般的なケースをいくつか紹介しよう:

また、訓練が簡単で、解釈しやすく、維持が速い。アンサンブルを使用する前に、より高い精度の利点と、それが必要とする追加的な時間、計算能力、複雑さを比較検討することが重要です。

次に、機械学習プロジェクトでアンサンブル学習を適用する主な方法を見てみよう。モデルを組み合わせるために使われる中核的な手法はいくつかあり、それぞれが独自の方法で性能を向上させている。最も一般的なアンサンブル手法は、バギング、ブースティング、スタッキング、ブレンディングである。

バギングとは、ブートストラップ集計の略で、データの異なる部分で同じモデルの複数のバージョンを訓練することによって、モデルの安定性と精度を向上させるのに役立つアンサンブル学習法である。

各サブセットは、ブートストラップ・サンプリングと呼ばれるプロセスで作成され、データ・ポイントはランダムに置換して選択される。これは、あるデータ点が選ばれた後、次のデータ点が選ばれる前に、そのデータ点がプールに戻されることを意味し、同じ点が複数回現れる可能性がある一方で、他の点が除外される可能性もある。このランダム性により、各モデルがわずかに異なるバージョンのデータセットで学習することが保証される。

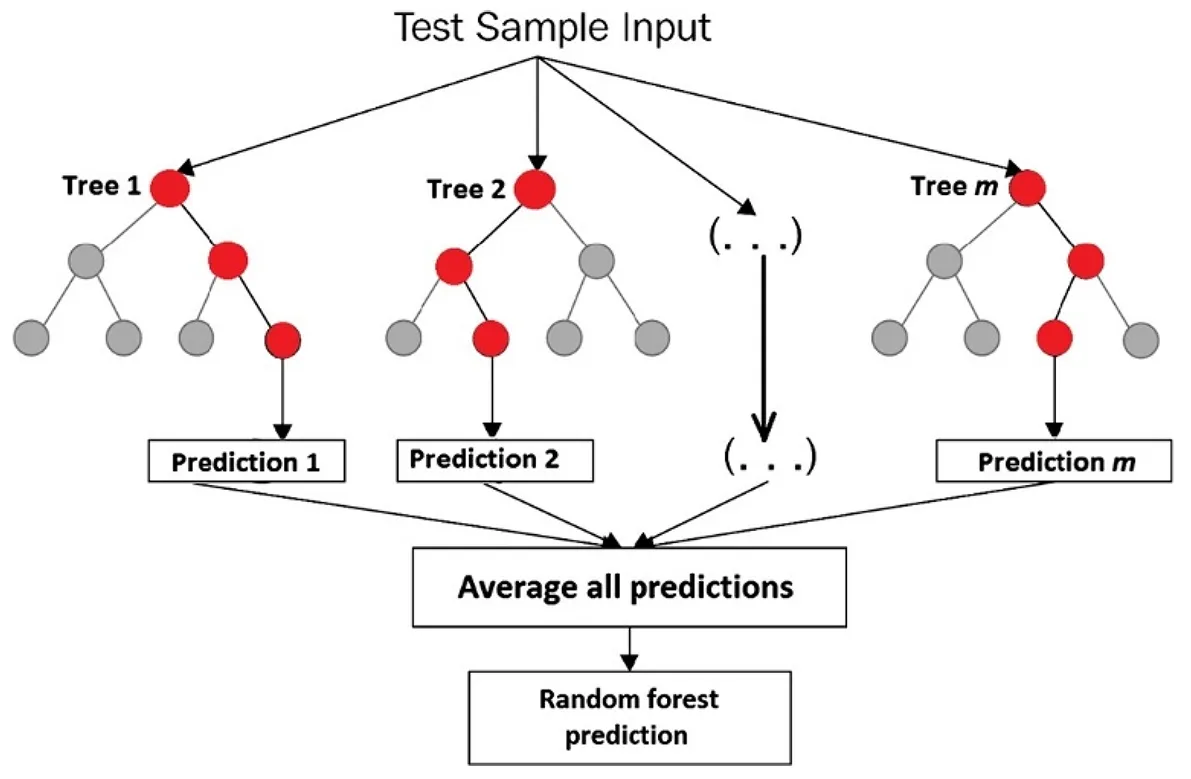

推論中、すべての学習済みモデルは並列に実行され、新しい未知のデータに対して予測を行う。各モデルは学習した内容に基づいて独自の出力を生成し、これらの個々の予測を組み合わせて最終的な結果を形成する。

住宅価格や販売予測のような回帰タスクの場合、これは通常、より滑らかな推定値を得るためにすべてのモデルの出力を平均化することを意味する。取引が不正かどうかを識別するような分類タスクの場合、アンサンブルは最終的なクラスを決定するために多数決を取ることが多い。

バギングがうまく機能する良い例として、決定木がある。決定木は、単一のデータセットで訓練すると、簡単にオーバーフィットしてしまう。わずかに異なるサンプルで多くの木を訓練し、その結果を組み合わせることで、バギングはオーバーフィッティングを減らし、信頼性を向上させる。

ランダムフォレスト・アルゴリズムを考えてみよう。これは決定木のアンサンブルであり、各決定木は訓練データセットのランダムなサブセットと特徴のランダムなサブセットで訓練される。

この特徴的なランダム性は、ツリーの相関性が低く、モデル全体がより安定し、正確であることを保証するのに役立つ。ランダムフォレストのアルゴリズムは、画像のclassify 、不正行為のdetect 、顧客離れの予測、売上予測、不動産価格の推定などに使用できます。

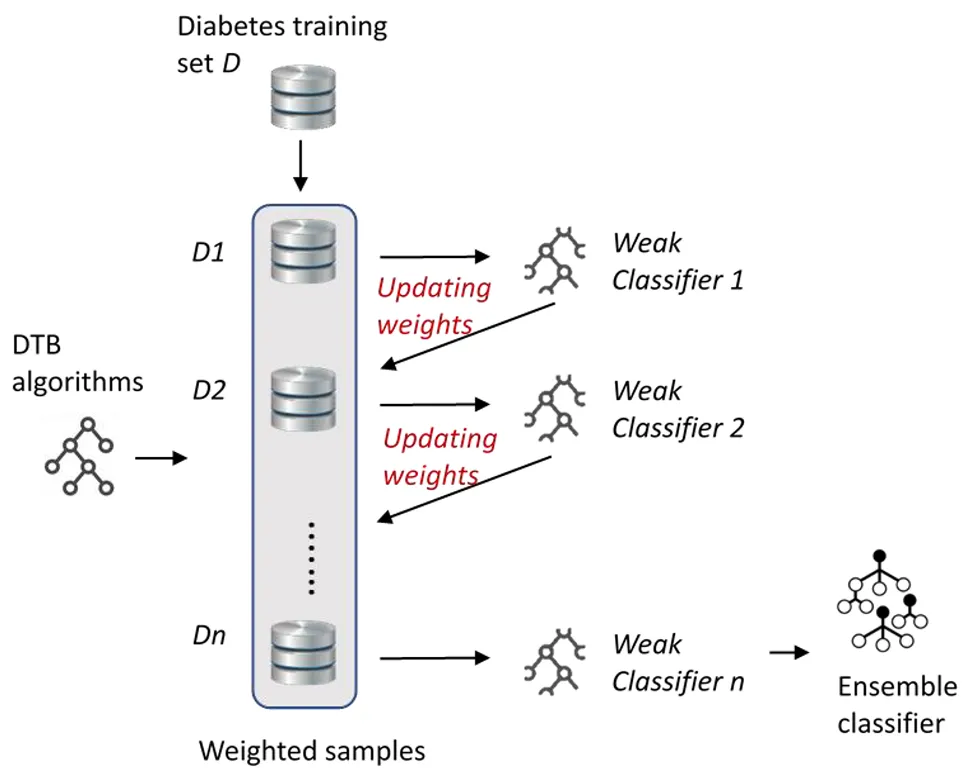

ブースティングは、弱い学習者(モデル)を、並行してではなく、次々に順次学習させることによって改善することに焦点を当てた、もうひとつのアンサンブル学習手法である。ブースティングの核となるコンセプトは、それぞれの新しいモデルが前のモデルのミスから学ぶことで、モデル全体のパフォーマンスを徐々に向上させるというものである。

独立したモデルを平均化することで分散を減らすバギングとは異なり、ブースティングは、それぞれの新しいモデルに、以前のモデルが苦戦した難しいケースにより注意を払わせることで、バイアスを減らす。

ブースティング・モデルは逐次的に学習されるため、最終的に予測値が組み合わされる方法は、他のアンサンブル手法とは若干異なります。各モデルはトレーニング中のパフォーマンスに比例して最終的な予測に貢献し、より正確なモデルはより大きなウェイトを受ける。

回帰タスクの場合、最終結果は通常、すべてのモデルの予測値の重み付き合計です。分類タスクの場合、アルゴリズムは最終的なクラスを決定するために、モデルからの重み付けされた票を組み合わせます。このアプローチは、他のモデルから学習しつつ、より正確なモデルにより多くの重みを与えることで、強力な全体モデルを作成するブースティングに役立ちます。

ここでは、ブースティング・アルゴリズムの一般的なタイプをいくつか紹介する:

スタック(積み重ねられた汎化)とも呼ばれるスタッキングは、メタ学習者として知られる最終モデルの入力として複数のモデルからの予測を使用することで、物事をさらに一歩進めます。これは、それぞれの意見を共有する専門家のグループがいて、最終的な意思決定者が、可能な限り最良の判断を下すために、それらの意見をどのように重み付けするかを学習するようなものだと考えることができる。

例えば、あるモデルは不正を発見するのが得意で、別のモデルは顧客離れを予測するのが得意かもしれない。メタ学習者は、それぞれがどのように機能するかを研究し、より正確な最終予測を行うために、それぞれの長所を一緒に使う。

ブレンディングは、複数のモデルからの予測を組み合わせて最終的な判断を下すので、スタッキングと似たような働きをするが、よりシンプルで迅速なアプローチをとる。スタッキングのようにクロスバリデーション(モデルをより信頼性の高いものにするために、データをいくつかの部分に分割し、トレーニングとテストの間で回転させる方法)を使用する代わりに、ブレンディングはホールドアウトセットと呼ばれるデータの一部を脇に置いておきます。

ベース・モデルは残りのデータで学習され、次にまだ見たことのないホールドアウト・セットで予測を行う。これは2つの重要な情報を生成します:実際の答え、つまり真のラベルと、各ベースモデルによる予測です。

これらの予測は、次にブレンドモデルまたはメタモデルと呼ばれる別のモデルに渡される。この最終モデルは、各ベースモデルの予測がどの程度正確かを研究し、それらを最善の方法で組み合わせる方法を学習する。

ブレンディングは、訓練とテストを数回繰り返すのではなく、1回だけの分割に依存するため、実行速度が速く、セットアップも簡単である。その代償として、学習する情報が若干少なくなるため、精度が少し落ちる可能性がある。

アンサンブル学習で重要なのは、モデルが見たことのないデータでどれだけうまく機能するかを評価することである。どんなに高度な技術であっても、それが汎化できることを確認するためにテストされなければならない。つまり、学習データをただ記憶するのではなく、新しい実世界の例に対して正確な予測を行うべきであるということだ。

ここでは、AIモデルの評価に使用される一般的なパフォーマンス指標をいくつか紹介する:

これまで、アンサンブル学習がどのように機能するのか、そしてその背後にある技術を探ってきた。次に、このアプローチがどのようなインパクトを与えているのかを見てみよう。

ここでは、アンサンブル学習が一般的に適用されている主な分野をいくつか紹介する:

アンサンブル学習は、数値やカテゴリー情報を含むスプレッドシートのような構造化されたデータや表形式のデータで最も一般的に使用されるが、テキスト、画像、音声、ビデオなどの非構造化データにも適用できる。

これらのデータタイプはより複雑で、モデルが解釈するのが難しいが、アンサンブル手法は精度と信頼性の向上に役立つ。例えば、コンピュータビジョンでは、アンサンブルは画像分類や物体検出のようなタスクを強化することができる。

畳み込みニューラルネットワーク(CNN)のような複数の視覚モデルの予測を組み合わせることで、システムは物体をより正確に認識し、単一のモデルを混乱させるかもしれない照明、角度、背景の変化に対応することができる。

コンピュータ・ビジョンにおけるアンサンブル学習の興味深い使用例は、エンジニアが複数の物体検出モデルを組み合わせて精度を向上させる場合である。照明、角度、物体の大きさが常に変化する建設現場の安全監視システムを開発しているエンジニアを想像してみてください。

単一のモデルでは、物陰にいる作業員を見逃してしまうかもしれないし、動いている機械を混同してしまうかもしれない。それぞれが異なる強みを持つモデルのアンサンブルを使用することで、システムはより信頼性が高くなり、そのようなエラーを起こしにくくなる。

特に Ultralytics YOLOv5のようなモデルは、モデル・アンサンブルと密接に関係している。エンジニアは、YOLOv5xやYOLOv5l6のような異なるYOLOv5 、一緒に予測を行うことができます。各モデルは同じ画像を分析し、独自の検出結果を生成し、それを平均化することで、より強力で正確な最終結果を生成します。

以下に、アンサンブル学習の主な利点をいくつか挙げる:

アンサンブル学習は様々な利点をもたらすが、考慮すべき課題もある。以下は、留意すべきいくつかの要因である:

アンサンブル学習は、複数のモデルを組み合わせることで、AIシステムをより正確で信頼性の高いものにする方法を示している。これはエラーを減らし、さまざまな種類のタスクのパフォーマンスを向上させるのに役立つ。機械学習とAIが成長し続ける中、このような技術は、より広範な導入と、より実用的で高性能なAIソリューションの実現を後押ししている。

成長中のコミュニティと GitHubリポジトリに参加して、ビジョンAIについてもっと知りましょう。農業と 物流における コンピュータビジョンのアプリケーションについて学ぶために、当社のソリューションページをご覧ください。ライセンスオプションをチェックして、今すぐ独自のコンピュータビジョンモデルを始めましょう!