初心者向けのクイックガイドで、AIモデルの学習方法をステップバイステップで学びましょう。ワークフロー、データセット、ツールなど、AI学習を始めるために必要な情報が満載です。

初心者向けのクイックガイドで、AIモデルの学習方法をステップバイステップで学びましょう。ワークフロー、データセット、ツールなど、AI学習を始めるために必要な情報が満載です。

ChatGPT、画像ジェネレーター、その他の人工知能(AI)ツールは、学校、職場、そして私たちの個人的なデバイスでさえも、日常生活に欠かせないものとなりつつある。しかし、それらが実際にどのように機能するのか不思議に思ったことはないだろうか?

これらのシステムの核となるのは、AIモデルが大量のデータから学習してパターンを認識し、意思決定を行うトレーニングと呼ばれるプロセスだ。何年もの間、AIモデルのトレーニングは非常に複雑なプロセスであった。

そのためには、膨大な量のデータを処理できる強力なコンピューターと、専門家によって収集されラベル付けされなければならない特殊なデータセットが必要だった。適切な環境のセットアップ、フレームワークのインストール、実験の実行には時間とコストがかかり、複雑だった。

今日、オープンソースのツール、使いやすいプラットフォーム、アクセス可能なデータセットによって、このプロセスははるかにシンプルになった。学生、エンジニア、AI愛好家、データサイエンティスト、そして初心者でさえも、高度なハードウェアや深い専門知識を必要とせずに、モデルトレーニングを試すことができるようになった。

この記事では、AIモデルをトレーニングする方法の手順を説明し、プロセスの各段階を説明し、ベストプラクティスを共有します。さっそく始めよう!

AIモデルのトレーニングでは、従うべきルールのリストを与えるのではなく、例から学習するようコンピューターシステムに教える。もしこうなら、こうする」と言う代わりに、たくさんのデータを見せて、自分でパターンを見つけさせるのだ。

このプロセスの核となるのは、データセット、アルゴリズム、トレーニング・プロセスという3つの重要なコンポーネントである。データセットは、モデルが研究する情報である。

アルゴリズムとは、データから学習するための方法であり、トレーニングプロセスとは、継続的に練習し、予測を行い、間違いを特定し、その都度改善する方法である。

このプロセスで重要なのは、訓練データと検証データの使用である。トレーニングデータはモデルがパターンを学習するのに役立ち、検証データはデータセットの別の部分で、モデルがどの程度学習できているかをテストするのに使われる。検証は、モデルが単に例を記憶しているのではなく、新しい未知のデータに対して信頼できる予測を行えることを保証する。

例えば、住宅価格について学習したモデルは、立地、広さ、部屋数、近隣の傾向などの詳細を用いて不動産価値を予測することができる。モデルは過去のデータを研究し、パターンを特定し、これらの要因が価格にどのように影響するかを学習する。

同様に、コンピュータビジョンモデルは、猫と犬を区別するために、何千ものラベル付き画像で訓練されるかもしれない。それぞれの画像は、形状、テクスチャー、そして耳、毛皮のパターン、尻尾など、猫と犬を区別する特徴を認識するようモデルに学習させる。どちらの場合も、モデルは訓練データを分析し、未見の例で性能を検証し、時間の経過とともに予測を改良することによって学習する。

モデル・トレーニングが実際にどのように機能するのか、詳しく見てみよう。

学習済みのAIモデルが予測に使われる場合、画像や文章、数字の集合などの新しいデータを取り込み、すでに学習した内容に基づいて出力を生成する。これは推論と呼ばれ、モデルがトレーニング中に学習したことを適用して、新しい情報に対して意思決定や予測を行うことを意味する。

しかし、モデルが効果的に推論を行うには、まず学習させる必要がある。トレーニングとは、モデルが例から学習し、パターンを認識し、後で正確な予測を行えるようにするプロセスである。

トレーニングでは、ラベル付けされた例をモデルに与える。例えば、"cat "という正しいラベルが付いた猫の画像などだ。モデルは入力を処理し、予測を生成する。その出力は正しいラベルと比較され、両者の差が損失関数を使って計算される。損失値は、モデルの予測誤差、またはその出力が望ましい結果からどれだけ離れているかを表す。

この誤差を減らすために、モデルは確率的勾配降下法SGD)やAdamオプティマイザーに頼る。オプティマイザーは、損失を最小化する方向に、重みとして知られるモデルの内部パラメータを調整する。これらの重みは、モデルがデータ内の異なる特徴にどの程度強く反応するかを決定する。

予測を行い、損失を計算し、重みを更新し、それを繰り返すというこのプロセスは、何度も繰り返される。サイクルを繰り返すごとに、モデルはデータに対する理解を深め、徐々に予測誤差を減らしていく。効果的に訓練されると、損失は最終的に安定し、モデルが訓練データに存在する主なパターンを学習したことを示すことが多い。

AIモデルのトレーニングは、最初は複雑に思えるかもしれませんが、シンプルなステップに分けることで、プロセスをより理解しやすくなります。各ステージは前のステージの上に構築され、アイデアから実用的なソリューションへと移行するのに役立ちます。

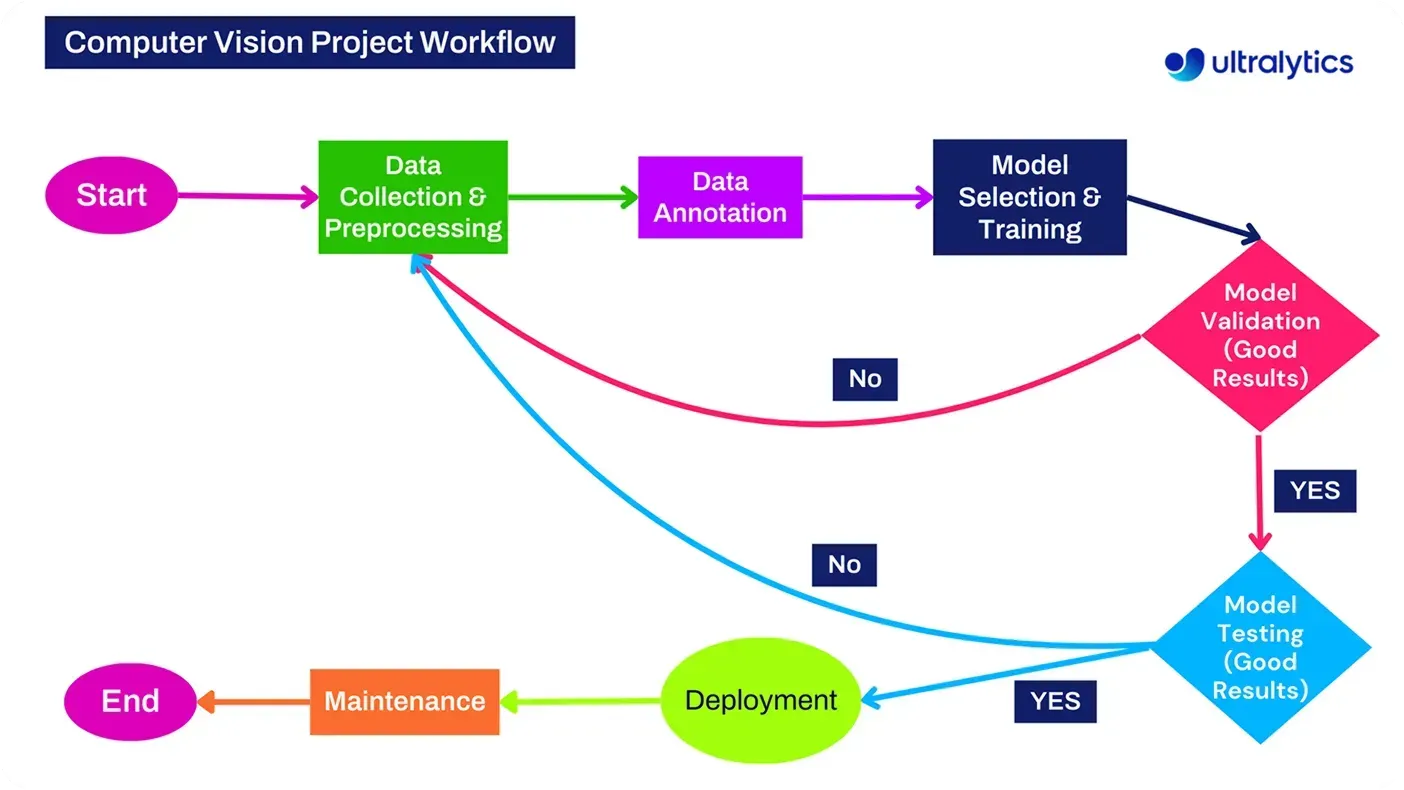

ユースケースの定義、データの収集と準備、モデルとアルゴリズムの選択、環境の設定、トレーニング、検証とテスト、そして最後にデプロイと反復。

AIモデルをトレーニングする最初のステップは、AIソリューションが解決したい問題を明確に定義することだ。目標が明確に定義されていないと、プロセスは容易に焦点を失い、モデルは意味のある結果をもたらさない可能性がある。ユースケースとは、モデルに予測や分類を期待する具体的なシナリオのことです。

例えば、機械が視覚情報を解釈し理解することを可能にするAIの一分野であるコンピュータビジョンでは、一般的なタスクは物体の検出である。これは、棚にある商品の識別、道路交通の監視、製造における欠陥の検出など、さまざまな方法で応用できる。

同様に、財務やサプライチェーン管理では、予測モデルがトレンドや需要、将来の業績を予測するのに役立つ。また、自然言語処理(NLP)では、テキスト分類によって、電子メールの並べ替え、顧客フィードバックの分析、レビューの感情detect 可能になります。

一般的に、明確な目標を持って始めると、適切なデータセット、学習方法、最適なモデルを選ぶのがずっと簡単になる。

ユースケースを定義したら、次のステップはデータの収集だ。学習データはすべてのAIモデルの基礎であり、このデータの質はモデルのパフォーマンスに直接影響する。データはモデル・トレーニングのバックボーンであり、AIシステムは学習データと同程度にしか優れていないということを念頭に置くことが重要です。データの偏りやギャップは、必然的に予測に影響を与える。

収集するデータの種類はユースケースによって異なる。例えば、医療画像分析には高解像度スキャンが必要であり、感情分析にはレビューやソーシャルメディアからのテキストが使われる。このようなデータは、研究コミュニティによって共有されるオープンデータセット、社内データベース、またはスクレイピングやセンサーデータなどのさまざまな収集方法から入手することができます。

収集後、データを前処理することができる。これにはエラーのクリーニング、フォーマットの標準化、アルゴリズムが学習できるように情報をラベリングすることなどが含まれる。データのクリーニングや前処理は、データセットの正確性と信頼性を保証する。

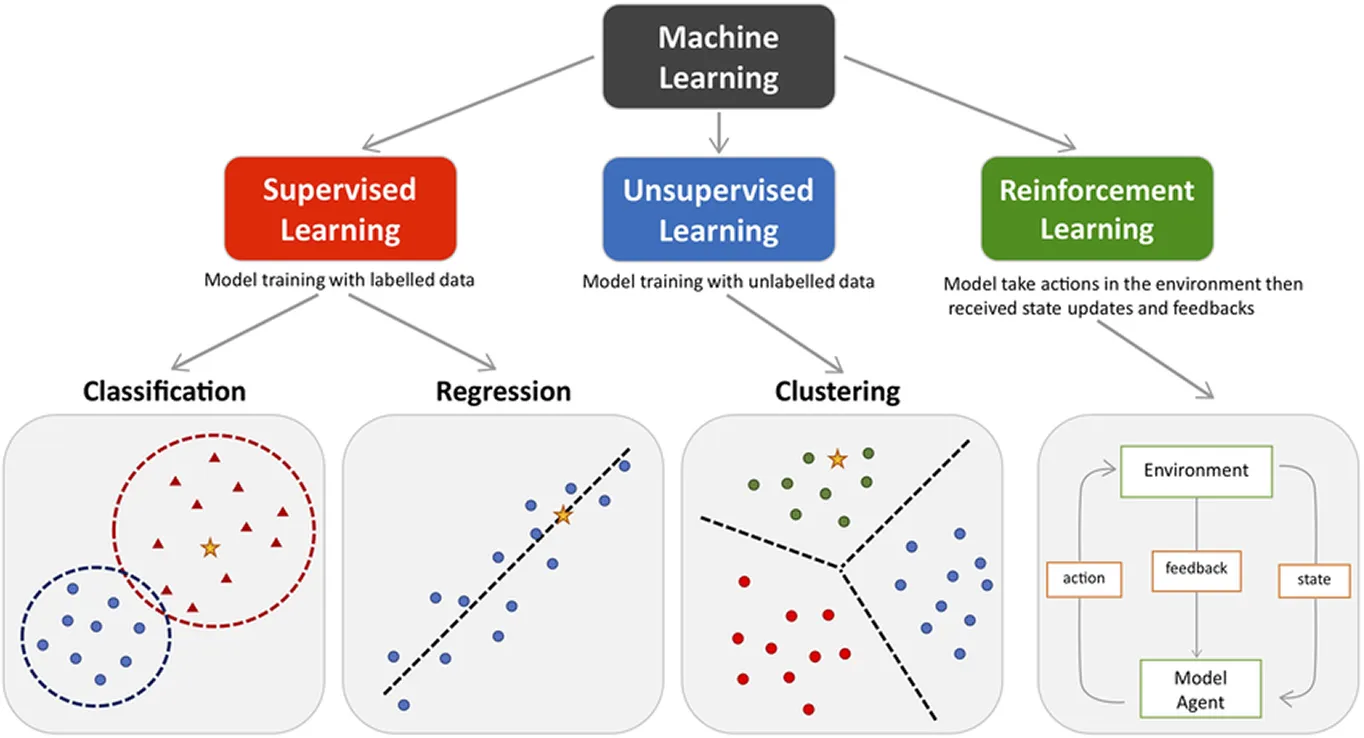

データの準備ができたら、次のステップは適切なモデルと学習方法を選択することだ。機械学習の手法は一般的に、教師あり、教師なし、強化学習の3つに分類される。

教師あり学習では、モデルはラベル付きデータから学習し、価格予測、画像認識、電子メール分類などのタスクに使用される。対照的に、教師なし学習は、ラベル付けされていないデータを使って、顧客のクラスタリングやトレンドの発見など、隠れたパターンやグループ分けを見つける。強化学習は、フィードバックと報酬を通じてエージェントを訓練するのに対し、ロボット工学、ゲーム、オートメーションなどでよく使われる。

実際には、このステップはデータ収集と密接に結びついている。というのも、どのようなモデルを選択するかは、利用可能なデータに依存することが多く、収集するデータは通常、モデルの要件によって形作られるからである。

どちらが先かは用途によって異なる。すでにデータを持っていて、それを活用する最善の方法を見つけたい場合もある。また、解決すべき問題があり、モデルを効果的にトレーニングするために新しいデータを収集したり作成したりする必要がある場合もあります。

この場合、すでにデータセットがあり、教師あり学習に最適なモデルを選びたいと仮定しよう。データが数字で構成されている場合、価格、売上、トレンドなどの結果を予測するために回帰モデルを学習するかもしれません。

同様に、画像を扱う場合、次のようなコンピュータ・ビジョン・モデルを使うことができる。 Ultralytics YOLO11やUltralytics YOLO26のようなコンピュータビジョンモデルを使用することができます。

一方、データがテキストの場合は、言語モデルが最適かもしれない。では、どのような学習手法やアルゴリズムを使えばいいのだろうか?それは、データセットのサイズや質、タスクの複雑さ、利用可能なコンピューティング・リソース、必要な精度のレベルなど、いくつかの要因に左右される。

これらの要素についてさらに学び、さまざまなAIのコンセプトを探求するには、当ブログのガイドセクションをご覧ください。

正しい環境を整えることは、AIモデルをトレーニングする前の重要なステップです。適切なセットアップを行うことで、実験をスムーズかつ効率的に進めることができます。

以下は、考慮すべき重要な点である:

環境が整ったら、いよいよトレーニングを開始する。これは、モデルがデータセットからパターンを認識し、時間の経過とともに改善することによって学習する段階である。

トレーニングでは、予測精度が向上するまで、モデルに繰り返しデータを表示し、内部パラメータを調整する。データセットを完全に通過するごとにエポックと呼ばれる。

パフォーマンスを向上させるには、ハイパーパラメータ・チューニングのような最適化テクニックを使うことができます。学習率、バッチ・サイズ、エポック数などの設定を調整することで、モデルの学習性能に大きな違いをもたらすことができます。

トレーニングを通して、パフォーマンス測定基準を使用して進捗を監視することが重要です。精度、正確さ、再現性、損失などの指標は、モデルが改善されているか、調整が必要かを示します。ほとんどの機械学習とAIライブラリには、これらのメトリクスをリアルタイムで簡単にtrack し、潜在的な問題を早期に特定できるダッシュボードとビジュアルツールが含まれています。

モデルのトレーニングが終わったら、評価と検証を行います。これには、今まで見たことのないデータでモデルをテストし、実際のシナリオに対応できるかどうかをチェックすることが含まれる。この新しいデータが実際にどこから来るのか不思議に思うかもしれない。

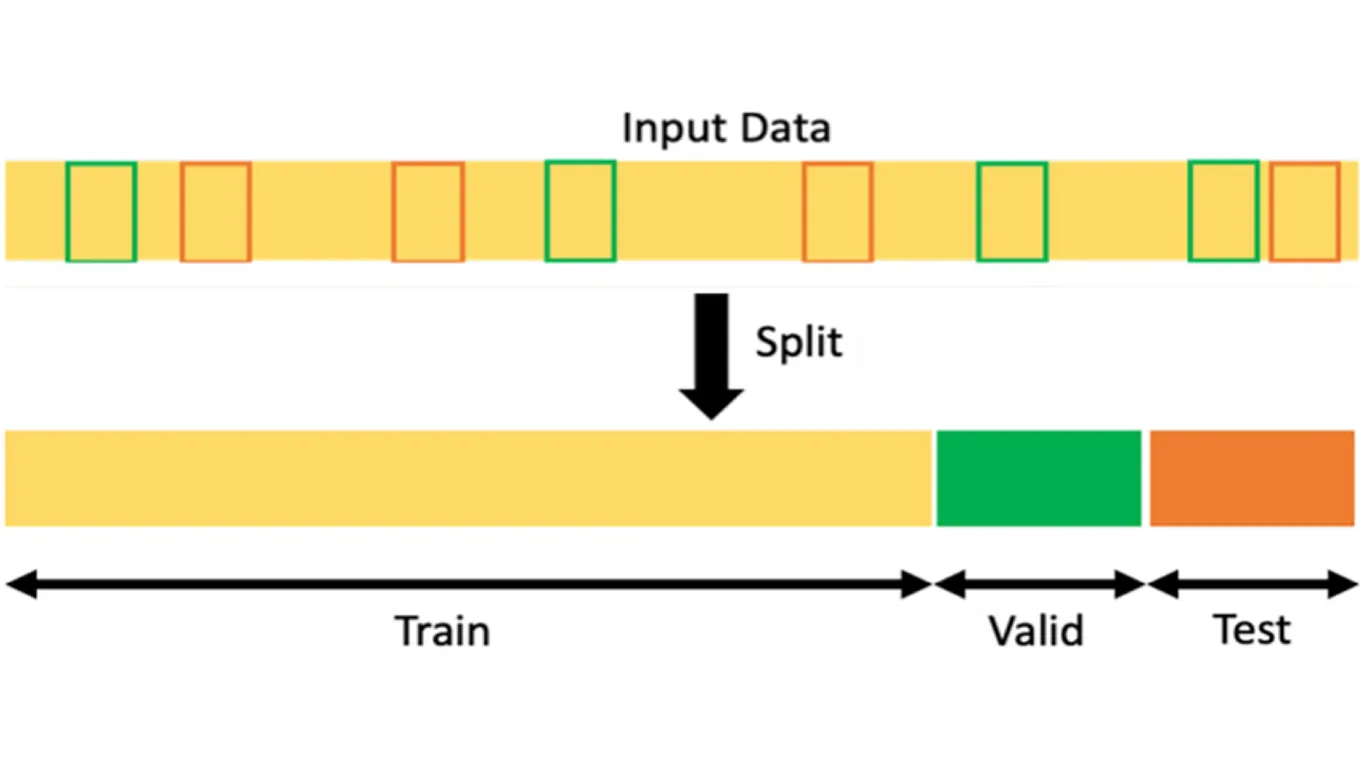

多くの場合、データセットはトレーニングの前に、トレーニングセット、検証セット、テストセットの3つに分けられる。訓練セットは、モデルにデータのパターンを認識させる。

一方、検証セットは、パラメーターを微調整し、オーバーフィッティング(モデルが訓練データに忠実に学習しすぎて、新しい未知のデータでパフォーマンスが低下すること)を防ぐために訓練中に使用される。

逆に、テストセットはその後に使用され、全く見たことのないデータに対してモデルがどれだけうまく機能するかを測定する。モデルが検証セットとテストセットの両方で一貫して良好なパフォーマンスを示した場合、単に例を記憶するのではなく、意味のあるパターンを学習したことを強く示す。

モデルが検証され、テストされた後、実際に実世界で使用するために展開することができる。これは単純に、モデルが現実世界で予測を行うことができるように、モデルを使用することを意味する。例えば、訓練されたモデルは、ウェブサイト、アプリ、または機械に統合され、新しいデータを処理して自動的に結果を出すことができる。

モデルはアプリケーションによって様々な方法で展開することができる。あるモデルはAPIを通じて共有され、他のアプリケーションがモデルの予測にアクセスできるようにする単純なソフトウェア接続である。また、クラウドプラットフォーム上でホスティングされるものもあり、そこではモデルの拡張や管理をオンラインで簡単に行うことができる。

場合によっては、モデルはカメラやセンサーなどのエッジデバイス上で実行される。これらのモデルは、インターネット接続に依存することなく、ローカルで予測を行う。最適な導入方法は、ユースケースと利用可能なリソースに依存する。

モデルを定期的にモニターし、アップデートすることも重要だ。時間の経過とともに、新しいデータや状況の変化がパフォーマンスに影響を与える可能性があります。継続的な評価、再トレーニング、最適化を行うことで、モデルの正確性、信頼性、および実世界のアプリケーションでの有効性を維持することができます。

AIモデルのトレーニングにはいくつかのステップがありますが、いくつかのベストプラクティスに従うことで、プロセスをよりスムーズに、結果をより信頼性の高いものにすることができます。より良い、より正確なモデルを構築するのに役立つ、いくつかの重要なプラクティスを見てみましょう。

すべてのカテゴリーやクラスが公平に表現されるように、バランスのとれたデータセットを使うことから始めよう。あるカテゴリーが他のカテゴリーよりも頻繁に現れると、モデルに偏りが生じ、正確な予測を行うのに苦労することになる。

次に、ハイパーパラメータチューニングのようなテクニックを活用する。これは、精度を向上させるために、学習率やバッチサイズなどの設定を調整することである。小さな変更でも、モデルの学習効果に大きな影響を与えることができる。

トレーニングを通して、精度、リコール、損失などの主要なパフォーマンス指標を監視します。これらの値は、モデルが意味のあるパターンを学習しているのか、それとも単にデータを記憶しているのかを判断するのに役立ちます。

最後に、常にワークフローを文書化する習慣をつけること。使用したデータ、実行した実験、達成した結果をtrack おきましょう。明確に文書化することで、成功した結果を再現しやすくなり、時間の経過とともにトレーニングプロセスを継続的に改良することができます。

AIは、さまざまな業界や用途で広く採用されているテクノロジーだ。テキストや画像から、音声や時間ベースのデータまで、データ、アルゴリズム、反復学習の利用という同じ基本原則があらゆる場所で適用されている。

ここでは、AIモデルがトレーニングされ、使用される主な分野をいくつか紹介する:

最近の技術の進歩にもかかわらず、AIモデルのトレーニングには、パフォーマンスと信頼性に影響を与える可能性のある、ある種の課題がつきまといます。ここでは、モデルを構築し、改良する際に留意すべき主な制限について説明します:

従来、AIモデルのトレーニングには、大規模なチーム、強力なハードウェア、複雑なインフラが必要だった。しかし今日では、最先端のツールやプラットフォームによって、そのプロセスはよりシンプルに、より速く、よりアクセスしやすくなっている。

これらのソリューションは、深い技術的専門知識の必要性を減らし、個人、学生、企業が簡単にカスタムモデルを構築し、展開することを可能にします。実際、AIトレーニングを始めるのはこれまでになく簡単です。

例えば、Ultralytics Python パッケージは手始めに最適です。Ultralytics YOLO モデルの学習、検証、推論を実行し、様々なアプリケーションに展開するためにエクスポートするために必要なすべてが提供されています。

Roboflow、TensorFlow、Hugging Face、PyTorch Lightningなど、その他の人気のあるツールも、データの準備からデプロイまで、AIトレーニングのワークフローのさまざまな部分を簡素化する。これらのプラットフォームにより、AI開発はこれまで以上にアクセスしやすくなり、開発者、企業、そして初心者でさえも実験と革新を行うことができるようになった。

AIモデルのトレーニングは複雑に思えるかもしれませんが、適切なツール、データ、アプローチがあれば、誰でも今日から始めることができます。ユースケースの定義から展開までの各ステップを理解することで、アイデアを現実のAIソリューションに変え、変化をもたらすことができる。AI技術が進化し続ける中、学び、構築し、革新する機会はこれまで以上に身近なものとなっている。

成長中のコミュニティに参加して、GitHubリポジトリで実践的なAIリソースを探索してください。今すぐVision AIを使って構築するには、ライセンスオプションをご覧ください。農業におけるAIがどのように農業を変革しているか、ロボット工学におけるVision AIがどのように未来を形成しているかについては、ソリューションのページをご覧ください。