ビジョンAIにおける画像マッチングの仕組みを学び、機械が視覚データをdetect、比較、理解するためのコア技術を探ります。

ビジョンAIにおける画像マッチングの仕組みを学び、機械が視覚データをdetect、比較、理解するためのコア技術を探ります。

絵画と車の写真のように、同じものの2枚の写真を見れば、その共通点に気づくのは簡単だ。しかし、機械の場合はそう簡単にはいかない。

このような比較を行うために、機械は視覚情報の解釈と理解を助ける人工知能(AI)の一分野であるコンピュータ・ビジョンに依存している。コンピュータ・ビジョンは、システムが物体をdetect し、シーンを理解し、画像やビデオからパターンを抽出することを可能にする。

特に、いくつかの視覚的タスクは、単一の画像を分析するだけではない。画像を比較して類似点を見つけたり、相違点を見つけたり、経時変化をtrack したりするのだ。

画像マッチングとして知られるビジョンAIは、照明や角度、背景が異なる場合でも、画像間の類似性を識別することに焦点を当てている。この技術は、ロボット工学、拡張現実(AR)、ジオマッピングなど、さまざまな用途に利用できる。

この記事では、イメージ・マッチングとは何か、その核となるテクニック、そして実際の応用例を紹介します。さっそく始めましょう!

イメージ・マッチングは、コンピュータ・システムが2つの画像に類似した内容が含まれているかどうかを理解することを可能にする。人間は、形、色、パターンに気づくことで、これを直感的に行うことができる。

一方、コンピューターは数値データに頼る。デジタル画像の最小単位である各ピクセルを調べることによって画像を分析する。

すべての画像はピクセルのグリッドとして保存され、各ピクセルは通常、赤、緑、青(RGB)の値を保持しています。これらの値は、画像を回転させたり、サイズを変更したり、異なる角度から見たり、異なる照明条件で撮影したりすると変化することがあります。このような変化があるため、画像をピクセル単位で比較することは信頼できないことが多い。

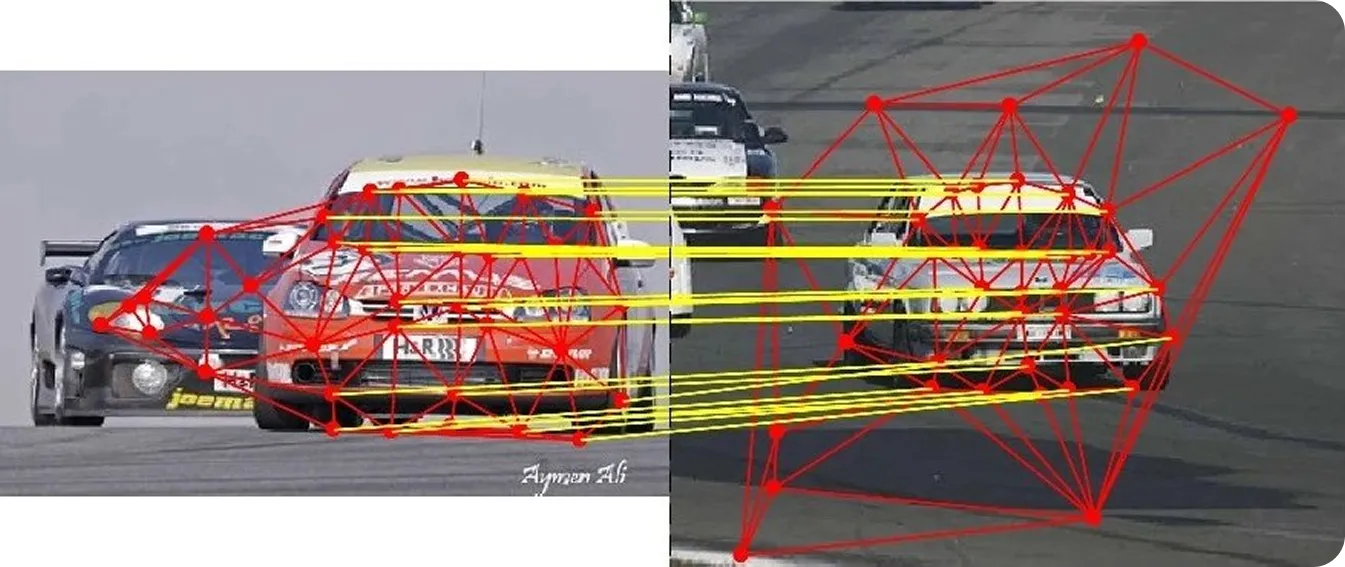

比較をより一貫したものにするため、画像マッチングは、画像がわずかに変化しても安定する傾向がある局所的な特徴、つまりコーナー、エッジ、テクスチャ領域に焦点を当てる。複数の画像からこれらの特徴(キーポイント)を検出することで、システムはより高い精度で画像を比較することができる。

このプロセスは、ナビゲーション、ローカリゼーション、AR(拡張現実)、マッピング、3D再構成、ビジュアルサーチなどのユースケースで広く使われている。システムが異なる画像や複数のフレームにまたがって同じ点を識別することで、動きをtrack し、シーンの構造を理解し、動的な環境において信頼性の高い判断を下すことができる。

画像マッチングには、システムが画像内の類似領域を識別・比較するためのいくつかの重要なステップが含まれる。各ステップは、さまざまな条件下で精度、一貫性、ロバスト性を向上させる。

イメージ・マッチングがどのように機能するのか、ステップ・バイ・ステップで見ていきましょう:

画像マッチングの実世界での応用を探る前に、まずコンピュータ・ビジョン・システムで使われている画像マッチング技術を詳しく見てみよう。

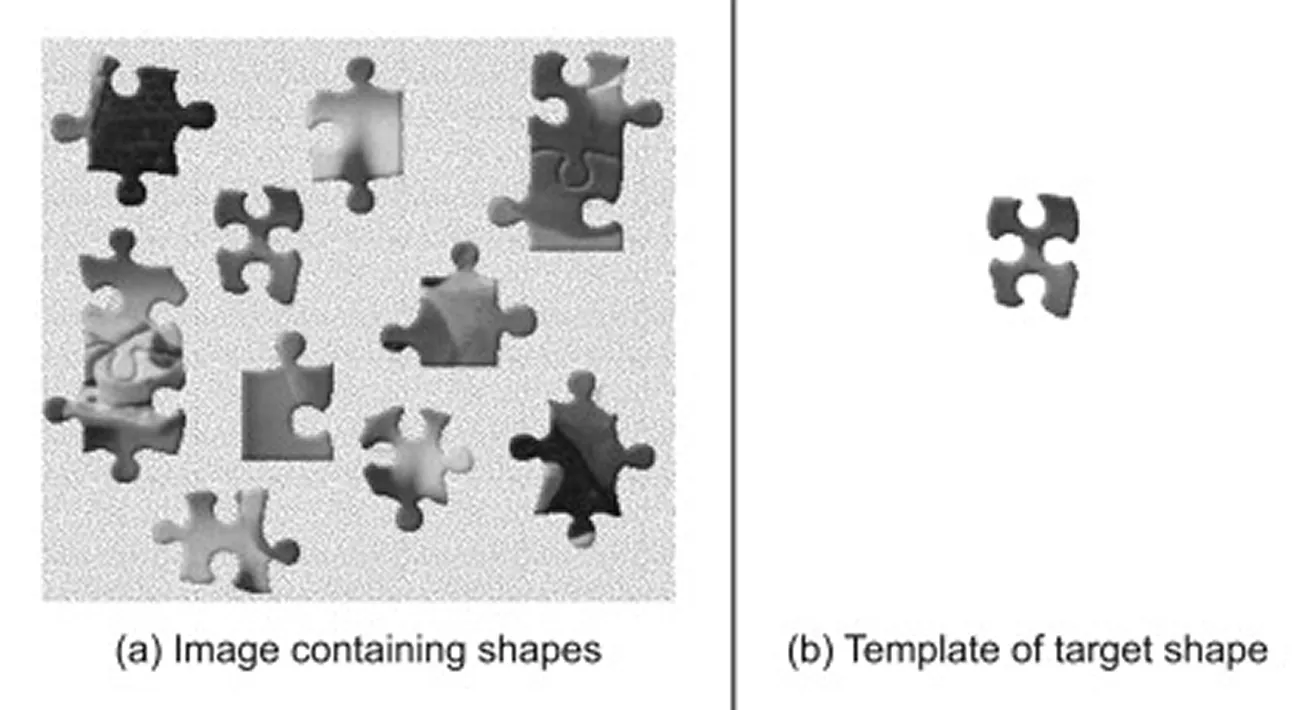

テンプレートマッチングは、最も単純な画像マッチング手法のひとつである。ピクセルの直接比較に依存し、より深い視覚的特徴を抽出しないため、一般に最新のコンピュータ・ビジョン手法というよりは画像処理手法と考えられている。

これは、より大きなシーン内で、より小さな参照画像(テンプレート)を見つけるために使用される。テンプレートをメイン画像にスライドさせ、各位置で類似度スコアを計算し、2つの領域がどれだけ密接に一致しているかを測定するアルゴリズムを使用して動作する。最も高いスコアを持つ領域が最もよく一致するとみなされ、オブジェクトがシーンに現れる可能性が最も高い場所を示す。

このテクニックは、オブジェクトのスケール、回転、照明が一貫している場合にうまく機能するため、管理された環境やベースライン比較に適しています。しかし、オブジェクトのサイズが変化したり、回転したり、部分的にオクルードされたり、ノイズの多い背景や複雑な背景の上に表示されるなど、オブジェクトがテンプレートと異なって見える場合、その性能は低下します。

ディープラーニングが広く採用されるようになる以前は、画像マッチングのほとんどは、画像内の特徴的なキーポイントを検出する古典的なコンピュータビジョンアルゴリズムに依存していた。これらの方法は、すべてのピクセルを比較する代わりに、画像の勾配、つまり強度の変化を分析し、目立つコーナー、エッジ、テクスチャ領域を強調する。

検出された各キーポイントは、記述子と呼ばれるコンパクトな数値要約を用いて表現されます。2つの画像を比較するとき、マッチャはこれらの記述子を評価し、最も類似したペアを見つけます。

強い類似度スコアは通常、両方の画像に同じ物理的なポイントが表示されていることを示します。マッチャーはまた、特定の距離測定基準や採点規則を使用して、特徴がどの程度密接に一致しているかを判断し、全体的な信頼性を向上させます。

ここでは、画像マッチングに使用される古典的なコンピュータビジョンアルゴリズムの主要なものをいくつか紹介する:

特定のルールに依存する古典的な手法とは異なり、ディープラーニングは大規模なデータセット(AIモデルがパターンを学習する視覚データの集合)から自動的に特徴を学習する。これらのモデルは通常、GPU(グラフィック・プロセッシング・ユニット)上で実行される。GPUは、大量の画像を処理し、複雑なニューラルネットワークを効率的に訓練するのに必要な高い計算能力を提供する。

これにより、AIモデルは、照明、カメラアングル、オクルージョンなどの現実世界の変化に対応できるようになります。また、モデルによっては、すべてのステップを1つのワークフローにまとめ、厳しい条件下でも堅牢なパフォーマンスをサポートします。

ここでは、画像の特徴抽出とマッチングのためのディープラーニングに基づくアプローチをいくつか紹介する:

イメージ・マッチングがどのように機能するかについて理解を深めたところで、イメージ・マッチングが重要な役割を果たす実際のアプリケーションを見てみよう。

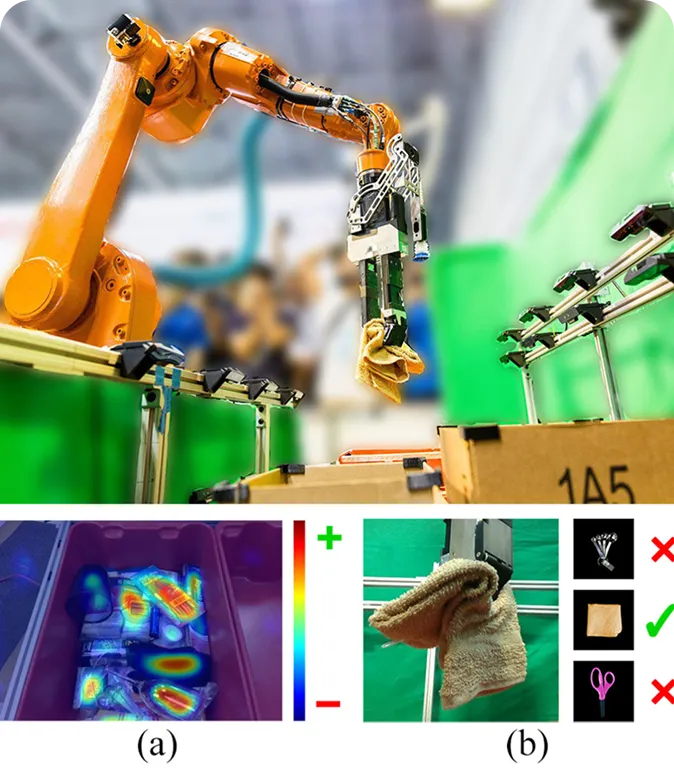

ロボットは多くの場合、忙しく変化する環境の中で動作し、どのような物体が存在し、それらがどのように配置されているかを理解する必要がある。イメージ・マッチングは、保存されている画像や参照画像と比較することで、ロボットが目にした物体を理解するのに役立ちます。これにより、ロボットは物体を認識し、その動きをtrack し、照明やカメラの角度が変わっても適応しやすくなります。

例えば倉庫では、ロボットによるピック・アンド・プレイス・システムが、画像マッチングを利用して異なる品物を識別し、取り扱うことができる。ロボットはまず物体をつかみ、その画像を参照サンプルと比較して識別する。

一度一致するものが見つかれば、ロボットはそれを正しく並べ替えたり配置したりする方法を知っている。このアプローチにより、ロボットはシステム全体を再トレーニングすることなく、見慣れた物体も新しい物体も認識できるようになる。また、棚を整理したり、部品を組み立てたり、品物を並べ替えたりするような、より良いリアルタイムの判断を下すのにも役立つ。

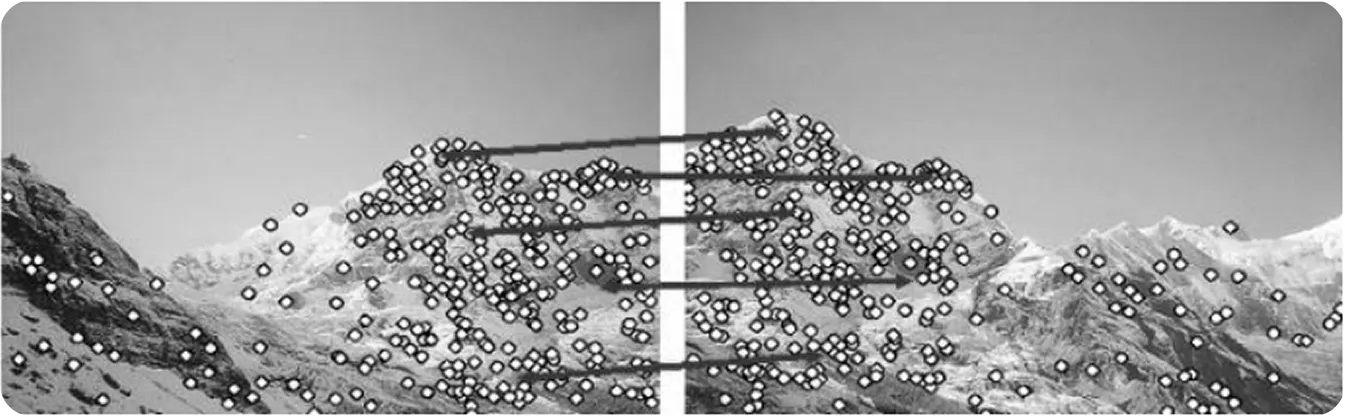

ドローンマッピング、バーチャルリアリティ、建築物検査などの分野では、システムが複数の2D画像から3Dモデルを再構築する必要があることが多い。そのためには、複数の画像にまたがって現れる、角やテクスチャ領域などの共通のキーポイントを特定するための画像マッチングに頼る。

これらの共有点は、システムが3D空間において画像が互いにどのように関連しているかを理解するのに役立つ。この考え方は、異なる視点から撮影された画像間でキーポイントを特定し、マッチングさせることで3D構造を構築する技術であるStructure from Motion(SfM)と密接に関連している。

マッチングが正確でないと、出来上がった3Dモデルが歪んで見えたり、不完全に見えたりする。このため、研究者たちは3D再構成のための画像マッチングの信頼性を向上させることに取り組んでおり、最近の進歩は有望な結果を示している。

興味深い例のひとつが、より高速でロバストな画像マッチングアルゴリズムであるHashMatchだ。HashMatchは、画像の詳細をハッシュコードと呼ばれるコンパクトなパターンに変換し、照明や視点が異なる場合でも、正しいマッチングの識別や異常値の除去を容易にする。

大規模なデータセットでテストしたところ、HashMatchはアライメントエラーが少なく、よりクリーンでリアルな3D再構築モデルを生成した。このため、ドローン・マッピング、ARシステム、文化遺産保護など、精度が重要な用途に特に有用である。

拡張現実(AR)に関しては、仮想オブジェクトを現実世界と一致させることがしばしば課題となる。屋外環境は、太陽光や天候などの環境条件によって常に変化します。現実世界の微妙な違いによって、バーチャルな要素が不安定に見えたり、少しずれて見えたりすることがあります。

この問題を解決するために、ARシステムは画像マッチングを使って周囲の状況を解釈する。ライブカメラフレームと保存された参照画像を比較することで、ユーザーがどこにいて、シーンがどのように変化したかを理解することができる。

例えば、XR(拡張現実)メガネを使用したミリタリースタイルの屋外ARトレーニングに関する研究では、研究者たちはSIFTやその他の特徴ベースの手法を使用して、実画像と参照画像間の視覚的ディテールをマッチングさせた。正確なマッチングにより、ユーザーが素早く動いたり照明が変化したりしても、バーチャル要素は現実世界と正しく位置合わせされた。

画像マッチングはコンピュータビジョンの中核をなす要素であり、システムが異なる画像を互いにどのように関連付けるか、あるいはシーンが時間とともにどのように変化するかを理解することを可能にする。ロボット工学、拡張現実(AR)、3D再構成、自律航法など、精度と安定性が不可欠な多くの実世界アプリケーションで重要な役割を果たしている。

SuperPointやLoFTRのような高度なAIモデルにより、今日のシステムは以前の方法よりもはるかに堅牢になりつつある。機械学習技術、特殊な視覚モジュール、ニューラルネットワーク、データセットが進歩し続けるにつれて、画像照合はより速く、より正確に、より適応的になっていくだろう。

成長中のコミュニティに参加して、GitHubリポジトリで実践的なAIリソースを探索してください。今すぐVision AIを使って構築するには、ライセンスオプションをご覧ください。農業におけるAIがどのように農業を変革しているか、ヘルスケアにおけるVision AIがどのように未来を形成しているかについては、ソリューションのページをご覧ください。