データセット蒸留が、大規模なデータセットを最適化された少数の合成サンプルに置き換えることで、モデルトレーニングを高速化し、計算コストを削減する仕組みを学びましょう。

データセット蒸留が、大規模なデータセットを最適化された少数の合成サンプルに置き換えることで、モデルトレーニングを高速化し、計算コストを削減する仕組みを学びましょう。

モデルを訓練することは、データサイエンティストの仕事の中で最も時間がかかる部分のように思えるかもしれない。しかし実際には、彼らの時間のほとんど(多くの場合60%から80%)は、データの準備作業——収集、クリーニング、モデリングのための整理——に費やされている。データセットが大きくなるほど、この準備時間も増加し、実験の速度を低下させ、反復作業を困難にする。

この課題に対処するため、研究者たちは長年にわたりトレーニングの効率化方法を模索してきた。合成データ、データセット圧縮、最適化手法の改善といったアプローチはすべて、大規模データセットを扱う際のコストと摩擦を低減し、機械学習ワークフローを高速化することを目的としている。

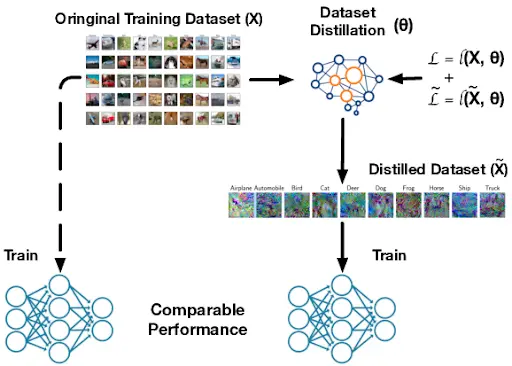

ここで提起される重要な疑問は、データセットを大幅に縮小しながらも、完全なデータでモデルを学習した場合と同等の性能を達成できるかどうかである。データセット蒸留はその有望な解決策の一つである。

大規模なトレーニングデータセットの本質的なパターンを保持しつつ、コンパクトなバージョンを生成します。これにより、トレーニングの高速化、計算リソースの削減、実験の効率化が実現されます。これはモデルのための「学習用カンニングペーパー」と捉えることができ、完全なデータセットと同じ中核パターンを教えるために設計された、ごく少数の合成データ例から成るセットです。

本記事では、データセット蒸留の仕組みと、それが現実世界のアプリケーションにおいてスケーラブルな機械学習および深層学習をどのように支えるかを探ります。さっそく始めましょう!

データセット蒸留とは、大規模な訓練用データセットを、元のデータセットとほぼ同等の情報をモデルに学習させられる、はるかに小規模なデータセットに凝縮するプロセスである。多くの研究者はこのプロセスをデータセット凝縮とも呼ぶ。その目的は、完全なデータセット全体に現れる本質的なパターンを捉えることにあるためである。

蒸留されたデータセットは、ランダムに生成された合成データや、単に実画像の小さな部分集合を選んだものとは異なります。それはランダムな偽データセットでも、元のデータの切り詰めコピーでもありません。

代わりに、最も重要なパターンを捉えるよう意図的に最適化されている。この過程で、すべてのピクセルと特徴量が調整・最適化されるため、蒸留データで訓練されたニューラルネットワークは、あたかも全データセットで訓練されたかのように学習する。

このアイデアは、2018年にTongzhou Wang、Jun-Yan Zhu、Antonio Torralba、Alexei A. EfrosによってarXivに投稿された論文で初めて登場した。初期のテストでは、 MNIST やCIFAR-10といった単純なデータセットを使用しており、数個の蒸留サンプルが数千枚の実画像に代わることを容易に示すことができた。

.webp)

それ以来、後続の研究によりデータセット蒸留はさらに進展し、ICMLやICLRで発表された手法により、凝縮処理の効率性と拡張性が向上している。

データセット蒸留は学習効率を向上させ、開発サイクルを加速させる。モデルが学習する必要のあるデータ量を削減することで、計算要件を低減する。

これは特に、モデルが時間とともに更新される継続的学習、多数のモデル設計がテストされるニューラルアーキテクチャ探索、メモリと電力が限られた小型デバイス上でモデルを実行するエッジトレーニングにおいて有用です。全体として、これらの利点により、データセット蒸留は多くの機械学習ワークフローにおいて、迅速な初期化、素早い微調整、初期プロトタイプの構築に優れた選択肢となります。

データセット蒸留は、合成または人工的に生成された学習サンプルを作成します。これらのサンプルは、モデルが実際のデータで学習するのと非常に似た方法で学習するのを助けます。これは、通常の学習中に3つの主要な要素を追跡することで機能します。

第一に損失関数があり、これはモデルの予測がどれほど誤っているかを示す誤差スコアである。第二にモデルパラメータがあり、これは学習過程で更新されるネットワークの内部重みである。

第三に、学習軌跡がある。これは時間経過とともに誤差と重みが段階的にどのように変化するかを記述するものである。合成サンプルは、モデルがそれらを用いて学習する際に、誤差が低下し、重みが完全なデータセットの場合と同様の方法で更新されるように最適化される。

データセット蒸留プロセスの仕組みを詳しく見てみましょう:

すべてのデータセット蒸留手法は、到達手段として異なるアルゴリズムを用いる場合でも、同じ中核的な考え方に立脚している。ほとんどのアプローチは、性能マッチング、分布マッチング、パラメータマッチングという3つのカテゴリーに分類される。

次に、それぞれを見て、どのように機能するかを確認しましょう。

データセット蒸留における性能マッチングは、モデルが元の完全なデータセットで学習した場合とほぼ同等の精度を達成できる、最適化された小さな訓練セットの作成に焦点を当てる。ランダムな部分集合を選択する代わりに、蒸留されたサンプルは最適化され、それらで訓練されたモデルが元のデータセットで訓練されたモデルと同様の予測、訓練中の損失挙動、または最終的な精度を実現するよう設計される。

メタ学習はこのプロセスを改善するために一般的に用いられる手法である。蒸留されたデータセットは反復的なトレーニングエピソードを通じて更新されるため、多くの可能性のある状況において効果を発揮するようになる。

これらの段階において、本手法は生徒モデルが現在の蒸留サンプルから学習する過程をシミュレートし、その生徒が実データでどの程度良好な性能を発揮するかを確認した後、より優れた教師となるよう蒸留サンプルを調整する。時間の経過とともに、蒸留セットは生徒モデルが異なる初期重みから開始したり異なるアーキテクチャを使用したりする場合でも、高速な学習と強力な汎化能力をサポートすることを学習する。これにより蒸留データセットの信頼性が向上し、単一の学習実行に依存しなくなる。

.webp)

一方、分布一致生成は、実際のデータセットの統計的パターンに一致する合成データを生成する。この手法は、モデルの最終的な精度のみに焦点を当てるのではなく、ニューラルネットワークが学習過程で生成する内部特徴に焦点を当てる。

次に、流通マッチングを推進する二つの手法を見ていきましょう。

単層分布一致法は、ニューラルネットワークの単一層に焦点を当て、実データと合成データに対して生成される特徴量を比較する。これらの特徴量(活性化とも呼ばれる)は、ネットワークのその時点でモデルが学習した内容を捉えるものである。

合成データが類似の活性化を生成するようにすることで、この手法は蒸留されたデータセットが元のデータセットと同様の重要なパターンを反映するよう促す。実際には、選択された層における活性化が実画像からの活性化と密接に一致するまで、合成サンプルは繰り返し更新される。

この手法は、一度に1つの表現レベルのみを整合させるため比較的単純である。特に、深層で多段階の特徴階層を一致させる必要がない小規模なデータセットやタスクにおいて効果を発揮する。単一の特徴空間を明確に整合させることで、単層マッチングは蒸留されたデータセットを用いた学習において安定かつ意味のある信号を提供する。

多層分布マッチングは、実データと合成データの比較を単一の層ではなくニューラルネットワークの複数の層で行うという考え方に基づいています。異なる層は異なる種類の情報を捉えます。初期層では単純なエッジやテクスチャから、深層では形状やより複雑なパターンまでを捉えるのです。

これらの層間で特徴を一致させることで、蒸留されたデータセットはモデルが複数のレベルで学習した内容を反映するよう調整される。ネットワーク全体で特徴を整合させるため、この手法は合成データがクラスを区別するためにモデルが依存するより豊かな信号を保持するのに役立つ。

これは特にコンピュータビジョン、つまりモデルが画像や動画を理解することを学ぶタスクにおいて有用である。有用なパターンが多くの層に分散しているためだ。特徴分布が複数の深さでよく一致する場合、蒸留されたデータセットは元の訓練データの代わりとしてより強力で信頼性の高いものとなる。

データセット蒸留におけるもう一つの重要なカテゴリーはパラメータマッチングである。精度や特徴量分布を一致させる代わりに、モデルの重みが学習中にどのように変化するかを一致させる。蒸留されたデータセットでの学習が実データ学習と同様のパラメータ更新を生むようにすることで、モデルはほぼ同一の学習経路をたどる。

次に、2つの主要なパラメータマッチング手法について順を追って説明します。

シングルステップマッチングは、実データ上でたった1回の学習ステップ後にモデルの重みに生じる変化を比較する手法である。その後、蒸留用データセットを調整し、その上で1ステップ学習したモデルが極めて類似した重み更新を生成するようにする。この手法は単一の更新のみに焦点を当てるため、単純明快で高速に実行できる。

欠点は、1ステップでは学習プロセス全体を反映できない点です。特に、より複雑なタスクでは、モデルがより豊かな特徴量を構築するために多くの更新を必要とします。そのため、シングルステップマッチングは、有用なパターンを素早く捉えられる単純な問題や小規模なデータセットで最も効果を発揮する傾向があります。

対照的に、多段階パラメータマッチングは、モデルの重みが単一の学習ステップではなく、複数の学習ステップにわたってどのように変化するかを検討する。この更新の連続がモデルの学習軌跡である。

蒸留されたデータセットは、モデルが合成サンプルで学習する際、その学習経路が実際のデータ上での経路に近似するように構築される。より長い学習区間を一致させることで、蒸留セットは元の学習プロセスにおける構造をより多く捕捉する。

学習が時間をかけて展開する過程を反映するため、マルチステップマッチングは通常、モデルが有用なパターンを習得するために多くの更新を必要とする大規模または複雑なデータセットでより効果を発揮する。track ステップtrack 計算量は増えるが、単一ステップマッチングよりも汎化性能が高く、より優れた性能を発揮する蒸留済みデータセットを生成することが多い。

主要なディスティレーション手法の理解を深めたところで、次に合成データの生成方法を見ていきましょう。データセットディスティレーションでは、合成サンプルが最も重要な学習信号を捉えるよう最適化されるため、少数のサンプルセットで大規模なデータセットを代替することが可能となります。

次に、この抽出されたデータがどのように生成され評価されるかを見ていきます。

データセット蒸留では、合成ピクセルは多くの学習ステップにわたって更新される。ニューラルネットワークは現在の合成画像から学習し、勾配に基づくフィードバックを送信する。このフィードバックは、各ピクセルが実際のデータセットのパターンにより良く一致するためにどのように変化すべきかを示すものである。

この手法が機能するのは、プロセスが微分可能であるためです(つまり各ステップが滑らかで明確に定義された勾配を持ち、小さなピクセル変化が損失関数の予測可能な変化をもたらす)。これにより、勾配降下法においてモデルが合成データを滑らかに調整することが可能となります。

最適化が進むにつれ、合成画像はモデルが認識する形状やテクスチャを含む意味のある構造を形成し始める。これらの洗練された合成画像は、分類器が学習に必要な主要な視覚的手がかりを捉えているため、画像分類タスクで頻繁に利用される。

蒸留されたデータセットは、それらを用いてモデルを訓練し、その結果を実データで訓練したモデルと比較することで評価される。研究者は検証精度を測定し、合成データセットがクラスを分離するために必要な識別特徴(モデルがクラスを区別するために依存するパターンや信号)を保持しているかどうかを確認する。また、異なる実行やモデル設定における安定性と汎化能力をテストし、蒸留データが過学習を引き起こさないことを保証する。

次に、データが限られている場合や高度に専門的な場合でも、蒸留されたデータセットがトレーニングを高速化し、計算コストを削減しながら高い性能を維持する方法を示す具体例を詳しく見ていきます。

コンピュータビジョンにおいては、画像や動画などの視覚データを理解するモデルを訓練することが目的である。これらのモデルはエッジ、テクスチャ、形状、物体といったパターンを学習し、それらを画像分類、物体検出、セグメンテーションなどのタスクに活用する。視覚課題は照明、背景、視点に多大な変動を伴うため、コンピュータビジョンシステムは通常、良好な汎化性能を得るために大規模なデータセットを必要とし、これが訓練コストの高さと速度の遅さにつながっている。

画像分類のユースケース(医療画像診断、野生生物モニタリング、工場の欠陥検出など)においては、モデルは精度と学習コストの間で厳しいトレードオフに直面することが多い。これらのタスクは通常、膨大なデータセットを扱う必要がある。

データセット蒸留は、元の訓練セットを少数の合成画像に圧縮しつつ、分類器にとって最も重要な視覚的手がかりを保持できる。ImageNetのような大規模ベンチマークでは、蒸留セットが元の画像の約4.2%しか使用せずとも高い分類精度を維持することが実証されている。これは、ごく少数の合成プロキシが数百万の実サンプルに取って代わり、はるかに少ない計算量で実現可能であることを意味する。

ニューラルアーキテクチャ探索(NAS)は、多数の可能なニューラルネットワーク設計を自動的に探索し、特定のタスクに最適な設計を見つける技術である。NASは多数の候補モデルを学習・評価する必要があるため、完全なデータセット上で実行すると時間がかかり、非常に計算負荷が高くなる。

データセット蒸留は、元のデータの主要な学習信号を保持したまま、ごく小さな合成トレーニングセットを生成することで、各候補アーキテクチャの検証を大幅に高速化します。これによりNASは設計を効率的に比較しつつ、良好なアーキテクチャと不良なアーキテクチャの順位付けを合理的に信頼できる水準に保ち、最終モデルの品質を大きく損なうことなく探索コストを削減できます。

継続的学習システムとは、一度だけ学習するのではなく、新しいデータが到着するたびに更新を続けるモデルを指し、高速かつメモリ効率の良い更新が必要である。カメラ、スマートフォン、センサーなどのエッジデバイスも、計算能力とストレージ容量に制約があるため、同様の限界に直面している。

データセット蒸留は、大規模な訓練セットを小さな合成セットに圧縮することで両方のケースに役立ちます。これにより、モデルは完全なデータセットではなく小さなリプレイセットを使用して適応または再訓練できます。例えばカーネルベースのメタ学習研究では、わずか10個の蒸留サンプルで標準的な画像分類ベンチマークであるCIFAR-10において64%以上の精度を達成できることが示された。リプレイセットが極めてコンパクトなため、特にモデルを頻繁に更新する必要がある場合、更新プロセスが大幅に迅速かつ実用的なものとなる。

大規模言語モデルでは、データセット蒸留を知識蒸留と併用することも可能です。蒸留された小さなデータセットは教師モデルからの最も重要なタスク信号を保持できるため、圧縮された生徒モデルは性能を大きく損なうことなく効率的に学習または更新できます。これらのデータセットは極めて小さいため、ストレージや演算能力が限られているエッジ環境やデバイス上での利用において特に有用です。更新後もモデルの精度を維持したい場合に適しています。

データセット蒸留を使用するメリットは以下の通りです:

データセット蒸留にはいくつかの利点がある一方で、留意すべき制限事項は以下の通りです:

データセット蒸留により、少数の合成サンプルで完全なデータセットと同等の効果でモデルを学習させることが可能となる。これにより機械学習は高速化・効率化され、スケーリングも容易になる。モデルの規模拡大に伴いデータ量が増加する中、蒸留データセットは精度を損なうことなく計算コストを削減する実用的な手段を提供する。

コミュニティに参加し、GitHubリポジトリをチェックしてAIについてさらに学びましょう。独自のビジョンAIプロジェクトを構築したい場合は、 ライセンスオプションをご覧ください。ソリューションページでは、医療分野におけるAIや小売業向けビジョンAIなどの応用事例について詳しく紹介しています。