単眼深度推定の仕組み、センサーベースの深度推定手法との比較、およびビジョンシステムにおけるスケーラブルな3D知覚の実現方法について学びます。

単眼深度推定の仕組み、センサーベースの深度推定手法との比較、およびビジョンシステムにおけるスケーラブルな3D知覚の実現方法について学びます。

自動運転車は周囲の状況を理解し、安全に走行できるように設計されている。これは単に歩行者や他の車両といった物体を認識するだけにとどまらない。

また、物体がどれほど離れているかを把握しなければ、適切に対応できません。しかし、機械にこの距離感覚を与えるのは容易ではありません。人間とは異なり、機械は画像から自然に奥行きを認識せず、その方法を明示的に教え込まなければならないのです。

その背景にある理由の一つは、ほとんどのカメラが世界を平坦な二次元画像として捉える点にある。それらの画像を現実世界の奥行きや3D構造を反映したものに変換するのは困難であり、特にシステムが日常的な環境で確実に動作する必要がある場合にはなおさらである。

興味深いことに、視覚データの解釈と理解に焦点を当てたAIの一分野であるコンピュータビジョンは、機械が画像から世界をより良く理解することを可能にします。例えば、単眼深度推定は、単一のカメラ画像のみを用いて物体の距離を推定するコンピュータビジョン技術です。

物体のサイズ、遠近法、質感、陰影といった視覚的手がかりを学習することで、これらのモデルはLiDAR(光検出と測距)やステレオカメラといった追加センサーに依存せずに深度を推定できます。本記事では、単眼深度推定とは何か、その仕組み、そして実際の応用例について探っていきます。さっそく始めましょう!

単眼深度推定は、単一の画像のみを用いて物体までの距離を機械が理解することを可能にする。単一のカメラに依存するため、この手法には低コストやハードウェア要件の簡素化など、いくつかの利点がある。

例えば、単一カメラで動作する手頃な価格の家庭用ロボットに応用できる。単一の画像からでも、ロボットシステムはどの壁が近く、どのドアが遠くにあるかを識別し、空間全体の奥行きを推定できる。

多くの場合、単一の画像には適切なスケールでの情報が含まれていないため、単眼深度推定は一般的に相対的な深度に焦点を当てます。つまり、正確な距離がわからなくても、どの物体が近く、どの物体が遠くにあるかを判断できるのです。

モデルがLiDARなどのセンサーによる深度測定値のような、真値距離または絶対深度を含むデータで学習されると、メートルなどの実世界単位での距離予測を学習できます。この種の参照データがなくても、モデルは相対的な深さを推測できますが、絶対距離を確実に推定することはできません。

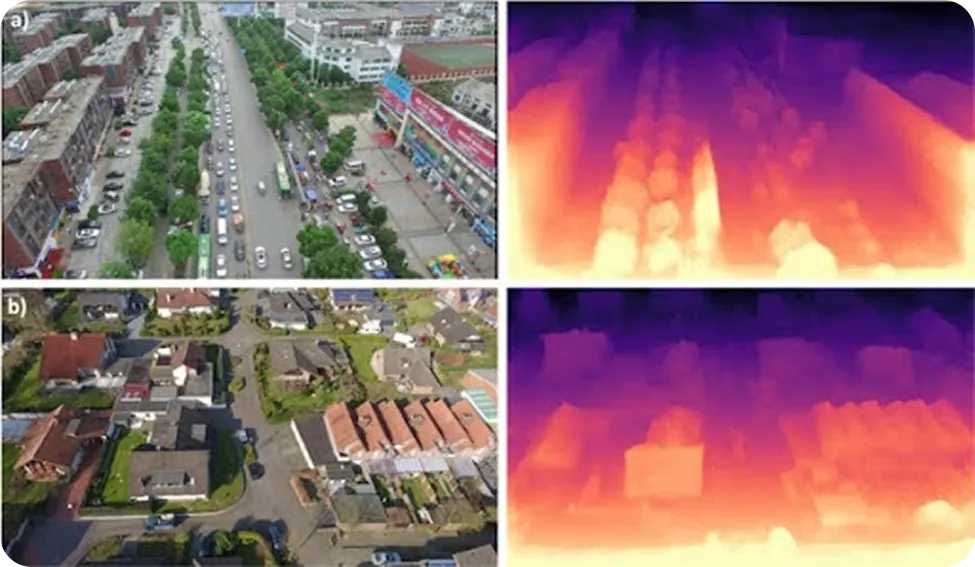

単眼深度推定の出力は通常、深度マップである。これは各ピクセルがシーンのその部分がどれほど近いか遠いかを表す画像である。深度マップは、視覚システムに環境の3D構造に関する基本的な理解を提供する。

深度推定は、利用可能なセンサー、ハードウェアの制約、精度要件に応じて、いくつかの方法でアプローチできる。従来の方法は、複数の視点や距離を直接測定する専用センサーに依存することが多い。

一般的な手法の一つがステレオビジョンであり、わずかに異なる視点から撮影された2つの同期画像を比較することで深度を推定する。2つの画像における対応する点間の差を測定することで、システムは物体がカメラからどれほど離れているかを推測できる。

別のアプローチとして、RGB-D(赤、緑、青、および深度)システムがある。これはアクティブ深度センサーを用いて各ピクセルの距離を直接測定する。これらのシステムは制御された環境下で正確な深度情報を提供できるが、追加のハードウェアを必要とする。

一方、LiDARベースの手法はレーザーパルスを用いて、シーンの精密な三次元表現を生成する。非常に高精度である一方、LiDARセンサーは高価なことが多く、ハードウェアの複雑さを大幅に増す。

一方、単眼深度推定は単一のRGB画像のみを用いて深度を推定する。複数のカメラや専用センサーに依存しないため、大規模展開が容易であり、コストやハードウェアリソースが限られている場合に適した選択肢である。

単一画像から深度を推定する際、単眼深度モデルは人間が距離を判断する際に本能的に用いる視覚的手がかりを認識することを学習する。これらの手がかりには遠近法線、物体の大きさ、テクスチャ密度、物体の重なり、陰影が含まれ、いずれも物体がカメラからどれほど離れているかについてのヒントを提供する。

これらの手がかりが組み合わさることで奥行き感が生まれます。小さく見える物体や部分的に遮られている物体は通常より遠くにあり、より鮮明な細部や大きな視覚的印象は通常、物体がより近くにあることを示唆します。

これらのパターンを学習するため、単眼深度モデルは大規模な画像データセットで訓練される。多くの場合、LiDARやステレオシステムなど他のソースから得られた深度情報と組み合わせて使用される。訓練中、モデルは視覚的手がかりと深度との関係を学習し、推論時に単一の画像から距離を推定できるようにする。

多様な訓練データを用いることで、現代のビジョンモデルは屋内・屋外シーンを含む幅広い環境において学習した理解を一般化でき、未知の視点にも対応できる。

次に、単一の画像から深度を推定するために用いられる主な手法と、これらの手法が時間とともにどのように進化してきたかを探ります。

初期の深度推定手法は、カメラの幾何学に結びついた単純な視覚的規則に依存していた。遠近法、物体の大きさ、ある物体が別の物体を遮っているかどうかといった手がかりが距離の推定に用いられた。

例えば、2つの類似した物体が異なる大きさで現れた場合、小さい方がより遠くにあると推測された。こうした手法は、照明やカメラ位置、シーンのレイアウトといった要素が一貫して保たれる制御された環境では、かなりうまく機能した。

しかし、現実世界のシーンでは、これらの仮定はしばしば破綻する。照明の変化、視点の変化、シーンの複雑さの増加は、深度推定の信頼性を損ない、制御されていない環境における古典的手法の有効性を制限する。

初期の機械学習手法は、データから直接パターンを学習することで深度推定に柔軟性をもたらした。固定された幾何学的規則のみに依存する代わりに、これらのモデルは視覚情報と距離の関係を学習しようと試み、エッジやテクスチャ、色の変化といった手がかりに基づく回帰問題として深度予測を扱った。

これらの特徴を選択することはプロセスの重要な部分であった。エンジニアはどの視覚信号を抽出するか、そしてそれらをどのように表現するかを決定しなければならず、モデルの性能はそれらの選択に大きく依存していた。

この手法は従来の方法より優れていたものの、依然として限界があった。選択された特徴に重要な文脈が欠けている場合、深度予測の精度は低下した。シーンがより複雑で多様になるにつれ、これらのモデルは信頼性の高い結果を生成するのに苦労することが多かった。

現代のほとんどの単眼深度推定システムは、データから複雑なパターンを学習できる多層ニューラルネットワークを指す深層学習を利用している。これらのモデルは画像から直接深度を予測し、深度マップを生成することを学習する。

多くの手法は畳み込みニューラルネットワーク(CNN)を用いて構築されている。CNNはエッジや形状などのパターンを検出することで画像を処理するように設計されたニューラルネットワークの一種である。これらのモデルはしばしばエンコーダ-デコーダ構成を採用する:エンコーダが画像から視覚的特徴を抽出し、デコーダがそれらの特徴を深度マップに変換する。画像を複数のスケールで処理することで、モデルはシーン全体のレイアウトを捉えつつ、明確な物体の境界も捉えることができる。

より新しいモデルは、画像内の異なる部分間の関係性を理解することに焦点を当てている。トランスフォーマーベースおよびビジョントランスフォーマー(ViT)モデルは、アテンション機構を採用している。これによりモデルは画像内のどの領域が最も関連性が高いかを特定し、離れた領域同士を関連付けることができる。これはモデルがシーン全体にわたる奥行きについて、より一貫性のある理解を構築するのに役立つ。

一部のシステムは両方のアイデアを組み合わせています。ハイブリッドCNN-トランスフォーマーモデルは、CNNを用いて局所的な細部を捉え、トランスフォーマーを用いてシーンの全体的な文脈をモデル化します。これにより精度が向上することが多い一方で、追加のメモリや処理能力など、より多くの計算リソースが必要となるのが一般的です。

単眼による深度推定について学ぶ中で、なぜ深度理解が視覚ベースのAIシステムにおいてそれほど重要な要素なのか、疑問に思うかもしれません。

システムが物体や表面までの距離を推定できる場合、シーンの配置や異なる要素間の関係性をより深く理解できるようになる。この種の空間認識能力は、特に自動運転のような実世界アプリケーションにおいて、信頼性の高い意思決定を行うために不可欠である。

深度情報は他のコンピュータビジョンタスクにも貴重な文脈を追加する。例えば、Ultralytics のようなモデルでサポートされる物体検出は、シーン内に何が存在するかをシステムに伝えることができるが、深度情報はそれらの物体がカメラや互いに対して相対的にどこに位置しているかを解明するのに役立つ。

これらの機能を組み合わせることで、3Dマップの構築、複雑な環境のナビゲーション、シーン全体の理解など、幅広いビジョンAIアプリケーションが可能になります。

ロボットや自動運転車は、安全に移動し、障害物を回避し、変化にリアルタイムで対応するためにこの情報に依存している。例えば、テスラの視覚のみによる運転アプローチは、物体の距離や道路上の位置を把握するために、LiDARではなくカメラ画像と深度推定を組み合わせた手法を採用している。

モデルアーキテクチャは様々ですが、ほとんどの単眼深度推定モデルは、単一の画像を深度マップに変換する際に類似したプロセスに従います。主な手順の概要は以下の通りです:

先ほど説明したプロセスは、既に学習済みまたは事前学習済みモデルが存在することを前提としています。では、単眼深度推定モデルの学習は実際にどのように行われるのでしょうか?

トレーニングは、ネットワークが効率的に処理できるよう画像データを準備することから始まります。入力画像はリサイズされ、一貫したスケールに正規化されます。その後、モデルを通過させて予測深度マップを生成し、各ピクセルでの距離を推定します。

予測された深度マップは、損失関数を用いて参照深度データと比較される。この損失関数は、モデルの予測値が真の深度からどれだけ離れているかを測定する。この損失値はモデルの現在の誤差を表し、改善のための指標を提供する。

最適化アルゴリズムはこの信号を用いて、内部重みを調整することでモデルを更新する。このため、最適化アルゴリズムは損失関数が各モデルパラメータに対してどのように変化するかを記述する勾配を計算し、これらの更新を複数のエポック(訓練データセット全体を通した完全なパス)にわたって繰り返し適用する。

この反復的な教師あり学習のトレーニングプロセスは、学習率(各更新ステップの大きさを制御する)やバッチサイズ(一度に処理する画像数を決定する)といったハイパーパラメータによって導かれる。トレーニングには膨大な数の数学的演算が伴うため、通常は並列計算に優れたグラフィックス処理装置(GPU)を用いて高速化される。

トレーニングが完了すると、モデルは検証データセットを用いて標準的な評価指標で評価される。検証データセットはトレーニング中に使用されなかった画像で構成される。この評価により、モデルが新規データに対してどの程度一般化できるかを測定できる。

訓練済みモデルは、新たなシナリオ向けに再利用または微調整が可能である。全体として、この訓練プロセスにより単眼深度推定モデルは一貫した深度推定値を生成でき、これは3D再構築や実世界での展開といった下流タスクに不可欠である。

単眼深度推定は、モデルが小さな視覚的詳細だけでなくシーン全体を理解する能力を高めるにつれ、急速に進歩した。従来の手法では、特に複雑な環境において不均一な深度マップが生成されることが多かった。

arXivに掲載された最近の研究で見られるように、新しいモデルはよりグローバルな文脈に焦点を当てており、これにより深さの予測がより安定し現実的に見えるようになっている。MiDaSやDPTといった著名なモデルは、多様で高解像度のデータセットから深さを学習し、多くのシーンにわたって良好に汎化することで、この変化を推進した。

より新しいモデル(ZoeDepthやDepth Anything V2など)は、この研究を基盤としつつ、幅広い設定条件で高い性能を維持しながらスケールの一貫性を向上させています。この種の進歩は、屋外と屋内の両方のシーンを網羅するKITTIやNYUといった一般的なベンチマークデータセットを用いて測定されることがよくあります。

もう一つの明確な傾向は、精度と実用性のバランスを取ることである。小型モデルは速度を最適化しており、エッジデバイスやモバイル端末でリアルタイムに動作できる。一方、大型モデルは高解像度と長距離深度精度を優先する。

次に、単眼深度推定が単一画像からシーンの3D構造を推論するためにどのように利用されるかを示す、実際の事例をいくつか見ていきましょう。

いずれの場合においても、深度情報は視覚的手がかりから推定された値であり、正確な測定値ではないことを念頭に置くことが重要です。この特性により、単眼深度推定は相対的な配置や空間関係の理解には有用ですが、LiDARやステレオシステムなど、距離を正確に測定するために設計されたセンサーの代替とはなりません。

ドローンは、森林、建設現場、災害地域、密集した都市部など、GPS信号が不安定な環境で運用されることが多い。こうした条件下で安全に飛行するには、周囲の地形を把握し、障害物までの距離を認識する必要がある。従来は、LiDARやステレオカメラなどのセンサーを追加する必要があり、これにより重量、消費電力、総コストが増加していた。

単眼深度推定はより簡便な代替手段である。単一のRGBカメラのみを使用し、ドローンは画像から深度を推定し、環境の基本的な3D理解を構築できる。これにより建物や樹木、急な地形変化などのdetect 、飛行経路をリアルタイムで調整することが可能となる。

これらの深度推定値は、障害物回避、高度制御、安全な着陸といった主要な航法タスクを支えています。その結果、軽量ドローンは専用の深度センサーに依存することなく、マッピング、点検、航法タスクを実行できます。

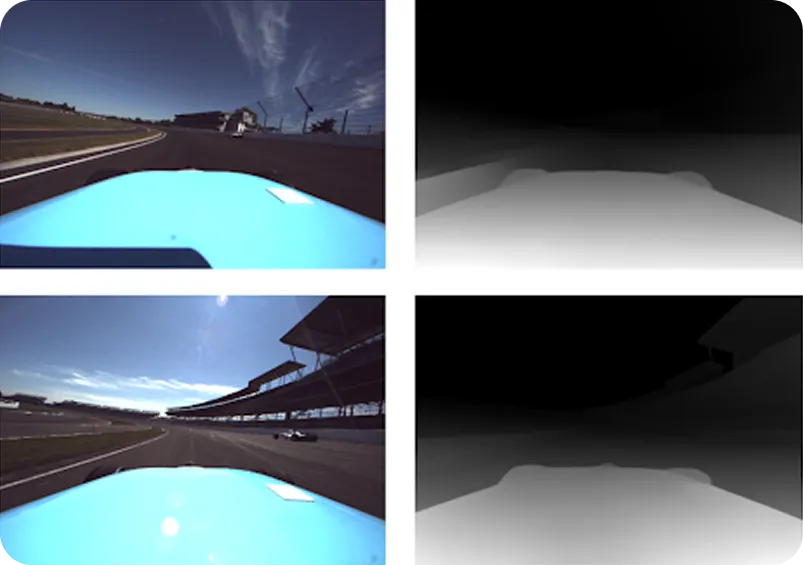

自動運転車は通常、LiDARセンサーに大きく依存している。LiDARはレーザーパルスを用いて距離を測定し、道路の3D視覚化を行う。非常に高精度ではあるものの、LiDARは急峻な道路の頂点、急勾配、遮蔽物、または車両の急激なピッチングに苦戦することがあり、疎な深度データや欠落した深度データを返すことがある。

単眼深度推定は、LiDARデータが不完全な場合でも単一のRGB画像から高密度な深度情報を提供することで、こうしたギャップを埋めるのに役立ちます。自動運転車が高速で丘の頂上付近に接近している状況を想定してください。LiDARビームは頂上の向こう側の道路をオーバーシュートする可能性があり、前方の状況が不確実なままとなります。

カメラベースの深度推定は、それでも遠近法やテクスチャといった視覚的手がかりから道路形状を推測でき、LiDARデータが安定するまで車両が信頼性の高い知覚を維持するのに役立つ。LiDARと単眼深度推定を組み合わせることで、困難な運転条件下でもより安定した知覚と安全な制御が可能となる。

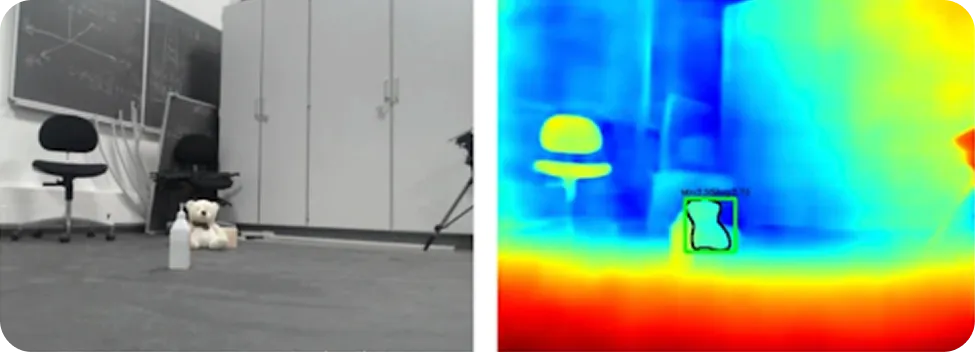

ロボットは、詳細な地図が利用できない場所で運用されることが多く、状況は絶えず変化する。安全に移動するためには、周囲の空間の広さや障害物の位置を確実に把握する必要がある。

単眼深度推定は、単一のRGBカメラを用いて、重く高価なハードウェアに依存することなく、この空間認識を提供できる。スケールや遠近法といった視覚的手がかりを学習することで、深度推定モデルは周囲の密な深度マップを生成できる。これによりロボットは、表面や物体までの距離を明確に把握できる。

特に、深度情報を物体 検出やセマンティックセグメンテーションといったコンピュータビジョンタスクと組み合わせることで、ロボットは環境をより包括的に把握できるようになる。物体を識別し、距離を把握し、安全に移動できる場所を判断できる。これにより、障害物回避、空きスペース検出、リアルタイム経路計画が実現される。

単眼深度推定を使用する主な利点の一部は以下の通りです:

単眼深度推定には明らかな利点がある一方で、考慮すべき制限事項がいくつかあります:

単眼による深度推定は興味深い研究分野ではあるが、実用的に適用可能な領域と不可能な領域を理解することが重要である。この手法が生成する距離値は、モデルが画像内で認識した内容に基づく推定値であり、現実世界から直接測定された正確な値ではない。

このため、照明やシーンの複雑さ、モデルが学習した対象との類似度といった要因によって結果の品質が変化する可能性があります。単眼深度推定は通常、近いものと遠いものの判別には優れていますが、正確な距離が必要な場合には信頼性が低くなります。

安全上極めて重要なシステム、産業用検査、あるいは物体と非常に精密に相互作用する必要があるロボットなど、精度が本当に重要な状況では、深度を直接測定する必要があります。LiDAR、レーダー、ステレオカメラ、構造化光システムなどのセンサーは、この目的のために設計されており、より信頼性の高い距離情報を提供します。

単眼による深度推定は、視覚的に困難な条件下でも苦戦することがある。照明不足、強い影、反射面や透明面、霧、煙、あるいは視覚的な質感が極めて少ないシーンは、いずれも深度推定の信頼性を低下させる。長距離での深度推定もまた、専用のセンサーの方が通常はより優れた性能を発揮するケースである。

実世界のソリューションにおいては、単眼深度推定は単独の解決策というより補助ツールとして最も効果を発揮する。有用な空間的文脈を追加し、他のセンサーが制限される場合の不足を補い、シーン全体の理解を向上させることができる。ただし、精度や安全性、厳格な信頼性が求められる場合には、深度情報の唯一のソースとしては不適切である。

単眼深度推定は、単一カメラ画像のみを用いて物体までの距離を推定するコンピュータビジョン技術である。遠近法、物体の大きさ、テクスチャ、陰影といった視覚的手がかりを学習することで、これらのAIモデルはLiDARやステレオカメラなどのセンサーに依存せず、シーンの3D構造を推論できる。これにより単眼深度推定は、自動運転、ロボティクス、3Dシーン理解などの応用分野において、費用対効果に優れ拡張性のある手法となる。

ビジョンAIについてさらに詳しく知りたい方は、当社のGitHubリポジトリをご覧いただき、コミュニティにご参加ください。ロボット工学におけるAIや 製造業におけるコンピュータビジョンについては、ソリューションページをご覧ください。コンピュータビジョンを今すぐ始めるためのライセンスオプションもご確認ください!