Ultralytics YOLO11使用したAI搭載ドローンアプリケーションの構築方法を学び、リアルタイムの物体検出とドローンベースのコンピュータビジョンタスクを実現します。

Ultralytics YOLO11使用したAI搭載ドローンアプリケーションの構築方法を学び、リアルタイムの物体検出とドローンベースのコンピュータビジョンタスクを実現します。

実店舗での買い物とオンラインショッピングは似ているように見えるかもしれませんが、異なるロジスティクスに依存しています。店舗は棚の補充が必要ですが、オンライン注文は玄関先までの配達に依存しています。技術の進歩のおかげで、両方のショッピング体験は並行して再構築されています。

例えば、配達に大きな変化が起きています。AI搭載のドローンが、製品が私たちの家に届く方法を変えています。これらのスマートドローンは、今後10年間で約8億800万件の配達を処理すると予想されており、空を日常の商取引のための最新の配達ルートに変えています。

配送ドローンは、人工知能(AI)と、視覚データを分析するために使用されるAIのサブフィールドであるコンピュータビジョンを使用して、障害物を回避して操縦する。以下のようなコンピュータ・ビジョン・モデル Ultralytics YOLO11のようなコンピュータビジョンモデルは、ドローンがリアルタイムで物体をdetect ・track するのを助け、ドローンが環境をよりよく理解し、相互作用できるようにします。

美団 (Meituan)やDJIなどの企業は、すでにコンピュータビジョンをドローンに統合しています。実際、さまざまな業界でのドローンの急速な採用により、AIドローン市場は2031年までに2,069億ドルに急成長すると予測されています。

この記事では、Ultralytics YOLO11 ようなコンピュータビジョンモデルが、ドローン配送のようなドローンベースのアプリケーションでどのように使用できるかを詳しく見ていきます。実世界のシナリオで使用される前に、これらの技術がどのように開発され、テストされるかを紹介する例を紹介します。

宅配ドローンの重要な部分は、航行中に家屋をdetect する能力である。この機能を再現し、その仕組みを理解するために、空撮ドローンが捉えた映像から家屋を識別できるコンピューター・ビジョン・モデルをトレーニングする。YOLO11 カスタムトレーニングし、ラベル付けされた例を使用して家を認識・detect するように、事前にトレーニングされたYOLO11 モデルを微調整する。

そのためには、ドローンからの高品質なビデオデータが必要です。興味深いことに、実際のドローンにアクセスできなくても、リアルな航空映像を生成できます。その方法を見てみましょう。

Google Earth Studioは、Google Earthの衛星画像や3D画像を使って静止画やアニメーションを作成できるウェブベースのアニメーションツールです。リアルな空撮映像の作成に利用できる。

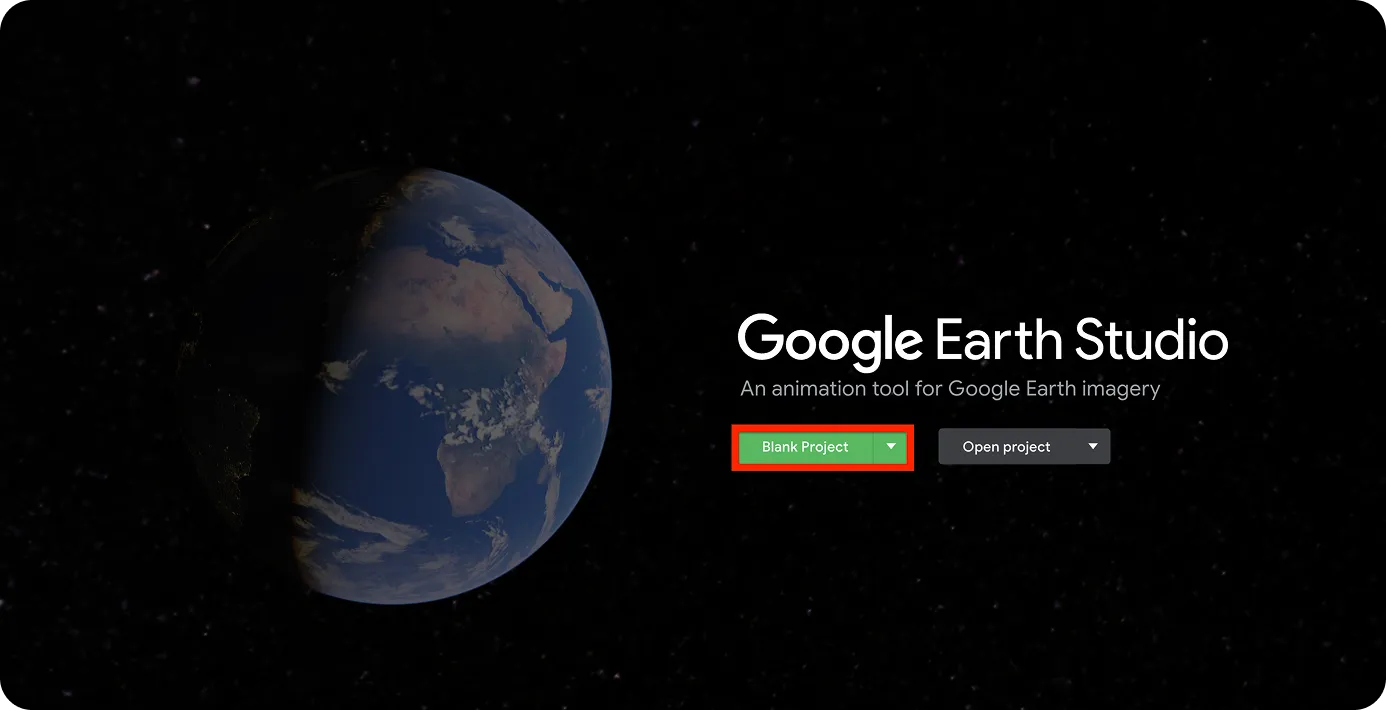

最初のステップは、Google Earth Studioを開き、以下のようにプロジェクトを作成することです。

ログインにはGoogle アカウントが必要です。

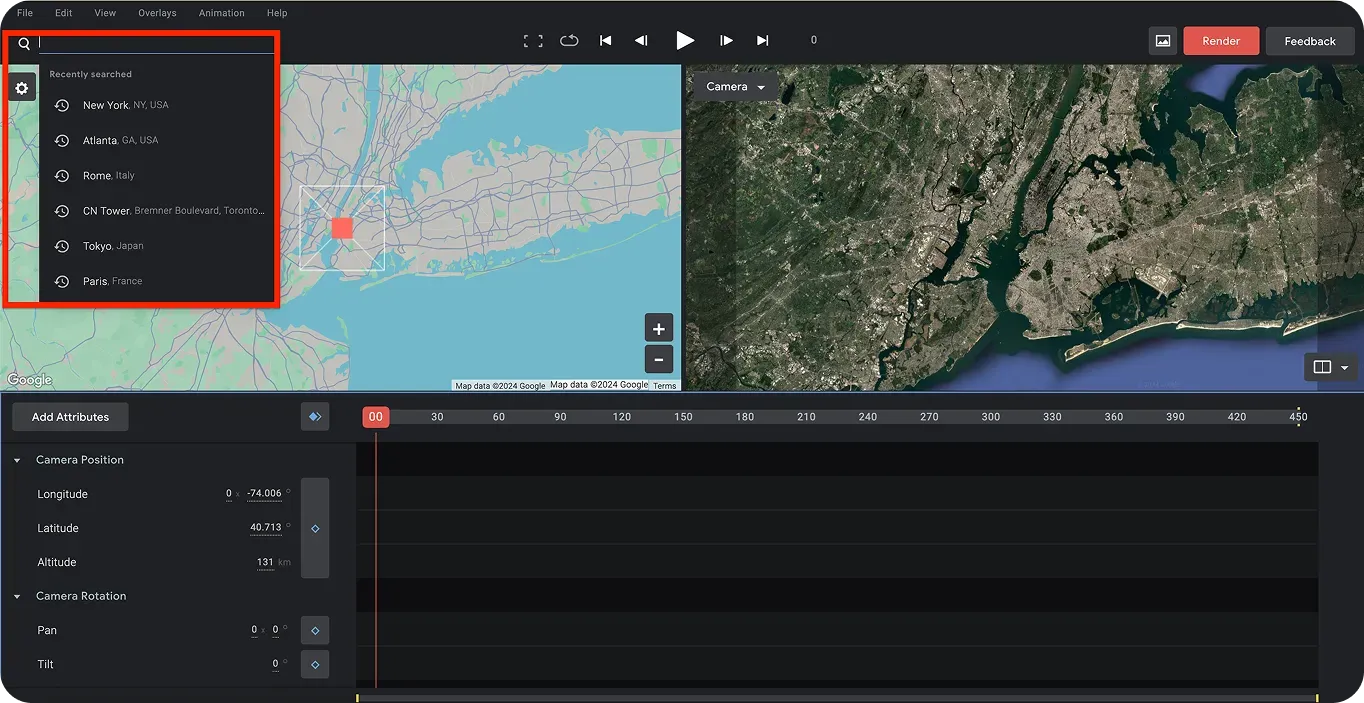

サインインしたら、人工ドローン動画の撮影場所を選ぶことができる。ページ左上の検索バーを使って場所を検索できる。このチュートリアルでは、カナダを選択する。また、家屋をdetect するモデルをトレーニングするため、ドローン映像は家屋の空撮映像でなければならない。

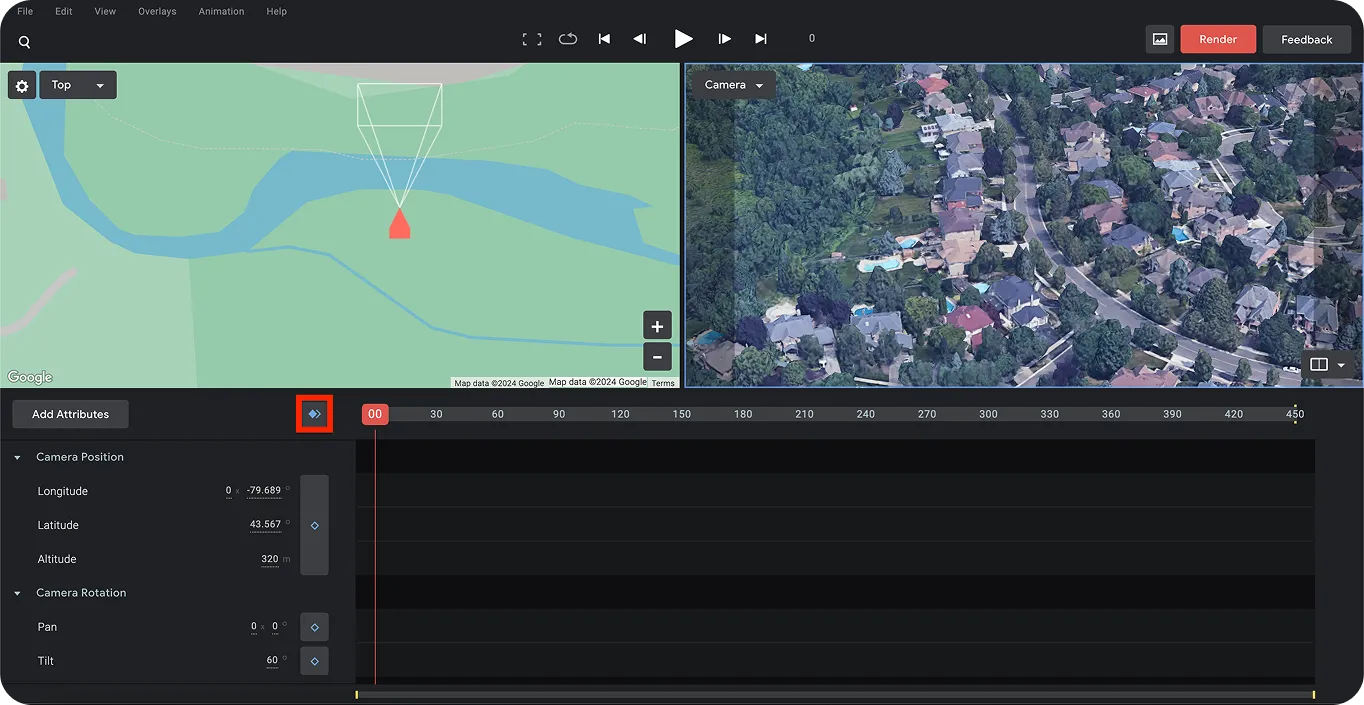

次に、人工ドローンショットの動きをキャプチャするために、最初と最後のタイムフレームを設定できます。ドローンショットの開始場所を選択したら、以下に示すように、青いひし形を使用して最初のフレームを設定します。

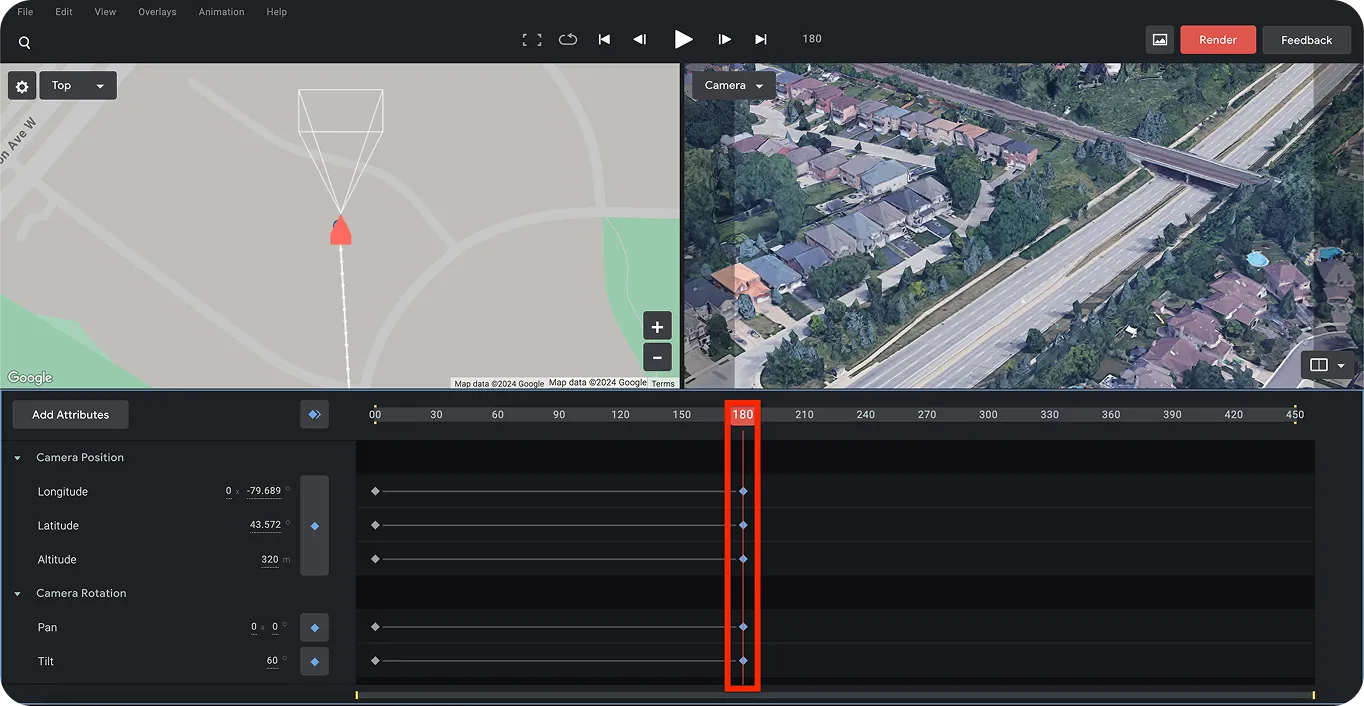

次に、ドローンの目的地を決定するために、最後のフレームを選択できます。これは、ドローン映像に動きの効果を作成するのに役立ちます。これを行うには、(以下に強調表示されている)バーを右にスライドさせて、ドローンショットに動きの効果を作成するために特定の時間に移動します。もう一度、青いひし形を使用して最後のポイントを設定します。

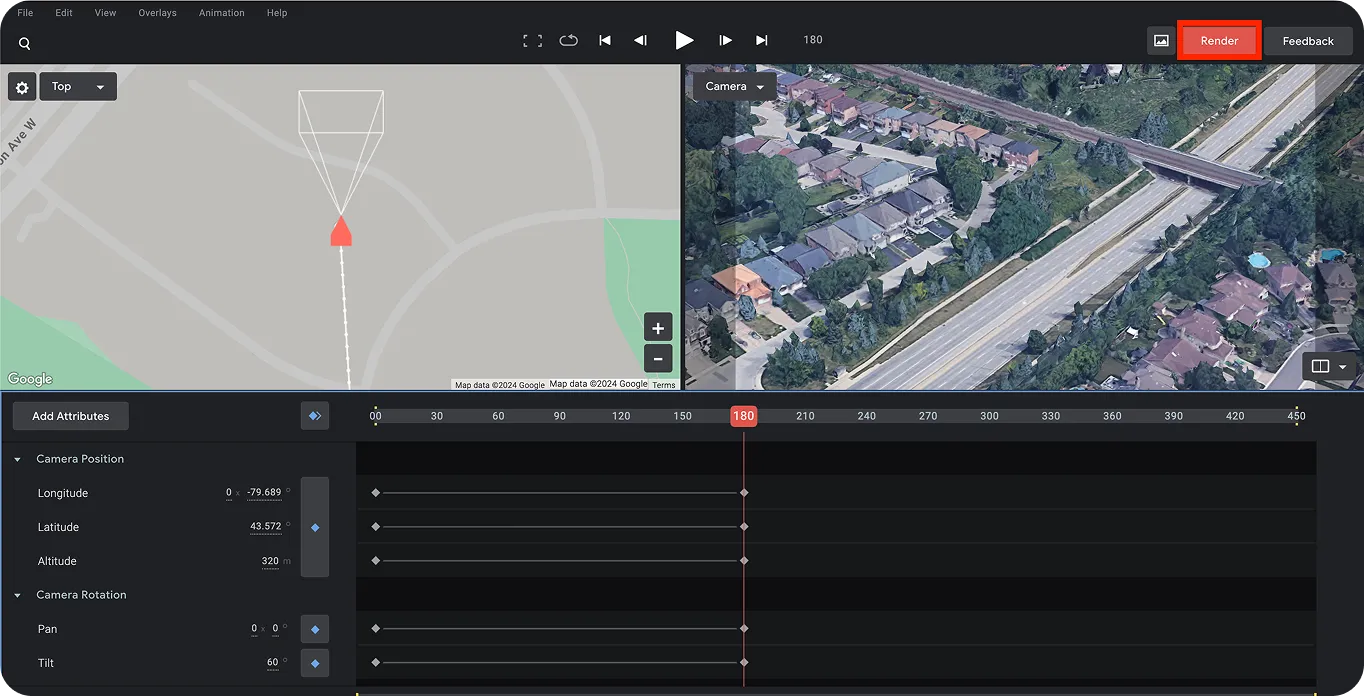

最後に、このプロジェクトを保存し、ページ右上隅にある赤い「Render」ボタンをクリックしてレンダリングできます。これにより、ドローンショットの最終的なビデオ出力が得られ、人工的なドローンビデオ映像が正常に作成されます。

人工的なドローンビデオ映像を作成したので、次のステップは、その中の住宅にラベル付けまたはアノテーションを付けることです。また、ビデオの個々のフレームを分離する必要があります。

まず、LabelImgをインストールします。LabelImgは、オープンソースの画像ラベリングツールです。ターミナルからpipパッケージインストーラーを使用して直接インストールするには、次のコマンド「pip install labelImg」を実行します。

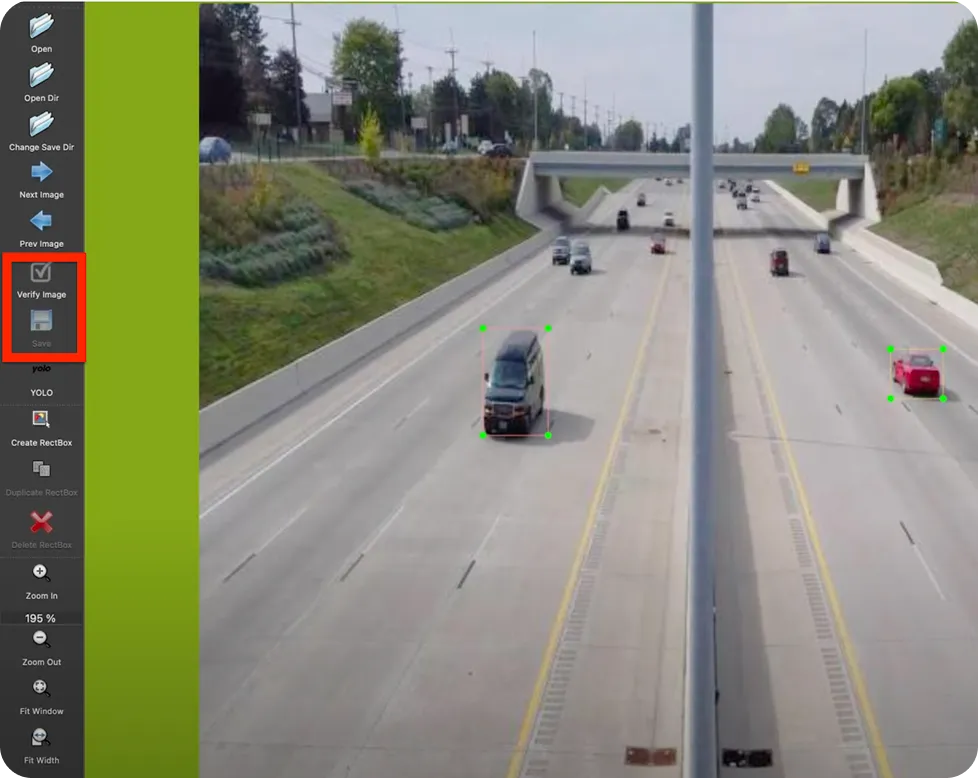

インストール後、ターミナルまたはコマンドプロンプトでコマンド「labelImg」を使用してツールを実行できます。これにより、以下に示すページが表示されます。

一方、オンラインの動画-画像変換ツールか、FFmpegと呼ばれるツールを使用して、動画をフレームに分割できます。FFmpegは、オーディオ、ビデオ、字幕、および関連するメタデータなどのマルチメディアコンテンツを処理するためのライブラリとツールのコレクションです。

次のターミナルコマンドを使用して、ドローン映像ビデオの各フレームを分離できます。

ドローン映像のフレームを分離したら、その中のオブジェクト(家)にラベルを付け始めることができる。LabelImgツールで画像フォルダに移動し、各画像のオブジェクトにラベルを付ける。ラベル付けした画像は必ず保存して確認すること。画像に注釈を付けたら、このデータを使ってYOLO11 トレーニングに移ります。

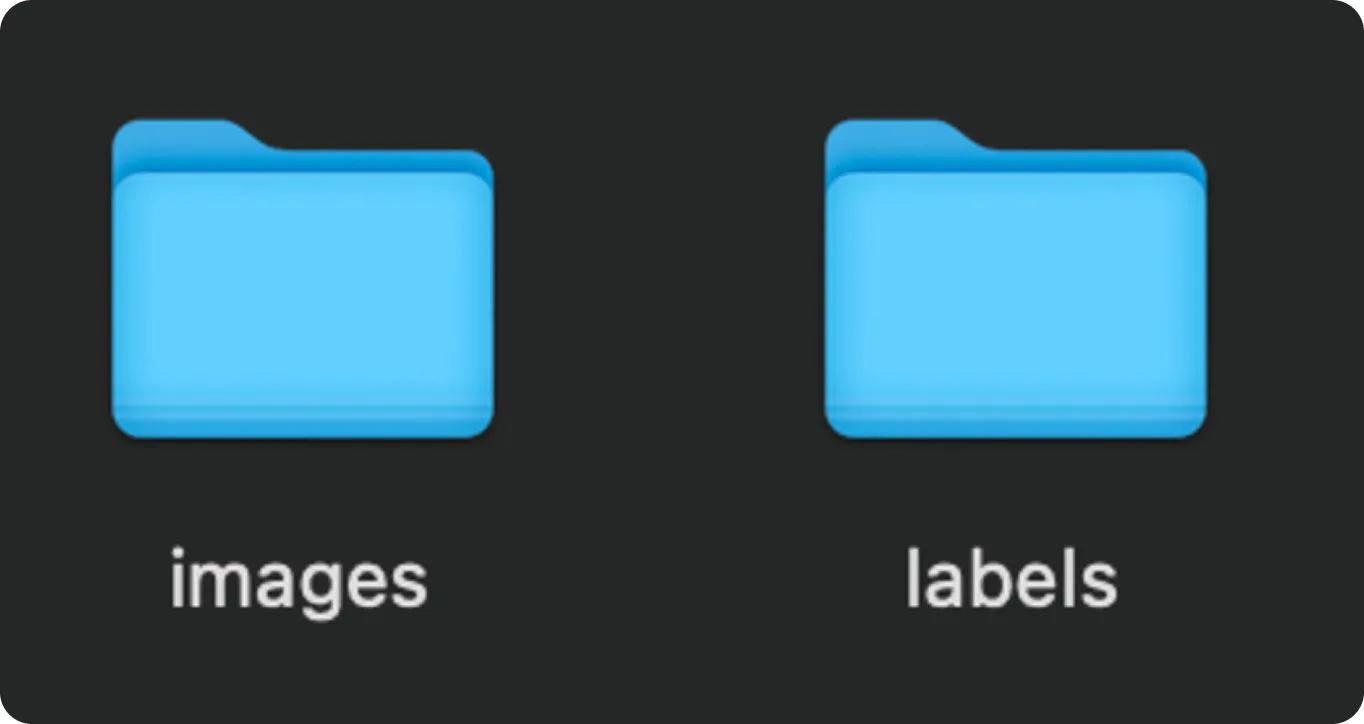

YOLO11トレーニングを始める前に、画像とラベルを整理します。train "と "valid "の2つのフォルダを作る。これらのフォルダに画像を分割します。それぞれのフォルダの中に、画像とそれに対応するラベルファイル(テキスト形式)のサブフォルダを以下のように分けて作成します。

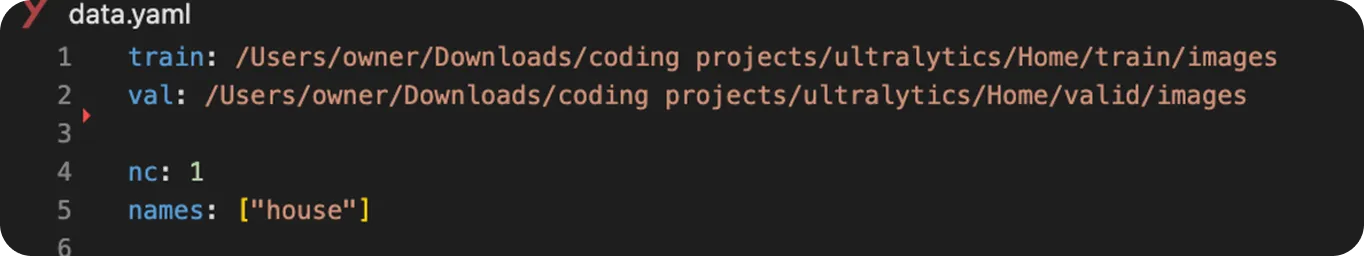

次に、YOLO11 モデルのトレーニングを次のように開始する:

from ultralytics import YOLO

# Load a YOLO11 model

model = YOLO("yolo11n.pt") # choose your model, e.g., YOLO11 nano

# Train the model with your data and settings

model.train(data="data.yaml", epochs=100, imgsz=640)

学習されたYOLO11 モデルは、推論と呼ばれるプロセスを通じて予測を行うことができる。推論とは、学習中に学習した内容に基づいて、新しい未知のデータを分析するためにモデルを使用することである。この場合、モデルを使って、画像や動画から家などの特定のオブジェクトを見つけ、その周りにバウンディング・ボックスを描くことでラベル付けすることができる。

予測を実行するには、以下のPython コードを使用して、入力ビデオに学習済みYOLO11 モデルを使用することができます。この例では、トレーニングに使用したのと同じ人工ドローンのビデオを使用しますが、お好みで他のビデオファイルを使用することもできます。

# Import library

from ultralytics import YOLO

# Load the YOLO model

model = YOLO("best.pt") # Choose your custom-trained model

# Predict the results from the model

results = model.predict(source="path/to/original/video.mp4", show=True, save=True)このコードを実行すると、予測とバウンディングボックスを含む出力ビデオファイルが保存されます。

ドローン宅配荷物の家屋検出は、コンピュータ・ビジョンとYOLO11 どのように応用できるかの一例に過ぎない。その他、コンピュータビジョン、YOLO11、ドローンの実際の使用例をいくつかご紹介します:

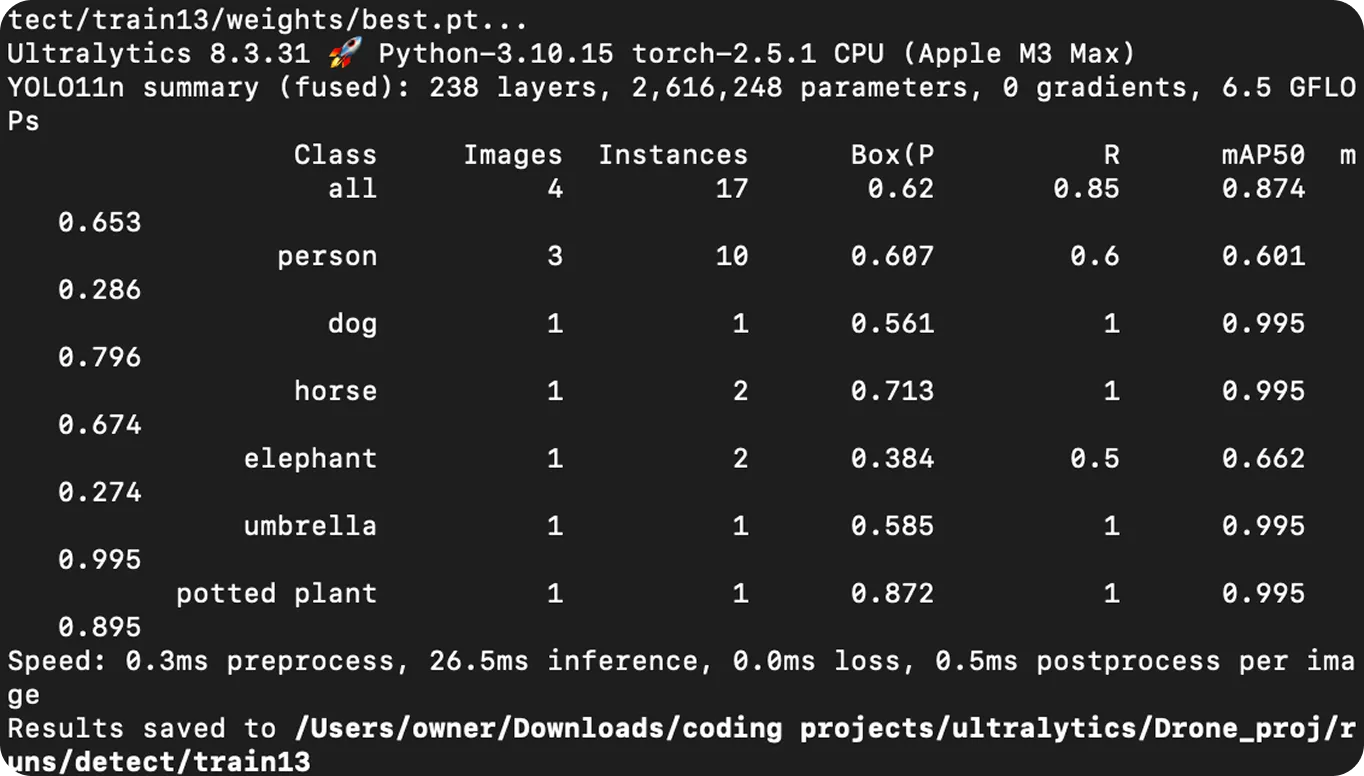

コンピュータ・ビジョンを搭載したAIドローンは、荷物の配達から緊急時や農業の支援まで、多くの産業を変えつつある。このガイドでは、人工ドローン映像の作成、映像内のオブジェクトのラベル付け、YOLO11トレーニング、そして家屋をdetect するための使用方法について説明する。

ドローンの映像に物体検出を適用することで、ドローンはより賢くなり、リアルタイムで物体を自動的に認識しtrack できるようになる。技術が向上するにつれ、AIを活用したドローンは、配達の迅速化、セキュリティの向上、災害対応の支援など、さらに大きな役割を果たすことになるだろう。

コミュニティに参加し、GitHubリポジトリを探索して、Vision AIについてさらに学びましょう。また、ライセンスオプションを確認して、コンピュータビジョンプロジェクトを始めましょう。製造業におけるAIや自動車産業におけるコンピュータビジョンなどのイノベーションにご興味がありますか?ソリューションページにアクセスして、詳細をご覧ください。