SIFTアルゴリズムについて解説します。SIFTとは何か、スケール不変なコンピュータビジョンのための強力な機能について学び、画像処理を強化しましょう。

SIFTアルゴリズムについて解説します。SIFTとは何か、スケール不変なコンピュータビジョンのための強力な機能について学び、画像処理を強化しましょう。

この記事で取り上げた概念の視覚的な解説については、以下の動画をご覧ください。

最近では、電話やカメラからスマートホームシステムまで、私たちが使用する多くのスマートデバイスには、顔、オブジェクト、さらには視覚的なシーン全体を認識できるAIソリューションが付属しています。この機能は、マシンが画像やビデオを理解して解釈できるようにする人工知能の分野であるコンピュータビジョンから来ています。

例えば、エッフェル塔の写真をどんな角度や距離から撮影しても、通常、お使いのデバイスはコンピュータビジョンを使用してそれを認識し、ギャラリー内の正しいフォルダに整理できます。これは簡単そうに聞こえますが、オブジェクトの認識は必ずしも単純ではありません。画像は、サイズ、角度、スケール、または照明によって大きく異なって見える可能性があり、そのため、機械が一貫して識別することが困難になります。

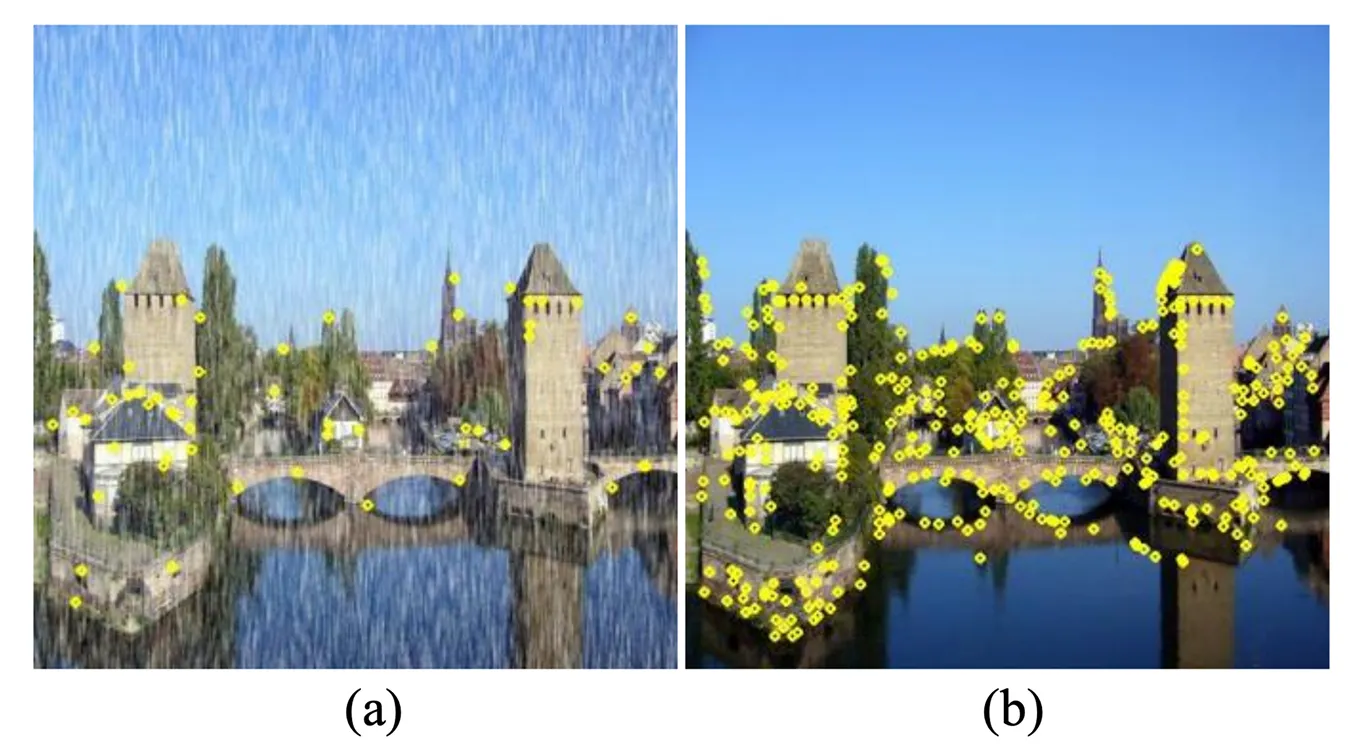

この問題を解決するために、研究者たちはSIFT(Scale Invariant Feature Transform)と呼ばれるコンピュータビジョンアルゴリズムを開発した。このアルゴリズムにより、異なる視聴条件下でも物体をdetect ことが可能になった。1999年にDavid Loweによって作成されたSIFTは、画像のコーナー、エッジ、パターンなど、画像のサイズを変更したり、回転させたり、照明を変えたりしても認識可能な、画像内のユニークなキーポイントを見つけて記述するように設計された。

のようなディープラーニング主導のコンピュータビジョンモデルが登場する以前は、そのようなモデルは存在しなかった。 Ultralytics YOLO11のようなディープラーニング主導のコンピュータビジョンモデルが普及する以前は、SIFTはコンピュータビジョンで広く使われている手法だった。SIFTは、写真内の特定のアイテムを識別することを目的とする物体認識や、重なり合う画像特徴を見つけることで写真の位置合わせを行う画像マッチングなどのタスクの標準的なアプローチであった。

この記事では、SIFTとは何か、その仕組みの概要、そしてコンピュータビジョンの進化においてなぜ重要なのかを簡単に解説します。それでは始めましょう!

画像では、オブジェクトはさまざまな方法で表示される可能性があります。たとえば、コーヒーマグは、上から、横から、明るい日光の下で、または暖かいランプの下で撮影される場合があります。同じマグカップも、カメラに近いときは大きく見え、遠いときは小さく見えることがあります。

これらの違いすべてが、コンピューターに物体を認識させることを複雑なタスクにしています。このコンピュータービジョンのタスクは物体検出と呼ばれ、Vision AIモデルは、サイズ、角度、または照明条件が変化しても、物体を正確に識別して位置を特定する必要があります。

これを実現するために、コンピュータビジョンは特徴抽出または検出と呼ばれるプロセスを利用します。モデルは、画像全体を一度に理解しようとするのではなく、鋭い角、独特のパターン、または角度、スケール、照明条件が変わっても認識可能なテクスチャなど、特徴的な画像の特徴を探します。

特に、これはScale Invariant Feature Transform(SIFT)が設計された目的です。SIFTは、画像がどのようにキャプチャされても、画像内のオブジェクトを確実に識別できる特徴検出および記述アルゴリズムです。

SIFT(Scale-Invariant Feature Transform)アルゴリズムは、物体認識に役立ついくつかの重要な特性を備えています。その主要な特性の1つが、スケール不変性と呼ばれるものです。これは、SIFTが、カメラに近い大きく見える物体でも、遠くにある小さく見える物体でも、物体のさまざまな部分を認識できることを意味します。物体が完全に見えていなくても、アルゴリズムは同じキーポイントを識別できます。

これは、スケール空間理論と呼ばれる概念を使用しています。簡単に言うと、画像を異なるレベルでぼかし、複数のバージョンを作成します。SIFTは、これらのバージョンを調べて、画像のサイズや鮮明さが変化しても同じ状態を保つパターンと詳細を見つけます。

例えば、数メートル離れて撮影された道路標識は、離れて撮影された同じ標識よりもはるかに大きく見えるが、SIFTは依然として同じ特徴的な特徴をdetect ことができる。このため、標識のスケールが大きく異なっていても、2つの画像を正しく一致させることができる。

画像内のオブジェクトは回転して表示されることもあり、時には上下逆さまになることさえあります。SIFTは、回転不変性と呼ばれる特性によってこれに対処します。アルゴリズムは、検出したすべてのキーポイントに対して、ローカルな画像の勾配に基づいて一貫した方向を割り当てます。これにより、オブジェクトがどのように回転していても、同じオブジェクトを認識できます。

これは、各キーポイントがどの方向を向いているかを示す小さな矢印でマークするようなものです。SIFTは、特徴をこれらの方向に向けることで、オブジェクトが回転している場合でもキーポイントが正しく一致するようにします。たとえば、風景写真に写っているランドマークは、カメラが傾いた状態で撮影された別の写真でも正しく識別できます。

サイズや回転以外にも、画像は照明の変化など、他の方法でも変化する可能性があります。オブジェクトの照明が明るい状態から暗い状態に変わったり、カメラの角度がわずかにずれたり、画像がぼやけたり、ノイズが発生したりする可能性があります。

SIFTは、このような変動に対応するように構築されています。これは、照明の変化や視点のわずかなずれの影響を受けにくい、特徴的でコントラストの高いキーポイントに焦点を当てることによって行われます。その結果、SIFTは、条件が変化すると失敗することが多い単純なエッジまたはコーナー検出方法よりも信頼性が高くなる傾向があります。

ギャラリーにある絵画を考えてみましょう。柔らかい自然光の下で撮影された場合でも、明るい人工スポットライトの下で撮影された場合でも、手持ちカメラでわずかにモーションブラーが発生した場合でも、認識できます。これらの違いにもかかわらず、キーポイントは正確なマッチングのために十分に安定しています。

次に、SIFTアルゴリズムの仕組みを見ていきましょう。このプロセスは、キーポイント検出、キーポイントのローカリゼーション、方向の割り当て、キーポイント記述という4つの主要なステップに分解できます。

最初のステップは、キーポイントを見つけ、detect ことである。キーポイントとは、角やテクスチャの鋭い変化など、画像内の特徴的な点のことで、物体のtrack 認識に役立つ。

これらの潜在的なキーポイントがあらゆるサイズで認識できるようにするために、SIFTはスケール空間と呼ばれるものを構築します。これは、ガウスフィルター(平滑化手法)で元の画像を徐々にぼかし、その結果をオクターブと呼ばれるレイヤーにグループ化して作成された画像のコレクションです。各オクターブには、ぼかしのレベルが異なる同じ画像が含まれており、次のオクターブは画像の小さいバージョンです。

SIFTは、あるぼやけた画像を別のぼやけた画像から減算することにより、Difference of Gaussians(DoG)を計算し、明るさが急激に変化する領域を強調表示します。これらの領域は、画像を拡大または縮小しても一貫しているため、候補キーポイントとして選択されます。

すべての候補キーポイントが有用であるとは限りません。なぜなら、弱いまたは不安定なものがあるからです。それらを改良するために、SIFTはテイラー展開と呼ばれる数学的な方法を使用します。これは、より高い精度でキーポイントの正確な位置を推定するのに役立ちます。

このステップでは、信頼性の低いポイントが削除されます。周囲に溶け込むコントラストの低いキーポイント、およびエッジに直接位置するキーポイントは、簡単にシフトする可能性があるため、破棄されます。このフィルタリングステップにより、最も安定した特徴的なキーポイントのみが残ります。

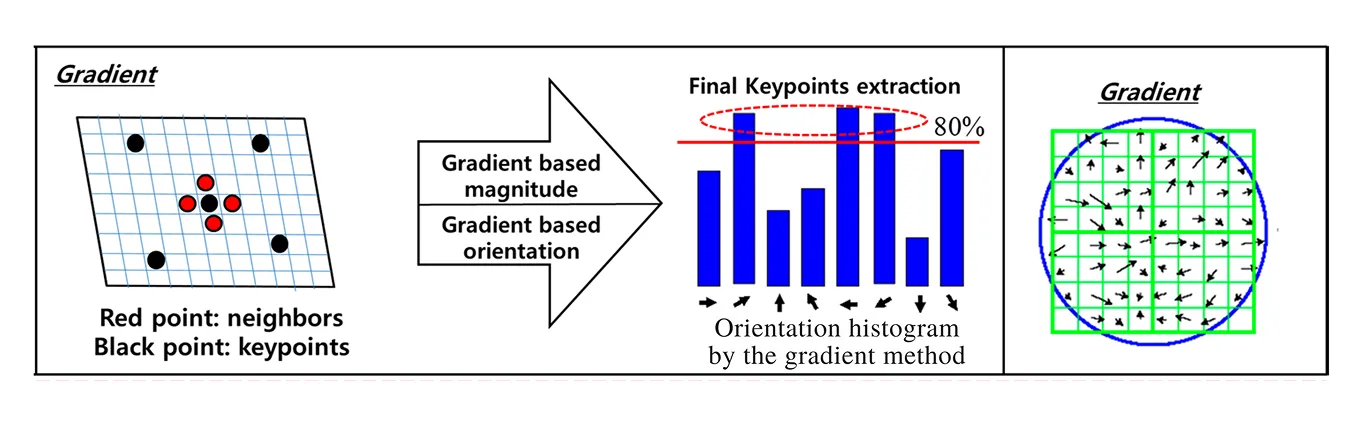

安定したキーポイントが識別されると、SIFTはそれらを回転不変にします。つまり、画像が横向きまたは上下逆さまになっても、それらを照合できます。これを行うために、SIFTは各キーポイントの周りの明るさの変化を分析します。これは、勾配として知られています。勾配は、ピクセル強度の変化の方向と強さの両方を示し、それらを合わせてポイントの周りのローカル構造をキャプチャします。

各キーポイントについて、SIFTは周囲の領域内の勾配を考慮し、それらを方向のヒストグラムにグループ化します。このヒストグラムの最も高いピークは、強度の変化の支配的な方向を示し、それがキーポイントの方向として割り当てられます。強度変化を示す勾配方向と、その変化の強さを示す勾配の大きさの両方が、このヒストグラムの構築に使用されます。

ほぼ同じくらい強いピークが他にもある場合、SIFTは同じキーポイントに複数の方向を割り当てます。これにより、オブジェクトが異常な角度で表示された場合に重要な特徴が失われるのを防ぎます。各キーポイントをその方向と一致させることで、SIFTは次のステップで生成される記述子が常に一貫性を保つようにします。

つまり、同じオブジェクトの2つの画像が異なる方向に回転していても、向きが揃えられたキーポイントは正しく一致します。このステップこそが、SIFTに回転を処理する強力な能力を与え、以前の特徴検出方法よりもはるかに堅牢にしている理由です。

SIFTの最後のステップは、各キーポイントを記述し、他の画像でも認識できるようにすることです。

SIFTは、各キーポイントの周囲の小さな正方形のパッチ(約16 x 16ピクセル)を見ることでこれを実現します。このパッチは、最初にキーポイントの向きに合わせて調整されるため、回転の影響を受けません。次に、パッチは4 x 4の小さな正方形のグリッドに分割されます。

それぞれの小さな正方形の中で、SIFTは明るさがさまざまな方向にどのように変化するかを測定します。これらの変化はヒストグラムと呼ばれるものに保存されます。これは、どの方向が最も一般的かを示すグラフのようなものです。各正方形は独自のヒストグラムを取得し、16個の正方形が一緒に16個のヒストグラムを生成します。

最後に、これらのヒストグラムを組み合わせて、合計128個の数値の単一のリストにします。このリストは特徴ベクトルと呼ばれ、キーポイントの指紋のように機能します。この指紋は、ポイント周辺のユニークなテクスチャと構造を捉えているため、サイズ変更、回転、または照明が異なっていても、異なる画像間で同じキーポイントを照合できます。

SIFTとは何か、そしてそれがどのように機能するかについて理解が深まったところで、コンピュータビジョンにおける実際の応用例をいくつか見ていきましょう。

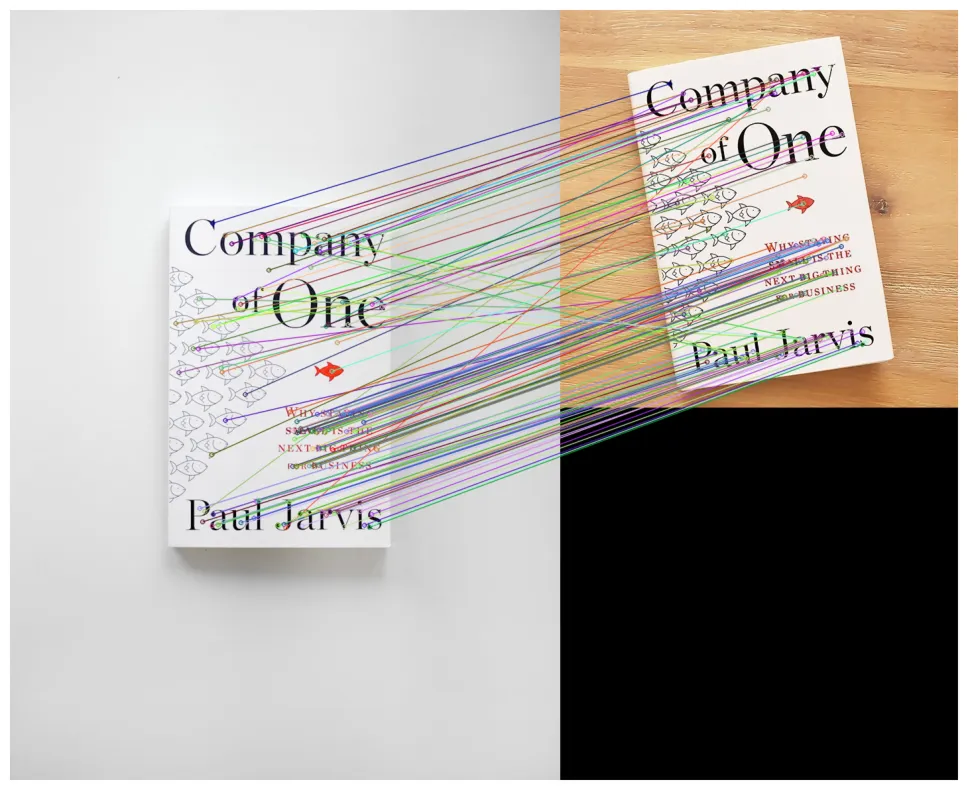

SIFTの主な用途の1つは、物体の認識と検出である。これは、物体が常に同じように見えるとは限らない場合でも、画像内の物体を認識し、位置を特定するようコンピュータに教えることである。例えば、SIFTは、本がカメラに近いか、遠いか、斜めに回転しているかに関係なく、本をdetect ことができる。

これが機能する理由は、SIFTが非常に特徴的で安定したキーポイントを抽出するためです。これらのキーポイントがSIFT記述子と組み合わされると、SIFT特徴が形成され、異なる画像間で同じオブジェクトをマッチングするための信頼性の高い方法が提供されます。これらの特徴は、オブジェクトのサイズ、位置、または向きが変化した場合でも、画像間で信頼性の高い特徴マッチングを可能にする、オブジェクトの一意の詳細を捉えます。

深層学習が普及する前は、SIFTはオブジェクト認識システムを構築するための最も信頼できる方法の1つでした。多くの場合、かなりの計算リソースを必要としましたが、大規模な画像データセット全体でオブジェクトを照合する必要がある研究やアプリケーションで広く使用されていました。

SIFTは、複数の写真を繋ぎ合わせて作成されたワイドな写真であるパノラマ画像を作成するためにも使用できます。SIFTを使用すると、異なる画像の重複部分で特徴的なキーポイントが見つけられ、互いに照合されます。これらの照合は、写真の配置方法に関するステッチングプロセスを導くアンカーとして機能します。

マッチングが完了すると、ステッチングアルゴリズムを使用して、正しいアライメントを計算できます。多くの場合、ある画像を別の画像にマッピングする幾何学的変換を使用します。次に、シームが消えるように画像をブレンドします。最終的な結果は、複数のショットから作成されたにもかかわらず、1枚のワイド写真のように見えるシームレスなパノラマです。

SIFTのもう1つの興味深いアプリケーションは3D再構成です。ここでは、さまざまな角度から撮影された複数の2D写真が組み合わされて、3次元モデルが構築されます。SIFTは、これらの画像全体で同じポイントを見つけて照合することによって機能します。

一致が作成されると、三角測量を使用して、それらのポイントの3D位置を推定できます。三角測量は、異なる視点から深度を計算する方法です。このプロセスは、モーションからの構造(SfM)の一部です。SfMは、複数の重複する画像を使用して、シーンの3D形状と写真を撮ったカメラの位置を推定する手法です。

通常、結果は3D点群、つまりオブジェクトまたは環境の輪郭を描く空間内の点の集合となります。SIFTは、Structure from Motionを実用化した最初のツールの1つでした。より新しい手法の方が高速で一般的になっていますが、速度よりも精度が重要な場合は、SIFTが引き続き適用されています。

SIFTは、特にVisual SLAM(Simultaneous Localization and Mapping:自己位置推定と地図作成の同時実行)において、ロボティクスでも使用されています。SLAMを使用すると、ロボットは周囲の地図を作成しながら、自身の位置を把握できます。

SIFTキーポイントは、照明や角度が変化してもロボットがフレーム間で認識できる信頼性の高いランドマークとして機能します。これらのランドマークを追跡することで、ロボットは自身の位置を推定し、地図をその場で更新できます。今日では、より高速な特徴検出器がロボティクスでより頻繁に使用されていますが、SIFTは初期のSLAMシステムで重要な役割を果たし、速度よりも堅牢性が重要な場合に依然として重要です。

SIFTアルゴリズムはコンピュータビジョンで広く使用されており、信頼性の高い方法として知られていますが、いくつかのトレードオフも伴います。そのため、プロジェクトに最適かどうかを判断する前に、その長所と短所を比較検討することが重要です。次に、その主な強みと限界について説明します。

SIFTアルゴリズムを使用する利点を以下に示します。

SIFTアルゴリズムを使用するデメリットを以下に示します。

SIFTの長所と短所を調べていると、その制限の多くが、より高度な技術への道を開いたことに気付くかもしれません。具体的には、畳み込みニューラルネットワーク(CNN)が強力な代替手段として登場しました。

CNNは、人間の視覚システムがどのように機能するかに触発された深層学習モデルの一種です。エッジやテクスチャのような単純なパターンから始まり、より複雑な形状やオブジェクトへと徐々に構築され、画像をレイヤーで処理します。SIFTの手作りの特徴ルールとは異なり、CNNはデータから直接特徴表現を学習します。

このデータ駆動型学習により、CNNは記述子のマッチングや分類タスクにおいてSIFTを上回る性能を発揮できます。また、CNNはより表現力豊かで堅牢であり、視覚データの多様性や複雑性にもより適応できます。

例えば、CNNベースのモデルは、ImageNetで画期的な結果を達成している。 ImageNetこれは、数千のカテゴリにまたがる数百万のラベル付き画像を含む大規模なベンチマークデータセットである。アルゴリズムがどれだけ物体を認識・classify できるかをテストするために設計されたImageNet 、旧来の特徴ベースの手法とディープラーニングのギャップを浮き彫りにすることができる。

CNNは、はるかに豊富で柔軟な表現を学習することでSIFTをすぐに上回り、照明の変化、異なる視点から、さらには部分的に隠れている場合でもオブジェクトを認識できるようになりました。SIFTが苦労することが多いシナリオです。

スケール不変特徴変換アルゴリズムは、コンピュータビジョンの歴史において重要な位置を占めている。このアルゴリズムは、変化する環境においても特徴をdetect する信頼性の高い方法を提供し、今日使用されている多くの手法に影響を与えた。

新しい技術はより高速で効率的ですが、SIFTはその基礎を築きました。SIFTは、今日のコンピュータビジョンの進歩がどこから始まったのかを示し、最先端のAIシステムがどれほど進歩したかを強調しています。

グローバルなコミュニティに参加し、GitHubリポジトリをチェックして、コンピュータビジョンについてさらに学びましょう。ソリューションページでは、農業におけるAIや小売業におけるコンピュータビジョンなどのイノベーションをご紹介しています。ライセンスオプションを確認して、独自のコンピュータビジョンモデルの構築を始めましょう。