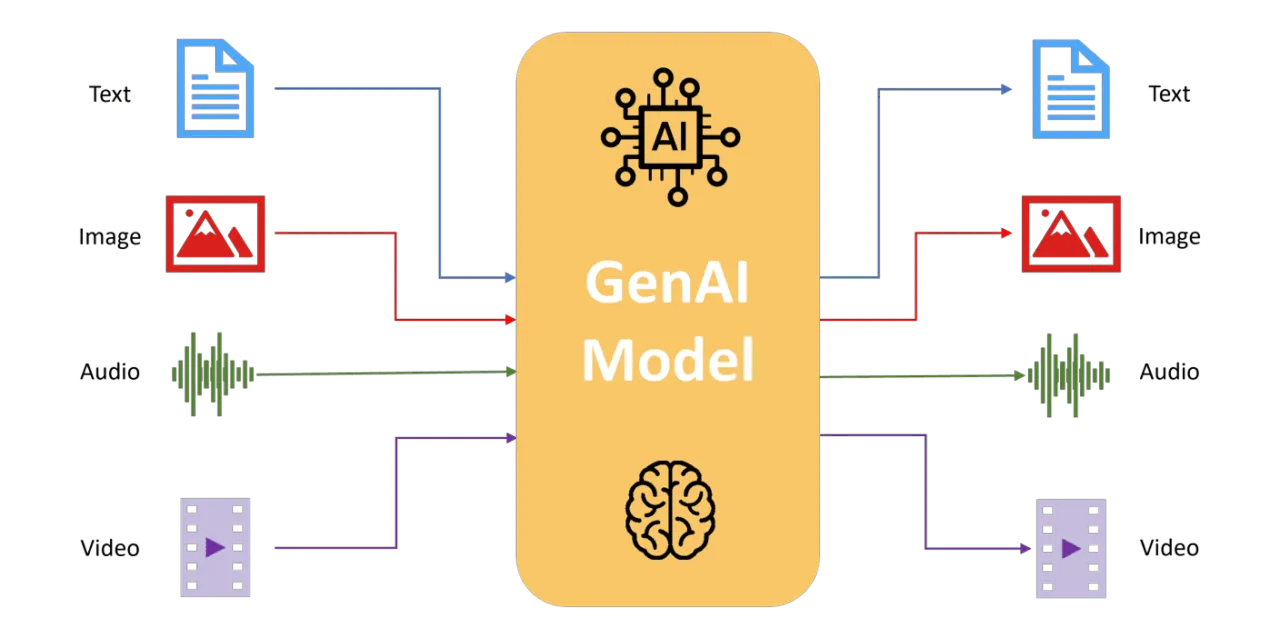

マルチモーダルモデルがテキスト、画像、音声、センサーデータを統合して、AIの認識、推論、意思決定をどのように向上させるかを探求します。

マルチモーダルモデルがテキスト、画像、音声、センサーデータを統合して、AIの認識、推論、意思決定をどのように向上させるかを探求します。

従来のAIシステムは通常、テキスト、画像、音声などの単一のデータソースからの情報を処理します。これらのユニモーダルなアプローチは、特定のタスクには優れていますが、複数の同時入力を含む複雑な現実世界のシナリオを処理できないことがよくあります。マルチモーダル学習は、統一されたフレームワーク内で多様なデータストリームを統合することにより、これに対処し、より豊かでコンテキストを意識した理解を可能にします。

人間の知覚に触発されたマルチモーダルモデルは、視覚、聴覚、言語を自然に統合する人間のように、組み合わされた入力に基づいて分析、解釈、および行動します。これらのモデルにより、AIは複雑なシナリオをより高い精度、堅牢性、および適応性で処理できます。

この記事では、マルチモーダルモデルがどのように進化してきたか、その仕組み、コンピュータビジョンにおける実践的な応用、そして複数のデータタイプを統合することに伴う利点と課題について解説します。

マルチモーダル学習とは何か、そしてそれが人工知能(AI)にとってなぜ重要なのか疑問に思われるかもしれません。従来のAIモデルは通常、画像、テキスト、音声、センサー入力など、一度に1種類のデータを処理します。

しかし、マルチモーダル学習は、システムが複数の多様なデータストリームを同時に分析、解釈、統合できるようにすることで、さらに一歩進んでいます。このアプローチは、人間の脳が視覚、聴覚、言語入力を自然に統合して、世界を包括的に理解する方法とよく似ています。

これらの異なるモダリティを組み合わせることで、マルチモーダルAIは、複雑なシナリオをより深く、よりニュアンス豊かに理解することができます。

例えば、ビデオ映像を分析する場合、マルチモーダルシステムは映像コンテンツだけを処理するのではなく、話し言葉の台詞、周囲の音、付随する字幕なども考慮する。

この統合的な視点により、AIは、各データタイプを個別に分析した場合には見逃してしまうようなコンテキストや微妙なニュアンスを捉えることができます。

実際には、マルチモーダル学習はAIができることを拡張します。画像キャプション、視覚的なコンテキストに基づいた質問応答、テキスト記述からのリアルな画像の生成、より直感的でコンテキストを認識したインタラクティブシステムの改善などのアプリケーションを強化します。

しかし、マルチモーダルモデルは、これらの異なるデータタイプをどのように組み合わせてこれらの結果を達成するのでしょうか?彼らの成功の背後にあるコアメカニズムを段階的に分解してみましょう。

マルチモーダルAIモデルは、特殊なプロセスを通じて強力な機能を実現します。各モダリティの個別の特徴抽出(画像、テキスト、音声などの各タイプのデータを個別に処理)、融合手法(抽出された詳細を組み合わせる)、および高度なアライメント技術(組み合わせられた情報が一貫性を持って適合するようにする)です。

これらの各プロセスがどのように機能するかをより詳細に見ていきましょう。

マルチモーダルAIモデルは、データタイプごとに異なる特殊なアーキテクチャを使用します。これは、視覚、テキスト、および音声またはセンサー入力が、それらのために特別に設計されたシステムによって処理されることを意味します。そうすることで、モデルは、それらをまとめる前に、各入力の一意の詳細をキャプチャできます。

さまざまな特殊なアーキテクチャを使用して、さまざまなタイプのデータから特徴を抽出する方法の例を次に示します。

個別に処理されると、各モダリティは、特定のデータタイプ内に含まれる一意の情報をキャプチャするように最適化された高レベルの特徴を生成します。

特徴を抽出した後、マルチモーダルモデルはそれらを統合された一貫性のある表現にマージします。これを効果的に行うために、いくつかの融合戦略が使用されます。

最後に、マルチモーダルシステムは、高度なアライメントおよび注意技術を利用して、異なるモダリティからのデータが効果的に対応するようにします。

コントラスト学習などの手法は、視覚的表現とテキスト表現を共有セマンティック空間内で密接に整合させるのに役立ちます。これにより、マルチモーダルモデルは、多様な種類のデータ間で強力で意味のある接続を確立し、モデルが「見る」ものと「読む」ものとの一貫性を確保できます。

Transformerベースの注意メカニズムは、モデルが各入力の最も関連性の高い側面に動的に焦点を当てることを可能にすることで、このアライメントをさらに強化します。たとえば、注意レイヤーを使用すると、モデルは特定のテキスト記述を視覚データ内の対応する領域に直接接続できるため、Visual Question Answering(VQA)や画像キャプションなどの複雑なタスクの精度が大幅に向上します。

これらの技術は、マルチモーダルAIがコンテキストを深く理解する能力を高め、AIが複雑な現実世界のデータに対して、よりニュアンスのある正確な解釈を提供することを可能にします。

マルチモーダルAIは大幅に進化し、初期のルールベースの手法から、高度な統合が可能な高度な深層学習システムへと移行しました。

初期の頃、マルチモーダルシステムは、画像、音声、センサー入力などの異なるデータタイプを、人間の専門家が手動で作成したルールや単純な統計的手法を使って組み合わせていた。例えば、初期のロボットナビゲーションは、カメラ画像とソナーデータを統合し、障害物をdetect ・回避していた。このようなシステムは効果的ではあるが、手作業による大規模な特徴抽出が必要であり、適応能力や汎化能力に限界があった。

深層学習の出現により、マルチモーダルモデルははるかに普及しました。マルチモーダルオートエンコーダーのようなニューラルネットワークは、さまざまなデータ型、特に画像データとテキストデータの結合表現の学習を開始し、AIがクロスモーダル検索やテキスト記述のみに基づいて画像を検索するなどのタスクを処理できるようにしました。

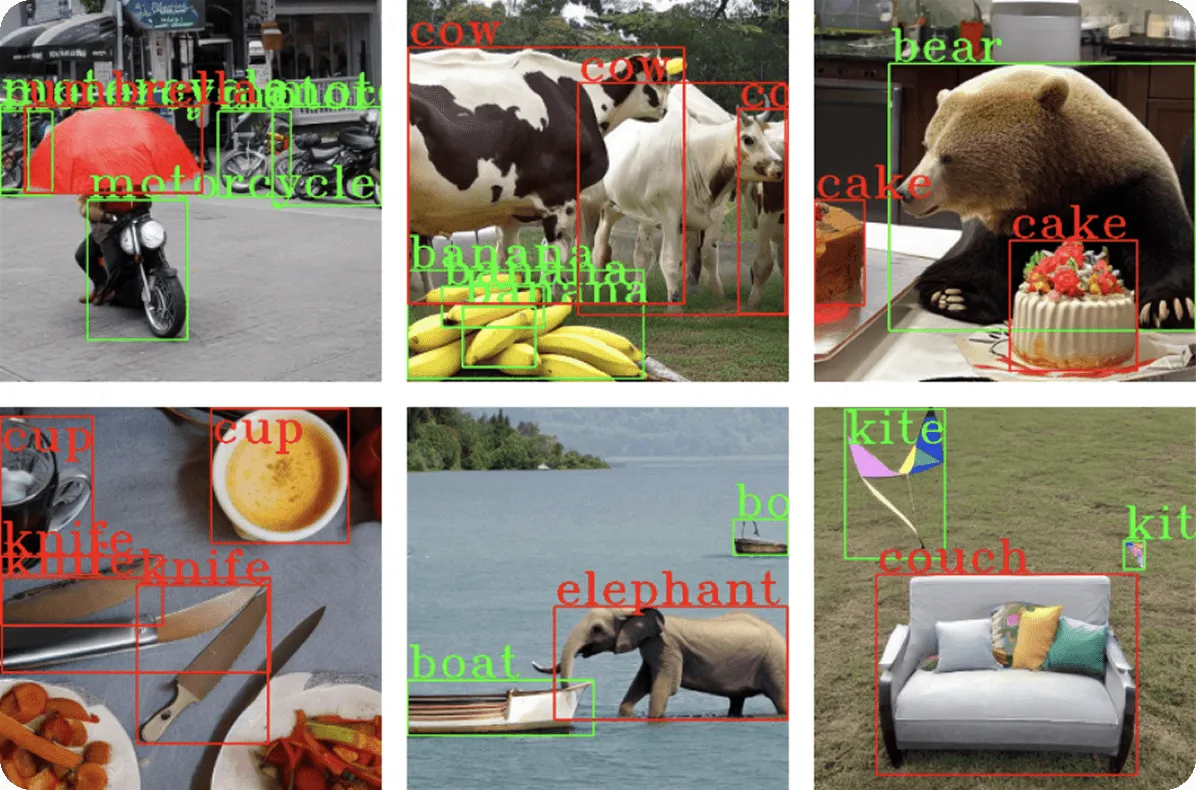

Visual Question Answering(VQA)のようなシステムが、画像を処理するためのCNNと、テキストを解釈するためのRNNまたはTransformerを統合するにつれて、進歩は続きました。これにより、AIモデルは、視覚コンテンツに関する複雑でコンテキストに依存する質問に正確に答えることができました。

ごく最近では、大規模なインターネット規模のデータセットでトレーニングされた大規模なマルチモーダルモデルが、AI機能をさらに革新しました。

これらのモデルは、コントラスト学習などの手法を活用して、視覚コンテンツとテキスト記述の間の一般化可能な関係を特定できるようにします。モダリティ間のギャップを埋めることにより、最新のマルチモーダルアーキテクチャは、人間とほぼ同じ精度で複雑な視覚的推論タスクを実行するAIの能力を強化し、マルチモーダルAIがその基礎段階からどれだけ進歩したかを示しています。

マルチモーダルモデルが多様なデータストリームをどのように統合するかを検討したので、これらの機能をコンピュータビジョンモデルにどのように適用できるかを見ていきましょう。

マルチモーダル学習は、視覚入力とテキスト、オーディオ、またはセンサーデータを組み合わせることで、AIシステムがますます洗練されたコンテキストリッチなアプリケーションに取り組むことを可能にします。

画像キャプションには、視覚データの自然言語記述を生成することが含まれます。従来の物体検出法は個々の物体を識別しますが、マルチモーダルキャプションはさらに進んで、関係とコンテキストを解釈します。

たとえば、マルチモーダルモデルは、ピクニックをしている人々の画像を分析し、「晴れた公園でピクニックをしている家族」のような説明的なキャプションを生成し、より豊かでアクセスしやすい出力を提供できます。

このアプリケーションはアクセシビリティにとって重要です。視覚障碍者向けの代替テキストや、大規模データベースのコンテンツタグ付けを生成するために使用できます。Transformerアーキテクチャはここで重要な役割を果たし、テキスト生成モジュールが注意メカニズムを通じて関連する視覚領域に焦点を当て、テキスト記述を視覚的特徴と動的に整合させることができます。

VQAモデルは、コンピュータビジョンと言語理解を組み合わせて、視覚コンテンツに基づいて自然言語の質問に答えます。これらのタスクには、画像コンテンツ、コンテキスト、およびセマンティック推論の詳細な理解が必要です。

Transformerアーキテクチャは、モデルのテキストコンポーネントと視覚コンポーネントが動的に相互作用し、質問に関連する正確な画像領域を特定できるようにすることで、VQAを強化しました。

例えば、GooglePaLIモデルは、視覚変換器(ViT)と言語エンコーダーおよびデコーダーを統合した高度な変換器ベースのアーキテクチャを使用しており、「写真の女性は何をしているのか」「動物は何匹見えるか」といった高度な質問に正確に答えることができる。

Attentionレイヤーは、モデルが入力の最も関連性の高い部分に焦点を当てるのに役立ち、各質問の単語が視覚的な手がかりに動的にリンクするようにします。これにより、基本的な物体検出を超えた、ニュアンスのある回答が可能になります。

テキストから画像生成とは、AIがテキストによる記述から直接視覚的なコンテンツを作成する能力を指し、意味的理解と視覚的創造の間のギャップを埋めるものです。

このタスクを実行するマルチモーダルモデルは、Transformerや拡散過程などの高度なニューラルアーキテクチャを利用して、詳細で文脈的に正確な画像を生成します。

たとえば、車両検出を目的としたコンピュータビジョンモデル用の合成トレーニングデータを生成することを想像してみてください。「交通量の多い通りに駐車している赤いセダン」や「高速道路を走行している白いSUV」のようなテキストによる記述が与えられた場合、これらのマルチモーダルモデルは、これらの正確なシナリオを描いた多様で高品質な画像を生成できます。

このような機能により、研究者や開発者は、数千もの画像を手動でキャプチャすることなく、物体検出データセットを効率的に拡張できるため、データ収集に必要な時間とリソースを大幅に削減できます。

より最近の手法では、拡散ベースの技術を適用し、ランダムな視覚的ノイズから始めて、テキスト入力と密接に一致するように画像を段階的に洗練します。この反復プロセスにより、現実的で多様な例を作成し、複数の視点、照明条件、車両タイプ、および背景をカバーする堅牢なトレーニングデータを確保できます。

このアプローチは、コンピュータビジョンにおいて特に価値があり、迅速なデータセット拡張を可能にし、モデルの精度を向上させ、AIシステムが確実に認識できるシナリオの多様性を高めます。

マルチモーダル検索システムは、テキストと画像の両方を共通の意味の言語に変換することで、検索を容易にします。たとえば、何百万もの画像とテキストのペアから学習したCLIPのような大規模なデータセットでトレーニングされたモデルは、テキストクエリを適切な画像と照合し、より直感的で正確な検索結果をもたらすことができます。

たとえば、「ビーチの夕焼け」のような検索クエリは、視覚的に正確な結果を返し、eコマースプラットフォーム、メディアアーカイブ、およびストックフォトデータベース全体でコンテンツの発見効率を大幅に向上させます。

マルチモーダルアプローチは、クエリと画像の説明が異なる言語を使用している場合でも、視覚ドメインとテキストドメイン間の学習された意味的アライメントのおかげで、検索の精度を保証します。

マルチモーダル学習は、コンピュータビジョンおよびそれ以降のAIの機能を強化するいくつかの重要な利点を提供します。

これらの強みにもかかわらず、マルチモーダルモデルには、独自の課題も伴います。

マルチモーダル学習は、複数のデータストリームにわたってより豊かで文脈的な理解を可能にすることで、AIを再構築しています。画像キャプション、視覚的な質問応答、テキストから画像生成、および強化された画像検索などのコンピュータビジョンにおけるアプリケーションは、多様なモダリティを統合する可能性を示しています。

計算上および倫理的な課題は残っていますが、Transformerベースの融合やコントラストアライメントなどのアーキテクチャにおける継続的なイノベーションは、これらの懸念に対処し続け、マルチモーダルAIをますます人間らしい知能へと押し進めています。

この分野が進化するにつれて、マルチモーダルモデルは、ヘルスケア診断から自律型ロボット工学まで、あらゆるものを強化する、複雑な現実世界のAIタスクに不可欠になります。マルチモーダル学習を採用することで、業界はAIの未来を形作る強力な機能を活用できるようになります。

成長を続けるコミュニティに参加しませんか?当社のGitHubリポジトリでAIについてさらに詳しく学んでください。ご自身のコンピュータビジョンプロジェクトを始める準備はできましたか?当社のライセンスオプションをご確認ください。ソリューションページでは、製造業におけるAIや自動運転におけるVision AIについてご紹介しています。