YOLO ビジョン2024の基調講演を再訪し、Hugging Faceオープンソース・ツールがAI開発をどのように前進させているかを探ることに焦点を当てます。

YOLO ビジョン2024の基調講演を再訪し、Hugging Faceオープンソース・ツールがAI開発をどのように前進させているかを探ることに焦点を当てます。

適切なアルゴリズムを選択することは、影響力のあるコンピュータビジョンソリューションを構築する上でのほんの一部にすぎません。AIエンジニアは、多くの場合、大規模なデータセットを扱い、特定のタスクに合わせてモデルを微調整し、実世界のパフォーマンスに合わせてAIシステムを最適化します。AIアプリケーションの採用が急速に進むにつれて、これらのプロセスを簡素化するツールの必要性も高まっています。

YOLO ビジョン2024(YV24)は、Ultralytics毎年開催しているハイブリッドイベントで、AIの専門家と技術愛好家が集まり、コンピュータビジョンの最新のイノベーションを探求しました。このイベントでは、AIアプリケーションの開発をスピードアップする方法など、さまざまなトピックについて議論が交わされた。

このイベントの重要なハイライトは、モデルのトレーニング、最適化、デプロイメントを合理化するオープンソースのAIプラットフォームであるHugging Face基調講演だった。Hugging Face機械学習エンジニアであるPavel Lakubovskii氏は、そのツールが、画像内のオブジェクトの検出、画像の異なるグループへの分類、特定の例に対する事前のトレーニングなしでの予測(ゼロショット学習)などのコンピュータビジョンタスクのワークフローをどのように改善するかを共有した。

Hugging Face Hubは、Ultralytics YOLO11ような様々なAIとコンピュータビジョンモデルをホストし、アクセスを提供しています。この記事では、Pavelの講演から重要な点をまとめ、開発者がどのようにHugging Faceオープンソースツールを使ってAIモデルを素早く構築し、デプロイできるかを見ていきます。

パベルはまず、Hugging Face オープンソースのAIプラットフォームとして紹介し、さまざまなアプリケーションのための事前学習済みモデルを提供することを紹介した。これらのモデルは、自然言語処理(NLP)、コンピュータビジョン、マルチモーダルAIなど、AIのさまざまな分野のために設計されており、システムがテキスト、画像、音声などのさまざまな種類のデータを処理することを可能にする。

パベルは、Hugging Face 現在100万以上のモデルをホストしており、開発者は特定のプロジェクトに適したモデルを簡単に見つけることができると述べた。Hugging Face 、モデルのトレーニング、微調整、展開のためのツールを提供することで、AI開発を簡素化することを目指している。開発者がさまざまなモデルを試すことができれば、AIを実世界のアプリケーションに統合するプロセスが簡素化される。

Hugging Face 当初NLPで知られていたが、その後コンピュータ・ビジョンやマルチモーダルAIに拡張され、開発者はより幅広いAIタスクに取り組むことができるようになった。また、フォーラム、Discord、GitHubを通じて、開発者がコラボレーションしたり、洞察を共有したり、サポートを受けたりできる強力なコミュニティもある。

さらに詳しく説明すると、パベルはHugging Faceツールがいかにコンピュータ・ビジョン・アプリケーションの構築を容易にするかを説明した。開発者は、画像分類、物体検出、ビジョン言語アプリケーションのようなタスクに使用できる。

彼はまた、これらのコンピュータ・ビジョン・タスクの多くは、Hugging Face 利用可能な事前学習済みモデルで処理することができ、ゼロから学習する必要性を減らすことで時間を節約できると指摘した。実際、Hugging Face 、食品分類、ペット分類、感情検出を含む、画像分類タスクのための13,000以上の事前訓練済みモデルを提供しています。

これらのモデルのアクセシビリティを強調して、彼は次のように述べています。「おそらく、プロジェクトのためにモデルをトレーニングする必要さえありません。コミュニティの誰かがすでにトレーニングしたモデルをHubで見つけることができるかもしれません。」

別の例として、パベルは、Hugging Face 、画像内のオブジェクトを識別し、位置を特定するために使用されるコンピュータ・ビジョンの重要な機能である、オブジェクト検出にどのように役立つかを詳しく説明しました。限られたラベル付きデータであっても、Hugging Face Hubで利用可能な事前訓練されたモデルは、物体検出をより効率的にすることができます。

彼はまた、Hugging Face掲載されている、このタスクのために作られたいくつかのモデルの概要も説明した:

Pavelは次に、Hugging Face 実際に使ってみることに焦点を移し、開発者がモデルを活用する3つの方法を説明した。

彼は、開発者がコードを書くことなく、Hugging Face Hub上で直接モデルをブラウズできる方法を実演し、インタラクティブなインターフェイスを通して即座にモデルをテストすることを容易にした。「コードを一行も書くことなく、またコンピュータにモデルをダウンロードすることなく試すことができます。一部のモデルはサイズが大きいため、ハブ上で実行することで、ストレージや処理の制限を避けることができます。

また、Hugging Face Inference API 、開発者はシンプルなAPIコールでAIモデルを実行することができます。複雑なセットアップを必要とせず、迅速なテスト、概念実証プロジェクト、ラピッドプロトタイピングに最適です。

より高度なユースケースのために、開発者は、PyTorch TensorFlow両方をサポートしながら、テキスト、ビジョン、オーディオタスクのために事前に訓練されたモデルを提供するオープンソースツールであるHugging Face Transformersフレームワークを使用することができます。Pavelは、たった2行のコードで、開発者はHugging Face Hubからモデルを取得し、画像プロセッサのような前処理ツールにリンクさせ、Vision AIアプリケーションのために画像データを分析できると説明した。

次にパベルは、Hugging Face AIのワークフローをどのように効率化できるかを説明した。彼が取り上げた重要なトピックのひとつは、ディープラーニング・モデルの中核機能であるTransformersのアテンション・メカニズムを最適化することで、入力データの最も関連性の高い部分に焦点を当てることができる。これにより、言語処理やコンピューター・ビジョンに関わるタスクの精度が向上する。しかし、リソースを大量に消費する可能性がある。

注意機構を最適化すると、メモリ使用量を大幅に削減しながら、速度を向上させることができます。Pavel氏は、「たとえば、より効率的な注意機構の実装に切り替えることで、最大1.8倍のパフォーマンス向上が見込めます」と指摘しました。

Hugging Face 、Transformersフレームワーク内でより効率的なアテンション実装のための組み込みサポートを提供します。開発者は、モデルをロードするときに代替のアテンション実装を指定するだけで、これらの最適化を有効にすることができます。

彼はまた、量子化についても話しました。量子化とは、パフォーマンスに大きな影響を与えることなく、AIモデルが使用する数値の精度を下げることで、モデルを小さくする手法です。これにより、モデルのメモリ使用量が減り、実行速度が向上するため、スマートフォンや組み込みシステムなど、処理能力が限られたデバイスに適しています。

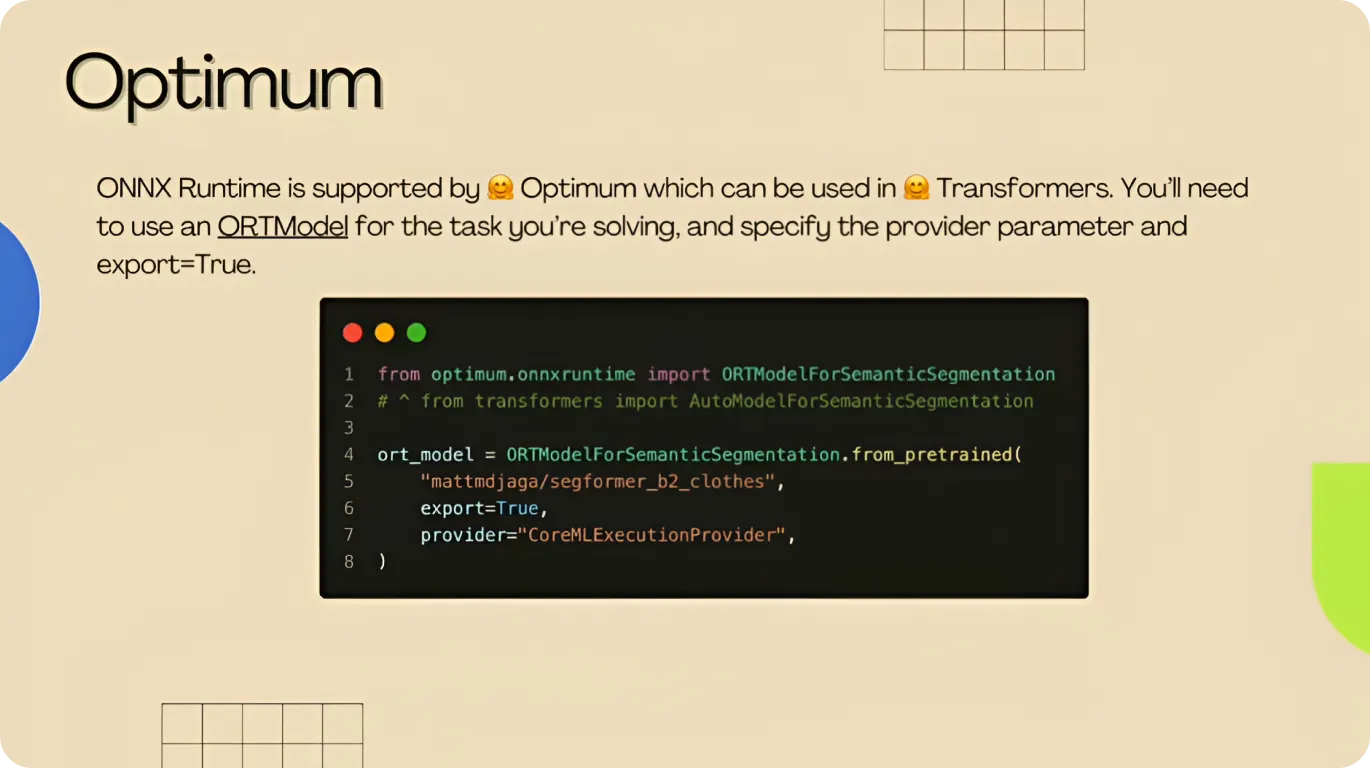

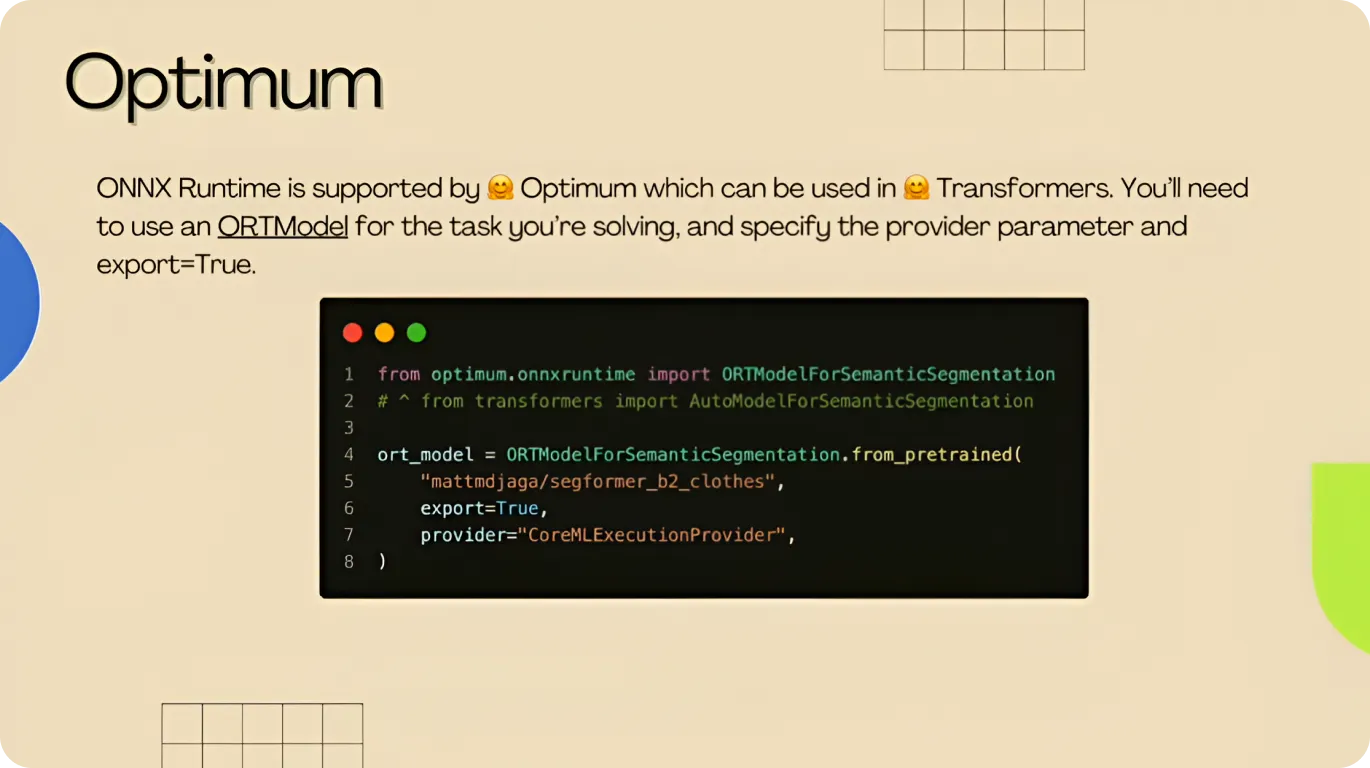

効率をさらに向上させるため、パベルはモデルの最適化とデプロイのために設計されたツールセットであるHugging Face Optimumライブラリを紹介した。わずか数行のコードで、開発者は量子化技術を適用し、モデルをONNX (Open Neural Network Exchange)のような効率的なフォーマットに変換することができ、クラウドサーバーやエッジデバイスを含むさまざまな種類のハードウェア上でスムーズに動作させることができる。

最後にPavelは、AIモデルがデータを処理する方法を最適化し、より高速で効率的に実行するPyTorch 機能であるTorch Compileの利点について言及した。Hugging Face 、Torch OptimumライブラリにTorch Compileを統合し、開発者が最小限のコード変更でこれらのパフォーマンス向上を利用できるようにしている。

モデルの計算構造を最適化することで、Torch コンパイルは推論時間を高速化し、精度や品質を損なうことなくフレームレートを毎秒29フレームから150フレームに向上させることができる。

続いてパベルは、適切なモデルを選択し、開発に最適なアプローチを選択した後、開発者がHugging Face ツールを使用してVision AIモデルを拡張し、展開する方法について簡単に触れた。

例えば、開発者はGradioとStreamlitを使ってインタラクティブなAIアプリケーションを展開することができる。Gradioは、開発者が機械学習モデルのためのウェブベースのインタフェースを作成することを可能にし、Streamlitは、シンプルなPython スクリプトでインタラクティブなデータアプリケーションを構築するのに役立ちます。

パベルはまた、Hugging Face 提供するガイド、トレーニング・ノートブック、スクリプト例について、「ゼロからすべてを書き始める必要はありません」と指摘した。これらのリソースは、開発者がゼロからすべてを構築することなく、すぐに使い始められるようにするものです。

基調講演の最後に、パベルはHugging Face Hubを使用する利点をまとめた。彼は、モデル管理とコラボレーションをいかに簡素化するかを強調した。彼はまた、初心者と専門家の両方がAIモデルを理解し、実装するのに役立つガイド、ノートブック、チュートリアルが利用可能であることに注意を促した。

「Hubにはすでに多くのクールなスペースがあります。類似のものを見つけ、共有コードをクローンし、数行修正し、モデルを自分のものと置き換え、それをプッシュバックすることができます」と彼は説明し、開発者にプラットフォームの柔軟性を活用するように促しました。

YV24での講演でパベルは、Hugging Face AIモデルのトレーニング、最適化、デプロイメントをサポートするツールを提供していることを紹介した。例えば、Transformers、Optimum、Torch Compileのようなイノベーションは、開発者がモデルのパフォーマンスを向上させるのに役立ちます。

AIモデルがより効率的になるにつれ、量子化とエッジ展開の進歩により、リソースが限られたデバイスでの実行が容易になっている。これらの改善と、Hugging Face ようなツールやUltralytics YOLO11ような高度なコンピュータビジョンモデルとの組み合わせが、スケーラブルで高性能なビジョンAIアプリケーションを構築する鍵となります。

成長中のコミュニティに参加しましょう!GitHubリポジトリでAIについて学び、yolo ライセンスをチェックしてVision AIプロジェクトを始めましょう。ヘルスケアにおけるコンピュータ・ビジョンや 農業におけるコンピュータ・ビジョンのようなイノベーションに興味がありますか?ソリューションのページをご覧ください!