Exploración de la detección de objetos pequeños con Ultralytics YOLO11

Descubra cómo Ultralytics YOLO11 una detección rápida y precisa de objetos pequeños en aplicaciones del mundo real, como la vigilancia y la robótica.

Descubra cómo Ultralytics YOLO11 una detección rápida y precisa de objetos pequeños en aplicaciones del mundo real, como la vigilancia y la robótica.

Los drones integrados con Vision AI pueden volar a cientos de metros sobre el suelo y aún así detect persona que aparece como unos pocos píxeles en su transmisión de vídeo. De hecho, es un reto habitual en aplicaciones como la robótica, la vigilancia y la teledetección, donde los sistemas deben identificar objetos muy pequeños dentro de una imagen.

Sin embargo, los modelos tradicionales de detección de objetos pueden tener dificultades para hacerlo. Los objetos pequeños en imágenes y vídeos representan una información visual muy limitada. En pocas palabras, cuando un modelo los analiza, no hay muchos detalles que aprender o reconocer.

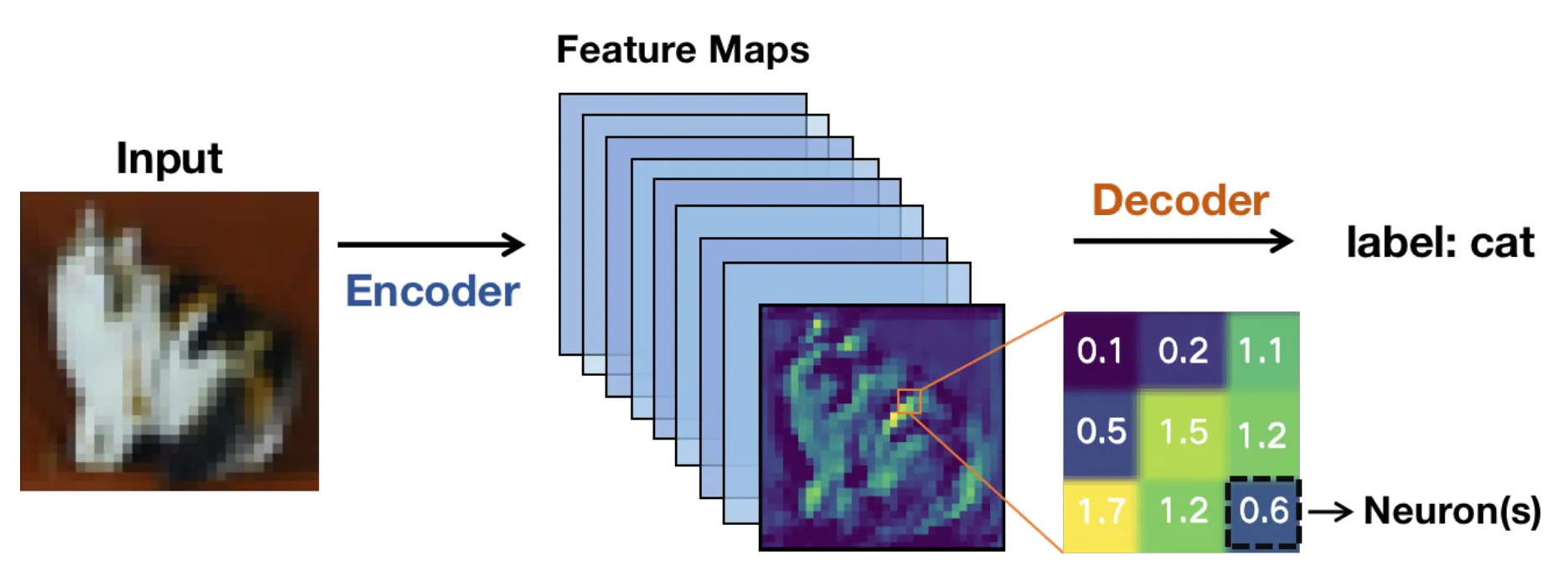

Bajo el capó, estos modelos suelen basarse en una arquitectura basada en redes neuronales convolucionales (CNN). Las imágenes pasan por capas de la red y se transforman en mapas de características o representaciones simplificadas que resaltan patrones relevantes en lugar de píxeles sin procesar.

A medida que la imagen se adentra en la red, estos mapas de características se vuelven más pequeños. Eso agiliza el cálculo, pero también implica que pueden desaparecer los detalles más sutiles.

En el caso de los objetos diminutos, esos detalles son cruciales. Una vez que esos detalles desaparecen, un modelo de visión artificial puede tener dificultades para detectar el objeto, lo que puede dar lugar a cuadros delimitadores menos precisos o inconsistentes.

Los sistemas de visión artificial integral en tiempo real complican aún más las cosas. Las imágenes de alta resolución ayudan a conservar los detalles, pero ralentizan la inferencia y requieren más GPU . Las resoluciones más bajas funcionan más rápido, pero los objetos pequeños se vuelven aún más difíciles de detect.

Se convierte en un equilibrio constante entre velocidad, precisión y límites del hardware. Gracias a los recientes avances tecnológicos, los modelos de visión artificial como Ultralytics YOLO11 y el próximo Ultralytics están diseñados para gestionar este equilibrio de forma más eficaz.

En este artículo, exploraremos por qué es difícil detectar objetos pequeños y cómo YOLO11 facilitar esta tarea. ¡Empecemos!

La detección de objetos pequeños es una tarea de la visión artificial, una rama de la inteligencia artificial, que se centra en identificar y localizar objetos que ocupan una parte muy pequeña de una imagen. Estos objetos suelen estar representados en la imagen por un número limitado de píxeles, que son las unidades más pequeñas de una imagen digital. Esto hace que sean más difíciles de detect los objetivos más grandes y claros (que suelen contener más píxeles).

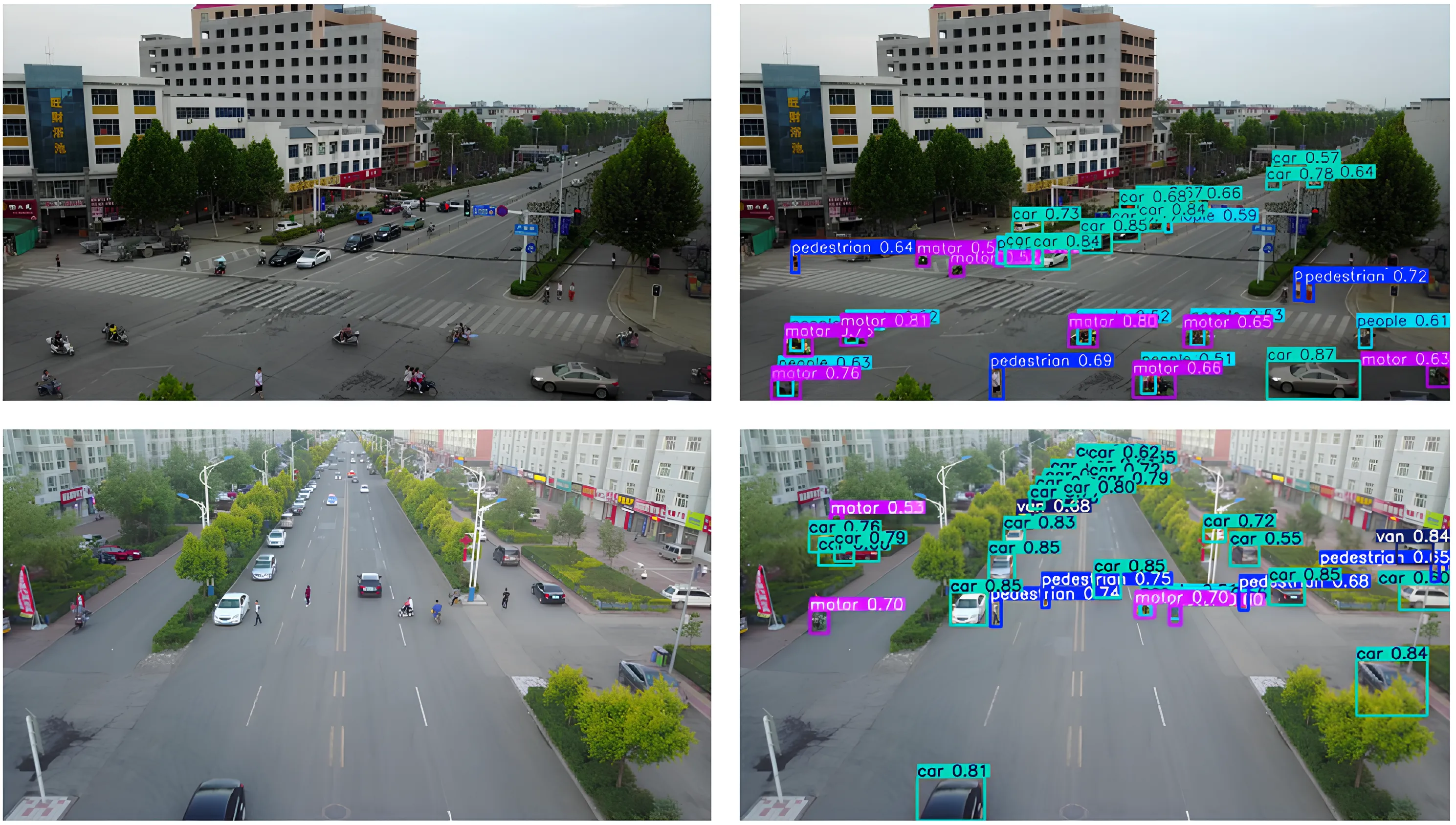

Por ejemplo, los vehículos en imágenes aéreas, las herramientas en una fábrica o las personas captadas por cámaras de vigilancia gran angular pueden aparecer como pequeños objetos dentro de la imagen. Detectarlos es importante porque a menudo contienen información crítica, y muchas aplicaciones del mundo real, como la vigilancia, dependen de estas detecciones para funcionar correctamente.

Cuando se pierden objetos pequeños, el rendimiento del sistema y la toma de decisiones pueden verse afectados. La supervisión mediante vehículos aéreos no tripulados (UAV) es un buen ejemplo, ya que pasar por alto un pequeño objeto en movimiento en el suelo puede afectar a la precisión de la navegación o el seguimiento.

Los sistemas anteriores utilizaban características artesanales y métodos tradicionales de visión por ordenador, que tenían dificultades en escenas concurridas o variadas. Incluso hoy en día, con modelos de aprendizaje profundo que funcionan mucho mejor, sigue siendo difícil detectar objetivos pequeños cuando solo ocupan una parte minúscula de la imagen.

A continuación, veamos algunos de los retos comunes que se presentan en diferentes situaciones reales a la hora de detectar objetos pequeños.

Los objetos pequeños contienen muy pocos píxeles, lo que limita la cantidad de detalles visuales que un modelo puede aprender durante etapas como la extracción de características. Como resultado, los patrones como los bordes, las formas y las texturas son más difíciles de detect, lo que hace que los objetos pequeños sean más propensos a mezclarse con el fondo.

A medida que las imágenes se mueven a través de las capas convolucionales de una red neuronal, la información visual de los píxeles se comprime gradualmente en mapas de características. Esto ayuda a que el modelo siga siendo eficiente, pero también significa que los detalles más sutiles se pierden.

En el caso de objetivos pequeños, las señales importantes pueden desaparecer antes de que la red de detección tenga oportunidad de actuar. Cuando eso ocurre, la localización pierde fiabilidad y los recuadros delimitadores pueden desplazarse, solaparse o perder por completo los objetos objetivo.

Los retos relacionados con el tamaño también suelen surgir por la oclusión. La oclusión se produce cuando los objetos, especialmente los más pequeños, quedan parcialmente ocultos por otros objetos de la escena.

Esto reduce el área visible de un objetivo, lo que limita la información disponible para el detector de objetos. Incluso una pequeña oclusión puede confundir a las redes de detección, especialmente cuando se combina con una entrada de baja resolución. Un ejemplo interesante de esto se puede ver en conjuntos de datos de UAV como VisDrone, donde los peatones, las bicicletas o los vehículos pueden quedar parcialmente bloqueados por edificios, árboles u otros objetos en movimiento.

Del mismo modo, la variación de escala introduce otra dificultad cuando el mismo objeto parece muy pequeño o relativamente grande dependiendo de la distancia y la posición de la cámara. A pesar de estos obstáculos, los algoritmos de detección deben reconocer estos pequeños objetos en diferentes escalas sin perder precisión.

El contexto también desempeña un papel importante en la detección. Por ejemplo, los objetos grandes suelen aparecer con un entorno claro que proporciona pistas visuales útiles. Por otro lado, los objetivos pequeños suelen carecer de esta información contextual, lo que dificulta el reconocimiento de patrones.

Las métricas de evaluación comunes, como la intersección sobre unión (IoU), miden el grado de coincidencia entre el cuadro delimitador predicho y el cuadro de referencia. Si bien IoU bien con objetos grandes, su comportamiento es muy diferente con objetos pequeños.

Los objetos pequeños ocupan solo unos pocos píxeles, por lo que incluso un pequeño desplazamiento en el recuadro previsto puede generar un gran error proporcional y reducir drásticamente la IoU . Esto significa que los objetos pequeños a menudo no alcanzan el IoU estándar utilizado para considerar correcta una predicción, incluso cuando el objeto es visible en la imagen.

Como resultado, los errores de localización son más propensos a clasificarse como falsos positivos o falsos negativos. Estas limitaciones han llevado a los investigadores a replantearse cómo los sistemas de detección de objetos evalúan y manejandetect pequeños ydetect .

A medida que los investigadores trabajaban para mejorar la detección de objetos pequeños, quedó claro que era esencial preservar y representar la información visual en múltiples escalas. Esta idea se refleja en investigaciones recientes de arXiv y en artículos presentados en foros como las conferencias internacionales del IEEE y la Asociación Europea de Visión por Computador (ECCV).

A medida que las imágenes avanzan en una red neuronal, los objetos pequeños pueden perder detalle o desaparecer por completo, por lo que los modelos modernos de visión artificial, como YOLO11 especialmente en mejorar la extracción de características. A continuación, repasaremos los conceptos básicos que subyacen a los mapas de características y las redes piramidales de características para comprenderlos mejor.

Cuando una imagen de entrada, como una imagen de teledetección, entra en una red neuronal, se transforma gradualmente en mapas de características. Se trata de representaciones simplificadas de la imagen que resaltan patrones visuales como bordes, formas y texturas.

A medida que la red se profundiza, estos mapas de características se reducen en tamaño espacial. Esta reducción ayuda al modelo a funcionar de manera eficiente y a centrarse en la información de alto nivel. Sin embargo, los mapas de características reducidos y profundos también reducen los detalles espaciales.

Mientras que los objetos grandes conservan suficiente información visual para una detección precisa, los objetivos pequeños pueden perder detalles críticos tras solo unas pocas capas de red. Cuando esto ocurre, un modelo puede tener dificultades para reconocer que un objeto pequeño existe. Esta es una de las principales razones por las que los objetos pequeños se pasan por alto en los modelos de detección profunda de objetos.

Las redes piramidales de características, a menudo denominadas FPN, se introdujeron para abordar la pérdida de detalle espacial y funcionan como un módulo de apoyo que combina información de múltiples capas para que los modelos puedan detect objetos detect de forma más eficaz. Este proceso también se conoce como agregación de características y fusión de características.

Las capas superficiales proporcionan detalles espaciales precisos, mientras que las capas más profundas añaden contexto semántico, lo que permite un aprendizaje eficaz de características a múltiples escalas. A diferencia del sobremuestreo ingenuo, que simplemente amplía los mapas de características, FPN conserva la información significativa y mejora la detección de objetos pequeños.

Los enfoques modernos se basan en esta idea utilizando la fusión de características adaptativas y diseños sensibles al contexto para mejorar aún más la detección de objetivos pequeños. En otras palabras, FPN ayuda a los modelos a ver tanto el panorama general como los pequeños detalles al mismo tiempo. Esta optimización es esencial cuando los objetos son pequeños.

A continuación, se ofrece una breve descripción de cómo han evolucionado y avanzado los modelos de detección de objetos a lo largo del tiempo para detect mejor detect de diferentes tamaños, incluidos los muy pequeños:

Ahora que comprendemos mejor cómo funciona la detección de objetos pequeños, veamos un par de aplicaciones reales en las que YOLO11 aplicar YOLO11 .

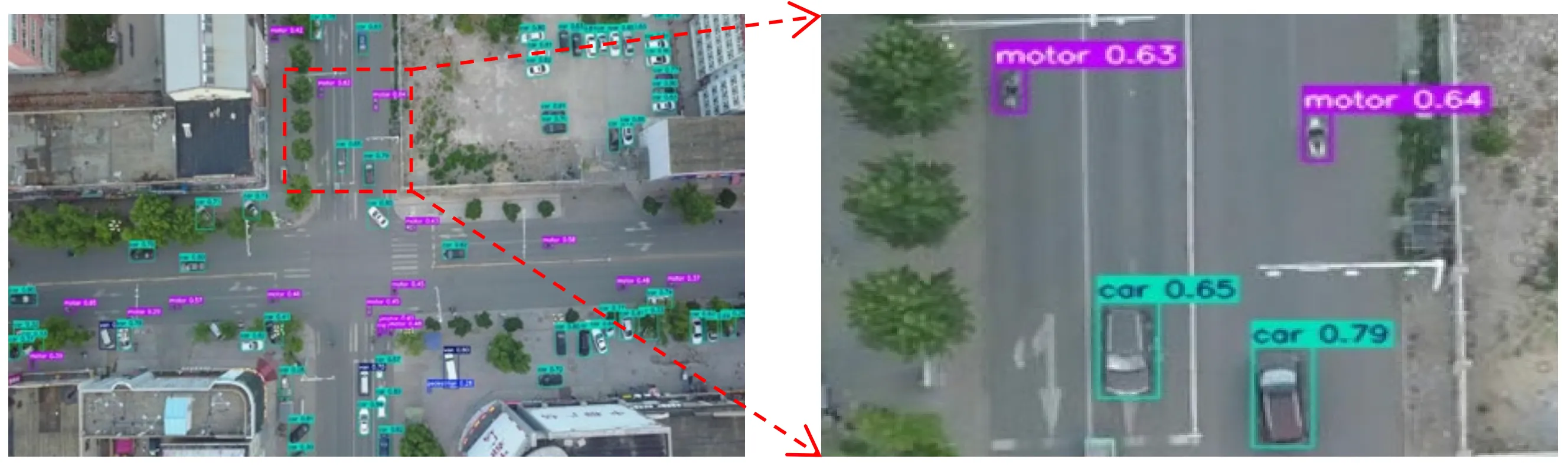

Imagina un dron volando a gran altura sobre una concurrida calle de la ciudad. Desde esa altura, los coches, las bicicletas e incluso las personas se reducen a unos pocos píxeles en una pantalla.

Los módulos de imágenes aéreas y UAV suelen capturar escenas como esta, en las que los objetos de interés son diminutos y están rodeados de fondos desordenados, lo que dificulta su detect por parte de los modelos de visión artificial.

En este tipo de situaciones, YOLO11 ser la opción ideal. Por ejemplo, un dron equipado con un modelo como YOLO11 supervisar el tráfico en tiempo real, detectando vehículos, ciclistas y peatones a medida que se mueven por la escena, incluso cuando cada objeto solo ocupa una pequeña parte de la imagen. Esto permite una toma de decisiones más rápida y una visión más precisa en aplicaciones como la gestión del tráfico, la seguridad pública o la planificación urbana.

Los robots se utilizan a menudo en entornos en los que la precisión y la sincronización son fundamentales. En entornos como almacenes, fábricas y granjas, un robot puede necesitar reconocer objetos muy pequeños, como una pieza en una cadena de montaje, una etiqueta en un paquete o un pequeño brote de planta en un campo, y responder rápidamente.

Detectar objetos de este tamaño puede resultar complicado, especialmente cuando solo aparecen como unos pocos píxeles en la imagen de la cámara o están parcialmente ocultos por otros objetos. Pasar por alto estos pequeños detalles puede ralentizar la automatización o afectar a la capacidad del robot para completar una tarea.

YOLO11 marcar la diferencia en estas situaciones. Su extracción de características mejorada y su rápida inferencia permiten a los robots detect objetos detect en tiempo real y actuar de inmediato.

YOLO11 admite la segmentación de instancias, lo que puede ayudar a los robots a comprender los límites de los objetos y captar los puntos con mayor precisión, en lugar de limitarse a localizar cuadros delimitadores generales. Por ejemplo, un brazo robótico integrado con YOLO11 detectar pequeños componentes en una cinta transportadora, segment forma exacta y recogerlos antes de que se alejen, lo que ayuda al sistema a mantener su eficiencia y fiabilidad.

Con tantos modelos de visión artificial disponibles en la actualidad, quizá se pregunte qué es lo que hace que Ultralytics YOLO11 sobre los demás.

A continuación se indican algunas razones por las que Ultralytics YOLO11 una excelente opción para aplicaciones en las que es necesario detectar objetos pequeños:

Además de utilizar un modelo como YOLO11, la forma en que se preparan las anotaciones, el conjunto de datos general y el procedimiento de entrenamiento del modelo pueden marcar una diferencia significativa en el rendimiento de la detección.

Aquí tienes un resumen rápido de en qué debes centrarte:

La detección de objetos pequeños es difícil porque los objetivos pequeños pierden detalle a medida que las imágenes pasan por un modelo de visión artificial. YOLO11 la forma en que se conservan estos detalles, lo que hace que la detección de objetos pequeños sea más fiable sin sacrificar el rendimiento en tiempo real. Este equilibrio permite YOLO11 una detección precisa y eficiente en aplicaciones del mundo real.

¡Únase a nuestra creciente comunidad! Explore nuestro repositorio de GitHub para obtener más información sobre la IA. Descubra innovaciones como la visión artificial en el comercio minorista y la IA en la industria automotriz visitando nuestras páginas de soluciones. Para comenzar a construir con visión artificial hoy mismo, consulte nuestras opciones de licencia.