Explora la segmentación de conceptos promptable, en qué se diferencia de los métodos tradicionales y cómo modelos relacionados, como YOLOE-26, permiten capacidades de vocabulario abierto.

Explora la segmentación de conceptos promptable, en qué se diferencia de los métodos tradicionales y cómo modelos relacionados, como YOLOE-26, permiten capacidades de vocabulario abierto.

La visión artificial está avanzando rápidamente y se está utilizando ampliamente para analizar imágenes y vídeos en entornos del mundo real. Por ejemplo, se están integrando aplicaciones que van desde sistemas de gestión del tráfico hasta análisis minoristas con modelos de visión artificial.

En muchas de estas aplicaciones, los modelos de visión, como los modelos de detección de objetos, se entrenan para reconocer un conjunto predefinido de objetos, incluidos vehículos, personas y equipos. Durante el entrenamiento, a estos modelos se les muestran muchos ejemplos etiquetados para que puedan aprender cómo aparece cada objeto y cómo distinguirlo de otros en una escena.

Para las tareas de segmentación, los modelos van un paso más allá y producen contornos precisos a nivel de píxel alrededor de estos objetos. Esto permite a los sistemas comprender exactamente dónde se encuentra cada objeto en una imagen.

Esto funciona bien siempre y cuando el sistema solo tenga que reconocer aquello para lo que ha sido entrenado. Sin embargo, en entornos reales, eso rara vez es así.

Las escenas visuales suelen ser dinámicas. Aparecen nuevos objetos y conceptos visuales, las condiciones cambian y los usuarios a menudo desean segment que no formaban parte de la configuración de entrenamiento original.

Estas limitaciones son especialmente evidentes en lo que respecta a la segmentación. A medida que la IA visual sigue evolucionando, crece la necesidad de modelos de segmentación más flexibles que puedan adaptarse a nuevos conceptos sin necesidad de volver a entrenarlos repetidamente. Por eso está ganando atención la segmentación de conceptos promptable (PCS).

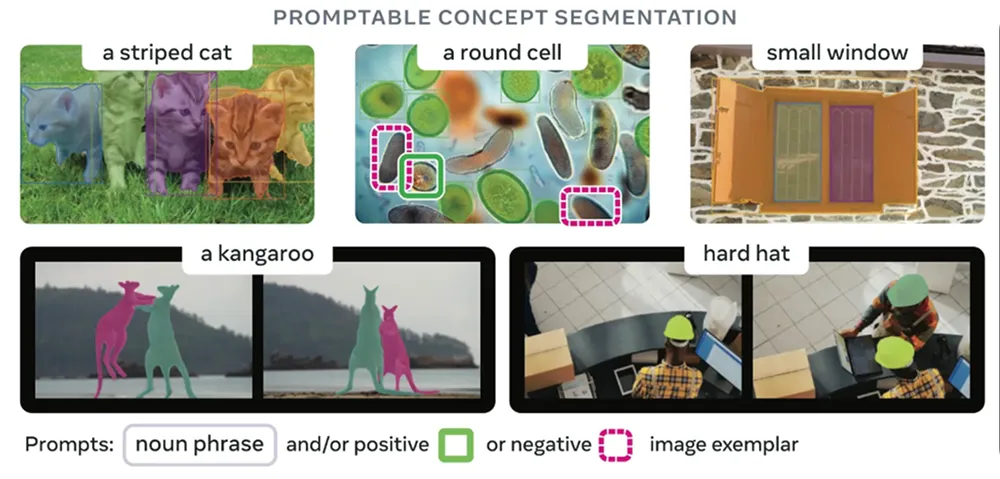

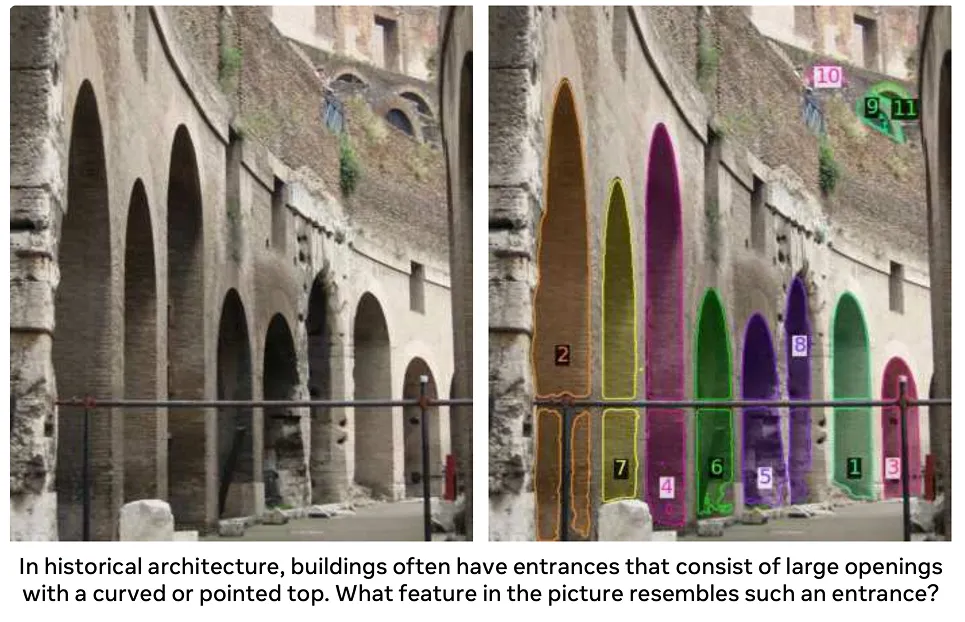

En lugar de basarse en una lista fija de categorías de objetos, los usuarios pueden describir lo que desean segment texto, indicaciones visuales o imágenes de ejemplo. A continuación, estos modelos pueden identificar y segment las regiones que coinciden con el concepto descrito, incluso si dicho concepto no se incluyó explícitamente durante el entrenamiento.

En este artículo, exploraremos cómo funciona la segmentación de conceptos promptable, en qué se diferencia de los enfoques tradicionales y dónde se utiliza actualmente.

En la mayoría de los casos, los modelos de segmentación se entrenan para reconocer una lista reducida de tipos de objetos. Esto funciona bien cuando un sistema de IA visual solo necesita detect segment conjunto específico de objetos.

Sin embargo, en las aplicaciones del mundo real, las escenas visuales son dinámicas. Aparecen nuevos objetos, cambian los requisitos de las tareas y los usuarios a menudo necesitan segment que no estaban incluidos en el conjunto de etiquetas original. Para hacer frente a estas situaciones, normalmente es necesario recopilar nuevos datos y anotaciones de alta calidad y volver a entrenar el modelo, lo que aumenta los costes y ralentiza la implementación.

La segmentación de conceptos por prompt resuelve este problema al permitir a los usuarios indicar al modelo qué buscar, en lugar de elegir entre una lista fija de etiquetas. Los usuarios describen el objeto o la idea que buscan, y el modelo resalta todas las áreas coincidentes en la imagen. Esto facilita mucho la conexión entre la intención del usuario y los píxeles reales de una imagen.

Los modelos que admiten la segmentación de conceptos sugeridos son flexibles porque pueden aceptar diferentes tipos de entradas. En otras palabras, hay más de una forma de indicar al modelo qué debe buscar, como descripciones de texto, pistas visuales o imágenes de ejemplo.

A continuación, analizamos más detenidamente cada enfoque:

Antes de profundizar en cómo funciona la segmentación de conceptos promptable, comparémosla primero con varios métodos tradicionales de segmentación de objetos.

PCS permite modelos de vocabulario abierto y basados en indicaciones. Puede trabajar con nuevas ideas descritas a través de indicaciones, pero la segmentación tradicional no puede. Existen varios tipos diferentes de enfoques de segmentación tradicional, cada uno con sus propias suposiciones y limitaciones.

A continuación, se muestran algunos tipos clave de segmentación tradicional:

Todos estos enfoques se basan en una lista predefinida de categorías de objetos. Funcionan bien dentro de ese ámbito, pero no gestionan muy bien los conceptos que quedan fuera de él. Cuando es necesario segmentar un nuevo objeto específico, normalmente se requieren datos de entrenamiento adicionales y un ajuste del modelo.

PCS pretende cambiar eso. En lugar de estar limitado a categorías predefinidas, te permite describir lo que deseas segment una imagen en el momento de la inferencia.

A continuación, veamos cómo evolucionaron los modelos de segmentación hacia la segmentación de conceptos activables.

Un modelo de base popular que marcó un cambio en la segmentación fue SAM, o Modelo de Segmentación de Cualquier Elemento. Se introdujo en 2023. En lugar de basarse en categorías de objetos predefinidas, SAM los usuarios guiar la segmentación mediante sencillas indicaciones visuales, como puntos o cuadros delimitadores.

Con SAM, los usuarios ya no tenían que seleccionar una etiqueta. Solo tenían que indicar dónde se encontraba un objeto y el modelo generaba una máscara para él. Esto hacía que la segmentación fuera más flexible, pero los usuarios aún tenían que mostrar al modelo dónde debía buscar.

SAM , lanzado en 2024, se basó en esta idea para gestionar escenas más complejas y ampliar la segmentación por indicaciones al vídeo. Mejoró la solidez en diferentes condiciones de iluminación, formas de objetos y movimientos, sin dejar de basarse principalmente en indicaciones visuales para guiar la segmentación.

El modelo SAM es el último paso en esta evolución. Se lanzó el año pasado y es un modelo unificado que combina la comprensión visual con la orientación lingüística, lo que permite un comportamiento coherente en las tareas de segmentación de imágenes y vídeos.

Con SAM , los usuarios no están limitados a señalar o dibujar indicaciones. En su lugar, pueden describir lo que desean segment texto, y el modelo busca en la imagen o en los fotogramas de vídeo las regiones que coinciden con esa descripción.

La segmentación se guía por conceptos en lugar de categorías de objetos fijas, lo que permite un uso abierto del vocabulario en diferentes contextos y a lo largo del tiempo. De hecho, SAM opera en un amplio espacio conceptual aprendido que se basa en una ontología derivada de fuentes como Wikidata y ampliada mediante datos de entrenamiento a gran escala.

En comparación con las versiones anteriores, que se basaban principalmente en indicaciones geométricas, SAM representa un paso hacia una segmentación más flexible y basada en conceptos. Esto lo hace más adecuado para aplicaciones del mundo real, en las que los objetos o ideas de interés pueden cambiar y no siempre se pueden definir de antemano.

Entonces, ¿cómo funciona la segmentación de conceptos promptable? Se basa en grandes modelos de visión y lenguaje visual preentrenados, que son modelos entrenados con colecciones masivas de imágenes y, en muchos casos, texto emparejado. Este entrenamiento les permite aprender patrones visuales generales y significado semántico.

La mayoría de los modelos PCS utilizan arquitecturas basadas en transformadores, que procesan una imagen completa de una sola vez para comprender cómo se relacionan entre sí las diferentes regiones. Un transformador de visión extrae características visuales de la imagen, mientras que un codificador de texto convierte las palabras en representaciones numéricas con las que el modelo puede trabajar.

Durante el entrenamiento, estos modelos pueden aprender de diferentes tipos de supervisión, incluyendo máscaras a nivel de píxel que definen los límites exactos de los objetos, cuadros delimitadores que localizan los objetos de forma aproximada y etiquetas a nivel de imagen que describen lo que aparece en una imagen. El entrenamiento con diferentes tipos de datos etiquetados ayuda al modelo a capturar tanto los detalles más precisos como los conceptos visuales más amplios.

En el momento de la inferencia, es decir, cuando el modelo se utiliza realmente para realizar predicciones, PCS sigue un proceso basado en indicaciones. El usuario proporciona orientación mediante descripciones de texto, pistas visuales como puntos o cuadros, o imágenes de ejemplo. El modelo codifica tanto la indicación como la imagen en una representación interna compartida o incrustaciones e identifica las regiones que se alinean con el concepto descrito.

A continuación, un decodificador de máscaras convierte esta representación compartida en máscaras de segmentación precisas a nivel de píxel. Dado que el modelo vincula las características visuales con el significado semántico, puede segment conceptos incluso si no se incluyeron explícitamente durante el entrenamiento.

Además, a menudo se puede perfeccionar el resultado ajustando la indicación o añadiendo orientaciones adicionales, lo que ayuda al modelo a gestionar escenas complejas o ambiguas. Este proceso iterativo favorece la optimización práctica durante la implementación.

Los modelos de segmentación de conceptos promptables suelen evaluarse en función de su capacidad segment conceptos segment vistos y de su solidez en diferentes escenarios. Los puntos de referencia suelen centrarse en la calidad de la máscara, la generalización y la eficiencia computacional, lo que refleja los requisitos de implementación en el mundo real.

A continuación, veamos dónde se está utilizando ya la segmentación de conceptos sugeribles y dónde está empezando a tener un impacto real.

Las imágenes médicas abarcan muchas estructuras biológicas, enfermedades y tipos de exploraciones, y cada día surgen nuevos casos. Los modelos de segmentación tradicionales tienen dificultades para mantenerse al día con esta variedad.

PCS encaja perfectamente en este espacio porque permite a los médicos describir lo que quieren encontrar en lugar de elegir entre una lista breve y rígida. Con frases de texto o indicaciones visuales, PCS se puede utilizar para segment o áreas de interés directamente, sin necesidad de volver a entrenar el modelo para cada nueva tarea. Esto facilita el manejo de diversas necesidades clínicas, reduce la necesidad de dibujar máscaras manualmente y funciona en muchos tipos de imágenes.

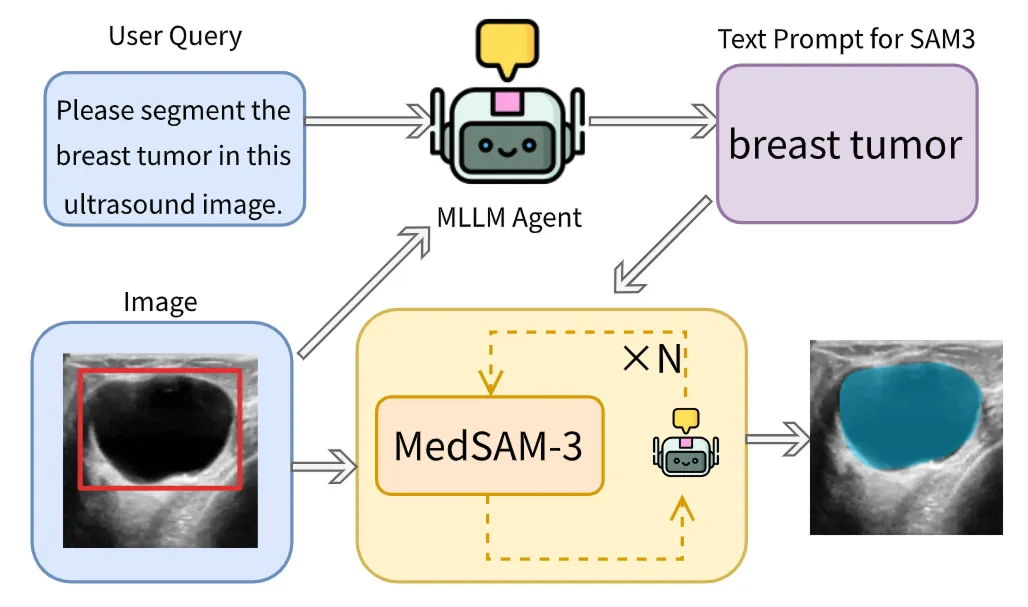

Un buen ejemplo es MedSAM-3, que adapta la arquitectura SAM para PCS con indicaciones de texto en imágenes médicas. Este modelo puede recibir indicaciones con términos anatómicos y patológicos explícitos, como nombres de órganos (por ejemplo, hígado o riñón) y conceptos relacionados con lesiones (por ejemplo, tumor o lesión). Una vez recibida la indicación, el modelo segmenta directamente la región correspondiente en la imagen médica.

MedSAM-3 también integra modelos lingüísticos multimodales de gran tamaño (MLLM o LLM multimodales), que pueden razonar tanto sobre texto como sobre imágenes. Estos modelos funcionan en una configuración de agente en bucle, en la que los resultados se refinan de forma iterativa para mejorar la precisión en los casos más difíciles.

MedSAM-3 ofrece un buen rendimiento con datos de rayos X, resonancia magnética, tomografía computarizada, ecografía y vídeo, lo que pone de relieve cómo PCS puede permitir flujos de trabajo de imágenes médicas más flexibles y eficientes en entornos clínicos reales.

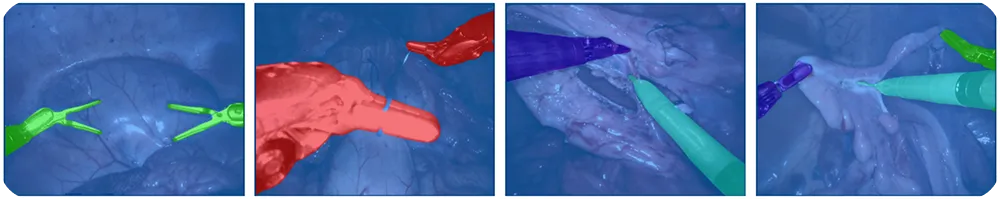

La cirugía robótica se basa en sistemas de visión para track y comprender escenas quirúrgicas que cambian rápidamente. Los instrumentos se mueven rápidamente, la iluminación varía y pueden aparecer nuevas herramientas en cualquier momento, lo que dificulta el mantenimiento de los sistemas de etiquetado predefinidos.

Con PCS, los robots pueden track , guiar cámaras y seguir los pasos quirúrgicos en tiempo real. Esto reduce el etiquetado manual y facilita la adaptación de los sistemas a diferentes procedimientos. Los cirujanos o los sistemas automatizados pueden utilizar indicaciones de texto como «pinza», «bisturí» o «herramienta de cámara» para indicar qué se debe segmentar en una imagen.

Otro modelo interesante y de última generación relacionado con la segmentación de conceptos por prompt es nuestro Ultralytics . Nuestro modelo aporta segmentación de vocabulario abierto y basada en prompts a la familiaYOLO Ultralytics YOLO .

YOLOE-26 se basa en la arquitectura Ultralytics y admite la segmentación de instancias de vocabulario abierto. YOLOE-26 permite a los usuarios guiar la segmentación de varias maneras.

Admite indicaciones de texto, en las que frases cortas y visualmente fundamentadas pueden especificar el objeto de destino, así como indicaciones visuales, que proporcionan orientación adicional basada en señales de imagen. Además, YOLOE-26 incluye un modo sin indicaciones para la inferencia sin disparo, en el que el modelo detecta y segmenta objetos a partir de un vocabulario integrado sin necesidad de indicaciones del usuario.

YOLOE-26 es ideal para aplicaciones como el análisis de vídeo, la percepción robótica y los sistemas basados en el borde, en los que las categorías de objetos pueden cambiar, pero la baja latencia y el rendimiento fiable siguen siendo esenciales. También es especialmente útil para el etiquetado de datos y la curación de conjuntos de datos, ya que agiliza los flujos de trabajo al automatizar partes del proceso de anotación.

Estas son algunas de las principales ventajas de utilizar la segmentación de conceptos promptable:

Aunque el PCS tiene claras ventajas, hay algunas limitaciones que hay que tener en cuenta:

A medida que explore la segmentación promptable, es posible que se pregunte para qué aplicaciones es más adecuada y cuándo un modelo de visión artificial tradicional como YOLO26 es más adecuado para el problema que está tratando de resolver. La segmentación promptable funciona bien para objetos generales, pero no es adecuada para casos de uso que requieren resultados muy precisos y consistentes.

La detección de defectos es un buen ejemplo. En la fabricación, los defectos suelen ser pequeños y sutiles, como pequeños arañazos, abolladuras, desalineaciones o irregularidades en la superficie. También pueden variar mucho en función de los materiales, la iluminación y las condiciones de producción.

Estos problemas son difíciles de describir con una simple indicación y aún más difíciles de detect para un modelo de uso general. En general, los modelos basados en indicaciones tienden a pasar por alto defectos o a producir resultados inestables, mientras que los modelos entrenados específicamente con datos de defectos son mucho más fiables para los sistemas de inspección del mundo real.

La segmentación de conceptos promptable facilita la adaptación de los sistemas de visión al mundo real, donde constantemente aparecen nuevos objetos e ideas. En lugar de quedar limitados a etiquetas fijas, los usuarios pueden simplemente describir lo que desean segment dejar que el modelo haga el resto, lo que ahorra tiempo y reduce el trabajo manual. Aunque todavía tiene limitaciones, la PCS ya está cambiando la forma en que se utiliza la segmentación en la práctica y es probable que se convierta en una parte fundamental de los futuros sistemas de visión.

Explora más sobre la IA visitando nuestro repositorio GitHub y uniéndote a nuestra comunidad. Echa un vistazo a nuestras páginas de soluciones para obtener más información sobre la IA en robótica y la visión artificial en la fabricación. ¡Descubre nuestras opciones de licencia para empezar a utilizar Vision AI hoy mismo!