Explorando SAM 3: el nuevo modelo Segment Anything de Meta AI

Descubra cómo SAM 3, el nuevo Segment Anything Model de Meta AI, facilita la detect, segment y track objetos en imágenes y vídeos del mundo real.

Descubra cómo SAM 3, el nuevo Segment Anything Model de Meta AI, facilita la detect, segment y track objetos en imágenes y vídeos del mundo real.

El 19 de noviembre de 2025, Meta AI lanzó Segment Anything Model 3, también conocido como SAM 3. Esta última versión del Segment Anything Model introduce nuevas formas de detect, segment y track objetos en imágenes y vídeos del mundo real utilizando indicaciones de texto, indicaciones visuales y ejemplos de imágenes.

El modelo SAM 3 se basa en SAM y SAM 2 y aporta nuevos avances y funciones como la segmentación de conceptos, la detección de vocabulario abierto y el seguimiento de vídeo en tiempo real. Es capaz de comprender frases sustantivas cortas, seguir objetos a lo largo de los fotogramas e identificar conceptos raros o muy precisos que los modelos anteriores no podían manejar con la misma coherencia.

Como parte del lanzamiento de SAM 3, Meta también presentó SAM 3D. Este conjunto de modelos de nueva generación reconstruye objetos, escenas y cuerpos humanos completos a partir de una sola imagen y amplía el ecosistema de Segment Anything a la comprensión tridimensional. Estas incorporaciones abren nuevas aplicaciones en visión por ordenador, robótica, edición multimedia y flujos de trabajo creativos.

En este artículo exploraremos qué es SAM 3, qué lo diferencia de SAM 2, cómo funciona el modelo y sus aplicaciones en el mundo real. Empecemos.

SAM 3 es un modelo de visión por ordenador de última generación que puede identificar, separar y track objetos en imágenes y vídeos a partir de instrucciones sencillas. En lugar de basarse en una lista fija de etiquetas, SAM 3 entiende el lenguaje natural y las pistas visuales, por lo que es fácil decirle al modelo lo que quieres encontrar.

Por ejemplo, con SAM 3, puede escribir una frase corta como "autobús escolar amarillo" o "un gato a rayas", hacer clic en un objeto o resaltar un ejemplo en una imagen. El modelo detect entonces todos los objetos que coincidan y generará máscaras de segmentación limpias (un contorno visual que muestra exactamente qué píxeles pertenecen a un objeto). SAM 3 también puede seguir esos objetos a través de los fotogramas de vídeo, manteniéndolos coherentes a medida que se mueven.

Otra parte interesante del anuncio de Meta AI es SAM 3D, que amplía el proyecto Segment Anything a la comprensión tridimensional. SAM 3D puede tomar una sola imagen 2D y reconstruir la forma, la pose o la estructura de un objeto o un cuerpo humano en tres dimensiones. En otras palabras, el modelo puede estimar cómo algo ocupa el espacio incluso cuando sólo se dispone de un punto de vista.

SAM 3D se ha lanzado en dos modelos diferentes: SAM 3D Objects, que reconstruye objetos cotidianos con geometría y textura, y SAM 3D Body, que estima la forma y la pose del cuerpo humano a partir de una sola imagen. Ambos modelos utilizan el resultado de la segmentación de SAM 3 y generan una representación 3D que se ajusta al aspecto y la posición del objeto en la foto original.

Estas son algunas de las actualizaciones clave que introduce SAM 3 para reunir la detección, la segmentación y el seguimiento en un modelo unificado:

Supongamos que estás viendo un vídeo de safari con muchos animales diferentes y quieres detect y segment sólo los elefantes. ¿Cómo sería esta tarea en las distintas versiones de SAM?

Con SAM, tendría que hacer clic manualmente en cada elefante de cada fotograma para generar una máscara de segmentación. No hay seguimiento, por lo que cada nuevo fotograma requiere nuevos clics.

Con SAM 2, se podía hacer clic una vez en un elefante, obtener su máscara y el modelo track a ese mismo elefante a través del vídeo. Sin embargo, si desea segment varios elefantes (objetos específicos), tendrá que hacer clics por separado, ya que SAM 2 no entiende por sí solo categorías como "elefante".

Con SAM 3, el flujo de trabajo es mucho más sencillo. Puede escribir "elefante" o dibujar un recuadro alrededor de un elefante para dar un ejemplo, y el modelo encontrará automáticamente todos los elefantes del vídeo, los segment y los track de forma coherente a lo largo de los fotogramas. Sigue siendo compatible con las indicaciones de clic y cuadro utilizadas en versiones anteriores, pero ahora también puede responder a indicaciones de texto e imágenes de ejemplo, algo que SAM y SAM 2 no podían hacer.

A continuación veremos cómo funciona el modelo SAM 3 y cómo se ha entrenado.

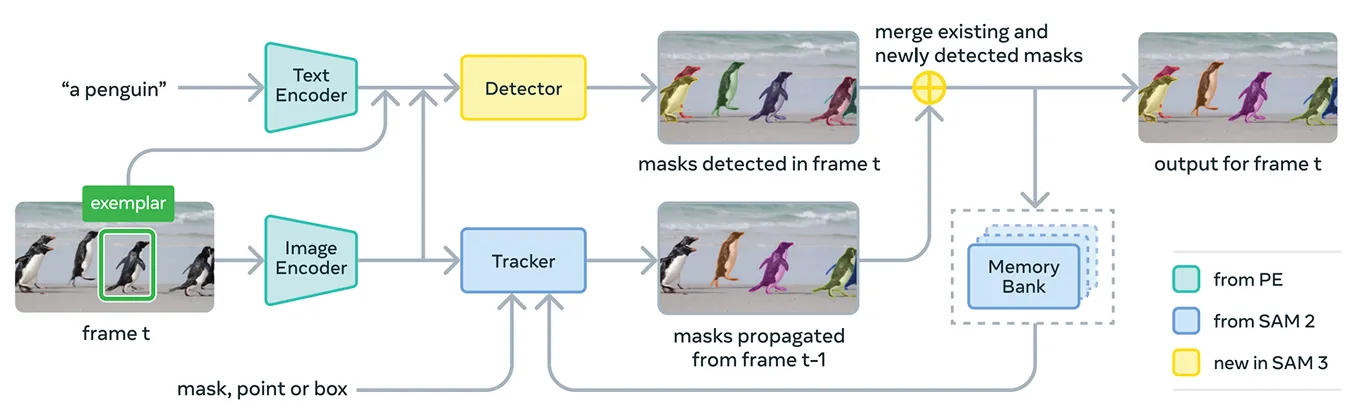

SAM 3 reúne varios componentes para dar soporte a indicaciones conceptuales y visuales en un único sistema. En su núcleo, el modelo utiliza Meta Perception Encoder, el codificador unificado de imagen-texto de código abierto de Meta.

Este codificador puede procesar tanto imágenes como frases nominales cortas. En pocas palabras, esto permite a SAM 3 vincular las características lingüísticas y visuales de forma más eficaz que las versiones anteriores del Segment Anything Model.

Además de este codificador, SAM 3 incluye un detector basado en la familia de modelos de transformadores DETR. Este detector identifica los objetos de la imagen y ayuda al sistema a determinar qué objetos corresponden a la indicación del usuario.

En concreto, para la segmentación de vídeo, SAM 3 utiliza un componente de seguimiento basado en el banco de memoria y el codificador de memoria de SAM 2. Esto permite al modelo retener información sobre los objetos a lo largo de los fotogramas para poder reidentificarlos y rastrearlos en el tiempo. De este modo, el modelo conserva información sobre los objetos a lo largo de los fotogramas para poder reidentificarlos y track lo largo del tiempo.

Para entrenar SAM 3, Meta necesitaba muchos más datos anotados de los que existen actualmente en Internet. Las máscaras de segmentación y las etiquetas de texto de alta calidad son difíciles de crear a gran escala, y delinear completamente cada instancia de un concepto en imágenes y vídeos es lento y costoso.

Para solucionarlo, Meta ha creado un nuevo motor de datos que combina el propio SAM 3, otros modelos de IA y anotadores humanos. El flujo de trabajo comienza con una serie de sistemas de IA, entre ellos SAM 3 y un modelo de subtitulado basado en Llama.

Estos sistemas escanean grandes colecciones de imágenes y vídeos, generan subtítulos, convierten esos subtítulos en etiquetas de texto y producen candidatos a máscaras de segmentación temprana. A continuación, anotadores humanos y de IA revisan estos candidatos.

Los anotadores de IA, entrenados para igualar o incluso superar la precisión humana en tareas como la comprobación de la calidad de las máscaras y la verificación de la cobertura de conceptos, filtran los casos sencillos. Los humanos solo intervienen en los ejemplos más complicados, en los que el modelo puede tener dificultades.

Este enfoque da a Meta un gran impulso en la velocidad de anotación. Al dejar que los anotadores de IA se ocupen de los casos fáciles, el proceso se hace cinco veces más rápido en las indicaciones negativas y un 36% más rápido en las positivas en los dominios más precisos.

Esta eficiencia permitió ampliar el conjunto de datos a más de cuatro millones de conceptos únicos. El bucle constante de propuestas de IA, correcciones humanas y predicciones actualizadas del modelo también mejora la calidad de las etiquetas con el tiempo y ayuda a SAM 3 a aprender un conjunto mucho más amplio de conceptos visuales y textuales.

En cuanto al rendimiento, SAM 3 ofrece una clara mejora respecto a los modelos anteriores. En la nueva prueba SA-Co de Meta, que evalúa la detección y segmentación de conceptos de vocabulario abierto, SAM 3 consigue aproximadamente el doble de rendimiento que los sistemas anteriores, tanto en imágenes como en vídeo.

También iguala o supera SAM 2 en tareas visuales interactivas como punto a máscara y máscara a máscara. Meta presenta mejoras adicionales en evaluaciones más difíciles, como el LVIS de disparo cero (en el que los modelos deben reconocer categorías poco frecuentes sin ejemplos de entrenamiento) y el recuento de objetos (que mide si se detectan todas las instancias de un objeto), lo que pone de relieve una mayor generalización en distintos dominios.

Además de estas mejoras de precisión, SAM 3 es eficiente, ya que procesa una imagen con más de 100 objetos detectados en unos 30 milisegundos en una GPU H200 y mantiene velocidades cercanas al tiempo real cuando rastrea múltiples objetos en vídeo.

Ahora que conocemos mejor SAM 3, vamos a ver cómo se utiliza en aplicaciones reales, desde el razonamiento avanzado guiado por texto hasta la investigación científica y los propios productos de Meta.

SAM 3 también puede utilizarse como herramienta dentro de un modelo de lenguaje multimodal más amplio, que Meta denomina Agente SAM 3. En lugar de dar a SAM 3 una frase corta como "elefante", el agente puede dividir una pregunta más complicada en indicaciones más pequeñas que SAM 3 entienda.

Por ejemplo, si el usuario pregunta: "¿Qué objeto de la imagen se utiliza para controlar y guiar a un caballo?", el agente prueba con distintas frases sustantivadas, las envía a SAM 3 y comprueba qué máscaras tienen sentido. Sigue refinando hasta que encuentra el objeto correcto.

Incluso sin haber sido entrenado en conjuntos de datos de razonamiento especiales, el agente SAM 3 obtiene buenos resultados en pruebas de referencia diseñadas para consultas de texto complejas, como ReasonSeg y OmniLabel. Esto demuestra que SAM 3 es compatible con sistemas que necesitan tanto comprensión lingüística como segmentación visual precisa.

Curiosamente, SAM 3 ya se utiliza en entornos de investigación en los que son importantes las etiquetas visuales detalladas. Meta colaboró con Conservation X Labs y Osa Conservation en la creación de SA-FARI, un conjunto de datos públicos de seguimiento de la fauna salvaje con más de 10.000 vídeos de cámaras trampa.

Cada animal de cada fotograma se etiqueta con recuadros y máscaras de segmentación, algo que llevaría muchísimo tiempo anotar a mano. Del mismo modo, en la investigación oceánica, SAM 3 se está utilizando junto con FathomNet y MBARI para crear máscaras de segmentación de instancias para imágenes submarinas y respaldar nuevos parámetros de evaluación.

Estos conjuntos de datos ayudan a los científicos a analizar las secuencias de vídeo con mayor eficacia y a estudiar animales y hábitats que suelen ser difíciles de track a escala. Los investigadores también pueden utilizar estos recursos para construir sus propios modelos de identificación de especies, análisis de comportamientos y seguimiento ecológico automatizado.

Además de sus usos en investigación, SAM 3 también está impulsando nuevas funciones y casos de uso en los productos de consumo de Meta. He aquí algunas de las formas en que ya se está integrando:

SAM 3 es un emocionante paso adelante en la segmentación. Introduce segmentación de conceptos, indicaciones de texto de vocabulario abierto y seguimiento mejorado. Con un rendimiento notablemente superior tanto en imágenes como en vídeo, y la incorporación de SAM 3D, el conjunto de modelos abre nuevas posibilidades para la IA de visión, las herramientas creativas, la investigación científica y los productos del mundo real.

Únase a nuestra comunidad y explore nuestro repositorio de GitHub para descubrir más sobre la IA. Si desea crear su propio proyecto de Vision AI, consulte nuestras opciones de licencia. Descubra más sobre aplicaciones como la IA en la sanidad y Vision AI en el comercio minorista visitando nuestras páginas de soluciones.