Explorer la détection de petits objets avec Ultralytics YOLO11

Découvrez comment Ultralytics YOLO11 une détection rapide et précise des petits objets dans des applications concrètes telles que la surveillance et la robotique.

Découvrez comment Ultralytics YOLO11 une détection rapide et précise des petits objets dans des applications concrètes telles que la surveillance et la robotique.

Les drones équipés de la technologie Vision AI peuvent voler à des centaines de mètres au-dessus du sol et être capables de detect personne qui n'apparaît que sous la forme de quelques pixels dans leur flux vidéo. En fait, il s'agit d'un défi courant dans des applications telles que la robotique, la surveillance et la télédétection, où les systèmes doivent identifier des objets très petits dans une image.

Mais les modèles traditionnels de détection d'objets peuvent avoir du mal à le faire. Les petits objets présents dans les images et les vidéos représentent des informations visuelles très limitées. En termes simples, lorsqu'un modèle les examine, il n'y a pas beaucoup de détails à apprendre ou à reconnaître.

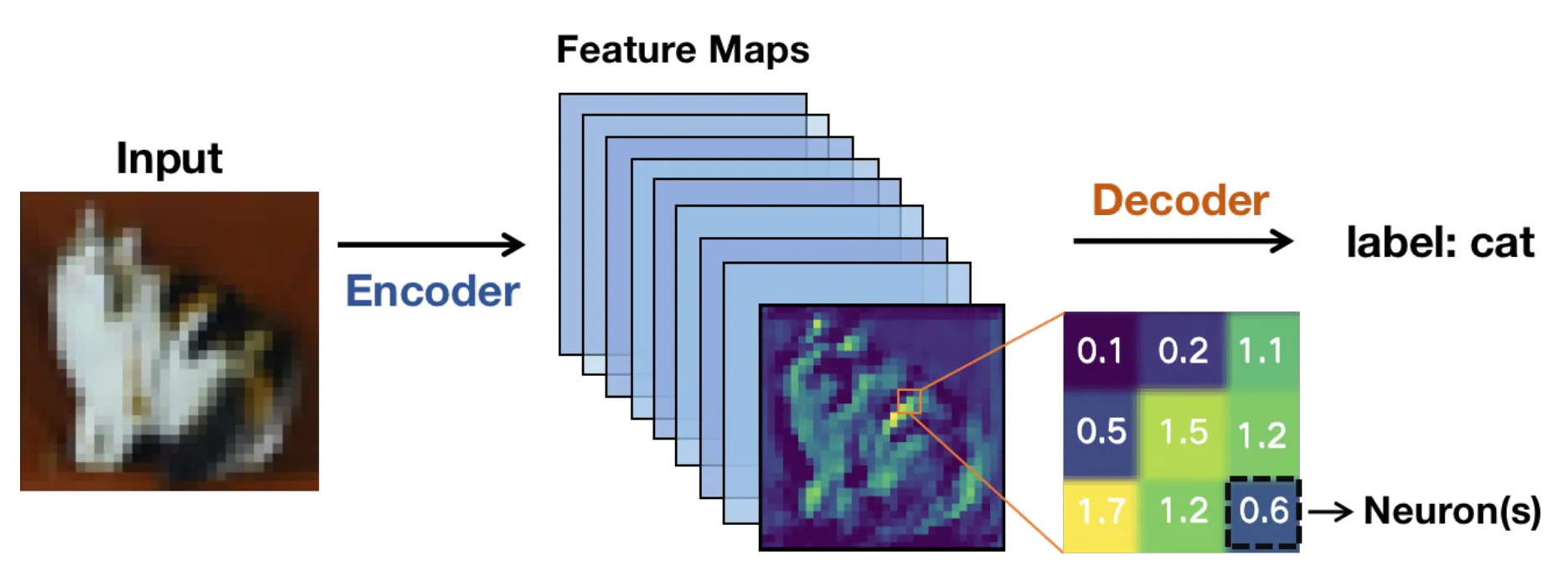

Sous le capot, ces modèles s'appuient généralement sur une architecture basée sur un réseau neuronal convolutif (CNN). Les images sont transmises à travers les couches du réseau et transformées en cartes de caractéristiques ou en représentations simplifiées qui mettent en évidence les motifs pertinents plutôt que les pixels bruts.

À mesure que l'image progresse dans le réseau, ces cartes de caractéristiques deviennent plus petites. Cela accélère le calcul, mais cela signifie également que les détails fins peuvent disparaître.

Pour les objets minuscules, ces détails sont essentiels. Une fois ces détails disparus, un modèle de vision par ordinateur peut avoir des difficultés à détecter l'objet, ce qui peut entraîner des cadres de sélection moins précis ou incohérents.

Les systèmes de vision par ordinateur de bout en bout en temps réel rendent cela encore plus difficile. Les images haute résolution permettent de préserver les détails, mais elles ralentissent l'inférence et nécessitent plus GPU . Les résolutions plus faibles fonctionnent plus rapidement, mais les petits objets deviennent encore plus difficiles à detect.

Il s'agit d'un équilibre constant entre vitesse, précision et limites matérielles. Grâce aux récentes avancées technologiques, les modèles de vision par ordinateur tels que Ultralytics YOLO11 et le prochain Ultralytics sont conçus pour gérer plus efficacement ce compromis.

Dans cet article, nous allons explorer les raisons pour lesquelles la détection de petits objets est difficile et comment YOLO11 la faciliter. C'est parti !

La détection de petits objets est une tâche relevant de la vision par ordinateur, une branche de l'IA, qui consiste à identifier et à localiser des objets occupant une très petite partie d'une image. Ces objets sont souvent représentés dans l'image par un nombre limité de pixels, qui sont les plus petites unités d'une image numérique. Cela les rend plus difficiles à detect des cibles plus grandes et plus nettes (qui contiennent souvent plus de pixels).

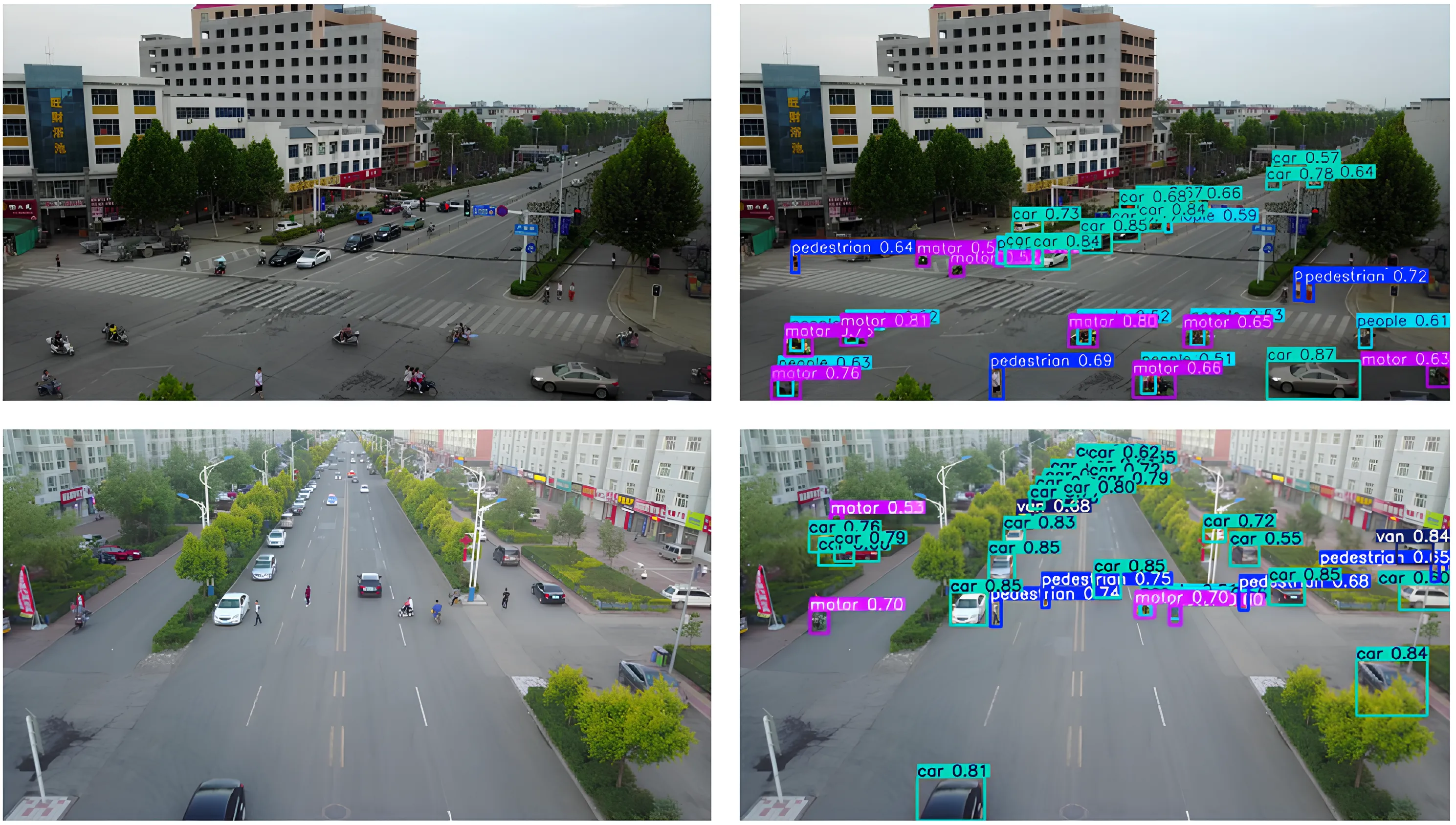

Par exemple, les véhicules sur les images aériennes, les outils dans une usine ou les personnes filmées par des caméras de surveillance grand angle peuvent tous apparaître comme de petits objets dans l'image. Il est important de les détecter, car ils contiennent souvent des informations cruciales et de nombreuses applications concrètes, telles que la surveillance, dépendent de ces détections pour fonctionner correctement.

Lorsque de petits objets sont manqués, les performances du système et la prise de décision peuvent être affectées. La surveillance par drone (UAV) en est un bon exemple, où le fait de manquer un petit objet en mouvement au sol peut avoir un impact sur la précision de la navigation ou du suivi.

Les systèmes antérieurs utilisaient des fonctionnalités artisanales et des méthodes traditionnelles de vision par ordinateur, qui rencontraient des difficultés dans les scènes animées ou variées. Même aujourd'hui, avec des modèles d'apprentissage profond beaucoup plus performants, il reste difficile de détecter de petites cibles lorsqu'elles n'occupent qu'une infime partie de l'image.

Examinons maintenant quelques-uns des défis courants qui se posent dans différents scénarios réels lors de la détection de petits objets.

Les petits objets contiennent très peu de pixels, ce qui limite la quantité de détails visuels qu'un modèle peut apprendre au cours d'étapes telles que l'extraction de caractéristiques. Par conséquent, les motifs tels que les contours, les formes et les textures sont plus difficiles à detect, ce qui rend les petits objets plus susceptibles de se fondre dans l'arrière-plan.

Lorsque les images traversent les couches convolutives d'un réseau neuronal, les informations visuelles contenues dans les pixels sont progressivement compressées en cartes de caractéristiques. Cela permet au modèle de rester efficace, mais cela signifie également que les détails fins s'estompent.

Pour les petites cibles, des indices importants peuvent disparaître avant que le réseau de détection n'ait eu le temps d'agir. Lorsque cela se produit, la localisation devient moins fiable et les cadres de sélection peuvent se déplacer, se chevaucher ou manquer complètement les objets cibles.

Les problèmes liés à la taille sont également souvent soulevés par l'occlusion. L'occlusion se produit lorsque des objets, en particulier les plus petits, sont partiellement masqués par d'autres objets dans la scène.

Cela réduit la zone visible d'une cible, ce qui limite les informations disponibles pour le détecteur d'objets. Même une petite occlusion peut perturber les réseaux de détection, en particulier lorsqu'elle est associée à une entrée à faible résolution. On en trouve un exemple intéressant dans les ensembles de données UAV tels que VisDrone, où les piétons, les vélos ou les véhicules peuvent être partiellement masqués par des bâtiments, des arbres ou d'autres objets en mouvement.

De même, la variance d'échelle introduit une autre difficulté lorsque le même objet apparaît très petit ou relativement grand selon la distance et la position de la caméra. Malgré ces obstacles, les algorithmes de détection doivent reconnaître ces petits objets à différentes échelles sans perdre en précision.

Le contexte joue également un rôle important dans la détection. Par exemple, les objets de grande taille apparaissent généralement dans un environnement clair qui fournit des repères visuels utiles. En revanche, les cibles de petite taille ne disposent souvent pas de ces informations contextuelles, ce qui rend la reconnaissance des formes plus difficile.

Les mesures d'évaluation courantes, telles que l'intersection sur l'union (IoU), mesurent le degré de chevauchement entre un cadre de sélection prédit et le cadre de référence. Si IoU bien pour les objets de grande taille, son comportement est très différent pour les petits objets.

Les petits objets n'occupent que quelques pixels, de sorte que même un léger décalage dans la boîte prédite peut créer une erreur proportionnelle importante et réduire considérablement le IoU . Cela signifie que les petits objets ne parviennent souvent pas à atteindre le IoU standard utilisé pour considérer une prédiction comme correcte, même lorsque l'objet est visible dans l'image.

En conséquence, les erreurs de localisation sont plus susceptibles d'être classées comme des faux positifs ou des faux négatifs. Ces limites ont incité les chercheurs à repenser la manière dont les systèmes de détection d'objets évaluent et traitentdetect petites etdetect .

Au fur et à mesure que les chercheurs s'efforçaient d'améliorer la détection des petits objets, il est apparu clairement qu'il était essentiel de préserver et de représenter les informations visuelles à plusieurs échelles. Cette idée se retrouve dans les récentes recherches arXiv et dans les articles présentés lors de conférences telles que les conférences internationales IEEE et celles de l'Association européenne de vision par ordinateur (ECCV).

À mesure que les images progressent dans un réseau neuronal, les petits objets peuvent perdre des détails ou disparaître complètement. C'est pourquoi les modèles modernes de vision par ordinateur, tels que YOLO11 une grande importance à l'amélioration de l'extraction des caractéristiques. Passons maintenant en revue les concepts fondamentaux qui sous-tendent les cartes de caractéristiques et les réseaux pyramidaux de caractéristiques afin de mieux les comprendre.

Lorsqu'une image d'entrée, telle qu'une image de télédétection, entre dans un réseau neuronal, elle est progressivement transformée en cartes de caractéristiques. Il s'agit de représentations simplifiées de l'image qui mettent en évidence des motifs visuels tels que les contours, les formes et les textures.

À mesure que le réseau s'approfondit, ces cartes de caractéristiques deviennent plus petites en taille spatiale. Cette réduction aide le modèle à fonctionner efficacement et à se concentrer sur les informations de haut niveau. Cependant, la réduction et l'approfondissement des cartes de caractéristiques réduisent également les détails spatiaux.

Alors que les objets de grande taille conservent suffisamment d'informations visuelles pour permettre une détection précise, les petites cibles peuvent perdre des détails essentiels après seulement quelques couches réseau. Lorsque cela se produit, un modèle peut avoir du mal à reconnaître l'existence même d'un petit objet. C'est l'une des principales raisons pour lesquelles les petits objets sont ignorés dans les modèles de détection d'objets profonds.

Les réseaux pyramidaux de caractéristiques, souvent appelés FPN, ont été introduits pour pallier la perte de détails spatiaux. Ils fonctionnent comme un module de soutien qui combine les informations provenant de plusieurs couches afin que les modèles puissent detect plus efficacement les detect objets. Ce processus est également connu sous le nom d'agrégation et de fusion de caractéristiques.

Les couches superficielles fournissent des détails spatiaux fins, tandis que les couches plus profondes ajoutent un contexte sémantique, permettant un apprentissage efficace des caractéristiques à plusieurs échelles. Contrairement à l'upsampling naïf, qui se contente d'agrandir les cartes de caractéristiques, le FPN préserve les informations significatives et améliore la détection des petits objets.

Les approches modernes s'appuient sur cette idée en utilisant la fusion adaptative des caractéristiques et des conceptions sensibles au contexte afin d'améliorer encore la détection des petites cibles. En d'autres termes, le FPN aide les modèles à voir à la fois la vue d'ensemble et les moindres détails. Cette optimisation est essentielle lorsque les objets sont petits.

Voici un aperçu de l'évolution et des progrès réalisés au fil du temps par les modèles de détection d'objets afin de mieux detect de différentes tailles, y compris les plus petits :

Maintenant que nous comprenons mieux comment fonctionne la détection de petits objets, examinons quelques applications concrètes où YOLO11 être utilisé.

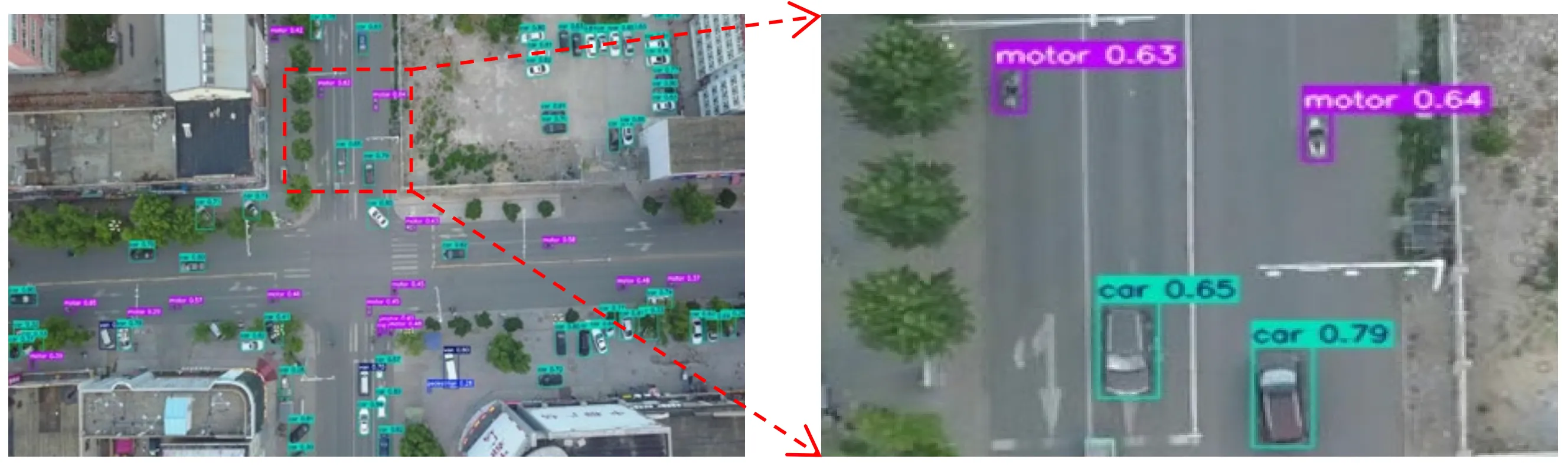

Imaginez un drone volant au-dessus d'une rue animée d'une grande ville. De cette hauteur, les voitures, les vélos et même les gens ne sont plus que quelques pixels sur un écran.

Les modules d'imagerie aérienne et par drone capturent souvent des scènes comme celle-ci, où les objets d'intérêt sont minuscules et entourés d'arrière-plans encombrés, ce qui rend leur detect difficile pour les modèles de vision par ordinateur.

Dans ce type de scénario, YOLO11 être un choix de modèle idéal. Par exemple, un drone équipé d'un modèle tel que YOLO11 surveiller le trafic en temps réel, détectant les véhicules, les cyclistes et les piétons qui se déplacent dans la scène, même lorsque chaque objet n'occupe qu'une petite partie de l'image. Cela permet une prise de décision plus rapide et des informations plus précises dans des applications telles que la gestion du trafic, la sécurité publique ou l'urbanisme.

Les robots sont souvent utilisés dans des environnements où la précision et le timing sont essentiels. Dans des environnements tels que les entrepôts, les usines et les exploitations agricoles, un robot peut être amené à reconnaître des objets très petits, tels qu'une pièce sur une chaîne de montage, une étiquette sur un colis ou un petit bourgeon dans un champ, et à réagir rapidement.

La détection d'objets de cette taille peut s'avérer compliquée, en particulier lorsqu'ils n'apparaissent que sous la forme de quelques pixels dans le flux vidéo de la caméra ou lorsqu'ils sont partiellement masqués par d'autres objets. Le fait de passer à côté de ces petits détails peut ralentir l'automatisation ou affecter la capacité du robot à accomplir une tâche.

YOLO11 faire la différence dans ces situations. Son extraction améliorée des caractéristiques et son inférence rapide permettent aux robots de detect objets en temps réel et d'agir immédiatement.

YOLO11 prend YOLO11 en charge la segmentation d'instances, qui peut aider les robots à comprendre les limites des objets et à saisir les points avec plus de précision, plutôt que de se contenter de localiser des cadres de sélection généraux. Par exemple, un bras robotique intégré à YOLO11 repérer de petits composants sur un tapis roulant, segment forme exacte et les saisir avant qu'ils ne soient hors de portée, ce qui aiderait le système à rester efficace et fiable.

Avec autant de modèles de vision par ordinateur disponibles aujourd'hui, vous vous demandez peut-être ce quiYOLO11 Ultralytics YOLO11 .

Voici quelques raisons pour lesquelles Ultralytics YOLO11 une excellente option pour les applications où de petits objets doivent être détectés :

Outre l'utilisation d'un modèle tel que YOLO11, la manière dont vous préparez vos annotations, l'ensemble des données et la procédure d'entraînement du modèle peuvent avoir une incidence significative sur les performances de détection.

Voici un bref aperçu des points à retenir :

La détection de petits objets est difficile, car les cibles de petite taille perdent en détails lorsque les images transitent par un modèle de vision par ordinateur. YOLO11 la préservation de ces détails, rendant la détection de petits objets plus fiable sans sacrifier les performances en temps réel. Cet équilibre permet YOLO11 prendre en charge une détection précise et efficace dans des applications concrètes.

Rejoignez notre communauté en pleine croissance ! Explorez notre dépôt GitHub pour en savoir plus sur l'IA. Découvrez des innovations telles que la vision par ordinateur dans le commerce de détail et l'IA dans l'industrie automobile en visitant nos pages de solutions. Pour commencer à développer avec la vision par ordinateur dès aujourd'hui, consultez nos options de licence.