フィットネス・アプリから患者モニタリングまで、「AIは実世界で人間の行動をdetect できるのか?

フィットネス・アプリから患者モニタリングまで、「AIは実世界で人間の行動をdetect できるのか?

私たちの日常生活は、普段意識することのない小さな動きで溢れています。部屋を歩いたり、机に座ったり、友人に手を振ったりすることは、私たちにとっては容易に感じられますが、AIでそれを検出することははるかに複雑です。人間にとって自然なことが、機械が理解しようとすると、非常に複雑なことになるのです。

この能力は人間活動認識(HAR)と呼ばれ、コンピューターが人間の行動パターンをdetect し、解釈することを可能にする。フィットネス・アプリは、HARが実際に使われている素晴らしい例だ。歩数やワークアウトのルーチンを追跡することで、AIがいかに日々の活動を監視できるかを示している。

HARの可能性に着目し、多くの産業がこの技術を採用し始めています。実際、ヒューマン行動認識市場は、2033年までに125億6,000万ドルを超えると予測されています。

この進歩の重要な部分は、画像やビデオなどの視覚データを機械が分析できるようにするAIの分野であるコンピュータビジョンによって推進されています。コンピュータビジョンと画像認識により、HARは研究コンセプトから、最先端のAIアプリケーションの実用的でエキサイティングな部分へと進化しました。

この記事では、HARとは何か、人間の行動を認識するために使用されるさまざまな方法、そしてコンピュータビジョンがどのように質問に答えるのに役立っているのかを探ります:AIは実世界のアプリケーションで人間の行動をdetect できるのか?さっそく始めましょう!

人間行動認識により、コンピュータシステムは、身体の動きを分析することで、人間の活動や行動を理解できます。画像内の人を単に検出するのとは異なり、HARは人が何をしているかを識別するのに役立ちます。たとえば、歩行と走行の区別、手の振り方の認識、または誰かが倒れたときの認識などです。

HARの基礎は、動きと姿勢のパターンにあります。人間の腕や脚の位置がわずかに変化するだけで、さまざまなアクションを示すことができます。HARシステムは、これらの微妙な詳細をキャプチャして解釈することで、身体の動きから意味のある洞察を得ることができます。

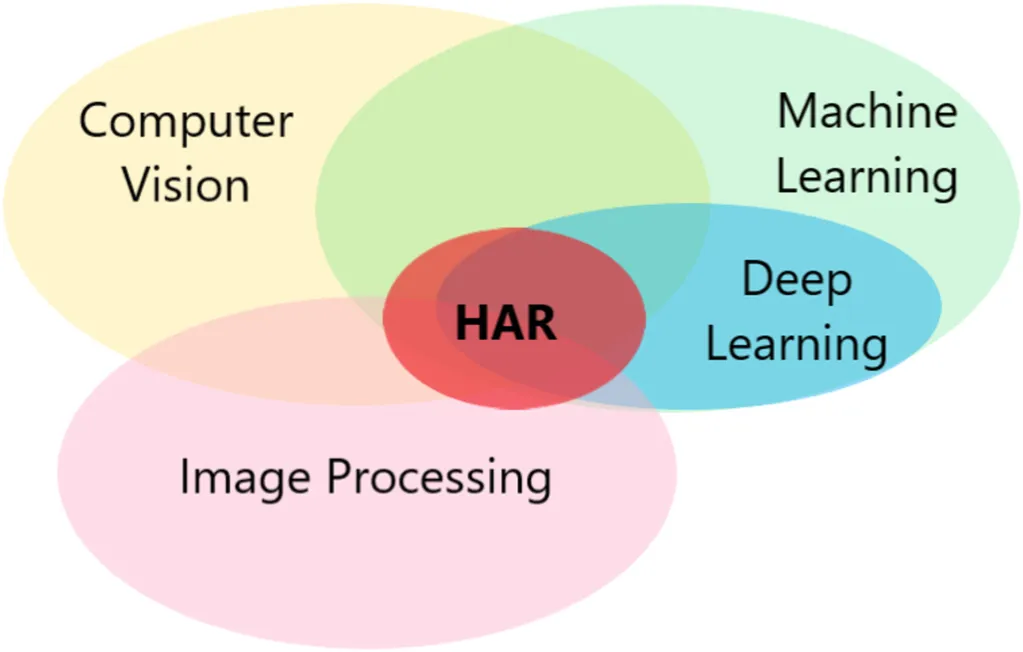

これを実現するために、人間の行動認識は、機械学習、深層学習モデル、コンピュータビジョン、画像処理などの複数のテクノロジーを組み合わせて、身体の動きを分析し、より高い精度で人間の行動を解釈します。

以前のHARシステムは、はるかに制限されていました。制御された環境下での単純で反復的なアクションしか処理できず、現実の状況では苦戦することがよくありました。

今日、AIと大量のビデオデータのおかげで、HARは精度と堅牢性の両方で大幅に進歩しました。最新のシステムは、はるかに高い精度で幅広いアクティビティを認識でき、ヘルスケア、セキュリティ、インタラクティブデバイスなどの分野でテクノロジーを実用的にしています。

人間の行動認識とは何かについて理解を深めたところで、機械が人間の行動をdetect するさまざまな方法を見てみよう。

一般的な手法を以下に示します。

あらゆるHARモデルまたはシステムにとって、データセットは出発点です。HARデータセットは、歩行、着席、手を振るなどのアクションをキャプチャするビデオクリップ、画像、またはセンサーデータなどの例のコレクションです。これらの例は、人間の動きのパターンを認識するようにAIモデルをトレーニングするために使用され、現実のアプリケーションで適用できます。

トレーニングデータの品質は、モデルの性能に直接影響します。クリーンで一貫性のあるデータは、システムがアクションを正確に認識するのを容易にします。

そのため、データセットはトレーニング前に前処理されることがよくあります。一般的な手順の1つは正規化です。これは、値を一貫してスケーリングしてエラーを減らし、過学習(モデルがトレーニングデータではうまく機能するが、新しいデータでは苦労する場合)を防ぎます。

モデルの性能をトレーニング以外で評価するために、研究者は評価指標とベンチマークデータセットを利用して、公平なテストと比較を可能にします。UCF101、HMDB51、Kineticsなどの一般的なコレクションには、人間の行動検出用にラベル付けされた数千のビデオクリップが含まれています。センサー側では、スマートフォンやウェアラブルから収集されたデータセットが、さまざまな環境で認識モデルをより堅牢にする貴重なモーション信号を提供します。

人間の行動をdetect するさまざまな方法の中で、コンピュータ・ビジョンは最も人気があり、広く研究されている。その主な利点は、画像やビデオから豊富なディテールをそのまま引き出せることだ。ピクセルをフレームごとに見て、動きのパターンを分析することで、人が余計な装置を身につけることなく、リアルタイムで行動を認識することができる。

深層学習、特に画像を分析するために設計された畳み込みニューラルネットワーク(CNN)における最近の進歩により、コンピュータビジョンはより高速、高精度、高信頼性になりました。

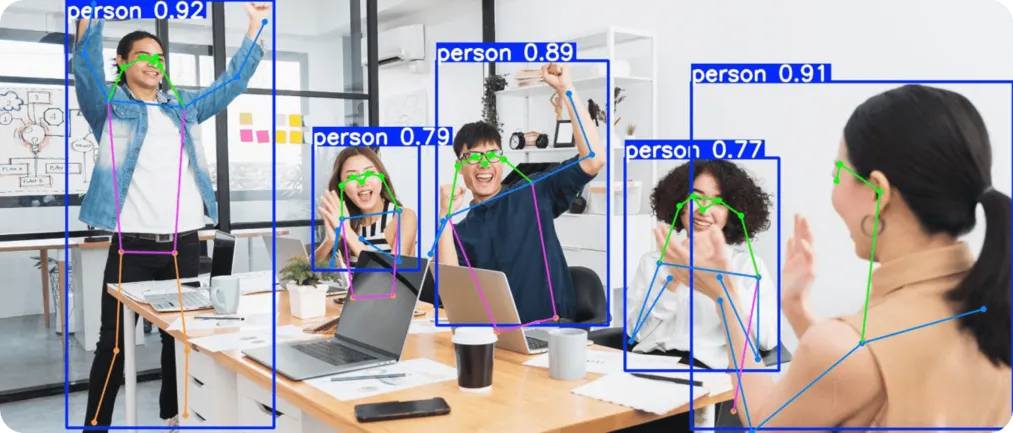

例えば、以下のような最先端のコンピュータビジョンモデルが広く使われている。 Ultralytics YOLO11のような最先端のコンピュータビジョンモデルは、これらの進歩の上に構築されている。YOLO11 、物体検出、インスタンス分割、ビデオフレームを横断する人物の追跡、人間のポーズの推定などのタスクをサポートしており、人間の活動認識に最適なツールとなっている。

Ultralytics YOLO11 11は、スピードと精度の両方を追求したビジョンAIモデルです。物体検出、物体追跡、姿勢推定など、コンピュータ・ビジョンの中核となるタスクをサポートします。これらの機能は、人間の活動認識に特に役立ちます。

物体検出はシーン内の人物を識別して位置を特定し、トラッキングはビデオフレームをまたいで人物の動きを追跡してアクションシーケンスを認識し、ポーズ推定は人体の主要な関節をマッピングして類似したアクティビティを区別したり、転倒のような急激な変化をdetect 。

例えば、モデルからの洞察は、静かに座っている人が立ち上がり、最終的に腕を上げて応援する様子を区別するために使用できます。これらの単純な日常の行動は、一見すると似ているように見えるかもしれませんが、シーケンスで分析すると非常に異なる意味を持ちます。

次に、コンピュータビジョンを活用した人間の行動認識が、私たちの日常生活に影響を与える実際のユースケースでどのように応用されているかについて詳しく見ていきましょう。

ヘルスケアでは、動作のわずかな変化が、人の状態に関する有用な洞察を提供する可能性があります。例えば、高齢の患者のつまずきや、リハビリ中の四肢の角度は、リスクや進捗を示すことがあります。これらの兆候は、定期健診のような従来の方法では見逃されがちです。

YOLO11 、ポーズ推定と画像解析を用いて、リアルタイムで患者をモニターすることで支援することができる。転倒のdetect 、回復運動のtrack 、歩行やストレッチなどの日常活動の観察に使用できる。センサーやウェアラブルデバイスを必要とせず、視覚分析によって動作するため、患者のケアをサポートする正確な情報を収集するシンプルな方法を提供する。

セキュリティ・システムは、誰かがうろついたり、立ち入り禁止区域を走ったり、突然攻撃的になるなど、人の異常な行動を素早く検知することに依存している。警備員が手作業ですべてを監視できないような忙しい環境では、こうした兆候は見逃されがちだ。そこで、コンピューター・ビジョンとYOLO11 出番となる。

YOLO11 、不審な動きをdetect 即座にアラートを送信できるリアルタイムのビデオ監視機能を搭載し、セキュリティ監視を容易にします。公共スペースでの群衆の安全をサポートし、プライベートエリアでの侵入検知を強化します。

このアプローチにより、警備員はコンピュータビジョンシステムと連携して作業し、人間とコンピュータのインタラクションとパートナーシップを構築し、不審な活動に対してより迅速かつタイムリーな対応を可能にします。

人間の行動認識にコンピュータビジョンを使用する利点のいくつかを以下に示します。

HARにコンピュータビジョンを使用することには多くのメリットがありますが、考慮すべき制限事項もあります。留意すべき点を以下に示します。

人工知能とコンピュータビジョンにより、機械が人間の行動をより正確に、リアルタイムで認識できるようになっています。ビデオフレームと動きのパターンを分析することで、これらのシステムは日常的なジェスチャーと突然の変化の両方を識別できます。技術の進歩に伴い、人間行動認識は研究室から、ヘルスケア、セキュリティ、日常的なアプリケーションのための実用的なツールへと移行しています。

GitHubリポジトリにアクセスし、コミュニティに参加して、AIについてさらに詳しく学んでください。ロボット工学におけるAIと製造業におけるコンピュータビジョンについてソリューションページをご覧ください。ライセンスオプションを確認して、Vision AIを始めましょう。