評価者間信頼性、コーエンのκ係数、ICC、評価者トレーニング、およびパーセント一致について理解します。これらの統計的指標が、研究およびデータ分析における観察者間の一貫性と合意をどのように保証するかを学びます。

評価者間信頼性、コーエンのκ係数、ICC、評価者トレーニング、およびパーセント一致について理解します。これらの統計的指標が、研究およびデータ分析における観察者間の一貫性と合意をどのように保証するかを学びます。

AIモデルを構築する際、データの品質は、その背後にあるアルゴリズムと同じくらい重要です。複数の人が同じデータにラベルを付けたり、レビューしたりする場合、意見の相違は必ず発生します。これは、研究、医療、教育など、多くの分野に当てはまります。

特に、AIの一分野であるコンピュータビジョンでは、次のようなモデルを訓練する必要がある。 Ultralytics YOLO11のようなモデルを学習させ、画像や動画のような視覚データを解釈させる。これらのラベルに一貫性がない場合、コンピュータ・ビジョンのモデルは正しいパターンを学習するのに苦労することになる。

評価者間信頼性(IRR)は、異なる個人またはラベラーがタスクについてどれだけ一貫して合意するかを測定します。これにより、一貫性を監視し、トレーニング、ガイドライン、または解釈のギャップを特定できます。これは、特定の目的のために特定のデータを使用してAIモデルが構築されるカスタムモデルのトレーニングにおいて特に重要です。

この記事では、評価者間信頼性とは何か、その測定方法、そして実際のプロジェクトでそれを向上させる方法について解説します。それでは、始めましょう!

評価者間信頼性とは、2人以上の人々(評価者とも呼ばれます)が、同じコンテンツにラベル付け、評価、またはレビューを行う際に、どれくらいの頻度で合意するかを測定するものです。これは、異なる評価者が与えられた基準をどれだけ一貫して使用しているかを確認するために使用されます。評価者間の合意が高いということは、タスクが明確に定義され、明確に理解されていることを意味します。

この概念は、さまざまな分野で使用されています。分野によっては、評価者間の一致、観察者間の信頼性、またはコーダー間の信頼性など、異なる名前で知られています。ただし、根本的な原則は同じです。

Vision AIにおいて、評価者間信頼性はデータラベリングプロセスの重要な部分です。コンピュータビジョンモデルのトレーニングには、大量の画像またはビデオフレームのデータセットのラベリングが必要となることが多いため、複数のAI開発者が同じデータに対して共同で作業します。

正確な結果を得るためには、同じラベリングガイドラインに従う必要があります。たとえば、動物をラベリングする場合、何をもって犬とみなすか、その周りにどのようにバウンディングボックスを描くか、ぼやけたオブジェクトをラベリングするか無視するかについて、全員が明確な合意をする必要があります。

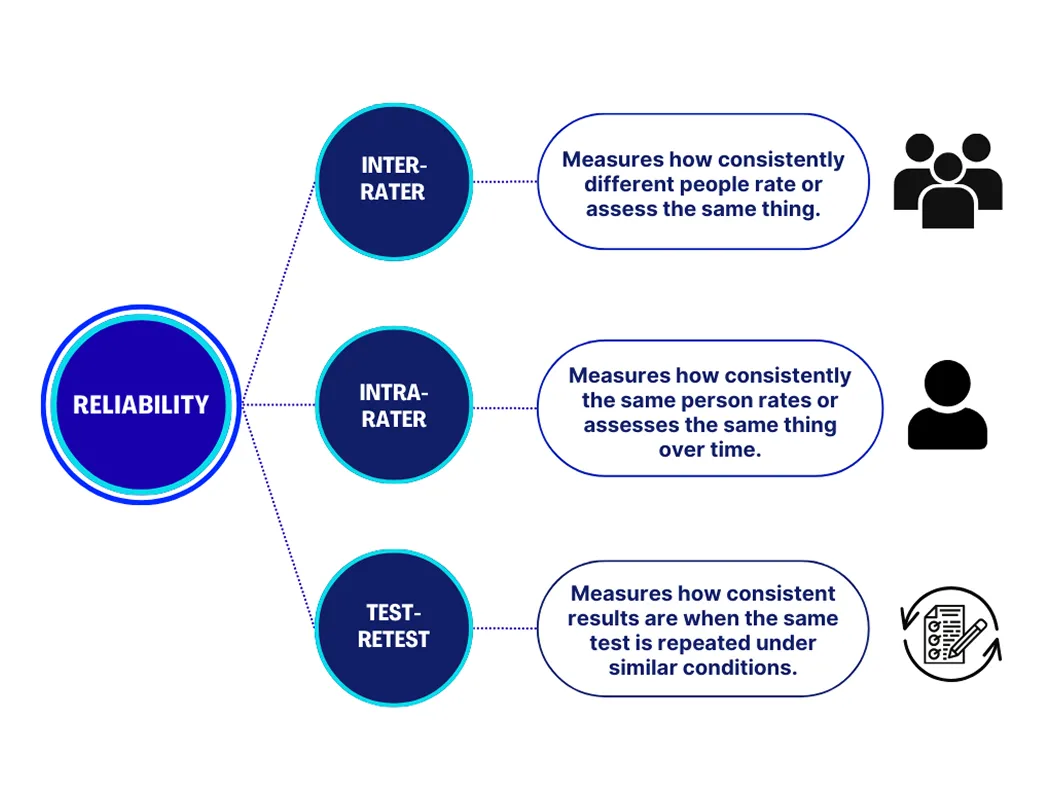

人がデータのラベリングまたはスコアリングに関与する場合、考慮すべき信頼性には主に3つのタイプがあります。それぞれが、結果の一貫性を測定する上で異なる目的を果たします。それぞれの詳細を見てみましょう。

これらの対策を組み合わせることで、人とプロセスの両方が安定した信頼できる結果を生み出していることを確認できます。

大規模なVision AIプロジェクトでは、ラベル付けされたデータの品質が、モデルのパフォーマンスに直接影響します。アノテーターがガイドラインを適用する方法にわずかな違いがあるだけでも、トレーニング中にモデルを混乱させる矛盾が生じる可能性があります。時間の経過とともに、これにより不正確な予測、リソースの浪費、およびコストのかかる再ラベル付けが必要になる可能性があります。

評価者間信頼性を測定することで、これらの問題を早期に発見できます。高い一致は、アノテーターが連携し、よりクリーンで信頼性の高いデータセットを生成していることを意味します。低い一致は、プロジェクトを進める前に、指示、例、またはトレーニングを改善する必要がある可能性があることを示しています。ラベラーが同期して作業することで、チームはより効果的に学習し、実際のアプリケーションでより良い結果を提供するAIモデルを構築できます。

複数の評価者と協力し、高い評価者間信頼性を維持するために留意すべき重要な実用的考慮事項を以下に示します。

評価者間信頼性を測定する方法はいくつかあり、最適な選択はデータの種類とタスクによって異なります。一部の方法は、単純なYes-Noの質問を扱う単一の評価者によく機能しますが、複数の評価者が関与する状況向けに設計されているものもあります。

一般的なアプローチには、パーセント一致、コーエンのκ係数、フレイスのκ係数、および級内相関係数が含まれます。各手法は、評価者間の一致のレベルを測定し、偶然に一致が発生する可能性を考慮します。

コーエンのκ係数は、2人の評価者間の評価者間信頼性を測定するために広く使用されている手法です。偶然による一致の可能性を考慮しながら、評価者がタスクに対してどの程度一致しているかを計算します。スコアは-1から1の範囲で、1は完全な一致を示し、0はランダムな推測と一致度が変わらないことを意味します。

同様に、複数の評価者が関与する場合、Fleissのκが使用されます。これは、グループの一貫性を示す全体的なスコアを提供します。画像のラベリングや感情のタグ付けなど、設定されたカテゴリを持つタスクには、両方の方法が使用されます。これらは計算が簡単で、ほとんどのアノテーションツールでサポートされています。

評価者間の一致度を測る別の方法として、一致率があります。これは、評価者が同じ判断を下した回数の割合を計算するものです。使い方は簡単ですが、偶然による一致は考慮されません。

一方、級内相関係数は、連続データまたはスケールベースのデータに使用されるより高度な方法です。これは、複数の評価者間での評価の一貫性を測定し、スコア、測定、または固定カテゴリを超えるその他のデータ型を含む研究でよく使用されます。

評価者間信頼性を測定する方法について理解が深まったところで、これらの方法が実際のアプリケーションでどのように使用できるかを順を追って説明します。

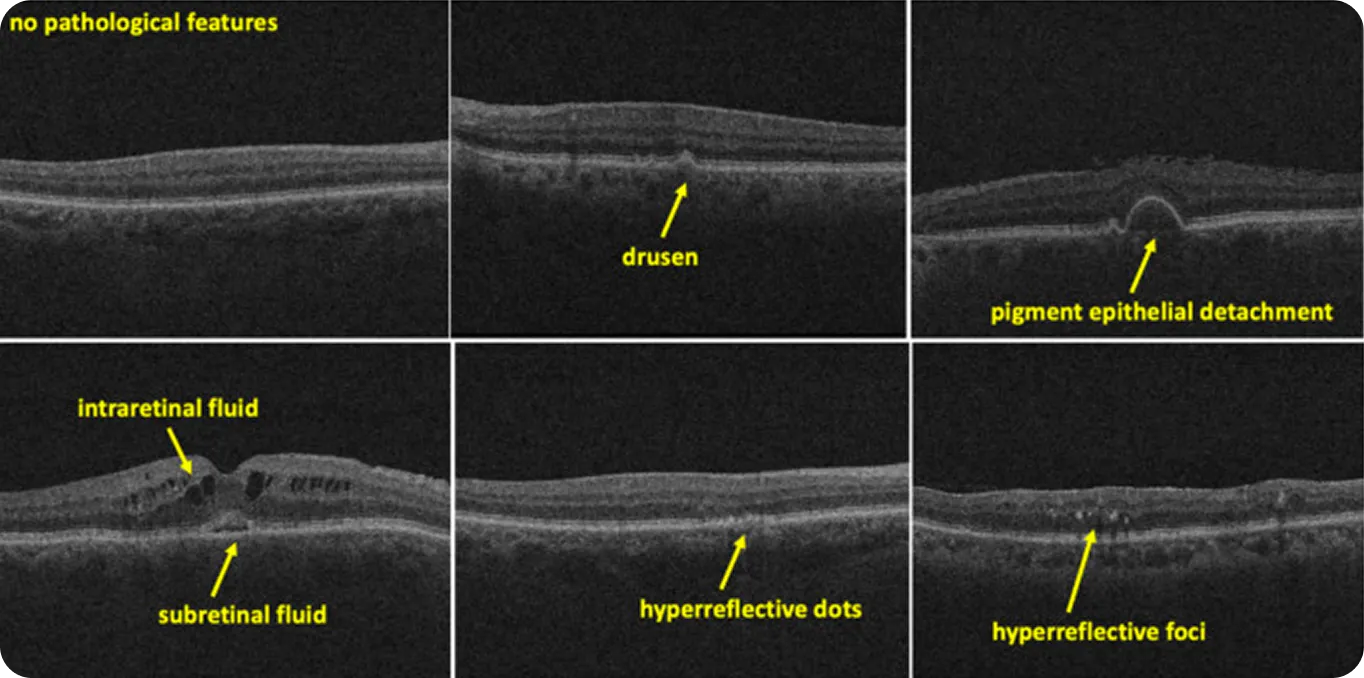

医療画像処理に関しては、解釈のわずかな違いでも、結果に大きな変化をもたらす可能性があります。たとえば、放射線科医は、微妙で曖昧、または定義が難しいパターンを識別するように求められることがよくあります。これらのパターンがAIシステムのトレーニングデータになると、リスクは高まります。専門家が同じスキャンに異なるラベルを付けると、モデルが間違ったパターンを学習したり、まったく学習できなかったりする可能性があります。

評価者間信頼性は、そのようなデータを扱うチームが、専門家の判断が実際にどれほど一貫性があるかを評価するのに役立ちます。たとえば、最近の網膜OCTスキャンに焦点を当てた研究では、2人の評価者が500枚の画像にラベルを付けました。

ドルーゼン(網膜下の黄色の沈着物)のような明確な特徴については、一致度は高く、カッパスコアは0.87でした。しかし、過反射焦点(網膜スキャンで見られる小さくて明るいスポット)のような定義が難しい要素については、スコアは0.33に低下しました。これは、より明確で明確に定義された特徴は、より一貫性のある専門家の判断を生み出す傾向があり、曖昧な特徴は解釈の余地を残すことを示しています。

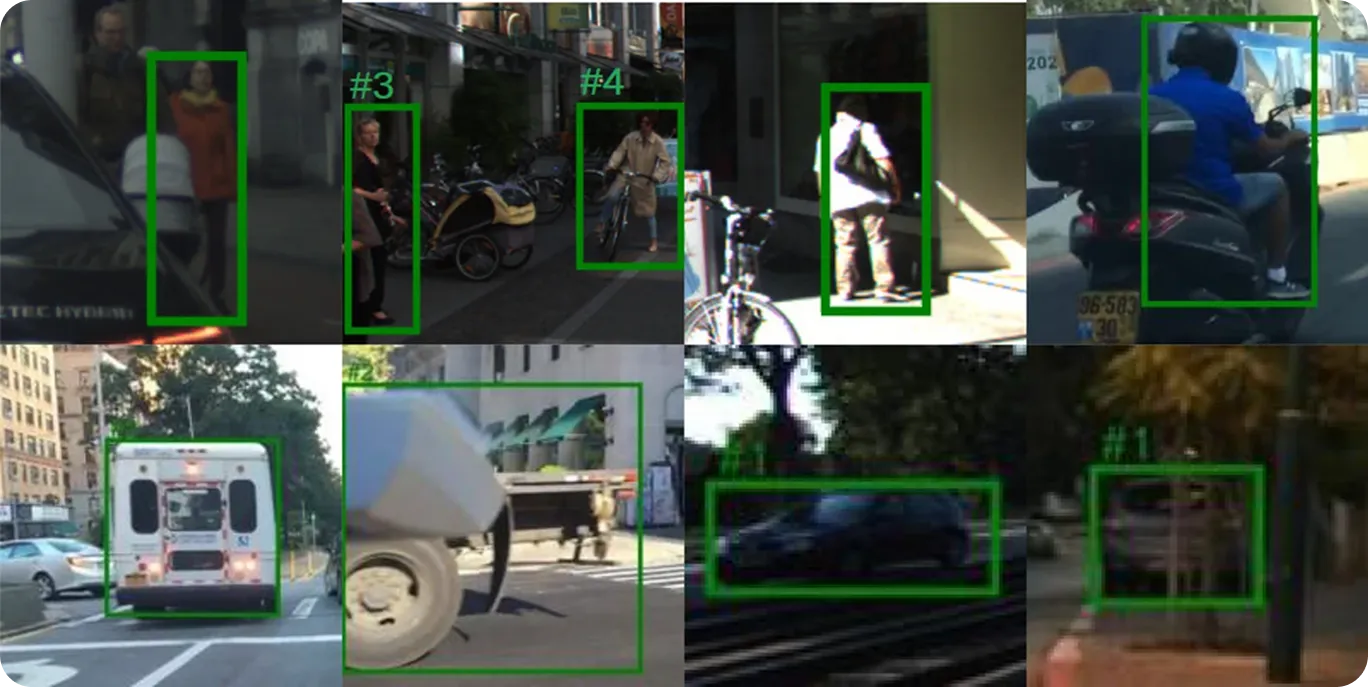

自動運転システムのAIモデルをトレーニングするには、さまざまな道路状況にわたって正確で一貫性のあるラベルが必要です。このようなプロジェクトに取り組むアノテーターは通常、歩行者、車両、交通標識、および車線マーキングを、多くの場合、暗い場所や混雑したシーンで識別するように求められます。

これらの決定は、モデルが過酷な現実世界の環境でどのように応答するかを学習する方法を形作ります。評価者間信頼性により、チームはそれらのラベルが評価者間で同じように適用されているかどうかを確認できます。

評価者間信頼性を測定することは、AIソリューションを構築する上で重要なステップですが、より広範な品質保証プロセスの一部です。チームとプロジェクト全体のデータ品質を向上させるのに役立つその他のプラクティスを以下に示します。

評価者間信頼性は、人々がラベルを適用したり、意思決定をしたりする際の一貫性を測定します。コーエンのκ係数、フレイスのκ係数、ICCなどの手法は、その合意を定量化するのに役立ちます。明確なガイドライン、トレーニング、およびバイアス制御により、信頼性の高いアノテーションは、より強力なデータとより良いモデル結果につながります。

コミュニティに参加し、GitHubリポジトリを探索して、AIについてさらに詳しく学びましょう。独自のVision AIプロジェクトを開始したい場合は、ライセンスオプションをご確認ください。また、ソリューションページでは、ヘルスケア分野におけるAIや小売業におけるVision AIがどのような影響を与えているかについてもご覧いただけます。