Ultralytics イノベーター、パートナー、AIコミュニティを集め、インスピレーションの1日を過ごしたYOLO Vision 2025 Shenzhenの重要な瞬間をご覧ください。

Ultralytics イノベーター、パートナー、AIコミュニティを集め、インスピレーションの1日を過ごしたYOLO Vision 2025 Shenzhenの重要な瞬間をご覧ください。

10月26日、YOLO Vision 2025(YV25)が深センのOCT Creative Culture ParkのB10ビルで中国デビューを飾った。Ultralyticsハイブリッド・ビジョンAIイベントには200人以上の参加者が集まり、YouTubeやBilibiliを通じてオンラインでも多くの参加者が集まった。

YV25深センのライブストリームは、YouTubeですでに3,500ビューを超え、イベントのハイライトがコミュニティ全体で共有されるにつれて注目を集め続けている。ビジョンAIの次の方向性について、アイデアと会話、そして実践的な探求に満ちた一日だった。

当日は、ホストの黄学英氏の温かい歓迎の言葉で始まり、イベントを通して皆につながり、学び、議論に参加するよう呼びかけた。彼女は、これが9月のロンドン開催に続く今年2回目のYOLO ビジョンであることを説明し、Vision AIコミュニティがここ深センで再び一堂に会することがいかにエキサイティングであるかを共有した。

この記事では、モデル・アップデート、スピーカー・セッション、ライブ・デモ、そしてみんながひとつになったコミュニティの瞬間など、当日のハイライトを再確認しよう。さっそく始めよう!

この日の最初の基調講演は、Ultralytics 創設者兼CEOのグレン・ジョーチャー氏が担当し、Ultralytics YOLO モデルが、研究のブレークスルーから、世界で最も広く使用されているビジョンAIモデルへと成長した経緯を紹介した。グレン氏は、初期の仕事はYOLO 使いやすくすることに重点を置いていたと説明した。

彼はモデルをPyTorch移植し、ドキュメントを改善し、あらゆる開発者がその上に構築できるようにすべてをオープンに共有した。2018年に真っ先に飛び込んだ。私の未来はここにあると決めたのです」。個人的な取り組みとして始まったことは、瞬く間に世界的なオープンソース・ムーブメントとなった。

今日、Ultralytics YOLO モデルは、毎日何十億もの推論を可能にしている。グレンは、このようなスケールが可能になったのは、構築に協力してくれた人々のおかげだと強調した。世界中の研究者、エンジニア、学生、ホビースト、オープンソースの貢献者たちが、YOLO 今日の形に作り上げてきた。

グレンの言葉を借りれば、「1000人近い(貢献者の)方々がいてくれて、本当に感謝している。この人たちのおかげで、今があるんだ。"

Ultralytics YOLO26の最初の外観は、今年の初めにYOLO Vision 2025 Londonのイベントで共有され、Ultralytics YOLO モデルファミリーの次の大きな前進として紹介された。YV25深圳で、グレンはその発表以来の進展について最新情報を提供し、このモデルがどのように進化してきたかをAIコミュニティに詳しく紹介した。

YOLO26は、より小さく、より速く、より正確でありながら、実世界での使用に耐えうるように設計されている。グレンによれば、チームはこの1年間、アーキテクチャの改良、デバイス間の性能のベンチマーク、リサーチやコミュニティからのフィードバックの取り込みに費やしてきたという。目標は、モデルの導入を難しくすることなく、最先端のパフォーマンスを提供することだ。

グレンが強調した中心的なアップデートのひとつは、YOLO26が専用のハイパーパラメータ・チューニング・キャンペーンと組み合わされていることで、完全にゼロからのトレーニングから、より大きなデータセットでの微調整へとシフトしている。彼は、このアプローチが実際のユースケースにより合致していると説明した。

以下は、このイベントで共有されたその他の主な改善点である:

これらのアップデートを組み合わせることで、CPU 処理速度が最大43%向上し、かつ、CPU モデルよりも精度が向上しています。 Ultralytics YOLO11YOLO26は、組込み機器、ロボット工学、エッジシステムにとって特にインパクトのあるものとなっています。

YOLO26は、現在YOLO11利用可能なすべてのタスクとモデルサイズをサポートし、ファミリー全体で25のモデルバリエーションを提供する。これには、検出、セグメンテーション、ポーズ推定、オリエンテッド・バウンディング・ボックス、分類のためのモデルが含まれ、ナノサイズから超大型まで幅広い。

チームはまた、5つのプロンプト可能なバリアントにも取り組んでいる。これらは、テキストプロンプトを受け取り、トレーニングなしで直接バウンディングボックスを返すことができるモデルである。

これは、さまざまなユースケースに適応しやすい、より柔軟な命令ベースのビジョンワークフローへの初期段階である。YOLO26モデルはまだ活発に開発中だが、初期の性能結果は強力であり、チームは近日中のリリースに向けて取り組んでいる。

YOLO26のアップデートの後、グレンは製品エンジニアリングの責任者であるPrateek Bhatnagarを迎え、Ultralytics Platformのライブデモを行いました。このプラットフォームは、データセットの探索、画像へのアノテーション、モデルのトレーニング、結果の比較など、コンピューター・ビジョンのワークフローの主要部分をまとめるために構築されています。

プラティーク氏は、このプラットフォームがUltralyticsオープンソースのルーツに忠実であることを指摘し、データセット・コミュニティとプロジェクト・コミュニティの2つのコミュニティ・スペースを紹介した。デモでは、AIが支援するアノテーション、簡単なクラウドトレーニング、ローカルGPU リソースを必要とせずにコミュニティから直接モデルを微調整できる機能などが紹介された。

このプラットフォームは現在開発中である。プラティークは、発表に注目するよう聴衆に呼びかけ、立ち上げをサポートするために中国でチームが成長していることを指摘した。

盛り上がりを見せる中、イベントは様々なYOLO モデルの研究者たちによるパネルディスカッションへと移行した。パネルディスカッションには、グレン・ジョーチャー、シニア機械学習エンジニアのジン・チウ、Metaの機械学習エンジニアでYOLOv10作者の一人であるチェン・ホイ、Meituanのアルゴリズム・ストラテジストでYOLOv6作者の一人であるボー・チャンが参加した。

ディスカッションでは、YOLO 実際の使用を通じてどのように進化し続けているかに焦点が当てられた。講演者は、エッジデバイス上での効率的な動作、小さな物体の検出の改善、モデルエクスポートの簡素化など、実用的な展開の課題によって進歩が促進されることが多いことに触れた。

パネルディスカッションでは、正確さだけを追求するのではなく、本番環境におけるスピード、使いやすさ、信頼性のバランスの重要性が指摘された。また、イテレーションとコミュニティからのフィードバックの重要性も共有された。

以下は、その会話から得られた他の興味深い洞察である:

次に、YV25深センの基調講演のいくつかを詳しく見てみよう。そこでは、AIコミュニティ全体のリーダーたちが、デジタルヒューマンやロボット工学からマルチモーダル推論や効率的なエッジ展開まで、ビジョンAIがどのように進化しているかを共有した。

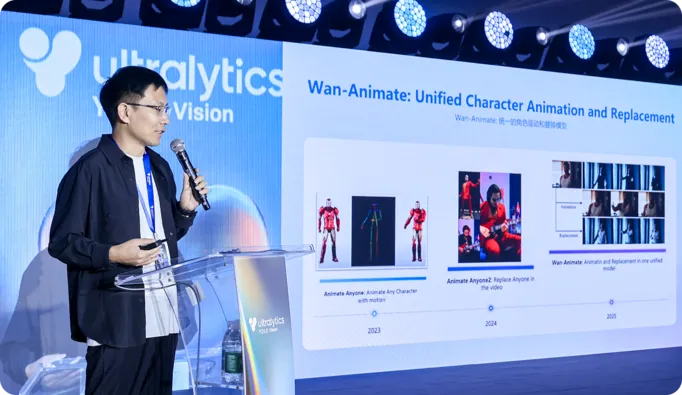

アリババQwenラボのPeng Zhang博士は、洞察に満ちたセッションで、彼のチームが、より自然な動きとコントロールを持つ表現力豊かなデジタルヒューマンを生成できる大規模なビデオモデルをどのように開発しているかを紹介した。彼はWan S2VとWan Animateについて説明し、音声やモーションリファレンスを使用してリアルなスピーチ、ジェスチャー、アニメーションを生成し、純粋なテキスト駆動型の生成の限界に対処しました。

Zhang博士はまた、外見と動きのゼロショットクローニングや、ライブカメラのフィードから直接顔をアニメーション化できる軽量モデルなど、リアルタイムのインタラクティブアバターへの進展についても語った。

YV25深センの重要なテーマのひとつは、単に世界を見るだけのビジョンモデルから、その中で行動できるシステムへのシフトである。言い換えれば、知覚はもはやパイプラインの終点ではなく、行動の始まりになりつつあるということだ。

例えば、D-RoboticsのHu Chunxu氏は基調講演で、同社の開発キットとSoC(System on a Chip)ソリューションが、統合されたハードウェアとソフトウェアスタック上でセンシング、リアルタイムのモーションコントロール、意思決定をどのように統合しているかを説明した。知覚と行動を別々の段階ではなく、連続的なフィードバックループとして扱うことで、彼らのアプローチは、実環境でより確実に動き、適応し、相互作用できるロボットをサポートする。

バイドゥ・パドルのアレックス・チャン氏は講演で、YOLO PaddleOCRがどのように連携してオブジェクトをdetect し、その周辺のテキストや構造を解釈するかを説明した。これにより、システムは画像や文書を、物流、検査、自動処理などのタスクで使用可能な構造化された情報に変換することができる。

YV25深圳でのもうひとつの興味深いトピックは、ビジョンAIがエッジデバイス上でいかに効率的で有能になってきているかということだった。

DEEPXのポール・ユング氏は、YOLO モデルを組み込みハードウェアに直接展開することで、クラウドへの依存を減らすことについて話した。低消費電力、最適化された推論、ハードウェアを意識したモデルチューニングに注力することで、DEEPXはドローン、モバイルロボット、ダイナミックな環境で動作する産業システムのリアルタイム知覚を可能にする。

同様に、Moore Threads社のLiu Lingfei氏は、Moore Threads E300プラットフォームが中央演算処理装置CPU、グラフィックス処理装置GPU、ニューラル処理装置(NPU)のコンピューティングを統合し、コンパクトなデバイスで高速ビジョン推論を実現する方法を紹介した。

このプラットフォームは、高フレームレートで複数のYOLO ストリームを実行でき、そのツールチェーンは量子化、静的コンパイル、パフォーマンスチューニングなどのステップを簡素化する。また、Moore Threads社は、開発者の障壁を下げるために、コンピュータビジョンモデルと展開例の幅広いセットをオープンソース化している。

最近まで、画像を理解し言語を解釈できる単一のモデルを構築するには、実行コストが高い大規模な変換器アーキテクチャが必要だった。YV25深圳で、Yuanshi IntelligenceのYue Ziyin氏は、トランスフォーマーのロングコンテクスト推論能力とリカレントモデルの効率性を融合させたアーキテクチャであるRWKVの概要を説明した。

同氏は、Vision-RWKVが解像度に比例してリニアにスケールする方法で画像を処理することで、この設計をコンピュータ・ビジョンに応用していることを説明した。これにより、高解像度の入力や、計算が制限されるエッジデバイスに適している。

ユエはまた、RWKVが視覚言語システムでどのように使用されているかを示した。そこでは、画像特徴がテキスト理解と組み合わされ、物体検出を超えて、シーン、文書、実世界の文脈の解釈に移行している。

ステージでの講演がビジョンAIの行く末を先取りするものであったのに対し、会場内のブースでは、ビジョンAIが今日すでにどのように活用されているかを示すものであった。参加者は、ライブで動作するモデルを見たり、ハードウェアのオプションを比較したり、これらのシステムを構築しているチームと直接話したりすることができた。

展示されていた技術の一部を紹介しよう:

すべてのエキサイティングな技術に加え、YV25深センで最も良かったことの1つは、コンピュータビジョンのコミュニティとUltralytics チームが再び直接集まったことです。一日を通して、人々はデモの周りに集まり、コーヒーブレイクの間にアイデアを共有し、講演が終わった後も会話が続きました。

研究者、技術者、学生、そして建設業者がメモを取り合い、質問し、配備からモデル・トレーニングまで実体験を交換した。また、Grupo OsborneのCinco Jotasのおかげで、切り分けたばかりのハモンでスペイン文化の雰囲気を味わうこともでき、温かい交流のひと時となりました。美しい会場、熱狂的な観衆、そして勢いの共有が、この日を本当に特別なものにした。

刺激的な基調講演から体験型デモまで、YOLO Vision 2025 Shenzhenは、Ultralytics コミュニティを定義するイノベーションの精神を捉えました。一日を通して、スピーカーと参加者はアイデアを交換し、新しいテクノロジーを探求し、AIの未来に対するビジョンを共有してつながりました。参加者は、Ultralytics YOLO次の展開に向け、活力を得て帰りました。

AIとコンピュータ・ビジョンで何が可能かを再考する。私たちのコミュニティと GitHubリポジトリに参加して、さらに多くのことを発見してください。農業におけるコンピュータビジョンや 小売業におけるAIのようなアプリケーションの詳細をご覧ください。ライセンスオプションを調べて、今すぐコンピュータビジョンを始めましょう!