물체 인식의 진화를 되돌아보는 시간을 가져보세요. 지난 몇 년 동안 YOLO (You Only Look Once) 모델이 어떻게 발전해왔는지 집중적으로 살펴볼 것입니다.

물체 인식의 진화를 되돌아보는 시간을 가져보세요. 지난 몇 년 동안 YOLO (You Only Look Once) 모델이 어떻게 발전해왔는지 집중적으로 살펴볼 것입니다.

컴퓨터 비전은 인간이 실제 세계를 인식하는 방식과 유사하게 기계가 이미지와 비디오를 보고 이해하도록 가르치는 데 중점을 둔 인공 지능(AI)의 하위 분야입니다. 객체 인식 또는 행동 식별은 인간에게는 자연스러운 일이지만, 기계의 경우에는 특정하고 전문화된 컴퓨터 비전 기술이 필요합니다. 예를 들어, 컴퓨터 비전의 핵심 작업 중 하나는 이미지나 비디오 내에서 객체를 식별하고 위치를 파악하는 객체 탐지입니다.

1960년대부터 연구자들은 컴퓨터가 사물을detect 방법을 개선하기 위해 노력해 왔습니다. 템플릿 매칭과 같은 초기 방식은 미리 정의된 템플릿을 이미지 전체에 밀어 일치하는 항목을 찾는 방식이었습니다. 이러한 접근 방식은 혁신적이긴 했지만 물체의 크기, 방향, 조명의 변화로 인해 어려움을 겪었습니다. 오늘날에는 다음과 같은 고급 모델이 있습니다. Ultralytics YOLO11 와 같은 고급 모델을 통해 가려진 물체라고 하는 작고 부분적으로 숨겨진 물체도 놀라운 정확도로 detect 수 있습니다.

컴퓨터 비전이 계속 발전함에 따라 이러한 기술이 어떻게 발전해왔는지 되돌아보는 것이 중요합니다. 이 글에서는 물체 인식의 진화를 살펴보고 YOLO (You Only Look Once) 모델의 변화에 대해 조명해 보겠습니다. 지금 시작하겠습니다!

물체 감지에 대해 자세히 알아보기 전에 컴퓨터 비전이 어떻게 시작되었는지 살펴볼까요? 컴퓨터 비전의 기원은 과학자들이 뇌가 시각 정보를 처리하는 방식을 탐구하기 시작한 1950년대 말과 1960년대 초로 거슬러 올라갑니다. 데이비드 휴벨과 토르스텐 위젤은 고양이를 대상으로 한 실험에서 뇌가 가장자리와 선과 같은 단순한 패턴에 반응한다는 사실을 발견했습니다. 이는 시각 시스템이 더 복잡한 패턴으로 넘어가기 전에 가장자리와 같은 이미지의 기본 특징을 detect 인식한다는 개념인 특징 추출의 기초를 형성했습니다.

거의 같은 시기에 물리적 이미지를 디지털 형식으로 변환할 수 있는 새로운 기술이 등장하면서 기계가 시각 정보를 처리하는 방식에 대한 관심이 높아졌습니다. 1966년, MIT(Massachusetts Institute of Technology)의 Summer Vision Project는 상황을 더욱 진전시켰습니다. 이 프로젝트는 완전히 성공하지는 못했지만 이미지에서 전경과 배경을 분리할 수 있는 시스템을 만드는 것을 목표로 했습니다. 많은 Vision AI 커뮤니티 사람들에게 이 프로젝트는 컴퓨터 비전이 과학 분야로서 공식적으로 시작되었음을 나타냅니다.

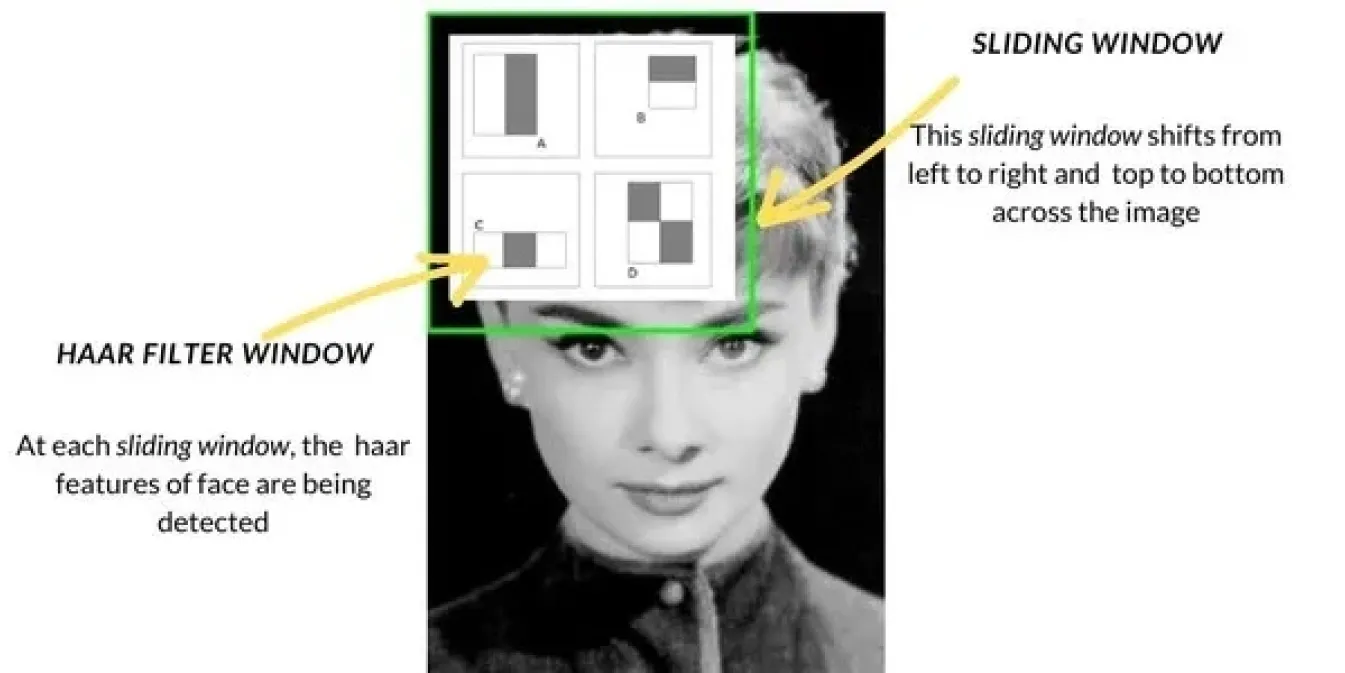

1990년대 말과 2000년대 초에 컴퓨터 비전이 발전하면서 물체 감지 방법은 템플릿 매칭과 같은 기본 기술에서 보다 고급화된 접근 방식으로 바뀌었습니다. 얼굴 감지와 같은 작업에 널리 사용된 하르 캐스케이드(Haar Cascade)가 대표적인 방법 중 하나였습니다. 이 방법은 슬라이딩 창으로 이미지를 스캔하고 이미지의 각 섹션에서 가장자리나 질감과 같은 특정 특징을 확인한 다음 이러한 특징을 결합하여 얼굴과 같은 물체를detect 방식으로 작동했습니다. 하르 캐스케이드는 이전 방법보다 훨씬 빨랐습니다.

이와 함께 HOG(Histogram of Oriented Gradients) 및 SVM(Support Vector Machines)과 같은 방법도 도입되었습니다. HOG는 슬라이딩 윈도우 기술을 사용하여 이미지의 작은 부분에서 빛과 그림자가 어떻게 변하는지 분석하여 모양을 기반으로 객체를 식별하는 데 도움을 주었습니다. 그런 다음 SVM은 이러한 특징을 분류하여 객체의 정체를 판단했습니다. 이러한 방법은 정확도를 향상시켰지만 여전히 실제 환경에서는 어려움을 겪었고 오늘날의 기술에 비해 속도가 느렸습니다.

2010년대에는 딥 러닝과 CNN(Convolutional Neural Networks)의 부상으로 객체 감지에 큰 변화가 있었습니다. CNN을 통해 컴퓨터는 많은 양의 데이터에서 중요한 특징을 자동으로 학습할 수 있게 되어 감지가 훨씬 더 정확해졌습니다.

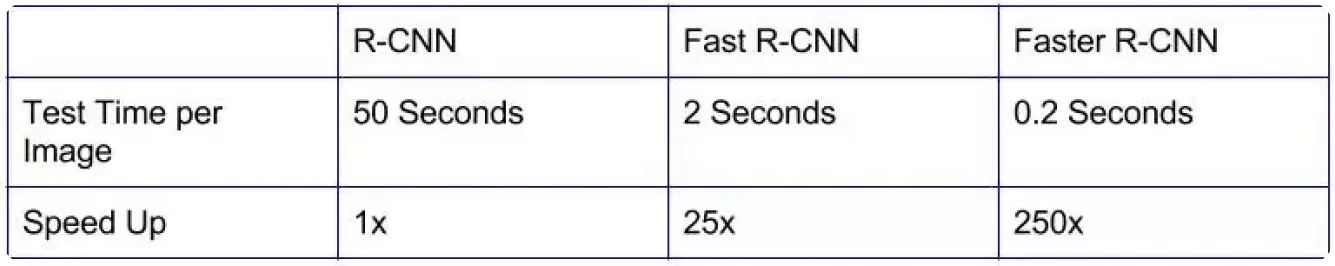

R-CNN (Region-based Convolutional Neural Networks)과 같은 초기 모델은 정밀도 면에서 큰 발전을 이루어 이전 방식보다 객체를 더 정확하게 식별하는 데 기여했습니다.

그러나 이러한 모델은 이미지를 여러 단계로 처리했기 때문에 속도가 느려 자율 주행차 또는 비디오 감시와 같은 분야의 실시간 애플리케이션에는 실용적이지 않았습니다.

속도 향상에 중점을 두어 더욱 효율적인 모델이 개발되었습니다. Fast R-CNN 및 Faster R-CNN과 같은 모델은 관심 영역을 선택하는 방법을 개선하고 탐지에 필요한 단계 수를 줄여 도움을 주었습니다. 이를 통해 객체 탐지 속도가 빨라졌지만 즉각적인 결과가 필요한 많은 실제 애플리케이션에는 여전히 충분히 빠르지 않았습니다. 실시간 탐지에 대한 수요가 증가함에 따라 속도와 정확성 사이의 균형을 맞출 수 있는 더욱 빠르고 효율적인 솔루션 개발이 추진되었습니다.

YOLO 는 이미지와 동영상에서 여러 객체를 실시간으로 감지할 수 있도록 하여 컴퓨터 비전을 재정의한 객체 감지 모델로, 이전의 감지 방법과는 매우 독특합니다. YOLO아키텍처는 감지된 각 객체를 개별적으로 분석하는 대신 객체 감지를 단일 작업으로 처리하여 CNN을 사용하여 객체의 위치와 클래스를 한 번에 예측합니다.

이 모델은 이미지를 그리드로 나누어 작동하며, 각 부분은 해당 영역에서 객체를 감지하는 역할을 합니다. 각 섹션에 대해 여러 예측을 수행하고 덜 확신하는 결과를 필터링하여 정확한 결과만 유지합니다.

컴퓨터 비전 애플리케이션에 YOLO 도입되면서 이전 모델보다 훨씬 빠르고 효율적으로 물체를 감지할 수 있게 되었습니다. 속도와 정확성 덕분에 YOLO 제조, 의료, 로봇 공학 등의 산업에서 실시간 솔루션으로 빠르게 인기를 얻게 되었습니다.

또 한 가지 중요한 점은 YOLO 오픈소스이기 때문에 개발자와 연구자들이 지속적으로 개선하여 더욱 발전된 버전을 만들 수 있다는 점입니다.

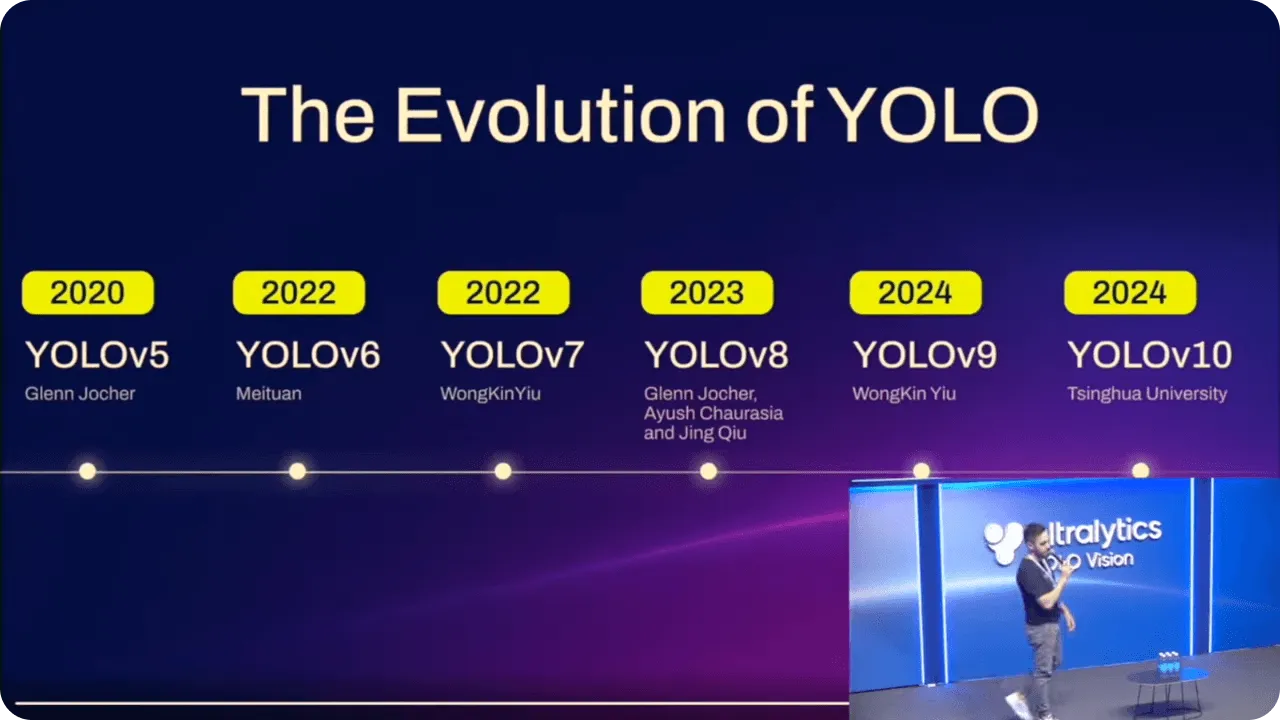

YOLO 모델은 시간이 지남에 따라 각 버전의 발전을 바탕으로 꾸준히 개선되어 왔습니다. 이러한 개선으로 성능 향상과 함께 다양한 수준의 기술 경험을 가진 사람들이 더 쉽게 사용할 수 있게 되었습니다.

예를 들어, 다음과 같은 경우 Ultralytics YOLOv5 가 도입되었을 때, 모델 배포가 더 간단해졌습니다. PyTorch를 통해 더 많은 사용자가 고급 AI로 작업할 수 있게 되었습니다. 정확성과 유용성이 결합되어 더 많은 사람들이 코딩 전문가가 아니어도 객체 감지를 구현할 수 있게 되었습니다.

Ultralytics YOLOv8 은 인스턴스 세분화와 같은 작업에 대한 지원을 추가하고 모델을 더욱 유연하게 만들면서 이러한 발전을 이어갔습니다. 기본 애플리케이션과 더 복잡한 애플리케이션 모두에 YOLO 더 쉽게 사용할 수 있게 되어 다양한 시나리오에서 유용하게 사용할 수 있게 되었습니다.

최신 모델로, Ultralytics YOLO11을 통해 더욱 최적화되었습니다. 매개변수 수는 줄이면서 정확도는 향상되어 이제 실시간 작업에 더욱 효율적입니다. 숙련된 개발자이든 AI를 처음 접하는 개발자이든, YOLO11 객체 감지에 대한 고급 접근 방식을 제공하여 쉽게 접근할 수 있습니다.

Ultralytics연례 하이브리드 행사인 YOLO Vision 2024(YV24)에서 출시된 YOLO11 물체 감지, 인스턴스 분할, 이미지 분류, 포즈 추정과 같은 YOLOv8 동일한 컴퓨터 비전 작업을 지원합니다. 따라서 사용자는 워크플로우를 조정할 필요 없이 이 새로운 모델로 쉽게 전환할 수 있습니다. 또한 YOLO11업그레이드된 아키텍처는 더욱 정확한 예측을 가능하게 합니다. 실제로 YOLO11m은 YOLOv8m 22% 적은 수의 파라미터로 COCO 데이터 세트에서 더 높은 평균 정밀도mAP를 달성했습니다.

또한 YOLO11 스마트폰과 기타 엣지 디바이스부터 더욱 강력한 클라우드 시스템까지 다양한 플랫폼에서 효율적으로 실행되도록 설계되었습니다. 이러한 유연성은 실시간 애플리케이션을 위한 다양한 하드웨어 설정에서 원활한 성능을 보장합니다. 또한 YOLO11 더 빠르고 효율적이어서 계산 비용을 절감하고 추론 시간을 단축할 수 있습니다. Ultralytics Python 패키지를 사용하든, 코드가 필요 없는 Ultralytics 허브를 사용하든, 기존 워크플로우에 YOLO11 쉽게 통합할 수 있습니다.

고급 객체 감지가 실시간 애플리케이션과 엣지 AI에 미치는 영향은 이미 산업 전반에 걸쳐 나타나고 있습니다. 석유 및 가스, 의료, 소매업과 같은 분야에서 AI에 대한 의존도가 높아지면서 빠르고 정확한 물체 감지에 대한 수요가 계속 증가하고 있습니다. YOLO11 컴퓨팅 성능이 제한된 디바이스에서도 고성능 감지를 가능하게 함으로써 이러한 수요에 대응하는 것을 목표로 합니다.

엣지 AI가 성장함에 따라 속도와 정확성이 중요한 환경에서 실시간 의사결정을 내리는 데 있어 YOLO11 같은 객체 감지 모델이 더욱 필수적인 요소가 될 것입니다. 설계와 적응성이 지속적으로 개선됨에 따라 객체 감지의 미래는 다양한 애플리케이션에 걸쳐 더욱 많은 혁신을 가져올 것으로 보입니다.

객체 감지는 단순한 방법에서 오늘날의 고급 딥러닝 기술로 발전하면서 먼 길을 걸어왔습니다. YOLO 모델은 이러한 발전의 중심에 있었으며, 다양한 산업 분야에서 더 빠르고 정확한 실시간 감지를 제공합니다. YOLO11 이러한 레거시를 기반으로 효율성을 개선하고 계산 비용을 절감하며 정확도를 향상시켜 다양한 실시간 애플리케이션을 위한 신뢰할 수 있는 선택이 될 것입니다. AI와 컴퓨터 비전의 지속적인 발전으로 물체 감지의 미래는 밝아 보이며, 속도, 정밀도, 적응성이 더욱 개선될 여지가 있습니다.

AI에 대해 더 알고 싶으신가요? 커뮤니티와 계속 소통하면서 학습을 이어가세요! GitHub 저장소를 확인하여 제조 및 헬스케어와 같은 산업에서 혁신적인 솔루션을 만들기 위해 AI를 어떻게 활용하고 있는지 알아보세요. 🚀

.webp)

.webp)