Entdecken Sie, wie visuelle Datentypen wie Wärmebilder, LiDAR und Infrarotbilder vielfältige Computer-Vision-Anwendungen in verschiedenen Branchen ermöglichen.

Entdecken Sie, wie visuelle Datentypen wie Wärmebilder, LiDAR und Infrarotbilder vielfältige Computer-Vision-Anwendungen in verschiedenen Branchen ermöglichen.

Technologien wie Drohnen waren früher nur Forschern und Spezialisten zugänglich, aber heutzutage wird hochmoderne Hardware einem breiteren Publikum zugänglich. Dieser Wandel verändert die Art und Weise, wie wir visuelle Daten erfassen. Dank der leichter zugänglichen Technologie können wir jetzt Bilder und Videos aus einer Vielzahl von Quellen aufnehmen, die über traditionelle Kameras hinausgehen.

Parallel dazu entwickelt sich die Bildanalyse, die durch Computer Vision, einen Zweig der künstlichen Intelligenz (KI), ermöglicht wird, rasch weiter, so dass Maschinen visuelle Daten effizienter interpretieren und verarbeiten können. Dieser Fortschritt hat neue Möglichkeiten für die Automatisierung, Objekterkennung und Echtzeitanalyse eröffnet. Maschinen sind nun in der Lage, Muster zu erkennen, Bewegungen track und komplexe visuelle Eingaben zu interpretieren.

Zu den wichtigsten Arten von visuellen Daten gehören RGB-Bilder (Rot, Grün, Blau), die häufig für die Objekterkennung verwendet werden, Wärmebilder, mit denen sich Wärmesignaturen bei schlechten Lichtverhältnissen detect lassen, und Tiefendaten, die es Maschinen ermöglichen, 3D-Umgebungen zu verstehen. Jeder dieser Datentypen spielt eine wichtige Rolle bei verschiedenen Anwendungen von Vision AI, die von der Überwachung bis zur medizinischen Bildgebung reichen.

In diesem Artikel werden wir die wichtigsten Arten von visuellen Daten untersuchen, die in Vision AI verwendet werden, und untersuchen, wie jede einzelne dazu beiträgt, die Genauigkeit, Effizienz und Leistung in verschiedenen Branchen zu verbessern. Los geht's!

Wenn Sie mit einem Smartphone ein Foto machen oder CCTV-Aufnahmen ansehen, arbeiten Sie in der Regel mit RGB-Bildern. RGB steht für Rot, Grün und Blau, und dies sind die drei Farbkanäle, die visuelle Informationen in digitalen Bildern darstellen.

RGB-Bilder und -Videos sind eng miteinander verwandte Arten von visuellen Daten, die in der Computer Vision verwendet und mit Standardkameras aufgenommen werden. Der Hauptunterschied besteht darin, dass Bilder einen einzelnen Moment festhalten, während Videos eine Abfolge von Einzelbildern sind, die zeigen, wie sich die Dinge im Laufe der Zeit verändern.

RGB-Bilder werden im Allgemeinen für Computer-Vision-Aufgaben wie Objekterkennung, Instanzsegmentierung und Posenschätzung verwendet, unterstützt durch Modelle wie Ultralytics YOLO11. Diese Anwendungen beruhen auf der Erkennung von Mustern, Formen oder spezifischen Merkmalen in einem Einzelbild.

Videos hingegen sind unverzichtbar, wenn Bewegung oder Zeit eine Rolle spielen, z. B. bei der Gestenerkennung, der Überwachung oder der Verfolgung von Aktionen. Da Videos als eine Reihe von Bildern betrachtet werden können, verarbeiten Computer-Vision-Modelle wie YOLO11 sie Bild für Bild, um Bewegung und Verhalten im Zeitverlauf zu verstehen.

So kann YOLO11 zum Beispiel RGB-Bilder oder Videos analysieren, um Unkraut detect und Pflanzen auf landwirtschaftlichen Feldern zu zählen. Dies verbessert die Überwachung von Pflanzen und hilft, Veränderungen über Wachstumsperioden hinweg track , um eine effizientere Betriebsführung zu ermöglichen.

Tiefendaten fügen den visuellen Informationen eine dritte Dimension hinzu, indem sie angeben, wie weit Objekte von der Kamera oder dem Sensor entfernt sind. Im Gegensatz zu RGB-Bildern, die nur Farbe erfassen und Textur, liefern Tiefendaten einen räumlichen Kontext. Sie zeigen den Abstand zwischen Objekten und der Kamera und ermöglichen so die Interpretation des 3D-Layouts einer Szene.

Diese Art von Daten wird mit Technologien wie LiDAR, Stereovision (mit zwei Kameras, um die menschliche Tiefenwahrnehmung nachzubilden) und Time-of-Flight-Kameras (Messung der Zeit, die das Licht benötigt, um zu einem Objekt und zurück zu gelangen) erfasst.

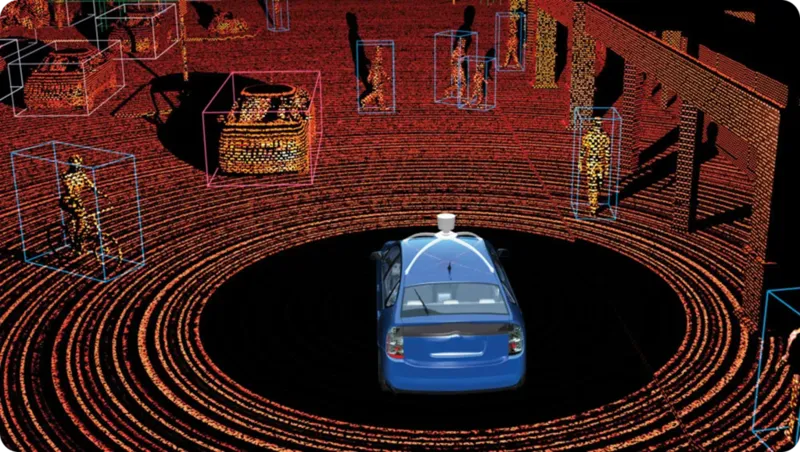

Unter diesen ist LiDAR (Light Detection and Ranging) oft die zuverlässigste für die Tiefenmessung. Es funktioniert, indem es schnelle Laserimpulse aussendet und misst, wie lange sie brauchen, um zurückzukehren. Das Ergebnis ist eine hochgenaue 3D-Karte, die als Punktwolke bezeichnet wird und die Form, Position und Entfernung von Objekten in Echtzeit hervorhebt.

Die LiDAR-Technologie lässt sich in zwei Haupttypen unterteilen, die jeweils für bestimmte Anwendungen und Umgebungen entwickelt wurden. Hier ist ein genauerer Blick auf beide Typen:

Eine wirkungsvolle Anwendung von LiDAR-Daten findet sich in autonomen Fahrzeugen, wo sie eine Schlüsselrolle bei Aufgaben wie der Erkennung von Fahrspuren, der Vermeidung von Kollisionen und der Identifizierung von Objekten in der Nähe spielen. LiDAR erzeugt detaillierte 3D-Echtzeitkarten der Umgebung, die es dem Fahrzeug ermöglichen, Objekte zu sehen, ihre Entfernung zu berechnen und sicher zu navigieren.

RGB-Bilder erfassen, was wir im sichtbaren Lichtspektrum sehen; andere Bildgebungstechnologien wie Thermal- und Infrarotbildgebung gehen jedoch darüber hinaus. Die Infrarotbildgebung erfasst Infrarotlicht, das von Objekten emittiert oder reflektiert wird, was sie bei schlechten Lichtverhältnissen nützlich macht.

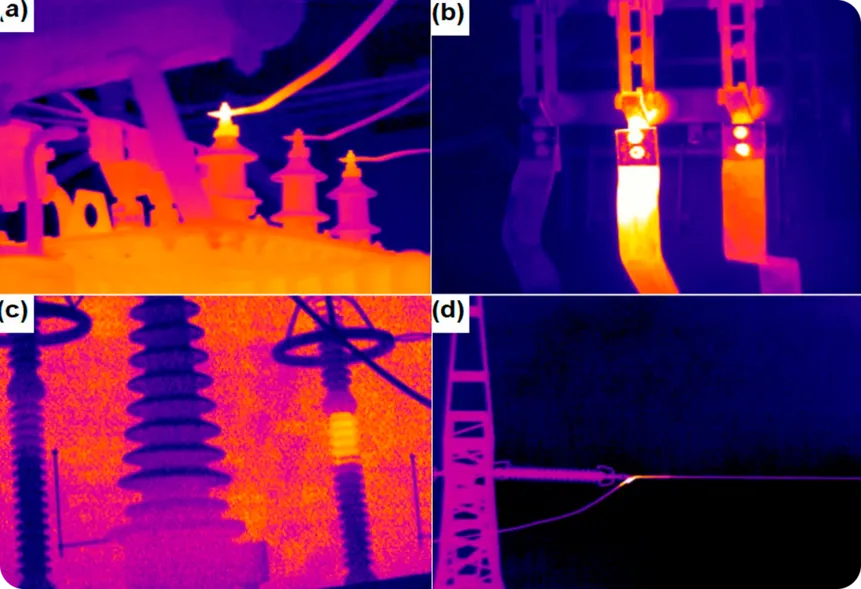

Thermografie hingegen erfasst die von Objekten abgegebene Wärme und zeigt Temperaturunterschiede an, wodurch sie in völliger Dunkelheit oder durch Rauch, Nebel und andere Hindernisse hindurch funktioniert. Diese Art von Daten ist besonders nützlich für die Überwachung und Erkennung von Problemen, insbesondere in Branchen, in denen Temperaturänderungen auf potenzielle Probleme hinweisen können.

Ein interessantes Beispiel ist die Verwendung von Thermografie zur Überwachung von elektrischen Komponenten auf Anzeichen von Überhitzung. Durch die Erkennung von Temperaturunterschieden können Wärmebildkameras Probleme identifizieren, bevor sie zu Geräteausfällen, Bränden oder kostspieligen Schäden führen.

Ebenso können Infrarotbilder helfen, Lecks in Rohrleitungen oder Isolierungen detect , indem sie Temperaturunterschiede identifizieren, die auf austretende Gase oder Flüssigkeiten hinweisen, was für die Vermeidung von Gefahrensituationen und die Verbesserung der Energieeffizienz entscheidend ist.

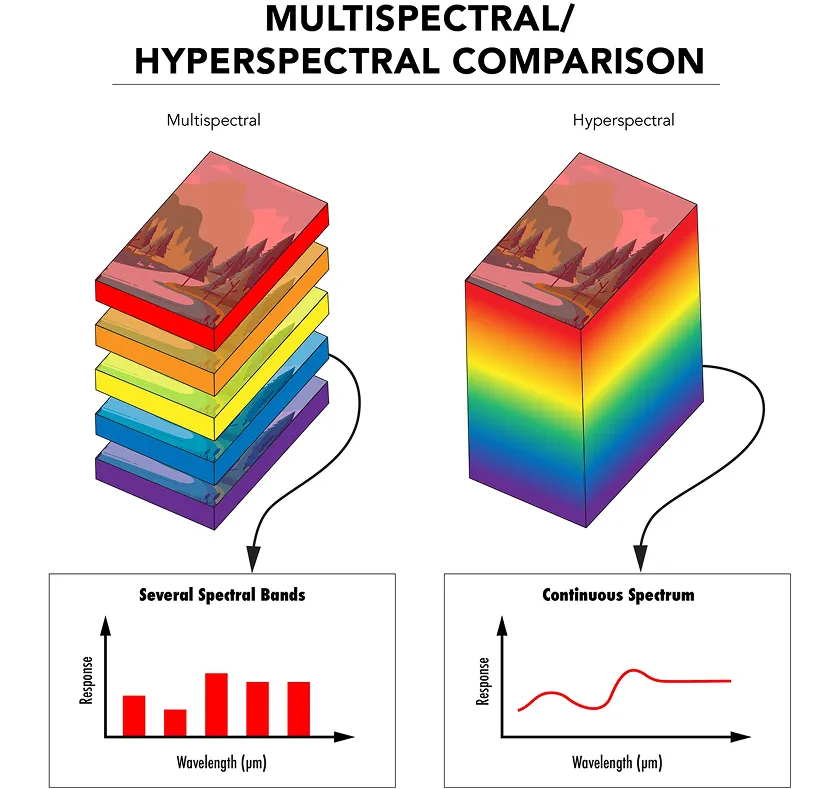

Während Infrarot- und Wärmebildgebung bestimmte Aspekte des elektromagnetischen Spektrums erfassen, sammelt die multispektrale Bildgebung Licht aus einigen ausgewählten Wellenlängenbereichen, die jeweils für einen bestimmten Zweck ausgewählt wurden, z. B. zur Erkennung gesunder Vegetation oder zur Identifizierung von Oberflächenmaterialien.

Die hyperspektrale Bildgebung geht noch einen Schritt weiter, indem sie Licht über Hunderte von sehr schmalen und kontinuierlichen Wellenlängenbereichen erfasst. Dies liefert eine detaillierte Lichtsignatur für jedes Pixel im Bild und ermöglicht ein viel tieferes Verständnis des beobachteten Materials.

Sowohl die multispektrale als auch die hyperspektrale Bildgebung verwenden spezielle Sensoren und Filter, um Licht bei verschiedenen Wellenlängen zu erfassen. Die Daten werden dann in einer 3D-Struktur, dem sogenannten Spektralwürfel, organisiert, wobei jede Schicht eine andere Wellenlänge darstellt.

KI-Modelle können diese Daten analysieren, um Merkmale detect , die normale Kameras oder das menschliche Auge nicht sehen können. Bei der Phänotypisierung von Pflanzen kann die hyperspektrale Bildgebung beispielsweise dazu verwendet werden, die Gesundheit und das Wachstum von Pflanzen zu überwachen, indem subtile Veränderungen in ihren Blättern oder Stängeln, wie etwa Nährstoffmangel oder Stress, erkannt werden. Dies hilft Forschern, die Pflanzengesundheit zu beurteilen und landwirtschaftliche Verfahren zu optimieren, ohne dass invasive Methoden erforderlich sind.

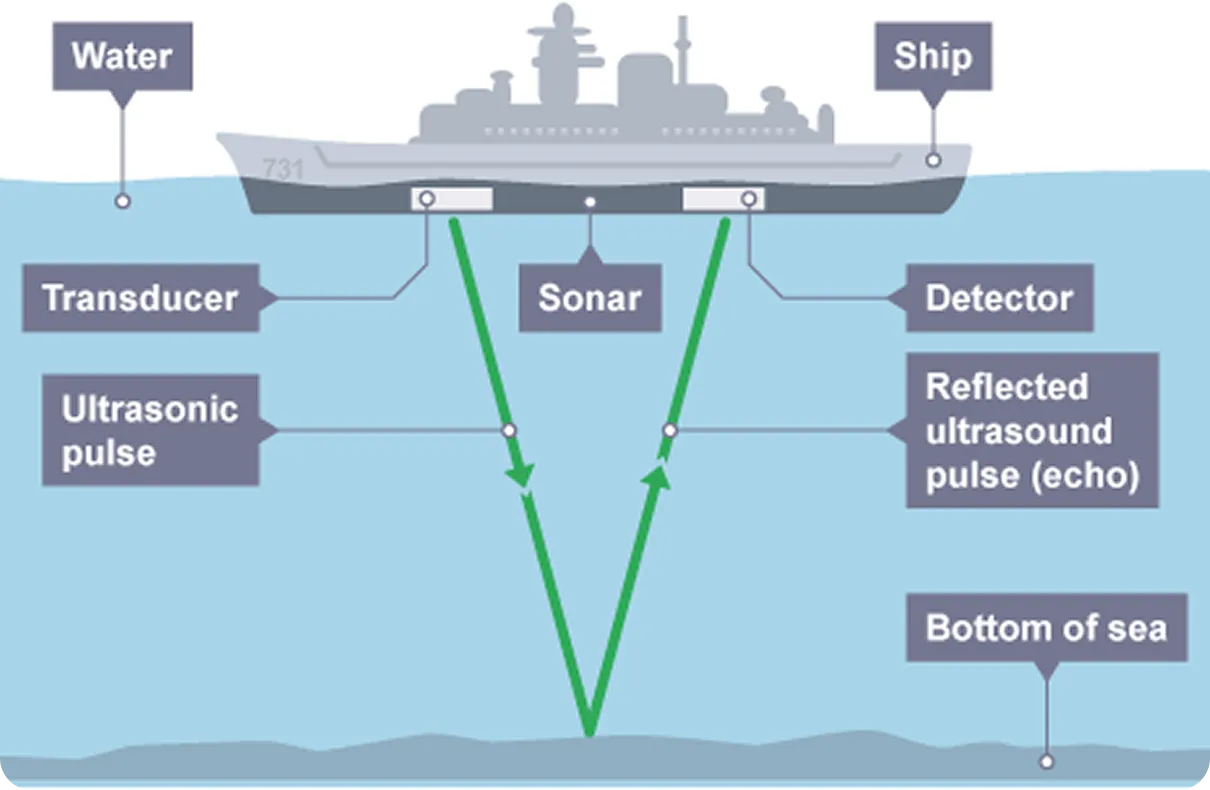

Radar- und Sonar-Bildgebung sind Technologien, die Objekte detect und kartieren, indem sie Signale aussenden und deren Reflektionen analysieren, ähnlich wie LiDAR. Im Gegensatz zur RGB-Bildgebung, die auf Lichtwellen zur Erfassung visueller Informationen beruht, verwendet Radar elektromagnetische Wellen, in der Regel Radiowellen, während Sonar Schallwellen verwendet. Sowohl Radar- als auch Sonarsysteme senden Impulse aus und messen die Zeit, die das Signal braucht, um von einem Objekt zurückzukommen, was Informationen über dessen Entfernung, Größe und Geschwindigkeit liefert.

Die Radarbildgebung ist besonders nützlich, wenn die Sichtverhältnisse schlecht sind, z. B. bei Nebel, Regen oder in der Nacht. Da es nicht auf Licht angewiesen ist, kann es Flugzeuge, Fahrzeuge oder Gelände in völliger Dunkelheit detect . Das macht Radar zu einer zuverlässigen Lösung für die Luftfahrt, die Wetterüberwachung und die autonome Navigation.

Im Vergleich dazu wird die Sonarbildgebung häufig in Unterwasserumgebungen eingesetzt, in denen kein Licht hinkommt. Sie verwendet Schallwellen, die sich durch Wasser bewegen und von untergetauchten Objekten abprallen, wodurch die Erkennung von U-Booten, die Kartierung von Meeresböden und die Durchführung von Unterwasserrettungsmissionen ermöglicht werden. Fortschritte in der Computer Vision ermöglichen nun eine weitere Verbesserung der Unterwassererkennung durch die Kombination von Sonardaten mit intelligenter Analyse zur Verbesserung der Erkennung und Entscheidungsfindung.

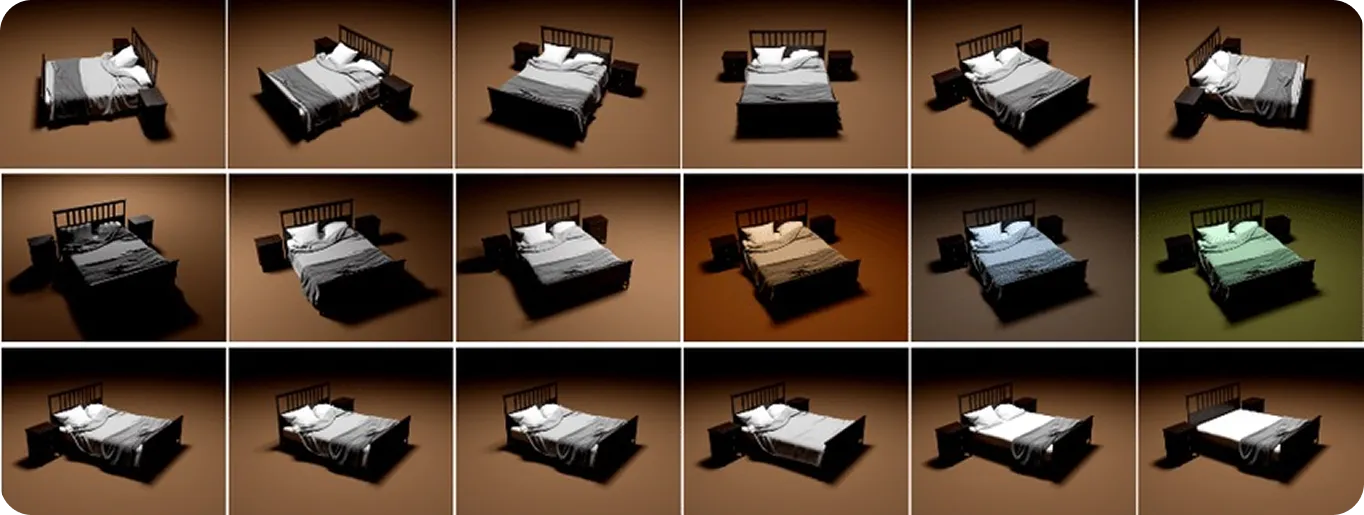

Bisher waren die verschiedenen Arten von Daten, die wir besprochen haben, solche, die aus der realen Welt gesammelt werden können. Synthetische und simulierte visuelle Daten sind jedoch beides Arten von künstlichen Inhalten. Synthetische Daten werden von Grund auf mit 3D-Modellierung oder generativer KI erzeugt, um realistisch aussehende Bilder oder Videos zu erstellen.

Simulierte Daten sind ähnlich, beinhalten aber die Erstellung virtueller Umgebungen, die das Verhalten der physischen Welt nachbilden, einschließlich Lichtreflexion, Schattenbildung und Objektbewegung. Während alle simulierten visuellen Daten synthetisch sind, sind nicht alle synthetischen Daten simuliert. Der Hauptunterschied besteht darin, dass simulierte Daten realistisches Verhalten replizieren, nicht nur das Aussehen.

Diese Datentypen sind nützlich für das Training von Computer-Vision-Modellen, insbesondere wenn reale Daten schwer zu sammeln sind oder wenn bestimmte, seltene Situationen simuliert werden müssen. Entwickler können ganze Szenen erstellen, Objekttypen, Positionen und Beleuchtung auswählen und automatisch Beschriftungen wie Begrenzungsrahmen für das Training hinzufügen. Dies hilft, große, vielfältige Datensätze schnell zu erstellen, ohne dass echte Fotos oder manuelle Beschriftung erforderlich sind, was kostspielig und zeitaufwändig sein kann.

Im Gesundheitswesen können beispielsweise synthetische Daten verwendet werden, um Modelle für die segment von Brustkrebszellen zu trainieren, wo das Sammeln und Beschriften großer Datensätze mit echten Bildern schwierig ist. Synthetische und simulierte Daten bieten Flexibilität und Kontrolle und füllen Lücken, wo reale Bilder nur begrenzt zur Verfügung stehen.

Nachdem wir uns nun angesehen haben, wie verschiedene Arten von visuellen Daten funktionieren und was sie leisten können, wollen wir uns genauer ansehen, welche Datentypen für bestimmte Aufgaben am besten geeignet sind:

Manchmal liefert ein einzelner Datentyp in realen Situationen möglicherweise nicht genügend Genauigkeit oder Kontext. Hier wird die multimodale Sensorfusion entscheidend. Durch die Kombination von RGB mit anderen Datentypen wie Wärme, Tiefe oder LiDAR können Systeme individuelle Einschränkungen überwinden und die Zuverlässigkeit und Anpassungsfähigkeit verbessern.

Zum Beispiel wird in der Lagerautomatisierung die Verwendung von RGB für die Objekterkennung, Tiefe für die Entfernungsmessung und Wärme für die Erkennung von überhitzten Geräten den Betrieb effizienter und sicherer. Letztendlich werden die besten Ergebnisse erzielt, wenn Datentypen basierend auf den spezifischen Anforderungen Ihrer Anwendung ausgewählt oder kombiniert werden.

Bei der Entwicklung von Vision-KI-Modellen ist die Wahl des richtigen Typs visueller Daten entscheidend. Aufgaben wie Objekterkennung, Segmentierung und Bewegungsverfolgung hängen nicht nur von Algorithmen ab, sondern auch von der Qualität der Eingabedaten. Saubere, vielfältige und genaue Datensätze tragen dazu bei, Rauschen zu reduzieren und die Leistung zu verbessern.

Durch die Kombination von Datentypen wie RGB, Tiefe, Wärme und LiDAR erhalten KI-Systeme einen umfassenderen Überblick über die Umgebung, wodurch sie unter verschiedenen Bedingungen zuverlässiger werden. Da sich die Technologie ständig verbessert, wird sie wahrscheinlich den Weg dafür ebnen, dass Vision AI in allen Branchen schneller, anpassungsfähiger und wirkungsvoller wird.

Treten Sie unserer Community bei und erkunden Sie unser GitHub-Repository, um mehr über Computer Vision zu erfahren. Entdecken Sie verschiedene Anwendungen im Zusammenhang mit KI im Gesundheitswesen und Computer Vision im Einzelhandel auf unseren Lösungsseiten. Sehen Sie sich unsere Lizenzoptionen an, um mit Vision AI zu beginnen.