Exploración de varios tipos de datos para aplicaciones de Vision AI

Descubra cómo los tipos de datos visuales como las imágenes térmicas, LiDAR e infrarrojas permiten diversas aplicaciones de visión artificial en todas las industrias.

Descubra cómo los tipos de datos visuales como las imágenes térmicas, LiDAR e infrarrojas permiten diversas aplicaciones de visión artificial en todas las industrias.

La tecnología como los drones solía ser limitada y solo accesible a investigadores y especialistas, pero hoy en día, el hardware de vanguardia es cada vez más accesible a un público más amplio. Este cambio está transformando la forma en que recopilamos datos visuales. Con una tecnología más accesible, ahora podemos capturar imágenes y vídeos de una variedad de fuentes, más allá de las cámaras tradicionales.

Paralelamente, el análisis de imágenes, facilitado por la visión por ordenador, una rama de la inteligencia artificial (IA), está evolucionando rápidamente, permitiendo a las máquinas interpretar y procesar datos visuales con mayor eficacia. Este avance ha abierto nuevas posibilidades de automatización, detección de objetos y análisis en tiempo real. Ahora las máquinas pueden reconocer patrones, track movimientos y dar sentido a datos visuales complejos.

Algunos tipos clave de datos visuales son las imágenes RGB (rojo, verde y azul), que suelen utilizarse para el reconocimiento de objetos, las imágenes térmicas, que ayudan a detect firmas de calor en condiciones de poca luz, y los datos de profundidad, que permiten a las máquinas comprender entornos tridimensionales. Cada uno de estos tipos de datos desempeña un papel fundamental en las diversas aplicaciones de la IA visual, que van desde la vigilancia a la obtención de imágenes médicas.

En este artículo, exploraremos los principales tipos de datos visuales utilizados en Vision AI y exploraremos cómo contribuye cada uno a mejorar la precisión, la eficiencia y el rendimiento en diversas industrias. ¡Empecemos!

Normalmente, cuando usas un smartphone para tomar una foto o ver imágenes de CCTV, estás trabajando con imágenes RGB. RGB significa rojo, verde y azul, y son los tres canales de color que representan la información visual en las imágenes digitales.

Las imágenes y los vídeos RGB son tipos de datos visuales estrechamente relacionados que se utilizan en la visión artificial, ambos capturados con cámaras estándar. La diferencia clave es que las imágenes capturan un solo momento, mientras que los vídeos son una secuencia de fotogramas que muestran cómo cambian las cosas con el tiempo.

Las imágenes RGB se utilizan generalmente para tareas de visión por ordenador como la detección de objetos, la segmentación de instancias y la estimación de poses, con el apoyo de modelos como Ultralytics YOLO11. Estas aplicaciones se basan en la identificación de patrones, formas o características específicas en un solo fotograma.

Los vídeos, por su parte, son esenciales cuando el movimiento o el tiempo son un factor, como en el reconocimiento de gestos, la vigilancia o el seguimiento de acciones. Dado que los vídeos pueden considerarse una serie de imágenes, los modelos de visión por ordenador como YOLO11 los procesan fotograma a fotograma para comprender el movimiento y el comportamiento a lo largo del tiempo.

Por ejemplo, YOLO11 puede utilizarse para analizar imágenes o vídeos RGB para detect malas hierbas y contar plantas en campos agrícolas. Esto mejora la supervisión de los cultivos y ayuda a track los cambios a lo largo de los ciclos de cultivo para una gestión agrícola más eficiente.

Los datos de profundidad añaden una tercera dimensión a la información visual al indicar a qué distancia se encuentran los objetos de la cámara o el sensor. A diferencia de las imágenes RGB que solo capturan el color y la textura, los datos de profundidad proporcionan contexto espacial. Muestran la distancia entre los objetos y la cámara, lo que permite interpretar el diseño 3D de una escena.

Este tipo de datos se captura utilizando tecnologías como LiDAR, visión estéreo (que utiliza dos cámaras para imitar la percepción de profundidad humana) y cámaras de Tiempo de Vuelo (Time-of-Flight, que miden el tiempo que tarda la luz en viajar hacia un objeto y regresar).

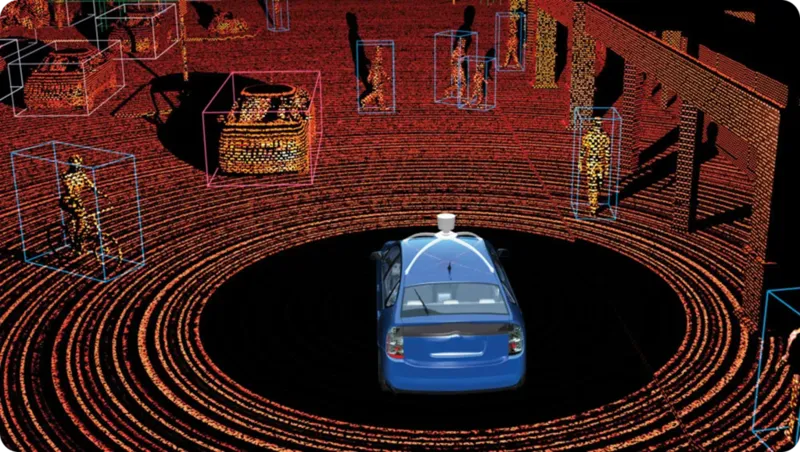

Entre estos, LiDAR (Light Detection and Ranging) suele ser el más fiable para la medición de la profundidad. Funciona enviando rápidos pulsos láser y midiendo el tiempo que tardan en rebotar. El resultado es un mapa 3D de alta precisión, conocido como nube de puntos, que destaca la forma, la posición y la distancia de los objetos en tiempo real.

La tecnología LiDAR se puede dividir en dos tipos principales, cada uno diseñado para aplicaciones y entornos específicos. Aquí hay una mirada más de cerca a ambos tipos:

Una aplicación impactante de los datos LiDAR se encuentra en los vehículos autónomos, donde desempeña un papel clave en tareas como la detección de carriles, la prevención de colisiones y la identificación de objetos cercanos. LiDAR genera mapas 3D detallados y en tiempo real del entorno, lo que permite al vehículo ver objetos, calcular su distancia y navegar de forma segura.

Las imágenes RGB capturan lo que vemos en el espectro de luz visible; sin embargo, otras tecnologías de imagen, como la imagen térmica y la infrarroja, van más allá. La imagen infrarroja captura la luz infrarroja que emiten o reflejan los objetos, lo que la hace útil en condiciones de poca luz.

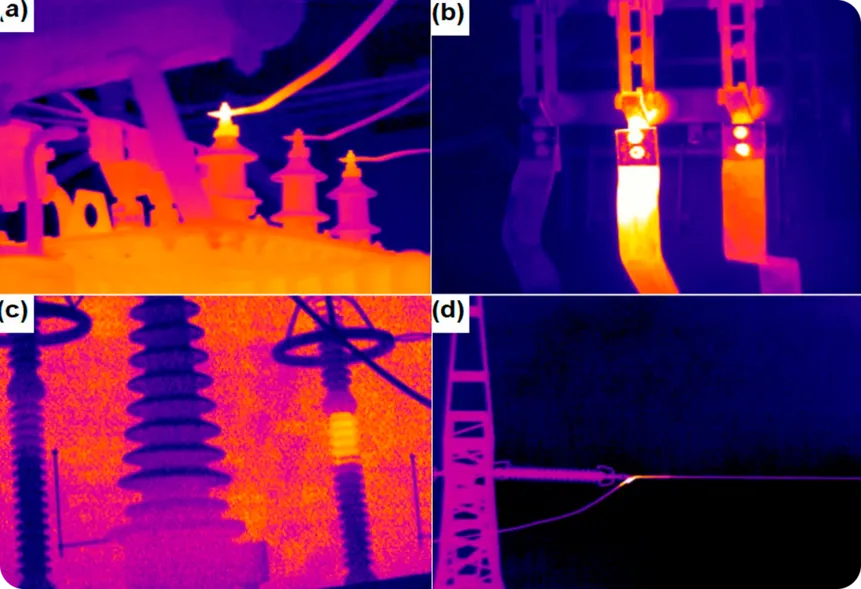

La termografía, en cambio, detecta el calor emitido por los objetos y muestra las diferencias de temperatura, lo que le permite funcionar en completa oscuridad o a través de humo, niebla y otras obstrucciones. Este tipo de datos es particularmente útil para monitorear y detectar problemas, especialmente en industrias donde los cambios de temperatura pueden indicar problemas potenciales.

Un ejemplo interesante es el uso de imágenes térmicas para supervisar los componentes eléctricos en busca de signos de sobrecalentamiento. Al detectar las diferencias de temperatura, las cámaras térmicas pueden identificar problemas antes de que provoquen fallos en los equipos, incendios o daños costosos.

Del mismo modo, las imágenes infrarrojas pueden ayudar a detect fugas en tuberías o aislamientos mediante la identificación de diferencias de temperatura que indican la salida de gases o fluidos, lo que resulta crucial para prevenir situaciones peligrosas y mejorar la eficiencia energética.

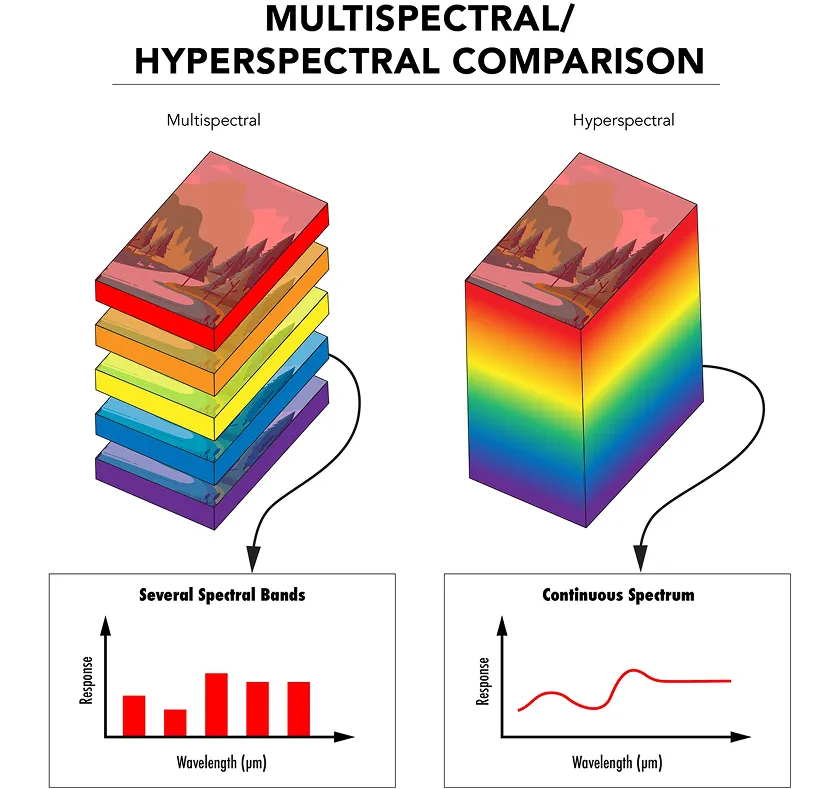

Mientras que las imágenes infrarrojas y térmicas capturan aspectos específicos del espectro electromagnético, las imágenes multiespectrales recogen la luz de unos pocos rangos de longitud de onda seleccionados, cada uno elegido para un propósito específico, como la detección de vegetación sana o la identificación de materiales de superficie.

La imagen hiperespectral va un paso más allá al capturar la luz a través de cientos de rangos de longitud de onda muy estrechos y continuos. Esto proporciona una firma de luz detallada para cada píxel de la imagen, ofreciendo una comprensión mucho más profunda de cualquier material que se observe.

Tanto las imágenes multiespectrales como las hiperespectrales utilizan sensores y filtros especiales para capturar la luz en diferentes longitudes de onda. Los datos se organizan entonces en una estructura 3D llamada cubo espectral, en la que cada capa representa una longitud de onda diferente.

Los modelos de IA pueden analizar estos datos para detect características que las cámaras normales o el ojo humano no pueden ver. Por ejemplo, en el fenotipado de plantas, las imágenes hiperespectrales pueden utilizarse para controlar la salud y el crecimiento de las plantas detectando cambios sutiles en sus hojas o tallos, como deficiencias de nutrientes o estrés. Esto ayuda a los investigadores a evaluar la salud de las plantas y optimizar las prácticas agrícolas sin necesidad de métodos invasivos.

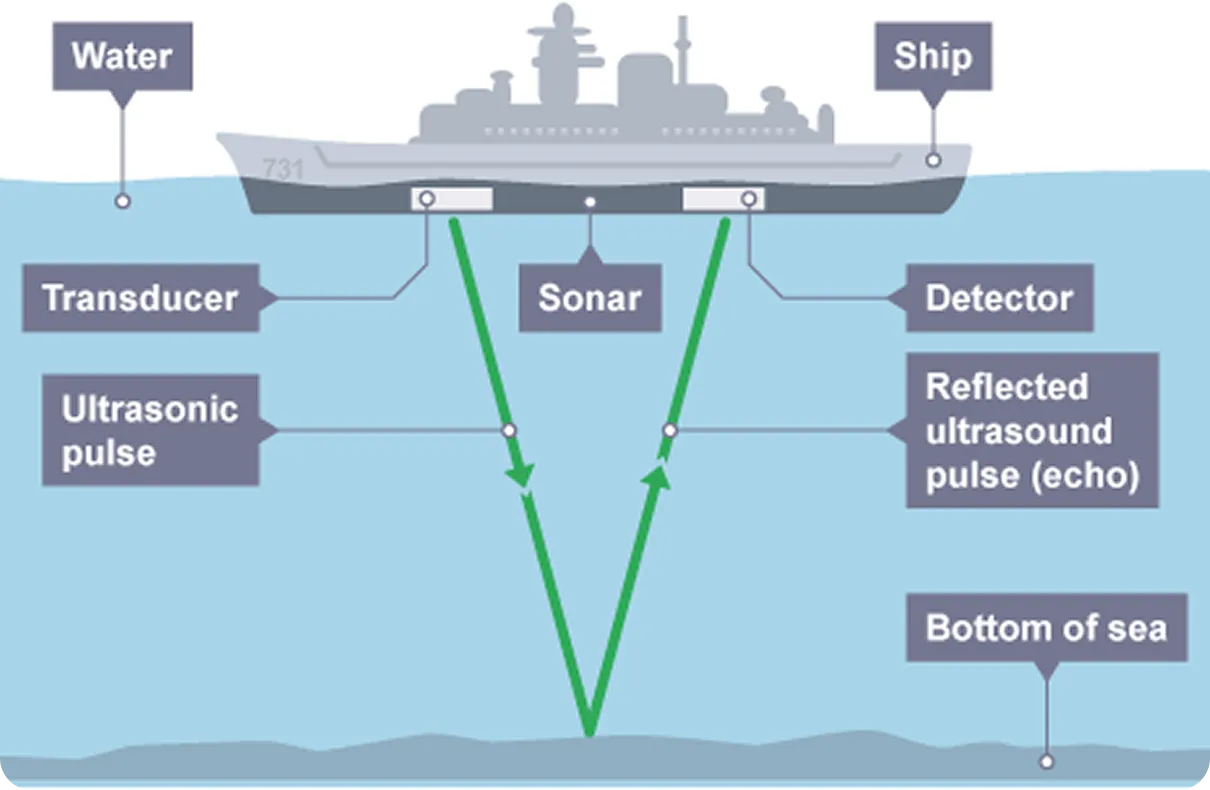

El radar y el sonar son tecnologías que detect y cartografían objetos enviando señales y analizando sus reflejos, de forma similar al LiDAR. A diferencia de las imágenes RGB, que se basan en ondas luminosas para captar información visual, el radar utiliza ondas electromagnéticas, normalmente ondas de radio, mientras que el sonar utiliza ondas sonoras. Tanto el radar como el sonar emiten impulsos y miden el tiempo que tarda la señal en rebotar en un objeto, lo que proporciona información sobre su distancia, tamaño y velocidad.

Las imágenes por radar son especialmente útiles cuando la visibilidad es escasa, como durante la niebla, la lluvia o la noche. Al no depender de la luz, puede detect aeronaves, vehículos o terrenos en completa oscuridad. Esto convierte al radar en una opción fiable para la aviación, la vigilancia meteorológica y la navegación autónoma.

En comparación, las imágenes de sonar se utilizan comúnmente en entornos submarinos donde la luz no puede llegar. Utiliza ondas de sonido que viajan a través del agua y rebotan en objetos sumergidos, lo que permite la detección de submarinos, el mapeo de los fondos oceánicos y la ejecución de misiones de rescate submarinas. Los avances en la visión artificial ahora están permitiendo una mayor mejora de la detección submarina mediante la combinación de datos de sonar con análisis inteligente para mejorar la detección y la toma de decisiones.

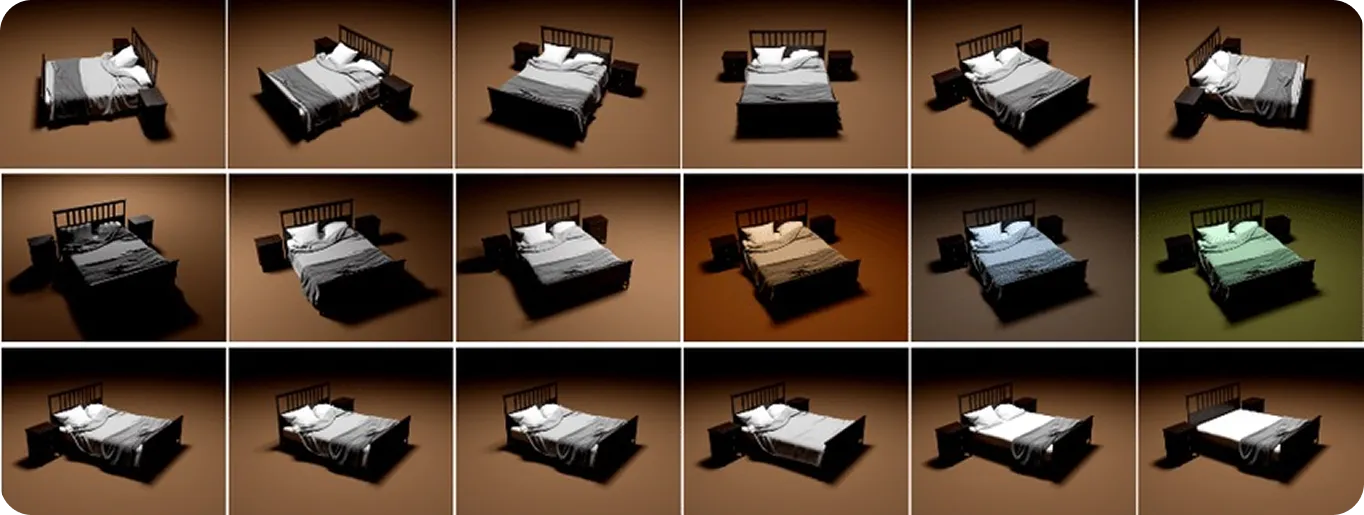

Hasta ahora, los diferentes tipos de datos que hemos comentado han sido aquellos que se pueden recopilar del mundo real. Sin embargo, los datos visuales sintéticos y simulados son ambos tipos de contenido artificial. Los datos sintéticos se generan desde cero utilizando modelado 3D o IA generativa para producir imágenes o vídeos de aspecto realista.

Los datos simulados son similares, pero implican la creación de entornos virtuales que replican el comportamiento del mundo físico, incluyendo la reflexión de la luz, la formación de sombras y el movimiento de los objetos. Aunque todos los datos visuales simulados son sintéticos, no todos los datos sintéticos son simulados. La diferencia clave es que los datos simulados replican el comportamiento realista, no solo la apariencia.

Estos tipos de datos son útiles para entrenar modelos de visión artificial, especialmente cuando los datos del mundo real son difíciles de recopilar o cuando es necesario simular situaciones específicas y poco comunes. Los desarrolladores pueden crear escenas completas, elegir tipos de objetos, posiciones e iluminación, y añadir automáticamente etiquetas como cuadros delimitadores para el entrenamiento. Esto ayuda a construir conjuntos de datos grandes y diversos rápidamente, sin necesidad de fotos reales o etiquetado manual, lo que puede ser costoso y llevar mucho tiempo.

Por ejemplo, en el ámbito sanitario, los datos sintéticos pueden utilizarse para entrenar modelos de segment células de cáncer de mama, donde resulta difícil recopilar y etiquetar grandes conjuntos de datos de imágenes reales. Los datos sintéticos y simulados aportan flexibilidad y control, llenando lagunas donde las imágenes del mundo real son limitadas.

Ahora que hemos visto cómo funcionan los diferentes tipos de datos visuales y lo que pueden hacer, veamos más de cerca qué tipos de datos son mejores para tareas específicas:

A veces, un solo tipo de datos puede no proporcionar suficiente precisión o contexto en situaciones del mundo real. Aquí es donde la fusión de sensores multimodal se vuelve clave. Al combinar RGB con otros tipos de datos como térmicos, de profundidad o LiDAR, los sistemas pueden superar las limitaciones individuales, mejorando la fiabilidad y la adaptabilidad.

Por ejemplo, en la automatización de almacenes, el uso de RGB para el reconocimiento de objetos, la profundidad para la medición de distancias y la tecnología térmica para la detección de equipos sobrecalentados hace que las operaciones sean más eficientes y seguras. En última instancia, los mejores resultados provienen de la selección o combinación de tipos de datos en función de las necesidades específicas de su aplicación.

Al construir modelos de Visión Artificial, elegir el tipo correcto de datos visuales es crucial. Tareas como la detección de objetos, la segmentación y el seguimiento del movimiento dependen no solo de los algoritmos, sino también de la calidad de los datos de entrada. Los conjuntos de datos limpios, diversos y precisos ayudan a reducir el ruido y mejorar el rendimiento.

Al combinar tipos de datos como RGB, profundidad, térmicos y LiDAR, los sistemas de IA obtienen una visión más completa del entorno, lo que los hace más fiables en diversas condiciones. A medida que la tecnología siga mejorando, es probable que allane el camino para que la visión artificial sea más rápida, adaptable y tenga un mayor impacto en todos los sectores.

Únase a nuestra comunidad y explore nuestro repositorio de GitHub para obtener más información sobre la visión artificial. Descubra varias aplicaciones relacionadas con la IA en la atención médica y la visión artificial en el comercio minorista en nuestras páginas de soluciones. Consulte nuestras opciones de licencia para comenzar con la Visión Artificial.